訓(xùn)練計(jì)算機(jī)視覺模型通常需要在各種場景配置和屬性下收集和標(biāo)注大量圖像。這個(gè)過程非常耗時(shí),確保捕獲的數(shù)據(jù)分布很好地映射到應(yīng)用程序場景的目標(biāo)域也是一個(gè)挑戰(zhàn)。

最近,合成數(shù)據(jù)已成為解決這兩個(gè)問題的一種方法。然而,現(xiàn)有的方法要么需要人類專家手動(dòng)調(diào)整每個(gè)場景屬性,要么用幾乎沒有控制的自動(dòng)方法;這需要渲染大量隨機(jī)的數(shù)據(jù)變異,其過程很慢,并且對于目標(biāo)域來說通常是次優(yōu)的。

作者提出了第一個(gè)完全可微分的合成數(shù)據(jù)流水線,在閉環(huán)中用神經(jīng)輻射場(NERF),其具備目標(biāo)應(yīng)用的損失函數(shù)。這個(gè)方法按需生成數(shù)據(jù),無需人力,最大限度地提高目標(biāo)任務(wù)的準(zhǔn)確性。

該方法在合成和真實(shí)目標(biāo)檢測任務(wù)中具備有效性。一個(gè)新的“YCB-in-the-Wild”數(shù)據(jù)集和基準(zhǔn),為現(xiàn)實(shí)環(huán)境中具有不同姿態(tài)的目標(biāo)檢測提供了測試場景。

最近,圖像生成技術(shù)神經(jīng)輻射場(NeRF),作為用基于神經(jīng)網(wǎng)絡(luò)的渲染器,替代傳統(tǒng)光柵化和光線跟蹤圖形學(xué)流水線的方法。這種方法可以生成高質(zhì)量的場景新視圖,無需進(jìn)行明確的3D理解。NeRF的最新進(jìn)展允許控制其他渲染參數(shù),如照明、材質(zhì)、反照率、外觀等。因此,被廣泛應(yīng)用于各種圖形和視覺任務(wù)。

NeRF及其變型具有一些誘人的特性:(i)可差分渲染,(ii)與GANs和VAEs不同的對場景屬性的控制,以及(iii)與傳統(tǒng)渲染器相比,數(shù)據(jù)驅(qū)動(dòng)的模式,而傳統(tǒng)渲染器需要精心制作3D模型和場景。這些屬性適合于為給定目標(biāo)任務(wù)按需生成最佳數(shù)據(jù)。

NeRF更適合學(xué)習(xí)生成合成數(shù)據(jù)集的優(yōu)勢在于兩個(gè)方面。 首先,NeRF學(xué)習(xí)僅基于圖像數(shù)據(jù)和攝像頭姿態(tài)信息從新視圖生成數(shù)據(jù)。

相反,傳統(tǒng)的圖形學(xué)流水線需要目標(biāo)的3D模型作為輸入。獲得具有正確幾何、材質(zhì)和紋理屬性的精確3D模型通常需要人類專家(即藝術(shù)家或建模師)。這反過來限制了傳統(tǒng)圖形學(xué)流水線在許多新目標(biāo)或場景的大規(guī)模渲染中的可擴(kuò)展性。

其次,NeRF是一種可微分的渲染器,因此允許通過渲染流水線進(jìn)行反向傳播,學(xué)習(xí)如何以模型和場景為中心的方式控制數(shù)據(jù)生成。 工作目標(biāo)是自動(dòng)合成最佳訓(xùn)練數(shù)據(jù),最大限度地提高目標(biāo)任務(wù)的準(zhǔn)確性,取名為Neural-Sim。

在這項(xiàng)工作中,將目標(biāo)檢測作為目標(biāo)任務(wù)。此外,最近,NeRF及其變型(NeRFs)已用于合成復(fù)雜場景的高分辨率真實(shí)感圖像。這里提出了一種優(yōu)化NERF渲染參數(shù)的技術(shù),生成用于訓(xùn)練目標(biāo)檢測模型的最佳圖像集。

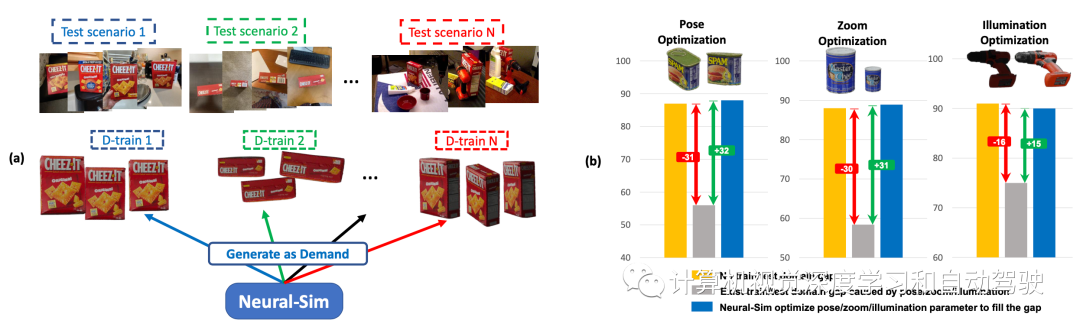

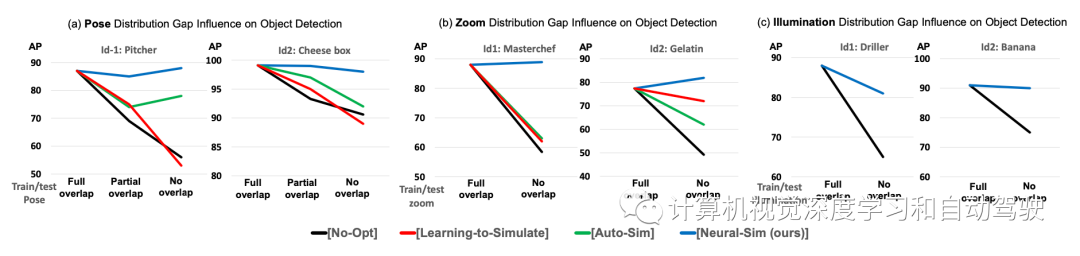

如圖所示:(a) 按需合成數(shù)據(jù)生成:給定目標(biāo)任務(wù)和測試數(shù)據(jù)集,Neural- Sim使用完全可微分的合成數(shù)據(jù)生成流水線按需生成數(shù)據(jù),最大限度地提高目標(biāo)任務(wù)的精度。(b) 訓(xùn)練/測試域間隙導(dǎo)致檢測精度顯著下降(黃色條至灰色條)。動(dòng)態(tài)優(yōu)化渲染參數(shù)(姿勢/縮放/照明),生成填充該間隙的最佳數(shù)據(jù)(藍(lán)色條)。

NeRF模型

NeRF表示為V =(φ,ρ),把觀察方向(或攝像頭姿態(tài))作為輸入,并渲染沿V觀看的場景圖像x=NeRF(V)。注意,這里技術(shù)通常廣泛適用于不同的渲染器。這項(xiàng)工作中還優(yōu)化了NeRF-in-the-wild(NeRF-w),允許外觀和照明變化以及姿勢變化。

合成訓(xùn)練數(shù)據(jù)生成

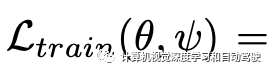

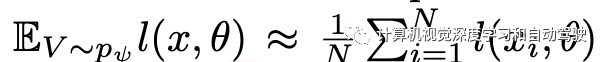

考慮渲染參數(shù)V的參數(shù)概率分布pψ,其中ψ表示分布的參數(shù)。應(yīng)注意,ψ對應(yīng)于所有渲染參數(shù),包括姿勢/縮放/照明,這里,為了簡單起見,ψ表示姿勢變量。為了生成合成訓(xùn)練數(shù)據(jù),首先采樣渲染參數(shù)V1、V2、…、VN~ pψ。然后,用NeRF生成具有各自渲染參數(shù)Vi的合成訓(xùn)練圖像xi=NeRF(Vi)。 使用現(xiàn)成的前景提取器獲得標(biāo)簽y1,y2,…,yN。由此生成的訓(xùn)練數(shù)據(jù)集表示為Dtrain = {(x1,y1)、(x2,y2),…,(xN,yN)}。

優(yōu)化合成數(shù)據(jù)生成

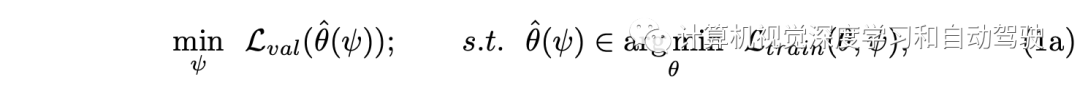

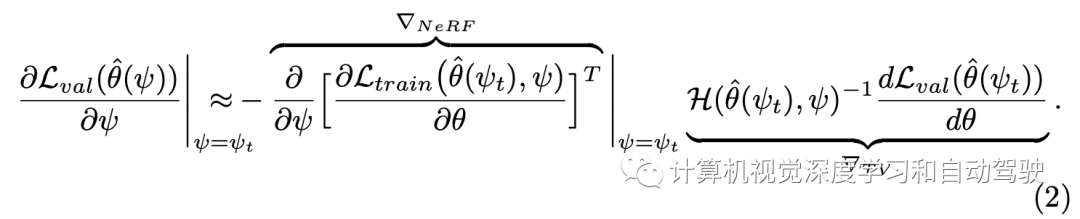

目標(biāo)是優(yōu)化渲染分布pψ,在Dtrain上訓(xùn)練目標(biāo)檢測模型使得在Dval上獲得良好的性能。如此構(gòu)建一個(gè)兩層優(yōu)化,即:

其中

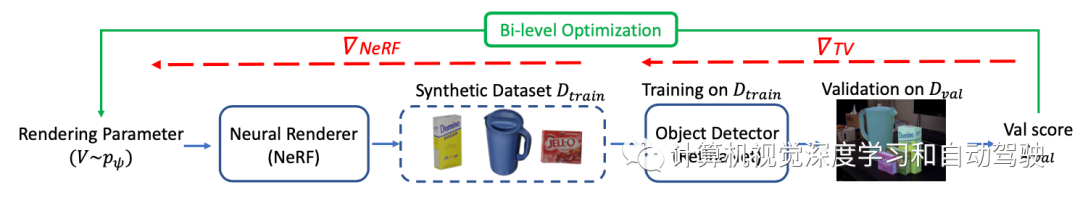

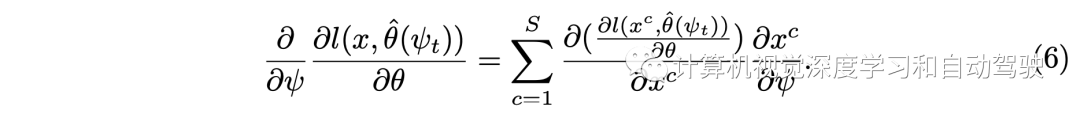

這里求解方法采用如下的梯度計(jì)算:其分成兩個(gè)項(xiàng)分別估計(jì),?NeRF對應(yīng)于通過從NeRF生成數(shù)據(jù)集的反向傳播,以及?TV對應(yīng)于通過訓(xùn)練和驗(yàn)證的近似反向傳播

如圖所示Neural-Sim的流水線:從經(jīng)過訓(xùn)練的神經(jīng)渲染器(NeRF)中找到生成視圖的最佳參數(shù),用作目標(biāo)檢測的訓(xùn)練數(shù)據(jù)。目標(biāo)是找到能夠生成合成訓(xùn)練數(shù)據(jù)Dtrain的最佳NeRF渲染參數(shù)ψ,在Dtrain上訓(xùn)練的模型(取RetinaNet為例)最大化驗(yàn)證集Dval表示的下游任務(wù)的精度。

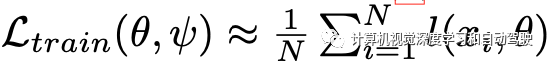

近似計(jì)算:

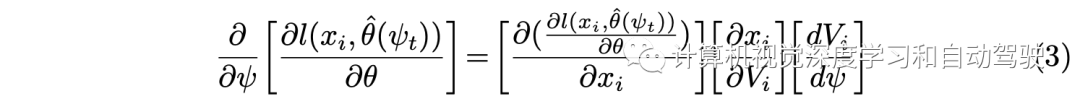

然后基于鏈?zhǔn)椒▌t得到:

為計(jì)算采用一些近似方法:

對于位姿參數(shù)離散區(qū)間上的分布pψ,提出了一種ψ的重新參數(shù)化,提供了dVi/dψ的有效近似(工具 1)。

用一種兩次向前一次向后(twice-forward-once-backward)的方法(工具2),大大減少了(2)中梯度近似的內(nèi)存和計(jì)算開銷。如果沒有這種新技術(shù),實(shí)現(xiàn)中需要涉及大矩陣和計(jì)算圖的高計(jì)算開銷。

即使使用上述技術(shù),在GPU內(nèi)存方面,(3)中計(jì)算第一項(xiàng)和第二項(xiàng)的開銷很大,取決于圖像大小。用逐塊梯度計(jì)算方法(工具 3)克服了這一問題。

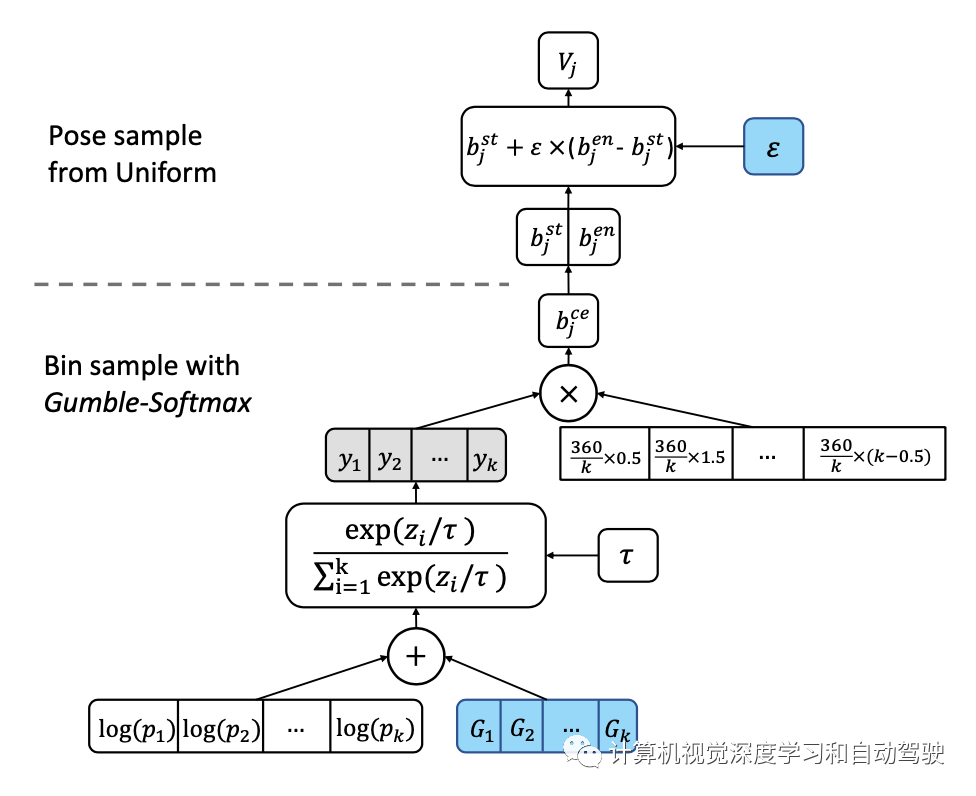

關(guān)于工具1中重新參數(shù)化的實(shí)現(xiàn),采用bin-samplinng,如圖所示:首先將位姿空間離散為一組k個(gè)bins,然后對其進(jìn)行采樣以生成NeRF的視圖參數(shù)。為了在采樣過程中反向傳播,用Gumble softmax的“重新參數(shù)化技巧”,從類別(即bin)分布中近似樣本。在每個(gè)bin中,均勻采樣。

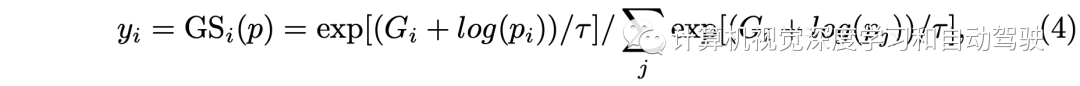

這里y的計(jì)算如下

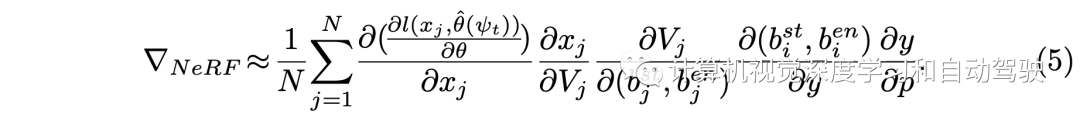

這樣?NeRF的計(jì)算變成:

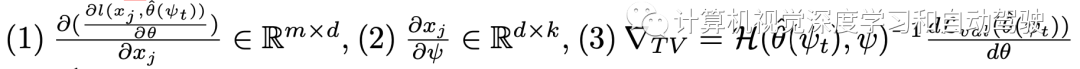

整個(gè)梯度計(jì)算包括三項(xiàng):

?

?

而工具2提出的“兩次向前一次向后“方法是這樣的:在第一個(gè)前向路徑中,不計(jì)算梯度,只渲染圖像形成Dtrain,保存用于渲染的y,φj的隨機(jī)樣本。然后,轉(zhuǎn)向梯度計(jì)算(3)。在第二次通路NeRF時(shí),保持相同的樣本,去計(jì)算梯度(1)和(2)。 所謂工具3的逐塊梯度計(jì)算如下:

NeRF-in-the-wild(NeRF-w)擴(kuò)展了普通NeRF模型,允許依賴于圖像的外觀和照明變化,從而可以顯式模擬圖像之間的光度差異。

NeRF-w沿觀看方向V作為輸入的是外觀嵌入,表示為l,圖像呈現(xiàn)為x=NeRF(V,l)。

對于NERF-w,位姿(V)的優(yōu)化與上述相同。照明的有效優(yōu)化,則利用NeRF-w的一個(gè)值得注意的特性:允許在顏色和照明之間進(jìn)行平滑插值。這能夠?qū)⒄彰鲀?yōu)化為連續(xù)變量,其中照明(l)可以寫成可用照明嵌入(li)的仿射函數(shù),l = sum(ψi? li)其中sum(ψi)= 1。

為從等式(3)計(jì)算梯度,?xi/?l使用工具2和工具3,以與上述相同的方式計(jì)算l,并且dl/dψ項(xiàng)計(jì)算是直接的,并通過投影梯度下降(projected gradient descent)進(jìn)行優(yōu)化。

實(shí)現(xiàn)細(xì)節(jié)如下:用傳統(tǒng)渲染Blender-Proc,100幅具有不同攝像頭姿態(tài)和縮放因子的圖像,為每個(gè)YCB目標(biāo)訓(xùn)練一個(gè)NeRF-w模型。用RetinaNet作為下游目標(biāo)檢測器。

為了加速優(yōu)化,在訓(xùn)練期間固定主干。在雙層優(yōu)化步驟中,用Gumble softmax 溫度τ = 0.1。在每次優(yōu)化迭代中,為每個(gè)目標(biāo)類渲染50幅圖像,并訓(xùn)練兩個(gè)epoch的 RetinaNet。

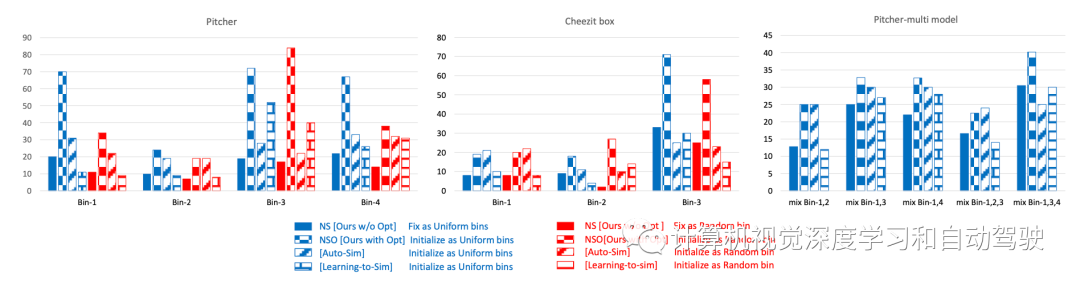

基線方法包括:提出的方法與學(xué)習(xí)模擬器參數(shù)的兩種流行方法進(jìn)行比較。第一個(gè)基線是“Learning to simulate (LTS)“,它提出了一種基于REINFORCE的方法來優(yōu)化模擬器參數(shù)。

還要注意,meta-sim是一種基于REINFORCE的方法。接下來,第二個(gè)考慮Auto-Sim,它提出了一種學(xué)習(xí)模擬器參數(shù)的有效優(yōu)化方法。

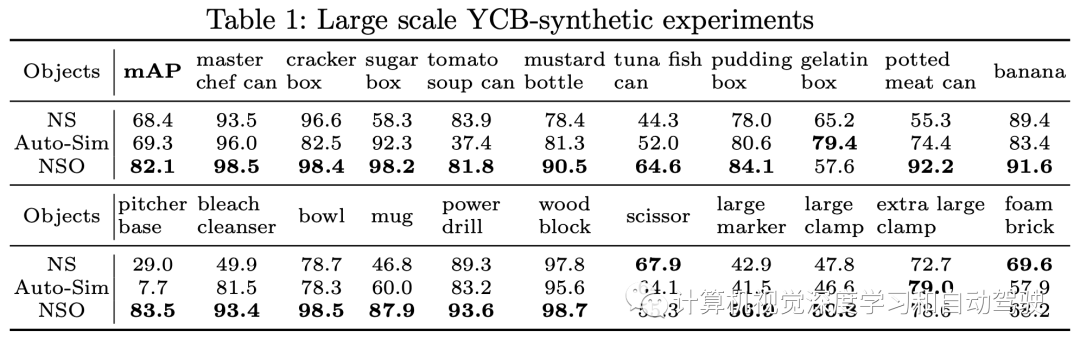

NS是指提出的方法沒有做兩層優(yōu)化的情況,NSO是指提出的方法采用兩層優(yōu)化的情況。

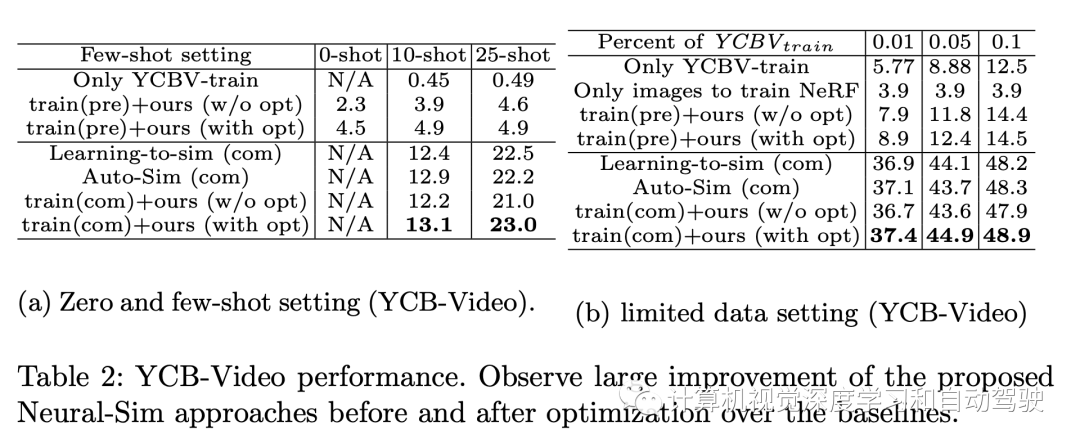

實(shí)驗(yàn)結(jié)果如下:

審核編輯:劉清

-

gpu

+關(guān)注

關(guān)注

28文章

4943瀏覽量

131202 -

攝像頭

+關(guān)注

關(guān)注

61文章

4976瀏覽量

98326 -

3D模型

+關(guān)注

關(guān)注

1文章

76瀏覽量

16443 -

提取器

+關(guān)注

關(guān)注

0文章

14瀏覽量

8193

原文標(biāo)題:Neural-Sim: 采用NeRF學(xué)習(xí)如何生成訓(xùn)練數(shù)據(jù)

文章出處:【微信號(hào):3D視覺工坊,微信公眾號(hào):3D視覺工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評(píng)論請先 登錄

KaihongOS操作系統(tǒng)FA模型與Stage模型介紹

適用于數(shù)據(jù)中心和AI時(shí)代的800G網(wǎng)絡(luò)

一種多模態(tài)駕駛場景生成框架UMGen介紹

英偉達(dá)GTC2025亮點(diǎn) NVIDIA推出Cosmos世界基礎(chǔ)模型和物理AI數(shù)據(jù)工具的重大更新

是否可以輸入隨機(jī)數(shù)據(jù)集來生成INT8訓(xùn)練后量化模型?

了解DeepSeek-V3 和 DeepSeek-R1兩個(gè)大模型的不同定位和應(yīng)用選擇

AN-715::走近IBIS模型:什么是IBIS模型?它們是如何生成的?

【「大模型啟示錄」閱讀體驗(yàn)】營銷領(lǐng)域大模型的應(yīng)用

【「大模型啟示錄」閱讀體驗(yàn)】如何在客服領(lǐng)域應(yīng)用大模型

大語言模型優(yōu)化生成管理方法

NVIDIA Isaac Sim滿足模型的多樣化訓(xùn)練需求

NVIDIA Nemotron-4 340B模型幫助開發(fā)者生成合成訓(xùn)練數(shù)據(jù)

NVIDIA AI Foundry 為全球企業(yè)打造自定義 Llama 3.1 生成式 AI 模型

深度學(xué)習(xí)模型有哪些應(yīng)用場景

AI時(shí)代,我們需要怎樣的數(shù)據(jù)中心?AI重新定義數(shù)據(jù)中心

評(píng)論