“源1.0”大模型是浪潮信息發(fā)布的中文巨量模型,參數(shù)量高達2457億,在中文語言能力理解和生成評測基準CUGE總榜中取得榜首,并獲得語言理解(篇章級)、語言生成、對話交互、多語言、數(shù)學(xué)推理等5項評測最佳成績。其中在數(shù)學(xué)推理評測中,源1.0大模型完成1000道小學(xué)數(shù)學(xué)應(yīng)用題,以76.9的高分大幅領(lǐng)先。

數(shù)學(xué)對邏輯和推理能力有極強的要求,以往大模型在數(shù)學(xué)領(lǐng)域表現(xiàn)欠佳。源1.0為何能取得這么好的成績?本文將介紹數(shù)學(xué)推理任務(wù)的背景、研究現(xiàn)狀,以及源1.0在數(shù)學(xué)推理任務(wù)方面的解決方案和表現(xiàn)。

數(shù)學(xué)單詞問題的研究背景及意義

數(shù)學(xué)單詞問題,即Math Word Problem(MWP),其主要目標是根據(jù)自然語言文字描述的內(nèi)容解決相應(yīng)的數(shù)學(xué)問題。也就是說,對于給定的數(shù)學(xué)問題,模型需要理解相關(guān)文字的數(shù)學(xué)含義,并推理出正確的表達式。

一個典型的MWP示例如下。

問題:“快車和慢車同時從相距450千米的兩城相對開出,4.5小時后兩車還相距90千米,快車和慢車的速度比為9:7,慢車每小時行多少千米?”

問題:“快車和慢車同時從相距450千米的兩城相對開出,4.5小時后兩車還相距90千米,快車和慢車的速度比為9:7,慢車每小時行多少千米?”

表達式:(450-90)/4.5*7/(9+7)

結(jié)果:35

不難發(fā)現(xiàn),該題目除了要求模型能夠理解基本的加減乘除法之外,還需要理解什么是比例問題。此外,若將問題中的“相對開出”改為“相反方向開出”,將會導(dǎo)致問題的數(shù)學(xué)邏輯大相徑庭。如何讓模型分辨出語言表達上的差異,并正確地推理出對應(yīng)的表達式是MWP任務(wù)的基本要求。

需要注意的是,在上面的MWP中,表達式中所需的數(shù)字量均可以在問題中找到,但在某些情況下,表達式中所需要的數(shù)字量并不會全部包含在問題中。例如,在含有分數(shù)的MWP示例中(如下紅框中所示),需要根據(jù)題目中的數(shù)學(xué)邏輯,在表達式中額外添加相應(yīng)的數(shù)字量“1”。同樣的問題還常見于計算圓的周長或面積時,需要額外添加數(shù)字量“3.14”。

問題:“一根電線長80米,第一次截去的全長的2/5,第二次截去了余下的1/4,這根電線還剩多少米?”

問題:“一根電線長80米,第一次截去的全長的2/5,第二次截去了余下的1/4,這根電線還剩多少米?”

表達式:80*(1-2/5-(1-2/5)*1/4)

結(jié)果:36

毫無疑問,MWP任務(wù)給模型的語言理解能力和數(shù)學(xué)推理能力都帶來了極大的挑戰(zhàn),如何解決MWP任務(wù)也是NLP領(lǐng)域的研究熱點之一。

數(shù)字單詞問題的研究現(xiàn)狀

實際上,直到2016年MWP的任務(wù)精度仍然比較有限。關(guān)于MWP任務(wù)在2016年之前的研究在此不作細述,相關(guān)綜述可參考論文:

How well do Computers Solve Math Word Problems? Large-Scale Dataset Construction and Evaluation (Huang et al., ACL 2016)

近幾年,借助DNN解決MWP任務(wù)的方法顯著提升了MWP任務(wù)精度,這些方法大致可以分為以下三類:基于seq2seq模型、基于seq2tree模型和基于預(yù)訓(xùn)練模型。

|基于seq2seq模型

該方法是由Wang Yan等學(xué)者[1]首次應(yīng)用在MWP任務(wù)上,并在大規(guī)模多題型的數(shù)據(jù)集(Math23K)上取得了顯著的效果(對于Math23K數(shù)據(jù)集將在后續(xù)內(nèi)容中進行說明)。該方法本質(zhì)上是采用Encoder-Decoder(enc-dec)結(jié)構(gòu)直接完成了從“問題”到“表達式”的映射。值得一提的是,前述的Math23K數(shù)據(jù)集規(guī)模較大題型較多(約22000道),是目前MWP任務(wù)評測的benchmark。

此外,通過設(shè)計不同的Encoder和Decoder結(jié)構(gòu)可以得到改進后的seq2seq方法。不過令人驚訝的是,Transformer結(jié)構(gòu)的enc-dec并未在Math23K數(shù)據(jù)集上表現(xiàn)出明顯的優(yōu)勢;而采用LSTM結(jié)構(gòu)作為enc-dec的LSTMVAE方法表現(xiàn)最佳。

|基于seq2tree模型

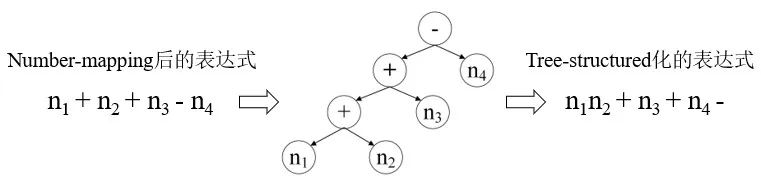

基于Seq2tree模型實際上是基于seq2seq模型的變種,簡單來說,就是將number-mapping后的表達式轉(zhuǎn)化為樹結(jié)構(gòu)作為模型訓(xùn)練的輸出(如圖1所示),由于父節(jié)點與子節(jié)點處的數(shù)學(xué)符號以及連接方式是固定的,這種方式能夠有效地限制表達式的多樣性。這里,表達式的多樣性可以理解為針對同一個問題可以列出不同的表達式,例如n1+n2-n3還可以寫成n2+n1-n3或者n1+(n2-n3)。

圖1 樹結(jié)構(gòu)化的表達式生成示意

在前述基礎(chǔ)下,基于seq2tree模型的MWP任務(wù)解決方法應(yīng)運而生,其核心思想是將原先的decoder被替換成了tree-based decoder。至此,MWP任務(wù)解決思路似乎主要集中在如何替換encoder和decoder問題上。例如,Wang Lei等學(xué)者又調(diào)整了encoder結(jié)構(gòu),提出了Graph2tree的方法并且在Math23K任務(wù)上精度高達75%。

|基于預(yù)訓(xùn)練模型

Wang Lei等學(xué)者[3]發(fā)現(xiàn)BERTGen和RoBERTGen(Dec:BERT、RoBERT;Enc:Transformer)在Math23K數(shù)據(jù)集上表現(xiàn)較為優(yōu)秀(76.9%)。此外,他們還驗證了GPT-2模型在Math23K數(shù)據(jù)集上的表現(xiàn)(74.3%),結(jié)果稍遜于基于BERT模型的方法,這可能是GPT-2模型結(jié)構(gòu)的原因(Decoder結(jié)構(gòu))。

|其他MWP任務(wù)解決方法

根據(jù)前述方法,可以看到的是encoder采用BERT模型較好,decoder采用tree-based方式較好,若將兩者結(jié)合形成BERT encoder + tree-based decoder[4],其在Math23K數(shù)據(jù)集上的精度達到了驚人的84.4%,是目前Math23K任務(wù)的baseline。

此外,在眾多MWP任務(wù)解決方法中Recall and learn方法[5]是十分值得一提的。該方法跳出了經(jīng)典的enc-dec結(jié)構(gòu),通過模擬人腦在解決問題時的類比能力,推理出數(shù)學(xué)問題的表達式,最終該方法在Math23K任務(wù)上的精度能夠達到82.3%。

“源1.0”大模型的MWP任務(wù)解決方案

需要指出的是,盡管構(gòu)建單個技能模型在一定程度上能夠較好地完成MWP任務(wù),但現(xiàn)有技能模型絕大多數(shù)仍采用的是encoder-decoder結(jié)構(gòu),針對類似decoder結(jié)構(gòu)下(如GPT-2)的模型數(shù)值推理能力的研究仍然較少。此外,從實現(xiàn)通用人工智能的目標來看,提升通用大模型的數(shù)值推理能力是十分必要的。

接下來,將詳細介紹浪潮信息的“源1.0”大模型(decoder結(jié)構(gòu))在Math23K任務(wù)上的相關(guān)工作,希望能夠?qū)μ嵘ㄓ么竽P偷臄?shù)值推理能力有所啟發(fā)。“源1.0”大模型在數(shù)學(xué)推理能力方面目前位列中文語言能力評測基準CUGE榜首。

| 目標導(dǎo)向的問答式Prompt設(shè)計

Math23K的標準數(shù)據(jù)樣例為:

{

“text”: “某班學(xué)生參加數(shù)學(xué)興趣小組,其中,參加的男生是全班人數(shù)的20%,參加的女生是全班人數(shù)的(2/7)多2人,不參加的人數(shù)比全班人數(shù)的(3/5)少5人,全班有多少人?”,

“segmented_text”: “某班 學(xué)生 參加 數(shù)學(xué) 興趣小組 , 其中 , 參加 的 男生 是 全班 人數(shù) 的 20% , 參加 的 女生 是 全班 人數(shù) 的 (2/7) 多 2 人 , 不 參加 的 人數(shù) 比 全班 人數(shù) 的 (3/5) 少 5 人 , 全班 有 多少 人 ?”,

“equation”: “x=(5-2)/(20%+(2/7)+(3/5)-1)”,

“l(fā)abel”: “35”

}

其中“text”和“equation”分別對應(yīng)了任務(wù)的問題和表達式信息。在嘗試過各種prompt后,最終確定的prompt設(shè)計如下。這種prompt設(shè)計將原本的問題拆分成了題干和待求解問題(“問:全班有多少人”)兩個部分,這是由于“問:”后面的內(nèi)容對表達式的生成十分關(guān)鍵。例如,“全班有多少人”和“全班女生有多少人”所對應(yīng)的表達式是完全不同的。

{

{

某班學(xué)生參加數(shù)學(xué)興趣小組,其中,參加的男生是全班人數(shù)的20%,參加的女生是全班人數(shù)的(2/7)多2人,不參加的人數(shù)比全班人數(shù)的(3/5)少5人,問:全班有多少人?答: x=(5-2)/(20%+(2/7)+(3/5)-1)

}

|相似啟發(fā)式數(shù)據(jù)增強方法

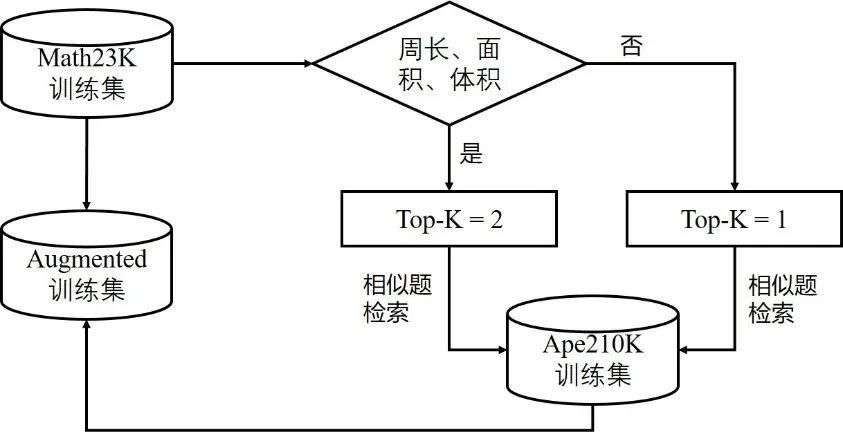

Math23K數(shù)據(jù)集的題型雖然較為豐富,但題型分布并不均勻。例如,涉及圖形周長、面積和體積類的問題顯然比其他題目類型要少,為保證模型在各類數(shù)學(xué)題型上均有較好的表現(xiàn),有必要將該類型的題目擴充。

本文采用了Ape210K數(shù)據(jù)集[6]對Math23K訓(xùn)練集進行擴充,Ape210K數(shù)據(jù)集是另一種較為常用的中文應(yīng)用數(shù)學(xué)題集,其題型更為豐富且題量更大(訓(xùn)練集約20萬道題)。然而,為保證模型在Math23K測試集上有良好的表現(xiàn),并不能簡單地將Math23K和Ape210K數(shù)據(jù)集混合在一起。為保證數(shù)據(jù)增強的有效性,本文提出了一種相似啟發(fā)式數(shù)據(jù)增強方法(如圖2所示)。

該方法針對Math23K訓(xùn)練集中的每一道題,首先判斷是否屬于圖形周長、面積和體積類題目。若屬于,則top-K取值為2,同時通過相似題檢索從Ape210K中召回對應(yīng)的相似題;若不屬于,則top-K取值為1,同樣進行相似題檢索。最后,將找到的相似題添加至Math23K訓(xùn)練集中,數(shù)據(jù)增強后的訓(xùn)練集約包含42000道題。

圖2 相似啟發(fā)式數(shù)據(jù)增強方法

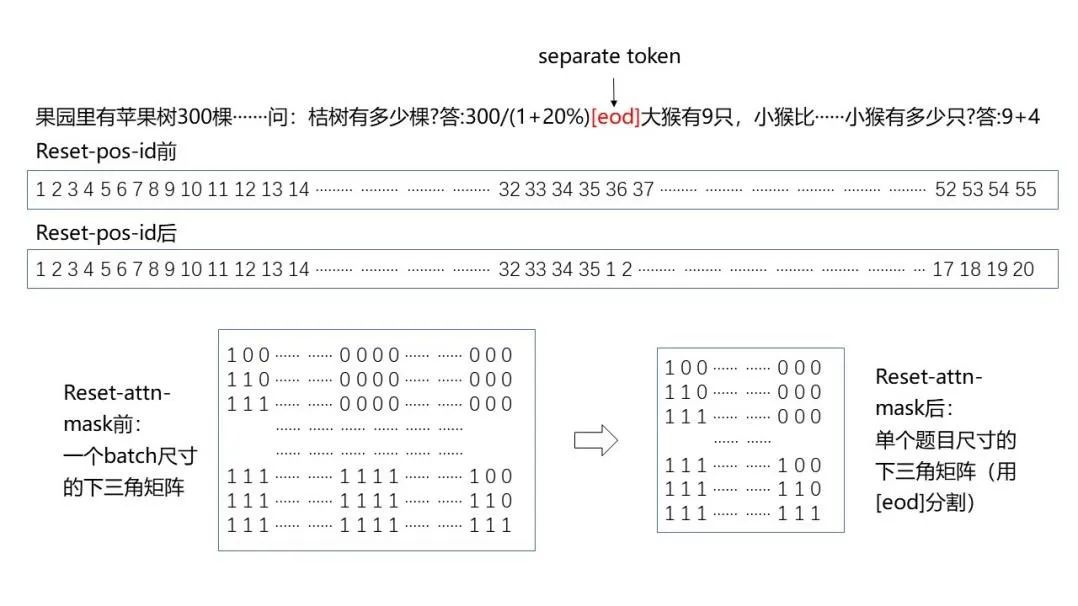

|Reset-position-id與reset-attention-mask設(shè)計

輸入到模型的一個batch中通常包含多道應(yīng)用題,且會出現(xiàn)截斷等問題。為避免不同題目和表達式之間相互影響,對模型進行reset-position-id和reset-attention-mask處理。圖3示意了reset前后的對比,采用了[eod]對不同題目之間做切割,在reset-pos-id之前,其位置編碼按照從左到右的順序排列;reset-pos-id之后,位置編碼按照單個題目進行順序排列。類似的,在reset-attn-mask之前,掩碼矩陣對應(yīng)的是batch尺寸的下三角矩陣;reset-attn-mask后,原先的掩碼矩陣被拆分成若干小的掩碼矩陣,每個小掩碼矩陣對應(yīng)單個題目尺寸的下三角矩陣。

圖3 reset-pos-id和reset-attn-mask前后對比(示意)

訓(xùn)練參數(shù)及結(jié)果

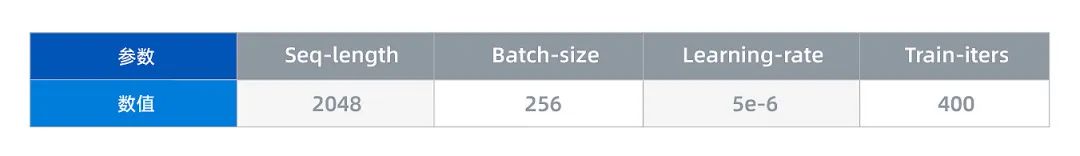

訓(xùn)練過程的主要參數(shù)設(shè)置如下。

表1 模型訓(xùn)練部分參數(shù)

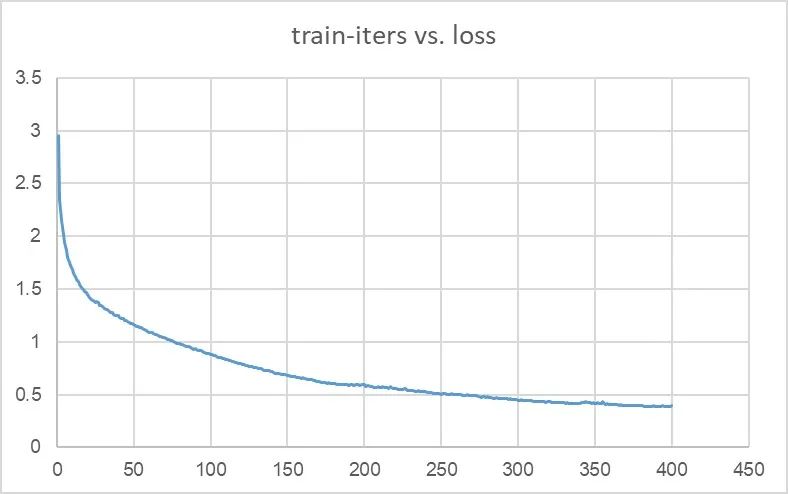

在訓(xùn)練了400個iteration后,模型的loss收斂至0.39(圖4)。

圖4 模型loss曲線

之后,在Math23K測試集上對所提方法的精度進行了測試,并與現(xiàn)有相關(guān)方法的結(jié)果進行對比(表2)。不難看出,與BERT、GPT-2以及CPM-2模型相比,所提方法下的“源1.0”大模型在Math23K任務(wù)上的精度最高。

表2 源1.0模型與BERT、GPT等在Math23K測試集上的對比

(相關(guān)結(jié)果見參考文獻[4])

總結(jié)與展望

為提升decoder結(jié)構(gòu)下的通用大模型在MWP任務(wù)上的精度,本文提出了一種目標導(dǎo)向的問答式prompt設(shè)計方法,該方法有利于引導(dǎo)模型建立問題與表達式之間的準確對應(yīng)關(guān)系;同時提出了一種相似啟發(fā)式數(shù)據(jù)增強方法,通過相似句召回的方式對數(shù)據(jù)集進行擴充,克服了原有數(shù)據(jù)集中題型分布不均勻的問題;此外,采用了重置位置編碼和掩碼矩陣的方法,解決了單個batch中的題目之間相互影響的問題。最后,在Math23K數(shù)據(jù)集上驗證了所提方法,結(jié)果證明了“源1.0”模型有很強的數(shù)學(xué)推理能力。

審核編輯:郭婷

-

浪潮

+關(guān)注

關(guān)注

1文章

458瀏覽量

23851 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24690

原文標題:浪潮“源”AI大模型如何求解數(shù)學(xué)應(yīng)用題

文章出處:【微信號:浪潮AIHPC,微信公眾號:浪潮AIHPC】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

阿里云開源推理大模型QwQ

Kimi發(fā)布新一代數(shù)學(xué)推理模型k0-math

高效大模型的推理綜述

NVIDIA助力麗蟾科技打造AI訓(xùn)練與推理加速解決方案

云加速服務(wù)在數(shù)據(jù)安全方面的潛在風險

工業(yè)智能網(wǎng)關(guān)在數(shù)據(jù)上云方面的作用、優(yōu)勢以及實施策略

阿里Qwen2-Math系列震撼發(fā)布,數(shù)學(xué)推理能力領(lǐng)跑全球

工業(yè)物聯(lián)網(wǎng)網(wǎng)關(guān)在數(shù)據(jù)融合與邊緣智能方面的作用

LLM大模型推理加速的關(guān)鍵技術(shù)

神經(jīng)網(wǎng)絡(luò)在數(shù)學(xué)建模中的應(yīng)用

智源研究院揭曉大模型測評結(jié)果,豆包與百川智能大模型表現(xiàn)優(yōu)異

【大語言模型:原理與工程實踐】大語言模型的評測

risc-v多核芯片在AI方面的應(yīng)用

深度探討VLMs距離視覺演繹推理還有多遠?

源1.0在數(shù)學(xué)推理任務(wù)方面的解決方案和表現(xiàn)

源1.0在數(shù)學(xué)推理任務(wù)方面的解決方案和表現(xiàn)

評論