本文簡要介紹發表在NeurIPS 2022上關于小樣本語義分割的論文《Intermediate Prototype Mining Transformer for Few-Shot Semantic Segmentation》。該論文針對現有研究中忽視查詢和支持圖像之間因類內多樣性而帶來的類別信息的差距,而強行將支持圖片的類別信息遷移到查詢圖片中帶來的分割效率低下的問題,引入了一個中間原型,用于從支持中挖掘確定性類別信息和從查詢中挖掘自適應類別知識,并因此設計了一個中間原型挖掘Transformer。文章在每一層中實現將支持和查詢特征中的類型信息到中間原型的傳播,然后利用該中間原型來激活查詢特征圖。借助Transformer迭代的特性,使得中間原型和查詢特征都可以逐步改進。相關代碼已開源在:

https://github.com/LIUYUANWEI98/IPMT

一、研究背景

目前在計算機視覺取得的巨大進展在很大程度上依賴于大量帶標注的數據,然而收集這些數據是一項耗時耗力的工作。為了解決這個問題,通過小樣本學習來學習一個模型,并將該模型可以推廣到只有少數標注圖像的新類別。這種設置也更接近人類的學習習慣,即可以從稀缺標注的示例中學習知識并快速識別新類別。

本文專注于小樣本學習在語義分割上的應用,即小樣本語義分割。該任務旨在用一些帶標注的支持樣本來分割查詢圖像中的目標物體。然而,目前的研究方法都嚴重依賴從支持集中提取的類別信息。盡管支持樣本能提供確定性的類別信息指導,但大家都忽略了查詢和支持樣本之間可能存在固有的類內多樣性。

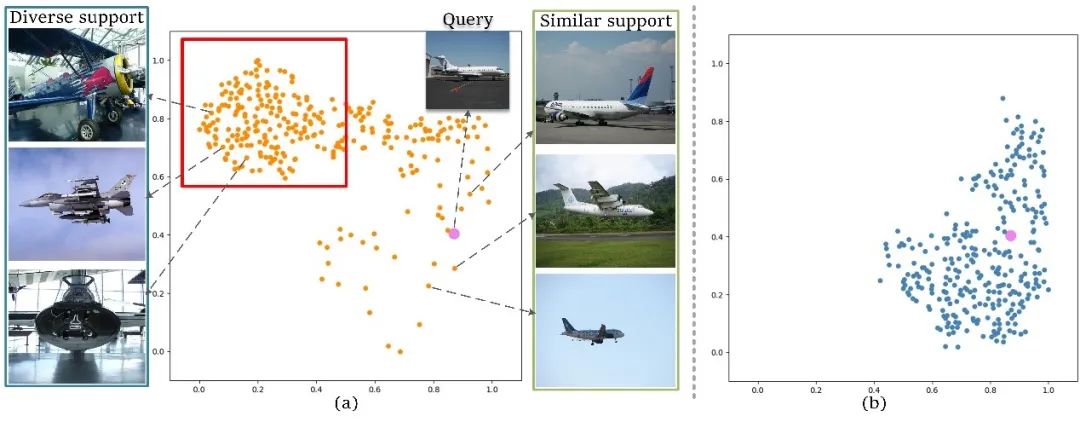

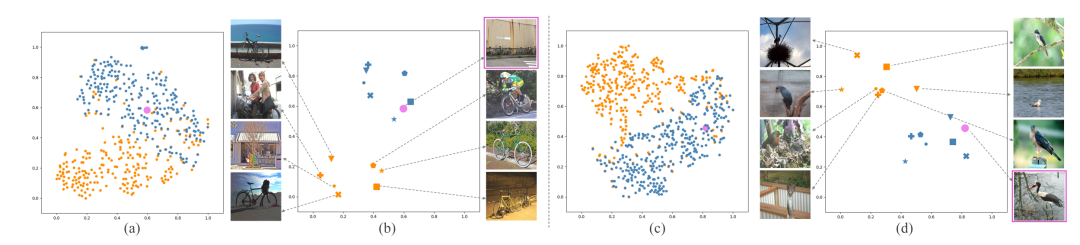

在圖1中,展示了一些支持樣本原型和查詢圖像原型的分布。從圖中可以觀察到,對于與查詢圖像相似的支持圖像(在右側標記為“相似支持圖像”),它們的原型在特征空間中與查詢原型接近,在這種情況下匹配網絡可以很好地工作。然而,對于與查詢相比在姿勢和外觀上具有較大差異的支持圖像(在左側標記為“多樣化支持圖像”),支持和查詢原型之間的距離會很遠。在這種情況下,如果將支持原型中的類別信息強行遷移到查詢中,則不可避免地會引入較大的類別信息偏差。

圖1 支持樣本原型與查詢圖像原型分布圖

因此,本文在通過引入一個中間原型來緩解這個問題,該原型可以通過作者提出的中間原型挖掘Transformer彌補查詢和支持圖像之間的類別信息差距。每層Transformer由兩個步驟組成,即中間原型挖掘和查詢激活。在中間原型挖掘中,通過結合來自支持圖像的確定性類別信息和來自查詢圖像的自適應類別知識來學習中間原型。然后,使用學習到的原型在查詢特征激活模塊中激活查詢特征圖。此外,中間原型挖掘Transformer以迭代方式使用,以逐步提高學習原型和激活查詢功能的質量。

二、方法原理簡述

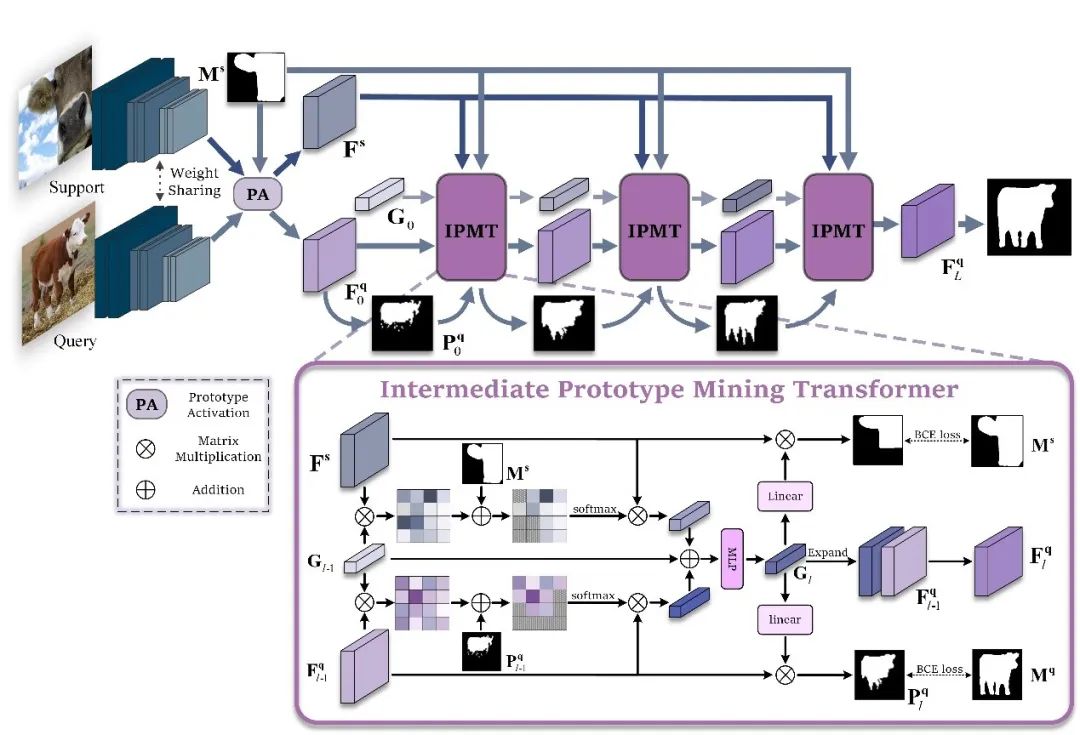

圖2 方法總框圖

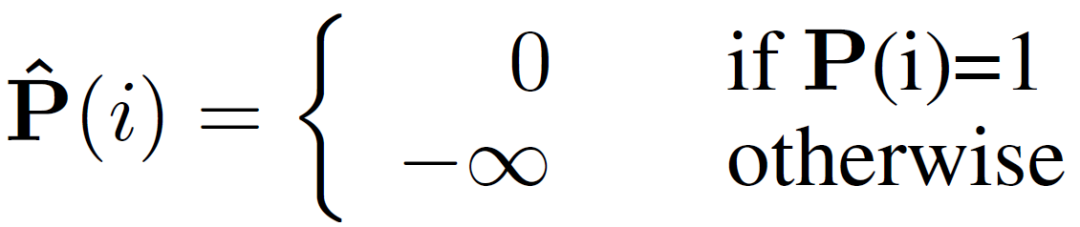

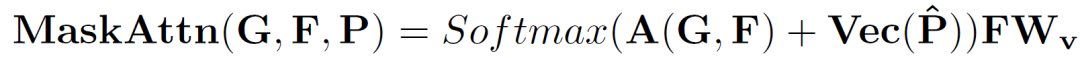

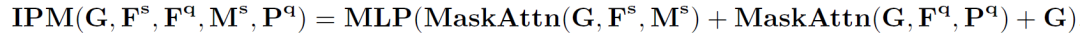

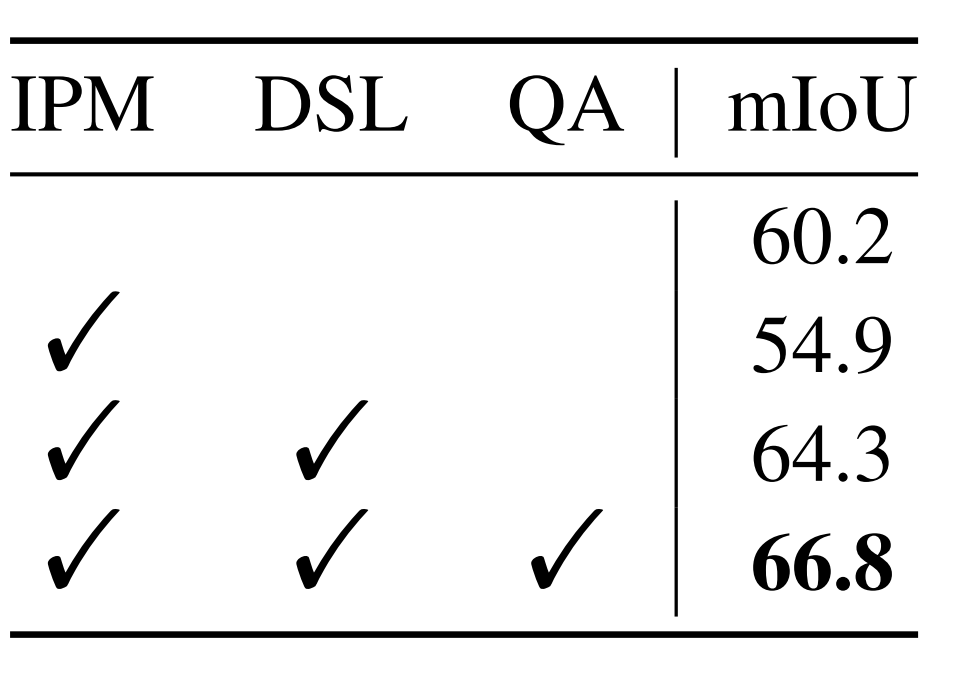

支持圖像和查詢圖像輸入到主干網絡分別提取除支持特征和查詢特征。查詢特征在原型激活(PA)模塊中經過簡單的利用支持圖像原型進行激活后,分割成一個初始預測掩碼,并將該掩碼和激活后的查詢特征作為中間原型挖掘Transformer層的一個輸入。同時,將支持特征、支持圖片掩碼和隨機初始化的一個中間原型也做為第一層中間原型挖掘Transformer的輸入。在中間原型挖掘Transformer層中,首先進行掩碼注意力操作。具體來說,計算中間原型與查詢或支持特征之間的相似度矩陣,并利用下式僅保留前景區域的特征相似度矩陣:

處理后的相似度矩陣作為權重,分別捕獲查詢或支持特征中的類別信息并形成新的原型。

查詢特征新原型、支持特征新原型和原中間原型結合在一起形成新的中間原型,完成對中間原型的挖掘。

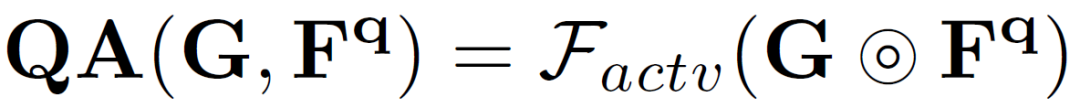

而后,新的中間原型在查詢特征激活模塊中對查詢特征中的類別目標予以激活。

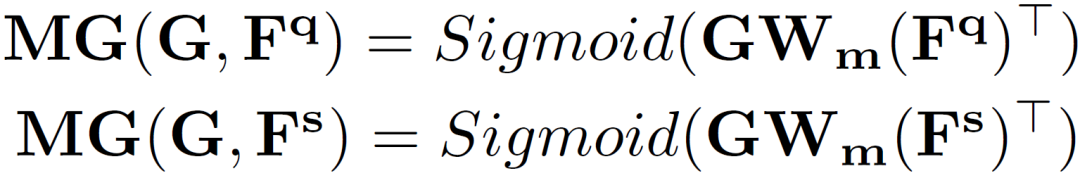

為了便于學習中間原型中的自適應類別信息,作者使用它在支持和查詢圖像上生成兩個分割掩碼,并計算兩個分割損失。

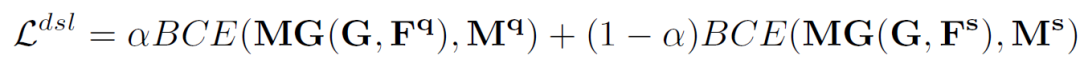

并設計雙工分割損失(DSL):

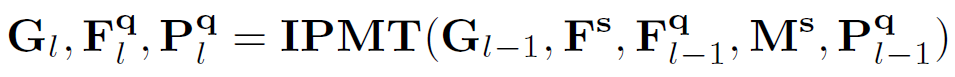

由于一個中間原型挖掘Transformer層可以更新中間原型、查詢特征圖和查詢分割掩碼,因此,作者通過迭代執行這個過程,得到越來越好的中間原型和查詢特征,最終使分割結果得到有效提升。假設有L 層,那么對于每一層有:

上式中具體過程又可以分解為以下環節:

三、實驗結果及可視化

圖3 作者提出方法的結果的可視化與比較

在圖3中,作者可視化了文章中方法和僅使用支持圖像的小樣本語義分割方法[1]的一些預測結果。可以看出,與第 2 行中僅使用支持信息的結果相比,第3行中的結果展現出作者的方法可以有效地緩解由固有的類內多樣性引起的分割錯誤。

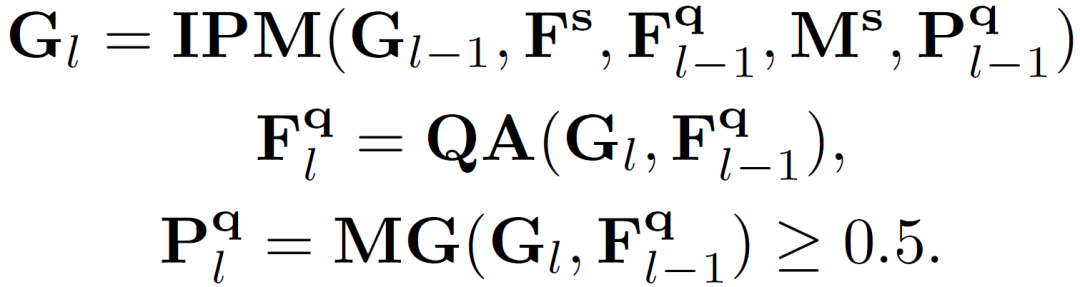

表4 與先前工作在PASCAL-5i[2]數據集上的效果比較

從表4中可以發現,作者的方法大大超過了所有其他方法,并取得了新的最先進的結果。在使用 ResNet-50 作為主干網絡時, 在 1-shot 設置下與之前的最佳結果相比,作者將 mIoU 得分提高了 2.6。此外,在使用 ResNet-101作為主干網絡時,作者方法實現了 1.8 mIoU(1-shot)和 2.2 mIoU(5-shot )的提升。

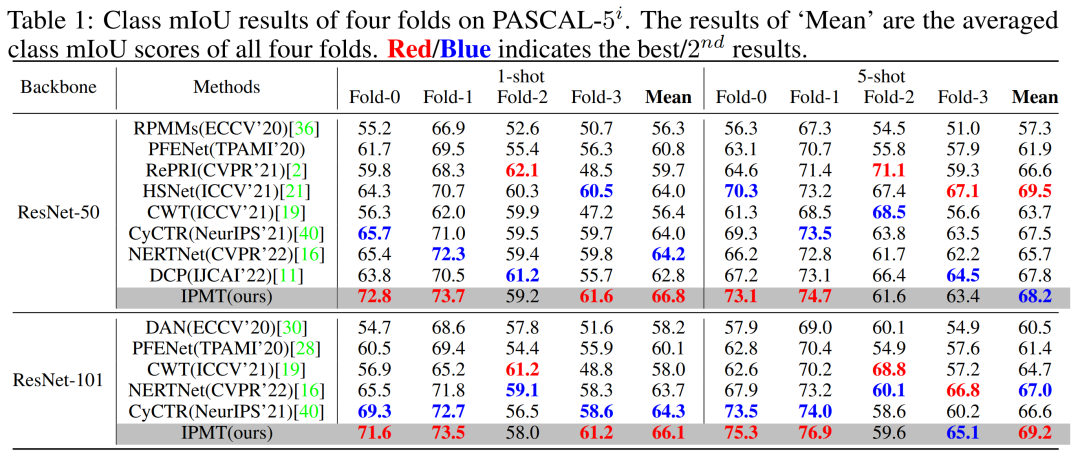

表5 各模塊消融實驗

表5中指出,當僅使用 IPM 會導致 5.3 mIoU 的性能下降。然而,當添加 DSL 時,模型的性能在baseline上實現了 4.1 mIoU 的提升。作者認為這種現象是合理的,因為無法保證 IPM 中的可學習原型將在沒有 DSL 的情況下學習中間類別知識。同時,使用 QA 激活查詢特征圖可以進一步將模型性能提高 2.5 mIoU。這些結果清楚地驗證了作者提出的 QA 和 DSL 的有效性。

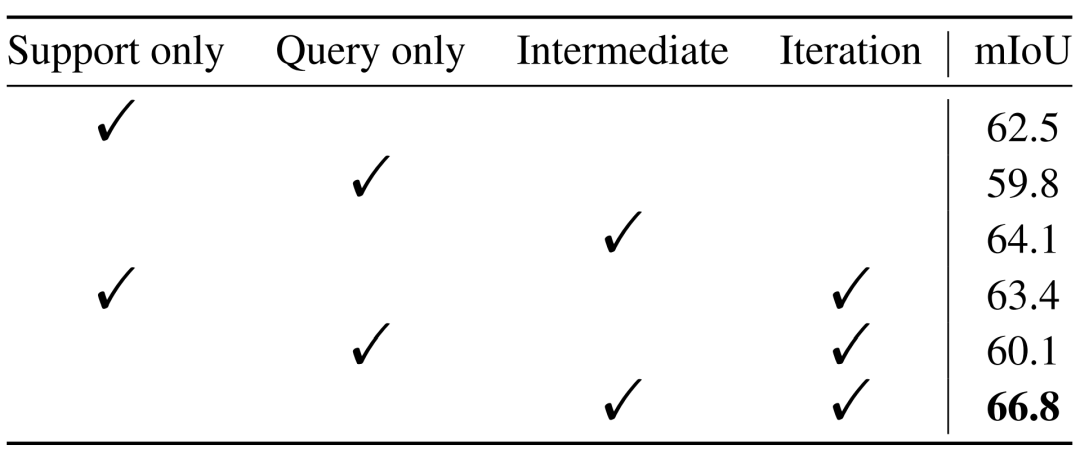

表6 中間原型Transformer有效性的消融研究

在表6中,作者對比了僅使用support或者query提供類別信息時,和是否使用迭代方式提取信息時的模型的性能情況。可以看出,借助中間原型以迭代的方式從support和query中都獲取類型信息所取得的效果更為出色,也驗證了作者提出方法的有效性。

圖7 支持原型和中間原型分別的可視化比較

如圖7所示,作者將原本的支持原型可視化為橘色,學習到的中間原型可視化為藍色,查詢圖像原型可視化為粉色。可以看到,在特征空間中,中間原型比支持原型更接近查詢原型,因此驗證了作者的方法有效地緩解了類內多樣性問題并彌補了查詢和支持圖像之間的類別信息差距。

四、總結及結論

在文章中,作者關注到查詢和支持之間的類內多樣性,并引入中間原型來彌補它們之間的類別信息差距。核心思想是通過設計的中間原型挖掘Transformer并采取迭代的方式使用中間原型來聚合來自于支持圖像的確定性類型信息和查詢圖像的自適應的類別信息。令人驚訝的是,盡管它很簡單,但作者的方法在兩個小樣本語義分割基準數據集上大大優于以前的最新結果。為此,作者希望這項工作能夠激發未來的研究能夠更多地關注小樣本語義分割的類內多樣性問題。

審核編輯 :李倩

-

模塊

+關注

關注

7文章

2696瀏覽量

47438 -

圖像

+關注

關注

2文章

1084瀏覽量

40455 -

計算機視覺

+關注

關注

8文章

1698瀏覽量

45982

原文標題:?NeurIPS 2022 | IPMT:用于小樣本語義分割的中間原型挖掘Transformer

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

手冊上新 |迅為RK3568開發板NPU例程測試

語義分割25種損失函數綜述和展望

手冊上新 |迅為RK3568開發板NPU例程測試

圖像語義分割的實用性是什么

圖像分割和語義分割的區別與聯系

迅為RK3568手冊上新 | RK3568開發板NPU例程測試

Transformer語言模型簡介與實現過程

圖像分割與語義分割中的CNN模型綜述

中間繼電器主要用于信號傳遞和放大的原因

中間繼電器的型號怎么表示

【大語言模型:原理與工程實踐】大語言模型的基礎技術

助力移動機器人下游任務!Mobile-Seed用于聯合語義分割和邊界檢測

基于Transformer的多模態BEV融合方案

IPMT:用于小樣本語義分割的中間原型挖掘Transformer

IPMT:用于小樣本語義分割的中間原型挖掘Transformer

評論