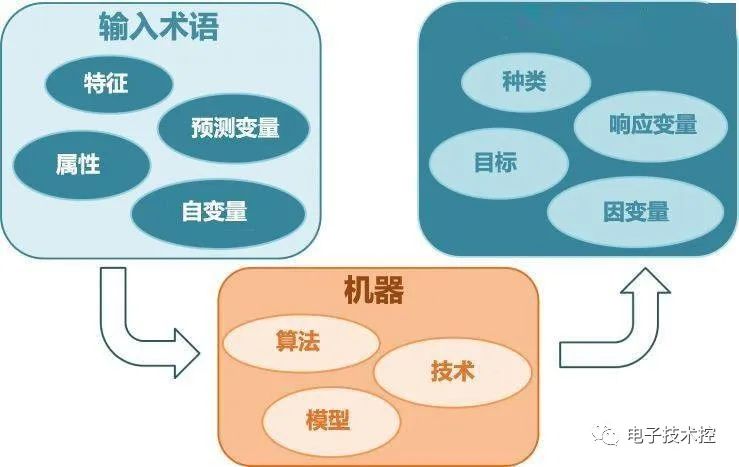

根據數據類型的不同,對一個問題的建模有不同的方式。在機器學習或者人工智能領域,人們首先會考慮算法的學習方式。在機器學習領域,有幾種主要的學習方式。將算法按照學習方式分類是一個不錯的想法,這樣可以讓人們在建模和算法選擇的時候考慮能根據輸入數據來選擇最合適的算法來獲得最好的結果。

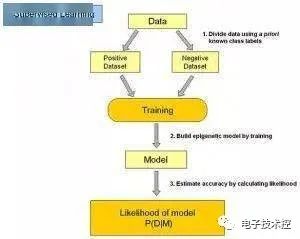

1. 監督式學習:

在監督式學習下,輸入數據被稱為“訓練數據”,每組訓練數據有一個明確的標識或結果,如對防垃圾郵件系統中“垃圾郵件”“非垃圾郵件”,對手寫數字識別中的“1“,”2“,”3“,”4“等。在建立預測模型的時候,監督式學習建立一個學習過程,將預測結果與“訓練數據”的實際結果進行比較,不斷的調整預測模型,直到模型的預測結果達到一個預期的準確率。監督式學習的常見應用場景如分類問題和回歸問題。常見算法有邏輯回歸(Logistic Regression)和反向傳遞神經網絡(Back Propagation Neural Network) 2. 非監督式學習:

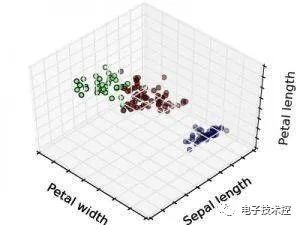

在非監督式學習中,數據并不被特別標識,學習模型是為了推斷出數據的一些內在結構。常見的應用場景包括關聯規則的學習以及聚類等。常見算法包括Apriori算法以及k-Means算法。 3. 半監督式學習:

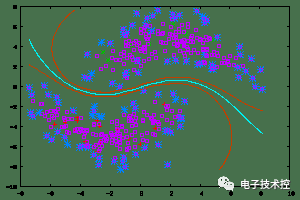

在此學習方式下,輸入數據部分被標識,部分沒有被標識,這種學習模型可以用來進行預測,但是模型首先需要學習數據的內在結構以便合理的組織數據來進行預測。應用場景包括分類和回歸,算法包括一些對常用監督式學習算法的延伸,這些算法首先試圖對未標識數據進行建模,在此基礎上再對標識的數據進行預測。如圖論推理算法(Graph Inference)或者拉普拉斯支持向量機(Laplacian SVM.)等。 4. 強化學習:

在這種學習模式下,輸入數據作為對模型的反饋,不像監督模型那樣,輸入數據僅僅是作為一個檢查模型對錯的方式,在強化學習下,輸入數據直接反饋到模型,模型必須對此立刻作出調整。常見的應用場景包括動態系統以及機器人控制等。常見算法包括Q-Learning以及時間差學習(Temporal difference learning) 在企業數據應用的場景下, 人們最常用的可能就是監督式學習和非監督式學習的模型。在圖像識別等領域,由于存在大量的非標識的數據和少量的可標識數據, 目前半監督式學習是一個很熱的話題。而強化學習更多的應用在機器人控制及其他需要進行系統控制的領域。 5. 算法類似性 根據算法的功能和形式的類似性,我們可以把算法分類,比如說基于樹的算法,基于神經網絡的算法等等。當然,機器學習的范圍非常龐大,有些算法很難明確歸類到某一類。而對于有些分類來說,同一分類的算法可以針對不同類型的問題。這里,我們盡量把常用的算法按照最容易理解的方式進行分類。 6. 回歸算法:

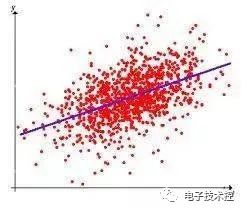

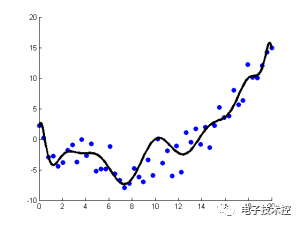

回歸算法是試圖采用對誤差的衡量來探索變量之間的關系的一類算法。回歸算法是統計機器學習的利器。在機器學習領域,人們說起回歸,有時候是指一類問題,有時候是指一類算法,這一點常常會使初學者有所困惑。常見的回歸算法包括:最小二乘法(Ordinary Least Square),邏輯回歸(Logistic Regression),逐步式回歸(Stepwise Regression),多元自適應回歸樣條(Multivariate Adaptive Regression Splines)以及本地散點平滑估計(Locally Estimated Scatterplot Smoothing) 7. 基于實例的算法

基于實例的算法常常用來對決策問題建立模型,這樣的模型常常先選取一批樣本數據,然后根據某些近似性把新數據與樣本數據進行比較。通過這種方式來尋找最佳的匹配。因此,基于實例的算法常常也被稱為“贏家通吃”學習或者“基于記憶的學習”。常見的算法包括 k-Nearest Neighbor(KNN), 學習矢量量化(Learning Vector Quantization, LVQ),以及自組織映射算法(Self-Organizing Map , SOM) 8. 正則化方法

正則化方法是其他算法(通常是回歸算法)的延伸,根據算法的復雜度對算法進行調整。正則化方法通常對簡單模型予以獎勵而對復雜算法予以懲罰。常見的算法包括:Ridge Regression,Least Absolute Shrinkage and Selection Operator(LASSO),以及彈性網絡(Elastic Net)。 9. 決策樹學習

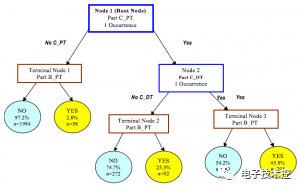

決策樹算法根據數據的屬性采用樹狀結構建立決策模型, 決策樹模型常常用來解決分類和回歸問題。常見的算法包括:分類及回歸樹(Classification And Regression Tree, CART), ID3 (Iterative Dichotomiser 3), C4.5, Chi-squared Automatic Interaction Detection(CHAID), Decision Stump, 隨機森林(Random Forest), 多元自適應回歸樣條(MARS)以及梯度推進機(Gradient Boosting Machine, GBM) 10. 貝葉斯方法

貝葉斯方法算法是基于貝葉斯定理的一類算法,主要用來解決分類和回歸問題。常見算法包括:樸素貝葉斯算法,平均單依賴估計(Averaged One-Dependence Estimators, AODE),以及Bayesian Belief Network(BBN)。 11. 基于核的算法

基于核的算法中最著名的莫過于支持向量機(SVM)了。基于核的算法把輸入數據映射到一個高階的向量空間, 在這些高階向量空間里, 有些分類或者回歸問題能夠更容易的解決。常見的基于核的算法包括:支持向量機(Support Vector Machine, SVM), 徑向基函數(Radial Basis Function ,RBF), 以及線性判別分析(Linear Discriminate Analysis ,LDA)等 12.聚類算法

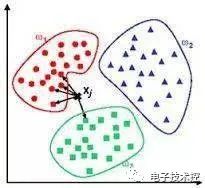

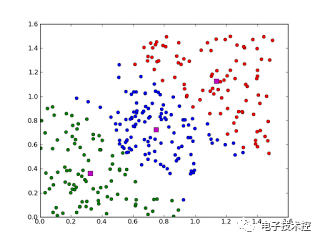

聚類,就像回歸一樣,有時候人們描述的是一類問題,有時候描述的是一類算法。聚類算法通常按照中心點或者分層的方式對輸入數據進行歸并。所以的聚類算法都試圖找到數據的內在結構,以便按照最大的共同點將數據進行歸類。常見的聚類算法包括 k-Means算法以及期望最大化算法(Expectation Maximization, EM)。 13. 關聯規則學習

關聯規則學習通過尋找最能夠解釋數據變量之間關系的規則,來找出大量多元數據集中有用的關聯規則。常見算法包括 Apriori算法和Eclat算法等。 14. 人工神經網絡

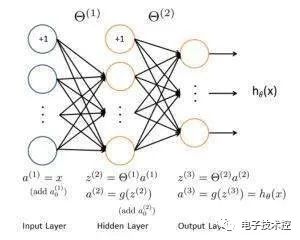

人工神經網絡算法模擬生物神經網絡,是一類模式匹配算法。通常用于解決分類和回歸問題。人工神經網絡是機器學習的一個龐大的分支,有幾百種不同的算法。(其中深度學習就是其中的一類算法,我們會單獨討論),重要的人工神經網絡算法包括:感知器神經網絡(Perceptron Neural Network), 反向傳遞(Back Propagation), Hopfield網絡,自組織映射(Self-Organizing Map, SOM)。學習矢量量化(Learning Vector Quantization, LVQ) 15. 深度學習

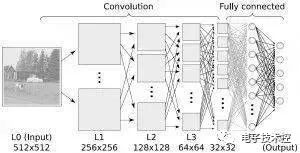

深度學習算法是對人工神經網絡的發展。在近期贏得了很多關注, 特別是百度也開始發力深度學習后, 更是在國內引起了很多關注。在計算能力變得日益廉價的今天,深度學習試圖建立大得多也復雜得多的神經網絡。很多深度學習的算法是半監督式學習算法,用來處理存在少量未標識數據的大數據集。常見的深度學習算法包括:受限波爾茲曼機(Restricted Boltzmann Machine, RBN), Deep Belief Networks(DBN),卷積網絡(Convolutional Network), 堆棧式自動編碼器(Stacked Auto-encoders)。 16. 降低維度算法

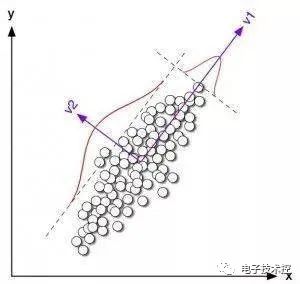

像聚類算法一樣,降低維度算法試圖分析數據的內在結構,不過降低維度算法是以非監督學習的方式試圖利用較少的信息來歸納或者解釋數據。這類算法可以用于高維數據的可視化或者用來簡化數據以便監督式學習使用。 常見的算法包括:主成份分析(Principle Component Analysis, PCA),偏最小二乘回歸(Partial Least Square Regression,PLS), Sammon映射,多維尺度(Multi-Dimensional Scaling, MDS), 投影追蹤(Projection Pursuit)等。 17. 集成算法:

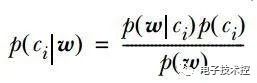

集成算法用一些相對較弱的學習模型獨立地就同樣的樣本進行訓練,然后把結果整合起來進行整體預測。集成算法的主要難點在于究竟集成哪些獨立的較弱的學習模型以及如何把學習結果整合起來。 這是一類非常強大的算法,同時也非常流行。常見的算法包括:Boosting, Bootstrapped Aggregation(Bagging), AdaBoost,堆疊泛化(Stacked Generalization, Blending),梯度推進機(Gradient Boosting Machine, GBM),隨機森林(Random Forest)。 常見機器學習算法優缺點: 樸素貝葉斯: 1. 如果給出的特征向量長度可能不同,這是需要歸一化為通長度的向量(這里以文本分類為例),比如說是句子單詞的話,則長度為整個詞匯量的長度,對應位置是該單詞出現的次數。 2. 計算公式如下:

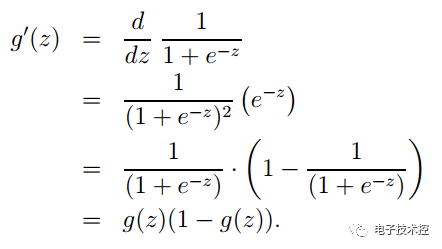

其中一項條件概率可以通過樸素貝葉斯條件獨立展開。要注意一點就是的計算方法,而由樸素貝葉斯的前提假設可知,=,因此一般有兩種,一種是在類別為ci的那些樣本集中,找到wj出現次數的總和,然后除以該樣本的總和;第二種方法是類別為ci的那些樣本集中,找到wj出現次數的總和,然后除以該樣本中所有特征出現次數的總和。 3. 如果中的某一項為0,則其聯合概率的乘積也可能為0,即2中公式的分子為0,為了避免這種現象出現,一般情況下會將這一項初始化為1,當然為了保證概率相等,分母應對應初始化為2(這里因為是2類,所以加2,如果是k類就需要加k,術語上叫做laplace光滑, 分母加k的原因是使之滿足全概率公式)。 樸素貝葉斯的優點:對小規模的數據表現很好,適合多分類任務,適合增量式訓練。 缺點:對輸入數據的表達形式很敏感。 決策樹:決策樹中很重要的一點就是選擇一個屬性進行分枝,因此要注意一下信息增益的計算公式,并深入理解它。 信息熵的計算公式如下: 其中的n代表有n個分類類別(比如假設是2類問題,那么n=2)。分別計算這2類樣本在總樣本中出現的概率p1和p2,這樣就可以計算出未選中屬性分枝前的信息熵。 現在選中一個屬性xi用來進行分枝,此時分枝規則是:如果xi=vx的話,將樣本分到樹的一個分支;如果不相等則進入另一個分支。很顯然,分支中的樣本很有可能包括2個類別,分別計算這2個分支的熵H1和H2,計算出分枝后的總信息熵H’=p1*H1+p2*H2.,則此時的信息增益ΔH=H-H’。以信息增益為原則,把所有的屬性都測試一邊,選擇一個使增益最大的屬性作為本次分枝屬性。 決策樹的優點:計算量簡單,可解釋性強,比較適合處理有缺失屬性值的樣本,能夠處理不相關的特征; 缺點:容易過擬合(后續出現了隨機森林,減小了過擬合現象)。 Logistic回歸:Logistic是用來分類的,是一種線性分類器,需要注意的地方有: 1. logistic函數表達式為: 其導數形式為:

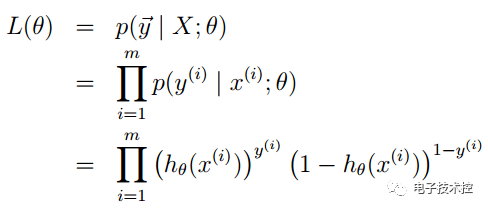

2. logsitc回歸方法主要是用最大似然估計來學習的,所以單個樣本的后驗概率為: 到整個樣本的后驗概率:

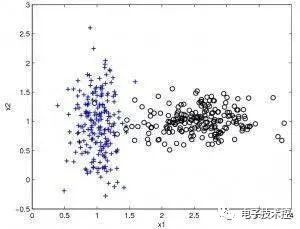

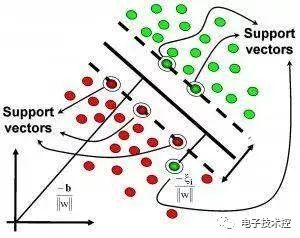

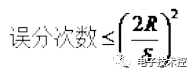

其中: 通過對數進一步化簡為: 3. 其實它的loss function為-l(θ),因此我們需使loss function最小,可采用梯度下降法得到。梯度下降法公式為: Logistic回歸優點: 1. 實現簡單 2. 分類時計算量非常小,速度很快,存儲資源低; 缺點: 1. 容易欠擬合,一般準確度不太高 2. 只能處理兩分類問題(在此基礎上衍生出來的softmax可以用于多分類),且必須線性可分; 線性回歸: 線性回歸才是真正用于回歸的,而不像logistic回歸是用于分類,其基本思想是用梯度下降法對最小二乘法形式的誤差函數進行優化,當然也可以用normal equation直接求得參數的解,結果為: 而在LWLR(局部加權線性回歸)中,參數的計算表達式為: 因為此時優化的是: 由此可見LWLR與LR不同,LWLR是一個非參數模型,因為每次進行回歸計算都要遍歷訓練樣本至少一次。 線性回歸優點:實現簡單,計算簡單; 缺點:不能擬合非線性數據; KNN算法:KNN即最近鄰算法,其主要過程為: 1. 計算訓練樣本和測試樣本中每個樣本點的距離(常見的距離度量有歐式距離,馬氏距離等); 2. 對上面所有的距離值進行排序; 3. 選前k個最小距離的樣本; 4. 根據這k個樣本的標簽進行投票,得到最后的分類類別; 如何選擇一個最佳的K值,這取決于數據。一般情況下,在分類時較大的K值能夠減小噪聲的影響。但會使類別之間的界限變得模糊。一個較好的K值可通過各種啟發式技術來獲取,比如,交叉驗證。另外噪聲和非相關性特征向量的存在會使K近鄰算法的準確性減小。 近鄰算法具有較強的一致性結果。隨著數據趨于無限,算法保證錯誤率不會超過貝葉斯算法錯誤率的兩倍。對于一些好的K值,K近鄰保證錯誤率不會超過貝葉斯理論誤差率。 注:馬氏距離一定要先給出樣本集的統計性質,比如均值向量,協方差矩陣等。關于馬氏距離的介紹如下: KNN算法的優點: 1. 思想簡單,理論成熟,既可以用來做分類也可以用來做回歸; 2. 可用于非線性分類; 3. 訓練時間復雜度為O(n); 4. 準確度高,對數據沒有假設,對outlier不敏感; 缺點: 1. 計算量大; 2. 樣本不平衡問題(即有些類別的樣本數量很多,而其它樣本的數量很少); 3. 需要大量的內存; SVM: 要學會如何使用libsvm以及一些參數的調節經驗,另外需要理清楚svm算法的一些思路: 1. svm中的最優分類面是對所有樣本的幾何裕量最大(為什么要選擇最大間隔分類器,請從數學角度上說明?網易深度學習崗位面試過程中有被問到。答案就是幾何間隔與樣本的誤分次數間存在關系:

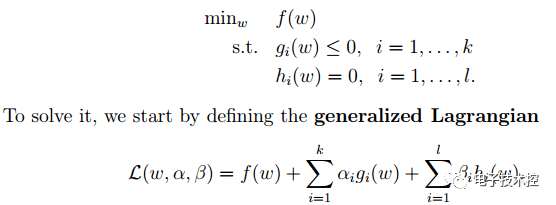

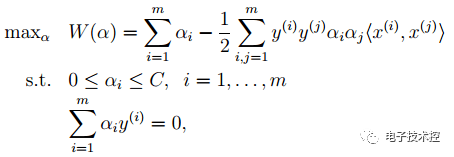

,其中的分母就是樣本到分類間隔距離,分子中的R是所有樣本中的最長向量值),即: 經過一系列推導可得為優化下面原始目標: 2. 下面來看看拉格朗日理論:

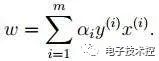

可以將1中的優化目標轉換為拉格朗日的形式(通過各種對偶優化,KKD條件),最后目標函數為: 我們只需要最小化上述目標函數,其中的α為原始優化問題中的不等式約束拉格朗日系數。 3. 對2中最后的式子分別w和b求導可得:

由上面第1式子可以知道,如果我們優化出了α,則直接可以求出w了,即模型的參數搞定。而上面第2個式子可以作為后續優化的一個約束條件。 4. 對2中最后一個目標函數用對偶優化理論可以轉換為優化下面的目標函數:

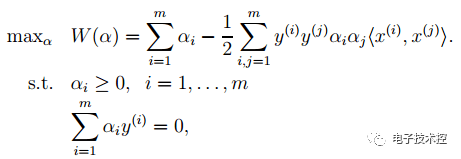

而這個函數可以用常用的優化方法求得α,進而求得w和b。 5. 按照道理,svm簡單理論應該到此結束。不過還是要補充一點,即在預測時有:

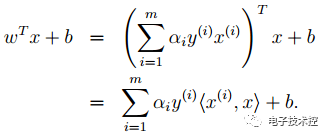

那個尖括號我們可以用核函數代替,這也是svm經常和核函數扯在一起的原因。 6. 最后是關于松弛變量的引入,因此原始的目標優化公式為: 此時對應的對偶優化公式為:

與前面的相比只是α多了個上界。 SVM算法優點: 1. 可用于線性/非線性分類,也可以用于回歸; 2. 低泛化誤差; 3. 容易解釋; 4. 計算復雜度較低; 缺點: 1. 對參數和核函數的選擇比較敏感; 2. 原始的SVM只比較擅長處理二分類問題; Boosting: 主要以Adaboost為例,首先來看看Adaboost的流程圖,如下:

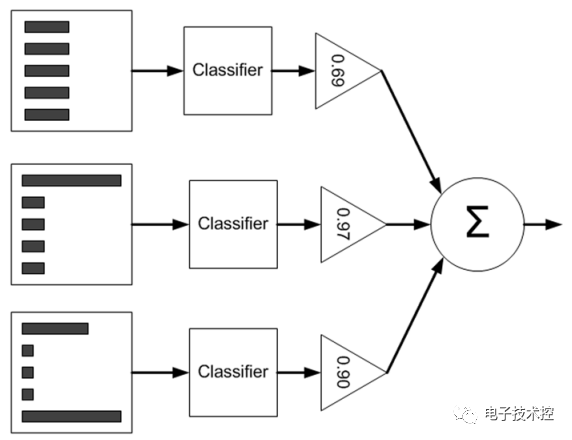

從圖中可以看到,在訓練過程中我們需要訓練出多個弱分類器(圖中為3個),每個弱分類器是由不同權重的樣本(圖中為5個訓練樣本)訓練得到(其中第一個弱分類器對應輸入樣本的權值是一樣的),而每個弱分類器對最終分類結果的作用也不同,是通過加權平均輸出的,權值見上圖中三角形里面的數值。那么這些弱分類器和其對應的權值是怎樣訓練出來的呢? 下面通過一個例子來簡單說明,假設的是5個訓練樣本,每個訓練樣本的維度為2,在訓練第一個分類器時5個樣本的權重各為0.2. 注意這里樣本的權值和最終訓練的弱分類器組對應的權值α是不同的,樣本的權重只在訓練過程中用到,而α在訓練過程和測試過程都有用到。 現在假設弱分類器是帶一個節點的簡單決策樹,該決策樹會選擇2個屬性(假設只有2個屬性)的一個,然后計算出這個屬性中的最佳值用來分類。 Adaboost的簡單版本訓練過程如下: 1. 訓練第一個分類器,樣本的權值D為相同的均值。通過一個弱分類器,得到這5個樣本(請對應書中的例子來看,依舊是machine learning in action)的分類預測標簽。與給出的樣本真實標簽對比,就可能出現誤差(即錯誤)。如果某個樣本預測錯誤,則它對應的錯誤值為該樣本的權重,如果分類正確,則錯誤值為0. 最后累加5個樣本的錯誤率之和,記為ε。 2. 通過ε來計算該弱分類器的權重α,公式如下:

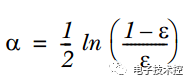

3. 通過α來計算訓練下一個弱分類器樣本的權重D,如果對應樣本分類正確,則減小該樣本的權重,公式為:

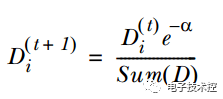

如果樣本分類錯誤,則增加該樣本的權重,公式為:

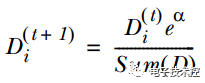

4. 循環步驟1,2,3來繼續訓練多個分類器,只是其D值不同而已。 測試過程如下: 輸入一個樣本到訓練好的每個弱分類中,則每個弱分類都對應一個輸出標簽,然后該標簽乘以對應的α,最后求和得到值的符號即為預測標簽值。 Boosting算法的優點: 1. 低泛化誤差; 2. 容易實現,分類準確率較高,沒有太多參數可以調; 3. 缺點: 4. 對outlier比較敏感; 聚類: 根據聚類思想劃分: 1. 基于劃分的聚類: K-means, k-medoids(每一個類別中找一個樣本點來代表),CLARANS. k-means是使下面的表達式值最小:

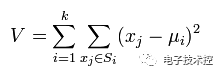

k-means算法的優點: (1)k-means算法是解決聚類問題的一種經典算法,算法簡單、快速。 (2)對處理大數據集,該算法是相對可伸縮的和高效率的,因為它的復雜度大約是O(nkt),其中n是所有對象的數目,k是簇的數目,t是迭代的次數。通常k<

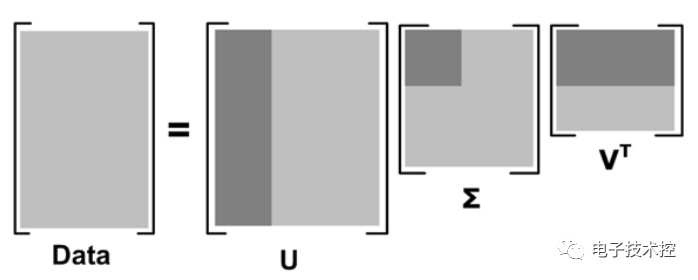

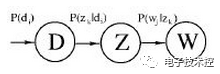

其中更深的顏色代表去掉小特征值重構時的三個矩陣。 果m代表商品的個數,n代表用戶的個數,則U矩陣的每一行代表商品的屬性,現在通過降維U矩陣(取深色部分)后,每一個商品的屬性可以用更低的維度表示(假設為k維)。這樣當新來一個用戶的商品推薦向量X,則可以根據公式X'*U1*inv(S1)得到一個k維的向量,然后在V’中尋找最相似的那一個用戶(相似度測量可用余弦公式等),根據這個用戶的評分來推薦(主要是推薦新用戶未打分的那些商品)。 pLSA:由LSA發展過來,而早期LSA的實現主要是通過SVD分解。pLSA的模型圖如下

公式中的意義如下:

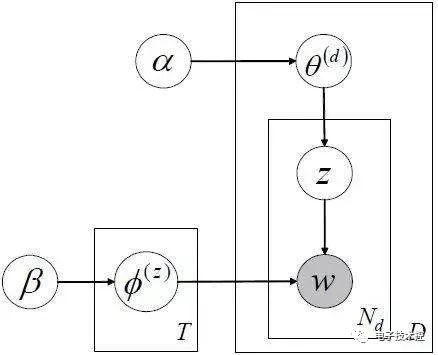

LDA主題模型,概率圖如下:

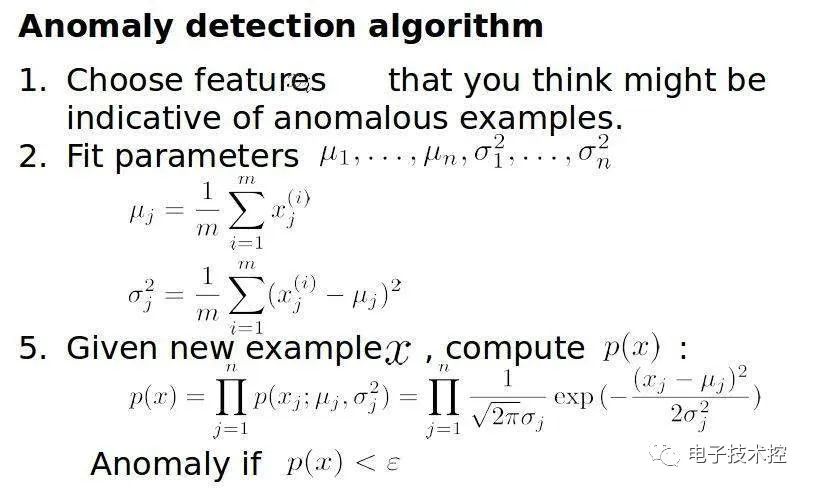

和pLSA不同的是LDA中假設了很多先驗分布,且一般參數的先驗分布都假設為Dirichlet分布,其原因是共軛分布時先驗概率和后驗概率的形式相同。 GDBT:GBDT(Gradient Boosting Decision Tree) 又叫 MART(Multiple Additive Regression Tree),好像在阿里內部用得比較多(所以阿里算法崗位面試時可能會問到),它是一種迭代的決策樹算法,該算法由多棵決策樹組成,所有樹的輸出結果累加起來就是最終答案。 它在被提出之初就和SVM一起被認為是泛化能力(generalization)較強的算法。近些年更因為被用于搜索排序的機器學習模型而引起大家關注。 GBDT是回歸樹,不是分類樹。其核心就在于,每一棵樹是從之前所有樹的殘差中來學習的。為了防止過擬合,和Adaboosting一樣,也加入了boosting這一項。 Regularization作用是 1. 數值上更容易求解; 2. 特征數目太大時更穩定; 3. 控制模型的復雜度,光滑性。復雜性越小且越光滑的目標函數泛化能力越強。而加入規則項能使目標函數復雜度減小,且更光滑。 4. 減小參數空間;參數空間越小,復雜度越低。 5. 系數越小,模型越簡單,而模型越簡單則泛化能力越強(Ng宏觀上給出的解釋)。 6. 可以看成是權值的高斯先驗。 異常檢測:可以估計樣本的密度函數,對于新樣本直接計算其密度,如果密度值小于某一閾值,則表示該樣本異常。而密度函數一般采用多維的高斯分布。 如果樣本有n維,則每一維的特征都可以看作是符合高斯分布的,即使這些特征可視化出來不太符合高斯分布,也可以對該特征進行數學轉換讓其看起來像高斯分布,比如說x=log(x+c), x=x^(1/c)等。異常檢測的算法流程如下:

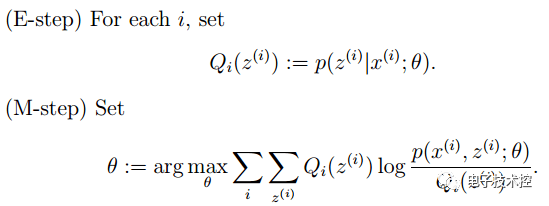

其中的ε也是通過交叉驗證得到的,也就是說在進行異常檢測時,前面的p(x)的學習是用的無監督,后面的參數ε學習是用的有監督。那么為什么不全部使用普通有監督的方法來學習呢(即把它看做是一個普通的二分類問題)? 主要是因為在異常檢測中,異常的樣本數量非常少而正常樣本數量非常多,因此不足以學習到好的異常行為模型的參數,因為后面新來的異常樣本可能完全是與訓練樣本中的模式不同。 EM算法:有時候因為樣本的產生和隱含變量有關(隱含變量是不能觀察的),而求模型的參數時一般采用最大似然估計,由于含有了隱含變量,所以對似然函數參數求導是求不出來的,這時可以采用EM算法來求模型的參數的(對應模型參數個數可能有多個), EM算法一般分為2步: E步:選取一組參數,求出在該參數下隱含變量的條件概率值; M步:結合E步求出的隱含變量條件概率,求出似然函數下界函數(本質上是某個期望函數)的最大值。 重復上面2步直至收斂,公式如下所示:

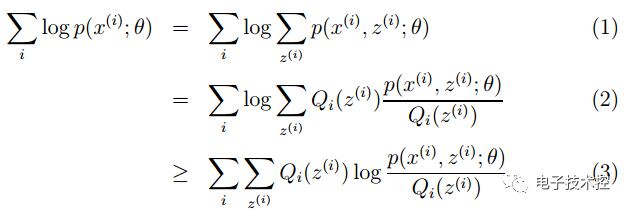

M步公式中下界函數的推導過程:

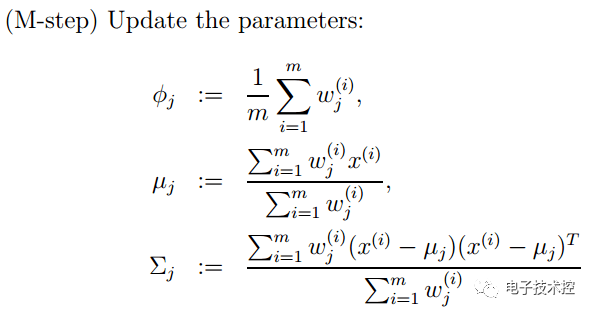

EM算法一個常見的例子就是GMM模型,每個樣本都有可能由k個高斯產生,只不過由每個高斯產生的概率不同而已,因此每個樣本都有對應的高斯分布(k個中的某一個),此時的隱含變量就是每個樣本對應的某個高斯分布。 GMM的E步公式如下(計算每個樣本對應每個高斯的概率): 更具體的計算公式為: M步公式如下(計算每個高斯的比重,均值,方差這3個參數):

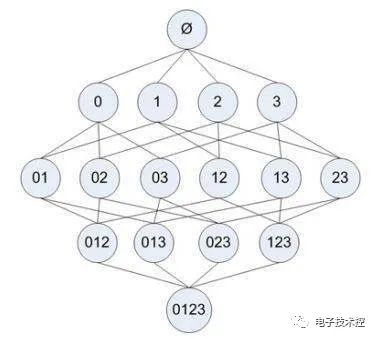

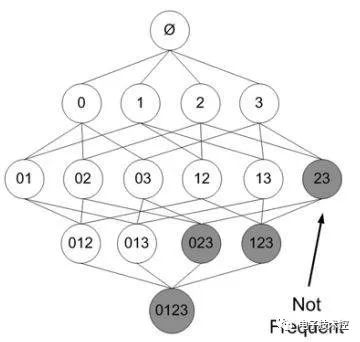

Apriori是關聯分析中比較早的一種方法,主要用來挖掘那些頻繁項集合。其思想是: 1. 如果一個項目集合不是頻繁集合,那么任何包含它的項目集合也一定不是頻繁集合; 2. 如果一個項目集合是頻繁集合,那么它的任何非空子集也是頻繁集合; Aprioir需要掃描項目表多遍,從一個項目開始掃描,舍去掉那些不是頻繁的項目,得到的集合稱為L,然后對L中的每個元素進行自組合,生成比上次掃描多一個項目的集合,該集合稱為C,接著又掃描去掉那些非頻繁的項目,重復… 看下面這個例子,元素項目表格: 如果每個步驟不去掉非頻繁項目集,則其掃描過程的樹形結構如下:

在其中某個過程中,可能出現非頻繁的項目集,將其去掉(用陰影表示)為:

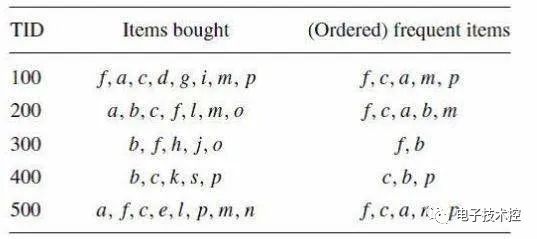

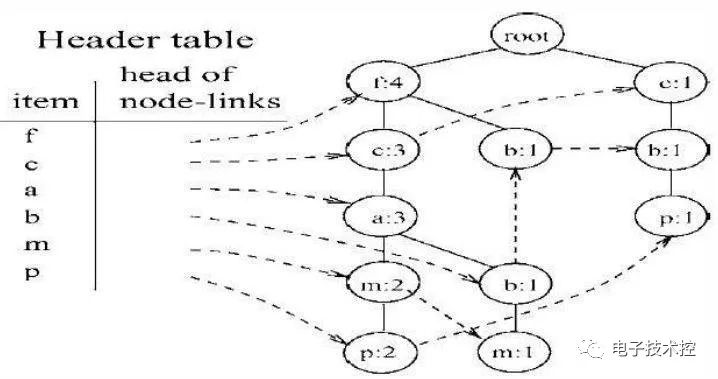

FP Growth是一種比Apriori更高效的頻繁項挖掘方法,它只需要掃描項目表2次。其中第1次掃描獲得當個項目的頻率,去掉不符合支持度要求的項,并對剩下的項排序。第2遍掃描是建立一顆FP-Tree(frequent-patten tree)。 接下來的工作就是在FP-Tree上進行挖掘,比如說有下表:

它所對應的FP_Tree如下:

然后從頻率最小的單項P開始,找出P的條件模式基,用構造FP_Tree同樣的方法來構造P的條件模式基的FP_Tree,在這棵樹上找出包含P的頻繁項集。 依次從m,b,a,c,f的條件模式基上挖掘頻繁項集,有些項需要遞歸的去挖掘,比較麻煩,比如m節點。 來源:圖靈人工智能

審核編輯:郭婷

-

人工智能

+關注

關注

1791文章

47183瀏覽量

238260 -

機器學習

+關注

關注

66文章

8406瀏覽量

132565

原文標題:17個機器學習的常用算法

文章出處:【微信號:電子技術控,微信公眾號:電子技術控】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

NPU與機器學習算法的關系

利用Matlab函數實現深度學習算法

深度學習中的時間序列分類方法

機器學習算法原理詳解

深度學習與傳統機器學習的對比

名單公布!【書籍評測活動NO.35】如何用「時間序列與機器學習」解鎖未來?

EMC問題解決實戰教學6——浪涌問題解決!

EMC問題解決實戰教學2——傳導發射問題解決!

機器學習領域將算法按照學習方式分類進行問題解決

機器學習領域將算法按照學習方式分類進行問題解決

評論