導(dǎo)航是一個(gè)內(nèi)容豐富、基礎(chǔ)扎實(shí)的問題領(lǐng)域,它推動(dòng)了許多不同領(lǐng)域的研究進(jìn)展:尤其是感知、計(jì)劃、記憶、探索和優(yōu)化。從歷史上看,這些挑戰(zhàn)都是單獨(dú)考慮的,并且建立的解決方案依賴于固定的數(shù)據(jù)集——例如,通過環(huán)境的記錄軌跡。然而,這些數(shù)據(jù)集不能用于決策和強(qiáng)化學(xué)習(xí),總的來說,導(dǎo)航作為一項(xiàng)交互式的學(xué)習(xí)任務(wù),其中學(xué)習(xí)agent的行動(dòng)和行為是與感知和規(guī)劃同時(shí)學(xué)習(xí)的,這一觀點(diǎn)相對(duì)來說沒有得到支持。因此,現(xiàn)有的導(dǎo)航基準(zhǔn)測(cè)試通常依賴于靜態(tài)數(shù)據(jù)集(Geiger等人,2013;Kendall等人,2015)或模擬器(Beattie等人,2016;Shah等人,2018年)。為了支持和驗(yàn)證端到端導(dǎo)航的研究,我們提出了StreetLearn:一個(gè)交互式的、第一人稱的、部分觀察的視覺環(huán)境,使用谷歌街景的照片內(nèi)容和廣泛的覆蓋范圍,并給出了一個(gè)具有挑戰(zhàn)性的目標(biāo)驅(qū)動(dòng)的導(dǎo)航任務(wù)的性能基線。

I.簡(jiǎn)介

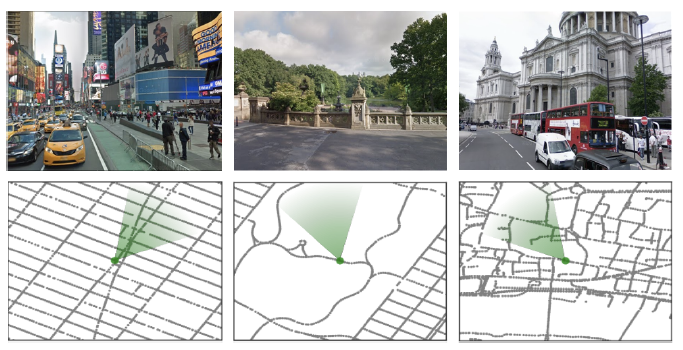

圖1 l 我們的環(huán)境是由來自StreetView的真實(shí)世界的地方建立的。圖中顯示了紐約市(時(shí)代廣場(chǎng)、中央公園)和倫敦(圣保羅大教堂)的不同景觀和相應(yīng)的本地地圖。綠色的圓錐體代表agent的位置和方向。

導(dǎo)航這一課題對(duì)各種研究學(xué)科和技術(shù)領(lǐng)域都具有吸引力,是希望破解網(wǎng)格和位置細(xì)胞密碼的神經(jīng)科學(xué)家的研究課題(Banino等人,2018;Cueva和Wei, 2018), 同時(shí)也是機(jī)器人研究的一個(gè)基本方面,希望建造可以到達(dá)給定目的地的移動(dòng)機(jī)器人。大多數(shù)導(dǎo)航算法涉及在探索階段建立一個(gè)明確的地圖,然后通過該表征進(jìn)行規(guī)劃和行動(dòng)。 最近,研究人員試圖通過探索和與環(huán)境的互動(dòng)來直接學(xué)習(xí)導(dǎo)航策略,例如使用端到端的深度強(qiáng)化學(xué)習(xí)(Lample和Chaplot,2017;Mirowski等人,2017;Wu等人,2018;Zhu等人,2017)。 為了支持這項(xiàng)研究,我們?cè)O(shè)計(jì)了一個(gè)名為StreetLearn的互動(dòng)環(huán)境,使用谷歌街景的圖像和基礎(chǔ)連接信息(見圖1),包括匹茲堡和紐約市的兩個(gè)大區(qū)域。該環(huán)境以高分辨率的攝影圖片為特色,展示了多樣化的城市環(huán)境,并以真實(shí)的街道連接圖跨越了城市規(guī)模的區(qū)域。 在這個(gè)環(huán)境中,我們開發(fā)了幾個(gè)穿越任務(wù),要求agent從一個(gè)目標(biāo)到另一個(gè)目標(biāo)進(jìn)行長(zhǎng)距離的導(dǎo)航。

其中一項(xiàng)任務(wù)在現(xiàn)實(shí)世界中類似于一個(gè)在特定城市工作的速遞員,他從一個(gè)被稱為 "A "的任意地點(diǎn)開始,然后被指示去一個(gè)用絕對(duì)坐標(biāo)定義的特定地點(diǎn)"B",但他從來沒有被告知這些地點(diǎn)的地圖或從A到B的路徑,或被告知自己的位置。 另一項(xiàng)任務(wù)是模仿谷歌地圖,遵循由自然語言導(dǎo)航指示和圖像縮略圖組成的一步一步的指示。額外的導(dǎo)航任務(wù)可以在StreetLearn環(huán)境中開發(fā)。 我們?cè)诘?節(jié)中描述了數(shù)據(jù)集、環(huán)境和任務(wù),在第3節(jié)中解釋了環(huán)境代碼,在第4節(jié)中描述了已實(shí)施的方法和基線方法,在第5節(jié)中描述了結(jié)果,在第6節(jié)中詳細(xì)介紹了相關(guān)工作。 II.環(huán)境

本節(jié)介紹了StreetLearn,一個(gè)利用谷歌街景構(gòu)建的互動(dòng)環(huán)境。由于街景數(shù)據(jù)是在全球范圍內(nèi)收集的,并且包括高分辨率圖像和圖表連接,因此它是研究導(dǎo)航的寶貴資源。

街景提供了一組地理定位的360°全景圖像,這些圖像構(gòu)成了一個(gè)無向圖的節(jié)點(diǎn)(我們交替使用節(jié)點(diǎn)和全景這一術(shù)語)。我們選擇了紐約市和匹茲堡的一些地區(qū)。紐約市可供下載的地區(qū)是曼哈頓第81街以南的地區(qū)。

這包括在一個(gè)由(40.695,-74.028)和(40.788,-73.940)定義的長(zhǎng)/寬邊界框內(nèi)的近似56K全景圖像。請(qǐng)注意,布魯克林、皇后區(qū)、羅斯福島以及曼哈頓的橋梁和隧道都不包括在內(nèi),我們只包括曼哈頓海濱和第79/81街的多邊形內(nèi)的全景圖,覆蓋面積為31.6平方公里。匹茲堡數(shù)據(jù)集包括58K張圖像,由(40.425, -80.035)和(40.460, -79.930)之間的經(jīng)度/緯度邊界框來定義,覆蓋8.9公里乘3.9公里的區(qū)域。

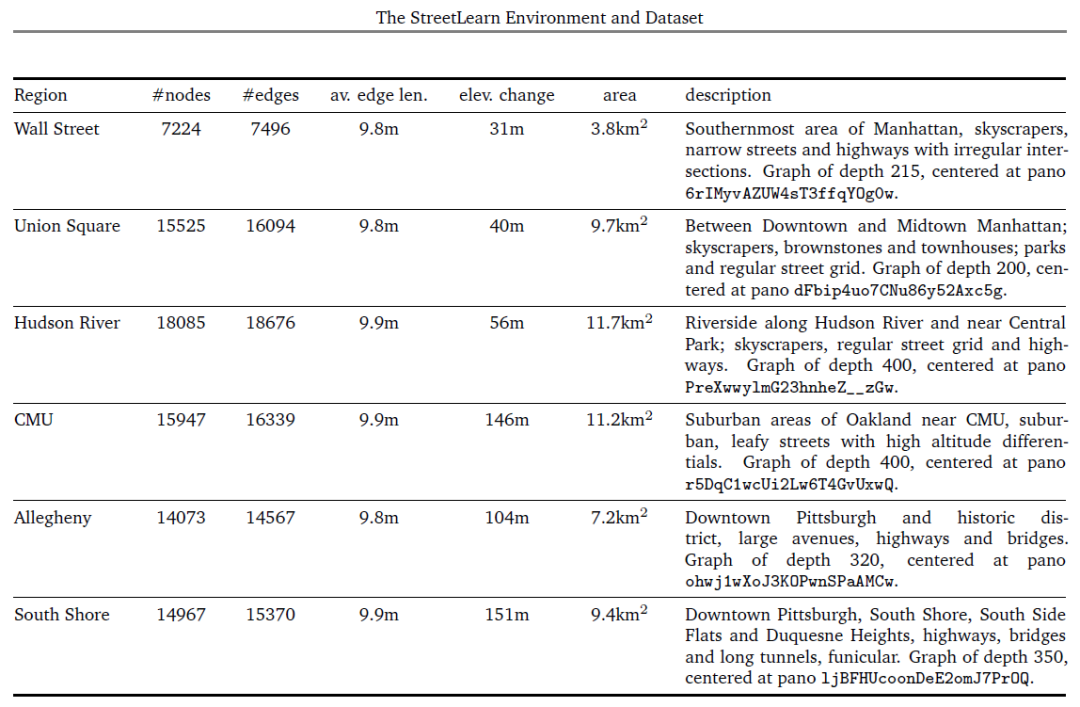

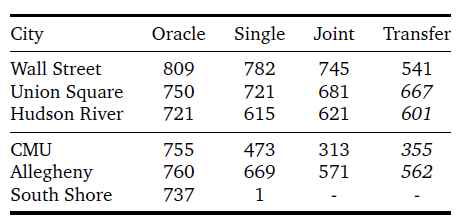

此外,我們?cè)诿總€(gè)城市確定了三個(gè)區(qū)域,可以單獨(dú)用于訓(xùn)練或轉(zhuǎn)移學(xué)習(xí)實(shí)驗(yàn)。表1給出了每個(gè)地區(qū)的統(tǒng)計(jì)數(shù)據(jù)。

無向圖的邊描述了節(jié)點(diǎn)與其他節(jié)點(diǎn)的接近性和可及性。我們不減少或簡(jiǎn)化基礎(chǔ)的連接性,而是使用完整的圖;因此,有許多節(jié)點(diǎn)的擁擠地區(qū),復(fù)雜的閉塞交叉口,隧道和人行道,以及其他偶發(fā)事件。

平均節(jié)點(diǎn)間距為10米,在交叉口的密度更高。雖然圖形被用來構(gòu)建環(huán)境,但agent從未觀察到底層圖形--只觀察到RGB圖像(公共街景產(chǎn)品中可見的疊加信息,如箭頭,也不被agent看到)。

圖1中顯示了RGB圖像和圖表的例子。 在我們的數(shù)據(jù)集中,每個(gè)全景圖都被存儲(chǔ)為一個(gè)協(xié)議緩沖區(qū)(Google,2008)對(duì)象,包含一個(gè)高質(zhì)量的壓縮JPEG格式的字符串,對(duì)等角圖像進(jìn)行編碼,并以下列屬性加以裝飾:一個(gè)獨(dú)特的字符串標(biāo)識(shí)符,全景相機(jī)的位置(經(jīng)度/緯度坐標(biāo)和高度,以米為單位)和方向(俯仰、滾動(dòng)和偏航角度),圖像的采集日期,以及直接連接的相鄰對(duì)象列表。 2.1.界定數(shù)據(jù)集內(nèi)的區(qū)域 在StreetLearn數(shù)據(jù)集中,整個(gè)曼哈頓和匹茲堡的環(huán)境包含了大的城市區(qū)域,每個(gè)區(qū)域代表了超過56000張街景全景圖,從一個(gè)極端到另一個(gè)極端,穿越這些區(qū)域可能需要經(jīng)過街景圖中接近1千的節(jié)點(diǎn)。 為了使學(xué)習(xí)具有可操作性,也為了確定訓(xùn)練和轉(zhuǎn)移的不同區(qū)域,我們可以將環(huán)境切割成更小的區(qū)域。例如,圖3顯示了將曼哈頓和匹茲堡切割成6個(gè)區(qū)域("華爾街"、"聯(lián)合廣場(chǎng)"、"哈德遜"、"CMU"、"阿勒格尼 "和"南岸")的情況,這在我們第5節(jié)的實(shí)驗(yàn)中使用。 在街道圖上劃分區(qū)域有許多可能性:最明顯的是用經(jīng)緯度邊界框來切割圖形,其缺點(diǎn)是會(huì)產(chǎn)生不相連的部分。第二種是用多邊形來切割圖形,但必須指定該多邊形的所有頂點(diǎn),依靠凸面體來選擇包含在多邊形內(nèi)的節(jié)點(diǎn),這很不方便。 我們選擇了第三種方法來確定我們的區(qū)域,通過廣度優(yōu)先搜索(BFS)(Moore, 1959; Zuse, 1972)從一個(gè)給定的節(jié)點(diǎn)開始增長(zhǎng)圖形區(qū)域,這只需要選擇一個(gè)中心全景圖和一個(gè)圖形深度,并確保產(chǎn)生的圖形是連接的。我們?cè)诒?中列出了這些區(qū)域的大小(以節(jié)點(diǎn)、邊和區(qū)域覆蓋率計(jì))、高度變化和描述,包括中央全景圖的ID和BFS圖的深度。 2.2.agent界面和速遞任務(wù)

RL環(huán)境需要指定agent的觀察和行動(dòng)空間,并定義任務(wù)。StreetLearn環(huán)境在每個(gè)時(shí)間點(diǎn)提供可視化觀察xt。視覺輸入是為了模擬第一人稱,部分觀察到的環(huán)境,因此xt是一個(gè)裁剪過的、60°正方形的RGB圖像,被縮放為84×84像素(即不是整個(gè)全景圖)。

動(dòng)作空間由五種離散的動(dòng)作組成。"緩慢 "向左或向右旋轉(zhuǎn)(±22.5°),"快速"向左或向右旋轉(zhuǎn)(±67.5°),或向前移動(dòng)(如果從當(dāng)前agent的姿勢(shì)來看,沒有一個(gè)邊緣,這個(gè)動(dòng)作就會(huì)成為一個(gè)noop)。

如果在agent的視錐中有多個(gè)邊,那么就選擇最中心的一個(gè)。

StreetLearn提供了一個(gè)額外的觀察,即目標(biāo)描述符gt,它向agent傳達(dá)了任務(wù)目標(biāo)--去哪里領(lǐng)取下一個(gè)收獲。

如何指定目標(biāo)有很多選擇:例如,圖像是一個(gè)自然的選擇(如(Zhu等人,2017)),但在城市范圍內(nèi)很快就變得模糊不清;可以使用基于語言的指示或街道地址(如(Chen等人,2018)),盡管這將把重點(diǎn)放在語言基礎(chǔ)而不是導(dǎo)航上;和地標(biāo)可用于以可擴(kuò)展的、無坐標(biāo)的方式對(duì)目標(biāo)位置進(jìn)行編碼(Mirowski等人,2018)。

對(duì)于這項(xiàng)快遞任務(wù),我們采取最簡(jiǎn)單的路線,并將目標(biāo)地點(diǎn)直接定為連續(xù)值坐標(biāo) (Lattg, Longtg)。注意目標(biāo)描述是絕對(duì)的;它與agent的位置無關(guān),只在繪制新目標(biāo)時(shí)發(fā)生變化(無論是在成功獲得目標(biāo)時(shí)還是在任務(wù)事件開始時(shí))。

在快遞任務(wù)中,可以概括為導(dǎo)航到城市中一系列隨機(jī)地點(diǎn)的問題,agent從StreetLearn圖中隨機(jī)抽樣的位置和方向開始每一個(gè)任務(wù)。從圖中隨機(jī)抽出一個(gè)目標(biāo)位置,計(jì)算出目標(biāo)描述符g0并輸入給agent。如果agent到達(dá)一個(gè)接近目標(biāo)的節(jié)點(diǎn)(100米,或大約一個(gè)城市街區(qū)),agent就會(huì)得到獎(jiǎng)勵(lì),并隨機(jī)選擇下一個(gè)目標(biāo)并輸入給agent。

每一個(gè)任務(wù)在1000個(gè)agent步驟后結(jié)束。agent在到達(dá)目標(biāo)時(shí)獲得的獎(jiǎng)勵(lì)與目標(biāo)和agent首次分配目標(biāo)時(shí)的位置之間的最短路徑成正比;很像速遞服務(wù),agent在較長(zhǎng)的旅程中獲得較高的獎(jiǎng)勵(lì)。

直觀地說,為了解決速遞任務(wù),agent需要學(xué)會(huì)將目標(biāo)編碼與在目標(biāo)位置觀察到的圖像相關(guān)聯(lián),以及將在當(dāng)前位置觀察到的圖像與到達(dá)不同目標(biāo)位置的策略相關(guān)聯(lián)。

2.3.課程

課程學(xué)習(xí)通過選擇更多更難的例子來呈現(xiàn)給學(xué)習(xí)算法,逐漸增加學(xué)習(xí)任務(wù)的復(fù)雜性(Bengio等人,2009;Graves等人,2017;Zaremba和Sutskever,2014)。我們發(fā)現(xiàn),對(duì)于目的地較遠(yuǎn)的速遞任務(wù),課程可能很重要。與其他RL問題(如Montezuma’s Revenge)類似,速遞員任務(wù)的獎(jiǎng)勵(lì)非常稀少;與該游戲不同,我們能夠制定一個(gè)自然的課程計(jì)劃。我們首先對(duì)agent位置500米范圍內(nèi)的新目標(biāo)進(jìn)行采樣(第1階段)。在第二階段,我們逐步擴(kuò)大允許目標(biāo)的最大范圍,以覆蓋整個(gè)圖形。

注意,雖然本文主要關(guān)注速遞任務(wù),但正如下面第3節(jié)所述,該環(huán)境已經(jīng)豐富了,通過一步步的(圖像、自然語言指令)和目標(biāo)圖像指定方向的可能性。

III.編碼

3.1.編碼結(jié)構(gòu)

我們?cè)趆ttps://github.com/deepmind/streetlearn提供了環(huán)境和agent的編碼。該編碼庫包含以下組件:

? 我們的C++ StreetLearn引擎用于加載、緩存和提供谷歌街景全景圖,并根據(jù)城市街道圖和agent的當(dāng)前位置和方向處理導(dǎo)航(從一個(gè)全景圖移動(dòng)到另一個(gè))。每個(gè)全景圖都從其等矩形(Wikipedia, 2005)表示投影到第一人稱視圖,可以指定偏航、俯仰和視場(chǎng)角度。

? 用于存儲(chǔ)全景圖和街道圖的消息協(xié)議緩沖區(qū)(Google, 2008)。

表1 l 紐約的三個(gè)地區(qū)(華爾街、聯(lián)合廣場(chǎng)和哈德遜河)和匹茲堡的三個(gè)地區(qū)(CMU、阿勒格尼和南岸)的相關(guān)信息。

? 一個(gè)基于Python的接口,用于調(diào)用具有自定義動(dòng)作空間的StreetLearn環(huán)境。

? 在Python StreetLearn界面中,幾個(gè)游戲被定義在單獨(dú)的文件中,文件名以game.py結(jié)尾。

? 一個(gè)簡(jiǎn)單的人類agent,使用Pygame在Python中實(shí)現(xiàn),在所要求的地圖上實(shí)例化StreetLearn環(huán)境,并使用戶能夠玩速遞或跟隨指令的游戲

? Oracleagent,類似于人類agent,自動(dòng)導(dǎo)航到指定的目標(biāo),并報(bào)告Oracle在速遞或指令遵循游戲中的表現(xiàn)。

?agent的TensorFlow實(shí)施。

3.2.編碼界面

我們的Python StreetLearn環(huán)境遵循OpenAI Gym2(Brockman等人,2016)的規(guī)范。

在實(shí)例化了一個(gè)特定的游戲和環(huán)境后,可以通過調(diào)用函數(shù)reset()來初始化環(huán)境。注意,如果在構(gòu)建時(shí)將auto_reset的flag設(shè)置為True,那么每當(dāng)一個(gè)情節(jié)結(jié)束時(shí),reset()將被自動(dòng)調(diào)用。

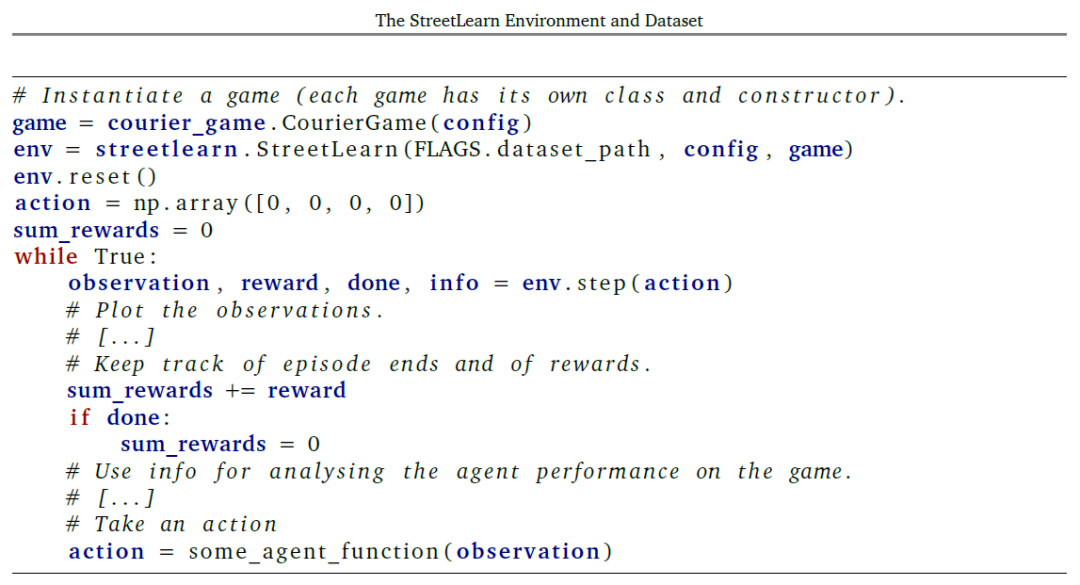

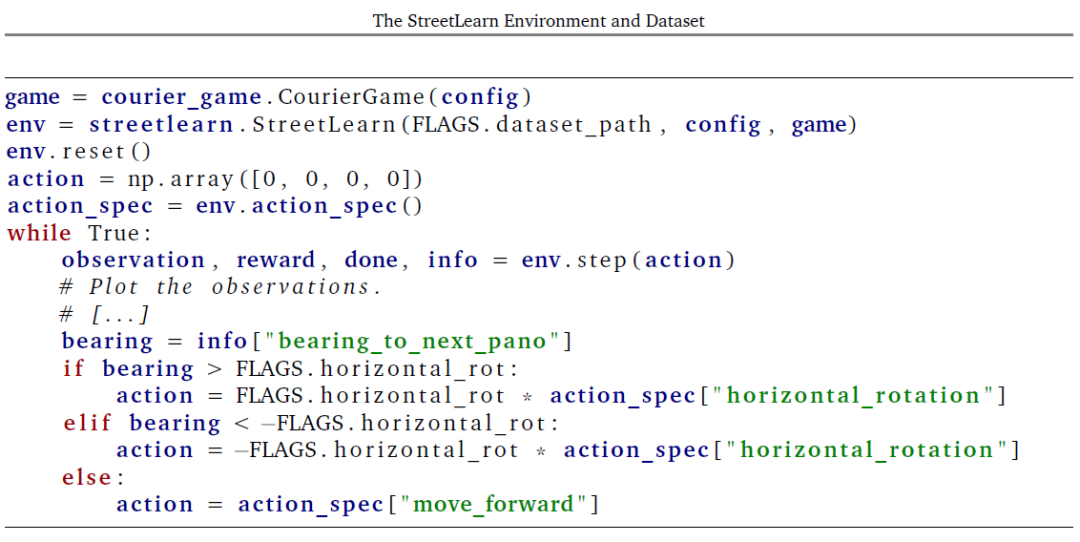

如清單4所示,agent在環(huán)境中通過迭代生成一個(gè)動(dòng)作,將其發(fā)送到(逐步通過)環(huán)境,并處理環(huán)境返回的觀察結(jié)果和獎(jiǎng)勵(lì)。對(duì)函數(shù)step(動(dòng)作)的調(diào)用返回:

? 觀察(構(gòu)造時(shí)要求的觀察數(shù)組和標(biāo)量的元組),

?獎(jiǎng)勵(lì)(一個(gè)帶有agent當(dāng)前獎(jiǎng)勵(lì)的浮動(dòng)標(biāo)度數(shù)),

?done(布爾值,表示一個(gè)游戲情節(jié)是否已經(jīng)結(jié)束并被重置),

?以及info(環(huán)境狀態(tài)變量字典,用于調(diào)試agent行為或訪問特權(quán)環(huán)境信息以進(jìn)行可視化和分析)。

3.3.行動(dòng)和觀察

我們向agent提供了四個(gè)行動(dòng):

? 在全景圖中向左或向右旋轉(zhuǎn)一個(gè)指定的角度(改變agent的偏航)。 ? 在全景圖中按指定的角度向上或向下旋轉(zhuǎn)(改變agent的間距)。 ? 如果agent從A到B的當(dāng)前方位在30度的公差角度內(nèi),則從當(dāng)前全景圖A向前移動(dòng)到另一個(gè)全景圖B。 ? 在全景圖中放大和縮小。 因此,agent行動(dòng)通過step(action)作為4個(gè)標(biāo)量數(shù)字的圖組被發(fā)送到環(huán)境中。 然而,對(duì)于通過強(qiáng)化學(xué)習(xí)訓(xùn)練離散策略agent,行動(dòng)空間被離散為整數(shù)。例如,我們?cè)冢∕irowski等人,2018)中使用了5個(gè)動(dòng)作:(向前移動(dòng),左轉(zhuǎn)22.5度,左轉(zhuǎn)67.5度,右轉(zhuǎn)22.5度,右轉(zhuǎn)67.5度)。目前可以要求從環(huán)境中獲得以下觀察結(jié)果:?view_image:從環(huán)境中返回并由agent看到的第一人稱視角圖像的RGB圖像; ?graph_image:自上而下的街道圖圖像的RGB圖像,通常不被agent看到; ?pitch:agent的俯仰角的標(biāo)量值,單位是度(零對(duì)應(yīng)于水平); ?yaw:agent的偏航角度的標(biāo)量值,單位是度(零對(duì)應(yīng)于北); ?yaw_label:agent偏航的整數(shù)離散值,使用16個(gè)bin; ?metadata:具有當(dāng)前全景圖元數(shù)據(jù)的Pano類型的消息協(xié)議緩沖區(qū); ?target_metadata:具有目的/目標(biāo)全景圖元數(shù)據(jù)的Pano類型的消息協(xié)議緩沖區(qū); ?latlng:agent當(dāng)前位置的緯度/經(jīng)度標(biāo)量值的元組; ?latlng:當(dāng)前agent位置的整數(shù)離散值,使用1024個(gè)bins(32個(gè)bins為緯度,32個(gè)bins為經(jīng)度); ?target_latlng:目的/目標(biāo)位置的緯度/經(jīng)度度標(biāo)量值的元組; ?target_latlng:目標(biāo)位置的整數(shù)離散值,使用1024個(gè)bins (32個(gè)bins 為緯度,32個(gè)bins 為經(jīng)度); ?thumbnails:從環(huán)境中返回的第一人稱視角圖像的n+1個(gè)RGB圖像集,當(dāng)用n個(gè)指令進(jìn)行指令追蹤游戲時(shí),agent應(yīng)該在特定的航點(diǎn)和目標(biāo)位置看到這些圖像; ?instructions:當(dāng)用n個(gè)指令進(jìn)行指令追蹤游戲時(shí),在特定的航點(diǎn)和目標(biāo)地點(diǎn)為agent提供n個(gè)指令集; ?neighbors:agent周圍的近鄰以自我為中心的可穿越性網(wǎng)格的矢量,agent周圍的方向有16個(gè)bin,bin 0對(duì)應(yīng)于agent正前方的可穿越性; ?ground_truth_direction:為了遵循最短路徑到達(dá)下一個(gè)目標(biāo)或航點(diǎn),agent要采取的相對(duì)地面真實(shí)方向的標(biāo)量值。這種觀察應(yīng)該只對(duì)使用模仿學(xué)習(xí)訓(xùn)練的agent提出要求。

3.4.游戲

以下游戲可在StreetLearn環(huán)境中使用:

3.4.1.硬幣_(tái)游戲在硬幣游戲中,獎(jiǎng)勵(lì)包括散落在地圖上的無形硬幣,每個(gè)硬幣的獎(jiǎng)勵(lì)為1。一旦被撿到,這些獎(jiǎng)勵(lì)在劇情結(jié)束前不會(huì)再出現(xiàn)。3.4.2.速遞_游戲在速遞游戲中,agent被賦予了一個(gè)目標(biāo)目的地,以經(jīng)/緯度對(duì)的形式加以說明。一旦達(dá)到目標(biāo)(有100米的容許偏差),就會(huì)對(duì)新的目標(biāo)進(jìn)行采樣,直到情節(jié)結(jié)束。 在一個(gè)目標(biāo)上的獎(jiǎng)勵(lì)與agent得到新的目標(biāo)分配時(shí)從其位置到該目標(biāo)位置的最短路徑上的全景圖數(shù)量成正比。額外的獎(jiǎng)勵(lì)形成包括當(dāng)agent到達(dá)距離目標(biāo)200米范圍內(nèi)時(shí)的早期獎(jiǎng)勵(lì)。 額外的硬幣也可以分散在整個(gè)環(huán)境中。硬幣的比例、目標(biāo)半徑和早期獎(jiǎng)勵(lì)半徑是可參數(shù)化的。課程_速遞游戲與速遞游戲類似,但在任務(wù)的難度上有一個(gè)課程(分配任務(wù)時(shí),從agent的位置到目標(biāo)的最大直線距離)。3.4.3.指令游戲目標(biāo)指令游戲及其變體--遞增指令游戲和逐步指令游戲使用導(dǎo)航指令來引導(dǎo)agent到達(dá)目標(biāo)。agent被提供了一個(gè)指令清單以及縮略圖,引導(dǎo)agent從其起始位置到目標(biāo)位置。 在逐步游戲中,agent每次提供一個(gè)指令和兩個(gè)縮略圖,在其他游戲變體中,整個(gè)列表在整個(gè)游戲中都可以使用。到達(dá)目標(biāo)地點(diǎn)(所有變體),以及擊中單個(gè)航點(diǎn)(僅增量和逐步)時(shí),均可獲得獎(jiǎng)勵(lì)。 在訓(xùn)練過程中,有各種課程策略可供agent使用,并且可以采用獎(jiǎng)勵(lì)塑造法,當(dāng)agent進(jìn)入到距離一個(gè)航點(diǎn)或目標(biāo)50米的范圍內(nèi)時(shí),提供零星的獎(jiǎng)勵(lì)。

IV.方法

本節(jié)簡(jiǎn)要介紹了在速遞任務(wù)中被評(píng)估的一系列方法。

4.1.Goal-dependent Actor-Critic 強(qiáng)化學(xué)習(xí) 我們將學(xué)習(xí)問題形式化為馬爾科夫決策過程,有狀態(tài)空間s,行動(dòng)空間A,環(huán)境s,以及一組可能的目標(biāo)g。 獎(jiǎng)勵(lì)函數(shù)取決于當(dāng)前的目標(biāo)和狀態(tài):R : s ×g ×A → R. 通常的強(qiáng)化學(xué)習(xí)目標(biāo)是找到使預(yù)期收益最大化的政策,該策略被定義為從狀態(tài)s0開始的折現(xiàn)獎(jiǎng)勵(lì)之和,折現(xiàn)率為γ。 I在這個(gè)導(dǎo)航任務(wù)中,一個(gè)狀態(tài)st的預(yù)期回報(bào)也取決于一系列的采樣目標(biāo){gk}k。策略是:給定當(dāng)前狀態(tài)st和目標(biāo)gt下,在動(dòng)作上的分布:π(als, g) = Pr(at = alst= s, gt = g)。我們將值函數(shù)定義為代理的期望返回值,該代理從狀態(tài)st的策略π中采樣動(dòng)作,目標(biāo)gt: 我們假設(shè)agent應(yīng)該從兩種類型的學(xué)習(xí)中獲益:第一,學(xué)習(xí)一般的、與位置無關(guān)的表征和探索行為;第二,學(xué)習(xí)本地特定的結(jié)構(gòu)和特征。一個(gè)導(dǎo)航代理不僅需要一個(gè)通用的內(nèi)部表征,以支持認(rèn)知過程,如場(chǎng)景理解,而且還需要組織和記憶一個(gè)地方特有的特征和結(jié)構(gòu)。因此,為了支持這兩種類型的學(xué)習(xí),我們專注于具有多種途徑的神經(jīng)架構(gòu)。 我們?cè)诒?中描述的六個(gè)區(qū)域評(píng)估了兩個(gè)agent。我們?cè)诖藢?duì)該方法進(jìn)行總結(jié),因?yàn)檫@些agent的全部架構(gòu)細(xì)節(jié)之前已經(jīng)描述過(Mirowski等人,2018)。 策略和價(jià)值函數(shù)都由一個(gè)神經(jīng)網(wǎng)絡(luò)設(shè)定參數(shù),該網(wǎng)絡(luò)共享除最終線性輸出以外的所有層。 該agent對(duì)原始像素圖像xt進(jìn)行操作,這些圖像通過卷積網(wǎng)絡(luò),如(Mnih等人,2016)。長(zhǎng)短期記憶(LSTM)(Hochreiter和Schmidhuber,1997)接收對(duì)話編碼器的輸出,以及過去的獎(jiǎng)勵(lì)rt+1和以前的行動(dòng)at+1。這兩種不同的結(jié)構(gòu)描述如下。

圖4 l 與環(huán)境互動(dòng)的主要循環(huán)。

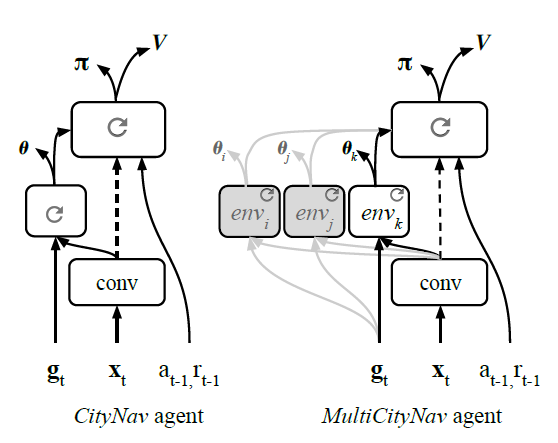

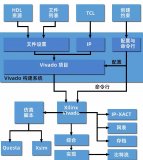

圖5l 架構(gòu)的比較。左圖:City-Nav是一個(gè)具有策略LSTM、獨(dú)立目標(biāo)LSTM和操作輔助航向(θ)的單一城市導(dǎo)航架構(gòu)。右圖:多城市導(dǎo)航是一個(gè)多城市架構(gòu),每個(gè)城市都有獨(dú)立的目標(biāo)LSTM路徑。

CityNav架構(gòu)(圖5b)有一個(gè)卷積編碼器和兩個(gè)LSTM層,它們被指定為策略LSTM和目標(biāo)LSTM。目標(biāo)描述gt與之前的動(dòng)作和獎(jiǎng)勵(lì)以及卷積編碼器的視覺特征一起被輸入到目標(biāo)LSTM。CityNav agent還在目標(biāo)LSTM的輸出上增加了一個(gè)輔助的航向(θ)預(yù)測(cè)任務(wù)。

多城市導(dǎo)航架構(gòu)(圖5c)擴(kuò)展了CityNav agent,以便在不同城市學(xué)習(xí)。 目標(biāo)LSTM的職責(zé)是編碼和封裝當(dāng)?shù)靥囟ǖ奶卣骱屯負(fù)浣Y(jié)構(gòu),這樣就可以添加多個(gè)路徑,每個(gè)城市或地區(qū)一個(gè)。此外,在對(duì)一些城市進(jìn)行訓(xùn)練后,我們證明卷積編碼器和政策LSTM變得足夠通用,只需要為新的城市訓(xùn)練一個(gè)新的目標(biāo)LSTM。

為了訓(xùn)練agent,我們使用IMPALA(Espeholt等人,2018),這是一個(gè)actor-critic的實(shí)現(xiàn),將行動(dòng)和學(xué)習(xí)分離開來。在我們的實(shí)驗(yàn)中,IMPALA的性能與A3C(Mnih等人,2016)相似。我們對(duì)CityNav使用256個(gè)行為體,對(duì)MultiCityNav使用512個(gè)行為體,批次大小分別為256或512,序列長(zhǎng)度為50。

我們注意到,這些計(jì)算資源并不是所有人都能得到的,所以我們驗(yàn)證了只用16個(gè)行動(dòng)者和1個(gè)學(xué)習(xí)者,在一臺(tái)帶有圖形處理單元(GPU)的臺(tái)式電腦上運(yùn)行,就能獲得類似的結(jié)果。

我們使用的臺(tái)式機(jī)有很大的內(nèi)存(192GB),用于實(shí)例化16個(gè)StreetLearn環(huán)境(每個(gè)環(huán)境都需要一個(gè)大的緩存內(nèi)存來緩存全景圖),但更小的內(nèi)存也可以使用,但要權(quán)衡一下更頻繁的磁盤訪問。

CityNav和基線架構(gòu)的TensorFlow實(shí)現(xiàn)(Mirowski等人,2018)可在https://github.com/deepmind/streetlearn的代碼回收庫中獲得。

訓(xùn)練器代碼是對(duì)(Espeholt等人,2018)的直接修改,來自https://github.com/deepmind/scalable_ agent,可單獨(dú)提供。

4.2.Oracle

我們還通過使用廣度優(yōu)先搜索計(jì)算從所有全景位置到指定目標(biāo)位置的最短路徑來計(jì)算所有任務(wù)的上限(Moore, 1959;Zuse, 1972)的全景連通性圖。這使我們能夠計(jì)算agent應(yīng)該去的下一個(gè)全景圖是哪一個(gè),以及agent為了向前移動(dòng)到那個(gè)全景圖應(yīng)該對(duì)齊的方向,重復(fù)這個(gè)過程直到到達(dá)目的地。

這個(gè)ground_truth_position可以作為一個(gè)觀察值被請(qǐng)求(對(duì)于模仿學(xué)習(xí)代理),或者從環(huán)境返回的信息字典中提取。清單6顯示了如何實(shí)現(xiàn) oracle agent,以提供一個(gè)有價(jià)值的衡量標(biāo)準(zhǔn)來衡量任務(wù)。

V.速遞任務(wù)的結(jié)構(gòu)

為了評(píng)估所描述的方法,我們給出了每個(gè)區(qū)域的單獨(dú)性能,以及多個(gè)區(qū)域的聯(lián)合訓(xùn)練結(jié)果。我們還展示了該方法的概括能力,即通過評(píng)估保留區(qū)域的目標(biāo),以及只對(duì)一個(gè)全新的區(qū)域進(jìn)行agent訓(xùn)練。 表2給出了在圖3和表1中定義的紐約市和匹茲堡市的六個(gè)不同地區(qū),不同的代理在每1000步事件中取得的平均總獎(jiǎng)勵(lì)。盡管代理人接受了獎(jiǎng)勵(lì)塑造的訓(xùn)練(即,當(dāng)他們?cè)谀繕?biāo)的小半徑范圍內(nèi)時(shí),他們會(huì)得到部分獎(jiǎng)勵(lì)),這里給出的每集回報(bào)只包括達(dá)到目標(biāo)時(shí)給予的全部獎(jiǎng)勵(lì)。實(shí)驗(yàn)都是用5個(gè)不同的種子重復(fù)進(jìn)行的。 在表2中,Oracle的結(jié)果是直接在圖上進(jìn)行廣度搜索的結(jié)果,因此它們反映了完美的性能。單一結(jié)果顯示了使用CityNav架構(gòu)為每個(gè)區(qū)域單獨(dú)訓(xùn)練的agent的性能。訓(xùn)練有素的agent在紐約市表現(xiàn)良好,實(shí)現(xiàn)了85%至97%的oracle收益,而在匹茲堡表現(xiàn)較差,尤其是在南岸地區(qū),agent完全失敗。 這可能是由于該地區(qū)具有挑戰(zhàn)性的海拔變化,即使在附近的節(jié)點(diǎn)之間也會(huì)產(chǎn)生錯(cuò)綜復(fù)雜的路線,這也是我們指定課程任務(wù)的一個(gè)偽命題(基于從agent位置到目標(biāo)的最大歐氏距離,不考慮實(shí)際旅行時(shí)間)。 特別是,當(dāng) agent在南岸的杜肯山頂時(shí),在河對(duì)岸的目標(biāo)地點(diǎn),如果乘坐飛機(jī)500米遠(yuǎn),公路距離可能會(huì)有數(shù)公里。 聯(lián)合結(jié)果顯示了在五個(gè)地區(qū)聯(lián)合訓(xùn)練的多城市導(dǎo)航agent在每個(gè)地區(qū)的表現(xiàn)(不包括南岸)。盡管現(xiàn)在在更大的范圍內(nèi)進(jìn)行了訓(xùn)練:兩個(gè)城市和五個(gè)地區(qū),但所產(chǎn)生的agent 在性能上只下降了一點(diǎn)。 最后,轉(zhuǎn)移給出了一個(gè)agent的表現(xiàn),該agent在四個(gè)地區(qū)接受訓(xùn)練(用斜體字給出),然后轉(zhuǎn)移到第五個(gè)地區(qū)(華爾街)。在這種轉(zhuǎn)移中,只有目標(biāo)LSTM被修改;架構(gòu)的其他兩個(gè)部分(卷積編碼器或策略LSTM)沒有梯度更新。

表2 l Oracle的每個(gè)城市目標(biāo)獎(jiǎng)勵(lì),單一訓(xùn)練的CityNav和多個(gè)CityNav agent在5個(gè)城市(華爾街、曼哈頓的聯(lián)合廣場(chǎng)和哈德遜河、匹茲堡的CMU和阿勒格尼)聯(lián)合訓(xùn)練或在4個(gè)城市(聯(lián)合廣場(chǎng)、哈德遜河、CMU和阿勒格尼)聯(lián)合訓(xùn)練。

圖6 l Oracle的實(shí)施,使用地面真實(shí)方向/方位到下一個(gè)全景圖。

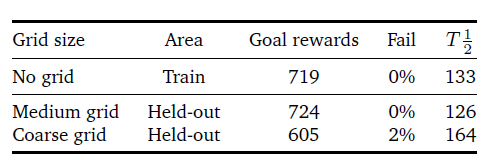

表3 l CityNav agent在一組目標(biāo)地點(diǎn)(中等和粗略的網(wǎng)格)上的概括表現(xiàn)(獎(jiǎng)勵(lì)和失敗指標(biāo))。我們還計(jì)算了半程時(shí)間(T1/2),即到達(dá)目標(biāo)的一半。

為了研究受過訓(xùn)練的agent的概括能力,我們掩蓋了25%的可能目標(biāo),并對(duì)剩余的目標(biāo)進(jìn)行訓(xùn)練(見圖5(Mirowski等人,2018)的說明)。在測(cè)試時(shí),我們只對(duì)agent在封閉區(qū)域達(dá)到目標(biāo)的能力進(jìn)行評(píng)估。注意,agent仍然能夠穿越這些區(qū)域,只是它從未在那里采樣過目標(biāo)。更確切地說,封閉的區(qū)域是經(jīng)緯度為0.01°(粗網(wǎng)格)或0.005°(中網(wǎng)格)的方塊(分別大約為1平方公里和0.5平方公里)。

在實(shí)驗(yàn)中,我們對(duì)CityNavagent進(jìn)行了1B步的訓(xùn)練,接下來凍結(jié)了agent的權(quán)重,并對(duì)其在100M步的封閉區(qū)域的表現(xiàn)進(jìn)行了評(píng)估。表3顯示,隨著封閉區(qū)面積的增加,agent的性能有所下降。為了進(jìn)一步理解,除了測(cè)試獎(jiǎng)勵(lì)指標(biāo),我們還使用了未完成目標(biāo)(Fail)和半行程時(shí)間(T1/2)指標(biāo)。

錯(cuò)過目標(biāo)的指標(biāo)衡量的是沒有達(dá)到目標(biāo)的百分比。半程時(shí)間衡量的是完成agent與目標(biāo)之間的一半距離所需的agent步驟數(shù)量。

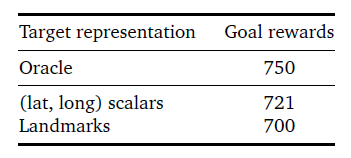

我們還在表4中比較了使用(經(jīng)緯度)目標(biāo)描述符與之前提出的地標(biāo)描述符(Mirowski等人,2018)時(shí)取得的性能。雖然地標(biāo)方案有一些優(yōu)勢(shì),比如避免了固定的坐標(biāo)框架,但(緯度,緯度)描述符的表現(xiàn)要優(yōu)于紐約聯(lián)合廣場(chǎng)地區(qū)的地標(biāo)。

表4 lCityNav代理在聯(lián)合廣場(chǎng)上使用不同類型的目標(biāo)表示時(shí)的表現(xiàn):(緯度,長(zhǎng)度)標(biāo)量與地標(biāo)。

VI.相關(guān)工作

StreetLearn環(huán)境與近年來出現(xiàn)的許多其他模擬器和數(shù)據(jù)集相關(guān),這些模擬器和數(shù)據(jù)集是為了響應(yīng)增強(qiáng)學(xué)習(xí)和更普遍地通過交互學(xué)習(xí)導(dǎo)航的更大興趣而出現(xiàn)的。

我們重點(diǎn)列舉了這些相關(guān)的數(shù)據(jù)集和環(huán)境,請(qǐng)讀者參考Mirowski等人(2018)對(duì)相關(guān)方法的更完整討論。

許多基于RL的導(dǎo)航方法依賴于模擬器,這些模擬器具有程序化生成的變化等特點(diǎn),但在視覺上往往是簡(jiǎn)單和不真實(shí)的,包括合成的3D環(huán)境,如VizDoom(Kempka等人,2016)、HoME(Brodeur等人,2017)、House 3D(Wu等人,2018)、Chalet(Yan等人)等。2016)、DeepMind Lab(Beattie等人,2016)、HoME(Brodeur等人,2017)、House 3D(Wu等人,2018)、Chalet(Yan等人,2018),或AI2-THOR(Kolve等人,2017)。

為了彌補(bǔ)模擬和真實(shí)之間的差距,研究人員開發(fā)了更真實(shí)、更高保真度的模擬環(huán)境(Dosovit- skiy等人,2017;Kolve等,2017;沙阿等人,2018;吳等人,2018)。然而,盡管模擬環(huán)境越來越具有照片真實(shí)感,但其固有的問題在于環(huán)境的有限多樣性和觀察結(jié)果的清潔性。

我們的真實(shí)世界數(shù)據(jù)集是多樣化和視覺逼真的,包括行人、汽車、公共汽車或卡車、不同的天氣條件和植被的場(chǎng)景,覆蓋了很大的地理區(qū)域。然而,我們注意到我們的環(huán)境有明顯的局限性:它不包含動(dòng)態(tài)元素,行動(dòng)空間必然是離散的,因?yàn)樗仨氃谌皥D之間跳躍,而且街道拓?fù)浣Y(jié)構(gòu)不能被任意改變或再生。

最近引入了更多視覺逼真的環(huán)境,如MatterportRoom-to-Room (Chang等人,2017)、AdobeIndoorNav(Mo等人,2018)、Stanford 2D- 3D-S(Armeni等人,2016)、ScanNet (Dai等人,2017)、Gibson環(huán)境(Xia等人,2018)和MI- NOS (Savva等人,2017)來表示室內(nèi)場(chǎng)景,其中一些還添加了導(dǎo)航指令。

deVries等人(2018)使用紐約的圖像,但依靠對(duì)附近地標(biāo)的分類注釋,而不是視覺觀察,并且只使用了500張全景圖的數(shù)據(jù)集(我們的數(shù)據(jù)集要大兩個(gè)數(shù)量級(jí))。最近,Cirik等人(2018),特別是Chen等人(2018)也提出了以街景圖像為基礎(chǔ)的較大的駕駛指令數(shù)據(jù)集。

VII.總結(jié)

導(dǎo)航是一項(xiàng)重要的認(rèn)知任務(wù),它使人類和動(dòng)物能夠在沒有地圖的情況下穿越一個(gè)復(fù)雜的世界。為了幫助理解這種認(rèn)知技能,它的出現(xiàn)和穩(wěn)健性,以及它在現(xiàn)實(shí)世界中的應(yīng)用,我們公開了一個(gè)數(shù)據(jù)集和一個(gè)基于谷歌街景的互動(dòng)環(huán)境。

我們精心策劃的數(shù)據(jù)集是由經(jīng)過人工審查和隱私審查的攝影圖片構(gòu)成的--我們采取了這些額外的預(yù)防措施,以確保所有的人臉和車牌都被適當(dāng)?shù)啬:恕?/p>

該數(shù)據(jù)集可獲得,并根據(jù)要求進(jìn)行分發(fā);在個(gè)人要求刪除或模糊谷歌街景網(wǎng)站上的特定全景圖的情況下,我們將其要求傳播給StreetLearn數(shù)據(jù)集的用戶,并向用戶提供符合刪除要求的最新版本。

我們的環(huán)境使agent的訓(xùn)練能夠純粹基于視覺觀察和絕對(duì)目標(biāo)位置表征來導(dǎo)航到不同的目標(biāo)位置。我們還用文字說明擴(kuò)展了該數(shù)據(jù)集,以實(shí)現(xiàn)基于獎(jiǎng)勵(lì)的任務(wù),重點(diǎn)是遵循相對(duì)方向來達(dá)到目標(biāo)。我們將依靠這個(gè)數(shù)據(jù)集和環(huán)境來解決接地的、長(zhǎng)距離的、目標(biāo)驅(qū)動(dòng)的導(dǎo)航的基本問題。

審核編輯:郭婷

-

谷歌

+關(guān)注

關(guān)注

27文章

6173瀏覽量

105645 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24743

原文標(biāo)題:自動(dòng)駕駛“環(huán)境和數(shù)據(jù)集”

文章出處:【微信號(hào):阿寶1990,微信公眾號(hào):阿寶1990】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

如何利用遙感監(jiān)測(cè)環(huán)境變化 遙感衛(wèi)星的工作原理與種類

HarmonyOS Next元服務(wù)蒹葭動(dòng)卡體驗(yàn)互動(dòng)

HarmonyOS Next元服務(wù)大學(xué)之道動(dòng)卡互動(dòng)

純凈IP:構(gòu)建可信網(wǎng)絡(luò)環(huán)境的基石

深圳特信電子 4G5G大功率屏蔽器:如何構(gòu)建安全通信環(huán)境

谷歌推出Project Oscar:利用代理技術(shù)高效管理軟件程序

如何使用Cygwin在Win64中構(gòu)建環(huán)境?

如何在不同應(yīng)用場(chǎng)景下構(gòu)建音頻測(cè)試環(huán)境

谷歌計(jì)劃推出明星網(wǎng)紅AI聊天機(jī)器人,與Meta展開技術(shù)競(jìng)爭(zhēng)

求助,通過VScode構(gòu)建的集成開發(fā)環(huán)境如何更新環(huán)境下的ESP-IDF版本?

谷歌模型框架是什么軟件?谷歌模型框架怎么用?

谷歌發(fā)布全新AI模型Genie

鴻蒙開發(fā)【編譯構(gòu)建】講解

自動(dòng)化構(gòu)建環(huán)境在FPGA設(shè)計(jì)中的應(yīng)用

StreetLearn利用谷歌街景構(gòu)建的互動(dòng)環(huán)境介紹

StreetLearn利用谷歌街景構(gòu)建的互動(dòng)環(huán)境介紹

評(píng)論