號外:

全場景高性能 AI 部署工具

FastDeploy 發版 v1.0

幾行代碼搞定 AI 部署,快速使用 150+ 預置部署示例,支持 CV、NLP、Speech、Cross-model 模型,并提供開箱即用的云邊端部署體驗,實現 AI 模型端到端的推理性能優化。

歡迎廣大開發者使用 NVIDIA 與飛槳聯合深度適配的 NGC 飛槳容器,在 NVIDIA GPU 上進行體驗 FastDeploy!

全場景高性能 AI 部署工具 FastDeploy

人工智能技術在各行各業正加速應用落地。為了向開發者提供產業實踐推理部署最優解,百度飛槳發起了 FastDeploy 開源項目。FastDeploy 具備全場景、簡單易用、極致高效三大特點。

(1)簡單易用:幾行代碼完成 AI 模型的 GPU 部署,一行命令切換推理后端,快速體驗 150+ 熱門模型部署

FastDeploy 精心設計模型 API,不同語言統一 API 體驗,只需要幾行核心代碼,就可以實現預知模型的高性能推理,極大降低了 AI 模型部署難度和工作量。一行命令切換 TensorRT、Paddle Inference、ONNX Runtime、Poros 等不同推理后端,充分利用推理引擎在 GPU 硬件上的優勢。

import fastdeploy as fd

import cv2

option = fd.RuntimeOption()

option.use_gpu()

option.use_trt_backend() # 一行命令切換使用 TensorRT部署

model = fd.vision.detection.PPYOLOE("model.pdmodel",

"model.pdiparams",

"infer_cfg.yml",

runtime_option=option)

im = cv2.imread("test.jpg")

result=model.predict(im)FastDeploy 幾行命令完成 AI 模型部署

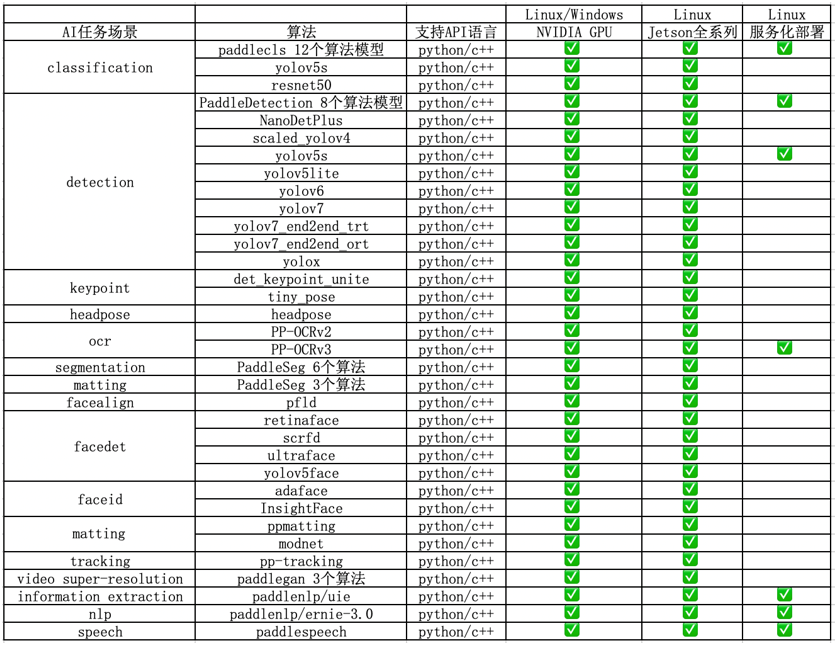

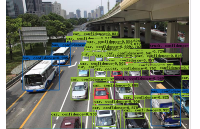

FastDeploy 支持 CV、NLP、Speech、Cross-modal(跨模態)四大 AI 領域,覆蓋 20 多主流場景、150 多個 SOTA 產業模型的端到端示例,包括圖像分類、圖像分割、語義分割、物體檢測、字符識別(OCR)、人臉檢測、人臉關鍵點檢測、人臉識別、人像扣圖、視頻扣圖、姿態估計、文本分類、信息抽取、文圖生成、行人跟蹤、語音合成等。支持飛槳 PaddleClas、PaddleDetection、PaddleSeg、PaddleOCR、PaddleNLP、PaddleSpeech 6 大熱門 AI 套件的主流模型及生態(如 PyTorch、ONNX 等)熱門模型的部署。

FastDeploy 在 NVIDIA GPU、Jetson上的 AI 模型部署庫

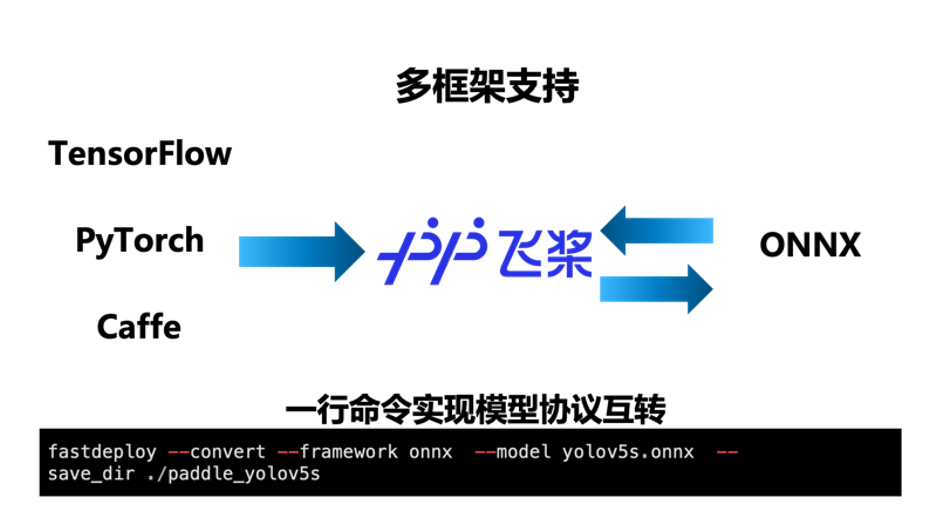

(2)全場景:支持多框架,輕松搞定 PaddlePaddle、PyTorch、ONNX 等模型部署

FastDeploy 支持 TensorRT、Paddle Inference、ONNX Runtime、Poros 推理引擎,統一部署 API,只需要一行代碼,便可靈活切換多個 GPU 推理引擎后端。內置了 X2Paddle 和 Paddle2ONNX 模型轉換工具,只需要一行命令便可完成其他深度學習框架到飛槳以及 ONNX 的相互轉換,讓其他框架的開發者也能通過 FastDeploy 體驗到飛槳模型壓縮與推理引擎的端到端優化效果。覆蓋 GPU、Jetson Nano、Jetson TX2、Jetson AGX、Jetson Orin 等云邊端場景全系列 NVIDIA 硬件部署。同時支持服務化部署、離線部署、端側部署方式。

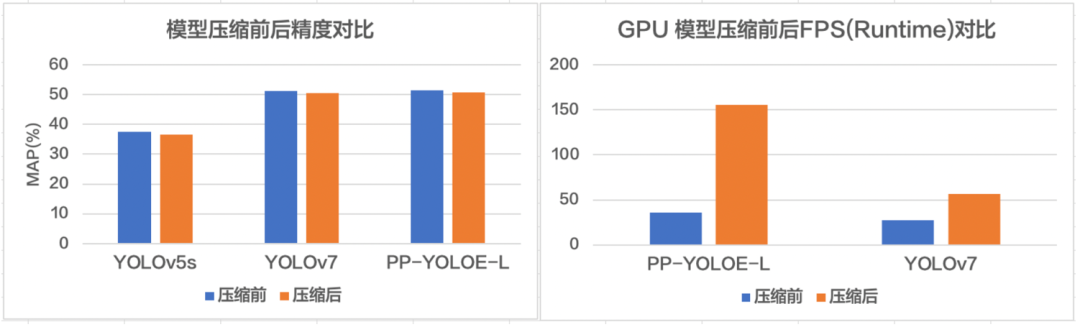

(3)極致高效:一鍵壓縮提速,預處理加速,端到端性能優化,提升 AI 算法產業落地

FastDeploy 集成了自動壓縮工具,在參數量大大減小的同時(精度幾乎無損),推理速度大幅提升。使用 CUDA 加速優化預處理和后處理模塊,將 YOLO 系列的模型推理加速整體從 41ms 優化到 25ms。端到端的優化策略,徹底解決 AI 部署落地中的性能難題。更多性能優化,歡迎關注 GitHub 了解詳情。

https://github.com/PaddlePaddle/FastDeploy

FastDeploy 一行命令實現自動壓縮,充分利用硬件資源提升推理速度

FastDeploy 提升 AI 任務端到端推理速

直播預告:服務化部署高并發調優實戰

12 月 12 日 - 12 月 30 日,《產業級 AI 模型部署全攻略》系列直播課程,FastDeploy 聯合 10 家硬件公司與大家直播見面。

12 月 14 日 20:30 開始,NVIDIA 與百度資深專家將為大家帶來以“一鍵搞定服務化部署,實現穩定高并發服務”為主題的精彩分享,詳細解說 FastDeploy 服務化部署實戰教學,以及如何提升 GPU 利用率和吞吐量!歡迎大家掃碼報名獲取直播鏈接,加入交流群與行業精英深度共同探討 AI 部署落地話題。

一鍵搞定服務化部署

實現穩定高并發服務

12 月 14 日,星期三,20:30

精彩亮點

-

企業級 NGC 容器,快速獲取強大的軟硬件能力

-

三行代碼搞定 AI 部署,一鍵體驗 150+ 部署 demo

-

服務化部署實戰教學,提升 GPU 利用率和吞吐量

會議嘉賓

Adam | NVIDIA 亞太區資深產品經理

Jason|百度資深研發工程師

參與方式

掃碼報名獲取直播鏈接

原文標題:在 NGC 上玩轉新一代推理部署工具 FastDeploy,幾行代碼搞定 AI 部署

文章出處:【微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

-

英偉達

+關注

關注

22文章

3893瀏覽量

92628

原文標題:在 NGC 上玩轉新一代推理部署工具 FastDeploy,幾行代碼搞定 AI 部署

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

【幸狐Omni3576邊緣計算套件試用體驗】DeepSeek 部署及測試

《AI Agent 應用與項目實戰》閱讀心得3——RAG架構與部署本地知識庫

如何部署OpenVINO?工具套件應用程序?

是否可以使用OpenVINO?部署管理器在部署機器上運行Python應用程序?

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

摩爾線程宣布成功部署DeepSeek蒸餾模型推理服務

用Ollama輕松搞定Llama 3.2 Vision模型本地部署

評論