NeurIPS 2022 | Parameter-Efficient Masking Networks,美國東北大學,羅切斯特理工等,提出參數集約型掩碼網絡,探索有限數量隨機數的表征能力并提升神經網絡儲存和傳輸效率。

為了處理更復雜的任務,近年來神經網絡的規模也在不斷變大,如何高效的儲存和傳輸神經網絡變得十分重要。另一方面,隨著彩票假說(Lottery Ticket Hypothesis (LTH))的提出,隨機稀疏神經網絡最近展現出很強的潛力,如何利用這種潛力來提高網絡的存儲和傳輸效率也很值得探索。

來自美國東北大學和羅切斯特理工的研究者提出參數集約型掩碼網絡(Parameter-Efficient Masking Networks (PEMN))。作者首先探索了有限數量隨機數生成的隨機網絡的表征能力。實驗表明,即使網絡由有限數量的隨機數生成,通過選擇不同的子網絡結構,其依然具有很好的表征能力。通過這種探索性實驗,作者自然地提出使用一組有限數量隨機數作為prototype,結合一組mask來表達一個神經網絡。因為有限數量的隨機數和二值的mask占用很少的儲存空間,作者以此來提出一種新的思路來進行網絡壓縮。文章已被NeurIPS 2022 接受。代碼已開源。

Parameter-Efficient Masking Networks

論文地址: https://arxiv.org/abs/2210.06699

論文代碼: https://github.com/yueb17/PEMN

1. 相關研究

MIT研究人員提出彩票假說 Lottery Ticket Hypothesis (ICLR’19):在一個隨機初始化網絡中,存在一個彩票子網絡(winning ticket)在被單獨訓練的情況下達到很好的效果。彩票假說探索了隨機稀疏網絡的可訓練性。Uber研究人員提出Supermask (NeurIPS’19):在一個隨機初始化網絡中,存在一個子網絡,可以直接用來做推斷而不需要訓練。Supermask探索了隨機稀疏網絡的可用性。華盛頓大學研究人員提出Edge-Popup (CVPR’20):通過反向傳播學習子網絡的mask,大幅提升了隨機稀疏網絡的可用性。

2. 研究動機/流程

以上相關研究從不同角度探索了隨機稀疏網絡的潛力,如可訓練性和可用性,其中可用性也可以理解為表征能力。在此工作中,作者感興趣的是由隨機數生成的神經網絡在不訓練權重的情況下有多強的表征能力。隨著對該問題的探索,作者提出了Parameter-Efficient Masking Networks (PEMN)。自然地,作者運用PEMN為網絡壓縮提供了一種新的思路,并作為一個例子對PEMN的潛在應用場景進行探索。

3. 探索隨機數構成的神經網絡的表征能力

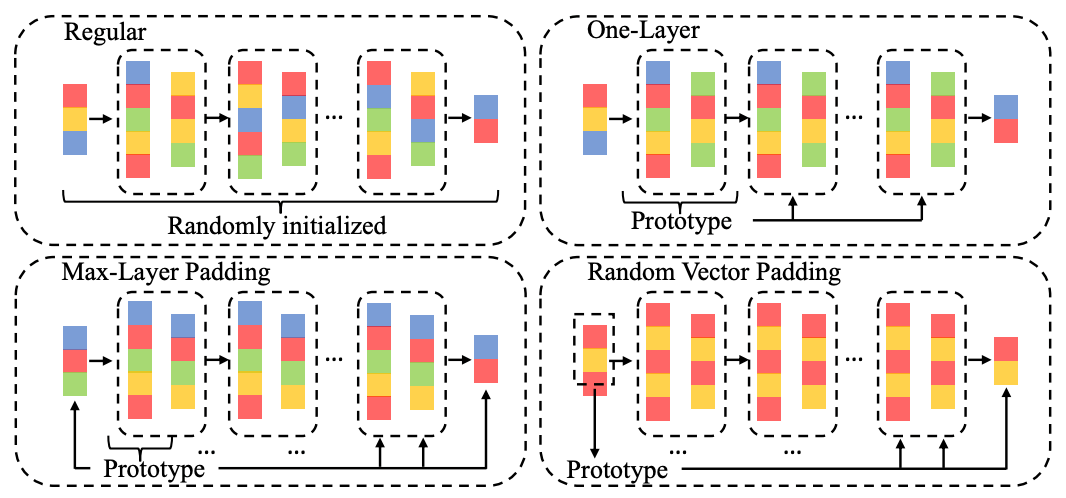

給定一個隨機網絡,作者選擇Edge-Popup算法在其中選擇子網絡來探索其表征能力。不同的是,相對于對整個網絡進行隨機初始化,作者提出了三種參數集約型的網絡生成策略來使用一個prototype構建隨機網絡。

One-layer: 選擇網絡中重復結構的權重作為prototype來填充其他的與之結構相同的網絡層。

Max-layer padding (MP): 選擇參數量最多的網絡層作為prototype并且截斷相應的參數量來填充其他網絡層。

Random vector padding (RP): 選擇一定長度的隨機向量作為prototype并對其進行復制來填充整個網絡。

三種不同的隨機網絡生成策略把網絡中不重復參數值(unique values)的數量逐步變小,我們基于不同策略得到的隨機網絡來選擇子網絡,從而探索了有限數量隨機數生成的隨機網絡的表征潛力。

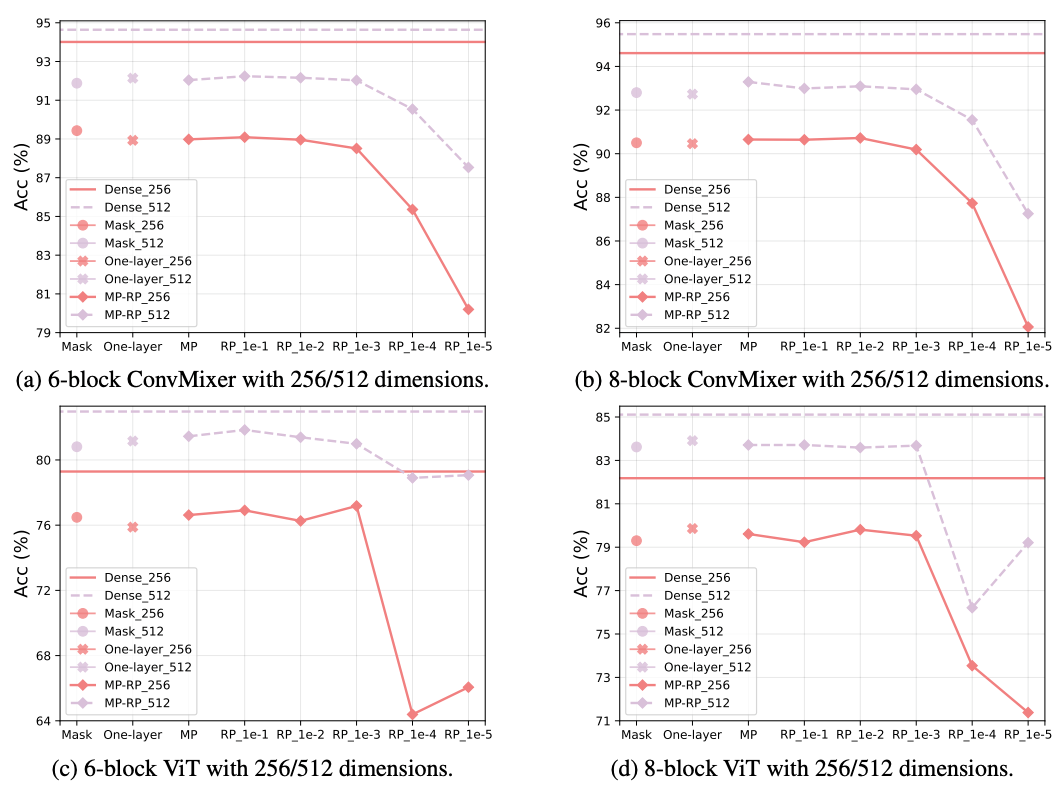

上圖展示了使用ConvMixer 和 ViT 網絡CIFAR10圖像分類的實驗結果。Y軸為準確率,X軸為使用不同策略得到的隨機網絡。隨之X軸的變大,隨機網絡中不重復隨機數數量逐漸變小 (RP后的數字表示相比較于MP,RP中不重復隨機數數量的比例)。根據實驗結果,我們觀察到即使隨機網絡只有非常有限的不重復隨機數(比如PR_1e-3),依然可以很好的維持選擇出來的子網絡的表征能力。至此,作者通過不同的隨機網絡生成策略,探索了有限數量隨機數構成的神經網絡的表征能力并觀察到即使不重復隨機數非常有限,其對應的隨機網絡依然可以很好地對數據進行表征。同時作者基于這些隨機網絡生成策略,結合所得到的子網絡掩碼,提出了Parameter-Efficient Masking Networks(PEMN)這種新的神經網絡類型。

4. 一種新的網絡壓縮思路

本文選擇了神經網路壓縮為例來拓展PEMN的潛在應用。具體來說,文中所提出的不同隨機網絡生成策略可以高效的使用prototype來代表完整的隨機網絡,尤其是最細粒度的random vector padding (RP)策略。作者使用RP策略中的隨機向量prototype和與之對應的一組子網絡掩碼來表示一個隨機網絡。在其中prototype需要保存浮點數格式,而掩碼只需要保存成二值格式。因為RP中的prototype長度可以很短(因為有限數量的不重復隨機數仍有很強的表征能力),所以表示一個神經網絡的開銷會變得很小,即儲存一個長度有限的浮點數格式的隨機向量和一組二值格式的掩碼。相比較于傳統的稀疏網絡儲存子網絡的浮點值,本文提出了一種新的網絡壓縮思路用來高效的儲存和傳輸神經網絡。

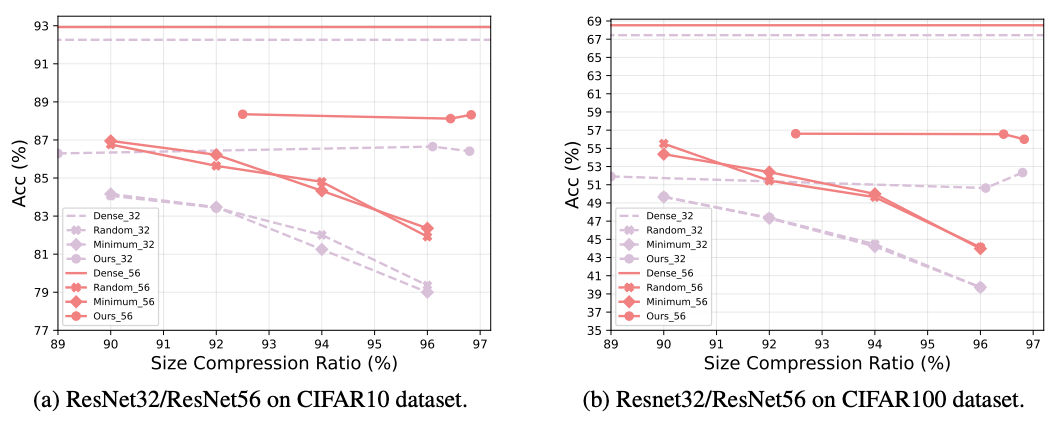

在上圖中,作者使用PEMN對網絡進行壓縮并與傳統的網絡剪枝方法進行對比。實驗使用ResNet網絡在CIFAR數據集做圖像分類任務。我們觀察到,新的壓縮方案表現普遍優于傳統的網絡剪枝,尤其是在很高的壓縮率下,PEMN仍然可以維持較好的準確率。

5. 結論

本文受近來隨機網絡展現出來的潛力所啟發,提出不同種參數集約策略來構建隨機神經網絡,進而探索了在只有有限的不重復隨機數的情況下所生成的隨機神經網絡的表征潛力,并提出參數集約型掩碼網絡Parameter-Efficient Masking Networks (PEMN)。作者將PEMN應用到網絡壓縮的場景中探索了其在實際應用方面的潛力并且為網絡壓縮提供了一種新的思路。作者提供了廣泛的實驗,表明了即使隨機網絡中只有非常有限的不重復隨機數,通過子網絡的選擇,其依然有較好的表征能力。此外,相比較于傳統剪枝算法,實驗表明新提出的方法可以取得更好的網絡壓縮效果,驗證了PEMN在該場景下的應用潛力。

審核編輯 :李倩

-

神經網絡

+關注

關注

42文章

4814瀏覽量

103805 -

算法

+關注

關注

23文章

4713瀏覽量

95520

原文標題:NeurIPS 2022 | PEMN:參數集約型掩碼網絡

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Linux系統中網絡配置詳解

飛凌嵌入式ElfBoard ELF 1板卡-文件系統之配置網絡參數

手把手教你如何調優Linux網絡參數

無法轉換TF OD API掩碼RPGA模型怎么辦?

子網掩碼反運算的步驟和應用

一文分清IP地址、子網和子網掩碼的關系

卷積神經網絡的參數調整方法

什么是小水電集約化管理?小水電集約化管理實現的價值

評論