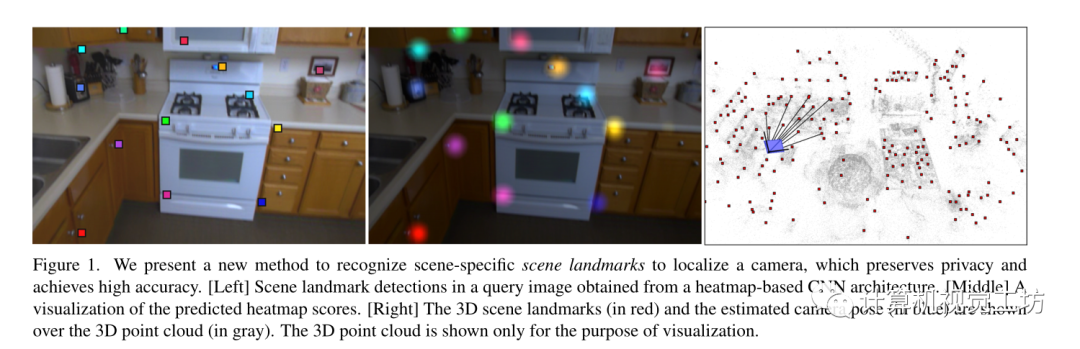

主要內(nèi)容:提出了一種基于學(xué)習(xí)的相機(jī)定位算法,其無(wú)需存儲(chǔ)圖像特征和場(chǎng)景三維點(diǎn)云,降低了存儲(chǔ)限制,通過(guò)識(shí)別場(chǎng)景中稀疏但顯著有代表性的landmark來(lái)找到2D-3D對(duì)應(yīng)關(guān)系進(jìn)行后續(xù)的魯棒姿態(tài)估計(jì),通過(guò)訓(xùn)練檢測(cè)landmark的場(chǎng)景特定的CNN來(lái)實(shí)現(xiàn)所提出的想法,即回歸輸入圖像中對(duì)應(yīng)landmark的2D坐標(biāo)。

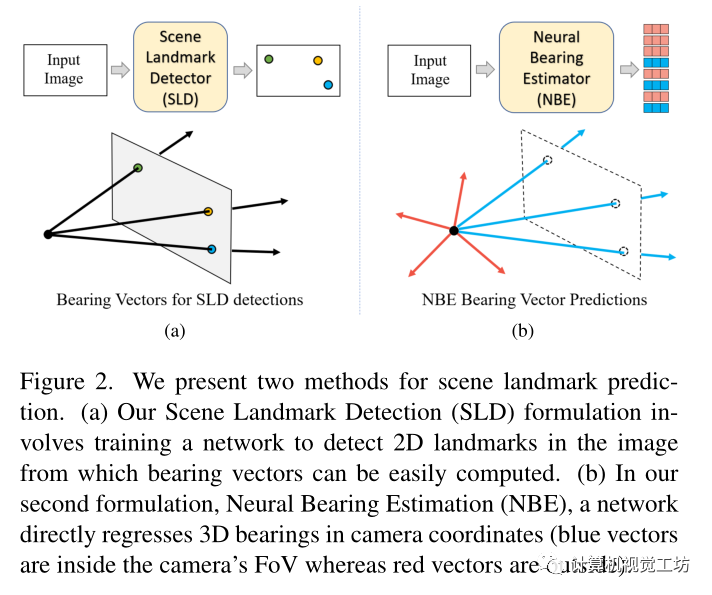

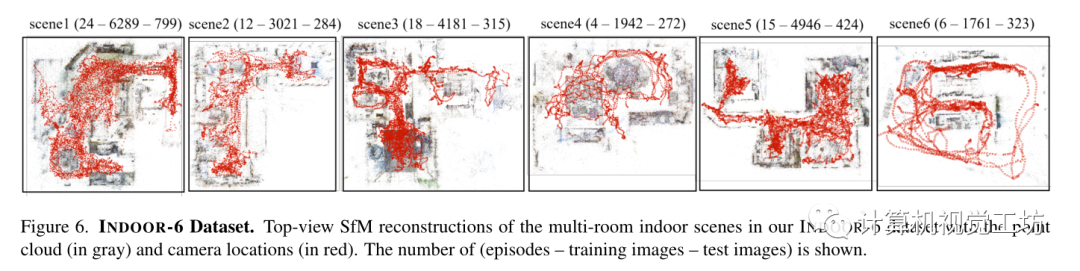

創(chuàng)新點(diǎn)與Contributions:1)與大多數(shù)landmark通常可見(jiàn)的人體姿態(tài)估計(jì)不同,由于相機(jī)視野有限并且無(wú)法同時(shí)觀察場(chǎng)景的不同部分,相機(jī)姿態(tài)估計(jì)任務(wù)中大多數(shù)場(chǎng)景l(fā)andmark不會(huì)同時(shí)可見(jiàn),文章通過(guò)提出一種新的神經(jīng)方位估計(jì)器(Neural Bearing Estimator,NBE)來(lái)解決這一問(wèn)題,該估計(jì)器可以直接回歸相機(jī)坐標(biāo)系中場(chǎng)景l(fā)andmark的3D方位向量,NBE學(xué)習(xí)全局場(chǎng)景表示的同時(shí)學(xué)習(xí)預(yù)測(cè)場(chǎng)景l(fā)andmark的方向向量,即使它們不可見(jiàn)。 2)提出了一個(gè)新的室內(nèi)定位數(shù)據(jù)集,INDOOR-6,相對(duì)于傳統(tǒng)的7-Scenes室內(nèi)數(shù)據(jù)集,包含更多變化的場(chǎng)景、晝夜圖像和強(qiáng)烈的照明變化 3)與現(xiàn)有的無(wú)存儲(chǔ)定位方法相比,具有低存儲(chǔ)的優(yōu)點(diǎn)且性能較好 文章提出了兩種預(yù)測(cè)圖像中場(chǎng)景l(fā)andmark的方法,在第一種方法中訓(xùn)練了一個(gè)模型來(lái)識(shí)別圖像中的2D場(chǎng)景地標(biāo),稱(chēng)之為場(chǎng)景地標(biāo)檢測(cè)器(SLD),由于假設(shè)已知的相機(jī)內(nèi)參,這些2D檢測(cè)可以轉(zhuǎn)換為3D方位矢量或射線。在第二種方法中訓(xùn)練了一個(gè)不同的模型直接預(yù)測(cè)相機(jī)坐標(biāo)系中l(wèi)andmark的3D方位向量,稱(chēng)之為神經(jīng)方位估計(jì)器(NBE)。注:使用SLD,只能檢測(cè)到相機(jī)視場(chǎng)(FoV)中可見(jiàn)的landmark,而NBE預(yù)測(cè)所有l(wèi)andmark的方位,包括相機(jī)視場(chǎng)外不可見(jiàn)的landmark。

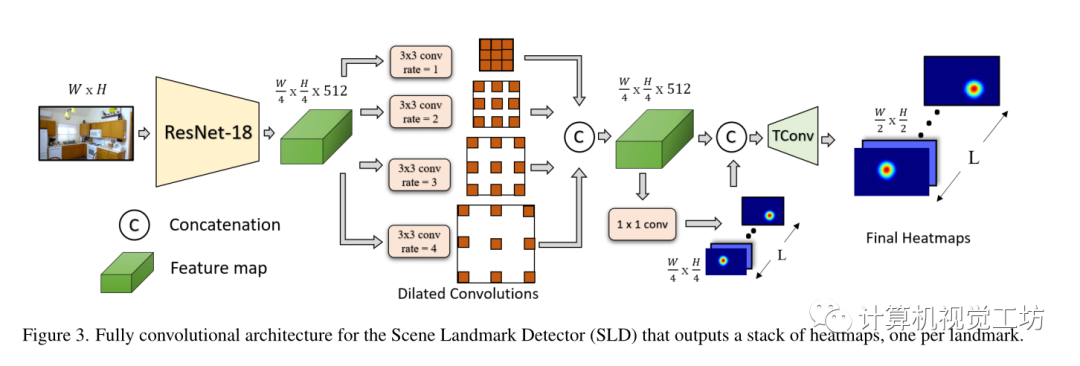

首先會(huì)有一個(gè)SFM構(gòu)建的點(diǎn)云模型,會(huì)在這些點(diǎn)云中挑選出有代表性的點(diǎn)云子集,用這些子集以及建圖時(shí)SFM算法生成的數(shù)據(jù)庫(kù)圖像的偽真值來(lái)訓(xùn)練兩個(gè)提出的網(wǎng)絡(luò)模型。SLD:SLD被設(shè)計(jì)為將RGB圖像I作為輸入并輸出一組像素似然圖(熱圖)表示每個(gè)可見(jiàn)地標(biāo)的位置,其模型架構(gòu)如下:

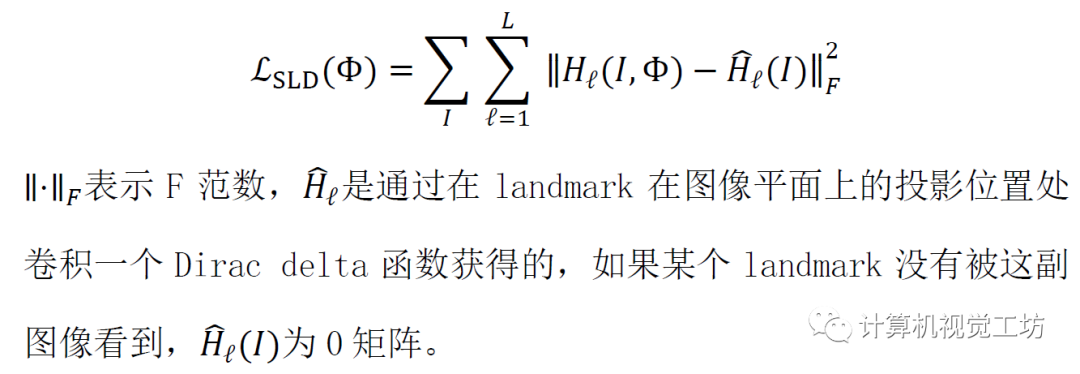

由四個(gè)主要組件組成:使用ResNet-18為backbone,刪除最后三個(gè)最大池化層以保留高分辨率特征圖(輸出分辨率為輸入圖像分辨率的四分之一),其次在ResNet-18之后使用擴(kuò)張卷積塊,擴(kuò)張率設(shè)置為1、2、3和4,接下來(lái)轉(zhuǎn)置卷積層執(zhí)行上采樣,并負(fù)責(zé)生成分辨率為輸入圖像一半的熱圖,最后一層由1×1卷積組成,預(yù)測(cè)L個(gè)熱圖通道,每個(gè)地標(biāo)一個(gè)。 訓(xùn)練損失:

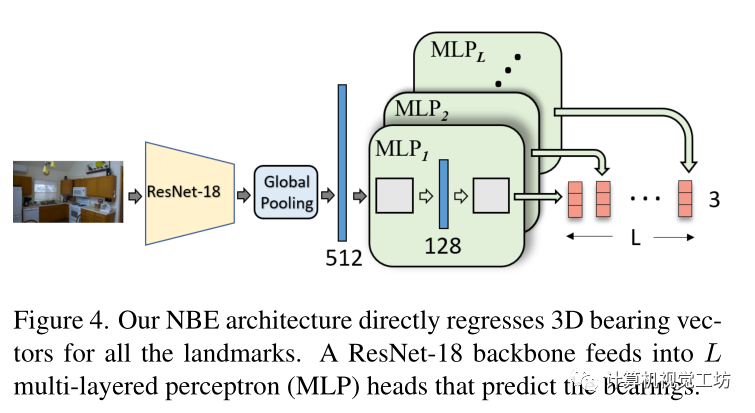

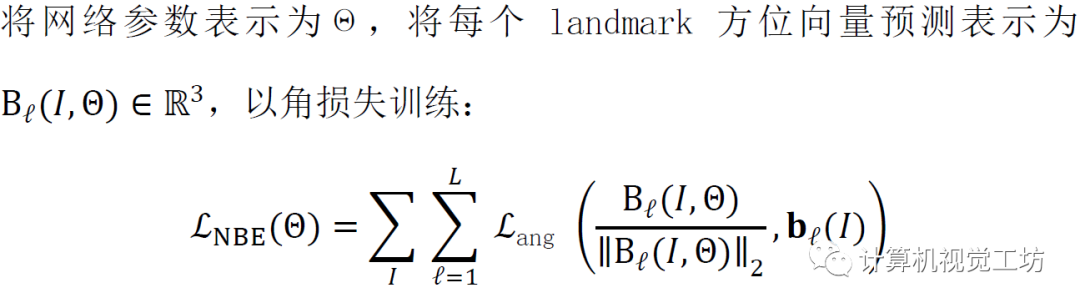

在推斷過(guò)程中,假設(shè)當(dāng)其最大熱圖值超過(guò)閾值τ=0.2時(shí)表明檢測(cè)到地標(biāo),利用亞像素精度計(jì)算熱圖峰值位置處裁剪的17×17 patch的期望值。NBE:設(shè)計(jì)了一個(gè)模型在給定圖像I的情況下回歸全部場(chǎng)景l(fā)andmark(即使它不可見(jiàn))的方位向量。 CNN將圖像I作為輸入以生成深度特征圖,然后是多個(gè)MLP(多層感知器)塊,每個(gè)塊輸出指向landmark的方向向量,MLP包含兩個(gè)全連接層,具有128個(gè)ReLU激活節(jié)點(diǎn)。

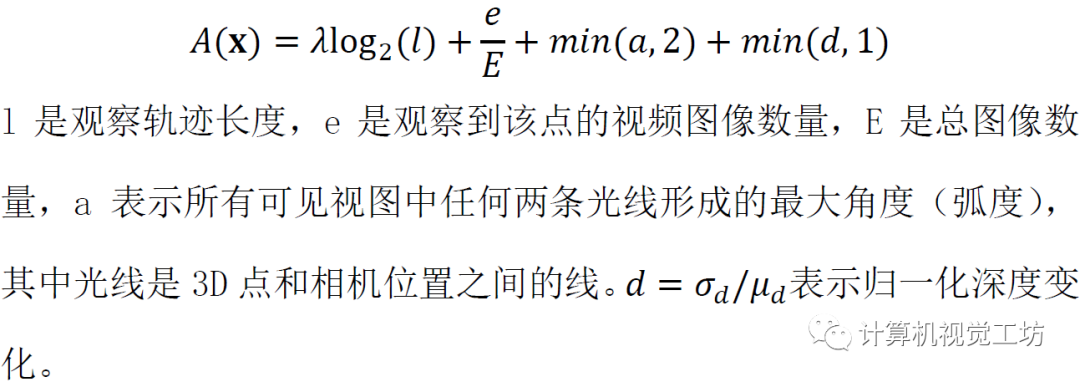

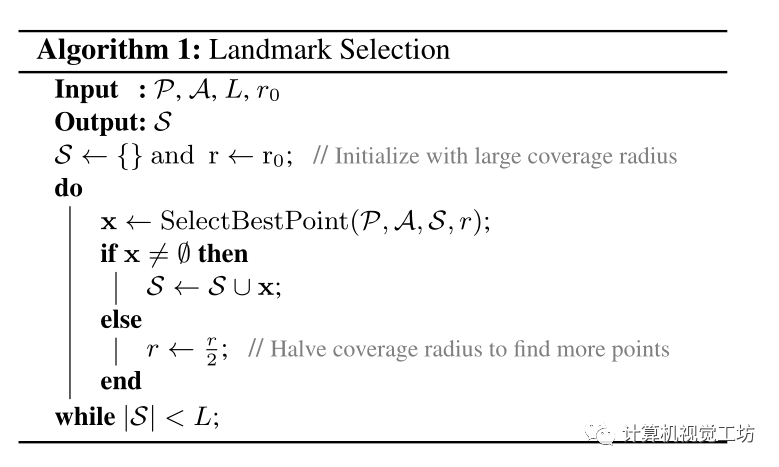

訓(xùn)練好兩個(gè)模型后,將每個(gè)查詢圖像輸入SLD網(wǎng)絡(luò)以獲得2D檢測(cè),然后根據(jù)內(nèi)參將其轉(zhuǎn)換為一組landmark方位向量B1,如果檢測(cè)到超過(guò)八個(gè)場(chǎng)景l(fā)andmark,使用魯棒最小解算器(P3P+RANSAC)計(jì)算相機(jī)姿態(tài),然后使用基于Levenberg-Marquardt的非線性細(xì)化。如果沒(méi)有8個(gè),將相同的圖像輸入NBE網(wǎng)絡(luò)并獲得預(yù)測(cè)方位B2,然后合并方位估計(jì)B1和B2的集合以形成新的集合B3,當(dāng)集合B1和B2中的方位指向同一地標(biāo)時(shí),保留來(lái)自B1的估計(jì),因?yàn)镾LD通常比NBE更準(zhǔn)確。最后使用上面描述的相同過(guò)程但使用B3計(jì)算相機(jī)姿態(tài)。如何從點(diǎn)云中選擇有代表性的場(chǎng)景l(fā)andmark提供給網(wǎng)絡(luò)進(jìn)行訓(xùn)練?從SfM點(diǎn)云P中找到L個(gè)場(chǎng)景l(fā)andmark的最佳子集是一個(gè)組合問(wèn)題,其中評(píng)估每個(gè)子集都是困難的。本文受之前以貪婪的方式尋找有區(qū)別的關(guān)鍵點(diǎn)或場(chǎng)景元素工作的啟發(fā),去選擇魯棒性(具有更長(zhǎng)的軌跡)、可重復(fù)性(在多個(gè)場(chǎng)景中看到)和可概括性(從許多不同的觀看方向和深度觀察)的場(chǎng)景l(fā)andmark,測(cè)量軌跡長(zhǎng)度大于閾值t的3D點(diǎn)x的顯著性得分A(x),如下所示:

除了最大化總體顯著性得分之外還尋找在空間上覆蓋3D場(chǎng)景的場(chǎng)景l(fā)andmark以便從場(chǎng)景內(nèi)的任何地方都可以看到一些地標(biāo),例如無(wú)論攝像機(jī)在場(chǎng)景中的哪個(gè)位置都希望一些地標(biāo)可見(jiàn)。為此使用算法1中描述的約束貪婪方法

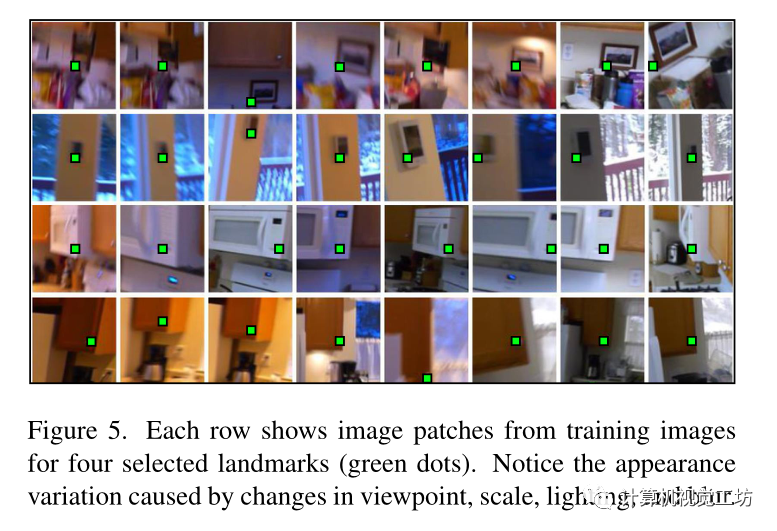

下圖表述一些挑選到的landmark在二維圖像中的投影的裁剪patch

實(shí)驗(yàn):訓(xùn)練模型的細(xì)節(jié)可去論文中查看 實(shí)驗(yàn)數(shù)據(jù)集是在自己提出的INDOOR-6數(shù)據(jù)集和7Scenes數(shù)據(jù)集上

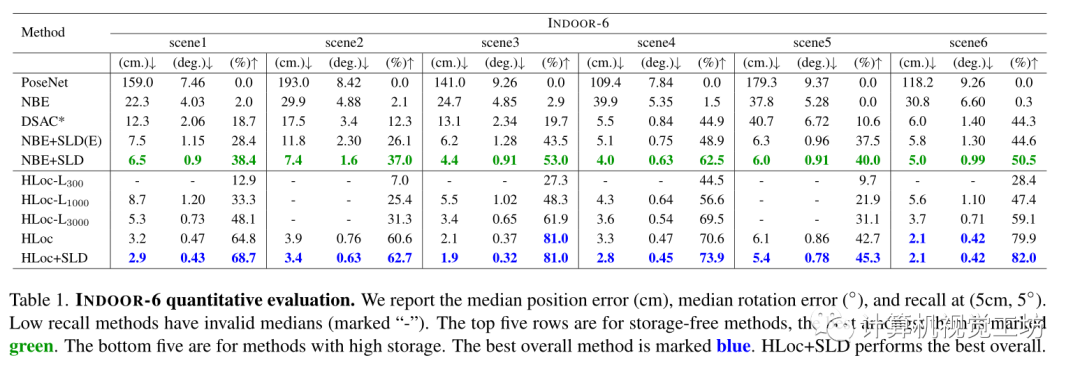

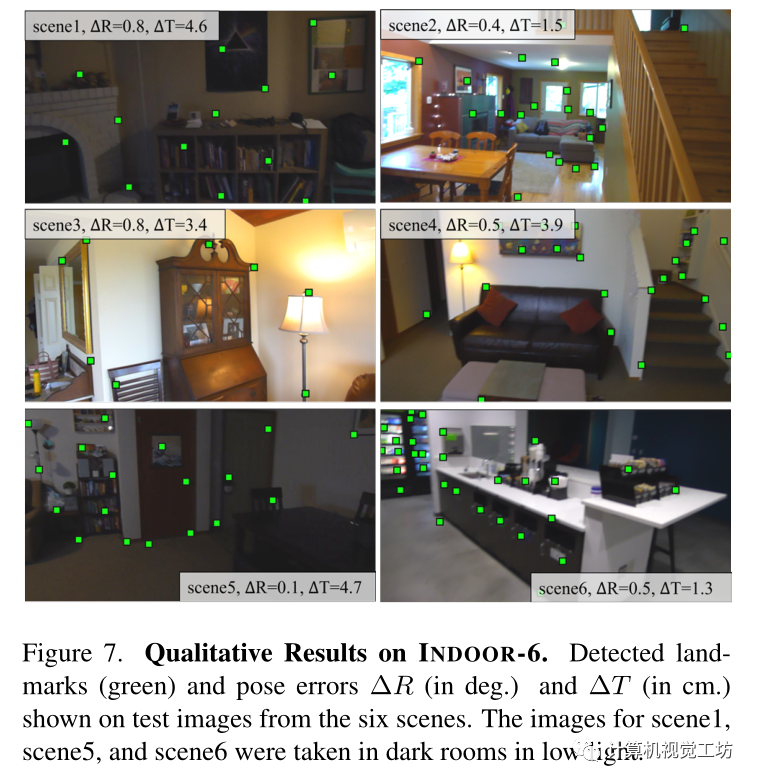

評(píng)估了單獨(dú)使用NBE, SLD,聯(lián)合使用NBE+SLD, NBE+SLD(E)(是更緊湊的網(wǎng)絡(luò)),和SOTA的基于分層定位方法結(jié)合HLoc+SLD Baseline為Posenet、DSAC、HLoc 在INDOOR-6數(shù)據(jù)集上的結(jié)果:

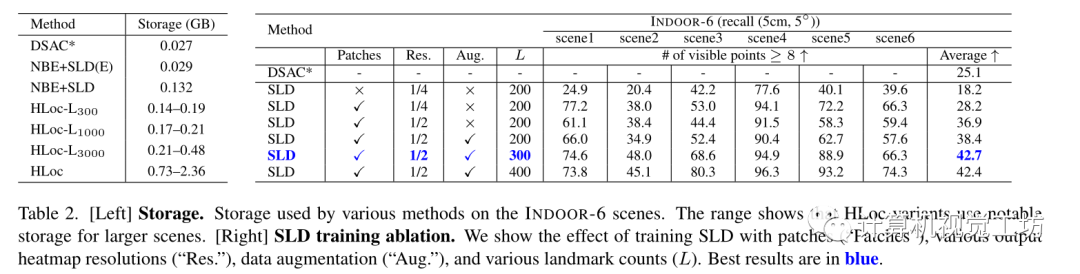

存儲(chǔ)比較和消融研究:

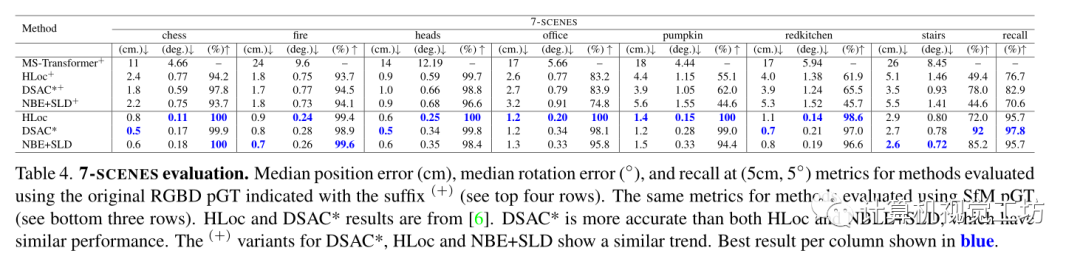

7Scenes數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果:

總結(jié):算法是一種存儲(chǔ)要求低但精度高的方法。主要見(jiàn)解是在人和物體姿態(tài)估計(jì)中廣泛用于關(guān)鍵點(diǎn)檢測(cè)的現(xiàn)代CNN架構(gòu)也適用于檢測(cè)顯著的、場(chǎng)景特定的3D landmark。 實(shí)驗(yàn)結(jié)果表明,其方法優(yōu)于以前的無(wú)存儲(chǔ)方法,但不如HLoc(頂級(jí)檢索和匹配方法之一)準(zhǔn)確,但是HLoc需要高存儲(chǔ)。而且基于landmark的2D–3D對(duì)應(yīng)關(guān)系補(bǔ)充了HLoc的對(duì)應(yīng)關(guān)系,并且在計(jì)算姿態(tài)之前結(jié)合這些對(duì)應(yīng)關(guān)系進(jìn)一步提高了HLoc精度。局限性:首先神經(jīng)網(wǎng)絡(luò)是特定于場(chǎng)景的,像其他學(xué)習(xí)方法一樣每個(gè)場(chǎng)景需要許多訓(xùn)練圖像,而且在使用之前需要仔細(xì)選擇場(chǎng)景l(fā)andmark集。

審核編輯 :李倩

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4772瀏覽量

100838 -

算法

+關(guān)注

關(guān)注

23文章

4615瀏覽量

92977 -

cnn

+關(guān)注

關(guān)注

3文章

352瀏覽量

22237

原文標(biāo)題:通過(guò)場(chǎng)景l(fā)andmark做定位的新思路(CVPR 2022)

文章出處:【微信號(hào):3D視覺(jué)工坊,微信公眾號(hào):3D視覺(jué)工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

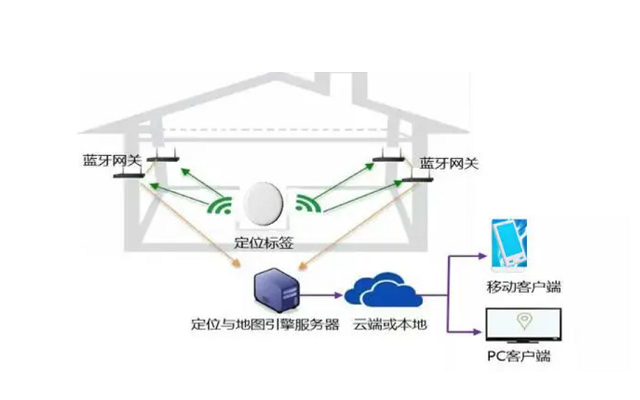

藍(lán)牙人員定位技術(shù):場(chǎng)景化應(yīng)用與優(yōu)勢(shì)分析

激光錫焊視覺(jué)定位技術(shù)的應(yīng)用場(chǎng)景

無(wú)線室內(nèi)定位系統(tǒng)是通過(guò)什么技術(shù)實(shí)現(xiàn)的呢?

單北斗定位終端的優(yōu)勢(shì)在哪些場(chǎng)景下更加凸顯

人員定位技術(shù)有哪些?10種人員定位技術(shù)原理及應(yīng)用場(chǎng)景介紹

電廠人員定位怎么做?分享電廠人員定位系統(tǒng)解決方案

園區(qū)人員定位怎么做?分享智慧園區(qū)人員定位系統(tǒng)解決方案

人員定位系統(tǒng)于不同場(chǎng)景的實(shí)際應(yīng)用

“技術(shù)故障”背刺巴菲特,金融大模型到底靠不靠譜?

OpenCV攜Orbbec 3D相機(jī)亮相CVPR 2024,加速AI視覺(jué)創(chuàng)新

北斗高精度定位手持終端在哪些場(chǎng)景中應(yīng)用

北斗高精度定位終端適用于什么行業(yè)場(chǎng)景

人員定位的行業(yè)應(yīng)用以及五種定位技術(shù)大盤(pán)點(diǎn)

藍(lán)牙信標(biāo)定位原理

通過(guò)場(chǎng)景l(fā)andmark做定位的新思路(CVPR 2022)

通過(guò)場(chǎng)景l(fā)andmark做定位的新思路(CVPR 2022)

評(píng)論