近年來,以深度學習模型為基礎的人工智能研究不斷取得突破性進展,但其大多具有黑盒性,不 利于人類認知推理過程,導致高性能的復雜算法、模型及系統普遍缺乏決策的透明度和可解釋性。在國 防、醫療、網絡與信息安全等對可解釋性要求嚴格的關鍵領域,推理方法的不可解釋性對推理結果及相關 回溯造成較大影響,因此,需要將可解釋性融入這些算法和系統中,通過顯式的可解釋知識推理輔助相關 預測任務,形成一個可靠的行為解釋機制。知識圖譜作為最新的知識表達方式之一,通過對語義網絡進行 建模,以結構化的形式描述客觀世界中實體及關系,被廣泛應用于知識推理。基于知識圖譜的知識推理在 離散符號表示的基礎上,通過推理路徑、邏輯規則等輔助手段,對推理過程進行解釋,為實現可解釋人工 智能提供重要途徑。針對可解釋知識圖譜推理這一領域進行了全面的綜述。闡述了可解釋人工智能和知識 推理相關概念。詳細介紹近年來可解釋知識圖譜推理方法的最新研究進展,從人工智能的 3 個研究范式角度 出發,總結了不同的知識圖譜推理方法。提出對可解釋的知識圖譜推理研究前景和未來研究方向。

1. 引 言

隨著信息技術的不斷發展,人工智能實現了 從能存會算的“計算智能”,到能聽會說、能看會 認的“感知智能”[1-3],再到下一階段具備理解、 推理和解釋能力的“認知智能”[4-6]的逐漸演變, 這 3 個階段的實現難度和價值同時逐次提升。然 而,在以深度學習為主導的人工智能技術中,大 多數的模型是不透明的,即模型在產生高精度結 果的同時,不能提供必要的解釋過程。模型的不 可解釋性嚴重影響了人們對模型決策的信任程 度,其可靠性和魯棒性均受到廣泛質疑[7],特別 在國防、醫療和網絡與信息安全等領域的許多關 鍵應用[8-11]中,保證系統所做出的決策具備透明 性和可解釋性是非常重要且必要的。

知識推理是人類智能活動的重要組成部分, 一直以來也是人工智能的核心研究內容之一。DeepMind 指出人工智能算法必須具備推理能力, 且推理過程需要依靠人的先驗知識[12],對推理的 結果形成必要的解釋。作為目前知識推理最新的 知識表達方式,知識圖譜[13]技術是一種實現可解 釋人工智能的可能解決方案[14],通過將不同數據 源中的數據統一結構,實現對多源信息的語義網 絡建模,為真實世界的各個推理任務提供概念、 關系和屬性等可解釋因素。

以安全領域的知識圖譜為例,該領域主要包 括網絡空間測繪圖譜、漏洞知識圖譜、惡意樣本 知識圖譜、攻擊路徑推理圖譜等。通過威脅建模 的方式,對多源異構的網絡安全領域信息進行加 工、處理、整合,轉化成為結構化的安全領域知 識庫,實現從威脅實體和關系的視角出發,識別威 脅以及對威脅進行評估。同時,在從圖譜海量數據 中挖掘、推理威脅的實體相關信息過程中,只有通 過可解釋的知識推理方法,才能進一步為推理結果 的安全可靠提供保證,提高威脅分析的效率。

在長期的研究和實踐過程中,研究人員相繼 總結了有關知識圖譜推理的不同技術,并嘗試從 不同的角度(如推理長度[15]、分布式表示[16]、圖 嵌入[17])對推理模型進行綜述。然而,對于推理 模型的可解釋性則缺少相關的總結與對比。同時, 人工智能的可解釋性越來越受到人們的重視,可 解釋知識推理在近幾年的學術界和工業界中逐漸 成為關注熱點,知識推理領域缺少較為全面且詳 細的針對可解釋知識圖譜推理的綜述文章。

本文通過廣泛整理與可解釋知識圖譜推理相 關的文獻,在介紹相關知識推理的基本概念及可 解釋性定義的基礎上,從人工智能研究范式的角 度出發,詳細闡述符號主義中的可解釋知識圖譜 推理方法、行為主義中的可解釋知識圖譜推理方 法、連接主義中的可解釋知識圖譜推理方法和新 型混合的可解釋知識圖譜推理方法,詳細說明了 在不同場景下,各類可解釋知識圖譜推理方法的 核心思想及改進過程。本文還討論了可解釋知識 圖譜推理的未來研究方向及前景。

1 可解釋的知識圖譜推理概述

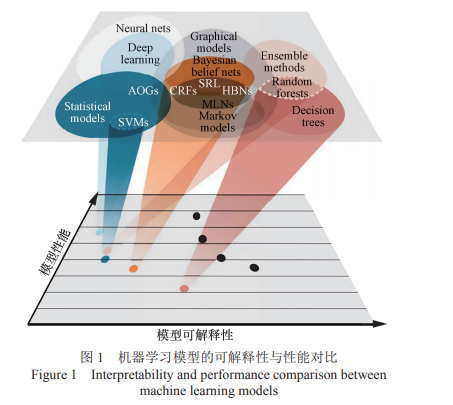

1.1 可解釋性的定義

目前業界較為認可的可解釋性定義為“可解 釋性是一種以人類認識、理解的方式給人類提供 解釋的能力”[5]。雖然人工智能技術不斷取得突破性進展,高 性能的復雜算法、模型及系統卻普遍無法向人類 用戶解釋它們的自主決策和行為,缺乏決策邏輯 的可解釋性[18]。如圖 1 所示,很多機器學習方法 在模型性能和可解釋性之間存在不平衡現象,往 往模型越復雜越難以解釋[14],這對模型后期的應 用和優化產生很大的影響,因此人們大多基于經 驗來調整模型參數以達到優化模型的目的[19],然 后通過觀察結果來判定操作的正確與否,充滿盲 目性與隨機性,忽略了模型可解釋性的重要性。

可解釋性對于用戶有效地理解、信任和管 理人工智能應用至關重要[6],它與深度神經網 絡中“黑匣子”的概念形成鮮明對比。不可解 釋的模型在實踐中經常出現難以預測正確結果 的情況,這在低風險的環境中,不會造成嚴重 后果(如視頻推薦系統),而對于可靠性要求較 高的系統則很危險[20](如醫療、法律和信息安 全領域),模型必須解釋如何獲得相關預測。可 解釋人工智能(XAI,explainable artificial intelligence)則提供了一種信任的基礎,在此基 礎上,人工智能才能在更大范圍發揮作用,有助 于識別潛在的錯誤,進而改進模型[4],提高信息 服務質量,滿足道德和法律的規范要求,為用戶 提供更智能的服務。

1.2 知識圖譜及相關推理任務

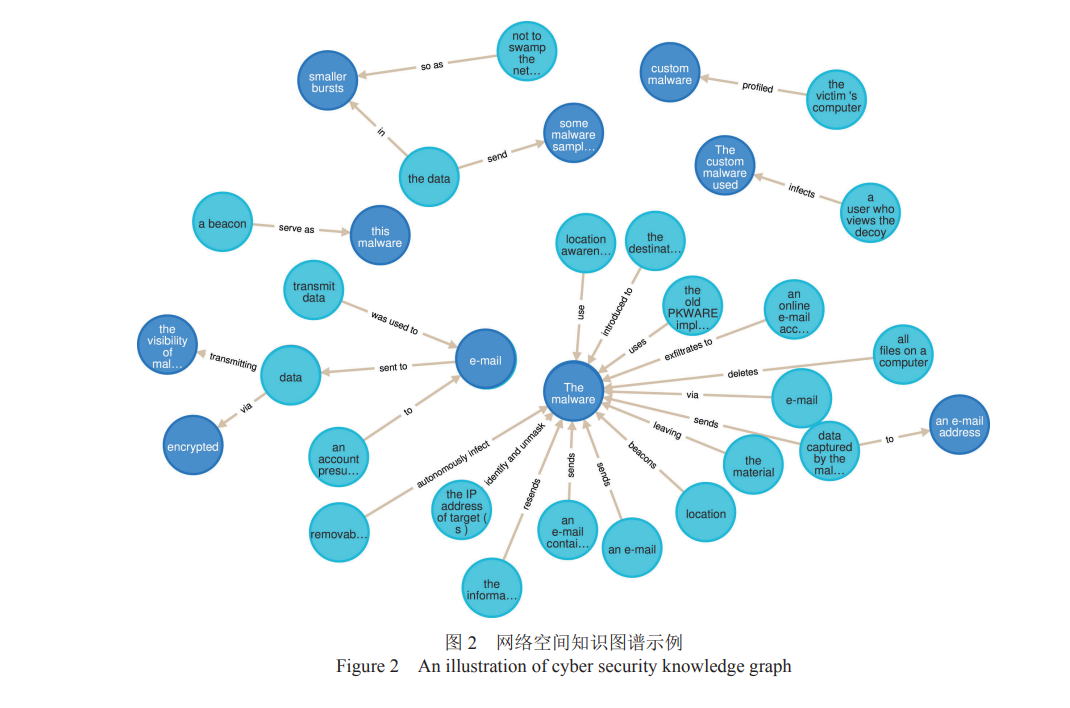

知識圖譜是人工智能的核心技術之一[13],作為 一種新型的知識表示方法,知識圖譜中包含大量的 先驗知識,并以結構化三元組的形式組織海量信息, 通過實體和關系的形式將不同的數據源進行關聯和 深度融合。目前,大量的知識圖譜,如 Yago[21]、 Dbpedia[22]和 Freebase[23]已經開發,相關技術已被廣 泛應用在智能問答[24]、推薦系統[25]和信息安全[26]等 任務中,其突出表現在學術界與工業界均獲得了廣 泛關注[27-28]。網絡空間知識圖譜示例[29]如圖 2 所示。

知識推理[15]則是從已知的知識出發,經過推 理挖掘,從中獲取所蘊含的新事實,或者對大量 已有知識進行歸納,從個體知識推廣到一般性知 識的過程。早期的推理研究大多在邏輯描述與知 識工程領域,很多學者提倡用形式化的方法來描 述客觀世界,認為一切推理是基于已有的邏輯知 識,如一階邏輯和謂詞邏輯,如何從已知的命題 和謂詞中得出正確的結論一直是研究的重點。近 些年,隨著互聯網數據規模的爆炸式增長,傳統 的基于人工建立知識庫的方法不能適應大數據時 代對大量知識的挖掘需求。數據驅動的推理方法 逐漸成為知識推理研究的主流[30]。面向知識圖譜的知識推理即在知識圖譜的圖 結構上,結合概念、屬性和關系等知識,通過相 關推理技術,進行知識推理的過程。知識圖譜中 所包含的概念、屬性和關系天然可用于解釋[31-32], 且更符合人類對于解釋的認知,方便為真實世界 的推理和解釋場景進行直觀建模,因此當前基于 知識圖譜的知識推理方法成為知識推理領域的典 型代表。下文中的“知識推理”如未加特別說明, 特指“面向知識圖譜的知識推理”。

知識圖譜推理任務主要包括知識圖譜補全和 知識圖譜去噪。前者是通過推斷出新的事實,擴 充知識圖譜,包括實體預測、關系預測、屬性預 測等任務。其中最為核心的任務是實體預測和關 系預測,實體預測是指利用給定的頭實體和關系 (或者關系和尾實體)找出有效三元組的尾實體 (頭實體);關系預測是指通過給定頭實體和尾實 體,推理出兩者間的關系。后者關注圖譜中已知 的知識,對于已經構建的圖譜中三元組的正誤進 行評判,但從本質上來講,兩者其實是在評估三 元組的有效性。除此之外,知識推理在下游的信 息檢索、智能問答和推薦系統中也發揮著重要的 作用,在智慧醫療、網絡與信息安全等領域顯現 出良好的應用場景[27-28]。

1.3 基于知識圖譜的可解釋知識推理

知識推理的可解釋性或者可解釋的知識推理, 是人工智能可解釋性的子問題[33]。與研究深度學習 算法的可解釋性不同,可解釋知識推理的目的是從 已知的知識出發,經過可解釋的推理方法,最終獲 取知識庫中蘊含的新知識。目前基于知識圖譜的可解釋知識推理是該領域前沿的研究方向之一,其在 可解釋知識推理上有諸多優勢,具體如下。首先,知識圖譜在表示模式上具有可解釋優 勢。知識表示是為描述世界所做的一組約定,是 知識的符號化、形式化或模型化的過程。常見的 知識表示方法包括謂詞邏輯表示法、產生式表示 法和分布式知識表示法等,作為一種新型的知識 表示方法,相對于這些傳統的知識表示方法,如 產生式表示法,知識圖譜具有語義豐富、結構友 好、知識組織結構易于理解的優點。

其次,基于知識圖譜的推理在推理過程中具 有可解釋的優勢。人類認識世界、理解事物的過 程,大多是在利用概念、屬性、關系進行理解和 認知,如對于問題“為什么鳥兒會飛?”,人類的 解釋可能是“鳥兒有翅膀”,這實質上使用了屬性 來解釋。知識圖譜中富含實體、概念、屬性、關 系等信息,通過圖結構形式化組織這些海量的知 識,為真實世界的各個推理場景直觀建模,可以 對最終的決策進行更多元的具體解釋。

最后,知識圖譜在存儲和使用上具有可解釋 的優勢,相比其他的存儲形式,知識圖譜以三元 組的形式對知識進行構建以及存儲,更加接近人 類通常認識事物“主謂賓”的認知和學習習慣, 對于人類理解會更加友好,對人們的可解釋性相 比其他知識表示方法較強[19]。

1.4 知識推理任務的評價指標

1.4.1 知識推理可解釋性的評價指標

本文采用的知識推理的可解釋性評價指標 如下。

(1)可解釋的范圍

根據模型產生的可解釋性范圍,可解釋性分 為局部可解釋和全局可解釋,即解釋是面向某個 或某類實例還是面向整個模型行為。

(2)可解釋的產生方式

根據模型解釋產生的方法,推理模型可以分 為事前可解釋和事后可解釋。其中,事前可解釋 主要指不需要額外輔助的解釋方法,解釋本身就 在自身的模型架構中,而事后可解釋指解釋本身 不在模型架構中,而是在模型訓練后,以人類可 理解的規則或可視化等方式,對模型做出決策的 邏輯過程進行后驗的解釋。

(3)可解釋的泛化性 根據解釋方法是否特定于模型,可以劃分為 特定于模型和與模型無關兩種解釋類別。

(4)可解釋在下游場景的適用性 根據下游實際業務需求對于知識推理方 法的可解釋性的要求,可以將推理方法分為適 用于可靠性優先領域(如醫療、網絡與信息安 全領域)和適用于效率優先領域(如電影推薦 系統)。本文在接下來綜述方法時,每類方法 根據以上 4 種評價指標對模型的可解釋性進行 對比分析。

1.4.2 知識推理準確性的評價指標

本文采用的知識推理的準確性評價指標包括 平均倒數排名(MRR,mean reciprocal rank)和 前 k 次命中正確預測結果的比例(Hit@k)。

2 可解釋的知識圖譜推理方法

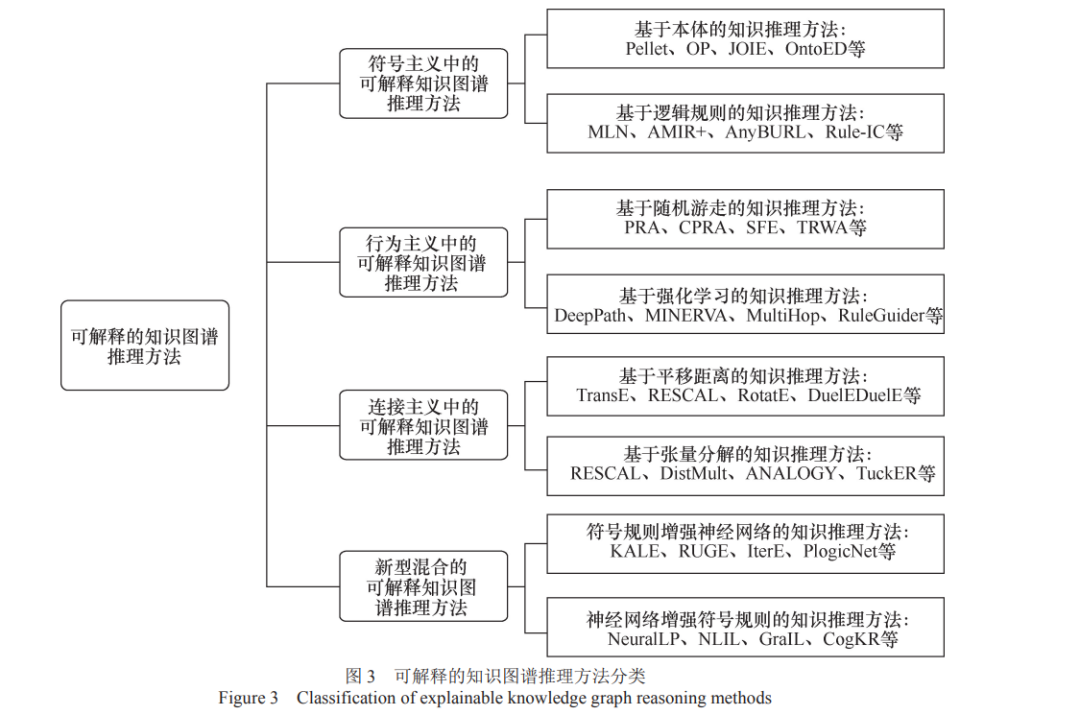

推動人工智能發展的 3 種主要研究范式(符 號主義、行為主義和連接主義),對知識圖譜推理 方法都有著很大的影響,但三者在研究方法和技 術路線等方面有著不同的觀點,導致不同研究范 式影響下的知識推理方法在可解釋性與效率上存 在不同的側重,所適用的應用場景有所差異。如 圖 3 所示,本文從這 3 種研究范式角度出發,結 合目前新型混合的知識圖譜推理技術,分別綜述 這些分類中最新的可解釋知識圖譜推理方法研究 進展。

2.1 符號主義中的可解釋知識圖譜推理方法

從符號主義角度,知識推理可以建模為依據 符號表征的一系列明確推論,通過顯式的定義推 理所需要的本體概念、規則等離散符號,進行邏 輯推理的過程。其核心是從實例中推導出一般的 本體演繹關系或邏輯規則,通過符號體系進行推理,同時,這些符號體系為推理結果提供顯式的 解釋。根據知識圖譜本體概念層和實體實例層的 劃分,符號推理方法可以分為基于本體的知識推 理和基于邏輯規則的知識推理,接下來分別介紹 其中有代表性的可解釋知識推理方法。

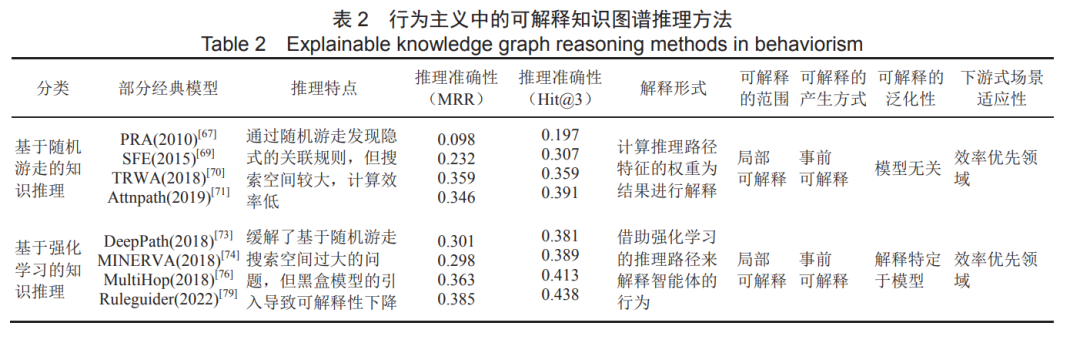

2.2 行為主義中的可解釋知識圖譜推理方法

從行為主義角度,知識圖譜推理可以建模為 在圖結構上通過多步游走,同時對每一步進行預 見和控制,通過序列決策逐步找到推理答案的過 程,其核心是實現知識圖譜圖結構上的多跳推理。該類方法在得到推理結果的同時,顯式地推導出 具體的路徑推導過程,因此可解釋性較強。該研究領域有兩個主要方向,分別是基于隨 機游走和基于強化學習的知識圖譜推理方法。基 于隨機游走的知識圖譜推理方法在圖結構上利用 隨機游走策略,結合合適的圖搜索算法獲取多條 路徑,利用這些路徑的特征預測實體間是否存在 潛在的關系;基于強化學習的知識圖譜推理方法 則通過智能體與環境不斷進行交互,以反饋和交 互的方式訓練智能體,在動作選擇和狀態更新的 動態過程中逐漸優化目標,進而實現知識推理。

2.3 連接主義中的可解釋知識圖譜推理方法

從連接主義角度,知識圖譜中的實體和關系 可以通過表示學習方法嵌入低維向量空間,進行 數值化的運算操作,進而實現知識推理。其核心是找到一種映射函數,將符號表示映射到向量空 間進行數值表示,從而減少維數災難,同時捕捉 實體和關系之間的隱式關聯,實現符號表示向量 化的直接計算。在語義的層面,很多淺層的表示模型在提升 效率的同時,考慮建模不同的關系模式(如對稱 關系、逆反關系和組合關系)、邏輯操作(如與、 或、非操作)和實體間的上下位層次關系,使模 型具有推理部分語義結構的能力,因此,連接主 義中的部分推理模型具有一定的可解釋性。該類 方法大體可以分為 3 種,分別是基于平移距離的 模型、基于張量分解的模型和基于神經網絡的模 型,本文重點對方法的可解釋性進行對比分析。

2.4 新型混合的可解釋知識圖譜推理方法

主流的挖掘隱式特征的嵌入學習模型 (TransE[87]、RotatE[91]等),提升了模型的推理效 率,但極大地影響了模型的可解釋性。基于圖遍 歷搜索的顯式邏輯規則挖掘方法(AMIE+[52]、 RDF2Rule[53]等)在提升推理過程可解釋性的同 時,效率方面有明顯的欠缺。因此,通過結合兩 者的優勢,利用符號推理在可解釋性和準確性上 的優勢以及神經網絡方法在魯棒性與效率上的優 勢,進行混合推理[113],可以一定程度解決傳統規 則方法的計算復雜度高等難題,同時提升神經網 絡方法的可解釋性。根據推理的不同側重點,可 以將新型的混合推理方法分為符號規則增強神經 網絡的知識推理和神經網絡增強符號規則的知識 推理。

3 結 束 語

隨著人工智能技術的廣泛應用,人工智能的 可解釋性受到越來越多的關注。在目前流行的深 度學習模型中,復雜的處理機制與大量的參數使 人類很難追溯與理解其推理過程,導致這種端到 端的黑箱學習方法可解釋性較差。知識圖譜作為知識的一種語義化和結構化的表達方式,以人類 可理解的表達形式進行知識推理,通過推理路徑、 邏輯規則等輔助手段,結合節點周圍的實體信息, 進行顯式的可解釋知識圖譜推理,為實現可解釋 人工智能提供了一種解決方案,在信息檢索、信 息安全、網絡空間安全等領域都有廣泛的應用前 景,引發了廣泛的關注。

3.1 可解釋的知識圖譜推理方法總結

本文概述了可解釋人工智能及知識推理的相 關概念,從經典的人工智能三大研究范式的角度 出發,總結和分析了可解釋的知識推理方法。無 論是以符號主義中的本體推理和規則推理方法為 代表的具有全局模型可解釋性的模型,還是通過 將推理過程顯式地進行學習(具體表現為證明、 關系路徑和邏輯規則等方式),從而為推理預測提 供可解釋性依據的具有事后過程可解釋性的模 型,都一定程度增強了人們對推理結果的理解, 同時實現對錯誤預測原因的輔助挖掘。如表 7 所示,本文對所介紹的知識圖譜推理 方法及特點進行相關的總結與對比分析。這些推 理方法根據推理目的不同,在推理準確性和可解 釋性方面各有側重,所適用的推理應用場景也因 此不同。符號主義中的知識推理模型有著很好的 可解釋性,推理準確、遷移性好。然而,離散的 符號表示方法通常不足以描述數據之間所有內在 關系,造成規則學習的搜索空間太大、效率較低, 且對數據中出現的噪聲魯棒性較差(如 AMIE+[52]、RDF2Rule[53]),因此這種推理方法適 用于數據庫知識結構規整,要求推理精度及可解 釋程度較高的推理場景,如醫療和信息安全等要 求可靠性優先的領域。在行為主義中的知識推理 模型中,以強化學習為代表,通過反饋和交互訓 練智能體,鼓勵獲得更大的獎勵,實現了較高的 推理效率,同時得到具體的推理路徑,可解釋性 雖然相較于邏輯規則有所降低,但得到了具體的 推理步驟,具有過程的可解釋性(如 DeepPath[73]、 MINERVA[74]),因此這種推理方法更適用針對序 列決策問題的多跳知識推理場景,如網絡安全領 域的攻擊路徑推理圖譜,推理效率和可解釋性均 有較大的優勢。在連接主義中的知識推理模型中, 通過數值化運算實現的模糊推理,加快了推理的速度,增強了模型的魯棒性和推理效率,但不能 為預測結果提供顯式的推理過程說明,對模型的 可解釋性造成了很大影響(如 TransE[87] 、 RotatE[91]),憑借其效率和魯棒性的優勢,這種推 理方法適用在低風險但效率要求較高的效率優先 領域,如電影推薦系統與問答系統等。在新型混 合的推理模型中,結合符號推理在可解釋性上的 優勢和神經網絡推理在魯棒性與效率上的優勢進 行的新型混合推理,無論是利用邏輯規則生成更 多實例,輔助高質量嵌入學習,還是通過神經網 絡模型輔助解決數據的歧義和不確定性,幫助歸 納出更多的顯式邏輯規則,推理的可解釋性和效 率都得到了提升(如 IterE[117]、RNNLogic[140]), 這種推理方法則更加需要結合系統及應用需求, 根據目標任務要求的效率或可解釋性等指標的不 同,動態調整對應神經網絡推理方法和符號推理 方法的側重點,有針對性地進行推理。

3.2 有待進一步解決的問題和挑戰

雖然目前可解釋的知識圖譜推理方法在不同 的研究范式下都取得了一定進展,但該領域仍處 于發展時期,各類方法在推理的準確性和推理過 程的可解釋性上很難達到平衡,需要在理論和實 際應用中進一步完善,在未來的研究中,可解釋 的知識推理還面臨很多新的挑戰,主要有以下 4 個 方面值得探索。

1) 結合常識知識的可解釋推理。常識推理即 利用人類對世界和行為基本理解的常識認知進行 推理。結合目前人類在深度學習方面的進展,表征并融入常識知識于推理模型,從而創造更加貼 近人類思維習慣的模型,將從本質上增加模型行 為的透明度,幫助人們獲得更具可解釋性的結果。

2) 考慮復雜推理模式的可解釋知識推理。在 知識邏輯推理中,推理的規則主要遵循傳遞性約 束,即鏈狀的推理,表達能力有限。但是現實生 活中所要面臨的要素更加復雜,需要支持更復雜 推理模式,自適應地挖掘更多樣、有效的推理結構, 如實現對樹狀或網狀等結構的邏輯規則推理[130], 同時保證挖掘規則的可靠性和可解釋性,輔助更 多樣的決策。

3) 多模態的可解釋知識推理。解釋方法大多 通過推理文本中的邏輯規則或路徑從而實現可解 釋性,但隨著移動通信技術的快速發展,如何有 效地利用語音、圖片等多模態信息進行解釋成為 一個具有挑戰性的問題[141]。多模態信息顯示出其 對知識圖譜進行可解釋推理的潛力,可以通過圖 像、聲音等多種模態對于推理的過程與結果進行 語義增強的解釋。

4) 可解釋性的量化度量指標。對于可解釋性 的優劣并不存在非常成熟的、廣為接受的量化標 準。大多數已有的方法是主觀度量,因而只能定 性分析,無法對可解釋模型的性能進行量化。這就造成用戶無法非常準確地判斷解釋方法的 優劣[142],所以需要進一步研究科學合理的可解釋 的評測指標,對解釋方法進行量化評價,模型 得到反饋并進行相關優化,從而更好地指導系 統的決策。

審核編輯 :李倩

-

人工智能

+關注

關注

1791文章

47208瀏覽量

238294 -

知識圖譜

+關注

關注

2文章

132瀏覽量

7704

原文標題:「可解釋知識圖譜推理」最新方法綜述

文章出處:【微信號:AI智勝未來,微信公眾號:AI智勝未來】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

大華股份榮獲2024年中國創新方法大賽一等獎

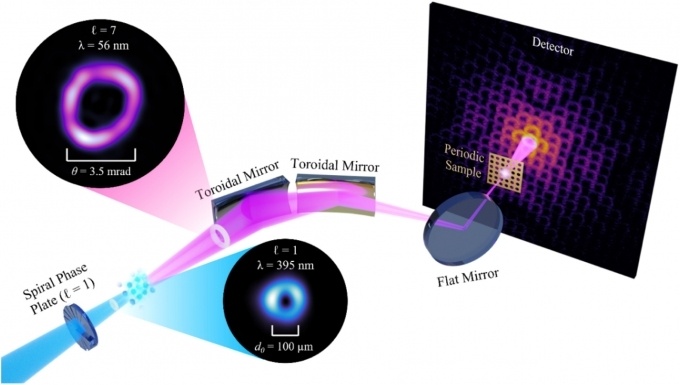

利用全息技術在硅晶圓內部制造納米結構的新方法

高效大模型的推理綜述

三星自主研發知識圖譜技術,強化Galaxy AI用戶體驗與數據安全

一種無透鏡成像的新方法

三星電子將收購英國知識圖譜技術初創企業

知識圖譜與大模型之間的關系

【大語言模型:原理與工程實踐】核心技術綜述

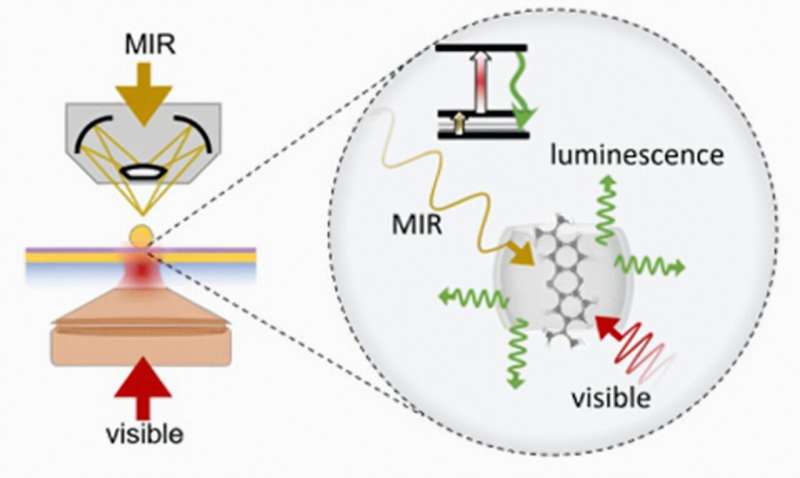

使隱形可見:新方法可在室溫下探測中紅外光

利用知識圖譜與Llama-Index技術構建大模型驅動的RAG系統(下)

知識圖譜基礎知識應用和學術前沿趨勢

「可解釋知識圖譜推理」最新方法綜述

「可解釋知識圖譜推理」最新方法綜述

評論