介紹

人工智能 (AI) 領域準備進入一個新的領域——機器從補充人類用戶的工具轉變為自主智能代理,可以設定自己的目標,決定學習什么,決定如何學習,和更多。高度智能系統改變世界的潛力類似于以往工業革命帶來的變化。問題不是智能系統是否會繼續改變我們的生活;而是 問題是以什么方式和在什么程度上。

什么是人工智能安全工程?

AI Safety Engineering(或簡稱“AI Safety”)是一個擬議的 AI 開發框架,它將機器倫理學與心理學、經濟學、金融學和其他領域相結合,以:

擴大對機器倫理的討論,以包括狹義的、一般的和超人的智能

將最近和正在進行的人工智能倫理討論與開發具有通用智能的機器的可用工程指南、流程和標準聯系起來

針對智能系統中已知和潛在漏洞的來源

作為一個新興的研究領域,人工智能安全的出現有幾個原因。首先,人工智能的成功不僅僅以實現目標來衡量;成功的人工智能是以符合人類價值觀和偏好的方式實現目標的人工智能。回顧 60 多年的 AI 發展,我們可以看到機器目標與人類價值觀和偏好之間的不一致遲早會導致 AI 失敗。正如本系列中所探討的那樣,將這種失調作為一個關鍵漏洞是開發安全人工智能的核心。

其次,人工智能的最新進展已經開始達到人工狹義智能系統的邊界,這些系統在給定的上下文中執行單一或狹義定義的任務。傳感器、大數據、處理,尤其是機器學習方面的進步使這些系統越來越像人類,并擴展了它們的能力和用途。考慮到這一點,達到人工智能的下一個層次——通用人工智能——即將到來,如果安全人工智能不是優先考慮的潛在后果也是如此。

Safe AI 的核心是假設通用人工智能會給人類帶來風險。AI Safety 不是通過嘗試在任務或目標級別將人類價值觀和偏好傳授給機器來解決這個問題——這可能是不可能的壯舉——AI Safety 旨在:

以符合人類能力和/或

優先考慮人類福利、合作行為和為人類服務

這樣做,我們將確保人工智能流程和目標在宏觀層面尊重人類,而不是試圖在微觀層面實現同樣的目標——讓機器傾向于對我們友好,作為智能核心的一部分。

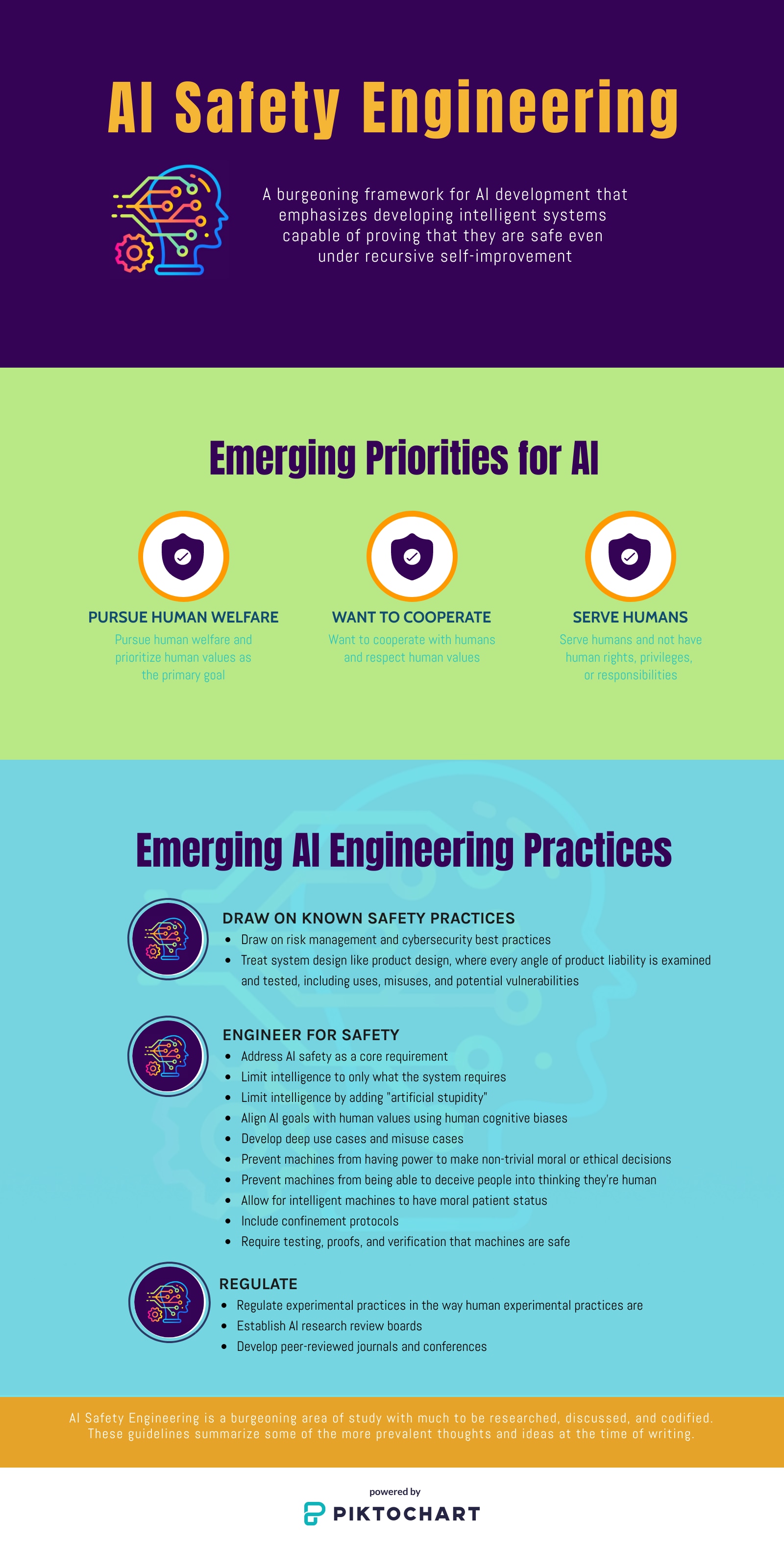

作為一種工程開發理念,AI Safety 將 AI 系統設計視為產品設計,對產品責任的每個角度進行檢查和測試,包括使用、誤用和潛在漏洞。圖 1說明了 AI Safety 的新興原則和建議。

圖 1:AI 安全工程強調開發智能系統,即使在遞歸自我改進的情況下也能證明它們是安全的。

在本系列中領先

AI 安全工程是一門新興學科,有很多需要研究、討論和編纂的內容。貿澤電子很高興推出這個博客系列,讓 AI 工程師了解關鍵概念并鼓勵參與其持續開發:

本系列的第 2 部分重點介紹了我們從過去 60 多年的 AI 開發中學到的經驗,即 AI 失敗的原因是機器目標與人類價值觀和偏好之間的不一致。它還討論了為什么將人類價值觀和偏好傳授給機器是一個無法解決的問題,并指出了安全人工智能的必要性。

第 3 部分討論了需要 AI 安全的另一個原因:AI 的進步正在突破人工狹義智能 (ANI) 系統的界限,并將人工智能 (AGI) 納入視野。

第 4 部分探討了實施 AI 安全的其他挑戰:不可預測性、不可解釋性和不可理解性。

第 5 部分描述了 AI 安全將改變工程的方式。開發深入用戶價值核心的用例和檢查情報漏洞是這里的兩個關鍵主題。

第 6 部分以關于使用“人工愚蠢”來幫助我們開發安全人工智能的討論作為結尾。限制機器能力以及理解認知偏差是這里的關鍵主題。

審核編輯hhy

-

AI

+關注

關注

87文章

30747瀏覽量

268900 -

人工智能

+關注

關注

1791文章

47200瀏覽量

238270

發布評論請先 登錄

相關推薦

初創公司SEA.AI利用NVIDIA邊緣AI和計算機視覺技術變革航海安全系統

為什么加速數據處理對各行各業的AI創新都至關重要

智譜AI與OpenAI、谷歌等簽署AI安全承諾

英國AI安全研究所推出AI模型安全評估平臺

亞馬遜云科技宣布生成式AI助手Amazon Q正式可用 激活企業內部數據并加速軟件開發

開發者手機 AI - 目標識別 demo

NanoEdge AI的技術原理、應用場景及優勢

智慧路燈桿AI監測應用,讓高速出行更安全

是德科技推出AI數據中心測試平臺旨在加速AI/ML網絡驗證和優化的創新

可用指南旨在使 AI 更安全

可用指南旨在使 AI 更安全

評論