PaLI-17B 在多個 benchmark 上都達到了 SOTA。

語言和視覺任務的建模中,更大的神經網絡模型能獲得更好的結果,幾乎已經是共識。在語言方面,T5、GPT-3、Megatron-Turing、GLAM、Chinchilla 和 PaLM 等模型顯示出了在大文本數據上訓練大型 transformer 的明顯優勢。視覺方面,CNN、視覺 transformer 和其他模型都從大模型中取得了很好的結果。language-and-vision 建模也是類似的情況,如 SimVLM、Florence、CoCa、GIT、BEiT 和 Flamingo。

在這篇論文中,來自谷歌的研究者通過一個名為 PaLI (Pathways Language and Image)的模型來延續這一方向的研究。

PaLI: A Jointly-Scaled Multilingual Language-Image Model

論文:https://arxiv.org/abs/2209.06794

PaLI 使用單獨 “Image-and-text to text” 接口執行很多圖像、語言以及 "圖像 + 語言" 任務。PaLI 的關鍵結構之一是重復使用大型單模態 backbone 進行語言和視覺建模,以遷移現有能力并降低訓練成本。

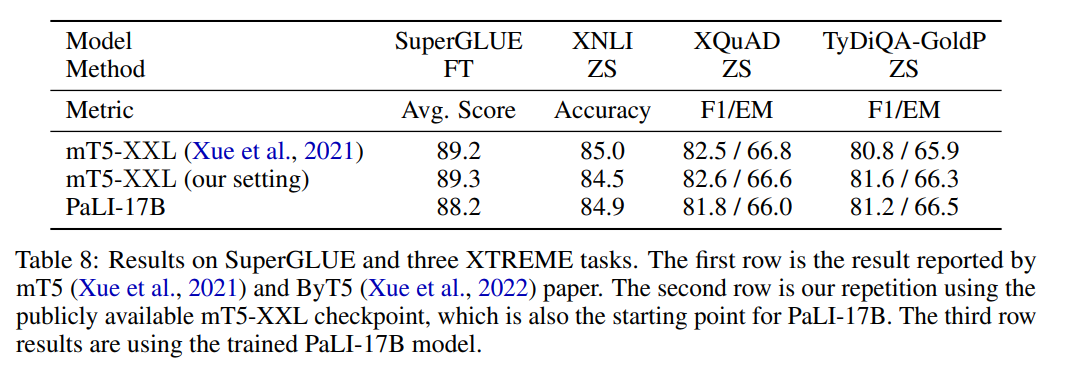

在語言方面,作者復用有 13B 參數的 mT5-XXL。mT5-XXL 已經把語言理解和泛化能力一體打包。作者通過實驗證明這些功能可以維護并擴展到多模態情況。

在視覺方面,除復用 2B 參數 ViT-G 模型外,作者還訓練了擁有 4B 參數的模型 ViT-e("enormous")。ViT-e 在圖像任務上表現出很好的性能(ImageNet 上準確率達到 90.9%;ObjectNet 準確率達到 84.9%)。

作者發現了聯合 scaling 視覺和語言組件的好處,視覺提供了更好的投入回報(每個參數 / FLOP 帶來的準確度提升)。實驗結果表明,最大的 PaLI 模型——PaLI-17B 在兩種任務模式下表現相對平衡,ViT-e 模型約占總參數的 25%。而先前的大規模視覺和語言建模工作,情況并非總是如此(Wang 等人,2022a;Alayrac 等人,2022),因為視覺和語言 backbone 之間的先驗量表并不匹配。

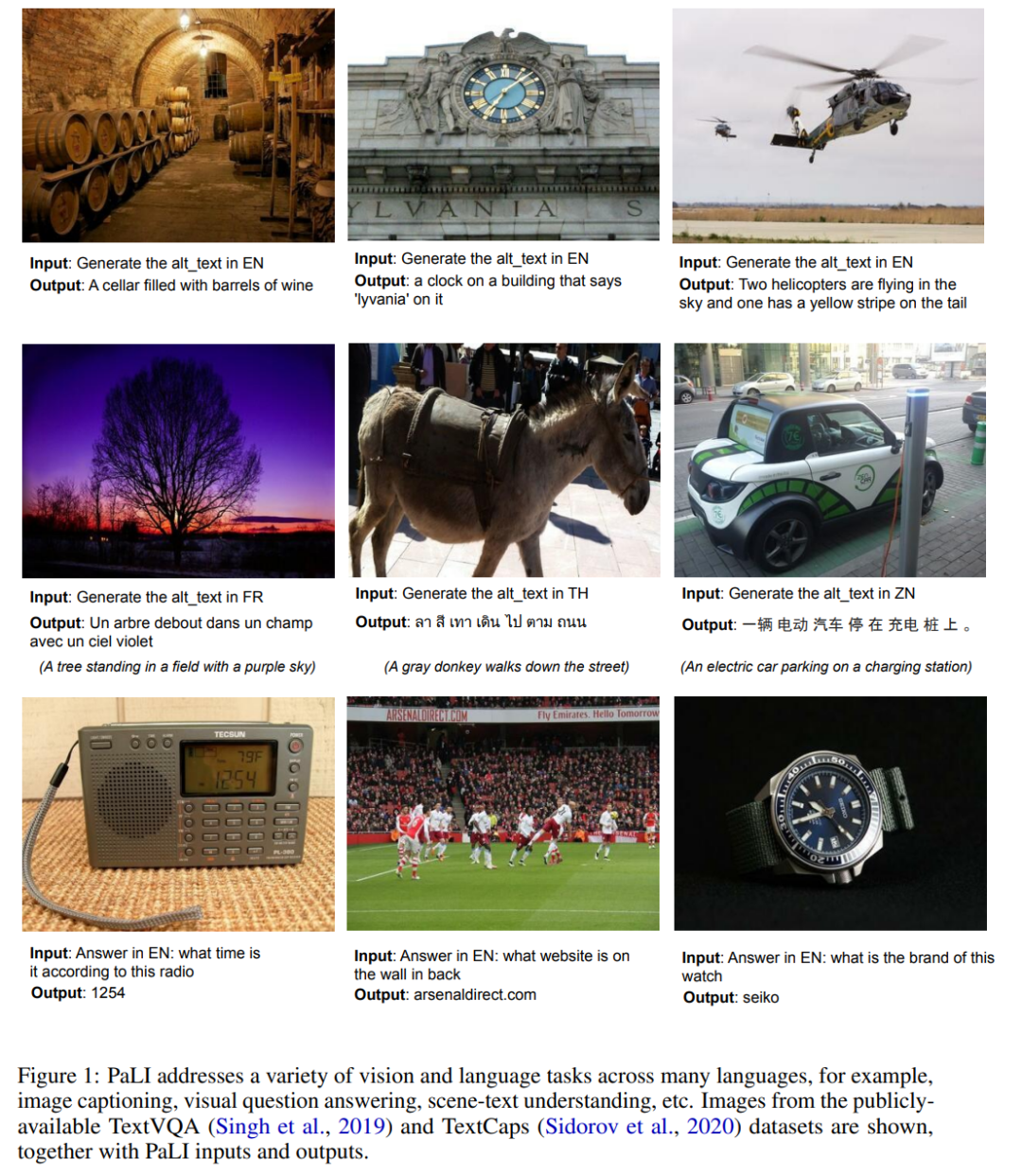

作者通過將多個圖像和 (或) 語言任務轉換為廣義的類似 VQA 的任務,實現它們之間的知識共享。使用 “image+query to answer” 來構建所有任務,其中檢索和回答都表示為文本標記。這使得 PaLI 能夠使用跨任務的遷移學習,并在廣泛的視覺和語言問題中增強 language-and-image 理解能力:圖像描述、視覺問答、場景文本理解等(如圖 1 所示)。

為了訓練 PaLI-17B,作者構建了全新的大容量 image-and-language 數據集 WebLI,包含 10B 的圖文對數據,WebLI 數據集包含 100 多種語言的文本。通過訓練模型用多種語言執行多模態任務,這大大增加了任務的多樣性,并測試了模型在跨任務和跨語言之間有效擴展的能力。作者也提供了數據卡來介紹有關 WebLI 及其構造的信息。

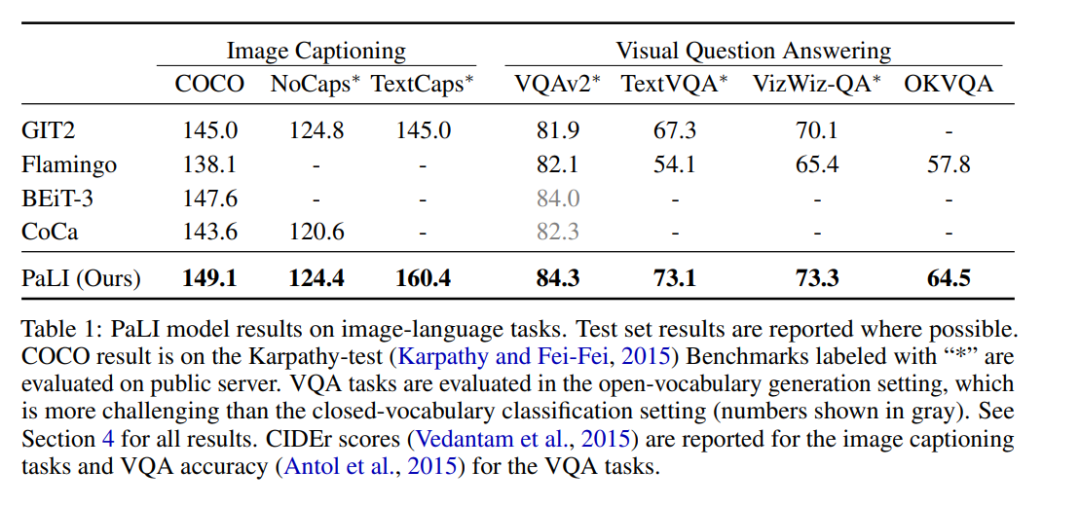

PaLI-17B 在多個 benchmark 上都達到了 SOTA,表現優于某些強大的模型(見表 1)。

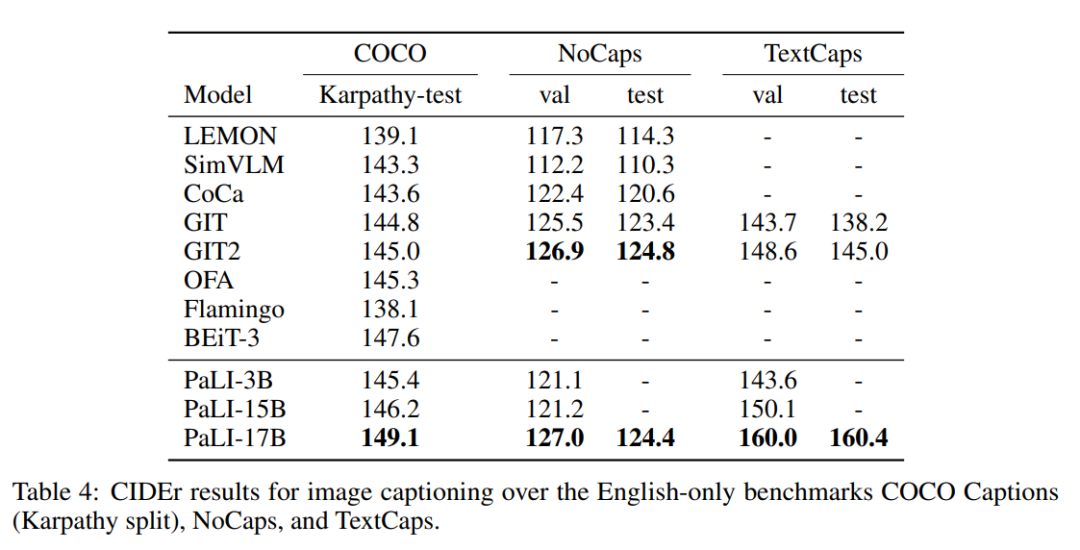

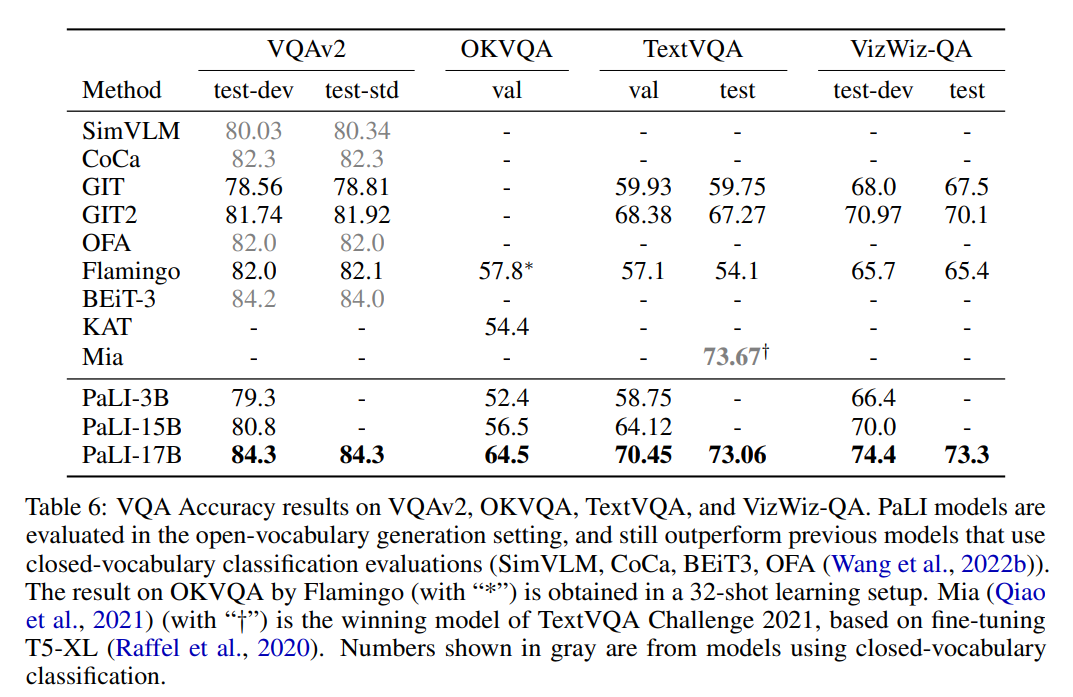

具體來說,PaLI 在 COCO 數據集 benchmark 上的表現優于多數新舊模型,在 Karpaty 分割上的得分為 149.1。PaLI 在 VQAv2 上使用類似 Flamingo 的開放詞匯文本生成的設置達到 84.3% 的最新 SOTA,該結果甚至優于在固定詞匯分類環境中評估的模型,例如 CoCa、SimVLM、BEiT-3。作者的工作為未來的多模態模型提供了 scaling 路線圖。Model scaling 對于多語言環境中的語言圖像理解特別重要。作者的結果支持這樣一個結論:與其他替代方案相比,scaling 每個模式的組件會產生更好的性能。

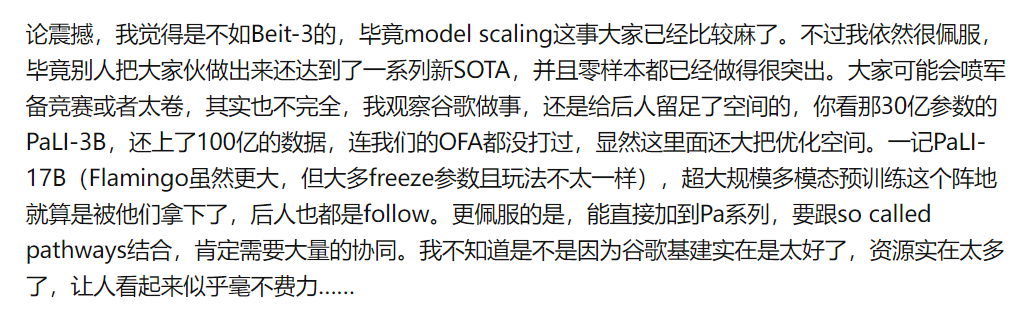

這篇文章在知乎上引發了一些討論。有人感嘆說,「剛要匯報 beit3,隨便一刷知乎,又被超了」(引自知乎用戶 @走遍山水路)。還有人認為,論震撼程度,PaLI 比不上 BEiT-3,「畢竟 model scaling 這事大家已經比較麻了」。但「谷歌把這個大家伙做出來了,還達到了一系列新 SOTA,并且零樣本都已經做得很突出,還是非常令人敬佩」(引自知乎用戶 @霜清老人)。

來自知乎用戶 @霜清老人的評價。鏈接:https://www.zhihu.com/question/553801955?utm_source

以下是論文細節。

模型架構

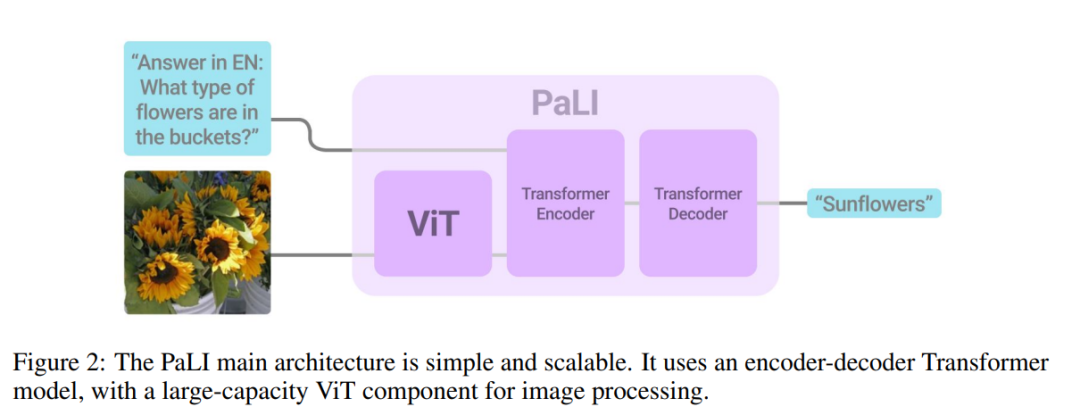

作者使用 PaLI 的目的是執行單模態(語言、視覺)和多模態(語言和視覺)任務。這些任務中的許多任務最好由不同的模型處理。如圖像分類及許多 VQA 需要從固定集合中預測元素,而 language-only 任務和圖像描述需要開放詞匯文本生成。作者通過使用所有任務所需的通用接口來解決該問題:模型接受圖像和文本字符串作為輸入,并生成文本作為輸出。在預訓練和微調時使用相同的接口。由于所有任務都使用相同的模型執行,即沒有任務特定的參數,因此使用基于文本的提示指導模型需要執行的任務。

圖 2 展示了模型架構的高階示意圖。其核心是一個文本 encoder-decoder transformer。為了將視覺作為輸入,向文本編碼器提供視覺“tokens”:視覺 transformer 將圖像作為輸入,并輸出相關特征。通過交叉注意力將視覺 token 傳遞到 encoder-decoder 模型之前,不會將池化應用于視覺 transformer 的輸出。

作者重復使用之前訓練過的單模態模型。對于文本 encoder-decoder,重復使用預訓練的 mT5(Xue 等,2021)模型,而對于圖像編碼,則重復使用大型 vanilla ViT 模型(Dosovitskiy 等,2021; Zhai 等,20222a)。

實驗結果

作者在三個純英文圖像的 benchmark 上評估了 PaLI 模型的變體,結果如表 4 所示。

作者對四個僅英文視覺問答(VQA)benchmark 進行評估,結果見表 6。

作者將 mT5-XXL 和 PaLI-17B 在一系列語言理解任務 benchmark 進行比較,對比結果如表 8 所示。

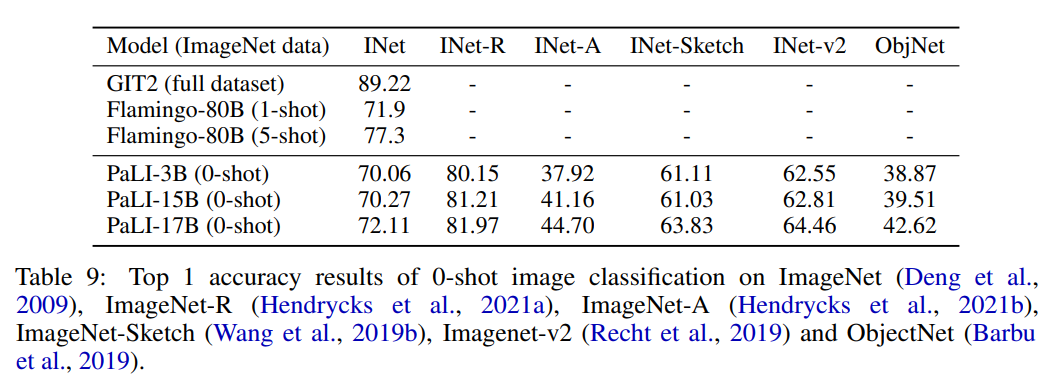

作者使用 224x224 分辨率(在高分辨率預微調之前)對 PaLI 模型在 Imagenet 和 Imagenet OOD 數據集上進行評估,評估結果如表 9 所示。

審核編輯 :李倩

-

神經網絡

+關注

關注

42文章

4814瀏覽量

103599 -

圖像

+關注

關注

2文章

1094瀏覽量

41248 -

模型

+關注

關注

1文章

3520瀏覽量

50420 -

大模型

+關注

關注

2文章

3141瀏覽量

4066

原文標題:ICLR 2023 | 谷歌提出PaLI:一種多模態大模型,刷新多個任務SOTA!

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

商湯日日新SenseNova融合模態大模型 國內首家獲得最高評級的大模型

基于MindSpeed MM玩轉Qwen2.5VL多模態理解模型

海康威視發布多模態大模型AI融合巡檢超腦

一種多模態駕駛場景生成框架UMGen介紹

商湯日日新多模態大模型權威評測第一

一文理解多模態大語言模型——上

基于AX650N/AX630C部署多模態大模型InternVL2-1B

評論