本文是對(duì)我們ICCV 2021被接收的文章NerfingMVS: Guided Optimization of Neural Radiance Fields for Indoor Multi-view Stereo 的介紹。在這個(gè)工作中,我們通過(guò)對(duì)神經(jīng)輻射場(chǎng)(NeRF)進(jìn)行引導(dǎo)優(yōu)化,實(shí)現(xiàn)了室內(nèi)的多視角三維重建(multi-view stereo)。很榮幸地,我們的文章被接收為ICCV 2021的Oral論文,目前項(xiàng)目代碼已開(kāi)源,歡迎大家試用和star~

效果展示

arXiv:https://arxiv.org/abs/2109.01129

主頁(yè):https://weiyithu.github.io/NerfingMVS/

Code:https://github.com/weiyithu/NerfingMVS

概述

熟悉3D視覺(jué)領(lǐng)域的朋友們都知道,近一年來(lái)NeRF大火。NeRF概括來(lái)說(shuō)是一個(gè)用MLP學(xué)習(xí)得到的神經(jīng)輻射場(chǎng)。它的訓(xùn)練數(shù)據(jù)是多視角的RGB圖片。學(xué)得的神經(jīng)輻射場(chǎng)可以表示場(chǎng)景的三維結(jié)構(gòu),從而實(shí)現(xiàn)新視角的視圖合成。對(duì)NeRF更加具體的介紹,請(qǐng)大家參考林天威:https://zhuanlan.zhihu.com/p/360365941

既然Nerf可以表示場(chǎng)景的三維信息,一個(gè)自然的想法是能不能將NeRF應(yīng)用到室內(nèi)場(chǎng)景三維重建任務(wù)中呢。NeRF有著一些優(yōu)勢(shì):相較于傳統(tǒng)的MVS,SfM算法,NeRF蘊(yùn)含了整個(gè)場(chǎng)景的信息,所以有潛力重建出低紋理區(qū)域的三維結(jié)構(gòu);而相較于另一個(gè)在線優(yōu)化的深度估計(jì)算法CVD ,NeRF不需要顯示地對(duì)不同視角的像素進(jìn)行匹配,這一點(diǎn)在室內(nèi)場(chǎng)景是很難做到的。但可惜的是,原生NeRF在室內(nèi)場(chǎng)景中存在形狀輻射歧義(shape-radiance ambiguity)的問(wèn)題。這個(gè)問(wèn)題的大致意思是NeRF可以合成出高質(zhì)量的新視角的RGB圖片,但它卻沒(méi)有學(xué)會(huì)場(chǎng)景的三維結(jié)構(gòu)。

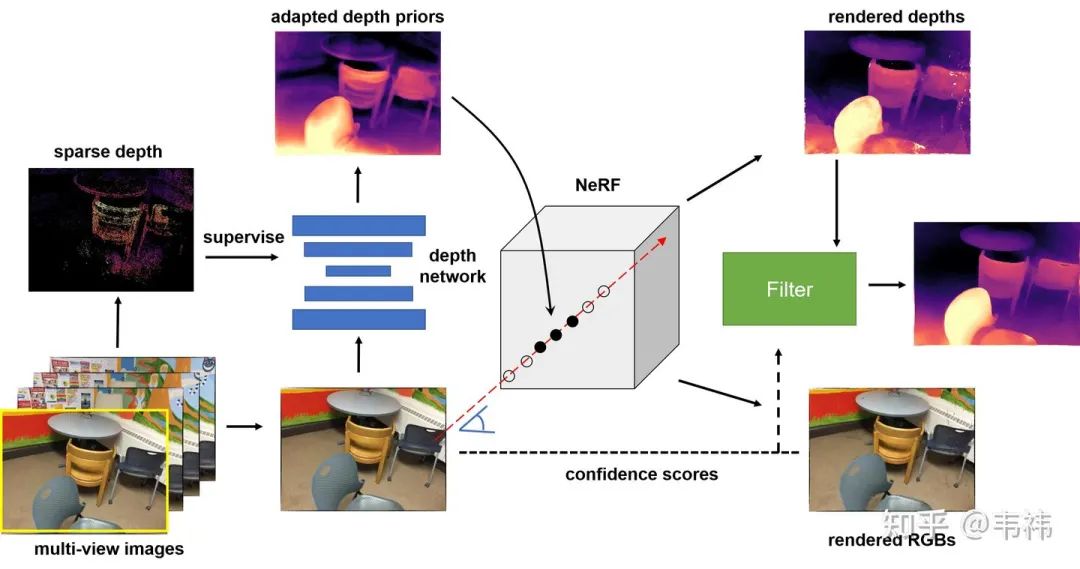

為了解決這個(gè)問(wèn)題,我們提出了NerfingMVS。我們方法的核心是用網(wǎng)絡(luò)預(yù)測(cè)出來(lái)的深度先驗(yàn)去引導(dǎo)神經(jīng)輻射場(chǎng)的優(yōu)化過(guò)程。我們首先用SfM得到的稀疏深度訓(xùn)練一個(gè)專屬于當(dāng)前場(chǎng)景的單目深度網(wǎng)絡(luò)。之后用這個(gè)單目深度網(wǎng)絡(luò)預(yù)測(cè)的深度圖來(lái)指導(dǎo)NeRF的學(xué)習(xí)。最后我們根據(jù)視角合成的結(jié)果利用濾波器去進(jìn)一步提升深度圖的質(zhì)量。在ScanNet上的實(shí)驗(yàn)結(jié)果表明,我們的方法超過(guò)了當(dāng)前最好方法的性能,并且我們還提升了新視角RGB圖片的質(zhì)量以及縮短了三倍的NeRF訓(xùn)練時(shí)間。

方法

我們的方法分為三個(gè)步驟:場(chǎng)景敏感的深度先驗(yàn),神經(jīng)輻射場(chǎng)的引導(dǎo)優(yōu)化,基于合成視圖的深度圖濾波。

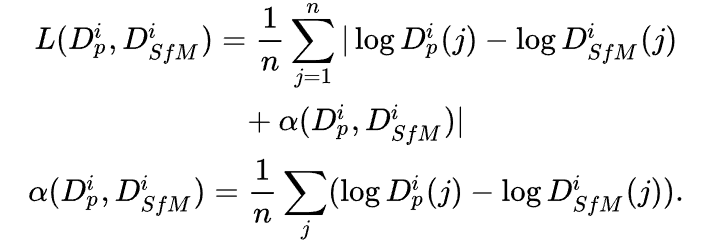

場(chǎng)景敏感的深度先驗(yàn):與CVD類似,我們同樣利用了神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)出來(lái)的深度先驗(yàn)。但不同的是,為了進(jìn)一步提升深度先驗(yàn)在當(dāng)前場(chǎng)景的精度,我們利用SfM重建出的稀疏深度對(duì)單目深度網(wǎng)絡(luò)進(jìn)行了微調(diào)(finetune)。這一步的目的其實(shí)是讓這個(gè)深度網(wǎng)絡(luò)過(guò)擬合在當(dāng)前場(chǎng)景上。具體來(lái)說(shuō),我們使用了COLMAP算法得到了多視角融合的點(diǎn)云,并將點(diǎn)云投影到各個(gè)視角下得到每個(gè)視角的稀疏深度。由于多視角融合的點(diǎn)云是經(jīng)過(guò)了幾何一致性校驗(yàn)的,因此雖然深度是稀疏的,但也是相對(duì)準(zhǔn)確的。此外,由于尺度歧義的問(wèn)題,我們使用了尺度不變的損失函數(shù):

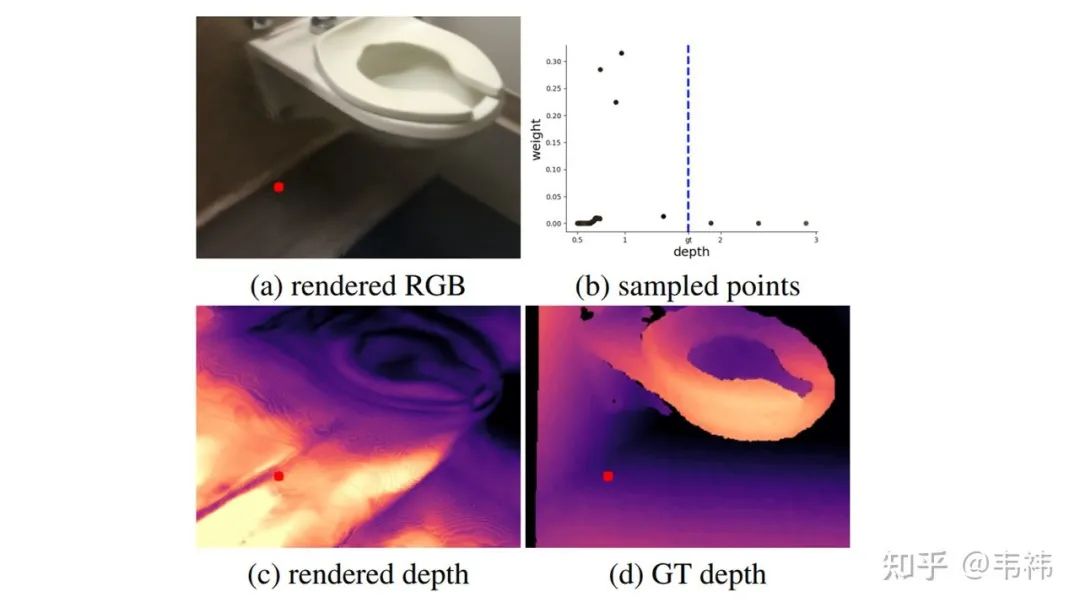

神經(jīng)輻射場(chǎng)的引導(dǎo)優(yōu)化:我們發(fā)現(xiàn)如果簡(jiǎn)單地在室內(nèi)場(chǎng)景應(yīng)用NeRF無(wú)法得到正確的三維重建結(jié)果。這其實(shí)就是所謂的形狀輻射歧義現(xiàn)象,換句話說(shuō),NeRF可以很好地?cái)M合出訓(xùn)練視角的RGB圖片(圖(a)),但卻沒(méi)有學(xué)到正確的場(chǎng)景3D結(jié)構(gòu)(圖(c))。造成這個(gè)問(wèn)題的本質(zhì)原因是對(duì)于同一組RGB圖片,會(huì)有多個(gè)神經(jīng)輻射場(chǎng)與之對(duì)應(yīng)。此外,現(xiàn)實(shí)室內(nèi)場(chǎng)景的RGB圖片會(huì)比較模糊并且圖片之間的位姿變換也會(huì)比較大,這導(dǎo)致了網(wǎng)絡(luò)的學(xué)習(xí)能力下降,加劇了這個(gè)問(wèn)題。

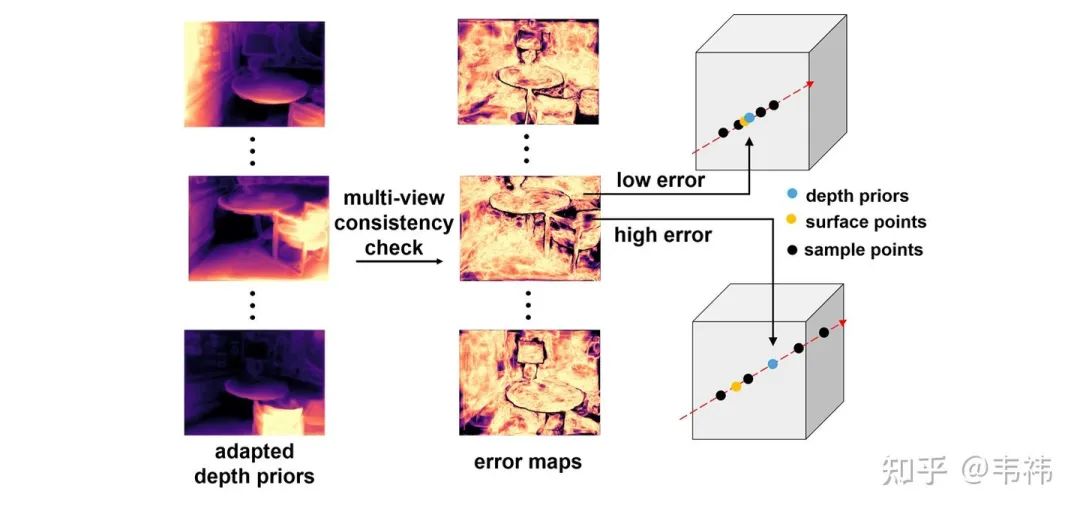

為了解決這個(gè)問(wèn)題,我們利用深度先驗(yàn)去指導(dǎo)NeRF的采樣過(guò)程。我們首先根據(jù)幾何一致性校驗(yàn)計(jì)算得到每個(gè)視角深度先驗(yàn)的誤差圖。具體來(lái)講,我們將每個(gè)視角的深度投影到其它視角下并與其它視角的深度計(jì)算相對(duì)誤差。NeRF中每個(gè)視角下每條ray的采樣中心點(diǎn)為對(duì)應(yīng)位置處的深度先驗(yàn),采樣范圍由誤差圖決定。誤差越小,深度先驗(yàn)的置信度越高,那么采樣范圍就越小;反之,誤差越大,深度先驗(yàn)的置信度越低,那么采樣范圍就越大。

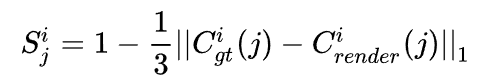

基于合成視圖的深度圖濾波:為了進(jìn)一步提升深度圖的質(zhì)量,我們最后進(jìn)行了一步濾波。這步操作是基于一個(gè)假設(shè):如果渲染出的RGB都不對(duì),那么對(duì)應(yīng)位置處算出來(lái)的深度也往往是錯(cuò)的。因此我們可以根據(jù)渲染得到的RGB與真實(shí)RGB之間的誤差計(jì)算逐像素的置信度圖:

這個(gè)置信度圖可以被用來(lái)濾波,我們這里使用的是平面雙邊濾波器(plane bilateral filtering)。

實(shí)驗(yàn)結(jié)果

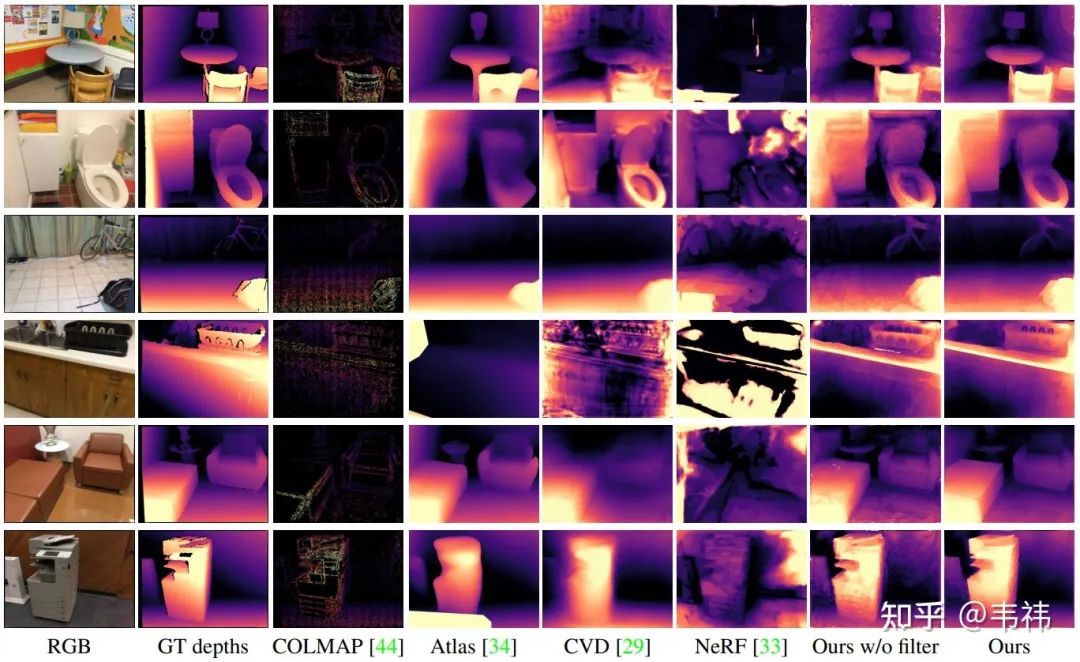

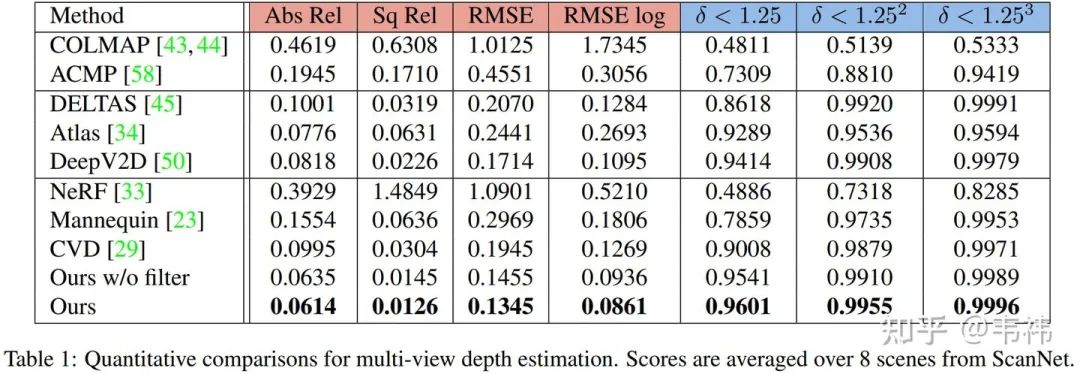

與SOTA方法對(duì)比:

無(wú)論是從定量還是定性的結(jié)果來(lái)看,我們的方法都達(dá)到了當(dāng)前最好性能,甚至超過(guò)了一些有監(jiān)督的方法:DELTAS,Atlas,DeepV2D。

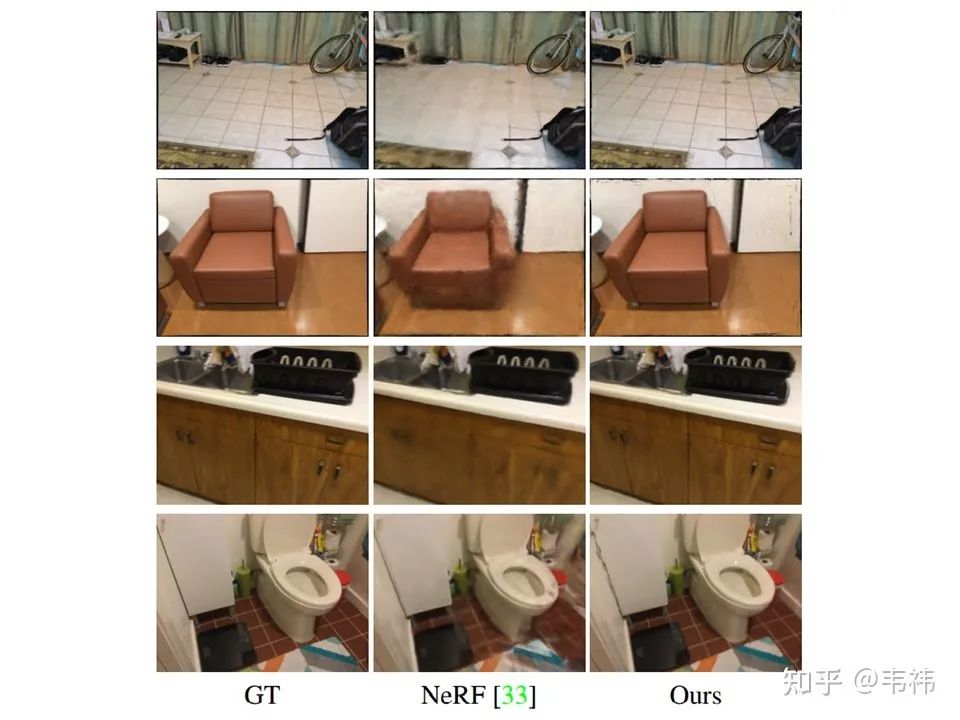

視圖合成結(jié)果:

前兩行是訓(xùn)練視角,后兩行是新視角。盡管視圖合成不是我們的主要任務(wù),我們的方法仍顯著地提升了NeRF視圖合成的結(jié)果。訓(xùn)練視角的提升也說(shuō)明了我們的方法可以幫助NeRF聚焦在更重要的區(qū)域并提升網(wǎng)絡(luò)的性能。此外,我們將NeRF的訓(xùn)練時(shí)間縮短至三分之一。

In-the-wild結(jié)果展示:

我們用手持相機(jī)在家拍攝了一些demo。

總結(jié)與討論

在這個(gè)工作中,我們將傳統(tǒng)SfM算法與NeRF結(jié)合解決室內(nèi)多視角重建問(wèn)題。我們方法的核心是將深度先驗(yàn)引入NeRF中指導(dǎo)它的采樣過(guò)程。在真實(shí)室內(nèi)場(chǎng)景數(shù)據(jù)集ScanNet上的實(shí)驗(yàn)結(jié)果表明,NerfingMVS取得了很好的效果。當(dāng)然我們的方法現(xiàn)在也存在一些limitations:1. 盡管我們大大加速了NeRF的訓(xùn)練過(guò)程,但現(xiàn)在仍無(wú)法達(dá)到實(shí)時(shí)。2. 我們需要SfM提供位姿和稀疏深度,因此比較依賴COLMAP的重建結(jié)果。

審核編輯 :李倩

-

算法

+關(guān)注

關(guān)注

23文章

4607瀏覽量

92839 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24689 -

3D視覺(jué)

+關(guān)注

關(guān)注

4文章

431瀏覽量

27521

原文標(biāo)題:ICCV 2021 Oral | NerfingMVS:引導(dǎo)優(yōu)化神經(jīng)輻射場(chǎng)實(shí)現(xiàn)室內(nèi)多視角三維重建

文章出處:【微信號(hào):3D視覺(jué)工坊,微信公眾號(hào):3D視覺(jué)工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

怎樣去設(shè)計(jì)一種基于RGB-D相機(jī)的三維重建無(wú)序抓取系統(tǒng)?

如何去開(kāi)發(fā)一款基于RGB-D相機(jī)與機(jī)械臂的三維重建無(wú)序抓取系統(tǒng)

無(wú)人機(jī)三維建模的信息

基于紋理映射的醫(yī)學(xué)圖像三維重建

基于FPGA的醫(yī)學(xué)圖像三維重建系統(tǒng)設(shè)計(jì)與實(shí)現(xiàn)

為什么說(shuō)三維重建才是計(jì)算機(jī)視覺(jué)的靈魂?

透明物體的三維重建研究綜述

NVIDIA Omniverse平臺(tái)助力三維重建服務(wù)協(xié)同發(fā)展

深度學(xué)習(xí)背景下的圖像三維重建技術(shù)進(jìn)展綜述

從多視角圖像做三維場(chǎng)景重建 (CVPR'22 Oral)

三維重建:從入門到入土

如何實(shí)現(xiàn)整個(gè)三維重建過(guò)程

基于光學(xué)成像的物體三維重建技術(shù)研究

NerfingMVS:引導(dǎo)優(yōu)化神經(jīng)輻射場(chǎng)實(shí)現(xiàn)室內(nèi)多視角三維重建

NerfingMVS:引導(dǎo)優(yōu)化神經(jīng)輻射場(chǎng)實(shí)現(xiàn)室內(nèi)多視角三維重建

評(píng)論