一些研究人員的報(bào)告稱,通用人工智能(AGI)可能是從我們當(dāng)前的語(yǔ)言模型技術(shù)進(jìn)行演進(jìn) [1],預(yù)訓(xùn)練 Transformer 語(yǔ)言模型為 AGI 的發(fā)展鋪平了道路。雖然模型訓(xùn)練數(shù)據(jù)集日漸增大,但缺乏基本指標(biāo)文檔,包括數(shù)據(jù)集大小、數(shù)據(jù)集 token 數(shù)量和具體的內(nèi)容細(xì)節(jié)。

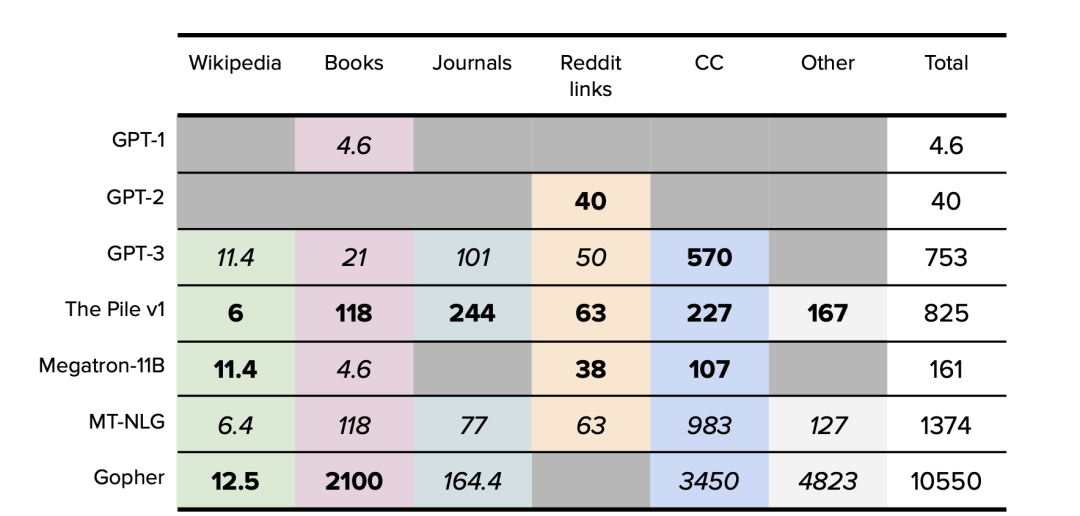

盡管業(yè)內(nèi)提出了數(shù)據(jù)集組成和整理文檔的標(biāo)準(zhǔn) [2],但幾乎所有重點(diǎn)研究實(shí)驗(yàn)室在揭示模型訓(xùn)練數(shù)據(jù)集細(xì)節(jié)這方面都做得不夠。這里整合的研究涵蓋了 2018 年到 2022 年初從 GPT-1 到 Gopher 的精選語(yǔ)言模型的所有數(shù)據(jù)集(包括主要數(shù)據(jù)集:Wikipedia 和 Common Crawl)的綜合視圖。

1、概述

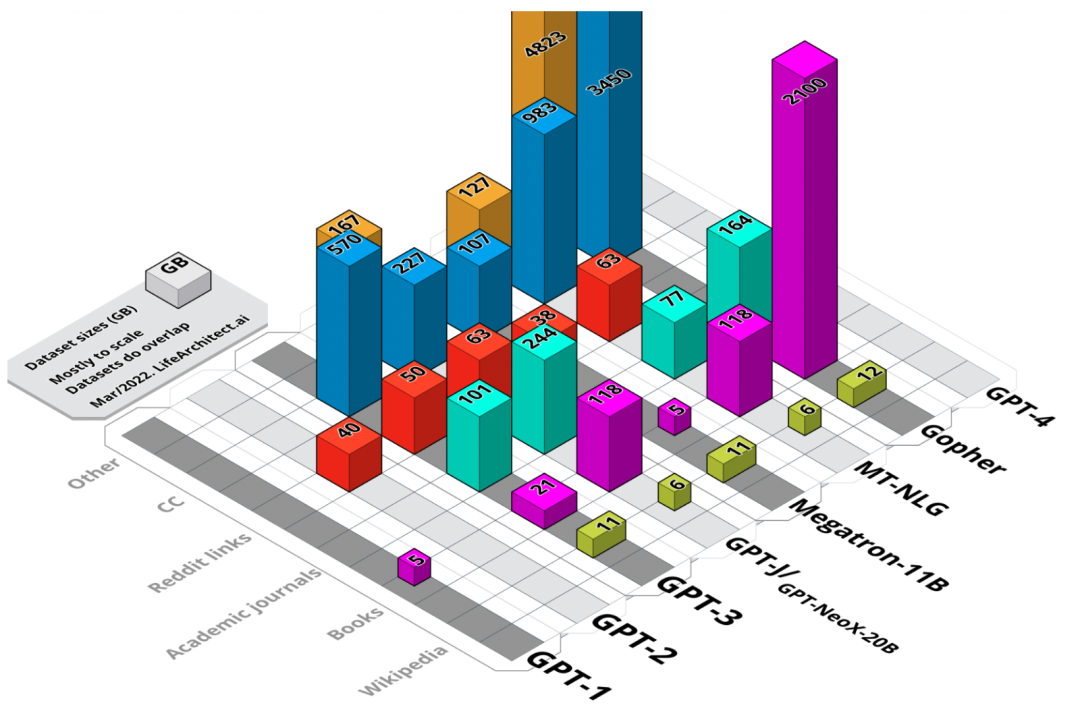

圖 1. 主要數(shù)據(jù)集大小的可視化匯總。未加權(quán)大小,以 GB 為單位。

2018 年以來(lái),大語(yǔ)言模型的開發(fā)和生產(chǎn)使用呈現(xiàn)出爆炸式增長(zhǎng)。一些重點(diǎn)研究實(shí)驗(yàn)室報(bào)告稱,公眾對(duì)大語(yǔ)言模型的使用率達(dá)到了驚人高度。2021 年 3 月,OpenAI 宣布 [3] 其 GPT-3 語(yǔ)言模型被 “超過(guò) 300 個(gè)應(yīng)用程序使用,平均每天能夠生成 45 億個(gè)詞”,也就是說(shuō)僅單個(gè)模型每分鐘就能生成 310 萬(wàn)詞的新內(nèi)容。

值得注意的是,這些語(yǔ)言模型甚至還沒(méi)有被完全理解,斯坦福大學(xué)的研究人員 [4] 最近坦言,“目前我們對(duì)這些模型還缺乏認(rèn)知,還不太了解這些模型的運(yùn)轉(zhuǎn)模式、不知道模型何時(shí)會(huì)失效,更不知道這些模型的突現(xiàn)性(emergent properties)能產(chǎn)生什么效果”。

隨著新型 AI 技術(shù)的快速發(fā)展,模型訓(xùn)練數(shù)據(jù)集的相關(guān)文檔質(zhì)量有所下降。模型內(nèi)部到底有什么秘密?它們又是如何組建的?本文綜合整理并分析了現(xiàn)代大型語(yǔ)言模型的訓(xùn)練數(shù)據(jù)集。

因?yàn)檫@方面的原始文獻(xiàn)并不對(duì)外公開,所以本文搜集整合了二、三級(jí)研究資料,在必要的時(shí)候本文會(huì)采用假設(shè)的方式來(lái)推算最終結(jié)果。

在本文中,我們會(huì)將原始論文中已經(jīng)明確的特定細(xì)節(jié)(例如 token 數(shù)量或數(shù)據(jù)集大小)歸類為 “公開的(disclosed)” 數(shù)據(jù),并作加粗處理。

多數(shù)情況下,適當(dāng)?shù)貐⒖级⑷?jí)文獻(xiàn),并采用假設(shè)的方式來(lái)確定最終結(jié)果是很有必要的。在這些情況下,token 數(shù)量和數(shù)據(jù)集大小等細(xì)節(jié)是 “確定的(determined)”,并以斜體標(biāo)記。

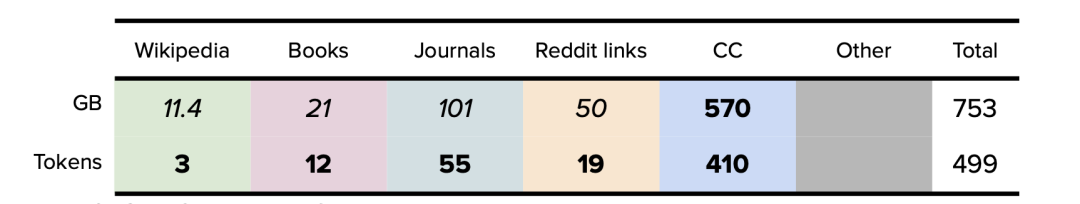

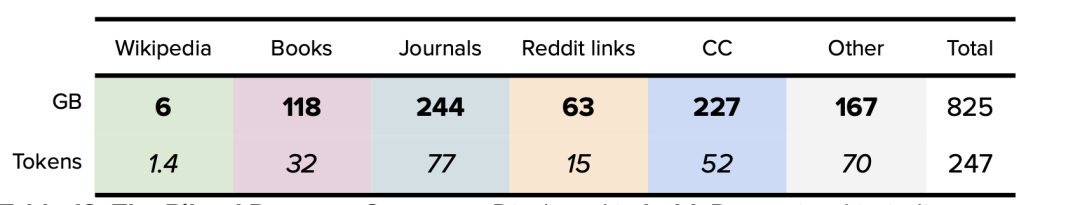

模型數(shù)據(jù)集可分為六類,分別是:維基百科、書籍、期刊、Reddit 鏈接、Common Crawl 和其他數(shù)據(jù)集。

表 1. 主要數(shù)據(jù)集大小匯總。以 GB 為單位。公開的數(shù)據(jù)以粗體表示。確定的數(shù)據(jù)以斜體表示。僅原始訓(xùn)練數(shù)據(jù)集大小。

1.1. 維基百科

維基百科是一個(gè)免費(fèi)的多語(yǔ)言協(xié)作在線百科全書,由超過(guò) 300,000 名志愿者組成的社區(qū)編寫和維護(hù)。截至 2022 年 4 月,英文版維基百科中有超過(guò) 640 萬(wàn)篇文章,包含超 40 億個(gè)詞 [5]。維基百科中的文本很有價(jià)值,因?yàn)樗粐?yán)格引用,以說(shuō)明性文字形式寫成,并且跨越多種語(yǔ)言和領(lǐng)域。一般來(lái)說(shuō),重點(diǎn)研究實(shí)驗(yàn)室會(huì)首先選取它的純英文過(guò)濾版作為數(shù)據(jù)集。

1.2. 書籍

故事型書籍由小說(shuō)和非小說(shuō)兩大類組成,主要用于訓(xùn)練模型的故事講述能力和反應(yīng)能力,數(shù)據(jù)集包括 Project Gutenberg 和 Smashwords (Toronto BookCorpus/BookCorpus) 等。

1.3. 雜志期刊

預(yù)印本和已發(fā)表期刊中的論文為數(shù)據(jù)集提供了堅(jiān)實(shí)而嚴(yán)謹(jǐn)?shù)幕A(chǔ),因?yàn)閷W(xué)術(shù)寫作通常來(lái)說(shuō)更有條理、理性和細(xì)致。這類數(shù)據(jù)集包括 ArXiv 和美國(guó)國(guó)家衛(wèi)生研究院等。

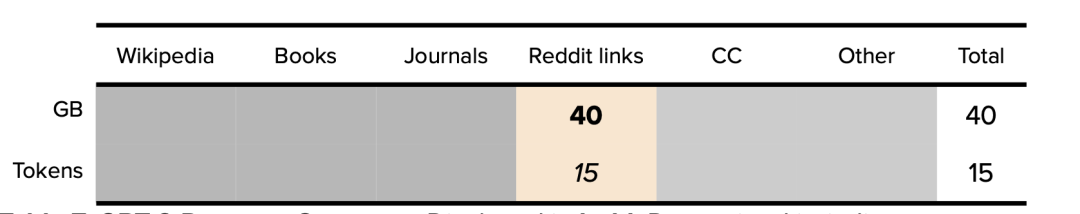

1.4. Reddit 鏈接

WebText 是一個(gè)大型數(shù)據(jù)集,它的數(shù)據(jù)是從社交媒體平臺(tái) Reddit 所有出站鏈接網(wǎng)絡(luò)中爬取的,每個(gè)鏈接至少有三個(gè)贊,代表了流行內(nèi)容的風(fēng)向標(biāo),對(duì)輸出優(yōu)質(zhì)鏈接和后續(xù)文本數(shù)據(jù)具有指導(dǎo)作用。

1.5. Common Crawl

Common Crawl 是 2008 年至今的一個(gè)網(wǎng)站抓取的大型數(shù)據(jù)集,數(shù)據(jù)包含原始網(wǎng)頁(yè)、元數(shù)據(jù)和文本提取,它的文本來(lái)自不同語(yǔ)言、不同領(lǐng)域。重點(diǎn)研究實(shí)驗(yàn)室一般會(huì)首先選取它的純英文過(guò)濾版(C4)作為數(shù)據(jù)集。

1.6. 其他數(shù)據(jù)集

不同于上述類別,這類數(shù)據(jù)集由 GitHub 等代碼數(shù)據(jù)集、StackExchange 等對(duì)話論壇和視頻字幕數(shù)據(jù)集組成。

2、常用數(shù)據(jù)集

2019 年以來(lái),大多數(shù)基于 Transformer 的大型語(yǔ)言模型 (LLM) 都依賴于英文維基百科和 Common Crawl 的大型數(shù)據(jù)集。在本節(jié)中,我們參考了 Jesse Dodge 和 AllenAI(AI2)[8] 團(tuán)隊(duì)的綜合分析,按類別對(duì)英文維基百科作了高級(jí)概述,并在 Common Crawl 數(shù)據(jù)集 [7] 的基礎(chǔ)上,用谷歌 C4 [6] (Colossal Clean Crawled Corpus) 在 Common Crawl 中提供了頂級(jí)域(domains)。

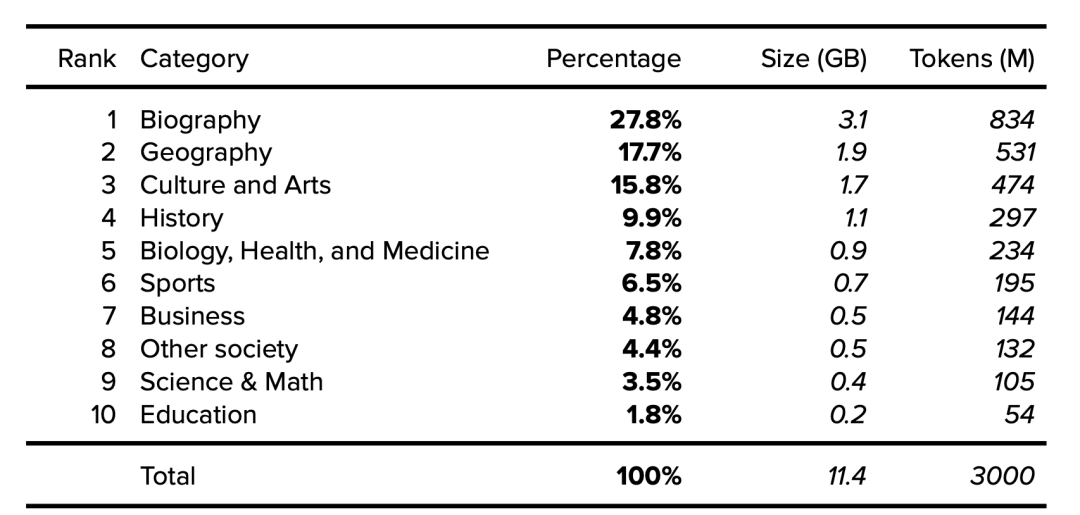

2.1. 維基百科(英文版)分析

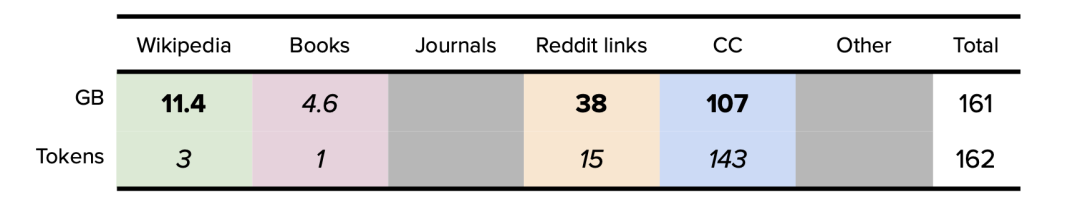

下面按類別 [9] 列出了維基百科的詳細(xì)信息,涵蓋了 2015 年抽樣的 1001 篇隨機(jī)文章,研究人員注意到隨時(shí)間推移文章傳播的穩(wěn)定性。假設(shè)一個(gè) 11.4GB、經(jīng)過(guò)清理和過(guò)濾的維基百科英文版有 30 億 token,我們就可以確定類別大小和 token。

表 2. 英文維基百科數(shù)據(jù)集類別。公開的數(shù)據(jù)以粗體表示。確定的數(shù)據(jù)以斜體表示。

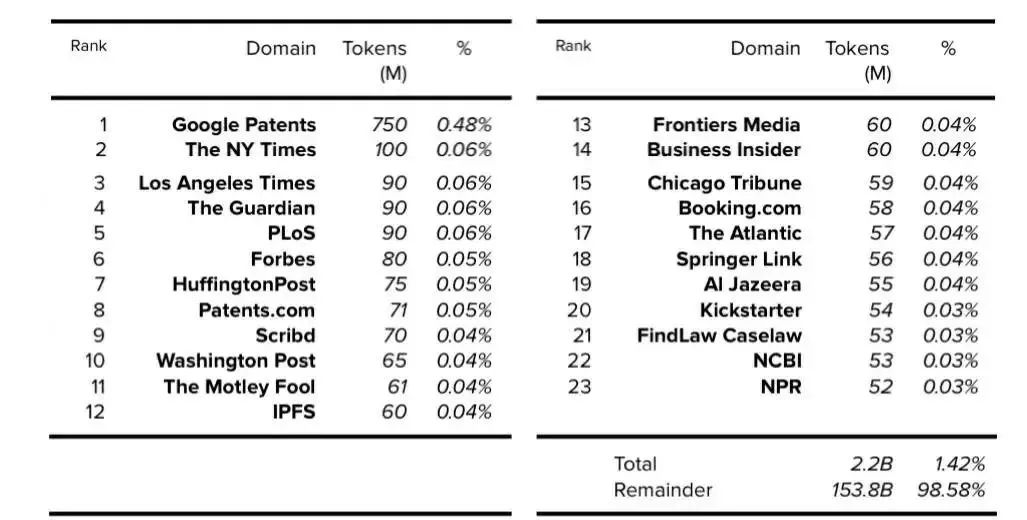

2.2 Common Crawl 分析

基于 AllenAI (AI2) 的 C4 論文,我們可以確定,過(guò)濾后的英文 C4 數(shù)據(jù)集的每個(gè)域的 token 數(shù)和總體百分比,該數(shù)據(jù)集為 305GB,其中 token 數(shù)為 1560 億。

表 3. C4:前 23 個(gè)域(不包括維基百科)。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

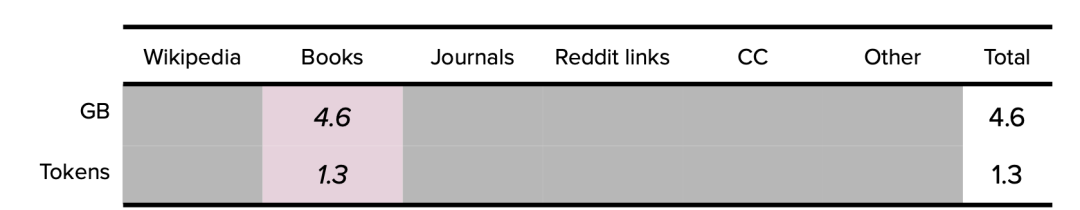

3、GPT-1 數(shù)據(jù)集

2018 年,OpenAI 發(fā)布了 1.17 億參數(shù)的 GPT-1。在論文中,OpenAI 并沒(méi)有公布模型訓(xùn)練數(shù)據(jù)集的來(lái)源和內(nèi)容 [10],另外,論文誤將‘BookCorpus’拼寫成了‘BooksCorpus’。BookCorpus 以作家未出版的免費(fèi)書籍為基礎(chǔ),這些書籍來(lái)自于 Smashwords,這是一個(gè)自稱為 “世界上最大的獨(dú)立電子書分銷商” 的電子書網(wǎng)站。這個(gè)數(shù)據(jù)集也被稱為 Toronto BookCorpus。經(jīng)過(guò)幾次重構(gòu)之后,BookCorpus 數(shù)據(jù)集的最終大小確定為 4.6GB [11]。

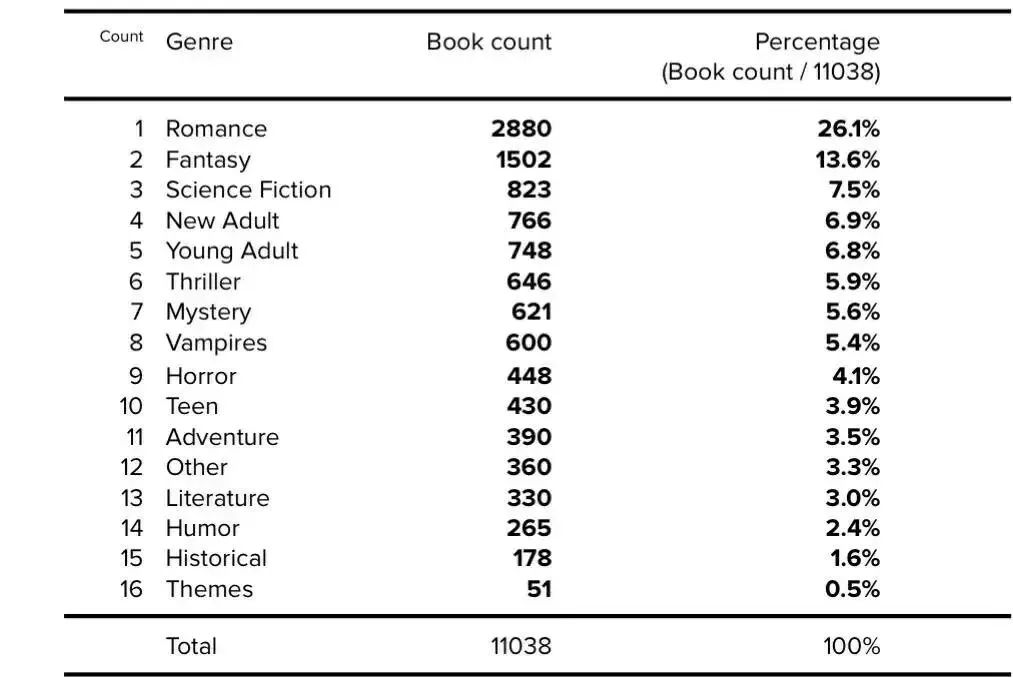

2021 年,經(jīng)過(guò)全面的回顧性分析,BookCorpus 數(shù)據(jù)集對(duì)按流派分組的書籍?dāng)?shù)量和各類書籍百分比進(jìn)行了更正 [12]。數(shù)據(jù)集中有關(guān)書籍類型的更多詳細(xì)信息如下:

表 4. BookCorpus 書籍類型。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

在隨后的數(shù)據(jù)集重構(gòu)中,BookCorpus 數(shù)據(jù)集進(jìn)一步過(guò)濾掉了書籍中的 “吸血鬼” 類別、降低了言情類書籍的百分比、增加了 “歷史” 類書籍,增加了收集的書籍?dāng)?shù)量。

3.1. GPT-1 數(shù)據(jù)集總結(jié)

GPT-1 最終的數(shù)據(jù)集總結(jié)分析如下:

表 5.GPT-1 數(shù)據(jù)集總結(jié)。以 GB 為單位。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

4、GPT-2 數(shù)據(jù)集

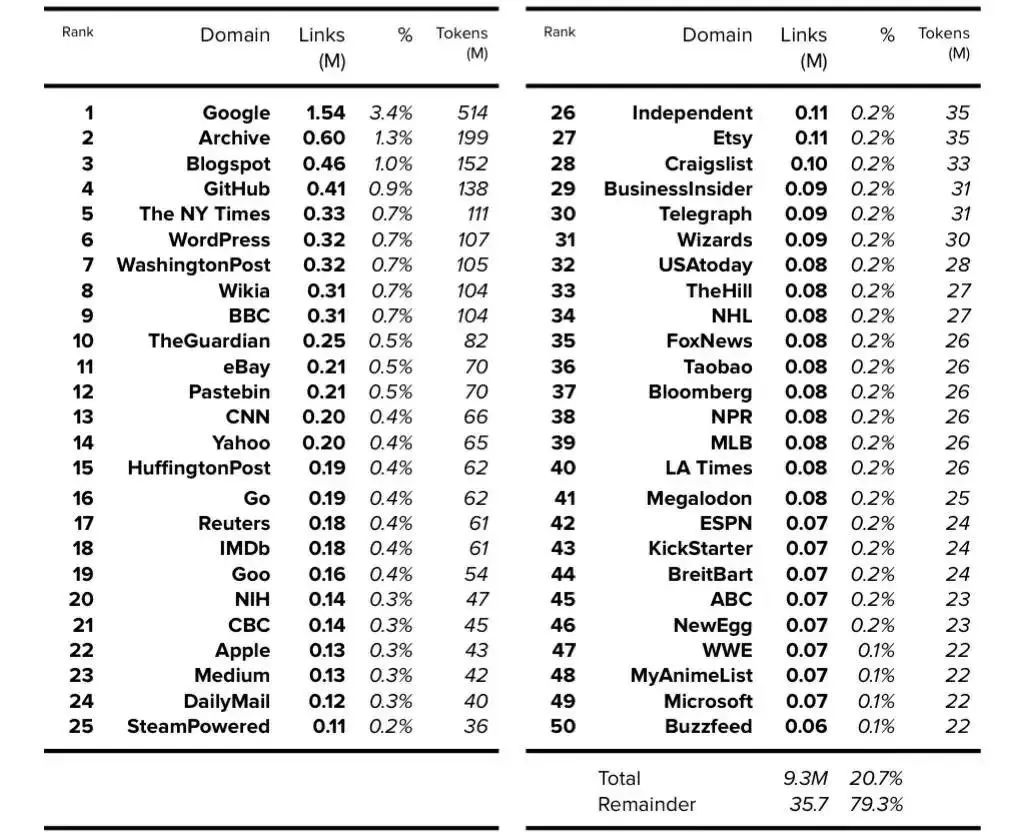

2019 年,OpenAI 發(fā)布了擁有 15 億參數(shù)的語(yǔ)言模型 GPT-2。GPT-2 論文闡明了所用訓(xùn)練數(shù)據(jù)集的大小 [13],不過(guò)并未說(shuō)明其內(nèi)容。而 GPT-2 模型卡(model card)(在 GPT-2 GitHub 倉(cāng)庫(kù)中)說(shuō)明了模型內(nèi)容 [14]。

我們可以從 GPT-3 論文中得到 token 數(shù)量,該論文使用了 WebText 擴(kuò)展版本來(lái)表示 190 億 token。據(jù)推測(cè),2020 年推出的 WebText 擴(kuò)展版本擁有 12 個(gè)月的額外數(shù)據(jù)(additional data),因此它可能比 2019 年推出的 GPT-2 版本大 25% 左右 [15]。GPT-2 最終的 token 數(shù)量確定為 150 億左右。

如 GPT-2 論文所述,假設(shè)模型卡顯示鏈接數(shù)時(shí),每個(gè)鏈接都可以被 4500 萬(wàn)鏈接總數(shù)所除,那 WebText 的內(nèi)容在數(shù)據(jù)集中所占的百分比的詳細(xì)信息就可以確定。

然后可以使用確定的 150 億 token 數(shù)量來(lái)查找每個(gè)域的 token 數(shù)量。請(qǐng)注意,在可用的前 1,000 個(gè)域中,此處僅顯示前 50 個(gè)域。

表 6. WebText: 前 50 個(gè)域。 公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

4.1. GPT-2 數(shù)據(jù)集總結(jié)

GPT-2 模型最終的數(shù)據(jù)集總結(jié)分析如下:

表 7. GPT-2 數(shù)據(jù)集總結(jié)。 公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

5、GPT-3 數(shù)據(jù)集

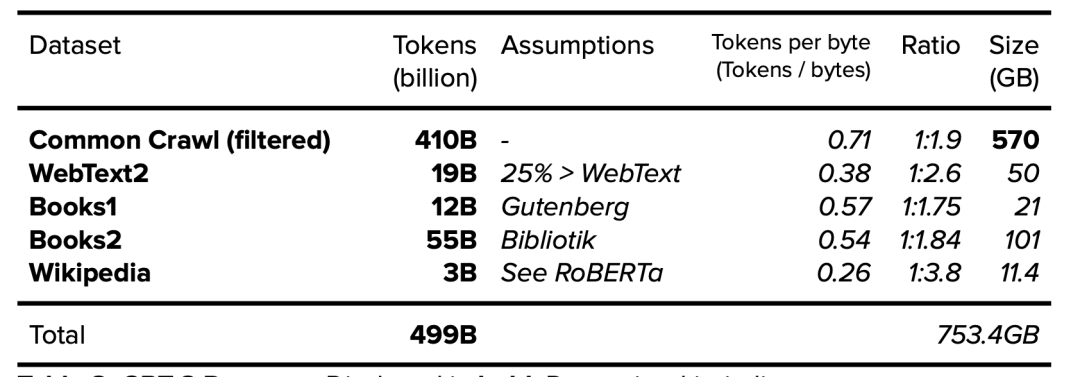

GPT-3 模型由 OpenAI 于 2020 年發(fā)布。論文闡明了所用訓(xùn)練數(shù)據(jù)集的 token 數(shù)量 [16],但訓(xùn)練數(shù)據(jù)集的內(nèi)容和大小尚不清楚(Common Crawl 的數(shù)據(jù)集大小除外 [17])

表 8. GPT-3 數(shù)據(jù)集。 公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

5.1. GPT-3:關(guān)于 Books1 和 Books2 數(shù)據(jù)集的分析

特別值得關(guān)注的是,在 OpenAI 的 GPT-3 論文中,并未公開 Books1 數(shù)據(jù)集(120 億 token)和 Books2 數(shù)據(jù)集(550 億 token)的大小和來(lái)源。關(guān)于這兩個(gè)數(shù)據(jù)集的來(lái)源人們提出了幾個(gè)假設(shè),包括來(lái)自 LibGen18 和 Sci-Hub 的類似數(shù)據(jù)集,不過(guò)這兩個(gè)數(shù)據(jù)集常以 TB 為計(jì),大到無(wú)法匹配。

5.2. GPT-3:Books1

GPT-3 使用的 Books1 數(shù)據(jù)集不可能與 GPT-1 使用的 BookCorpus 數(shù)據(jù)集相同,原因在于 Books1 的數(shù)據(jù)集更大,達(dá) 120 億 token。在一篇引用的論文 [19] 中就提及 GPT-1 使用的 BookCorpus 數(shù)據(jù)集擁有 9.848 億個(gè)詞,但這可能只相當(dāng)于 13 億 token(984.8 字 x 1.3 字的 token 乘數(shù))。

通過(guò)標(biāo)準(zhǔn)化項(xiàng)目古騰堡語(yǔ)料庫(kù)(SPGC),Books1 有可能與古騰堡項(xiàng)目保持一致性。SPGC 是一種開放式科學(xué)方法,被用于古騰堡項(xiàng)目完整的 PG 數(shù)據(jù)的精選(curated)版本。SPGC 包含 120 億個(gè) token [20],大約為 21GB [21]。

5.3. GPT-3:Books2

Books2(550 億 token)可能與 Bibliotik 保持一致,并由 EleutherA 收集該來(lái)源的數(shù)據(jù),組成數(shù)據(jù)集,使其成為 The Pile v1 的一部分。Bibliotik 版本為 100.96GB [22],其確定的 token 數(shù)僅為 250 億,低于 Books2 公開的 550 億。然而,使用 SPGC 的‘每字節(jié) token 數(shù)’比率(大約為 1:1.75),Bibliotik 的 token 數(shù)和大小將更接近于 Books2。

5.4. GPT-3 數(shù)據(jù)集總結(jié)

附錄 A 概述了使用 Wikipedia + CommonCrawl + WebText 數(shù)據(jù)集的頂級(jí)資源列表。GPT-3 模型的最終數(shù)據(jù)集總結(jié)分析如下:

表 9.GPT-3 數(shù)據(jù)集總結(jié)。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

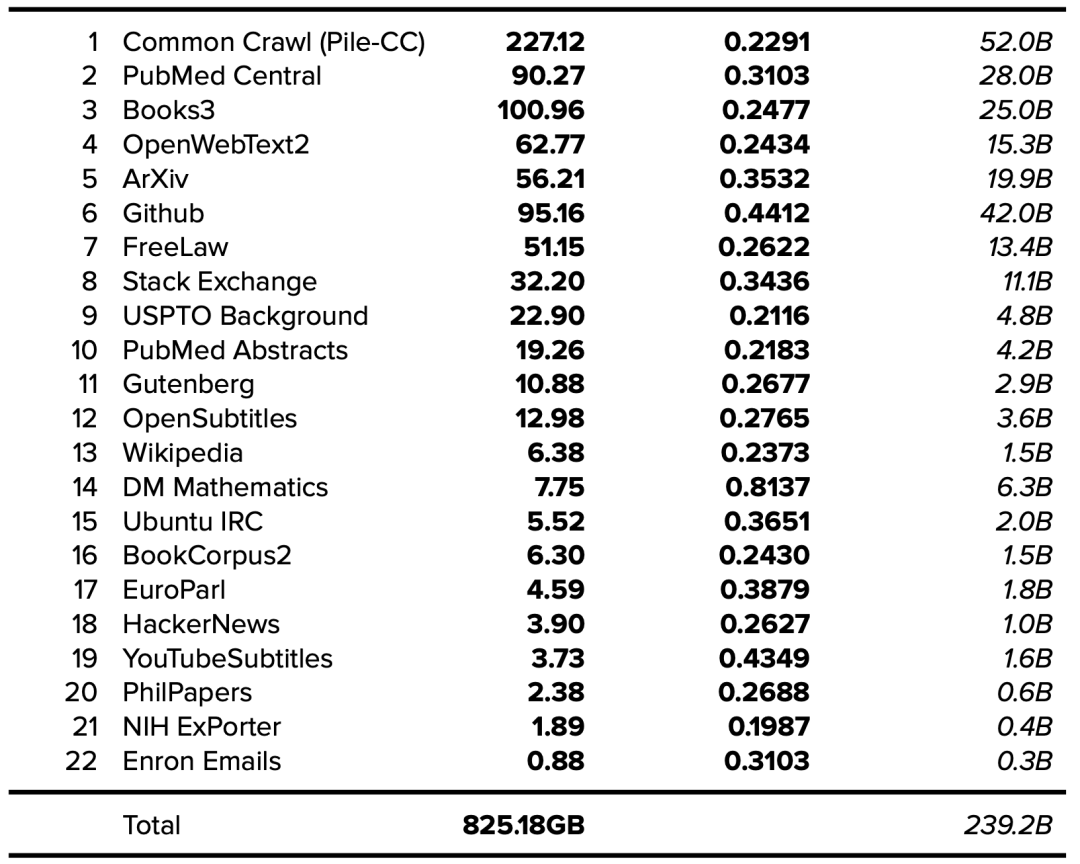

6、The Pile v1(GPT-J 和 GPT-NeoX-20B)數(shù)據(jù)集

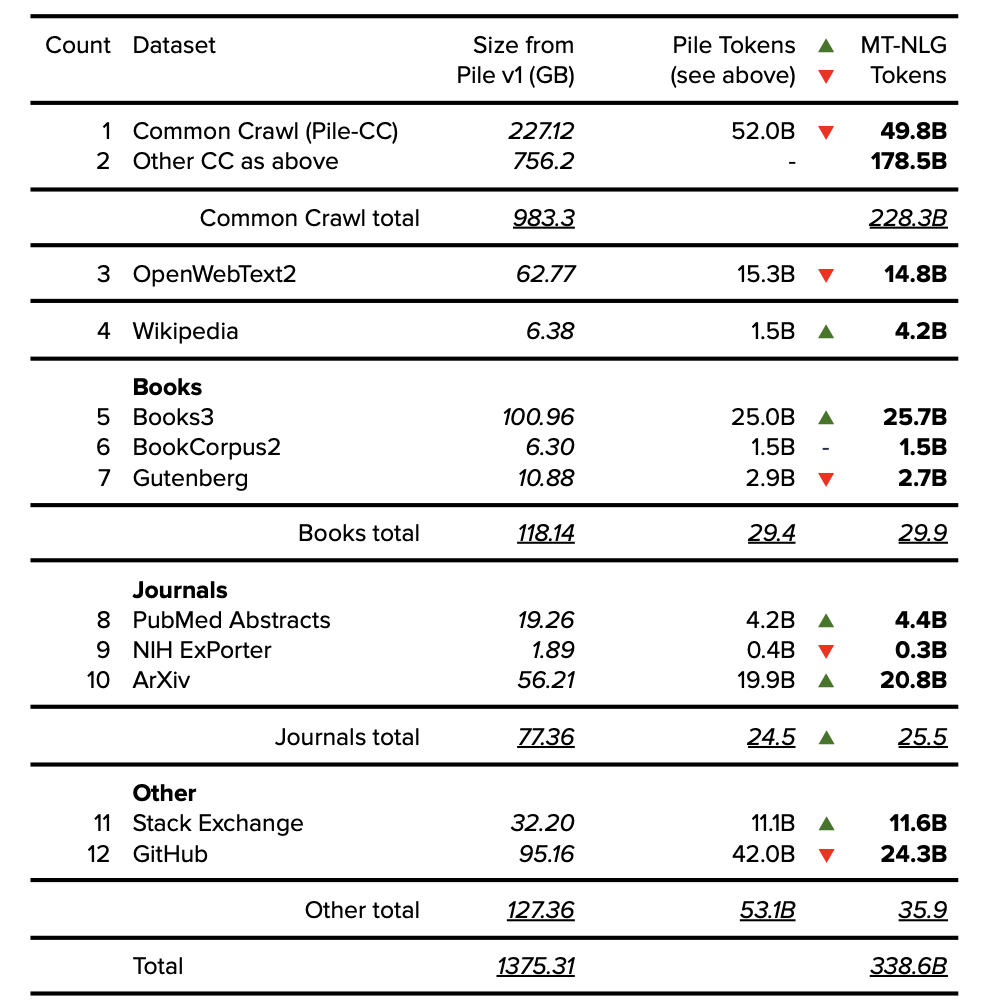

The Pile v1 數(shù)據(jù)集由 EleutherAI 于 2021 年發(fā)布,該數(shù)據(jù)集已被用于訓(xùn)練包括 GPT-J、GPT-NeoX-20B 在內(nèi)的多種模型,并作為包括 MT-NLG 在內(nèi)的其他模型的部分?jǐn)?shù)據(jù)集。The Pile v1 論文闡明了所用訓(xùn)練數(shù)據(jù)集的來(lái)源和大小。隨著 token 數(shù)量的增加,The Pile v1 論文應(yīng)被用作未來(lái)數(shù)據(jù)集文檔的黃金標(biāo)準(zhǔn)。

有關(guān) token 數(shù)量的更多詳情,可以使用本文提供的信息來(lái)確定,參見表 1(大小以 GB 為單位)和表 7(token / 每字節(jié))[23]。

表 10. The Pile v1 數(shù)據(jù)集。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

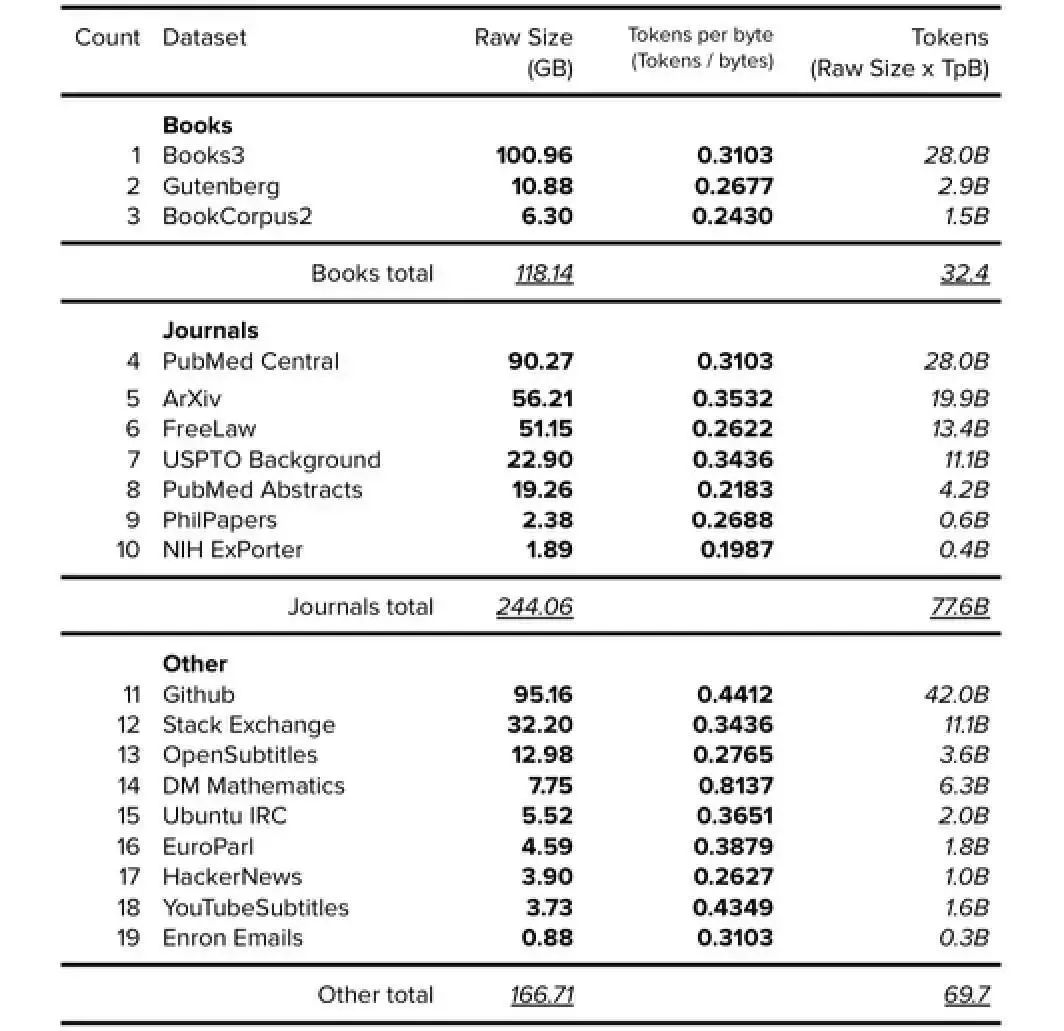

6.1. The Pile v1 分組數(shù)據(jù)集(Grouped Datasets)

為了確定如‘Books’、‘Journals’和‘CC’這類數(shù)據(jù)集的大小,筆者對(duì)數(shù)據(jù)集進(jìn)行了分組,如下表所示。

表 11. The Pile v1 分組數(shù)據(jù)集(不包括 Wikipedia、CC 和 WebText)。公開的數(shù)據(jù)以粗體表示,確定的以斜體表示。

6.2. The Pile v1 數(shù)據(jù)集總結(jié)

The Pile v1 數(shù)據(jù)集與 GPT-J 和 GPT-NeoX-20B 模型的最終數(shù)據(jù)集總結(jié)分析如下:

表 12. Pile v1 數(shù)據(jù)集總結(jié)。 公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

7、Megatron-11B 和 RoBERTa 數(shù)據(jù)集

2019 年,Meta AI (當(dāng)時(shí)稱之為 Facebook AI) 和華盛頓大學(xué)聯(lián)合發(fā)布了擁有 1.25 億參數(shù)的 RoBERTa 模型。次年,Meta AI 發(fā)布了擁有 110 億參數(shù)的 Megatron-11B 模型。Megatron-11B 使用的訓(xùn)練數(shù)據(jù)集與 RoBERTa 相同。RoBERTa [24] 論文闡明了所用訓(xùn)練數(shù)據(jù)集的內(nèi)容,不過(guò)必須參考引用的論文 (BERT [25] 和 toryes [26]) 來(lái)確定最終的數(shù)據(jù)集大小。

BookCorpus : 確定的數(shù)據(jù)集為 4.6GB,如上面的 GPT-1 部分所示。

維基百科:公開的數(shù)據(jù)集為 “16GB(BookCorpus 加上英文維基百科)”。在減去 BookCorpus 數(shù)據(jù)集(4.6GB,如上面的 GPT-1 部分所述)后,維基百科數(shù)據(jù)集確定為 11.4GB。

CC-News :(經(jīng)過(guò)濾后)公開的數(shù)據(jù)集為 76GB。

OpenWebText : 公開的數(shù)據(jù)集為 38GB。

Stories : 公開的數(shù)據(jù)集為 31GB。請(qǐng)注意,此數(shù)據(jù)集是 “基于常識(shí)推理任務(wù)問(wèn)題” 的 Common Crawl 內(nèi)容,不屬于本文的‘Books’類別。相反,將 Stories 與 CC-News 數(shù)據(jù)集(76GB)相結(jié)合,Common Crawl 的總數(shù)據(jù)集則為 107GB。

7.1. Megatron-11B 和 RoBERTa 的數(shù)據(jù)集總結(jié)

Megatron-11B 和 RoBERTa 最終的數(shù)據(jù)集總結(jié)分析如下:

表 13. Megatron-11B 和 RoBERTa 的數(shù)據(jù)集總結(jié)。 公示的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

8、MT-NLG 數(shù)據(jù)集

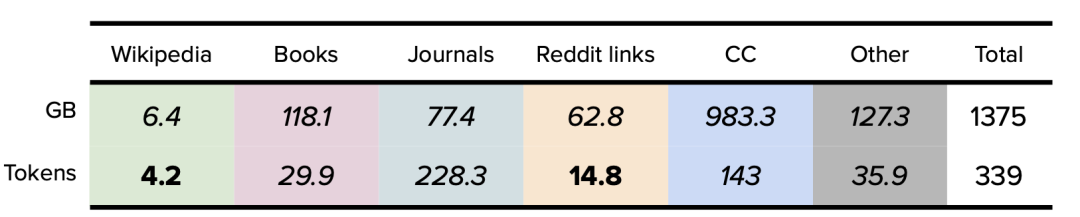

2021 年,英偉達(dá)和微軟發(fā)布了擁有 5300 億參數(shù)的語(yǔ)言模型 MT-NLG。MT-NLG 是微軟 Turing NLG(擁有 170 億參數(shù))和英偉達(dá) Megatron-LM(擁有 83 億參數(shù))的 “繼任者”。MT-NLG 論文闡明了所用訓(xùn)練數(shù)據(jù)集的來(lái)源和 token 數(shù)量,不過(guò)沒(méi)有明確指出數(shù)據(jù)集的大小。

如前所述,有關(guān)數(shù)據(jù)集大小的更多詳情,可以使用 The Pile v1 論文中提供的信息來(lái)確定。雖然使用的組件相同,但注意的是,MT-NLG 和 The Pile v1 中報(bào)告的組件大小卻各不相同,這是由于來(lái)自 Eleuther AI (The Pile v1 數(shù)據(jù)集) 和 Microsoft/NVIDIA (MT-NLG 模型) 的研究人員采用了不同的數(shù)據(jù)過(guò)濾和去重方法。

8.1. MT-NLG 中的 Common Crawl 數(shù)據(jù)集

Pile-CC:公開的數(shù)據(jù)集為 498 億 token,確定的數(shù)據(jù)為 227.12GB 左右,參見上述 Pile v1 部分。

CC-2020-50: 公開的數(shù)據(jù)集為 687 億 token,假設(shè) token 的每字節(jié)率(per byte rate)為 0.25 TpB=274.8GB。

CC-2021-04:公開的數(shù)據(jù)集為 826 億 token,假設(shè) token 的每字節(jié)率為 0.25 TpB=330.4GB

RealNews(來(lái)自 RoBERTa/Megatron-11B):顯示為 219 億 token。根據(jù) RealNews 論文 [27],數(shù)據(jù)集確定為 120GB。

CC-Stories (來(lái)自 RoBERTa/Megatron-11B):公開的數(shù)據(jù)集為 53 億 token,如上述 RoBERTa 部分所示,數(shù)據(jù)集確定為 31GB。

根據(jù)以上來(lái)源,可確認(rèn) Common Crawl 的總數(shù)據(jù)量為 983.32GB,共計(jì) 2283 億 token。

8.2. MT-NLG 分組數(shù)據(jù)集(Grouped Datasets)

表 14. MT-NLG 分組數(shù)據(jù)集。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

8.3. MT-NLG 數(shù)據(jù)集總結(jié)

MT-NLG 模型最終的數(shù)據(jù)集總結(jié)分析如下:

表 15. MT-NLG 數(shù)據(jù)集總結(jié)。 公示的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

9、MT-NLG 數(shù)據(jù)集 Gopher 數(shù)據(jù)集

Gopher 模型由 DeepMind 于 2021 年發(fā)布,有 2800 億參數(shù)。該論文清楚地說(shuō)明了所使用訓(xùn)練數(shù)據(jù)集所包含的高級(jí) token 數(shù)量和大小 [28],但沒(méi)有說(shuō)明詳細(xì)內(nèi)容。

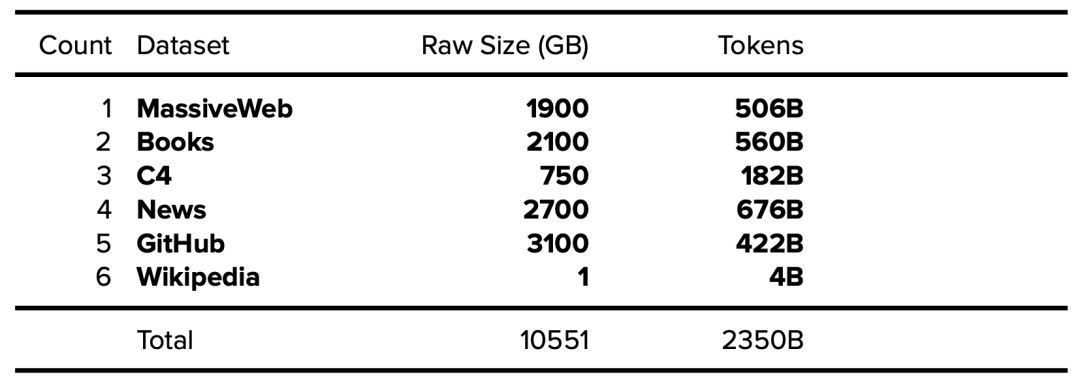

表 16. 公開的 Gopher 數(shù)據(jù)集 (MassiveText)。公開的數(shù)據(jù)以粗體表述,確定的數(shù)據(jù)以斜體表示。

有趣的是,據(jù) Gopher 論文披露:其 Books 數(shù)據(jù)集中包含一些超過(guò) 500 年歷史(1500-2008)的書籍。

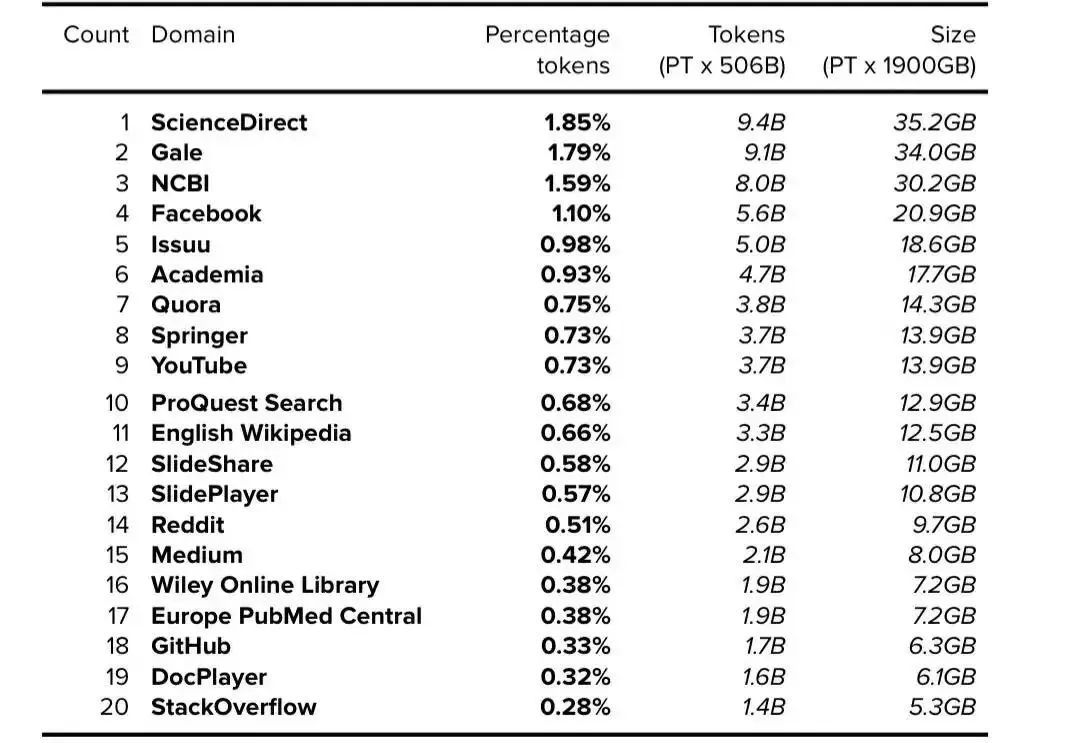

9.1. MassiveWeb 數(shù)據(jù)集分析

DeepMind 于 2014 年被谷歌收購(gòu),并在創(chuàng)建 MassiveText 時(shí)獲得了海量數(shù)據(jù)。雖然 Gopher 論文中沒(méi)有進(jìn)一步詳細(xì)描述 MassiveWeb,但第 44 頁(yè)附錄中的表 A3b 注明了 MassiveWeb 中出現(xiàn)的前 20 個(gè)域 [29]。根據(jù)披露的每個(gè)域所占的百分比,我們可以使用 MassiveWeb 的總 token 數(shù)(5060 億 token)和總原始大小(1900GB)來(lái)確定每個(gè)域的 token 數(shù)量和大小。

表 17. MassiveWeb:前 20 個(gè)域。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

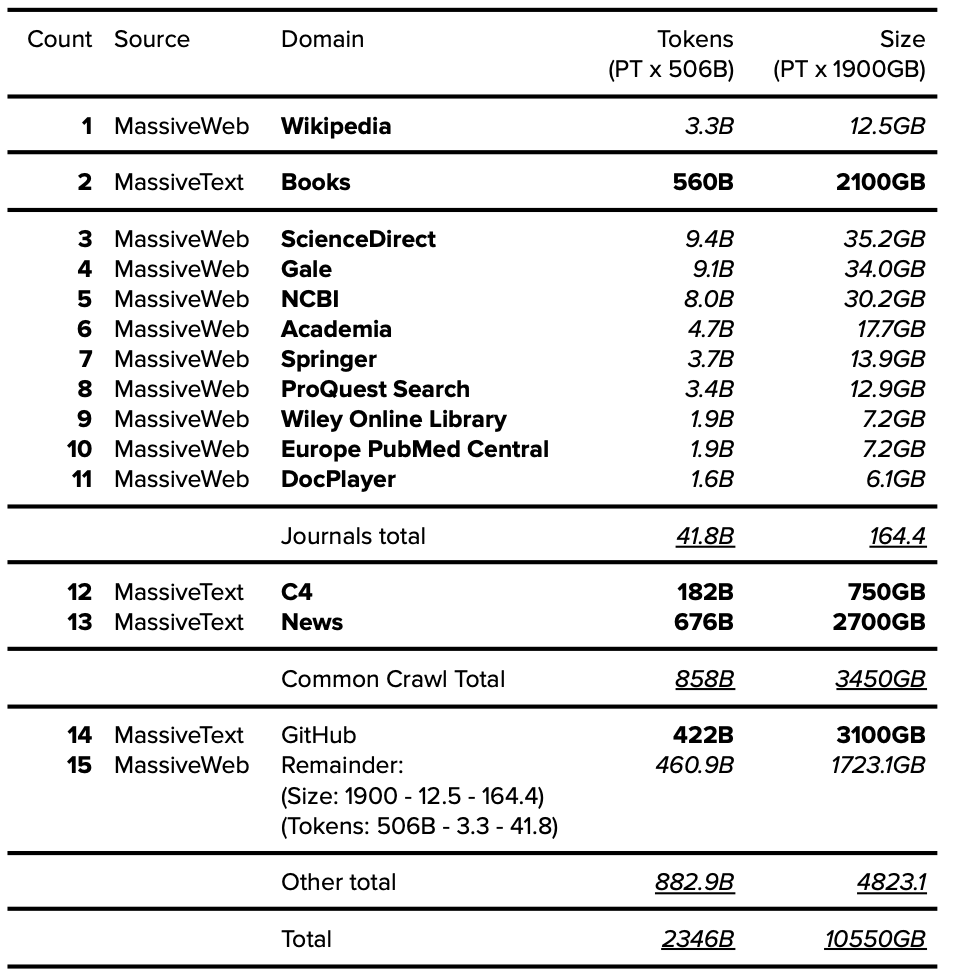

9.2. Gopher:關(guān)于維基百科數(shù)據(jù)集的分析

維基百科數(shù)據(jù)集的總規(guī)模很難確定。在 Gopher 論文中,研究人員指出維基百科沒(méi)有進(jìn)行數(shù)據(jù)去重 [30]。然而,論文中列出的不同大小數(shù)據(jù)集(12.5GB MassiveWeb Wikipedia 與 1GB MassiveText Wikipedia)可能是由于失誤而造成的,誤將 “10GB” 寫成了 “1GB”。無(wú)論如何,本文僅使用 MassiveWeb 數(shù)據(jù)集版本 (12.5GB)。

9.3. Gopher: 不包括 WebText

Gopher 數(shù)據(jù)集的組成部分不包括 Reddit 外鏈的 WebText 數(shù)據(jù)集。為了清楚起見,盡管 Reddit 是 MassiveWeb 中的頂級(jí)域,但該數(shù)據(jù)集僅抓取 Reddit 域內(nèi)的 Reddit 鏈接。根據(jù)定義,WebText [31] 由 “所有 Reddit 的外鏈” 組成(即指向 Reddit 域外的鏈接)。

9.4. Gopher 分組數(shù)據(jù)集

MassiveWeb 被認(rèn)為是 MassiveText 的子組件,并被集成到 Gopher 的數(shù)據(jù)集匯總中,其分組基于以下列出的可用信息:

表 18. Gopher 分組數(shù)據(jù)集。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

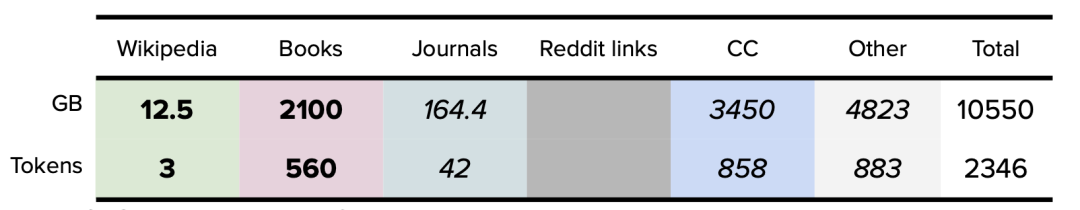

9.5. Gopher 數(shù)據(jù)集總結(jié)

Gopher 是本文中最大的數(shù)據(jù)集,大小為 10.5TB。Gopher 模型的最終數(shù)據(jù)集總結(jié)分析為:

表 19. Gopher 數(shù)據(jù)集總結(jié)。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

10、結(jié)論

對(duì)于訓(xùn)練當(dāng)代 Transformer 大型語(yǔ)言模型的數(shù)據(jù)集而言,這可能是最全面的整合分析內(nèi)容(截止 2022 年初)。在主要數(shù)據(jù)源不透明的情況下,本次研究主要從二級(jí)和三級(jí)來(lái)源收集數(shù)據(jù),并經(jīng)常需要假定來(lái)確定最終估計(jì)值。隨著研究人員要處理千萬(wàn)億個(gè) token(1,000 萬(wàn)億)和數(shù)千 TB 的數(shù)據(jù)(1,000TB),確保詳細(xì)披露數(shù)據(jù)集組成的文檔變得越來(lái)越重要。

特別值得關(guān)注的是,基于大型語(yǔ)言模型的強(qiáng)大 AI 系統(tǒng)產(chǎn)生的冗長(zhǎng)而匿名的輸出正在迅速發(fā)展,其中許多數(shù)據(jù)集的細(xì)節(jié)內(nèi)容幾乎沒(méi)有文檔說(shuō)明。

強(qiáng)烈建議研究人員使用突出顯示的 “數(shù)據(jù)集的數(shù)據(jù)表(Datasheet for Datasets)” 論文中提供的模板,并在記錄數(shù)據(jù)集時(shí)使用最佳實(shí)踐論文(即 Pile v1 論文,包括 token 數(shù)量)。數(shù)據(jù)集大小(GB)、token 數(shù)量(B)、來(lái)源、分組和其他詳細(xì)信息指標(biāo)均應(yīng)完整記錄和發(fā)布。

隨著語(yǔ)言模型不斷發(fā)展并更廣泛地滲透到人們的生活中,確保數(shù)據(jù)集的詳細(xì)信息公開透明、所有人都可訪問(wèn)且易于理解是有用、緊迫和必要的。

審核編輯 :李倩

-

人工智能

+關(guān)注

關(guān)注

1791文章

47183瀏覽量

238255 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24689 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1558瀏覽量

7595

原文標(biāo)題:詳解ChatGPT數(shù)據(jù)集之謎

文章出處:【微信號(hào):AI_Architect,微信公眾號(hào):智能計(jì)算芯世界】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

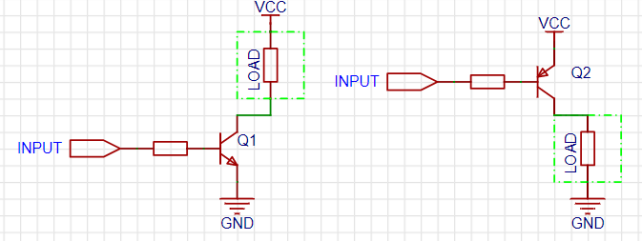

開集、開漏與推挽輸出原理詳解

詳解ChatGPT數(shù)據(jù)集之謎

詳解ChatGPT數(shù)據(jù)集之謎

評(píng)論