文章作者:武卓 博士/ River Li/ Peter Chen

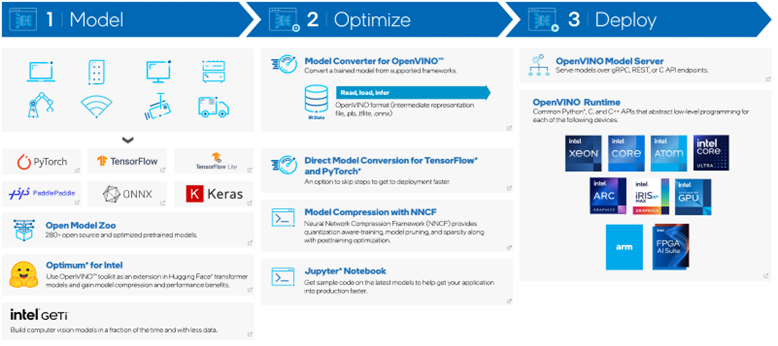

你是否準備好在新的一年體驗 OpenVINO 工具套件分發版的最新長期支持 (LTS) 版本?

OpenVINO 2022.3 LTS 版本現已發布,可幫助你快速輕松地開發卓越的人工智能應用,并跨邊緣和云端部署深度學習推理工作負載,無論你處于人工智能編程的什么階段。

作為人工智能開發人員,無論你希望將 OpenVINO 用于 C 應用內,還是希望將其用于無法兼容 OpenVINO 軟件包的應用二進制接口 (ABI) 的 C++ 應用,或用于需要運行時加載 OpenVINO 庫的應用,C API 均可助您一臂之力!

C API 2.0 現已隨 OpenVINO 2022.3 LTS 版本一起發布,包含以下主要功能:

01C API 2.0 支持 OpenVINO 2.0 C++API

如果開發人員以前僅知道如何應用 OpenVINO C++API 2.0,該特性可幫助他們更輕松地應用 C API 2.0,反之亦然。

02新的 C API 使用張量名稱

和索引處理模型輸入/輸出

借助新的 C API 2.0 命名規則,開發人員可以更方便地編寫代碼和調用函數,因為它遵循了流行的深度學習命名規則和用途。

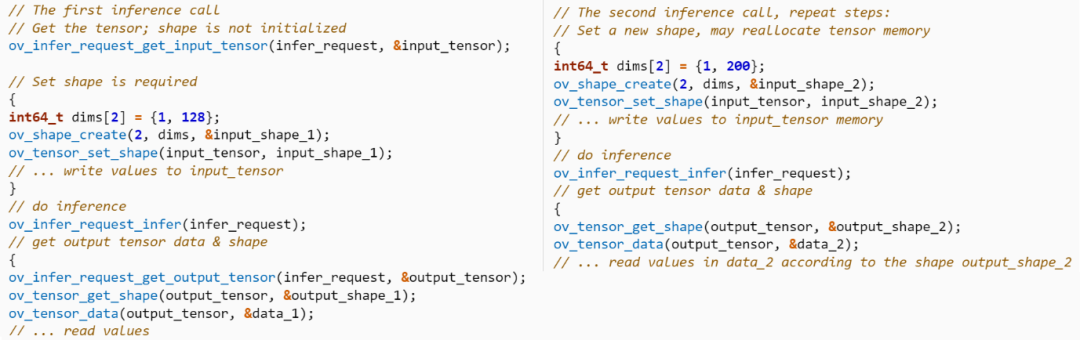

03支持動態輸入和動態模型

一些深度學習模型涉及動態輸入,即在某些輸入維度上,輸入尺寸可能會不時變化。例如,對于一些自然語言處理 (NLP) 用例,輸入至模型的內容(例如所提問題問題的長度)取決于特定的問題。現在,C API 2.0 支持動態輸入和動態模型,您可以輕松將其應用于動態輸入和模型。上面列舉了一些代碼片段。

04為模型前期/后期處理提供大量 C API

C API 2.0 中提供了大量前期和后期處理 C API,以進一步加快 OpenVINO 實施深度學習模型推理的速度。例如,我們可以使用這樣的預處理 API 將 NV12 輸入數據轉換為與實際模型輸入相同的 BGR 格式,而無需使用 OpenCV 對 OpenVINO 執行數據格式轉換,從而節省預處理時間。

05屬性(鍵、數值、數字)的統一界面

對開發人員來說,為不同的用例設置/提供屬性更為方便,而且這也可以提高可擴展性,便于未來支持更多新屬性。

01如何使用 C API 2.0?

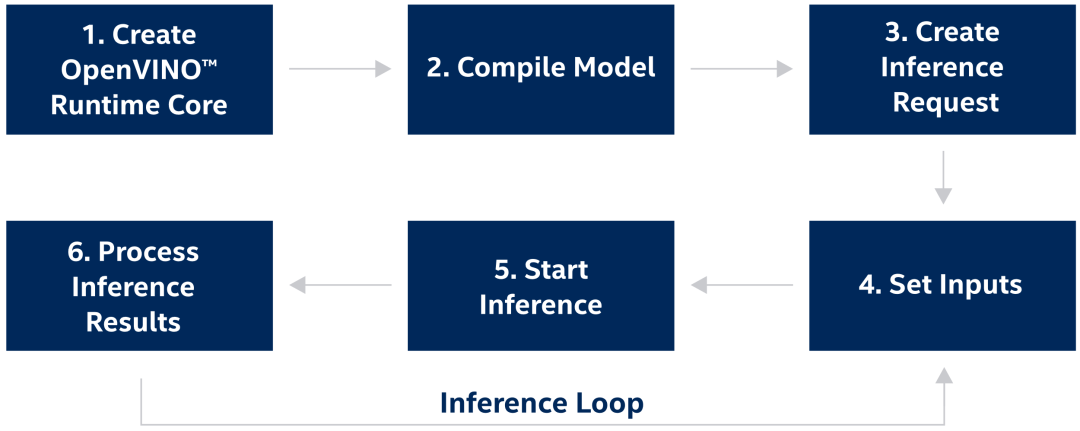

如要開始使用 C API 2.0 構建自己的應用,您需要創建一個管道將 OpenVINO 集成到您的應用中(如圖 1 所示)。

圖 1.OpenVINO 推理管道的步驟

步驟1:創建 OpenVINO 運行時內核

添加標頭文件以支持 OpenVINO 運行時:

#include

使用以下代碼創建 OpenVINO 內核,以管理可用設備和讀取模型對象:

ov_core_t* core = NULL; ov_core_create(&core);

步驟2:編譯模型

以下代碼展示了以 OpenVINO 中間代碼 (IR) 文件的格式編譯深度學習模型的示例。您還可將其替換為其他框架的模型格式,如 TensorFlow、ONNX 等。

ov_compiled_model_t* compiled_model = NULL; ov_core_compile_model_from_file(core, "model.xml", "AUTO", 0, &compiled_model);

向右滑動查看完整代碼

步驟3:創建推理請求

使用以下代碼創建推理請求:

ov_infer_request_t* infer_request = NULL; ov_compiled_model_create_infer_request(compiled_model, &infer_request);

向右滑動查看完整代碼

步驟4:設置輸入

// Get input port for model with one input ov_output_const_port_t* input_port = NULL; ov_model_const_input(model, &input_port); // Get the input shape from input port ov_shape_t input_shape; ov_const_port_get_shape(input_port, &input_shape); // Get the the type of input ov_element_type_e input_type; ov_port_get_element_type(input_port, &input_type); // Create tensor from external memory ov_tensor_t* tensor = NULL; ov_tensor_create_from_host_ptr(input_type, input_shape, memory_ptr, &tensor); // Set input tensor for model with one input ov_infer_request_set_input_tensor(infer_request, tensor);

向右滑動查看完整代碼

步驟5:開始推理

OpenVINO 運行時支持同步或異步模式的推理。使用異步 API 可提高應用的整體幀速率:當加速器運行繁忙時,應用可在主機上正常工作,無需等待推理完成。以下代碼展示了在異步模式下設置推理的示例。

ov_infer_request_start_async(infer_request); ov_infer_request_wait(infer_request);

向右滑動查看完整代碼

步驟6:處理推理結果

檢查輸出張量,并使用以下代碼處理推理結果。

ov_tensor_t* output_tensor = NULL; // Get output tensor by tensor index ov_infer_request_get_output_tensor_by_index(infer_request, 0, &output_tensor);

向右滑動查看完整代碼

步驟7:釋放分配的對象

為避免內存泄漏,使用 C API 開發的應用需要按順序釋放分配的對象。

ov_shape_free(&input_shape); ov_tensor_free(output_tensor); ov_output_const_port_free(input_port); ov_tensor_free(tensor); ov_infer_request_free(infer_request); ov_compiled_model_free(compiled_model); ov_model_free(model); ov_core_free(core);

向右滑動查看完整代碼

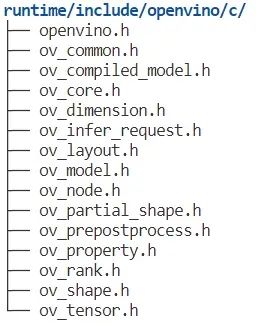

02在哪里找到 C API 2.0?

您可以通過“runtime/lib/libopenvino_c.so”(如圖 2 所示)輕松找到 C API 庫和標頭文件。

圖 2 在哪里找到 C API 2.0

03總結

總之,在 OpenVINO 2022.3 LTS 版本中,C API 更新為 C API 2.0。借助 C API 2.0,開發人員可以獲得多種新特性,能夠更輕松地在 C 應用中集成 OpenVINO。

審核編輯:湯梓紅

-

API

+關注

關注

2文章

1499瀏覽量

61962 -

編程

+關注

關注

88文章

3614瀏覽量

93686 -

人工智能

+關注

關注

1791文章

47183瀏覽量

238252 -

函數

+關注

關注

3文章

4327瀏覽量

62569 -

深度學習

+關注

關注

73文章

5500瀏覽量

121111

原文標題:OpenVINO? 的 C API 2.0 有何新特性?| 開發者實戰

文章出處:【微信號:英特爾物聯網,微信公眾號:英特爾物聯網】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

如何使用OpenVINO C++ API部署FastSAM模型

使用OpenVINO運行C++ API創建輸入tensor并執行推理遇到的問題求解

在Raspberry Pi上從源代碼構建OpenVINO 2021.3收到錯誤怎么解決?

JDBCTM 2.0 API

OpenVINO工具套件預處理API的概念及使用方法

OpenVINO? 2022.2新版本有哪些亮眼的新特性

用OpenVINO? C++ API編寫YOLOv8-Seg實例分割模型推理程序

基于OpenVINO Python API部署RT-DETR模型

基于OpenVINO C++ API部署RT-DETR模型

基于OpenVINO C# API部署RT-DETR模型

用OpenVINO C# API在intel平臺部署YOLOv10目標檢測模型

使用OpenVINO C# API部署YOLO-World實現實時開放詞匯對象檢測

OpenVINO?的C API 2.0有何新特性?

OpenVINO?的C API 2.0有何新特性?

評論