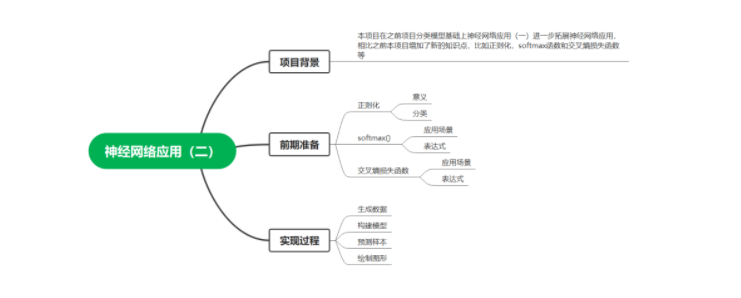

一.項目背景

本項目在之前項目分類模型基礎上神經(jīng)網(wǎng)絡應用(一)進一步拓展神經(jīng)網(wǎng)絡應用,相比之前本項目增加了新的知識點,比如正則化,softmax函數(shù)和交叉熵損失函數(shù)等。

二.前期準備

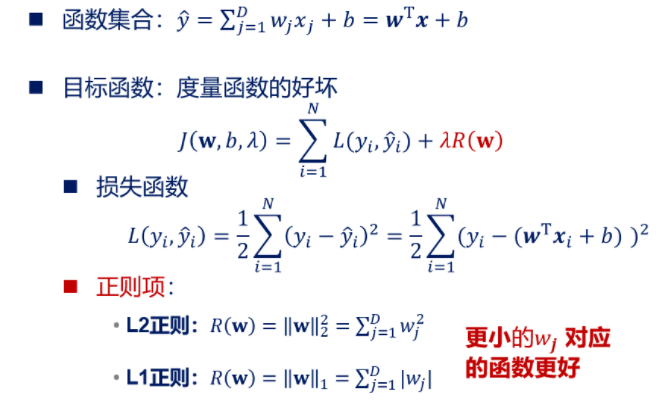

1.正則化

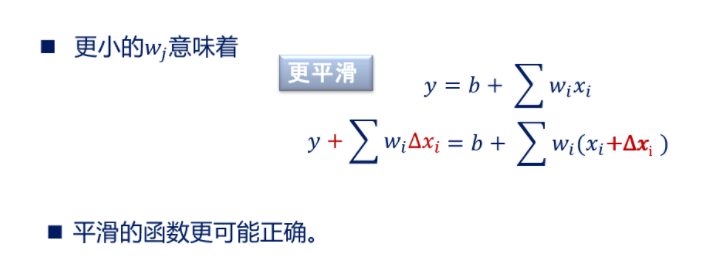

1)解釋:在機器學習中為了防止模型過擬合(簡單說就是在訓練集上樣本表現(xiàn)的

很好,在測試集上表現(xiàn)的很差),經(jīng)常需要進行正則化,所謂正則化簡單來說就是讓模

型系數(shù)變得相對小一點,防止數(shù)據(jù)稍微變化引起模型圖形曲線較大波動,總之一句話,

讓模型曲線表現(xiàn)更加平穩(wěn)。

2)分類:正則化總體分類為L1正則化和L2正則化。兩者區(qū)別在于范數(shù)級別不同,

L2正則化是||w||2,L1正則化是||w||1范數(shù),并且L2正則傾向于系數(shù)W盡量均衡(非

零分量個數(shù)盡量多),L1正則化使W分類盡量稀疏(非零分量個數(shù)盡量少),我們以線

性回歸為例,簡單說明一下。

【注】正則項不包括截距項。

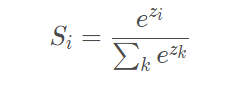

2.Softmax函數(shù)

1)Softmax經(jīng)常被應用在多分類任務的神經(jīng)網(wǎng)絡中的輸出層,簡單理解可以認為

Softmax輸出的是幾個類別選擇的概率。比如我有一個二分類任務,Softmax函數(shù)可以

根據(jù)它們相對的大小,輸出二個類別選取的概率,并且概率和為1。表達式如下,Si代

表的是第i個神經(jīng)元的輸出。

softmax函數(shù)

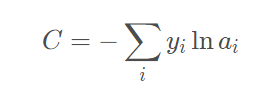

3.交叉熵損失函數(shù)

在神經(jīng)網(wǎng)絡反向傳播中需要損失函數(shù),損失函數(shù)其實表示的是真實值與網(wǎng)絡的估計

值的誤差,有了這個誤差我們才能知道怎樣去修改網(wǎng)絡中的權(quán)重。損失函數(shù)可以有很多

形式,這里用的是交叉熵函數(shù),主要是由于這個求導結(jié)果比較簡單,易于計算,并且交

叉熵解決某些損失函數(shù)學習緩慢的問題,函數(shù)表達式如下

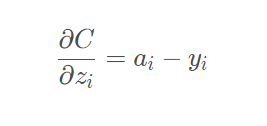

它的導數(shù)推到過程我們就不再說明,網(wǎng)上有很多資料大家可以參考,針對本項目分類

模型,我們最終結(jié)果為如下,也就是我們的預測概率值減去目標值。

三.實現(xiàn)過程

1.生成數(shù)據(jù)

#生成數(shù)據(jù)

def generate_data():

#設定種子數(shù),保定生成數(shù)據(jù)相同

np.random.seed(0)

#生成數(shù)據(jù)集和標簽,noise表示產(chǎn)生噪音

X, y = datasets.make_moons(200, noise=0.20)

#返回數(shù)據(jù)集

return X, y2.構(gòu)建模型

#計算損失函數(shù)

def calculate_loss(model, X, y):

#訓練樣本個數(shù)

num_examples = len(X) # training set size

#加載模型參數(shù)

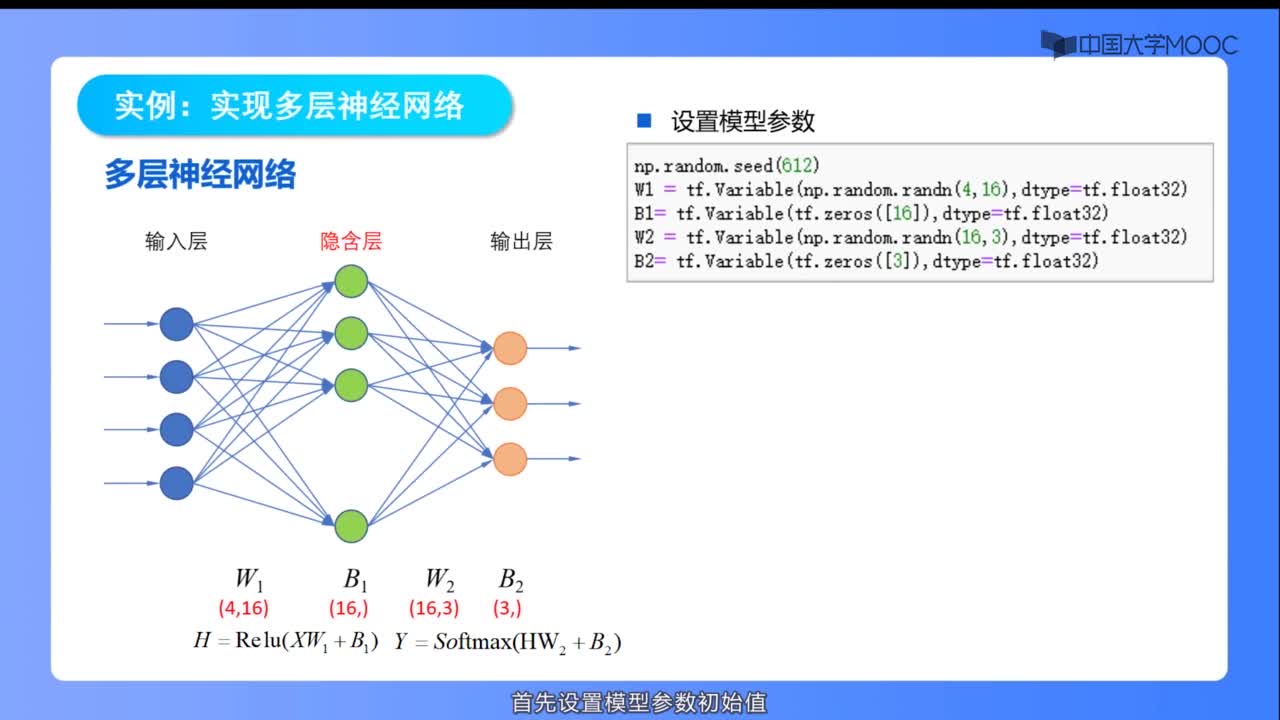

W1, b1, W2, b2 = model['W1'], model['b1'], model['W2'], model['b2']

#前向傳播

z1 = X.dot(W1) + b1

a1 = np.tanh(z1)

z2 = a1.dot(W2) + b2

exp_scores = np.exp(z2)

#softmax函數(shù)歸一化

probs = exp_scores / np.sum(exp_scores, axis=1, keepdims=True)

#定義交叉熵損失函數(shù)

corect_logprobs = -np.log(probs[range(num_examples), y])

#計算總的損失函數(shù)

data_loss = np.sum(corect_logprobs)

#L2正則化,防止過擬合

data_loss += Config.reg_lambda / 2 * (np.sum(np.square(W1)) + np.sum(np.square(W2)))

#除以樣本總數(shù)

return 1. / num_examples * data_loss

#構(gòu)建模型

def build_model(X, y, nn_hdim, num_passes=20000, print_loss=False):

#樣本個數(shù)

num_examples = len(X)

#記錄隨機中子數(shù)

np.random.seed(0)

#初始化神經(jīng)網(wǎng)絡參數(shù)

W1 = np.random.randn(Config.nn_input_dim, nn_hdim) / np.sqrt(Config.nn_input_dim)

b1 = np.zeros((1, nn_hdim))

W2 = np.random.randn(nn_hdim, Config.nn_output_dim) / np.sqrt(nn_hdim)

b2 = np.zeros((1, Config.nn_output_dim))

#存儲模型參數(shù)

model = {}

#遍歷每一輪

for i in range(0, num_passes):

#前向傳播

z1 = X.dot(W1) + b1

#函數(shù)表達式(e(z)-e(-z))/(e(z)+e(-z))

#隱藏層輸出

a1 = np.tanh(z1)

z2 = a1.dot(W2) + b2

#輸出層輸出

exp_scores = np.exp(z2)

#計算概率

probs = exp_scores / np.sum(exp_scores, axis=1, keepdims=True)

#反向傳播

delta3 = probs

#計算損失函數(shù)導數(shù)

delta3[range(num_examples), y] -= 1

#計算w2梯度

dW2 = (a1.T).dot(delta3)

#計算b2梯度

db2 = np.sum(delta3, axis=0, keepdims=True)

#計算輸入層到隱藏層總誤差

delta2 = delta3.dot(W2.T) * (1 - np.power(a1, 2))

#計算w1梯度

dW1 = np.dot(X.T, delta2)

#計算b1梯度

db1 = np.sum(delta2, axis=0)

#正則化系數(shù)w(只對w進行正則化,b不改變)

dW2 += Config.reg_lambda * W2

dW1 += Config.reg_lambda * W1

#更新參數(shù)

W1 += -Config.epsilon * dW1

b1 += -Config.epsilon * db1

W2 += -Config.epsilon * dW2

b2 += -Config.epsilon * db2

#存儲模型參數(shù)

model = {'W1': W1, 'b1': b1, 'W2': W2, 'b2': b2}

#輸出損失函數(shù)

if print_loss and i % 1000 == 0:

print("Loss after iteration %i: %f" % (i, calculate_loss(model, X, y)))

#返回模型參數(shù)

return model3.預測樣本

#預測樣本

def predict(model, x):

#加載模型參數(shù)

W1, b1, W2, b2 = model['W1'], model['b1'], model['W2'], model['b2']

#前向傳播

z1 = x.dot(W1) + b1

a1 = np.tanh(z1)

z2 = a1.dot(W2) + b2

#計算總體輸出

exp_scores = np.exp(z2)

#softmax函數(shù)

probs = exp_scores / np.sum(exp_scores, axis=1, keepdims=True)

#返回預測概率最大值對應標簽

return np.argmax(probs, axis=1)4.繪制圖形可視化

#繪制邊界線

def plot_decision_boundary(pred_func, X, y):

#分別設置間隔

x_min, x_max = X[:, 0].min() - 0.5, X[:, 0].max() + 0.5

y_min, y_max = X[:, 1].min() - 0.5, X[:, 1].max() + 0.5

#步長

h = 0.01

#生成網(wǎng)格數(shù)據(jù)

xx, yy = np.meshgrid(np.arange(x_min, x_max, h), np.arange(y_min, y_max, h))

#預測整個網(wǎng)格z值

Z = pred_func(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

#繪制分割線

plt.contourf(xx,

yy,

Z,

cmap=plt.cm.Spectral)

#繪制散點圖

plt.scatter(X[:, 0],

X[:, 1],

c=y,

cmap=plt.cm.Spectral)

#顯示圖形

plt.show()

#可視化函數(shù)

def visualize(X, y, model):

#繪制圖形

plot_decision_boundary(lambda x:predict(model,x), X, y)

#設置標題

plt.title("Neural Network")

#主函數(shù)

def main():

#生成數(shù)據(jù)

X, y = generate_data()

#構(gòu)建模型

model = build_model(X, y, 3, print_loss=True)

#可視化

visualize(X, y, model)

#預測準確樣本數(shù)

accuracy=0

#設定種子數(shù),保定生成數(shù)據(jù)相同

np.random.seed(1)

#生成數(shù)據(jù)集和標簽,noise表示產(chǎn)生噪音

X_test, y = datasets.make_moons(200, noise=0.20)

#驗證測試集

for i in range(len(X_test)):

#預測測試集

if y[i]==predict(model,X_test[i]):

#預測準確數(shù)目

accuracy+=1

#輸出準確率

print("Accuracy:",float(accuracy)/len(X_test))

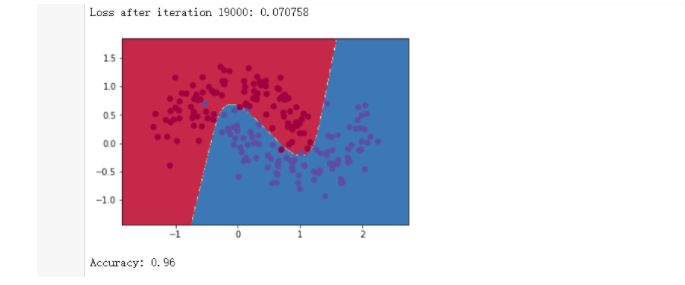

結(jié)論:準確率為96%(這里測試集數(shù)據(jù)我們添加了噪音),如果在產(chǎn)生測試集數(shù)據(jù)時取掉

noise參數(shù)(也就是說取掉噪音數(shù)據(jù)),準確率會更高。

聲明:本文內(nèi)容及配圖由入駐作者撰寫或者入駐合作網(wǎng)站授權(quán)轉(zhuǎn)載。文章觀點僅代表作者本人,不代表電子發(fā)燒友網(wǎng)立場。文章及其配圖僅供工程師學習之用,如有內(nèi)容侵權(quán)或者其他違規(guī)問題,請聯(lián)系本站處理。

舉報投訴

-

神經(jīng)網(wǎng)絡

+關(guān)注

關(guān)注

42文章

4814瀏覽量

103758 -

函數(shù)

+關(guān)注

關(guān)注

3文章

4381瀏覽量

64963 -

Softmax

+關(guān)注

關(guān)注

0文章

9瀏覽量

2705

發(fā)布評論請先 登錄

相關(guān)推薦

熱點推薦

1 LeNet神經(jīng)網(wǎng)絡(2)#神經(jīng)網(wǎng)絡

神經(jīng)網(wǎng)絡深度學習

未來加油dz

發(fā)布于 :2023年05月16日 15:31:35

3.1 多層神經(jīng)網(wǎng)絡(2)#神經(jīng)網(wǎng)絡

神經(jīng)網(wǎng)絡深度學習

未來加油dz

發(fā)布于 :2023年05月16日 18:50:47

6 實現(xiàn)多層神經(jīng)網(wǎng)絡(2)#神經(jīng)網(wǎng)絡

神經(jīng)網(wǎng)絡深度學習

未來加油dz

發(fā)布于 :2023年05月17日 11:43:17

【PYNQ-Z2申請】基于PYNQ的卷積神經(jīng)網(wǎng)絡加速

,得到訓練參數(shù)2、利用開發(fā)板arm與FPGA聯(lián)合的特性,在arm端實現(xiàn)圖像預處理已經(jīng)卷積核神經(jīng)網(wǎng)絡的池化、激活函數(shù)和全連接,在FPGA端實現(xiàn)卷積運算3、對整個系統(tǒng)進行調(diào)試。4、在基本實現(xiàn)系統(tǒng)的基礎上

發(fā)表于 12-19 11:37

用Python從頭實現(xiàn)一個神經(jīng)網(wǎng)絡來理解神經(jīng)網(wǎng)絡的原理2

有個事情可能會讓初學者驚訝:神經(jīng)網(wǎng)絡模型并不復雜!『神經(jīng)網(wǎng)絡』這個詞讓人覺得很高大上,但實際上神經(jīng)網(wǎng)絡算法要比人們想象的簡單。

這篇文章完全是為新手準備的。我們會通過用Python從頭實現(xiàn)一個

評論