導(dǎo) 讀

本文是 AAAI 2023 Oral 入選論文 Tracking and Reconstructing Hand Object Interactions from Point Cloud Sequences in the Wild 的解讀。本論文由北京大學(xué)王鶴研究團(tuán)隊(duì)與北京通用人工智能研究院、弗吉尼亞理工大學(xué)、斯坦福大學(xué)、清華大學(xué)、哥倫比亞大學(xué)合作,針對(duì)追蹤并重建一段輸入點(diǎn)云序列中的手和物體這一任務(wù)進(jìn)行了研究。

我們首次提出了一個(gè)基于點(diǎn)云的手部關(guān)節(jié)追蹤網(wǎng)絡(luò) HandTrackNet,并設(shè)計(jì)了一套完整的算法來(lái)完成手和物體追蹤與重建這一具有挑戰(zhàn)性的任務(wù)。此外,為了獲得更多樣且精準(zhǔn)的數(shù)據(jù),我們?cè)?a href="http://www.1cnz.cn/tags/仿真器/" target="_blank">仿真器中生成了大量手物交互的數(shù)據(jù),并模擬了深度相機(jī)的拍攝原理,以獲得接近真實(shí)世界噪聲分布的深度數(shù)據(jù)。僅用仿真數(shù)據(jù)進(jìn)行訓(xùn)練,我們的方法可以很好地泛化到未見(jiàn)過(guò)的真實(shí)場(chǎng)景測(cè)試數(shù)據(jù)上,以較快的速度(9FPS)取得遠(yuǎn)超前人工作的精度。

論文鏈接:

http://arxiv.org/abs/2209.12009

項(xiàng)目主頁(yè):

https://pku-epic.github.io/HOtrack

代碼地址:

https://github.com/PKU-EPIC/HOTrack

圖1. HO3D 數(shù)據(jù)集上的效果展示圖。左起依次為輸入點(diǎn)云,輸出重建結(jié)果,另一個(gè)視角的輸出,以及輸出與 RGB 疊置的效果。可以看到,我們的算法對(duì)手物交互中的遮擋問(wèn)題有很好的魯棒性。

圖2. DexYCB 數(shù)據(jù)集上的效果展示圖。

01

引 言

手和物體的交互作為人類(lèi)與復(fù)雜現(xiàn)實(shí)場(chǎng)景交互的主要途徑,在現(xiàn)實(shí)生活中無(wú)處不在。作為感知人類(lèi)與物體交互的主要方法,位姿追蹤和重建人手與物體是兩個(gè)至關(guān)重要的研究課題,可以實(shí)現(xiàn)廣泛的應(yīng)用,包括人機(jī)交互[1],增強(qiáng)現(xiàn)實(shí)[2],以及讓機(jī)器人從人類(lèi)的演示中學(xué)習(xí)相應(yīng)技能(如抓取和操縱等[3])。

近年來(lái),隨著深度學(xué)習(xí)的發(fā)展,越來(lái)越多基于深度學(xué)習(xí)的工作涌現(xiàn)出來(lái),研究如何從單幀信息(RGB 圖片[4]或點(diǎn)云[5])中去感知手和物體,重建他們的幾何形狀或是估計(jì)他們的位姿,但是這類(lèi)方法往往無(wú)法利用上視頻相鄰幀之間的連續(xù)性。另一方面,深度學(xué)習(xí)非常依賴(lài)數(shù)據(jù),而對(duì)真實(shí)場(chǎng)景視頻中的手和物體去準(zhǔn)確標(biāo)注三維幾何形狀及位姿是一件非常困難且成本極大的事情,現(xiàn)有的數(shù)據(jù)集如 DexYCB[6]和 HO3D[7]都規(guī)模不大且包含的物體數(shù)量少(不超過(guò)20個(gè)不同物體),用這樣的數(shù)據(jù)難以訓(xùn)練出能夠泛化到未見(jiàn)過(guò)的手和物體的模型。

因此,在這個(gè)工作中,我們關(guān)注于這樣一個(gè)非常有挑戰(zhàn)的任務(wù)——在不用任何真實(shí)數(shù)據(jù)作訓(xùn)練的前提下,對(duì)自然條件下的點(diǎn)云序列,聯(lián)合追蹤并重建人手和物體。我們的任務(wù)設(shè)定如下所述:給定一個(gè)包含已分割的手和物體的深度點(diǎn)云序列,還有初始的手部位姿和物體位姿,我們的算法需要去重建手和物體的幾何形狀,并以一個(gè)在線的方式(即對(duì)于第幀的預(yù)測(cè)只能利用當(dāng)前幀和過(guò)去幀的信息,不能利用未來(lái)幀的信息)對(duì)他們的位姿進(jìn)行追蹤。我們選擇點(diǎn)云這一模態(tài)作為輸入而非圖片是因?yàn)樗麄兙哂懈訙?zhǔn)確的三維結(jié)構(gòu),便于我們感知手和物體的位姿,并且具有更小的歧義性。

為了實(shí)現(xiàn)這一目標(biāo),首先,為了緩解數(shù)據(jù)問(wèn)題,我們提出了一套流程來(lái)合成手和物體交互的仿真數(shù)據(jù)集。該數(shù)據(jù)集擁有非常高的多樣性,無(wú)論是手的形狀、物體的形狀,還是兩者的交互姿勢(shì);此外,得益于仿真環(huán)境的優(yōu)勢(shì),這些數(shù)據(jù)帶有免費(fèi)的位姿和形狀標(biāo)注。為了最小化仿真和現(xiàn)實(shí)的領(lǐng)域差異,我們利用 DDS[8]提出的基于結(jié)構(gòu)光的深度傳感器模擬器,生成帶有真實(shí)傳感器噪聲的仿真點(diǎn)云。

除此之外,我們首次提出了一個(gè)基于點(diǎn)云的手部姿勢(shì)跟蹤網(wǎng)絡(luò),HandTrackNet,以追蹤幀間手部關(guān)節(jié)的運(yùn)動(dòng)。HandTrackNet 建立在 PointNet++[9]的基礎(chǔ)上,基于上一幀的預(yù)測(cè)來(lái)估計(jì)當(dāng)前幀手部關(guān)節(jié)位置的變化。相較于單幀回歸的算法,這樣做壓縮了輸出數(shù)據(jù)的分布空間,簡(jiǎn)化了回歸任務(wù),增強(qiáng)了時(shí)序上的連續(xù)性。此外,HandTrackNet 會(huì)從上一幀的預(yù)測(cè)中計(jì)算手的全局位姿,并利用手的全局位姿來(lái)將當(dāng)前幀的輸入點(diǎn)云變換到一個(gè)規(guī)范化的坐標(biāo)系內(nèi),這極大地壓縮了輸入數(shù)據(jù)的分布空間,進(jìn)一步簡(jiǎn)化了回歸任務(wù)。在訓(xùn)練過(guò)程中,HandTrackNet 會(huì)學(xué)習(xí)修正隨機(jī)的手部關(guān)節(jié)擾動(dòng),因此不會(huì)過(guò)擬合到任何時(shí)序軌跡上。

最后,為了更好的解決手和物體遮擋帶來(lái)的歧義性,我們進(jìn)一步利用基于優(yōu)化的方法來(lái)推理手和物體之間的空間關(guān)系,獲取物理上更加真實(shí)的預(yù)測(cè)。我們先將追蹤到的手部關(guān)節(jié)位置轉(zhuǎn)化為 MANO[10]這一參數(shù)化模型的表示,得到手部幾何的重建,然后根據(jù)手和物體交互的先驗(yàn)構(gòu)建幾個(gè)能量函數(shù),用于進(jìn)一步調(diào)整手的位姿,從而產(chǎn)生更加符合物理規(guī)律、更加真實(shí)的手部位姿。

通過(guò)充分的實(shí)驗(yàn),我們證明了我們的方法在從未見(jiàn)過(guò)的真實(shí)世界手和物體交互數(shù)據(jù)集 HO3D[7]和 DexYCB[6]中的有效性。我們的方法在手和物體的位姿追蹤精度上明顯優(yōu)于之前的方法,并顯示出良好的追蹤魯棒性和極強(qiáng)的泛化性。整個(gè)算法能夠以交互式幀率(約9FPS)進(jìn)行在線跟蹤和重建。

02

方法簡(jiǎn)介

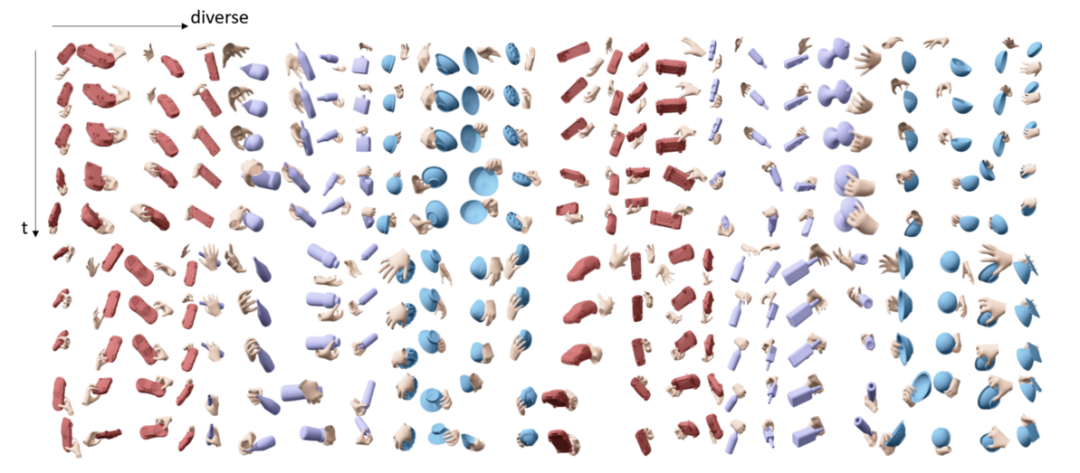

圖3. 我們生成的 SimGrasp 數(shù)據(jù)集。

首先,為了應(yīng)對(duì)數(shù)據(jù)不足的問(wèn)題,我們?cè)诜抡姝h(huán)境中造了一個(gè)手和物體交互的數(shù)據(jù)集 SimGrasp,包含超過(guò)450個(gè)不同的物體和100個(gè)不同大小的手,一共生成了1810段視頻,每段視頻有100幀。我們首先使用 GraspIt[11]來(lái)生成了一些手和物體呈持握狀態(tài)的數(shù)據(jù),然后將手往手背方向挪一定距離,并通過(guò)對(duì)位姿插值的方式獲取動(dòng)態(tài)抓取的視頻。為了減少 Sim2real 的巨大差異,我們重新實(shí)現(xiàn)了 DDS 算法[8],基于結(jié)構(gòu)光深度相機(jī)的原理,在仿真環(huán)境中模擬了真實(shí)相機(jī)點(diǎn)云會(huì)產(chǎn)生的噪聲。

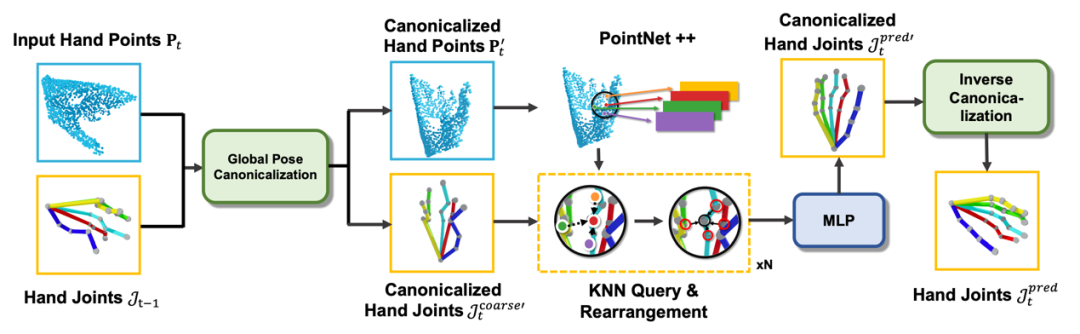

圖4. HandTrackNet 結(jié)構(gòu)示意圖。

在方法上,我們首次提出了一個(gè)基于點(diǎn)云的手部關(guān)節(jié)追蹤網(wǎng)絡(luò) HandTrackNet,該網(wǎng)絡(luò)接收當(dāng)前第幀的手部點(diǎn)云和上一幀預(yù)測(cè)的手部關(guān)節(jié)位置作為輸入,并對(duì)二者進(jìn)行全局姿勢(shì)規(guī)范化處理。然后,它利用 PointNet++[9]從規(guī)范化的手部點(diǎn)云中提取特征,并使用每個(gè)關(guān)節(jié)進(jìn)行近鄰查詢(xún)和特征傳遞,最后用一個(gè)多層線性感知機(jī)來(lái)回歸并更新關(guān)節(jié)位置。

其中,主要的創(chuàng)新部分在于利用上一幀預(yù)測(cè)的關(guān)節(jié)位置來(lái)進(jìn)行全局姿勢(shì)規(guī)范化上。前人的工作[5]發(fā)現(xiàn)手的全局位姿的多樣性會(huì)給網(wǎng)絡(luò)預(yù)測(cè)關(guān)節(jié)位置帶來(lái)很大的困難,而如果能夠設(shè)計(jì)比較好的全局位姿規(guī)范化方法,使得所有的輸入點(diǎn)云都能被變換到同一個(gè)規(guī)范位姿下(例如手心朝向軸,指尖指向軸),就能大大降低學(xué)習(xí)難度,提升泛化能力。注意到,按照之前定義的手部規(guī)范位姿,規(guī)范化的手部點(diǎn)云的第一特征向量應(yīng)該平行軸,第二特征向量應(yīng)該平行軸,因此前人工作[5]中大多使用 PCA 來(lái)獲取手部點(diǎn)云的外包圍盒,并利用上述特性進(jìn)行手的全局姿勢(shì)規(guī)范化。然而,這樣的做法存在的缺陷是當(dāng)手被嚴(yán)重遮擋時(shí),獲取的外包圍盒無(wú)法很好地反應(yīng)真實(shí)手部全局位姿,因此不適用于手和物體交互的場(chǎng)景。

而我們則是注意到,手部指根處的關(guān)節(jié)點(diǎn)相對(duì)位置無(wú)論手指怎么動(dòng)都是基本不變的,因此我們可以用 SVD 求解上一幀指根關(guān)節(jié)位置相對(duì)于預(yù)定義的規(guī)范位姿下的指根位置的平移和旋轉(zhuǎn),結(jié)合視頻的連續(xù)性,利用這一平移和旋轉(zhuǎn)去規(guī)范化當(dāng)前幀的手部點(diǎn)云輸入。

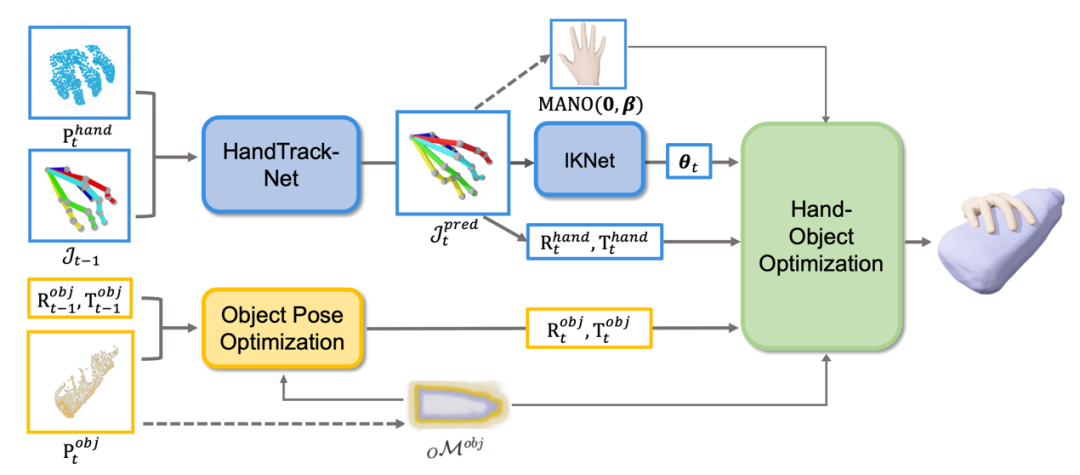

圖5. 完整流程圖。第0幀,我們會(huì)重建手和物體的幾何(如虛線所示);后續(xù)每一幀,我們會(huì)分別預(yù)測(cè)物體的位姿和手的位姿,并通過(guò)優(yōu)化來(lái)進(jìn)一步修復(fù)手的位姿。我們還可以每10幀更新一次手和物體的幾何。

利用 HandTrackNet 獲取手部關(guān)節(jié)位置后,我們利用一個(gè)簡(jiǎn)單的多層感知機(jī)網(wǎng)絡(luò) IKNet 將手部關(guān)節(jié)位置轉(zhuǎn)化成了手部各關(guān)節(jié)角度,將作為 MANO 這一常用的手部參數(shù)化模型的輸入,結(jié)合第0幀通過(guò)優(yōu)化獲得的手部形狀參數(shù),就可以得到手的完整三維重建了。而物體這一支,我們?cè)诘?幀利用 DeepSDF[12]的技術(shù)來(lái)根據(jù)觀察到的點(diǎn)云去重建類(lèi)別級(jí)未知物體的幾何形狀,并在之后每一幀通過(guò)優(yōu)化的辦法來(lái)解算物體位姿。最后,我們還使用了一個(gè)聯(lián)合優(yōu)化的模塊,使用手與物體不會(huì)互相穿透、手指會(huì)貼近物體表面等條件作為能量函數(shù)來(lái)優(yōu)化手的位姿,獲取更符合物理規(guī)律、更真實(shí)的手物交互。我們還可以每隔10幀更新一次手和物體的幾何,降低初始化時(shí)的幾何誤差對(duì)后續(xù)追蹤的影響。

03

實(shí)驗(yàn)結(jié)果

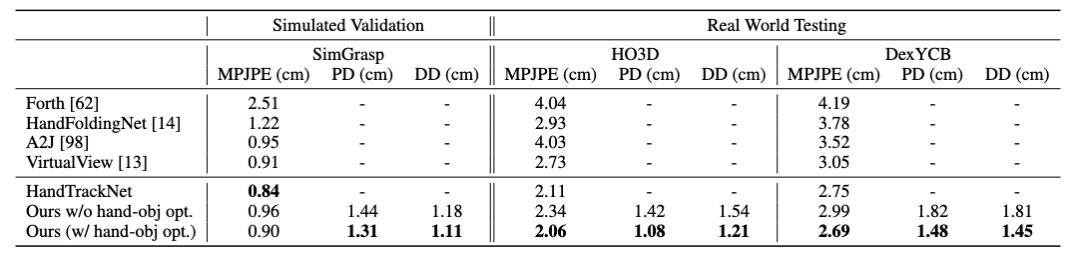

我們僅僅使用我們合成的仿真數(shù)據(jù)集 SimGrasp 進(jìn)行訓(xùn)練,在不使用任何真實(shí)數(shù)據(jù)進(jìn)一步訓(xùn)練的情況下,直接在 HO3D[7]和 DexYCB[6]這兩個(gè)具有挑戰(zhàn)性的真實(shí)數(shù)據(jù)集上進(jìn)行測(cè)試。相較于之前基于單幀預(yù)測(cè)的工作HandFoldingNet[13],A2J[14]和 VirtualView[15]以及基于追蹤的工作 Forth[16],我們的方法在平均關(guān)節(jié)位置誤差這項(xiàng)指標(biāo)上在兩個(gè)數(shù)據(jù)集中分別能顯著提升6mm 和3mm 以上。

圖6. 手部關(guān)節(jié)追蹤實(shí)驗(yàn)結(jié)果。MPJPE 指平均關(guān)節(jié)位置誤差,PD 指手和物體最大穿透深度,DD 指手和物體在接觸時(shí)手指到物體上最近點(diǎn)的平均距離。

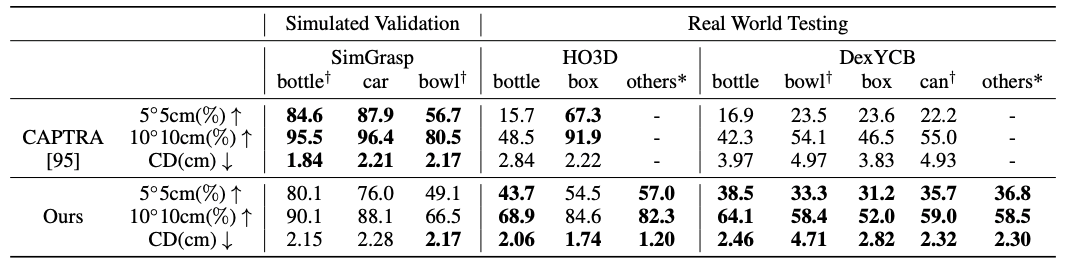

物體追蹤方面,雖然之前的工作 CAPTRA[17]在驗(yàn)證集上能獲得更好的表現(xiàn),但是在真實(shí)數(shù)據(jù)的測(cè)試集上,我們基于優(yōu)化的方法能夠一致地超過(guò)它,證明了我們方法具有更強(qiáng)的泛化能力。

圖7. 物體追蹤實(shí)驗(yàn)結(jié)果。5度5cm 指旋轉(zhuǎn)誤差小于5度且平移誤差小于5cm 的百分比,10度10cm 同理,CD 指帶位姿的重建物體和標(biāo)注物體的倒角距離(Chamfer distance)。

審核編輯 :李倩

-

算法

+關(guān)注

關(guān)注

23文章

4619瀏覽量

93041 -

仿真器

+關(guān)注

關(guān)注

14文章

1019瀏覽量

83801 -

人工智能

+關(guān)注

關(guān)注

1792文章

47404瀏覽量

238910 -

點(diǎn)云

+關(guān)注

關(guān)注

0文章

58瀏覽量

3804

原文標(biāo)題:AAAI 2023 Oral | 北京大學(xué)等提出HandTrackNet:點(diǎn)云序列中手物交互的位姿追蹤與重建

文章出處:【微信號(hào):CVer,微信公眾號(hào):CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

北京大學(xué)在集成光學(xué)相關(guān)研究取得進(jìn)展

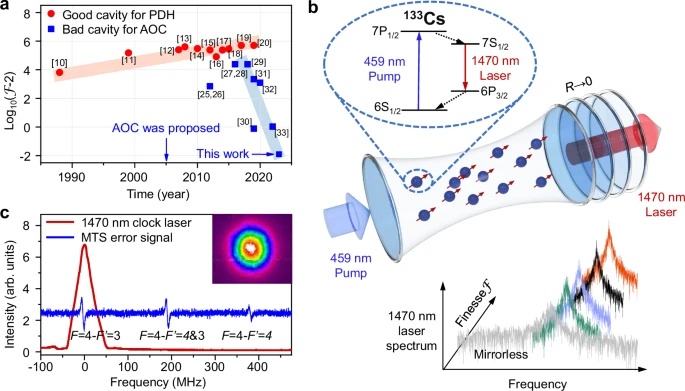

北京大學(xué)研究團(tuán)隊(duì)在新型激光領(lǐng)域取得重要進(jìn)展

RISC-V AI技術(shù)正式納入北京大學(xué)研究生課程

Aigtek誠(chéng)邀您蒞臨第五屆超聲換能器及材料技術(shù)研討會(huì)!

北京大學(xué)謝濤:基于RISC-V構(gòu)建AI算力的優(yōu)勢(shì)和兩種模式

引領(lǐng)高校原生人才新生態(tài) 北京大學(xué)鯤鵬昇騰科教創(chuàng)新卓越中心正式成立

潤(rùn)石科技董事長(zhǎng)參加北京大學(xué)集成電路學(xué)院“未名·芯”論壇

北京大學(xué)講座 | 大模型時(shí)代的軟件研發(fā):技術(shù)、范式與工具

北京大學(xué)-知存科技存算一體聯(lián)合實(shí)驗(yàn)室揭牌,開(kāi)啟知存科技產(chǎn)學(xué)研融合戰(zhàn)略新升級(jí)

北京大學(xué)問(wèn)世世界最薄光學(xué)晶體:氮化硼晶體

北京大學(xué)高性能計(jì)算綜合能力競(jìng)賽圓滿結(jié)束

Testin云測(cè)鴻蒙原生應(yīng)用兼容測(cè)試服務(wù)入選2023中國(guó)ToB行業(yè)影響力價(jià)值榜

百川智能與北京大學(xué)將共建通用人工智能聯(lián)合實(shí)驗(yàn)室

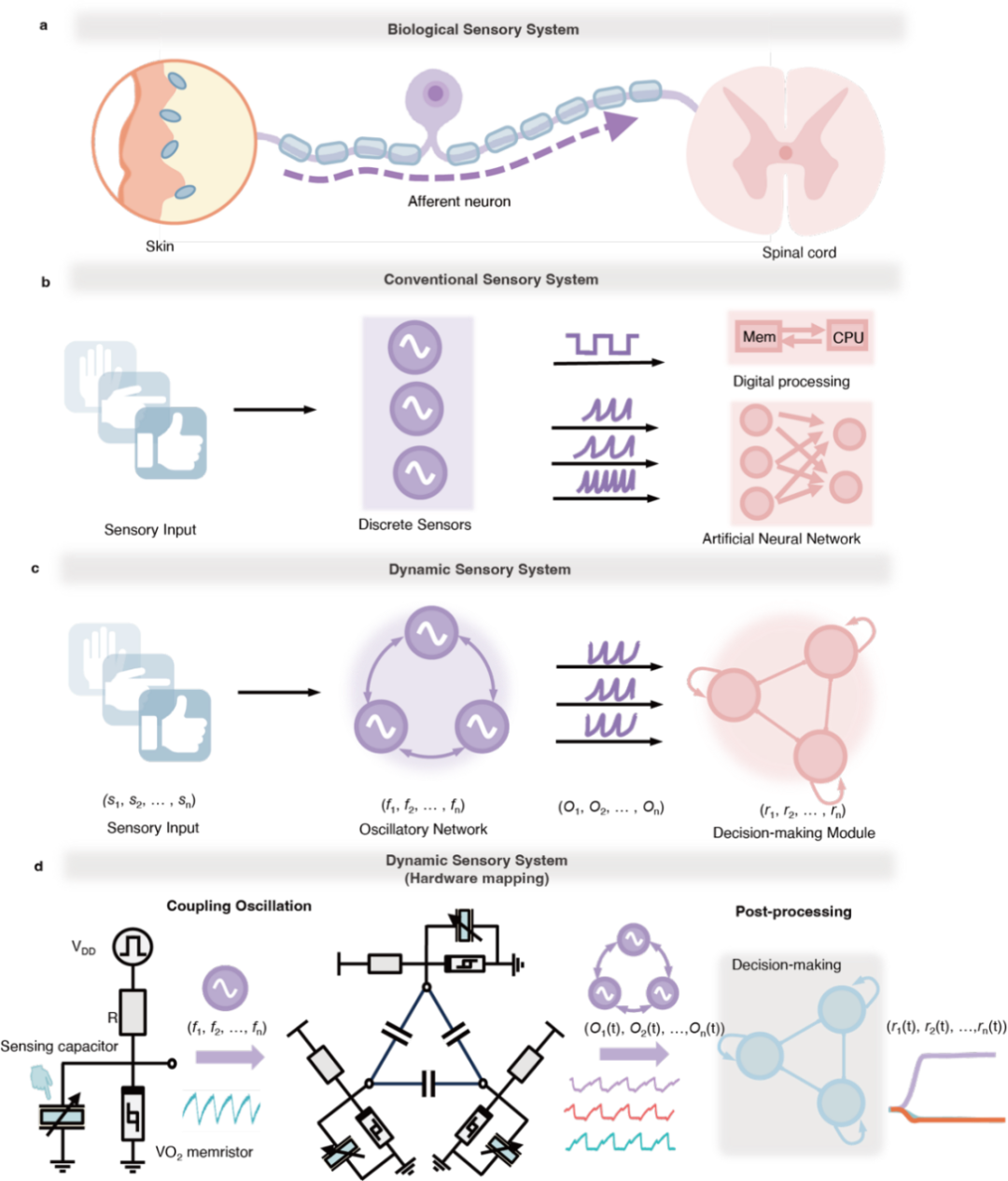

北京大學(xué)首次硬件實(shí)現(xiàn)電容耦合的VO2相變振蕩動(dòng)力學(xué)計(jì)算系統(tǒng)

TDK中國(guó)榮獲“2023中國(guó)年度優(yōu)選雇主”

北京大學(xué)等提出HandTrackNet:點(diǎn)云序列中手物交互的位姿追蹤與重建

北京大學(xué)等提出HandTrackNet:點(diǎn)云序列中手物交互的位姿追蹤與重建

評(píng)論