神經網絡是一類用層構建的模型。常用的神經網絡類型包括卷積神經網絡和遞歸神經網絡。

結構

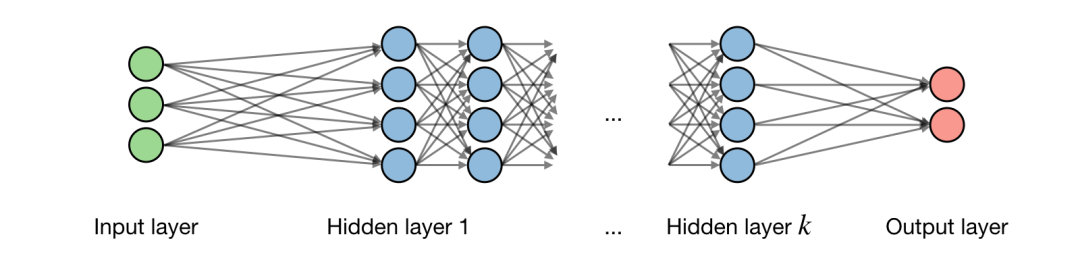

關于神經網絡架構的描述如下圖所示:

記 為網絡的第 層, 為一層中隱藏的第 個 單元,得到:

式中 分別表示權重,偏移和輸出。

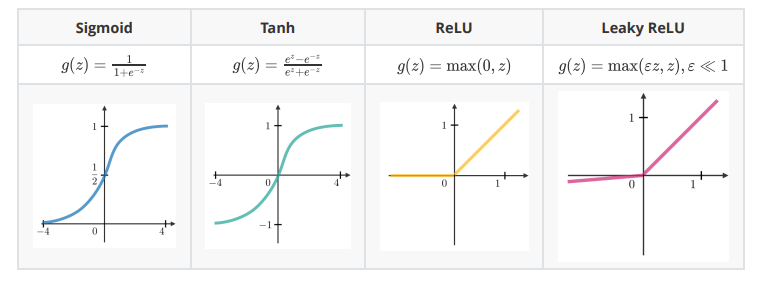

激活函數

在隱含單元的末端使用激活函數向模型引入非線性復雜性。以下是最常見的幾種:

交叉熵損失(Cross-entropy loss)

在神經網絡中,交叉熵損失 是常用的,定義如下:

學習率(Learning rate)

學習率通常記作 ,表示在哪一步權重得到了更新。這個可以是固定的,也可以是自適應變化的。目前最流行的方法是 Adam,這是一種自適應學習率的方法。

反向傳播(Backpropagation)

反向傳播是一種通過考慮實際輸出和期望輸出更新神經網絡權重的方法。權重 的導數用鏈式法則計算(chain rule),它的形式如下:

因此權重更新如下:

更新權重

在神經網絡中,權重的更新方式如下:

第一步:對訓練數據取一批(batch);第二步:進行正向傳播以獲得相應的損失;第三步:反向傳播損失,得到梯度;第四步:使用梯度更新網絡的權重。

丟棄(Dropout)

它是一種通過在神經網絡中刪除單元來防止過度擬合訓練數據的技術。實際應用中,單元被刪除的概率是 ,或被保留的概率是 。

卷積神經網絡(Convolutional Neural Networks)

卷積層需求

記 為輸入量大小, 為卷積層神經元大小, 為 zero padding 數量,那么匹配給定體積輸入的神經元數量 為:

批量正則化(Batch normalization)

這一步是超參數(hyperparameter) 正則化批量 。記 分別為批量值的平均值和方差,正則化表示如下:

它通常用于完全連接或卷積層之后,且在非線性層之前。目的是允許更高的學習率,減少初始化的強依賴。

遞歸神經網絡(Recurrent Neural Networks)

門類型(Types of gates)

以下是在我們碰到的典型遞歸神經網絡中存在的不同類型的門:

| 輸入門(Input gate) | 忘記門(Forget gate) | 輸出門(Output gate) | 門(Gate) |

|---|---|---|---|

| 是否寫入神經元? | 是否擦出神經元? | 是否顯示神經元? | 寫入多少 |

長短期記憶網絡(LSTM, Long Short-Term Memory)

長短期記憶網絡是RNN模型的一種,它通過添加“忘記”門來避免梯度消失問題。

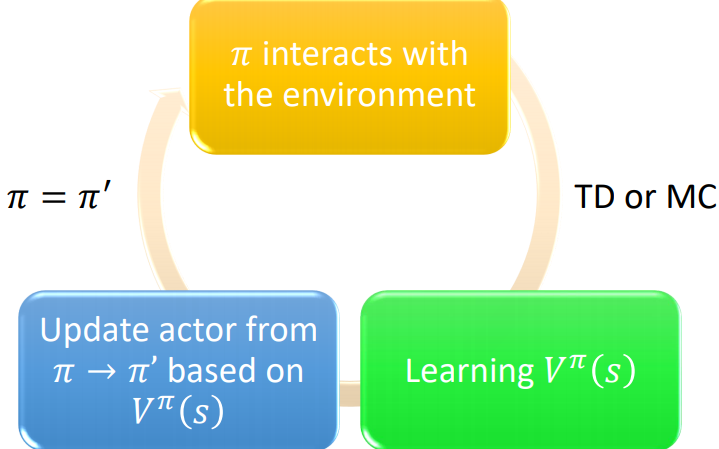

強化學習與控制(Reinforcement Learning and Control)

強化學習的目標是讓代理(agent)學會如何在環境中進化。

馬爾科夫決策過程(Markov decision processes)

馬爾科夫決策過程(MDP)是一個5元組 ,其中:

是一組狀態。

是一組行為。

是 和 的狀態轉換概率。

是discount系數。

或者 是算法要最大化的獎勵函數。

策略(Policy)

策略 是一個映射狀態到行為的函數 。

備注:我們說,如果給定一個狀態 ,我們執行一個給定的策略 ,得到的行為是 。

價值函數(Value function)

對于給定的策略 和狀態 ,我們定義價值函數如下 :

貝爾曼方程(Bellman equation)

最優貝爾曼方程描述了最優策略 的價值函數 :

備注:對于給定的狀態 ,我們記最優策略 為:

價值迭代算法(Value iteration algorithm)

算法包含2步:

第一步,初始化價值:

第二步,基于之前的價值進行迭代:

最大似然估計(Maximum likelihood estimate)

狀態轉移概率的最大似然估計如下:

的行為次數

Q-learning

Q-learning是 一種無模型,公式如下:

-

神經網絡

+關注

關注

42文章

4771瀏覽量

100720 -

算法

+關注

關注

23文章

4608瀏覽量

92844 -

函數

+關注

關注

3文章

4329瀏覽量

62576 -

深度學習

+關注

關注

73文章

5500瀏覽量

121117 -

強化學習

+關注

關注

4文章

266瀏覽量

11250

原文標題:全面整理:深度學習(ANN,CNN,RNN)和強化學習重要概念和公式

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

什么是深度強化學習?深度強化學習算法應用分析

深度強化學習實戰

將深度學習和強化學習相結合的深度強化學習DRL

薩頓科普了強化學習、深度強化學習,并談到了這項技術的潛力和發展方向

如何深度強化學習 人工智能和深度學習的進階

DeepMind發布強化學習庫RLax

模型化深度強化學習應用研究綜述

基于深度強化學習仿真集成的壓邊力控制模型

《自動化學報》—多Agent深度強化學習綜述

深度學習和強化學習的重要概念和公式

深度學習和強化學習的重要概念和公式

評論