01.發源于OpenAI,成名于生成式語言

OpenAI 是一家世界領先的非營利性人工智能研究公司。OpenAI 于 2015 年在舊金山成立,是一家非營利的人工智能研究公司,公司的目標是以最有可能造福全人類的方式推進人工智能,而不受財務回報需求的約束。OpenAI 創始人背景深厚,由埃隆·馬斯克與硅谷孵化器 Y Combinator 投資人山姆·阿爾特曼等人聯合創立。公司研究人員經驗豐富,包括前Google Brain 研究科學家伊利亞·蘇茨凱弗與前 Stripe 首席技術官格雷格·布羅克曼等世界一流研究工程師與科學家。

2018 年,隨著特斯拉對 AI 的應用深入,為避免潛在利益沖突,馬斯克主動離任董事會,僅保留捐資人和顧問的身份。由于 AI 訓練花費金額巨大,2019 年公司從非營利性公司轉向部分盈利公司,成立了 OpenAI LP 利潤上限子公司,即任何對 OpenAI LP 投資的收益都將統一轉移至一家非盈利公司,回報達到投資的 100 倍后進行利潤分配。

同年,OpenAI 收到微軟注資 10 億美元,就 Azure 業務開發人工智能技術。2020 年發布 GPT-3 語言模型,由微軟獲得獨家授權。2022 年發布 ChatGPT 的自然語言生成式模型,帶來更大潛在應用空間。2023 年,微軟擬對 OpenAI 追加數十億美元投資,利用自身算力基礎設施資源發揮與 OpenAI 業務協同效應,深入布局生成式 AI 技術。

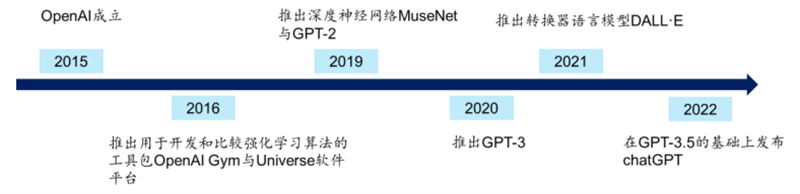

2016 年,推出用于開發和比較強化學習算法的工具包 OpenAI Gym,加速公開社會中 RL 研究進度。同時推出 Universe 軟件平臺,用于測試和訓練 AI 在全球游戲、網站和其他應用程序中的智能程度。2019 年,OpenAI 推出深度神經網絡 MuseNet,可以使用 4 種不同的樂器生成 10分鐘的音樂作品以及最終模型版本的 GPT-2。2020 年,研發團隊在 GPT-2 的基礎上拓展參數,發布了 GPT-3 語言模型。2021 年,發布了轉換器語言模型 DALL·E,從文本描述生成圖像。2022 年,OpenAI 在 GPT-3.5 的基礎上推出了 ChatGPT,強化了人工智能的語言對話能力,引起社會廣泛關注。

▲OpenAI 產品

OpenAI 當前盈利主要通過付費 API 接口,并嘗試拓展盈利模式。目前,OpenAI 提供 GPT-3、Codex 以及 DALL·E 的 API 數據接口,分別執行用戶自然語言任務、自然語言轉換為代碼的任務以及創建和編輯圖像的任務。API 接口根據類型不同以流量收費,比如圖像模型以分辨率分類按張數收費,語言模型則以基于的子模型型號按字符數收費。OpenAI API 盈利情況較好,據路透社數據,OpenAI 2022 年收入數千萬美元,公司預計 2023 與 2024 年收入分別為 2 億美元和 10 億美元。同時,OpenAI 正嘗試拓展自身盈利模式,2023 年 1 月試點推出訂閱制 ChatGPT Plus,收取每月 20 美元的會員費以得到各類優先服務。

▲OpenAI API 價格

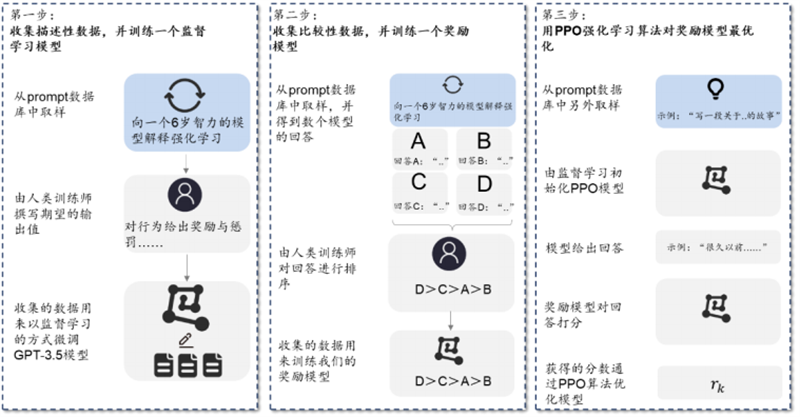

ChatGPT 使用來自人類反饋的強化學習 (RLHF) 來訓練該模型。首先使用監督微調訓練了一個初始模型:人類 AI 訓練員提供對話,他們在對話中扮演雙方——用戶和 AI 助手。其次,ChatGPT 讓標記者可以訪問模型編寫的建議,以幫助他們撰寫回復。最后,ChatGPT 將這個新的對話數據集與原有數據集混合,將其轉換為對話格式。具體來看,主要包括三個步驟:

1)第一階段:訓練監督策略模型。在 ChatGPT 模型的訓練過程中,需要標記者的參與監督過程。首先,ChatGPT 會從問題數據集中隨機抽取若干問題并向模型解釋強化學習機制,其次標記者通過給予特定獎勵或懲罰引導 AI 行為,最后通過監督學習將這一條數據用于微調 GPT3.5 模型。

2)第二階段:訓練獎勵模型。這一階段的主要目標,在于借助標記者的人工標注,訓練出合意的獎勵模型,為監督策略建立評價標準。訓練獎勵模型的過程同樣可以分為三步:1、抽樣出一個問題及其對應的幾個模型輸出結果;2、標記員將這幾個結果按質量排序;3、將排序后的這套數據結果用于訓練獎勵模型。

3)第三階段:采用近端策略優化進行強化學習。近端策略優化(Proximal Policy Optimization)是一種強化學習算法,核心思路在于將 Policy Gradient 中 On-policy 的訓練過程轉化為Off-policy,即將在線學習轉化為離線學習。具體來說,也就是先通過監督學習策略生成 PPO模型,經過獎勵機制反饋最優結果后,再將結果用于優化和迭代原有的 PPO 模型參數。往復多次第二階段和第三階段,從而得到參數質量越來越高的 ChatGPT 模型。

▲ChatGPT 模型原理

從 ChatGPT 的訓練原理中,我們不難發現,這一訓練過程存在幾個特點:

1)采用的是單一大模型。在 GPT 模型興起之前,大多數 AI 模型主要是針對特定應用場景需求進行訓練的小模型,存在通用性差、訓練數據少、適應范圍小的弊端。而我們看到,ChatGPT 雖然在過程中使用了獎勵模型等輔助手段,但最終用于實現自然語言理解和生成式功能的主模型只有一個,但卻在語義理解、推理、協作等方面表現出了更強能力。因此,ChatGPT 的成功,驗證了參數增長、訓練數據量增大,對 AI 模型的重要意義。

2)采用的是小樣本學習方法。在小樣本學習(Few-shot Learning)方法下,AI 預訓練模型在不必使用大量標記的訓練數據,就可以建立起比較通用的泛化能力。簡單來說,小樣本學習即是在給定有限信息和較少訓練數據的情況下,嘗試對總體規律進行理解和預測,這一過程類似于“學習如何去學習”。對于小樣本學習在 ChatGPT 中的應用,我們認為,這一方法解決了大模型數據標注工作量巨大的問題,是模型得以迅速迭代的基礎。

3)采用人類反饋微調監督學習。ChatGPT 是從 GPT3.5(即 InstructGPT)改進而來的版本,相比于前代,ChatGPT 主要變化在于采用了人類反饋機制,對監督學習過程進行微調。本質上來說,無論是大模型還是小樣本學習,解決的目標都是提升訓練的效率,但真正令ChatGPT 實現結果準確、合理的關鍵技術,還是在于加入了人類反饋。據 Long Ouyang等人 2022 年發表的《Training language models to follow instructions with humanfeedback》,InstructGPT 僅用 13 億個參數就實現了比 1750 億個參數的 GPT-3 更優的輸出解雇,顯著提升了真實性、減少了有害信息的輸出。02.三大維度拆解GPT模型特征

拆解GPT模型可以幫助理解ChatGPT之所以強大的原因。從前面的討論中,我們發現,ChatGPT 的成功離不開 AI 大模型的加持,強大的算法訓練模型,使得 ChatGPT 在迭代中獲得實現接近自然語言的表達能力。而這一切的核心,都來自一個模型:GPT 模型。因此,以 GPT 模型為核心,從三個維度出發去拆解 GPT 模型,以此進一步挖掘 ChatGPT 強大背后的原因。

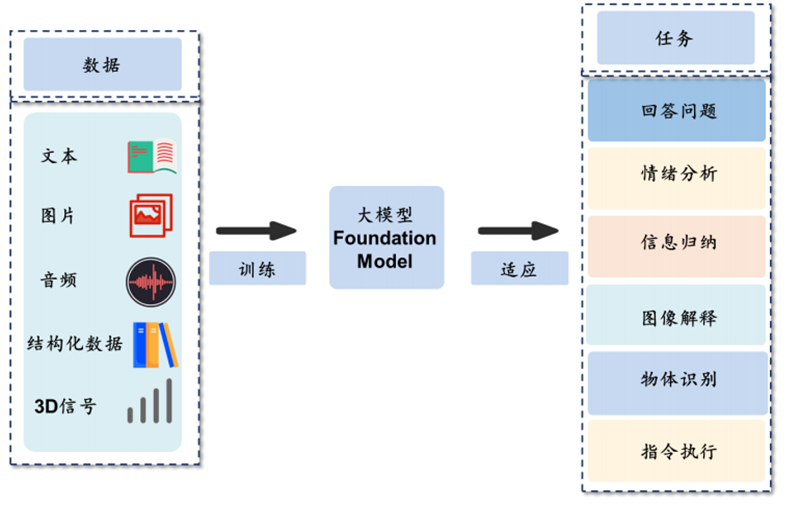

維度一:單一大模型:ChatGPT使用單一大模型,積累強大底層通用能力。對于 ChatGPT 所用到的訓練模型,從模型體量來看,屬于 AI 單一大模型的范疇。對比傳統 AI 訓練模型,單一大模型的“大”體現在:1)更多的模型參數量;2)更大的數據處理量;3)更大的訓練計算量。模型體量的增大,帶來的最直接變化,在于 AI 模型通用能力的跨越式提升。傳統的 AI 訓練方法,大多以單一知識領域的應用為目標,主要使用特定領域有標注的數據進行模型訓練,模型通用性差,如果更換使用場景,往往需要進行重新訓練。而大模型的訓練,一是能使用的數據來源更加廣泛,可用數據量更大;二是對標注要求更低,只需要對數據進行微調甚至不調就可以用于訓練;三是輸出的能力更加泛化通用,在語義理解、邏輯推理、文本表達等方面能力更出眾。

從通用到特殊,單一大模性具備豐富的垂直領域應用潛力。基于對底層能力的訓練,AI 大模型積累了對于數據背后特征和規則的理解,因此在進行垂直領域的時候,可以做到“舉一反三”。這一過程,與人類學習知識的過程類似,都是先學習如何去學習,再構建聽說讀寫能力,最后在不同學科深入探索。AI 大模型也是一樣,在完成通用能力積累之后,可以將學習能力移植到需要應用的特定領域,通過投喂垂直領域數據,可以使模型達到目標場景所需的性能。

▲單一大模性具備豐富的垂直領域應用潛力

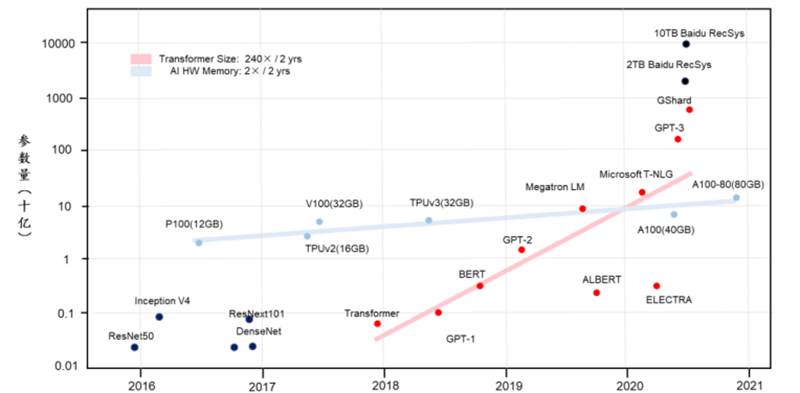

從大模型自身的發展過程來看,參數量的變化是一個非常值得關注的指標。從最早的 ResNet、Inception 等模型,到如今的 GPT,模型參數量不斷增長。2018 年前后 OpenAI 先后推出 Transformer 和GPT-1 模型,參數量來到 1 億級別。隨后谷歌提出 3 億參數的 BERT 模型,參數量再次增長。2019、2020 年,OpenAI 加速追趕,陸續迭代出 GPT-2、GPT-3 模型,參數量分別為15 億、1750 億,實現模型體量質的飛躍。另一方面,參數運算需要大規模并行計算的支持,核心難點在于內存交換效率,取決于底層 GPU 內存容量。以英特爾為例,從 2017 年 V100的 32GB 內存到 2020 年 A100 的 80GB 內存,GPU 內存容量的提升量級與模型參數相比顯然不在同一量級。而 ChatGPT 的解決方法,則是與微軟聯手,借助 Azure 強大的基礎算力設施,為 ChatGPT 提供訓練支持。

▲單一大模型的參數量快速增長

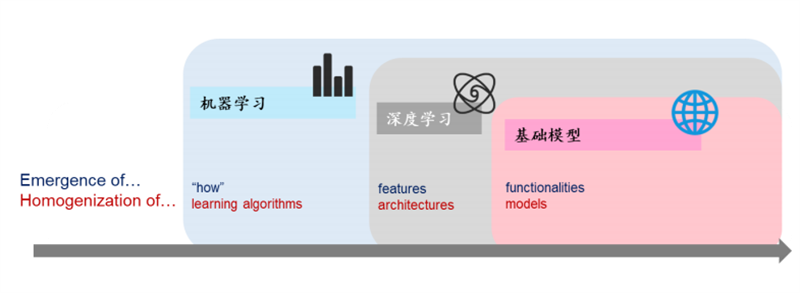

2021 年 8 月,李飛飛等學者于 arXiv 發表《On the Opportunities and Risk of Foundation Models》,將大模型統一命名為 Foundation Models,即基礎模型或基石模型。此外,論文還提出基礎模型面臨的兩大問題:1)同質化。盡管基礎模型基于標準的深度學習和遷移學習,但其規模導致了新能力的涌現,其在眾多任務中的有效性激勵了同質化的產生;2)特性涌現。盡管基礎模型即將被廣泛部署,但目前研究者對其如何工作、何時失效以及其涌現的特性衍生了何種能力尚缺乏清晰的理解。舉例來看,如機器學習的引入,使得算法從數據案例中學會了如何執行(自動推斷);深度學習的引入,涌現了用于預測的高級特征;基礎模型的引入,涌現了上下文學習等高級功能。但在這一過程中,機器學習使學習算法變得同質化(例如,邏輯回歸),深度學習使模型架構同質化(例如,卷積神經網絡架構),大模型使得下游模型同質化(例如,下游模型一定會繼承上游模型缺陷)。

從本質上來說,上下游模型同質化的問題無法被完全解決,OpenAI 選擇的方向是盡可能填補缺陷漏洞。從 GPT-3.5版本開始,OpenAI 團隊在模型中引入了監督學習過程。在監督學習模式下,人類反饋機制開始加入到模型訓練過程,從而不斷糾正模型生成結果,逐步提升輸出結果的準確性和真實性。隨著大模型朝著越來越符合人類期望的方向演進,對話邏輯和表達方式逐漸逼近人類水平,才最終達到我們今天所看到的樣子。

▲基礎模型帶來特性涌現和模型同質化

通過拆解單一大模型的原理、特征及發展歷程,我們發現單一大模型的引入,是 ChatGPT 強大語言的根本來源。展望未來,我們認為ChatGPT 或將在大模型加持下加速迭代,主要因為:1)大模型訓練效果取決于數據量,目前 ChatGPT 僅使用 2021 年之前的數據,隨著更多數據的加入,模型底層語言能力有望進一步加強;2)大模型具備能力遷移潛力,垂直領域應用或將加速 ChatGPT 進化;3)OpenAI 背靠微軟,大算力資源為模型演進提供保障;4)隨著軟件用戶規模持續擴張,用戶自身的反饋又會帶來類似監督學習的效果,或將帶動 ChatGPT 加速迭代。基于此,看好 AI 大模型及 ChatGPT 未來應用前景,商業化落地或將加快。

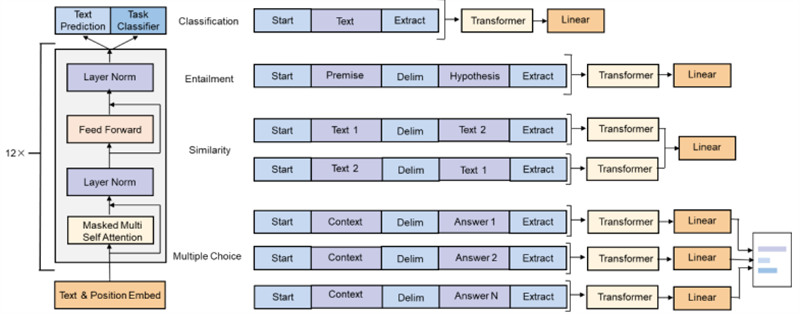

維度二:預訓練語言模型。拆解模型來看,主要關注預訓練語言模型和Transformer特征抽取器。前面討論了ChatGPT 背后所使用的 AI 大模型及其迭代過程,但如果我們將拆解動作繼續深入,在更細顆粒度的視角下,其實可以將訓練模型做進一步的拆解。實際上,GPT(General Pre-Training)即通用預訓練語言模型,簡單來說就是一種利用 Transformer 作為特征抽取器,基于語言模型進行預訓練的模型。因此,接下來我們從模型的兩個關鍵特征出發,分別從預訓練語言模型和 Transformer 特征抽取器的角度來分析 GPT 模型的迭代過程。

預訓練語言模型無需人工標簽,為NLP研究帶來質變。預訓練屬于遷移學習的范疇,其思想是在利用標注數據之前,先利用無標注的數據,即純文本數據訓練模型,從而使模型能夠學到一些潛在的跟標注無關的知識,最終在具體的任務上,預訓練模型就可以利用大量的無標注數據知識,標志著自然語言處理模型進入了大規模復制階段。從實現原理上來看,預訓練語言模型是通過計算某個詞句 w 的出現概率,即 p(W),在給定詞句的情況下,可以自行計算出后一個詞或句出現的概率。因此,GPT 的訓練可以在無人工標簽的基礎上進行,通過連續不斷地預測、迭代參數、再預測,模型最終實現語言能力的學習。

在大多數基于統計方法和神經網絡的自然語言處理模型中都需要大量已標注的數據集來滿足模型訓練,但并非所有的訓練任務都能獲取足夠的標注信息。同時,隨著模型復雜度和參數數量的增加,大多數數據集的大小難以支持訓練。而預訓練模型能先通過利用無標注的數據訓練模型,解決傳統模型無法解決的實際問題。而且由于預訓練語言模型可以利用現實世界中大量的純文本數據訓練,擴大了其訓練范圍和規模,擁有發掘大模型(Foundation Models)的潛力。

第一代預訓練模型是靜態詞向量模型,經訓練給每一個詞賦予靜態詞向量,讓相似的詞聚集在一起,實現了符號空間到向量空間的映射,經典結構有 Continuous Bag-of-Words(CBOW)和 Skip-Gram(SG)等。而由于第一代模型的詞向量靜態性,使其不能結合上下文,進而有無法分辯同義詞等缺陷。最新的第二代預訓練模型,包括 BERT、GPT 等則在此基礎上允許靜態詞向量與上下文交互,這種動態詞向量優化了同義詞問題。目前,第二代預訓練模型的標準范式是“預訓練+微調”:首先在大量的文本上訓練出一個預訓練語言模型,再根據實際情況對得到的預訓練語言模型進行微調,加強了模型對下游應用場景的契合度。

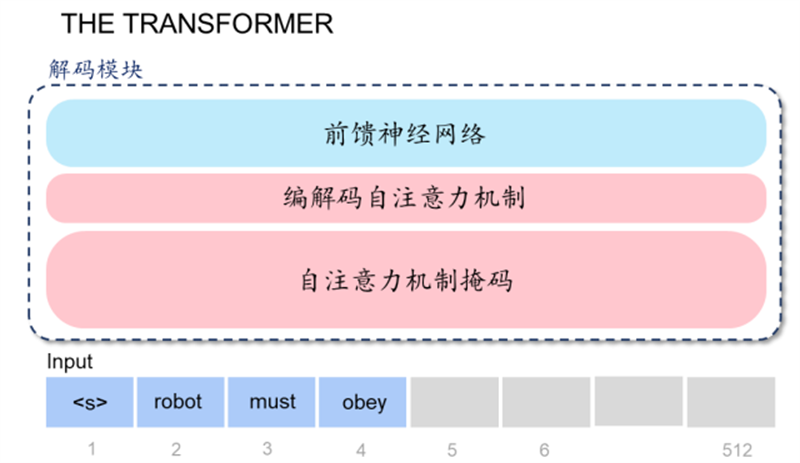

維度三:Transformer特征抽取器。Transformer是大模型高效運行的根基。前面我們從單一大模型出發,對預訓練語言模型進行了 。但如果我們繼續深入,會發現語言模型仍然不是 GPT 模型的最底層,語言模型之下還需要有具體的調度架構和運算邏輯,來實現最終的計算。我們認為,Transformer特征抽取器在 GPT 模型中,就承擔了這樣的一個角色,直接決定了 AI 大模型能否實現高效率的運算和學習。

Transformer 模型最早由谷歌在 2017 年提出,屬于深度學習模型架構的一種,特點是在學習中引入了注意力機制。對比循環神經網絡(RNN)來看,Transformer 與 RNN 均對輸入數據,如自然語言等,進行順序處理,并主要應用于翻譯和文本摘要等工作。但 Transformer 與 RNN 不同的是,Transformer 中的注意機制可以為輸入序列中的任何字符提供上下文,因此可以一次處理所有輸入,而不是一次只處理一個詞。因此,與 RNN 相比,Transformer 可以實現更大規模的并行計算,大大減少了模型訓練時間,使得大規模 AI 模型得以被應用。

▲Transformer 解碼模塊拆解

在 GPT 模型中,解碼模塊相當于基本架構單元,通過彼此堆疊的方式,拼湊成最終我們看到的 GPT 模型底層架構。這里有兩個值得關注的要點:1)解碼模塊的數量決定了模型的規模,GPT-1 一般有 12 個模塊,GPT-2有 48 個,GPT-3 則有 96 個模塊;2)針對模塊輸出的結果還需要進行 Finetune(對模型進行調優)。

▲解碼模塊堆疊形成 GPT 模型完整架構

03.生成式AI應用于創造性工作

AI 可分為生成式 AI 和分析型 AI,其中分析型 AI(Analytical AI),主要在給定數據的情況下,通過分析找出規律和關系,并在此基礎上生成報告或給出建議。比如通過追蹤客戶行為以刻畫用戶畫像,并基于此進行個性化推薦,實現精準營銷;通過收集城市中傳感器的大量數據并分析,預測天氣及環境污染情況,從而幫助相關部門進行政策制定。不同于分析型 AI 局限于分析已有內容,生成式 AI(Generative AI)可以通過學習已有數據和信息生成多種形式的新的內容,在創造性工作的領域進行應用,目前生成式 AI 的應用主要包括生成文本、圖像、對話、音視頻、代碼、3D 等。

▲生成型 AI 應用領域

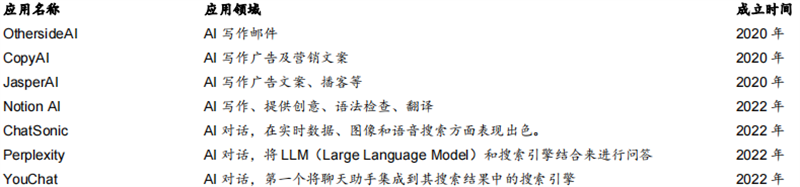

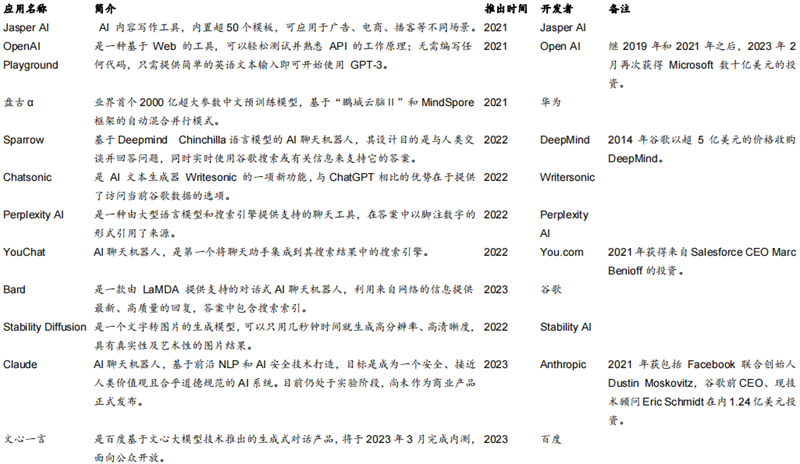

ChatGPT 通過學習大量語料并通過生成模型生成文本回答,其基礎 GPT-3 是一個大型語言模型。該模型通過對大量語料的預訓練,學習了語言的語法、語義、語用等特征,并通過對語言的生成任務進行微調,以適應各種應用場景。目前,除了 ChatGPT 外,有大量 AIGC 應用產品基于 GPT-3 模型。

▲基于 GPT-3 的 AI 產品

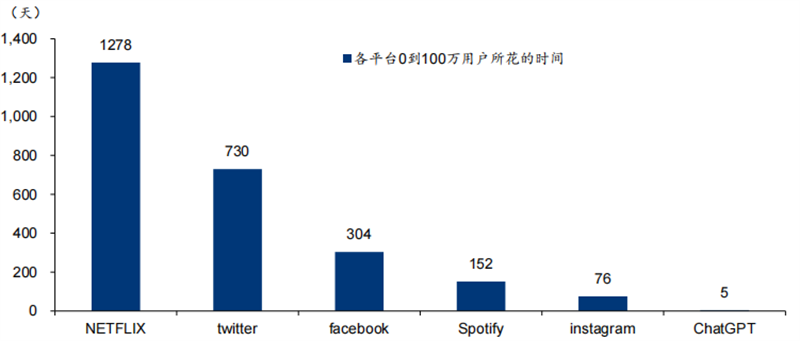

據各公司官網,ChatGPT 從 0 到 100 萬用戶數僅花費 5 天,速度遠超其他平臺。從活躍用戶角度,據Similarweb,2023 年 1 月期間,ChatGPT 平均每天約有 1300 萬獨立訪客,超出 22 年 12月一倍。用戶數量的快速擴大反映了 ChatGPT 具備較強的商業化潛力。

▲ChatGPT 從 0 到 100 萬用戶速度遠超其他平臺

AIGC(AI Generated Content)指由人工智能生成的內容,包括文本、圖像、音頻、3D 等多種類型,具有高效及自動化生產的特點。近年來谷歌、亞馬遜、百度等國內外巨頭持續布局 AIGC。2014 年,谷歌以超 5 億美元的價格收購人工智能公司 DeepMind;2023 年 3 月,谷歌宣布向人工智能初創公司 Anthropic 投資約 3 億美元,建立新的合作伙伴關系;2022 年 11 月,亞馬遜宣布與 AI 制圖平臺 Stability AI 合作,成為其首選云合作伙伴,同時為其提供亞馬遜 Tradium 芯片;2021 年 4 月,華為諾亞方舟實驗室聯合多部門推出首個 2000 億參數中文預訓練模型盤古α;2023 年 2 月,百度官宣類 ChatGPT 大模型新項目文心一言(英文名 ERNIE Bot)。

▲AIGC 領域產品

微軟發布基于 OpenAI 模型的全新搜索引擎 Bing 和 Edge 瀏覽器。在 FY23Q2 電話會議上,微軟表示將增加對 ChatGPT 的支持,使得客戶能夠很快在自己的應用程序上調用它。隨后,公司宣布擴大與 OpenAI 的合作伙伴關系,將向 OpenAI 進行一項為期多年、價值數十億美元的投資,以加速其在人工智能領域的技術突破。2 月 7 日,公司召開發布會推出基于新的 OpenAI 模型搜索引擎 Bing 和 Edge 瀏覽器,將搜索、瀏覽器、聊天功能結合起來,用戶既可以選擇傳統搜索結果與聊天對話框并排顯示,也可以選擇直接與聊天機器人進行對話。在新版的 Bing 之下,用戶搜索直接給出答案,而非網頁鏈接,結果相關性更強、更加智能化。目前新版 Bing 已經開放有限預覽,預計在未來幾周推出移動版本。

谷歌、百度積極跟進,商業應用有望加速。1 月 27 日,美國數字媒體公司 BuzzFeed 率先宣布計劃使用 OpenAI 提供的技術來協助創作個性化內容。谷歌方面,近期向 OpenAI競爭對手之一的 Anthropic 投資約 3 億美元,獲得該公司 10%股份,Anthropic 將用投資從谷歌的云計算部門購買大量計算資源;2 月 6 日,谷歌透露計劃推出一款聊天機器人 Bard 以應對 ChatGPT,該服務將開放給受信任的測試人員,并在未來的幾周向更廣泛的公眾開放服務。百度方面,2 月 7 日宣布將推出類 ChatGPT 項目文心一言(英文名為ERNIE Bot),預計將在 3 月份完成內測,面向公眾開放。隨著微軟將 ChatGPT 整合至自身產品中,谷歌、百度等 AI 領軍企業也宣布推出聊天機器人,未來有望將聊天機器人整合至搜索引擎甚至辦公軟件等業務當中,商業化應用有望加速落地。

審核編輯 :李倩

-

人工智能

+關注

關注

1791文章

47269瀏覽量

238439 -

OpenAI

+關注

關注

9文章

1087瀏覽量

6504 -

ChatGPT

+關注

關注

29文章

1560瀏覽量

7641

原文標題:三大維度拆解ChatGPT!讓巨頭們興奮的技術真相

文章出處:【微信號:CADCAM_beijing,微信公眾號:智能制造IMS】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

三大維度拆解ChatGPT!讓巨頭們興奮的技術真相

三大維度拆解ChatGPT!讓巨頭們興奮的技術真相

評論