以ChatGPT、GPT-4、文心一言為代表的AIGC大模型,集文本撰寫、代碼開發(fā)、詩詞創(chuàng)作等功能于一體,展現(xiàn)出了超強的內(nèi)容生產(chǎn)能力,帶給人們極大震撼。

AIGC,AI-Generated Content(人工智能生產(chǎn)內(nèi)容) 作為一個通信老司機,除了AIGC大模型本身之外,小棗君更加關(guān)注的,是模型背后的通信技術(shù)。到底是一張怎樣的強大網(wǎng)絡(luò),在支持著AIGC的運轉(zhuǎn)?此外,AI浪潮的全面來襲,將對傳統(tǒng)網(wǎng)絡(luò)帶來怎樣的變革?

█AIGC,到底需要多大的算力?

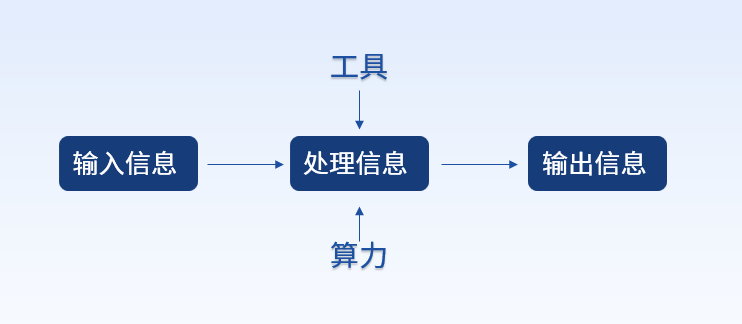

眾所周知,數(shù)據(jù)、算法和算力,是人工智能發(fā)展的三大基本要素。  ?

?

前面提到的幾個AIGC大模型,之所以那么厲害,不僅是因為它們背后有海量的數(shù)據(jù)投喂,也因為算法在不斷進化升級。更重要的是,人類的算力規(guī)模,已經(jīng)發(fā)展到了一定程度。強大的算力基礎(chǔ)設(shè)施,完全能夠支撐AIGC的計算需求。 AIGC發(fā)展到現(xiàn)在,訓(xùn)練模型參數(shù)從千億級飆升到了萬億級。為了完成這么大規(guī)模的訓(xùn)練,底層支撐的GPU數(shù)量,也達到了萬卡級別規(guī)模。

以ChatGPT為例,他們使用了微軟的超算基礎(chǔ)設(shè)施進行訓(xùn)練,據(jù)說動用了10000塊V100 GPU,組成了一個高帶寬集群。一次訓(xùn)練,需要消耗算力約3640 PF-days(即每秒1千萬億次計算,運行3640天)。

一塊V100的FP32算力,是0.014 PFLOPS(算力單位,等于每秒1千萬億次的浮點運算)。一萬塊V100,那就是140 PFLOPS。

也就是說,如果GPU的利用率是100%,那么,完成一次訓(xùn)練,就要3640÷140=26(天)。

GPU的利用率是不可能達到100%,如果按33%算(OpenAI提供的假設(shè)利用率),那就是26再翻三倍,等于78天。 可以看出,GPU的算力、GPU的利用率,對大模型的訓(xùn)練有很大影響。

那么問題來了,影響GPU利用率的最大因素,是什么呢? 答案是:網(wǎng)絡(luò)。

一萬甚至幾萬塊的GPU,作為計算集群,與存儲集群進行數(shù)據(jù)交互,需要極大的帶寬。此外,GPU集群進行訓(xùn)練計算時,都不是獨立的,而是混合并行。GPU之間,有大量的數(shù)據(jù)交換,也需要極大的帶寬。

如果網(wǎng)絡(luò)不給力,數(shù)據(jù)傳輸慢,GPU就要等待數(shù)據(jù),導(dǎo)致利用率下降。利用率下降,訓(xùn)練時間就會增加,成本也會增加,用戶體驗會變差。

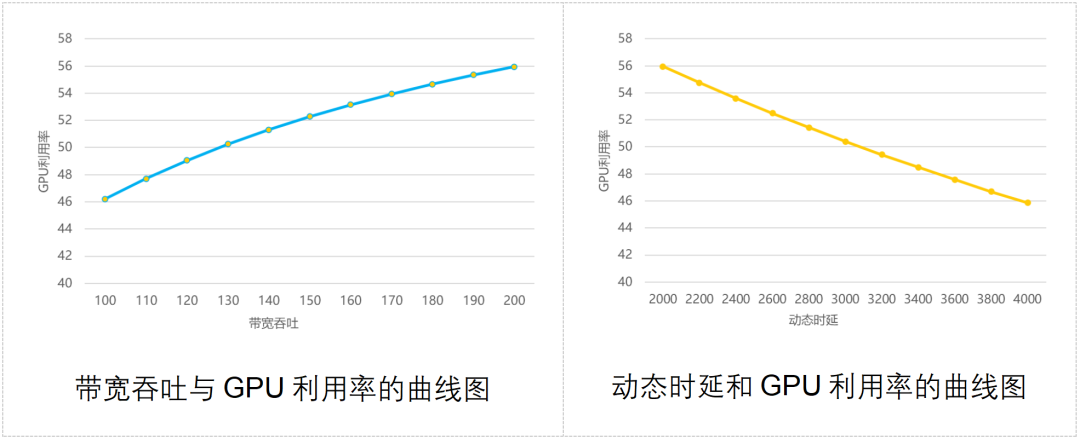

業(yè)界曾經(jīng)做過一個模型,計算出網(wǎng)絡(luò)帶寬吞吐能力、通信時延與GPU利用率之間的關(guān)系,如下圖所示:  ?

?

大家可以看到,網(wǎng)絡(luò)吞吐能力越強,GPU利用率越高;通信動態(tài)時延越大,GPU利用率越低。

一句話,沒有好網(wǎng)絡(luò),別玩大模型。

█怎樣的網(wǎng)絡(luò),才能支撐AIGC的運行?

為了應(yīng)對AI集群計算對網(wǎng)絡(luò)的調(diào)整,業(yè)界也是想了不少辦法的。 傳統(tǒng)的應(yīng)對策略,主要是三種:Infiniband、RDMA、框式交換機。我們分別來簡單了解一下。

Infiniband組網(wǎng)

Infiniband(直譯為“無限帶寬”技術(shù),縮寫為IB)組網(wǎng),搞數(shù)據(jù)通信的童鞋應(yīng)該不會陌生。

這是目前組建高性能網(wǎng)絡(luò)的最佳途徑,帶寬極高,可以實現(xiàn)無擁塞和低時延。ChatGPT、GPT-4所使用的,據(jù)說就是Infiniband組網(wǎng)。

如果說Infiniband組網(wǎng)有什么缺點的話,那就是一個字——貴。相比傳統(tǒng)以太網(wǎng)的組網(wǎng),Infiniband組網(wǎng)的成本會貴好幾倍。這項技術(shù)比較封閉,業(yè)內(nèi)目前成熟的供應(yīng)商只有1家,用戶沒什么選擇權(quán)。

RDMA網(wǎng)絡(luò)

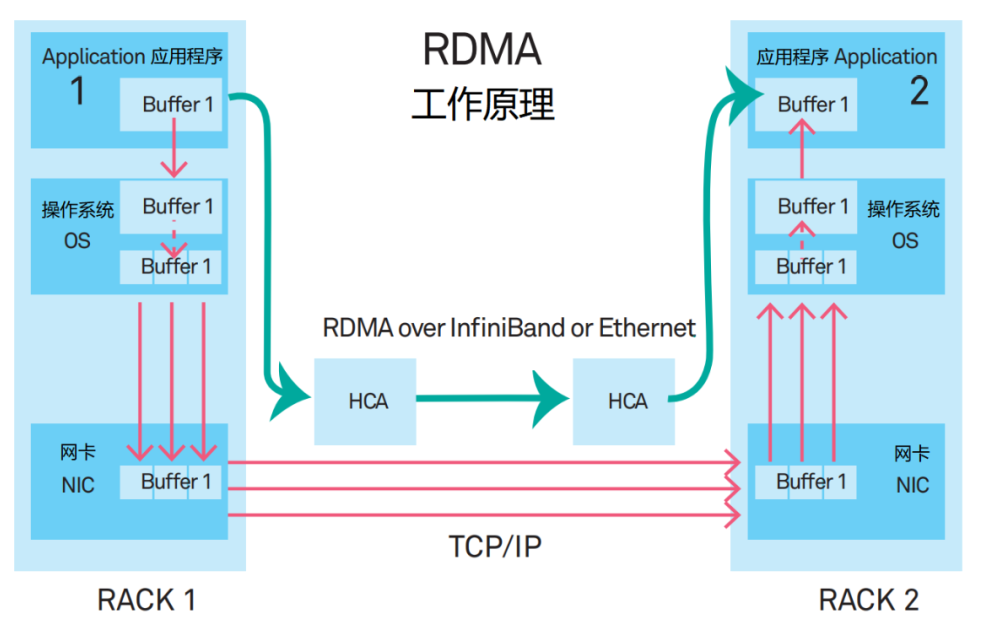

RDMA的全稱是Remote Direct Memory Access(遠程直接數(shù)據(jù)存取)。它是一種新型的通信機制。在RDMA方案里,應(yīng)用程序的數(shù)據(jù),不再經(jīng)過CPU和復(fù)雜的操作系統(tǒng),而是直接和網(wǎng)卡通信,不僅大幅提升了吞吐能力,也降低了時延。

?

?

RDMA最早提出時,是承載在InfiniBand網(wǎng)絡(luò)中的。現(xiàn)在,RDMA逐漸移植到了以太網(wǎng)上。

目前,高性能網(wǎng)絡(luò)的主流組網(wǎng)方案,是基于RoCE v2(RDMA over Converged Ethernet,基于融合以太網(wǎng)的RDMA)協(xié)議來組建支持RDMA的網(wǎng)絡(luò)。

這種方案有兩個重要的搭配技術(shù),分別是PFC(Priority Flow Control,基于優(yōu)先級的流量控制)和ECN(Explicit Congestion Notification,顯式擁塞通知)。它們是為了避免鏈路中的擁塞而產(chǎn)生的技術(shù),但是,頻繁被觸發(fā),反而會導(dǎo)致發(fā)送端暫停發(fā)送,或降速發(fā)送,進而拉低通信帶寬。(下文還會提到它們)

框式交換機

國外有部分互聯(lián)網(wǎng)公司,寄希望于利用采用框式交換機(DNX芯片+VOQ技術(shù)),來滿足構(gòu)建高性能網(wǎng)絡(luò)的需求。

DNX:broadcom(博通)的一個芯片系列 VOQ:Virtual Output Queue,虛擬輸出隊列 這種方案看似可行,但也面臨以下幾個挑戰(zhàn)。

首先,框式交換機的擴展能力一般。機框大小限制了最大端口數(shù),如想做更大規(guī)模的集群,需要橫向擴展多個機框。

其次,框式交換機的設(shè)備功耗大。機框內(nèi)線卡芯片、Fabric芯片、風(fēng)扇等數(shù)量眾多,單設(shè)備的功耗超過2萬瓦,有的甚至3萬多瓦,對機柜供電能力要求太高。

第三,框式交換機的單設(shè)備端口數(shù)量多,故障域大。 基于以上原因,框式交換機設(shè)備只適合小規(guī)模部署AI計算集群。

█到底什么是DDC

前面說的都是傳統(tǒng)方案。既然這些傳統(tǒng)方案不行,那當(dāng)然就要想新辦法。

于是,一種名叫DDC的全新解決方案,閃亮登場了。

DDC,全名叫做Distributed Disaggregated Chassis(分布式分散式機箱)。

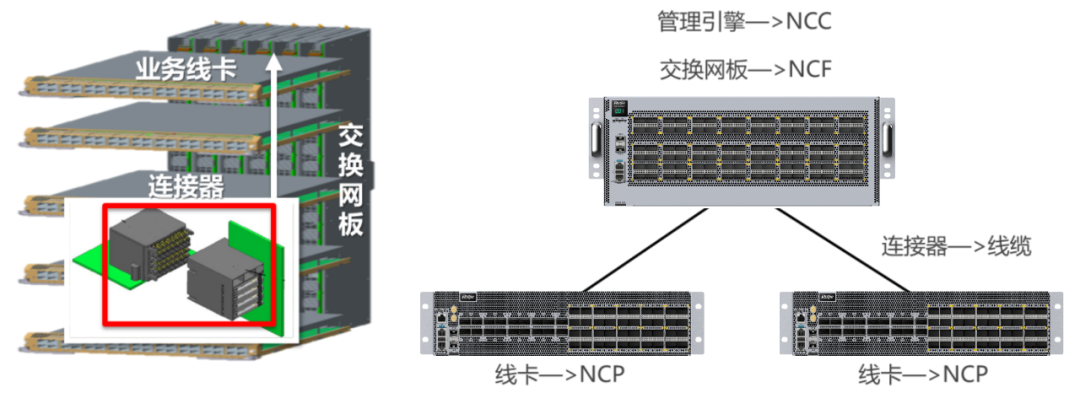

它是前面框式交換機的“分拆版”。框式交換機的擴展能力不足,那么,我們干脆把它給拆開,將一個設(shè)備變成多個設(shè)備,不就OK了?  ?

?

框式設(shè)備,一般分為交換網(wǎng)板(背板)和業(yè)務(wù)線卡(板卡)兩部分,相互之間用連接器連接。

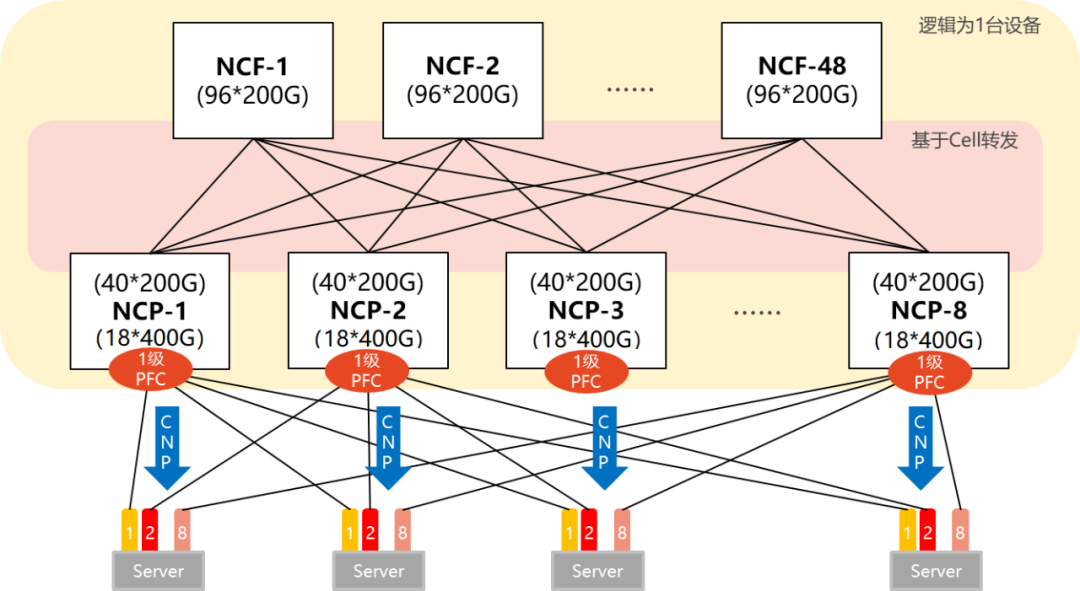

DDC方案,將交換網(wǎng)板變成了NCF設(shè)備,將業(yè)務(wù)線卡變成了NCP設(shè)備。連接器,則變成了光纖。框式設(shè)備的管理功能,在DDC架構(gòu)中,也變成了NCC。

NCF:Network Cloud Fabric(網(wǎng)絡(luò)云管理控制平面)

NCP:Network Cloud Packet Processing(網(wǎng)絡(luò)云數(shù)據(jù)包處理)

NCC:Network Cloud Controller(網(wǎng)絡(luò)云控制器)

DDC從集中式變成分布式之后,擴展能力大大增強了。它可以根據(jù)AI集群的大小,靈活設(shè)計組網(wǎng)規(guī)模。

我們來舉兩個例子(單POD組網(wǎng)和多POD組網(wǎng))。

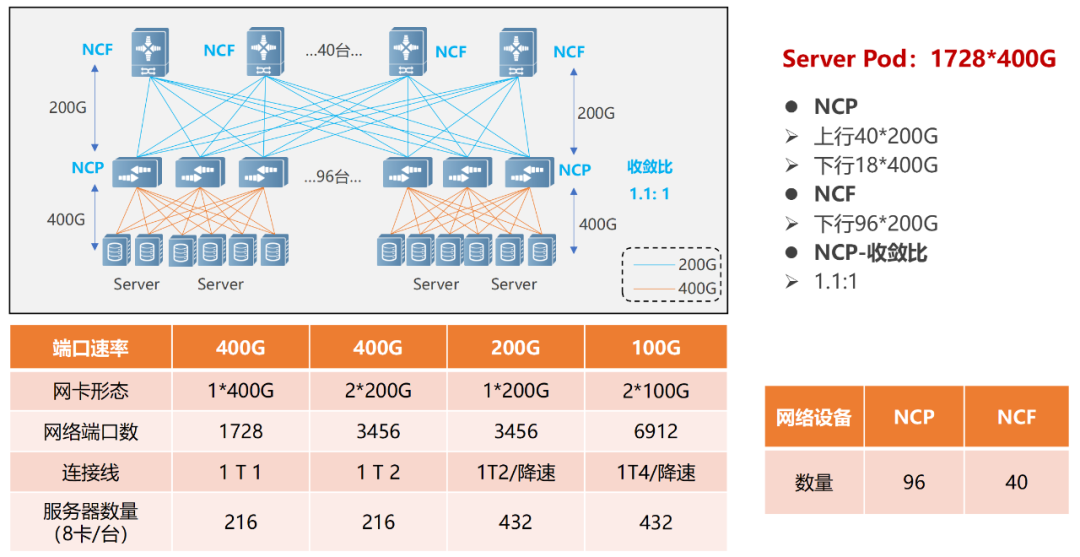

單POD組網(wǎng)中,采用96臺NCP作為接入,其中NCP下行共18個400G接口,負責(zé)連接AI計算集群的網(wǎng)卡。上行共40個200G接口,最大可以連接40臺NCF,NCF提供96個200G接口,該規(guī)模上下行帶寬為超速比1.1:1。整個POD可支撐1728個400G網(wǎng)絡(luò)接口,按照一臺服務(wù)器配8塊GPU來計算,可支撐216臺AI計算服務(wù)器。

單POD組網(wǎng)

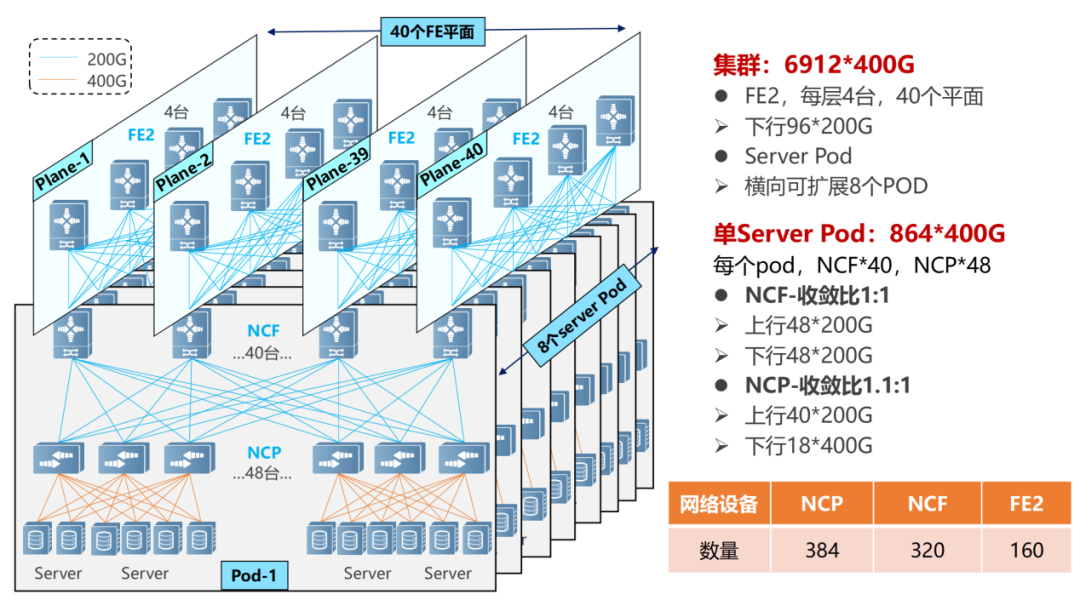

多級POD組網(wǎng),規(guī)模可以變得更大。

在多級POD組網(wǎng)中,NCF設(shè)備要犧牲一半的SerDes,用于連接第二級的NCF。所以,此時單POD采用48臺NCP作為接入,下行共18個400G接口。

多POD組網(wǎng)

單個POD內(nèi),可以支撐864個400G接口(48×18)。通過橫向增加POD(8個),實現(xiàn)規(guī)模擴容,整體最大可支撐6912個400G網(wǎng)絡(luò)端口(864×8)。

NCP上行40個200G,接POD內(nèi)40臺NCF。POD內(nèi)NCF采用48個200G接口,48個200G接口分為12個一組上行到第二級的NCF。第二級NCF采用40個平面(Plane),每個平面4臺NCF-P,分別對應(yīng)在POD內(nèi)的40臺NCF。

整個網(wǎng)絡(luò)的POD內(nèi)實現(xiàn)了1.1:1的超速比(北向帶寬大于南向帶寬),而在POD和二級NCF之間實現(xiàn)了1:1的收斂比(南向帶寬/北向帶寬)。

? ?

? ?

█DDC的技術(shù)特點

站在規(guī)模和帶寬吞吐的角度,DDC已經(jīng)可以滿足AI大模型訓(xùn)練對于網(wǎng)絡(luò)的需求。

然而,網(wǎng)絡(luò)的運作過程是復(fù)雜的,DDC還需要在時延對抗、負載均衡性、管理效率等方面有所提升。

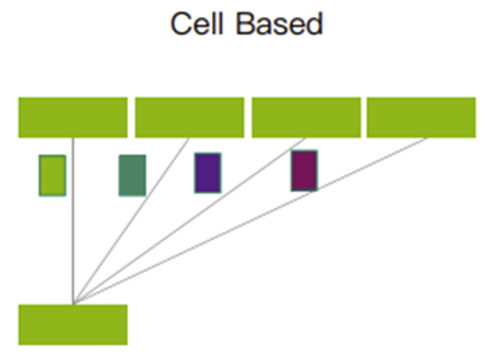

基于VOQ+Cell的轉(zhuǎn)發(fā)機制,對抗丟包

網(wǎng)絡(luò)在工作的過程中,可能會出現(xiàn)突發(fā)流量,造成接收端來不及處理,引起擁塞和丟包。

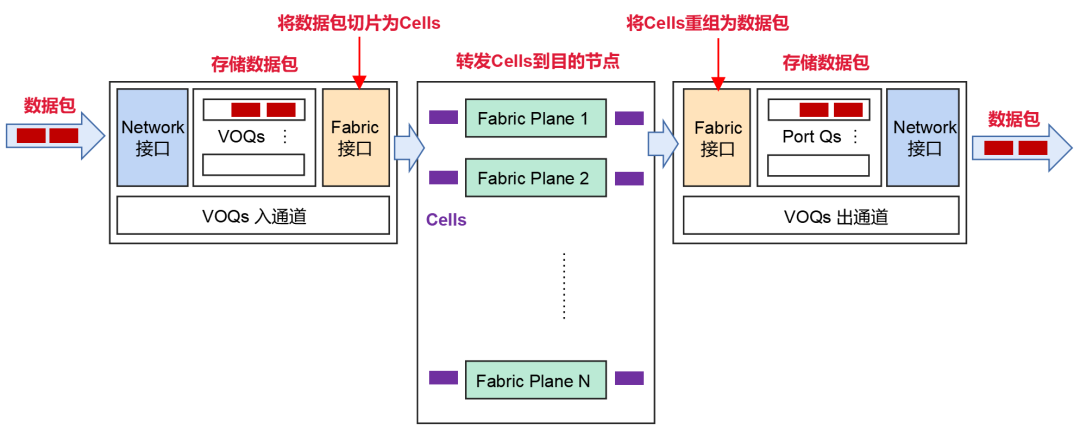

為了應(yīng)對這種情況,DDC采取了基于VOQ+Cell的轉(zhuǎn)發(fā)機制。

?

?

發(fā)送端從網(wǎng)絡(luò)接收到數(shù)據(jù)包之后,會分類到VOQ(虛擬輸出隊列)中存儲。

在發(fā)送數(shù)據(jù)包前,NCP會先發(fā)送Credit報文,確定接收端是否有足夠的緩存空間處理這些報文。

如果接收端OK,則將數(shù)據(jù)包分片成Cells(數(shù)據(jù)包的小切片),并且動態(tài)負載均衡到中間的Fabric節(jié)點(NCF)。

如果接收端暫時沒能力處理報文,報文會在發(fā)送端的VOQ中暫存,并不會直接轉(zhuǎn)發(fā)到接收端。

在接收端,這些Cells會進行重組和存儲,進而轉(zhuǎn)發(fā)到網(wǎng)絡(luò)中。

切片后的Cells,將采用輪詢的機制發(fā)送。它能夠充分利用到每一條上行鏈路,確保所有上行鏈路的傳輸數(shù)據(jù)量近似相等。

輪詢機制

這樣的機制,充分利用了緩存,可以大幅度減少丟包,甚至不會產(chǎn)生丟包情況。數(shù)據(jù)重傳減少了,整體通信時延更穩(wěn)定更低,從而可以提高帶寬利用率,進而提升業(yè)務(wù)吞吐效率。

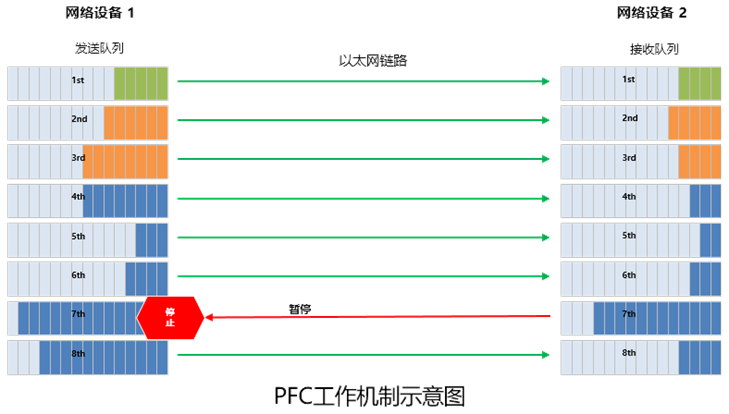

PFC單跳部署,避免死鎖

前面我們提到,RDMA無損網(wǎng)絡(luò)中引入了PFC(基于優(yōu)先級的流量控制)技術(shù),進行流量控制。

簡單來說,PFC就是在一條以太網(wǎng)鏈路上創(chuàng)建 8 個虛擬通道,并為每條虛擬通道指定相應(yīng)優(yōu)先級,允許單獨暫停和重啟其中任意一條虛擬通道,同時允許其它虛擬通道的流量無中斷通過。 ?

?

PFC可以實現(xiàn)基于隊列的流量控制,但是,它也存在一個問題,那就是死鎖。

所謂死鎖,就是多個交換機之間,因為環(huán)路等原因,同時出現(xiàn)了擁塞(各自端口緩存消耗超過了閾值),又都在等待對方釋放資源,從而導(dǎo)致的“僵持狀態(tài)”(所有交換機的數(shù)據(jù)流永久堵塞)。

DDC的組網(wǎng)下,就不存在PFC的死鎖問題。因為,站在整個網(wǎng)絡(luò)的角度,所有NCP和NCF可以看成一臺設(shè)備。對于AI服務(wù)器來說,整個DDC,就是一個交換機,不存在多級交換機。所以,就不存在死鎖。

另外,根據(jù)DDC的數(shù)據(jù)轉(zhuǎn)發(fā)機制,可在接口處部署ECN(顯式擁塞通知)。

ECN機制下,網(wǎng)絡(luò)設(shè)備一旦檢測到RoCE v2流量出現(xiàn)了擁塞(內(nèi)部的Credit和緩存機制無法支撐突發(fā)流量),就會向服務(wù)器端發(fā)送CNP(Congestion Notification Packets,擁塞通知報文),要求降速。

分布式OS,提升可靠性

最后再看看管理控制平面。

前面我們提到,在DDC架構(gòu)中,框式設(shè)備的管理功能變成了NCC(網(wǎng)絡(luò)云控制器)。NCC非常重要,如果采用單點式的方式,萬一出現(xiàn)問題,就會導(dǎo)致整網(wǎng)故障。

為了避免出現(xiàn)這樣的問題,DDC可以取消NCC的集中控制面,構(gòu)建分布式OS(操作系統(tǒng))。

基于分布式OS,可以基于SDN運維控制器,通過標準接口(Netconf、GRPC等)配置管理設(shè)備。這樣的話,每臺NCP和NCF獨立管理,有獨立的控制面和管理面,大大提升了系統(tǒng)的可靠性,也更加便于部署。

█DDC的商用進展

綜上所述,相對傳統(tǒng)組網(wǎng),DDC在組網(wǎng)規(guī)模、擴展能力、可靠性、成本、部署速度方面,擁有顯著優(yōu)勢。它是網(wǎng)絡(luò)技術(shù)升級的產(chǎn)物,提供了一種顛覆原有網(wǎng)絡(luò)架構(gòu)的思路,可以實現(xiàn)網(wǎng)絡(luò)硬件的解耦、網(wǎng)絡(luò)架構(gòu)的統(tǒng)一、轉(zhuǎn)發(fā)容量的擴展。

業(yè)界曾經(jīng)使用OpenMPI測試套件進行過框式設(shè)備和傳統(tǒng)組網(wǎng)設(shè)備的對比模擬測試。測試結(jié)論是:在All-to-All場景下,相較于傳統(tǒng)組網(wǎng),框式設(shè)備的帶寬利用率提升了約20%(對應(yīng)GPU利用率提升8%左右)。

正是因為DDC的顯著能力優(yōu)勢,現(xiàn)在這項技術(shù)已經(jīng)成為行業(yè)的重點發(fā)展方向。例如銳捷網(wǎng)絡(luò),他們就率先推出了兩款可交付的DDC產(chǎn)品,分別是400G NCP交換機——RG-S6930-18QC40F1,以及200G NCF交換機——RG-X56-96F1。

RG-S6930-18QC40F1交換機的高度為2U,提供18個400G的面板口,40個200G的Fabric內(nèi)聯(lián)口,4個風(fēng)扇和2個電源。

RG-X56-96F1交換機的高度為4U,提供96個200G的Fabric內(nèi)聯(lián)口,8個風(fēng)扇和4個電源。

據(jù)悉,銳捷網(wǎng)絡(luò)會繼續(xù)研發(fā),持續(xù)推出更多適合智算中心網(wǎng)絡(luò)場景的產(chǎn)品。

█最后的話

AIGC的崛起,已經(jīng)掀起了互聯(lián)網(wǎng)行業(yè)的新一輪技術(shù)革命。

我們可以看到,越來越多的企業(yè),正在加入這個賽道,參與角逐。這意味著,網(wǎng)絡(luò)基礎(chǔ)設(shè)施的升級,迫在眉睫。

DDC的出現(xiàn),將大幅提升網(wǎng)絡(luò)基礎(chǔ)設(shè)施的能力,不僅可以有效應(yīng)對AI革命對網(wǎng)絡(luò)基礎(chǔ)設(shè)施提出的挑戰(zhàn),更將助力整個社會的數(shù)字化轉(zhuǎn)型,加速人類數(shù)智時代的全面到來。

審核編輯:劉清

-

gpu

+關(guān)注

關(guān)注

28文章

4830瀏覽量

129778 -

人工智能

+關(guān)注

關(guān)注

1800文章

48083瀏覽量

242155 -

OpenAI

+關(guān)注

關(guān)注

9文章

1184瀏覽量

6917 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1578瀏覽量

8285 -

AIGC

+關(guān)注

關(guān)注

1文章

372瀏覽量

1737

原文標題:到底什么樣的網(wǎng)絡(luò),才能帶得動AIGC?

文章出處:【微信號:鮮棗課堂,微信公眾號:鮮棗課堂】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

算智算中心的算力如何衡量?

科技云報到:要算力更要“算利”,“精裝算力”觸發(fā)大模型產(chǎn)業(yè)新變局?

AIGC入門及鴻蒙入門

企業(yè)AI算力租賃模式的好處

算力調(diào)度的基礎(chǔ)知識

算力基礎(chǔ)篇:從零開始了解算力

【一文看懂】大白話解釋“GPU與GPU算力”

OCTC發(fā)布"算力工廠"!力促智算中心高效規(guī)劃建設(shè)投運

中國算力大會召開,業(yè)界首個算力高質(zhì)量評估體系發(fā)布

大模型時代的算力需求

揭秘芯片算力:為何它如此關(guān)鍵?

到底什么是算力?算力的價值在哪里?

AIGC到底需要多大的算力?

AIGC到底需要多大的算力?

評論