Claude在MLIR代碼分析上完全超越了ChatGPT并表現(xiàn)十分驚艷,請閱讀全文或者自己注冊感受它的強大。結論:在本文的任務中,Claude > ChatGPT >> NewBing

0x0. 前言

這里將以oneflow IR部分中的一個Codegen任務(目標是在mlir codegen中支持oneflow stream,用oneflow stream替換pass中自己生成的stream,PR鏈接為:https://github.com/Oneflow-Inc/oneflow/pull/10149)為例,來對比一下newibing(chatgpt)和claude對mlir的理解能力。claude是Anthropic公司推出的類似于chatgpt的聊天機器人,這家公司是OpenAI的最大競爭對手之一,因為創(chuàng)辦這家公司的人也是OpenAI的前員工。然后Claude是參考這個issue: https://www.zhihu.com/question/594115372/answer/2988759047 將其直接添加到slack里進行對話。

0x1. PR簡介

PR鏈接為:https://github.com/Oneflow-Inc/oneflow/pull/10149

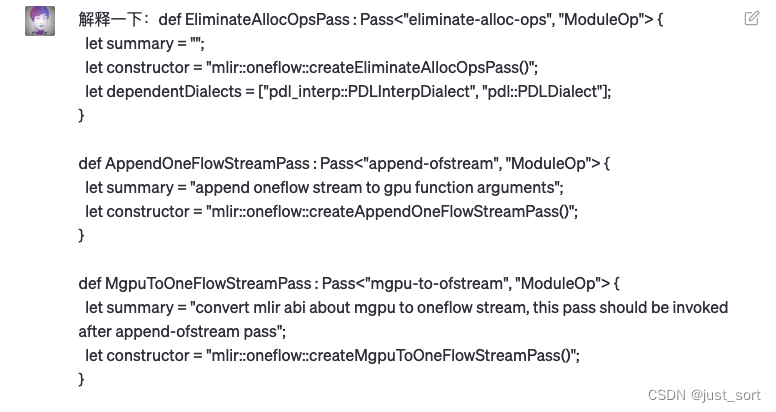

這個PR實現(xiàn)了3個Pass (定義在 OneFlowPasses.td),也就是:

defEliminateAllocOpsPass:Pass<"eliminate-alloc-ops","ModuleOp">{

letsummary="";

letconstructor="mlir::createEliminateAllocOpsPass()";

letdependentDialects=["pdl_interp::PDLInterpDialect","pdl::PDLDialect"];

}

defAppendOneFlowStreamPass:Pass<"append-ofstream","ModuleOp">{

letsummary="appendoneflowstreamtogpufunctionarguments";

letconstructor="mlir::createAppendOneFlowStreamPass()";

}

defMgpuToOneFlowStreamPass:Pass<"mgpu-to-ofstream","ModuleOp">{

letsummary="convertmlirabiaboutmgputooneflowstream,thispassshouldbeinvokedafterappend-ofstreampass";

letconstructor="mlir::createMgpuToOneFlowStreamPass()";

}

EliminateAllocOpsPass用來消除IR中的無效memref.alloc指令,AppendOneFlowStreamPass給GPU相關的函數(shù)添加GPU啟動kernel需要的stream參數(shù),MgpuToOneFlowStreamPass發(fā)生在AppendOneFlowStreamPass執(zhí)行之后(它生成了stream參數(shù))并把mgpu相關的stream abi替換為oneflow stream abi。

我們分別使用newbing和claude來讓它們分析一下這幾行OneFlowPasses.td中定義的Pass意圖:

newbing:

newbing直接看不懂,其實我感覺claude也應該看不懂吧,抱著懷疑的態(tài)度問一下。

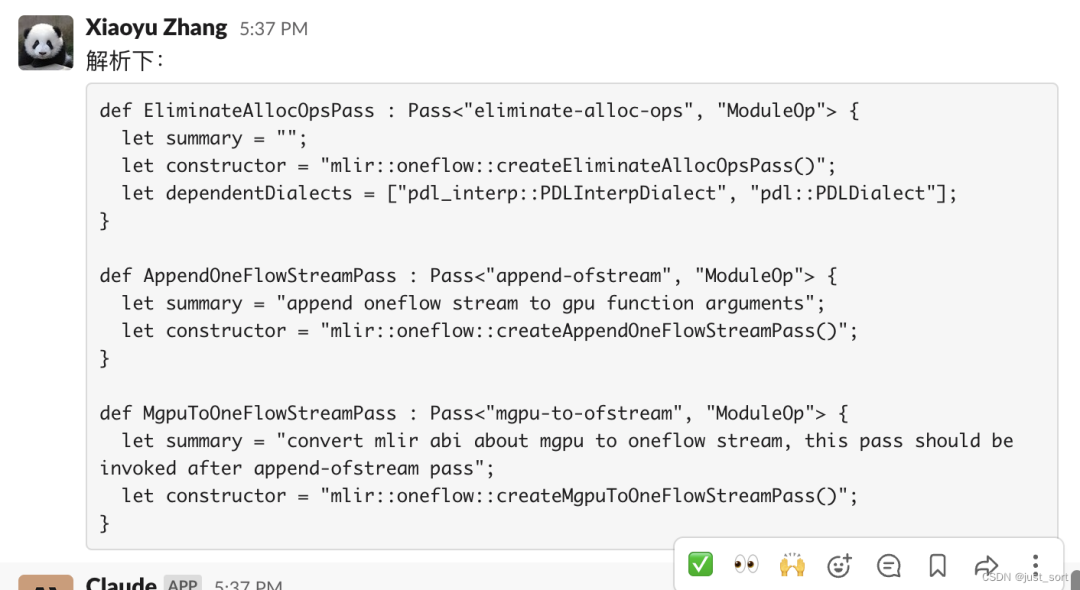

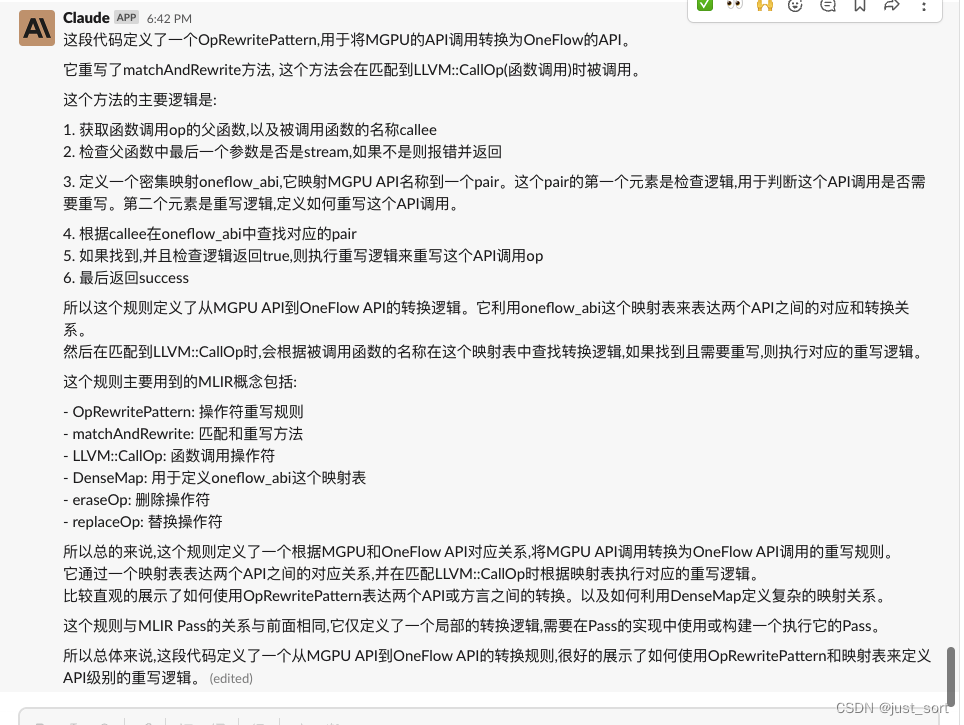

太瘋狂了,claude不僅讀懂了td文件的代碼,甚至為我們列出了這個代碼涉及到的MLIR概念。感覺是訓練數(shù)據(jù)考慮了MLIR相關的預料?接下來我們再對比下C++實現(xiàn)的Pass代碼。

0x2. 對比具體實現(xiàn)

PR鏈接為:https://github.com/Oneflow-Inc/oneflow/pull/10149

0x2.1 EliminateAllocOpsPass

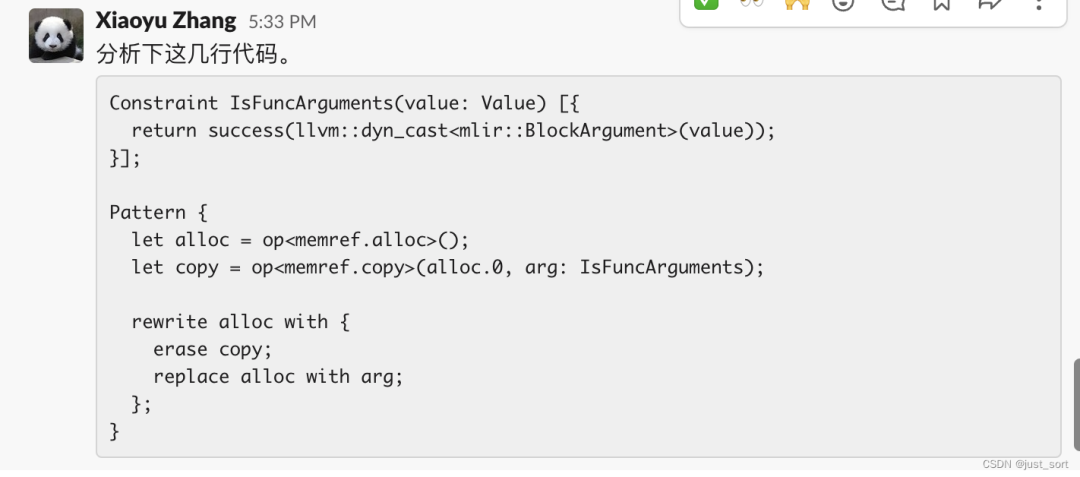

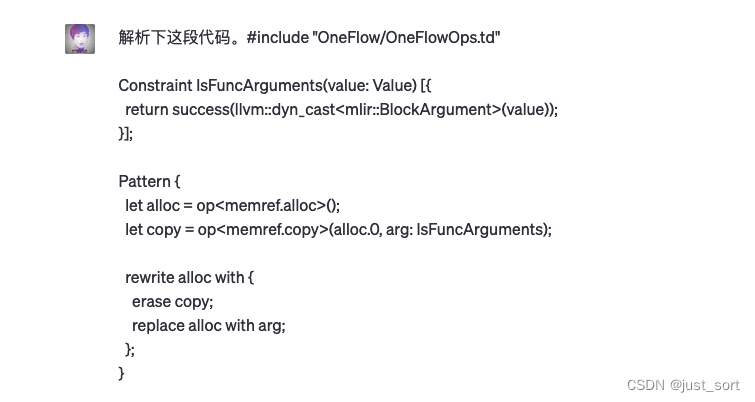

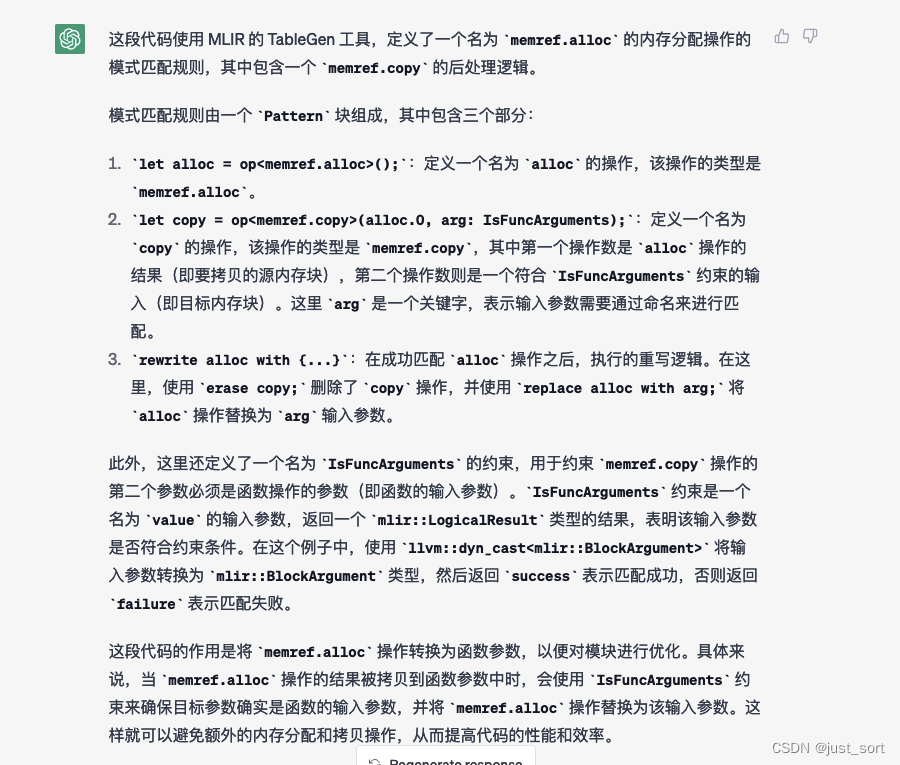

EliminateAllocOpsPass使用MLIR提供的PDL語言來完成Pattern的匹配和重寫,具體實現(xiàn)在 oneflow/ir/lib/OneFlow/PDLL/AllocEliminationPatterns.pdll :

#include"OneFlow/OneFlowOps.td"

ConstraintIsFuncArguments(value:Value)[{

returnsuccess(llvm::dyn_cast(value));

}];

Pattern{

letalloc=op();

letcopy=op(alloc.0,arg:IsFuncArguments);

rewriteallocwith{

erasecopy;

replaceallocwitharg;

};

}

接下來,我們分別對比一下newbing和chatgpt對它的分析結果。

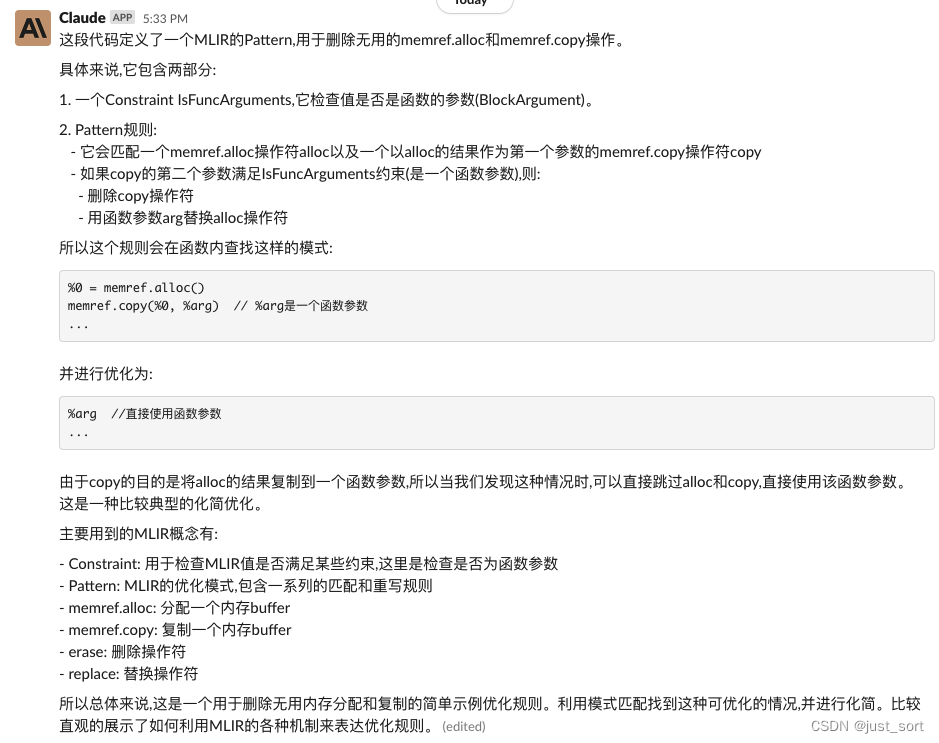

newbing并不能解析出這段代碼是MLIR的PDL語言,當然也無法理解代碼內(nèi)容。我們可以再使用Claude試試。

個人感覺這個解釋是非常強大且精準的,Claude的答案非常驚艷。

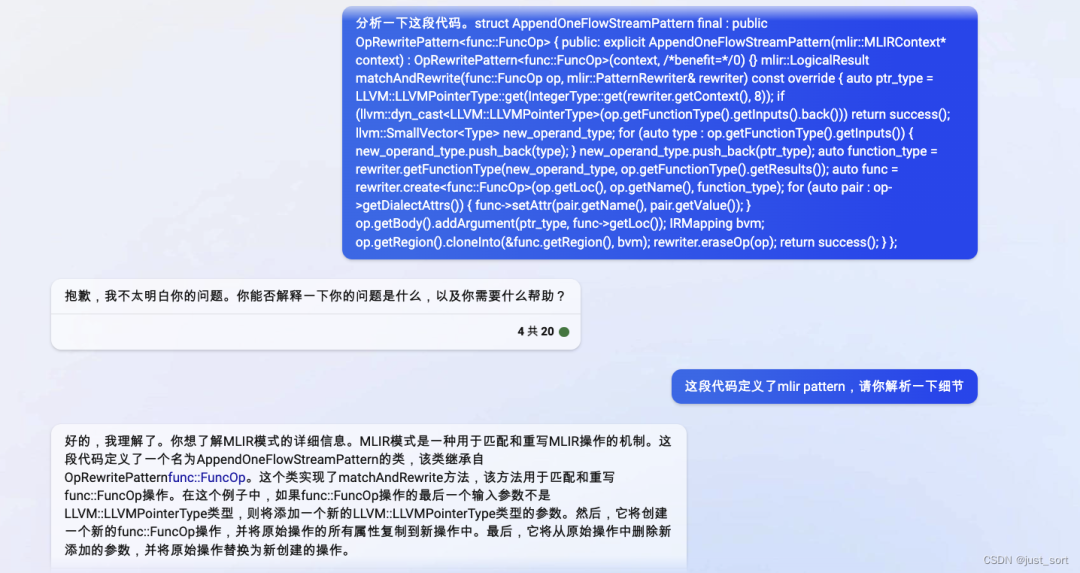

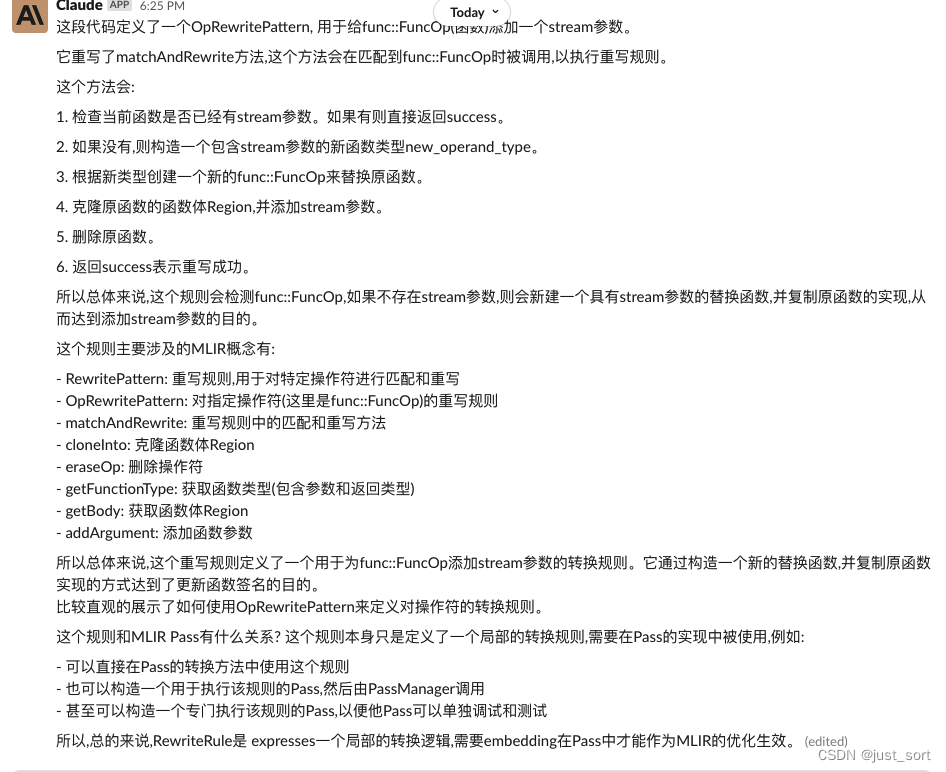

0x2.2 AppendOneFlowStreamPass

接下來我們看一下AppendOneFlowStreamPass的實現(xiàn),這個實現(xiàn)是在oneflow/ir/lib/OneFlow/Transform/OneFlowStream.cpp這個文件,具體代碼如下:

structAppendOneFlowStreamPatternfinal:publicOpRewritePattern{

public:

explicitAppendOneFlowStreamPattern(mlir::MLIRContext*context)

:OpRewritePattern(context,/*benefit=*/0) {}

mlir::LogicalResultmatchAndRewrite(func::FuncOpop,

mlir::PatternRewriter&rewriter)constoverride{

autoptr_type=LLVM::get(rewriter.getContext(),8));

if(llvm::dyn_cast(op.getFunctionType().getInputs().back()))

returnsuccess();

llvm::SmallVectornew_operand_type;

for(autotype:op.getFunctionType().getInputs()){new_operand_type.push_back(type);}

new_operand_type.push_back(ptr_type);

autofunction_type=

rewriter.getFunctionType(new_operand_type,op.getFunctionType().getResults());

autofunc=rewriter.create(op.getLoc(),op.getName(),function_type);

for(autopair:op->getDialectAttrs()){func->setAttr(pair.getName(),pair.getValue());}

op.getBody().addArgument(ptr_type,func->getLoc());

IRMappingbvm;

op.getRegion().cloneInto(&func.getRegion(),bvm);

rewriter.eraseOp(op);

returnsuccess();

}

};

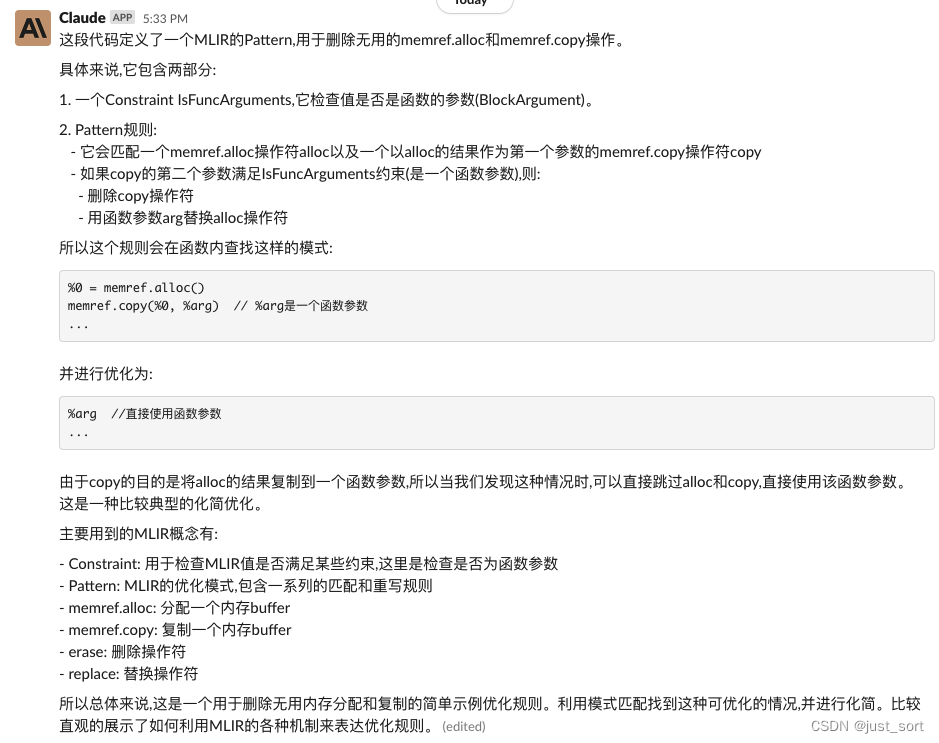

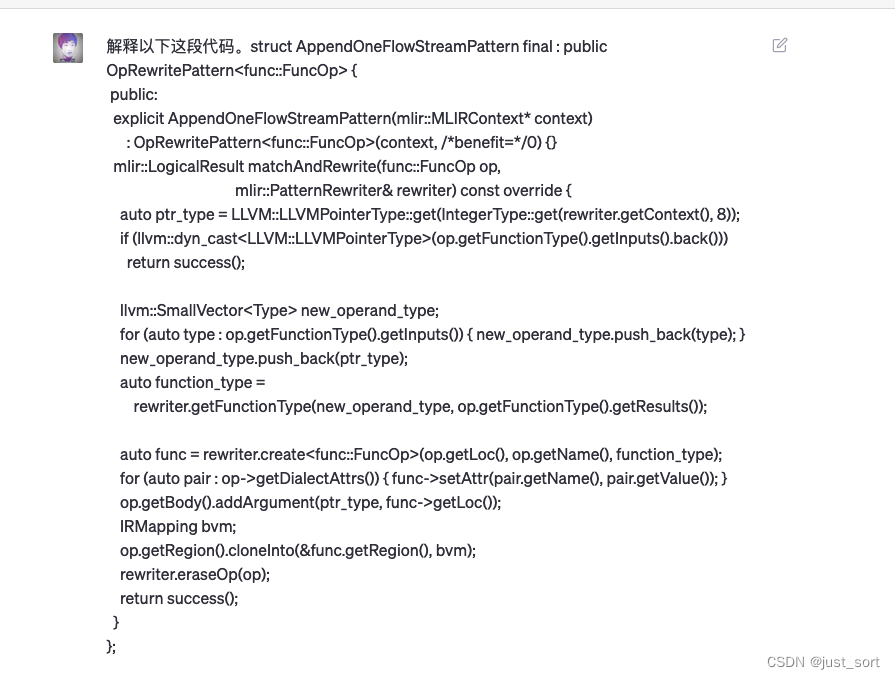

c++代碼newbing(chatgpt)按道理可以看懂了,我們讓它分析一下:

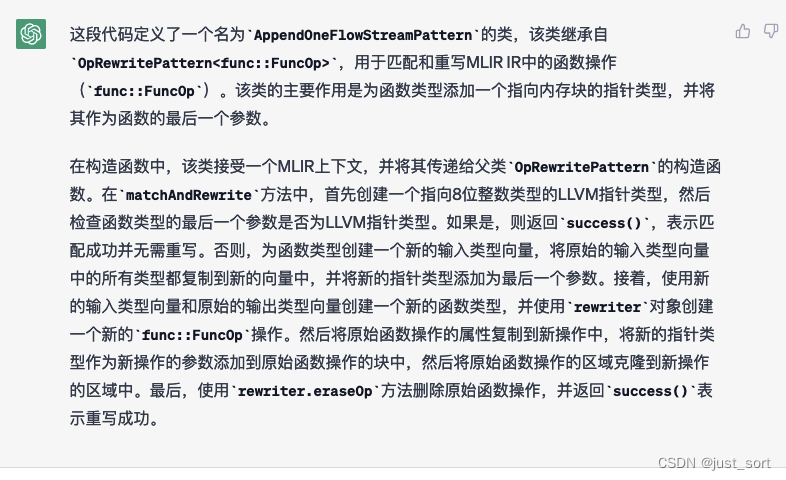

直接問chatgpt,它還是不懂這段代碼。我手動提示了下它說,這段代碼定義了一個mlir pattern,然后它先是重復我的話給出了一段回答。然后接下來就是胡說八道了,在這個例子中表現(xiàn)很差。接下來我們拷問一下Claude:

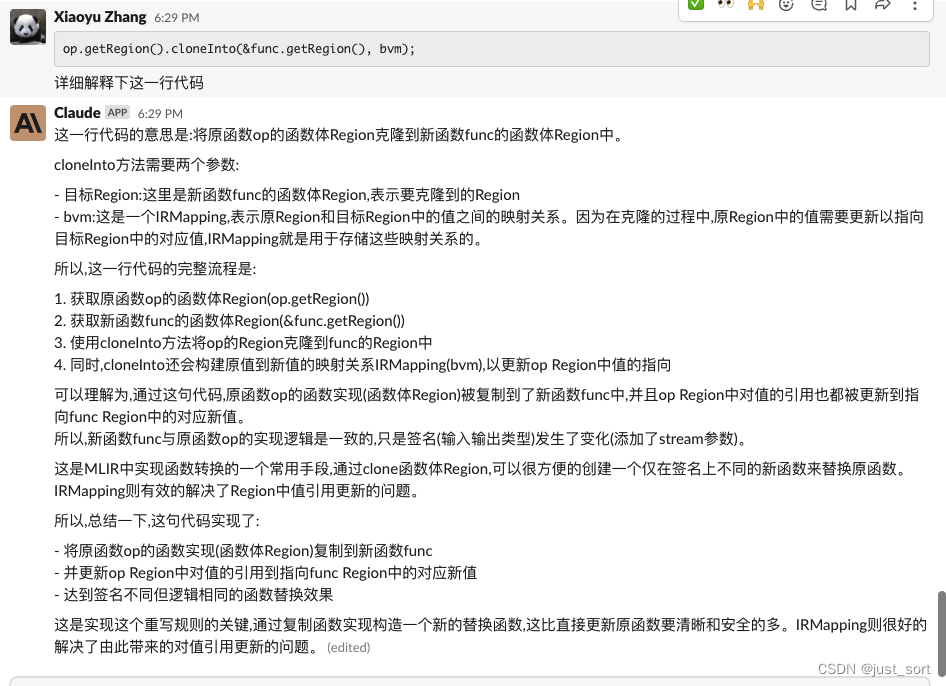

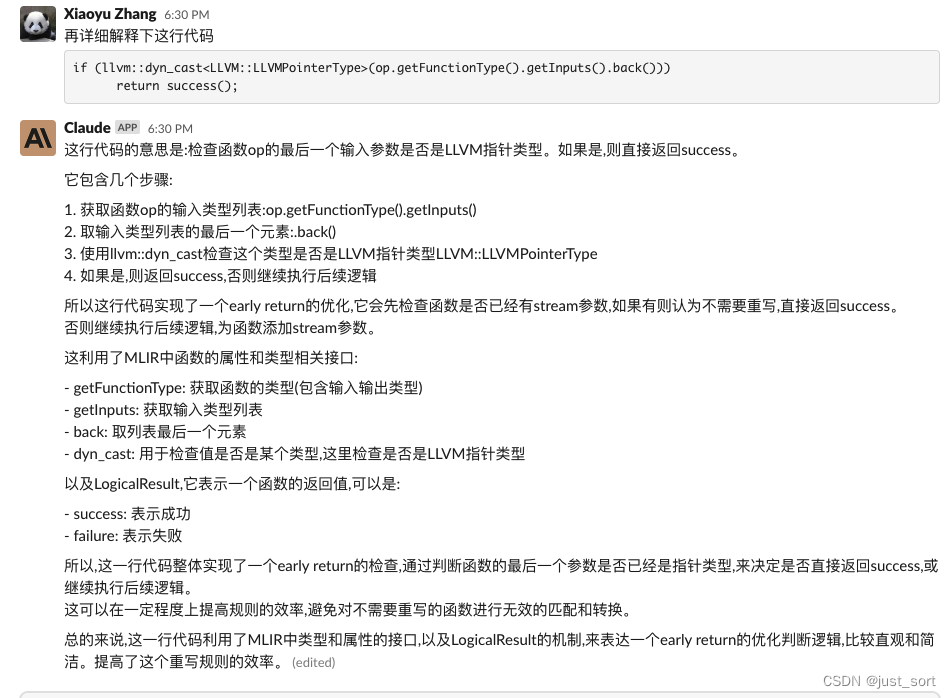

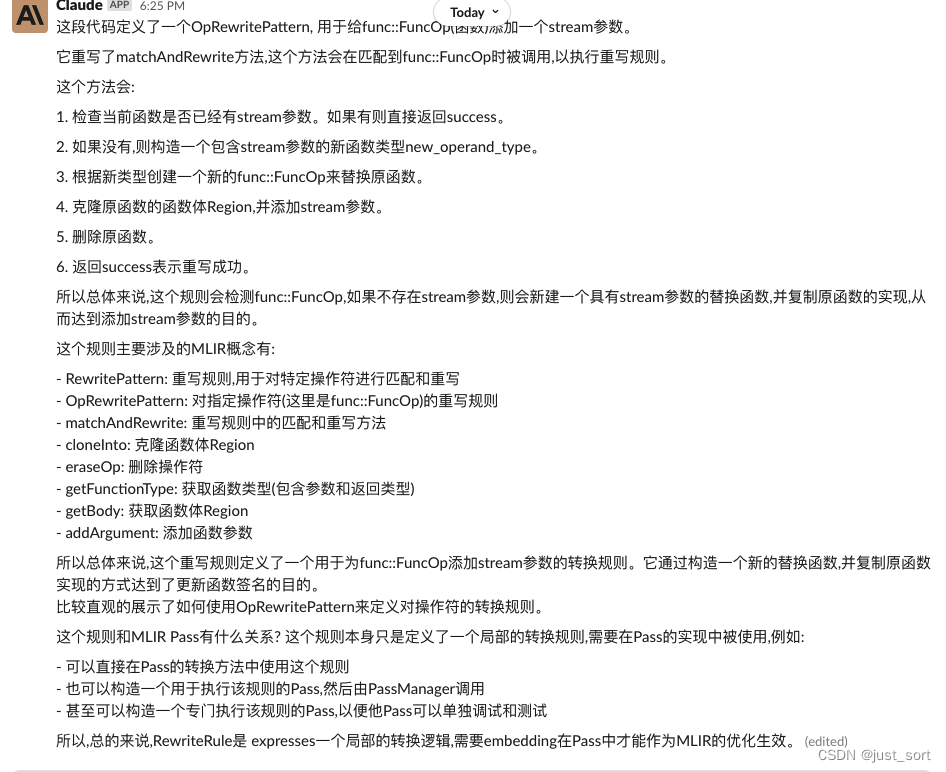

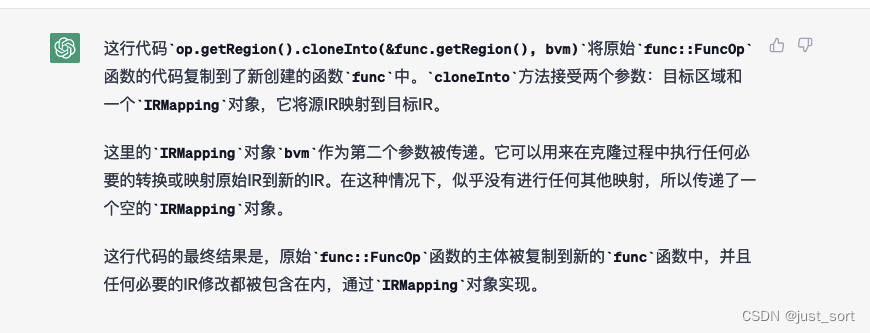

我們繼續(xù)問一下c++代碼中的一些細節(jié):

非常強大,給出的解釋大多比較精準,并且似乎Claude真的完全理解了這段代碼的邏輯。我們需要注意的是,這段代碼是我同事今天才寫的,模型的泛化性真的很好。

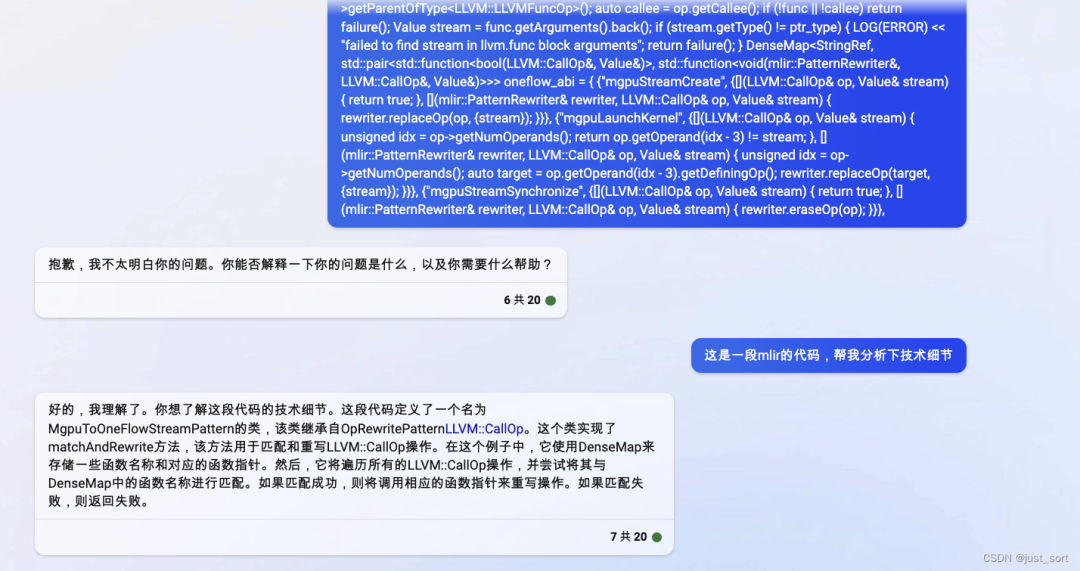

MgpuToOneFlowStreamPass

我們最后再分析下MgpuToOneFlowStreamPass的實現(xiàn)。

structMgpuToOneFlowStreamPatternfinal:publicOpRewritePattern{

public:

explicitMgpuToOneFlowStreamPattern(mlir::MLIRContext*context)

:OpRewritePattern(context,/*benefit=*/0) {}

mlir::LogicalResultmatchAndRewrite(LLVM::CallOpop,

mlir::PatternRewriter&rewriter)constoverride{

autoptr_type=LLVM::get(rewriter.getContext(),8));

autofunc=op->getParentOfType();

autocallee=op.getCallee();

if(!func||!callee)returnfailure();

Valuestream=func.getArguments().back();

if(stream.getType()!=ptr_type){

LOG(ERROR)<"failedtofindstreaminllvm.funcblockarguments";

returnfailure();

}

DenseMapstd::pair<std::function<bool(LLVM::CallOp&,Value&)>,

std::function<void(mlir::PatternRewriter&,LLVM::CallOp&,Value&)>>>

oneflow_abi={

{"mgpuStreamCreate",

{[](LLVM::CallOp&op,Value&stream){returntrue;},

[](mlir::PatternRewriter&rewriter,LLVM::CallOp&op,Value&stream){

rewriter.replaceOp(op,{stream});

}}},

{"mgpuLaunchKernel",

{[](LLVM::CallOp&op,Value&stream){

unsignedidx=op->getNumOperands();

returnop.getOperand(idx-3)!=stream;

},

[](mlir::PatternRewriter&rewriter,LLVM::CallOp&op,Value&stream){

unsignedidx=op->getNumOperands();

autotarget=op.getOperand(idx-3).getDefiningOp();

rewriter.replaceOp(target,{stream});

}}},

{"mgpuStreamSynchronize",

{[](LLVM::CallOp&op,Value&stream){returntrue;},

[](mlir::PatternRewriter&rewriter,LLVM::CallOp&op,Value&stream){

rewriter.eraseOp(op);

}}},

{"mgpuStreamDestroy",

{[](LLVM::CallOp&op,Value&stream){returntrue;},

[](mlir::PatternRewriter&rewriter,LLVM::CallOp&op,Value&stream){

rewriter.eraseOp(op);

}}},

};

autoout=oneflow_abi.find(callee.value().str());

if(out!=oneflow_abi.end()&&out->getSecond().first(op,stream)){

out->getSecond().second(rewriter,op,stream);

}

returnsuccess();

}

};

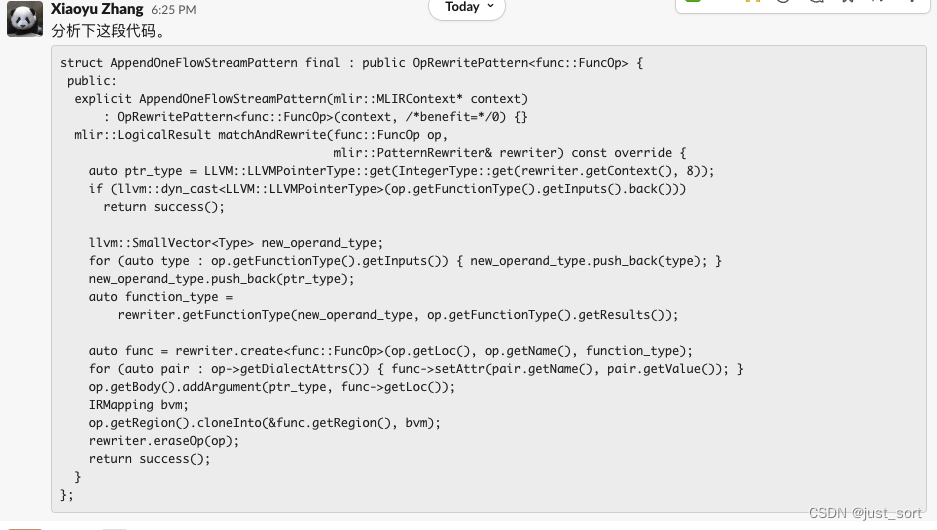

還是先讓chatgpt分析下:

回答還是比較模棱兩可,并且可以確定的事情是chatgpt完全沒有理解這段代碼。

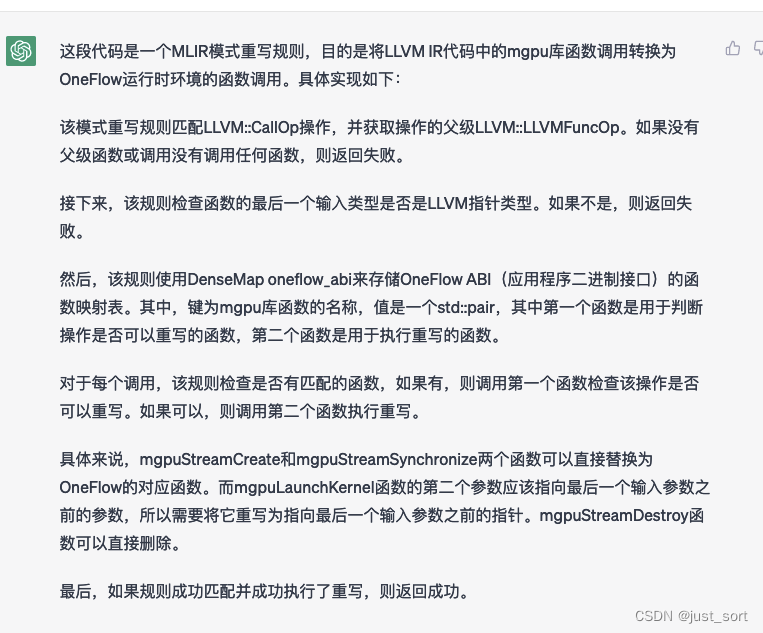

接下來還是使用Claude來測試下:

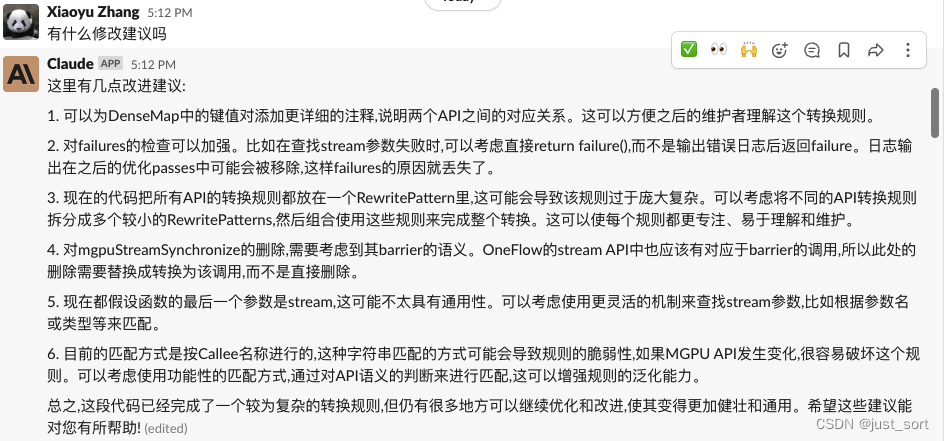

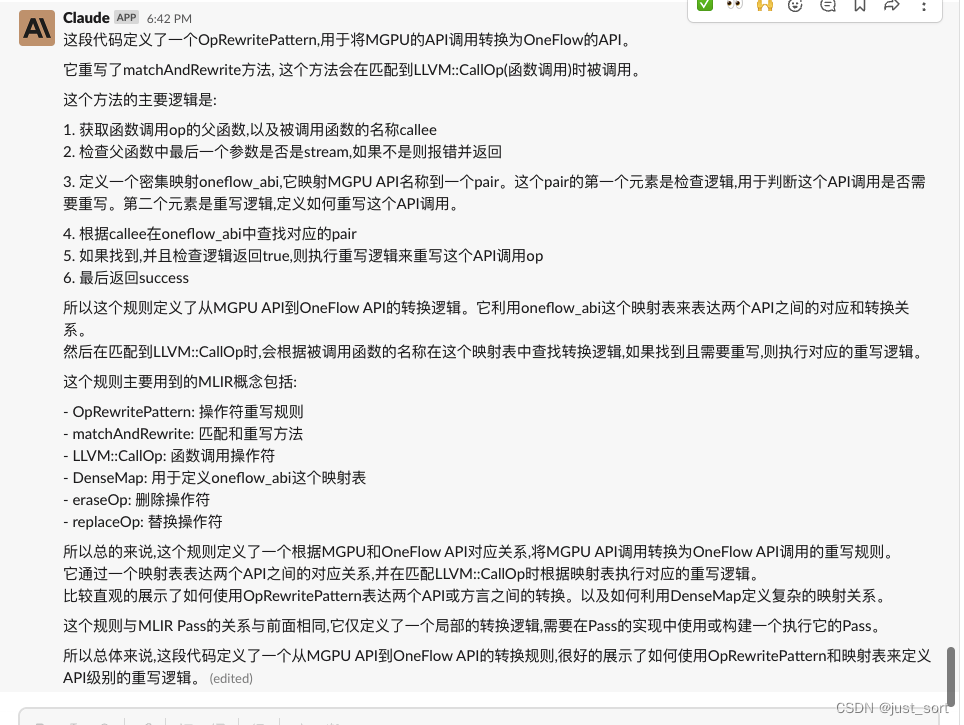

這個地方讓我震驚的點是,它不僅理解了這段代碼,而且知道在MLIR里面這段代碼只是一個Pattern規(guī)則,如果要應用這個規(guī)則需要在MLIR里面再構建一個Pass。最后我們再讓Claude給我們一些Review意見:

這里的第4點提示讓我感到有些疑惑,我還請教了下同事,順便讓同事補充一下注釋。

整體來說,在閱讀MLIR代碼方面,Claude已經(jīng)相當智能,全面領先Newbing(Chatgpt),感覺以后可以日常用Claude來輔助Review IR相關代碼。

0x3. 總結

我這里以MLIR的一個任務對比了一下ChatGpt和Claude,我感受到了Calude的強大之處。雖然暫時還沒有評測過別的任務,但我已經(jīng)被Calude表現(xiàn)出來的代碼分析能力所震撼。我們甚至可以將Claude作為一個入門AI編譯器的入門工具

--------------------------------分割線-------------------------------------

評論區(qū)有朋友提出newbing的一些功能被限制了,并不等價于chatgpt3.5,我借了一個官方的chatgpt賬號重新測試了一下,以下是測試結果:

就這個例子來說,chatgpt的解釋沒有Claude那么細節(jié),Claude的結果確實比chatgpt的好一點,不過chatgpt確實知道這個是MLIR的Pass,不像newbing那樣被限制。

EliminateAllocOpsPass

接下來問問 EliminateAllocOpsPass 的實現(xiàn):

我們可以對比下上面Calude的結果,感覺針對這個問題ChatGPT的描述以及理解是不如Claude那么自然的。從這個回答里面我們并不能看出ChatGPT理解了這個實現(xiàn)的原理,而Claude則完全理解了。

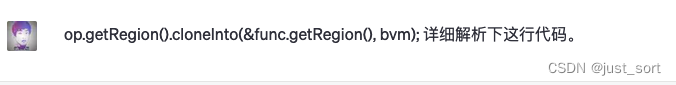

AppendOneFlowStreamPattern

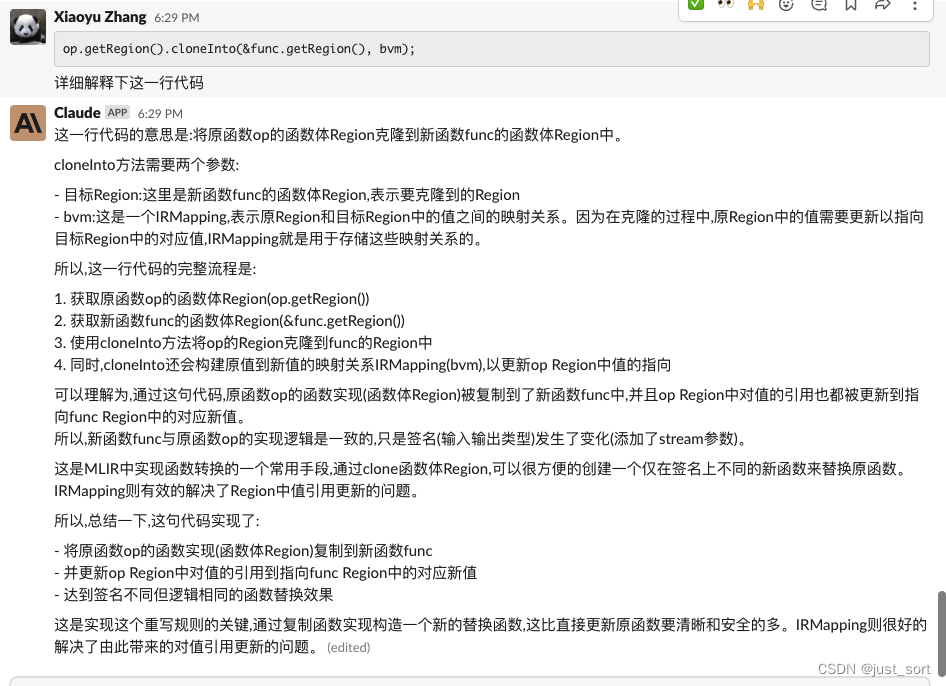

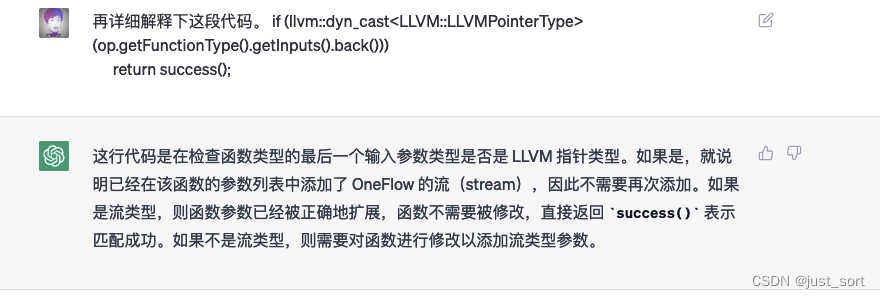

對比下Claude:

可以看到Claude的分析比ChatGPT好很多,它明確的知道if (llvm::dyn_cast 這行代碼是檢查當前函數(shù)是否已經(jīng)有Stream參數(shù),而ChatGPT的回答則不知道這個指針類型的參數(shù)就代表Stream。

接下來是細節(jié)分析。

對比下Claude

Claude的解釋再次擊敗了ChatGPT

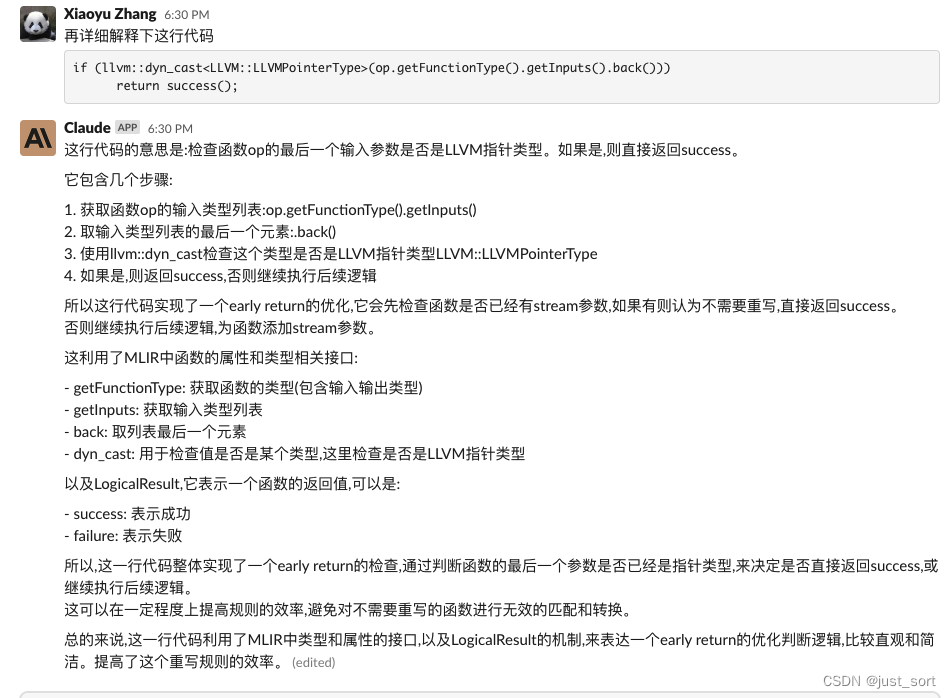

對比下Claude

可以看到Claude的結果顯然也是更優(yōu)的,不僅為我們解釋了所有細節(jié)還列出了用到的MLIR相關屬性和接口。

MgpuToOneFlowStreamPass

我們最后再分析下MgpuToOneFlowStreamPass的實現(xiàn)。

對比Claude

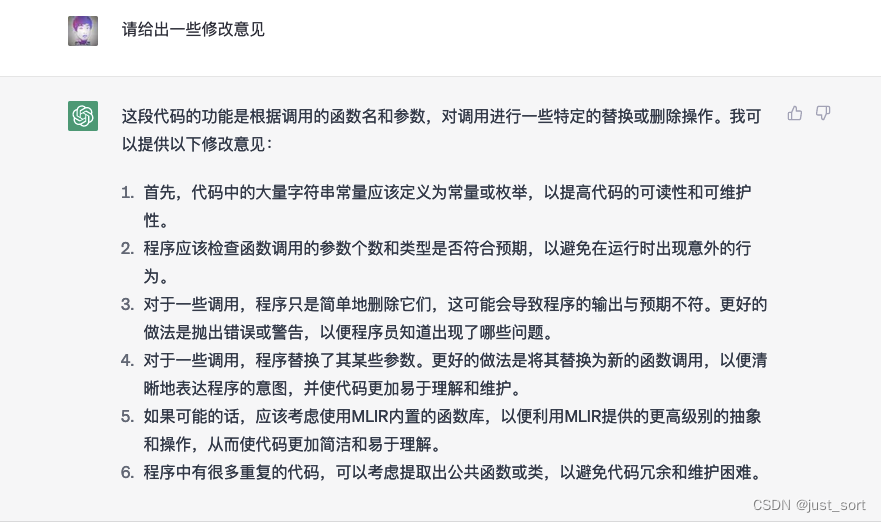

Claude的結果也顯著優(yōu)于ChatGPT,并且可以發(fā)現(xiàn)ChatGPT的回答里面還漏掉了一個mgpuStreamSynchronize ABI。最后,我們再問一下ChatGPT能不能給出一些修改意見。

感覺和Claude差不多。

結論2

整體來看,在這個Review MLIR代碼的任務中,Claude > ChatGPT >> NewBing

審核編輯 :李倩

-

聊天機器人

+關注

關注

0文章

339瀏覽量

12304 -

ChatGPT

+關注

關注

29文章

1558瀏覽量

7595

原文標題:結論2

文章出處:【微信號:GiantPandaCV,微信公眾號:GiantPandaCV】歡迎添加關注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關推薦

在IC設計/驗證中怎么應用ChatGPT呢?

科技大廠競逐AIGC,中國的ChatGPT在哪?

十分鐘學會Xilinx FPGA 設計

AI編譯器:ChatGpt和Claude有何區(qū)別

Claude在MLIR代碼分析上完全超越了ChatGPT

如何設計MLIR的Dialect來在GPU上生成高性能的代碼?

ChatGPT最強競品Claude2來了:代碼、GRE 成績超越GPT-4,免費可用

你的自選股里,99%的ChatGPT概念股沒有技術含量

如何適配新架構?TPU-MLIR代碼生成CodeGen全解析!

Claude在MLIR代碼分析上完全超越了ChatGPT并表現(xiàn)十分驚艷

Claude在MLIR代碼分析上完全超越了ChatGPT并表現(xiàn)十分驚艷

評論