1、Rx Sensitivity(接收靈敏度)

接收靈敏度,這應該是最基本的概念之一,表征的是接收機能夠在不超過一定誤碼率的情況下識別的最低信號強度。這里說誤碼率,是沿用CS(電路交換)時代的定義作一個通稱,在多數情況下,BER (bit error rate)或者PER (packet error rate)會用來考察靈敏度,在LTE時代干脆用吞吐量Throughput來定義——因為LTE干脆沒有電路交換的語音信道,但是這也是一個實實在在的進化,因為第一次我們不再使用諸如12.2kbps RMC(參考測量信道,實際代表的是速率12.2kbps的語音編碼)這樣的"標準化替代品"來衡量靈敏度,而是以用戶可以實實在在感受到的吞吐量來定義之。

2、SNR(信噪比)

講靈敏度的時候我們常常聯系到SNR(信噪比,我們一般是講接收機的解調信噪比),我們把解調信噪比定義為不超過一定誤碼率的情況下解調器能夠解調的信噪比門限(面試的時候經常會有人給你出題,給一串NF、Gain,再告訴你解調門限要你推靈敏度)。那么S和N分別何來?

S即信號Signal,或者稱為有用信號;N即噪聲Noise,泛指一切不帶有有用信息的信號。有用信號一般是通信系統發射機發射出來,噪聲的來源則是非常廣泛的,最典型的就是那個著名的-174dBm/Hz——自然噪聲底,要記住它是一個與通信系統類型無關的量,從某種意義上講是從熱力學推算出來的(所以它跟溫度有關);另外要注意的是它實際上是個噪聲功率密度(所以有dBm/Hz這個量綱),我們接收多大帶寬的信號,就會接受多大帶寬的噪聲——所以最終的噪聲功率是用噪聲功率密度對帶寬積分得來。

3、TxPower(發射功率)

發射功率的重要性,在于發射機的信號需要經過空間的衰落之后才能到達接收機,那么越高的發射功率意味著越遠的通信距離。

那么我們的發射信號要不要講究SNR?譬如說,我們的發射信號SNR很差,那么到達接收機的信號SNR是不是也很差?

這個牽涉到剛才講過的概念,自然噪聲底。我們假設空間的衰落對信號和噪聲都是效果相同的(實際上不是,信號能夠通編碼抵御衰落而噪聲不行)而且是如同衰減器一般作用的,那么我們假設空間衰落-200dB,發射信號帶寬1Hz,功率50dBm,信噪比50dB,接收機收到信號的SNR是多少?

接收機收到信號的功率是50-200=-150Bm(帶寬1Hz),而發射機的噪聲50-50=0dBm通過空間衰落,到達接收機的功率是0-200=-200dBm(帶寬1Hz)?這時候這部分噪聲早已被"淹沒"在-174dBm/Hz的自然噪聲底之下了,此時我們計算接收機入口的噪聲,只需要考慮-174dBm/Hz的"基本成分"即可。這在通信系統的絕大部分情況下是適用的。

4、ACLR/ACPR

我們把這些項目放在一起,是因為它們表征的實際上是"發射機噪聲"的一部分,只是這些噪聲不是在發射信道之內,而是發射機泄漏到臨近信道中去的部分,可以統稱為"鄰道泄漏"。

其中ACLR和ACPR(其實是一個東西,不過一個是在終端測試中的叫法,一個是在基站測試中的叫法罷了),都是以"Adjacent Channel"命名,顧名思義,都是描述本機對其他設備的干擾。而且它們有個共同點,對干擾信號的功率計算也是以一個信道帶寬為計。這種計量方法表明,這一指標的設計目的,是考量發射機泄漏的信號,對相同或相似制式的設備接收機的干擾——干擾信號以同頻同帶寬的模式落到接收機帶內,形成對接收機接收信號的同頻干擾。

在LTE中,ACLR的測試有兩種設置,EUTRA和UTRA,前者是描述LTE系統對LTE系統的干擾,后者是考慮LTE系統對UMTS系統的干擾。所以我們可以看到EUTRAACLR的測量帶寬是LTE RB的占用帶寬,UTRA ACLR的測量帶寬是UMTS信號的占用帶寬(FDD系統3.84MHz,TDD系統1.28MHz)。換句話說,ACLR/ACPR描述的是一種"對等的"干擾:發射信號的泄漏對同樣或者類似的通信系統發生的干擾。

這一定義是有非常重要的實際意義的。實際網絡中同小區鄰小區還有附近小區經常會有信號泄漏過來,所以網規網優的過程實際上就是容量最大化和干擾最小化的過程,而系統本身的鄰道泄漏對于鄰近小區就是典型的干擾信號;從系統的另一個方向來看,擁擠人群中用戶的手機也可能成為互相的干擾源。

同樣的,在通信系統的演化中,從來是以"平滑過渡"為目標,即在現有網絡上升級改造進入下一代網絡。那么兩代甚至三代系統共存就需要考慮不同系統之間的干擾,LTE引入UTRA即是考慮了LTE在與UMTS共存的情形下對前代系統的射頻干擾。

5、調制頻譜/開關頻譜

而退回到GSM系統,Modulation Spectrum(調制譜)和Switching Spectrum(切換譜,也有稱為開關譜的,對舶來品不同翻譯的緣故)也是扮演了鄰道泄漏相似的角色。不同的是它們的測量帶寬并不是GSM信號的占用帶寬。從定義上看,可以認為調制譜是衡量同步系統之間的干擾,而切換譜是衡量非同步系統之間的干擾(事實上如果不對信號做gating,切換譜一定是會把調制譜淹沒掉的)。

這就牽涉到另一個概念:GSM系統中,各小區之間是不同步的,雖然它用的是TDMA;而相比之下,TD-SCDMA和之后的TD-LTE,小區之間是同步的(那個飛碟形狀或者球頭的GPS天線永遠是TDD系統擺脫不了的桎梏)。

因為小區間不同步,所以A小區上升沿/下降沿的功率泄漏可能落到B小區的payload部分,所以我們用切換譜來衡量此狀態下發射機對鄰信道的干擾;而在整個577us的GSM timeslot里,上升沿/下降沿的占比畢竟很少,多數時候兩個相鄰小區的payload部分會在時間上交疊,評估這種情況下發射機對鄰信道的干擾就可以參考調制譜。

6、SEM(光譜發射掩模)

講SEM的時候,首先要注意它是一個"帶內指標",與spurious emission區分開來,后者在廣義上是包含了SEM的,但是著重看的其實是發射機工作頻段之外的頻譜泄漏,其引入也更多的是從EMC(電磁兼容)的角度。

SEM是提供一個"頻譜模版",然后在測量發射機帶內頻譜泄漏的時候,看有沒有超出模版限值的點。可以說它與ACLR有關系,但是又不相同:ACLR是考慮泄漏到鄰近信道中的平均功率,所以它以信道帶寬為測量帶寬,它體現的是發射機在鄰近信道內的"噪聲底";SEM反映的是以較小的測量帶寬(往往100kHz到1MHz)捕捉在鄰近頻段內的超標點,體現的是"以噪聲底為基礎的雜散發射"。

如果用頻譜儀掃描SEM,可以看到鄰信道上的雜散點會普遍的高出ACLR均值,所以如果ACLR指標本身沒有余量,SEM就很容易超標。反之SEM超標并不一定意味著ACLR不良,有一種常見的現象就是有LO的雜散或者某個時鐘與LO調制分量(往往帶寬很窄,類似點頻)串入發射機鏈路,這時候即便ACLR很好,SEM也可能超標。

7、EVM(誤差矢量)

首先,EVM是一個矢量值,也就是說它有幅度和角度,它衡量的是"實際信號與理想信號的誤差",這個量度可以有效的表達發射信號的"質量"——實際信號的點距離理想信號越遠,誤差就越大,EVM的模值就越大。

在(一)中我們曾經解釋過為什么發射信號的信噪比不是那么重要,原因有二:第一是發射信號的SNR往往遠遠高于接收機解調所需要的SNR;第二是我們計算接收靈敏度時參考的是接收機最惡劣的情況,即在經過大幅度空間衰落之后,發射機噪聲早已淹沒在自然噪聲底之下,而有用信號也被衰減到接收機的解調門限附近。

但是發射機的"固有信噪比"在某些情況下是需要被考慮的,譬如近距離無線通信,典型的如802.11系列。

802.11系列演進到802.11ac的時候,已經引入了256QAM的調制,對于接收機而言,即便不考慮空間衰落,光是解調這樣高階的正交調制信號就已經需要很高的信噪比,EVM越差,SNR就越差,解調難度就越高。

做802.11系統的工程師,往往用EVM來衡量Tx線性度;而做3GPP系統的工程師,則喜歡用ACLR/ACPR/Spectrum來衡量Tx線性性能。

從起源上講,3GPP是蜂窩通信的演進道路,從一開始就不得不關注鄰信道、隔信道(adjacent channel, alternative channel)的干擾。換句話說,干擾是影響蜂窩通信速率的第一大障礙,所以3GPP在演進的過程中,總是以"干擾最小化"為目標的:GSM時代的跳頻,UMTS時代的擴頻,LTE時代RB概念的引入,都是如此。

而802.11系統是固定無線接入的演進,它是秉承TCP/IP協議精神而來,以"盡最大能力的服務"為目標,802.11中經常會有時分或者跳頻的手段來實現多用戶共存,而布網則比較靈活(畢竟以局域網為主),信道寬度也靈活可變。總的來說它對干擾并不敏感(或者說容忍度比較高)。

通俗的講,就是蜂窩通信的起源是打電話,打不通電話用戶會去電信局砸場子;802.11的起源是局域網,網絡不好大概率是先耐著性子等等(其實這時候設備是在作糾錯和重傳)。

這就決定了3GPP系列必然以ACLR/ACPR一類"頻譜再生"性能為指標,而802.11系列則可以以犧牲速率來適應網絡環境。

具體說來,"以犧牲速率來適應網絡環境",就是指的802.11系列中以不同的調制階數來應對傳播條件:當接收機發現信號差,就立即通知對面的發射機降低調制階數,反之亦然。 前面提到過,802.11系統中SNR與EVM相關很大,很大程度上EVM降低可以提高SNR。 這樣我們就有兩種途徑改善接收性能:一是降低調制階數,從而降低解調門限; 二是降低發射機EVM,使得信號SNR提高。

因為EVM與接收機解調效果密切相關,所以802.11系統中以EVM來衡量發射機性能(類似的,3GPP定義的蜂窩系統中,ACPR/ACLR是主要影響網絡性能的指標); 又因為發射機對EVM的惡化主要因為非線性引起(譬如PA的AM-AM失真),所以EVM通常作為衡量發射機線性性能的標志。

7.1、EVM與ACPR/ACLR的關系

很難定義EVM與ACPR/ACLR的定量關系,從放大器的非線性來看,EVM與ACPR/ACLR應該是正相關的:放大器的AM-AM、AM-PM失真會擴大EVM,同時也是ACPR/ACLR的主要來源。

但是EVM與ACPR/ACLR并不總是正相關,我們這里可以找到一個很典型的例子:數字中頻中常用的Clipping,即削峰。 Clipping是削減發射信號的峰均比(PAR),峰值功率降低有助于降低通過PA之后的ACPR/ACLR; 但是Clipping同時會損害EVM,因為無論是限幅(加窗)還是用濾波器方法,都會對信號波形產生損傷,因而增大EVM。

7.2、PAR的源流

PAR(信號峰均比)通常用CCDF這樣一個統計函數來表示,其曲線表示的是信號的功率(幅度)值和其對應的出現概率。 譬如某個信號的平均功率是10dBm,它出現超過15dBm功率的統計概率是0.01%,我們可以認為它的PAR是5dB。

PAR是現代通信系統中發射機頻譜再生(諸如ACLP/ACPR/Modulation Spectrum)的重要影響因素。峰值功率會將放大器推入非線性區從而產生失真,往往峰值功率越高、非線性越強。

在GSM時代,因為GMSK調制的衡包絡特性,所以PAR=0,我們在設計GSM功放的時候經常把它推到P1dB,以得到最大限度的效率。引入EDGE之后,8PSK調制不再是衡包絡,因此我們往往將功放的平均輸出功率推到P1dB以下3dB左右,因為8PSK信號的PAR是3.21dB。

UMTS時代,無論WCDMA還是CDMA,峰均比都比EDGE大得多。原因是碼分多址系統中信號的相關性:當多個碼道的信號在時域上疊加時,可能出現相位相同的情況,此時功率就會呈現峰值。

LTE的峰均比則是源自RB的突發性。OFDM調制是基于將多用戶/多業務數據在時域上和頻域上都分塊的原理,這樣就可能在某一"時間塊"上出現大功率。LTE上行發射用SC-FDMA,先用DFT將時域信號擴展到頻域上,等于"平滑"掉了時域上的突發性,從而降低了PAR。

8、干擾指標匯總

這里的"干擾指標",指的是出了接收機靜態靈敏度之外,各種施加干擾下的靈敏度測試。實際上研究這些測試項的由來是很有意思的。

我們常見的干擾指標,包括Blocking,Desense,Channel Selectivity等。

8.1、Blocking(阻塞)

Blocking實際上是一種非常古老的RF指標,早在雷達發明之初就有。其原理是以大信號灌入接收機(通常最遭殃的是第一級LNA),使得放大器進入非線性區甚至飽和。此時一方面放大器的增益驟然變小,另一方面產生極強非線性,因而對有用信號的放大功能就無法正常工作了。

另一種可能的Blocking其實是通過接收機的AGC來完成的:大信號進入接收機鏈路,接收機AGC因此產生動作降低增益以確保動態范圍;但是同時進入接收機的有用信號電平很低,此時增益不足,進入到解調器的有用信號幅度不夠。

Blocking指標分為帶內和帶外,主要是因為射頻前端一般會有頻帶濾波器,對于帶外blocking會有抑制作用。但是無論帶內還是帶外,Blocking信號一般都是點頻,不帶調制。事實上完全不帶調制的點頻信號在現實世界里并不多見,工程上只是把它簡化成點頻,用以(近似)替代各種窄帶干擾信號。

對于解決Blocking,主要是RF出力,說白了就是把接收機IIP3提高,動態范圍擴大。對于帶外Blocking,濾波器的抑制度也是很重要的。

8.2、AM Suppression

AM Suppression是GSM系統特有的指標,從描述上看,干擾信號是與GSM信號相似的TDMA信號,與有用信號同步且有固定delay。

這種場景是模擬GSM系統中鄰近小區的信號,從干擾信號的頻偏要求大于6MHz(GSM帶寬200kHz)來看,這是很典型的鄰近小區信號配置。所以我們可以認為AM Suppression是一個反映GSM系統實際工作中接收機對鄰小區的干擾容忍度。

8.2、Adjacent (Alternative) Channel Suppression (Selectivity)

這里我們統稱為"鄰信道選擇性"。在蜂窩系統中,我們組網除了要考慮同頻小區,還要考慮鄰頻小區,其原因可以在我們之前討論過的發射機指標ACLR/ACPR/Modulation Spectrum中可以找到:因為發射機的頻譜再生會有很強的信號落到相鄰頻率中(一般來說頻偏越遠電平越低,所以鄰信道一般是受影響最大的),而且這種頻譜再生事實上是與發射信號有相關性的,即同制式的接收機很可能把這部分再生頻譜誤認為是有用信號而進行解調,所謂鵲巢鳩占。

舉個例子:如果兩個相鄰小區A和B恰好是鄰頻小區(一般會避免這樣的組網方式,這里只是討論一個極限場景),當一臺注冊到A小區的終端游走到兩個校區交界處,但是兩個小區的信號強度還沒有到切換門限,因此終端依然保持A小區連接;B小區基站發射機的ACPR較高,因此終端的接收頻帶內有較高的B小區ACPR分量,與A小區的有用信號在頻率上重疊;因為此時終端距離A小區基站較遠,因此接收到的A小區有用信號強度也很低,此時B小區ACPR分量進入到終端接收機時就可以對原有用信號造成同頻干擾。

如果我們注意看鄰道選擇性的頻偏定義,會發現有Adjacent和Alternative的區別,對應ACLR/ACPR的第一鄰道、第二鄰道,可見通信協議中"發射機頻譜泄漏(再生)"與"接收機鄰道選擇性"實際上是成對定義的。

8.3、Co-Channel Suppression (Selectivity)

這種描述的是絕對的同頻干擾,一般是指兩個同頻小區之間的干擾模式。

按照之前我們描述的組網原則,兩個同頻小區的距離應該盡量遠,但是即便再遠,也會有信號彼此泄漏,只是強度高低的區別。對于終端而言,兩個校區的信號都可以認為是"正確的有用信號"(當然協議層上有一組接入規范來防范這種誤接入),衡量終端的接收機能否避免"西風壓倒東風",就看它的同頻選擇性。

8.4 總結

Blocking是"大信號干擾小信號",RF尚有周旋余地;而以上的AM Suppression, Adjacent (Co/Alternative) Channel Suppression (Selectivity)這些指標,是"小信號干擾大信號",純RF的工作意義不大,還是靠物理層算法為主。

Single-tone Desense是CDMA系統獨有的指標,它有個特點:作為干擾信號的single-tone是帶內信號,而且距離有用信號很近。 這樣就有可能產生兩種信號落到接收頻域內:第一種是由于LO的近端相噪,LO與有用信號混頻形成的基帶信號、和LO相噪與干擾信號混頻形成的信號,都會落到接收機基帶濾波器的范圍之內,前者是有用的信號而后者是干擾; 第二種是由于接收機系統中的非線性,有用信號(有一定帶寬,譬如1.2288MHz的CDMA信號)可能與干擾信號在非線性器件上產生交調,而交調產物有可能同樣落在接收頻域之內成為干擾。

Single-tone desense的起源是北美在發起CDMA系統時,與原有的模擬通信系統AMPS采用了同一頻段,兩張網長期共存,作為后來者的CDMA系統必須考慮AMPS系統對自身的干擾。

到這里我想起當年被稱為"通則不動,動則不通"的小靈通,因為長期占用1900~1920MHz頻率,所以天朝TD-SCDMA/TD-LTE B39的實施一直是在B39的低段1880~1900MHz,直到小靈通退網為止。

教科書上對Blocking的解釋比較簡單:大信號進入接收機放大器使得放大器進入非線性區,實際增益變小(對有用信號的)。

但是這樣很難解釋兩種場景:

場景一:前級LNA線性增益18dB,當大信號灌入使其達到P1dB的時候,增益是17dB; 如果沒有引入其他影響(默認LNA的NF等都沒有發生變化),那么對整個系統的噪聲系數影響其實非常有限,無非是后級NF在計入到總NF時分母變小了一點,對整個系統的靈敏度影響不大。

場景二:前級LNA的IIP3很高因此沒有受影響,受影響的是第二級gain block(干擾信號使其達到P1dB附近),在這種情況下整個系統NF的影響就更小了。

我在這里拋磚引玉,提出一個觀點:Blocking的影響可能分兩部分,一部分是教科書上所講的Gain受到壓縮,另一部分實際上是放大器進入非線性區之后,有用信號在這個區域里發生了失真。這種失真可能包括兩部分,一部分是純粹的放大器非線性造成有用信號的頻譜再生(諧波分量),另一部分是大信號調制小信號的Cross Modulation。(可以理解)

由此我們還提出另一個設想:如果我們要簡化Blocking測試(3GPP要求是掃頻,非常費時間),也許可以選取某些頻點,這些頻點出現Blocking信號時對有用信號的失真影響最大。

從直觀上看,這些頻點可能有:f0/N和f0*N(f0是有用信號頻率,N是自然數)。前者是因為大信號在非線性區自身產生的N次諧波分量正好疊加在有用信號頻率f0上形成直接干擾,后者是疊加在有用信號f0的N次諧波上進而影響到輸出信號f0的時域波形——解釋一下:根據帕塞瓦爾定律,時域信號的波形實際上是頻域基頻信號與各次諧波的總和,當頻域上N次諧波的功率發生變化時,時域上對應的變化就是時域信號的包絡變化(發生了失真)。

9、動態范圍,溫度補償與功率控制

動態范圍,溫度補償和功率控制很多情況下是"看不到"的指標,只有在進行某些極限測試的時候才會表現出它們的影響,但是本身它們卻體現著RF設計中最精巧的部分。

9.1、發射機動態范圍

發射機動態范圍表征的是發射機"不損害其他發射指標前提下"的最大發射功率和最小發射功率。

"不損害其他發射指標"顯得很寬泛,如果看主要影響,可以理解為:最大發射功率下不損害發射機線性度,最小發射功率下保持輸出信號信噪比。

最大發射功率下,發射機輸出往往逼近各級有源器件(尤其末級放大器)的非線性區,由此經常發生的非線性表現有頻譜泄漏和再生(ACLR/ACPR/SEM),調制誤差(PhaseError/EVM)。此時最遭殃的基本上都是發射機線性度,這一部分應該比較好理解。

最小發射功率下,發射機輸出的有用信號則是逼近發射機噪聲底,甚至有被"淹沒"在發射機噪聲中的危險。 此時需要保障的是輸出信號的信噪比(SNR),換句話說就是在最小發射功率下的發射機噪聲底越低越好。

在實驗室曾經發生過一件事情:有工程師在測試ACLR的時候,發現功率降低ACLR反而更差(正常理解是ACLR應該隨著輸出功率降低而改善),當時第一反應是儀表出問題了,但是換一臺儀表測試結果依然如此。 我們給出的指導意見是測試低輸出功率下的EVM,發現EVM性能很差; 我們判斷可能是RF鏈路入口處的噪聲底就很高,對應的SNR顯然很差,ACLR的主要成分已經不是放大器的頻譜再生、而是通過放大器鏈路被放大的基帶噪聲。

9.2、接收機動態范圍

接收機動態范圍其實與之前我們講過的兩個指標有關,第一個是參考靈敏度,第二個是接收機IIP3(在講干擾指標的時候多次提到)。

參考靈敏度實際上表征的就是接收機能夠識別的最小信號強度,這里不再贅述。 我們主要談一下接收機的最大接收電平。

最大接收電平是指接收機在不發生失真情況下能夠接收的最大信號。 這種失真可能發生在接收機的任何一級,從前級LNA到接收機ADC。 對于前級LNA,我們唯一可做的就是盡量提高IIP3,使其可以承受更高的輸入功率; 對于后面逐級器件,接收機則采用了AGC(自動增益控制)來確保有用信號落在器件的輸入動態范圍之內。 簡單的說就是有一個負反饋環路:檢測接收信號強度(過低/過高)-調整放大器增益(調高/調低)-放大器輸出信號確保落在下一級器件的輸入動態范圍之內。

這里我們講一個例外:多數手機接收機的前級LNA本身就帶有AGC功能,如果你仔細研究它們的datasheet,會發現前級LNA會提供幾個可變增益段,每個增益段有其對應的噪聲系數,一般來講增益越高、噪聲系數越低。 這是一種簡化的設計,其設計思想在于:接收機RF鏈路的目標是將輸入到接收機ADC的有用信號保持在動態范圍之內,且保持SNR高于解調門限(并不苛求SNR越高越好,而是"夠用就行",這是一種很聰明的做法)。 因此當輸入信號很大時,前級LNA降低增益、損失NF、同時提高IIP3; 當輸入信號小時,前級LNA提高增益、減小NF、同時降低IIP3。

9.3、溫度補償

一般來講,我們只在發射機作溫度補償。

當然,接收機性能也是受到溫度影響的:高溫下接收機鏈路增益降低,NF增高; 低溫下接收機鏈路增益提高,NF降低。 但是由于接收機的小信號特性,無論增益還是NF的影響都在系統冗余范圍之內。

對于發射機溫度補償,也可以細分為兩部分:一部分是對發射信號功率準確度的補償,另一部分是對發射機增益隨溫度變化進行補償。

現代通信系統發射機一般都進行閉環功控(除了略為"古老"的GSM系統和Bluetooth系統),因此經過生產程序校準的發射機,其功率準確度事實上取決于功控環路的準確度。 一般來講功控環路是小信號環路,且溫度穩定性很高,所以對其進行溫度補償的需求并不高,除非功控環路上有溫度敏感器件(譬如放大器)。

對發射機增益進行溫度補償則更加常見。 這種溫度補償常見的有兩種目的:一種是"看得見的",通常對沒有閉環功控的系統(如前述GSM和Bluetooth),這類系統通常對輸出功率精確度要求不高,所以系統可以應用溫度補償曲線(函數)來使RF鏈路增益保持在一個區間之內,這樣當基帶IQ功率固定而溫度發生變化時,系統輸出的RF功率也能保持在一定范圍之內; 另一種是"看不見的",通常是在有閉環功控的系統中,雖然天線口的RF輸出功率是由閉環功控精確控制的,但是我們需要保持DAC輸出信號在一定范圍內(最常見的例子是基站發射系統數字預失真(DPD)的需要),那么我們就需要將整個RF鏈路的增益比較精確的控制在某個值左右——溫補的目的就在于此。

發射機溫補的手段一般有可變衰減器或者可變放大器:早期精度稍低以及低成本精度要求較低的情況下,溫補衰減器比較常見; 對精度要求更高的情形下,解決方案一般是:溫度傳感器+數控衰減器/放大器+生產校準。

9.4 發射機功率控制

講完動態范圍和溫度補償,我們來講一個相關的、而且非常重要的概念:功率控制。

發射機功控是大多數通信系統中必需的功能,在3GPP中常見的諸如ILPC、OLPC、CLPC,在RF設計中都是必需被測試、經常出問題、原因很復雜的。 我們首先來講發射機功控的意義。

所有的發射機功控目的都包含兩點:功耗控制和干擾抑制。

我們首先說功耗控制:在移動通信中,鑒于兩端距離變化以及干擾電平高低不同,對發射機而言,只需要保持"足夠讓對方接收機準確解調"的信號強度即可; 過低則通信質量受損,過高則空耗功率毫無意義。 對于手機這樣以電池供電的終端更是如此,每一毫安電流都需錙銖必量。

干擾抑制則是更加高級的需求。在CDMA類系統中,由于不同用戶共享同一載頻(而以正交用戶碼得以區分),因此在到達接收機的信號中,任何一個用戶的信號對于其他用戶而言,都是覆蓋在同一頻率上的干擾,若各個用戶信號功率有高有高低,那么高功率用戶就會淹沒掉低功率用戶的信號;因此CDMA系統采取功率控制的方式,對于到達接收機的不同用戶的功率(我們稱之為空中接口功率,簡稱空口功率),發出功控指令給每個終端,最終使得每個用戶的空口功率一樣。這種功控有兩個特點:第一是功控精度非常高(干擾容限很低),第二是功控周期非常短(信道變化可能很快)。

在LTE系統中,上行功控也有干擾抑制的作用。因為LTE上行是SC-FDMA,多用戶也是共享載頻,彼此間也互為干擾,所以空口功率一致同樣也是必需的。

GSM系統也是有功控的,GSM中我們用"功率等級"來表征功控步長,每個等級1dB,可見GSM功率控制是相對粗糙的。

干擾受限系統

這里提一個相關的概念:干擾受限系統。CDMA系統是一個典型的干擾受限系統。從理論上講,如果每個用戶碼都完全正交、可以通過交織、解交織完全區分開來,那么實際上CDMA系統的容量可以是無限的,因為它完全可以在有限的頻率資源上用一層層擴展的用戶碼區分無窮多的用戶。但是實際上由于用戶碼不可能完全正交,因此在多用戶信號解調時不可避免的引入噪聲,用戶越多噪聲越高,直到噪聲超過解調門限。

換而言之,CDMA系統的容量受限于干擾(噪聲)。

GSM系統不是一個干擾受限系統,它是一個時域和頻域受限的系統,它的容量受限于頻率(200kHz一個載頻)和時域資源(每個載頻上可共享8個TDMA用戶)。所以GSM系統的功控要求不高(步長較粗糙,周期較長)。

9.5 發射機功率控制與發射機RF指標

講完發射機功控,我們進而討論一下在RF設計中可能影響發射機功控的因素(相信很多同行都遇到過閉環功控測試不過的郁悶場景)。

對于RF而言,如果功率檢測(反饋)環路設計無誤,那么我們對發射機閉環功控能做的事情并不多(絕大多數工作都是由物理層協議算法完成的),最主要的就是發射機帶內平坦度。

因為發射機校準事實上只會在有限的幾個頻點上進行,尤其在生產測試中,做的頻點越少越好。 但是實際工作場景中,發射機是完全可能在頻段內任一載波工作的。 在典型的生產校準中,我們會對發射機的高中低頻點進行校準,意味著高中低頻點的發射功率是準確的,所以閉環功控在進行過校準的頻點上也是無誤的。 然而,如果發射機發射功率在整個頻段內不平坦,某些頻點的發射功率與校準頻點偏差較大,因此以校準頻點為參考的閉環功控在這些頻點上也會發生較大誤差乃至出錯。

以下是另一篇文章里提及的解釋,一并分享給大家!

我們常見的射頻指標很多,很多參數由于業內人士經常使用,經常用簡稱,但對普通電子愛好者來說就顯得有些晦澀,甚至有些專有名詞網上去查來查去依然是云里霧里,不知所云。

首先,我們了解下,什么是射頻信號。 射頻,Radio Frequency,簡稱RF。 那么什么樣的信號叫做射頻信號呢? 首先射頻信號指的是模擬信號,而不是數字信號。 也就是說數字信號頻率再高也不能叫射頻信號。 數字信號的傳輸速度單位是bps(bits per second,比特每秒),Mbps(Mega bits per second,兆比特每秒),Gbps(Giga bits per second,吉比特每秒),而模擬信號或者說交流信號的頻率單位為Hz、MHz、GHz。 我們假設射頻信號頻率下限為10MHz,數字信號可以分為低速數字信號和高速數字信號。

低速數字信號:射頻?

高速數字信號:射頻≥

這樣低速數字信號就可以定義為R<10Mbps,高速數字信號定義為R≥10Mbps。

由此,我們定義頻率高于10MHz的交流信號為射頻信號;

遠小于10Mbps的數字信號為低速數字信號;

大于等于10Mbps的數字信號為高速數字信號。

1、Rx Sensitivity(接收靈敏度)

接收靈敏度,應該是射頻領域中最基本的概念之一,是表示接收機能夠在不超過一定誤碼率的情況下識別的最低信號強度。這里說誤碼率,是沿用GSM和WCDMA CS(Circuit Switched,電路域交換)時代的定義作一個通稱。在多數情況下,BER (Bit Error Rate,誤比特率)或PER (Packet Error Rate,誤包率)用來考察靈敏度。而LTE用Throughput(吞吐量)來表征靈敏度,用吞吐量不低于95%的最小信號表征LTE的靈敏度。

先來看下靈敏度的計算公式:

靈敏度 = 10log10(KT0) + 10log10(BW)+NF+CNRmin

其中10log10(KT0)表示的是室溫25℃的底噪-174dBm,在絕對零度-273℃時我們認為電子是不運動的,這個時候的底噪是-174dBm,室溫下電子有活動了,但底噪增加的非常有限,為了計算方便,室溫下的底噪還記做-174dBm。

BW:Band Width,帶寬;

NF:Noise Figure,系統的噪聲系數,一般指第一個低噪放的噪聲系數;

CNRmin:Minimum Carrier Noise Ratio Allowed,系統解調所允許的最小載波噪聲比;

以LTE 20MHz業務為例,講解下LTE靈敏度的由來。

靈敏度(LTE) = 10log10(KT0) + 10log10(BW)+NF+CNRmin

= -174dbm + 10log10(18*10^6)+ 6db + (-1)dB

= -174dBm+72.55+6dB+(-1)dB

=-96.45dBm

BW = 18MHz for LTE 20MHz(100 RB = 100*180kHz = 18MHz)

NF = 6db(這里的NF對系統來說就是第一級LNA之前的插損加上該LNA自身的噪聲系數NF)

CNRmin : -1db

2、SNR(信噪比)

第一部分講靈敏度的時候我們多次提到過SNR,SNR就是信噪比,我們把接收機的解調信噪比定義為不超過一定誤碼率的情況下解調器能夠解調的最低信噪比門限,S即信號Signal,或者稱為有用信號;N即噪聲Noise,泛指一切非有用信號的信號。有用信號是通信系統的發射機發射出來,對手機來說就是基站的發射機發出來并且通過PA放大的;而噪聲的來源則是非常廣泛的,最典型的就是那個著名的-174dBm/Hz——自然噪聲底,要記住它是一個與通信系統類型無關的量,從某種意義上講是從熱力學推算出來的(所以它跟溫度有關);另外要注意的是它實際上是個噪聲功率密度(所以有dBm/Hz這個量綱),我們接收多大帶寬的信號,就會接受多大帶寬的噪聲——所以最終的噪聲功率是用噪聲功率密度對帶寬積分得來。

3、Tx Power(發射功率)

發射功率的重要性,在于發射機的信號需要經過空間的衰落之后才能到達接收機,那么越高的發射功率意味著越遠的通信距離。那么自由空間的損耗大約是個什么數值呢?

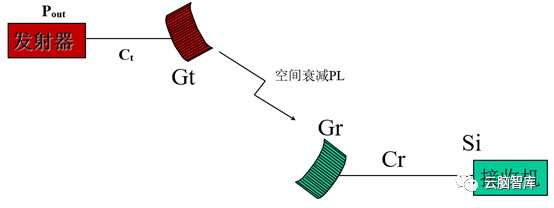

基站下行鏈路預算計算

接收器的信號接收強度為 :Si = Pout - Ct + Gt - PL + Gr – Cr,其中Pout表示基站發射的功率,Ct基站發射信號的鏈路損耗,Gt表示發射天線增益,PL表示空間損耗,Gr表示接收天線增益,Cr表示接收信號的鏈路損耗,Si表示接收機收到的信號。

自由空間損耗,指的是電磁波在空氣中傳播時候的能量損耗,電磁波在穿透任何介質的時候都會有損耗。自由空間損耗公式:空間損耗PL=20log(F)+20log(D)+32.4;F為頻率,單位為MHz;D為距離,單位為Km。

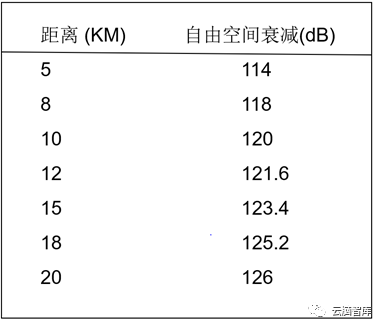

由PL=20log(F)+20log(D)+32.4,算出來:

在2.4 GHz : 空間損耗PL=32.4+20log(2400)+20logD[km]=100 +20logD[km]

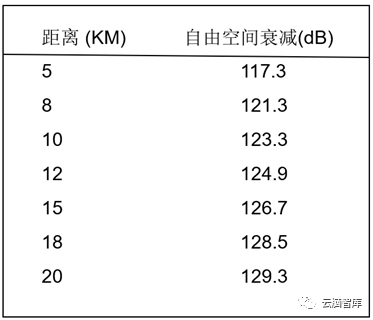

在3.5 GHz : 空間損耗PL=32.4+20log(3500)+20logD[km]=103.3 +20logD[km]

在5.8. GHz : 空間損耗PL=32.4+20log(5800)+20logD[km]=107.7 + 20 Log D[km]

2.4GHz信號的自由空間衰減值

3.5GHz信號的自由空間衰減值

LTE基站的普遍功率為40W,46dBm,假設基站部署的頻率是2.4GHz,那么20公里外的信號大小只有46-126=-80dBm,依然足夠手機使用;但如果是5G基站,部署在n78頻段,頻率是3.5GHz,那20公里以外的信號大小是多少呢?46-129.3=-83.3dBm,如果要保持和LTE基站同樣的覆蓋率,相應的功率就要提高3.3dB,差不多是加大一倍。

因此功率對于基站提高網絡覆蓋率是非常重要的,同理,保證手機端的上行功率對提高上行網絡接入能力也有重要意義。

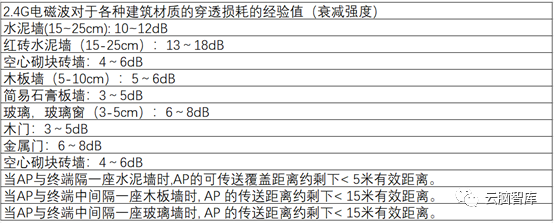

附常見的介質的衰減值參考表:

常見的介質的衰減值參考表

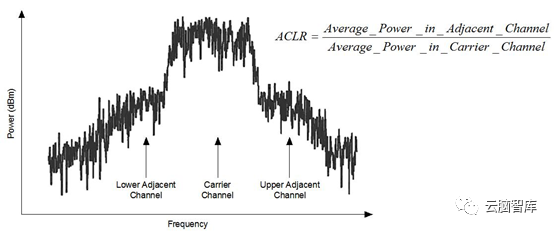

4、ACLR/ACPR

我們把這些項目放在一起,是因為它們表征的實際上是“發射機噪聲”的一部分,只是這些噪聲不是在發射信道之內,而是發射機泄漏到臨近信道中去的部分,可以統稱為“鄰道泄漏”。其中ACLR和ACPR(其實是一個東西,不過一個是在終端測試中的叫法,一個是在基站測試中的叫法罷了,終端中的CDMA指標中也叫ACPR),都是以“Adjacent Channel”命名,顧名思義,都是描述本機對本系統本頻段其他設備的干擾。而且它們有個共同點,對干擾信號的功率計算也是以一個信道帶寬為計。這種計量方法表明,這一指標的設計目的,是考量發射機泄漏的信號,對相同或相似制式的設備接收機的干擾——干擾信號以同頻同帶寬的模式落到接收機帶內,形成對接收機接收信號的同頻干擾。

ACLR的定義

在LTE中,ACLR的測試有兩種設置,EUTRA和UTRA,前者是描述LTE系統對LTE系統的干擾,后者是考慮LTE系統對UMTS(實際上就是WCDMA和TD-SCDMA)系統的干擾。所以我們可以看到EUTRA ACLR的測量帶寬是LTE RB的占用帶寬,如果不好區分,看到E就是LTE。UTRA ACLR的測量帶寬是UMTS信號的占用帶寬(FDD系統3.84MHz,TDD系統1.28MHz)。換句話說,ACLR/ACPR描述的是一種“對等的”干擾:發射信號的泄漏對同樣或者類似的通信系統發生的干擾。實際網絡中同小區鄰小區、附近小區經常會有信號泄漏過來,所以網規網優的過程實際上就是容量最大化和干擾最小化的過程,而系統本身的鄰道泄漏對于鄰近小區就是典型的干擾信號;基站的不同信道或者基站與基站之間有干擾,同樣的,在手機端,也會互相干擾。在通信系統的演化中,從運營商的投資角度來說,從來都是“平滑過渡”的,2G-->3G-->4G-->5G,即使現在都到5G時代了,2G的GSM依然在運營,LTE引入UTRA即是考慮了LTE在與UMTS共存的情形下對前代系統的射頻干擾。B1頻段有WCDMA,有LTE,未來也有5G,因此5G系統同樣也要考慮5G對自身系統相鄰信道和LTE和UMTS的影響;

LTE系統測試的UTRA和E-UTRA ACLR

在分享一篇通俗易懂的解釋:

甲乙兩人在一起交談,乙說:“你沒有說清楚!”甲說:“你怎么聽不明白呢?”其實本來說是一回事,聽是另一回事;但說得特別清晰可以彌補聽力的不足,同樣,聽的能力特別強,也可以降低對說話清晰度的要求。

那么怎樣衡量無線通信系統“說、聽”的能力呢?這里介紹一組收發相關的射頻指標。

說,就相當于無線通信系統的“發射”,說話的時候盡量只對著與你交流的人講, 不要影響不相關的人,也就是說“不該說的盡量不說”;從發射的角度看,盡量發射信道帶寬范鬧內的信分,不要發射到別的信道上或者別的系統使用的頻段上,否則會干擾其他信號。

衡量發射機帶內輻射能力、帶外抑制能力的主要指標就是鄰道泄漏比和雜散輻射。

聽,就相當于無線通信系統的“接收”,聽話的時候盡量只聽與你交流的人說話,不要聽和你不相關的人講話,否則會分散你的注意力,影響你的聽話效果,也就是說“不該聽的盡量不聽”;從接收機的角度看,盡量接收信道帶寬范圍內的信號,不要接收其他頻率的信號,否則會影響接收效果。

衡量接收機帶內接收能力、帶外響應抑制能力的主耍指標就是接收靈敏度和雜散響應。

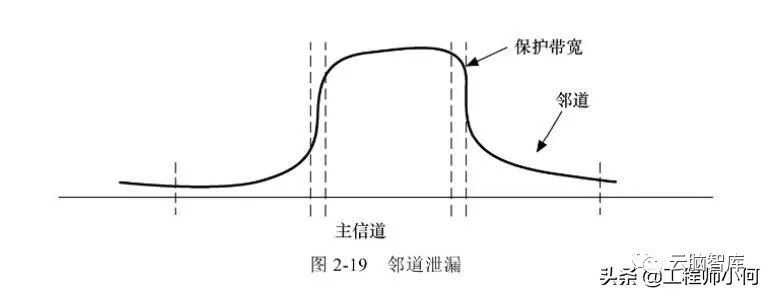

1、鄰道泄露比

(現象類比)讀小學的時候,由于教室緊張,一年級和二年級在一個教室上課,由一個老師來教。一年級學生讀課文出錯,二年級的就嘩然大笑(鄰道泄漏);

二年級的被老師批評,一年級的就起哄(鄰道泄漏)。一、二年級互相影響得非常厲害。為了減少一、二年級的互相影響,老師在他們中間加了一個 隔板(增加了保護帶寬),這樣相互影響就降低了很多。但看不著,有時候卻能聽得著,最后老師索性把隔板換成隔墻(隔離度又增加了),這樣影響就降到了最低。

鄰道泄漏是用來衡量射頻器件對主工作頻率外的信道的影響特性,或稱帶外輻射特性,就像一年級學生的嘈雜聲可能會影響到二年級一樣。當然這種影響越小越好。

鄰道泄漏比(ACLR)就是泄漏在鄰逬的功率與主信道功率之比,通常用dBc表示,如閣2-19 所示。

鄰道泄漏越小越好,鄰道泄漏比的絕對值就應該越大越好。其值越大,表明主信道功率比池漏在鄰道的功率大得越多,說明對鄰道的影響越小。

WCDMA的要求是:笫一鄰道(偏離載頻±5MHz)的ACLR達到45dBc ;笫二鄰道(偏離載頻±10MHz)的ACLR達到50dBc。

2、雜散輻射

(現象類比)我們的生活小區旁邊有一個工地,徹夜燈火明亮。安裝探照燈(工作帶寬范圍內的輻射)的主要目的是為了便于巡查,從而避免工地的各種物資丟失。可是探照燈太亮了,輻射到了我們小區(雜散輻射),影響了我們小區很多人的休息(雜散輻射必然帶來干擾)。

射頻發信機本應該在規定的頻率范圍內發送無線信號,即發射帶內信號號; 正如探照燈應該主要照射工地范圍一樣。 由于射頻發信機的內部元器件并非理想器件,存在或多或少的非線性,在發射無線信號的過程中,產生了很多非規定頻率范圍內的信號,即發生了雜散輻射,就像探照燈照到了旁邊的生活小區。

射頻發倍機發射了非自己頻率范圍的信號,就可能對其他通信系統造成干擾,就像工地的探照燈影響了旁邊小區居民休息一樣。

雜散輻射可能是一些非線性元器件產牛的諧波分量、交調信號等。 為了防止一個系統的雜散輻射對其他無線通信系統造成干擾,需要提高系統的電磁兼容性能。 在協議中都會規定這個系統的不同帶外頻率范圍的最大雜散輻射水平,規定的形式一般都楚在一個頻率范圍內單位帶寬最大允許的雜散輻射是多少dBm;

如協議上規定,WCDMA的發射機在150kHz?30MHz范圍內每10kHz帶寬的雜散輻射不能超過-36dBm。

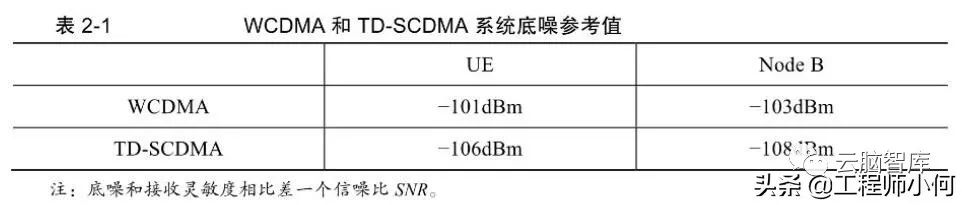

3、底噪

系統底噪Pn,就是一個小區空閑時的噪聲功率。 任何用電設備都存在噪聲,這個噪聲主要來源是熱噪聲,其大小和開氏溫度、帶寬、設備的噪聲系數有關。 系統底噪的公式為:

Pn= 10lg(KTB) + NF = 10lg(KT) + 10lg(B) + NF = n0 + 10lg(B) + NF

其中:NF為接收機的噪盧系數; K為波爾茲曼常數; T為絕對溫度; B為信號帶寬。

前而講過,常溫下噪聲的功率譜密度n0是-174dBm/Hz,在WCDMA中帶寬是 3.84MHz,而在TD-SCDMA中帶寬B是1.28MHz。 噪聲系數NF基站一般取5dB,手機取7dB。 WCDMA和TD-SCDMA系統底噪參考值如表2-1所示。

4、接收靈敏度

(邏輯類比)豬八戒問孫悟空:“猴哥,我對高小姐那么好,卻怎么越來越難讓她高興了? ”

孫悟空說:“你對她的好估計沒有達到她愛的接收靈敏度。 ”

豬八戒問:“什么叫愛的接收靈敏度? ”

孫悟空說道:“愛的接收靈敏度就是高小姐能夠感覺到高興的最小要求。 ”

豬八戒問:“這個靈敏度和什么有關系呢? ”

孫悟空說道:“和3個方面有關系。第一:基本生活保障(熱噪聲,最起碼的要求),比如說一天20元;

第二:環境系數(噪聲系數),就是高小姐周圍女人的費用高于基本生活保障的倍數,比如說3倍;

第三就是高小姐最小幸福感倍數(信噪比要求),即高小姐感覺幸福要求最少應該比別人多得到的倍數,比如說2倍。”如圖2-20所示。

豬八戒悟道:“也就是說高小姐愛的接收靈敏度應該這樣計算:

高小姐愛的月接收靈敏度=基本保障 / 天 x 天數 x 環境系數 x 高小姐幸福感系數=20 x 30 x 3 x 2=3600元。這是高小姐的最低要求。”

孫悟空道:“如果換成對數關系,即用dB表示,就可以變成相加的關系, 即10lg (高 小姐愛的月接收靈敏度)=10lg (基本保障 /天 x 天數)+10lg (環境 系數)+10lg (高小姐幸福感系數)。”

接收靈敏度就是接收機能夠止確地把有用信號拿出來的最小信號接收功率。它和3個因素奮關系,即帶寬范圍內的熱噪聲、系統的噪聲系數、系統把有用信號拿出所需要的最小信噪比。帶寬范圍內的熱噪聲經過接收機,這些噪聲被放大了NF倍,要想把有用信號從噪聲中拿出來,就必須要求有用信號比噪聲再大SNR倍。即:

S = 10lg(KTB) + NF + SNR = Pn + SNR (2-3)

其中:S為接收靈敏度,單位是dBm ;

K為波爾茲曼常數,單位是J/K; T為絕對溫度,單位是K;

KT就是在當前溫度下每Hz的熱噪聲功率(類似于高小姐每天的基本保障);

B表示信號帶寬,單位足Hz (類似于高小姐基本保障的計算周期為一個月);

KTB代表帶寬范圍內的熱噪聲功率(類似于高小姐一個月的基本保障);

NF表示系統的噪聲系數, 單位是dB (類似于環境系數);

SNR表示解調所需信噪比,單位是dB (類似于高小姐的幸福感倍數);

Pn表小系統底噪,單位是dBm。

從式(2-3)可以看出,要想讓接收機“聽清楚”發射機“說的話”,信號電f強度一定要大于接收機的接收靈敏度S。當然接收靈敏度S越小,說明接收機的接收性能越好, 就像狗能聽到人類聽不到的微小聲音,說明狗的聽覺比人的靈敏度尚;接收靈敏度越大, 說明接收機的接收性能越差,就像有的老人耳聾,你需要用很大的聲咅說話,他才能聽到。

環境溫度升靈敏度S就會變化,接收性能就會惡化,因此要盡最降低系統所在環境的溫度。

帶寬越大,系統的噪聲系數越大,靈敏度S就會越大,接收性能也會惡化,這就要求在設計接收機的時候,要考慮到系統的帶寬、噪聲系數對靈敏度S的影響。

解調所需的最小信噪比越小越好,這樣可以增加系統的接收性能。最小信噪比要求和移動臺的速度、所處的無線環境及所耍求的通信質量有關,不同無線制式耍求不同, 同一無線線制式的不同業務也不相同。

5、雜散響應

(現象類比)道德法庭審判潘金蓮:“你為什么背叛自己的丈夫,走向萬劫不復?”(對雜散信號做出響應)

潘金蓮委屈地說:“奴家覺得西門大官人大帥了,太有財了!我無力抗拒。” (雜散信號很強)

道德法庭繼續批判說:“社會上的誘惑那么多,你都無法抗拒么?”(難道 你對雜散信號總要響應么)

潘金蓮仍然很委屈地說:“自從結婚后,我對武大給我的一切越來越沒有感覺,接收靈敏度越來越差,沒有任何幸福感,反而對外面的帥哥比較感興趣。” (確實存在雜散響應)

道德法庭總結道:“也就是說一方面是外面的誘惑太大(雜散信號強),另 一方面是由于你本身的抗誘惑能力很差(存在雜散響應)。”如圖2-21所示。

雜散響應也稱寄生響應,就是在接收機中產生的,和接收到的有用信號頻率相近的、 系統無法濾除的干擾信號。無線環境中存在很多干擾信號,人多數可以通過接收機的濾波器過濾掉,但有的接收機的抗雜散響應能力差,系統的后級濾波器是無法濾掉接收機本身產生的雜散響應的,就像潘金蓮尤法抵抗西門慶的雜散誘惑,自己產生了雜散響應一樣。

從系統接收的角度看,系統工作的頻率范圍內沒有什么干擾,似由于環境的帶外干擾太大,且本身的抗雜散響應能力弱,就會引起系統接收性能變差。

6、什么是駐波、行波、行駐波?

(現象類比)什么叫行軍?行軍就是行動的軍隊、不斷向前的軍隊(類似行波)。從行軍道路的任一處看,通過的部隊人數不為零。行動的軍隊突然碰上了一條河,長官命令原地踏步。雖然每個戰士都在自己的位置上踏步。但是從道路的某一處看,沒有人通過。我們把不再前進的軍隊稱為駐軍(類似駐波)。長官發現不遠處有一個獨木橋,于是命令2個人原路返回向上級匯報地形,其他人走向獨木橋,這時有人返回,有人繼續前進,但前進的人數明顯多 于返回的人數(類似行駐波)。

什么是行波?

行波就是行動的無線電波。無線電波在空氣或者射頻器件中傳播時其,波形不斷向前推進,其能量隨波的傳播而不斷向前傳遞,傳播介質的任何一處,通過的平均能量不為零,就像不斷前行的隊伍一樣。

駐波是駐波?

駐波就是不再繼續推進的無線電波,雖然電波上的任何一點都在上下震動,但波形沒有傳播出去,就像原地踏步的隊伍不再前進一樣。兩列波(如入射波與反射波)振幅和頻率相同、傳播方向相反,疊加后波形不向前推進,就足駐波。

無線電波的駐波大家不易看到,似海岸峭壁前經常可以看到水的駐波。前進的水波由于受到峭壁的限制,產生了反射水波,前進水波和反射水波疊加形成了水的駐波。水而作周期性升降,但并不向前傳播。

傳輸線在阻抗不匹配的情況下,同時存在入射波和反射波,就像有前進、有返回的隊伍一樣。反射波的振幅小于入射波,入射波和反射波相疊加,形成的合成波叫行駐波。

使用射頻傳輸線傳送無線電波的時候,我們需要盡可能多的電波能量傳送出去,盡量少的能量停留在傳輸線上,以免造成過多的損耗。那么我們希望射頻傳輸線里的無線電波最好是行波。但實際工程中,不會有這么理想的情況,射頻傳輸線里的無線電波一 般都是接近行波的行駐波。駐波比、回波損耗等概念都是用來描述行駐波向前傳送能量和往回反射能量多少的指標。下面分別介紹。

7、什么是駐波比、回波損耗?

(現象類比)軍隊的運輸線是用來傳送后勤補給的路線。如果后勤補給距離很近,在同一個村子里,可以很容易把補給送達目的地,不會有什么損耗(傳輸線很短時,認為是導線,沒有損耗)。但一般路線會很長,可能有各種各樣的影響,比如干旱導致蔬菜水分蒸發、下雨導致糧食發霉等(當傳輸線遠遠大于其波長時,就不能認為沒有損耗了)。

射頻傳輸線是用來傳輸無線電波能量的導線,是射頻器件之間的連接器。天線和基站機頂門之間的士:要傳輸線,稱為饋線(Feeder)。為了匹配射頻器件(主要足基站和天線)的接入端口,連接在饋線和射頻器件端口之間幾米內的傳輸線,稱為跳線(Jumper)。

對比一下:電風扇的電源線長1m,居民用電的工作頻率是50Hz,波長就是 6000km。這根傳輸線相對于波長是非常短的,可以認為線上各點的電壓和電流是相同的,等效為電路中的一點,不需要考慮無線電波波動效應的影響,可以認為從電源到風扇是短路的。

但在無線通信中,使用的是超高頻,也就是說無線信號的波長很短,3G無線制式的波長約為0.15m,一般來說,傳輸線的長度比信號的波長大很多,線上各點的電壓和電流不再相間,所以射頻傳輸線也叫長線傳輸線。常見的射頻傳輸線有平行線、同軸線等。

選擇傳輸線的時候要關注兩個指標:衡量匹配程度的特性阻抗和衡量幅度衰減、相位偏移的傳播常數。下面會重點介紹。

8、什么是傳輸線的特性阻抗?

(現象類比)運輸線的糟糕路況(類似傳輸線里的特性阻抗)會影響運輸車隊的速度,路越窄,路的阻礙作用越大(特性阻抗大,通過的無線電波能量就小);路越寬、路況越好,通過的車隊速度越快(通過的無線電波能量越多)。假若一段路況特別好,另一段路況特別差,從路況好的路段進入差的路段,車隊就需要放慢速度。這就說明兩段路的路況不匹配(阻抗不匹配)。

特征阻抗是射頻傳輸線影響無線電波電壓、電流的幅值和相位變化的固有特性,等于各處的電壓與電流的比值,用Z0表示。在射頻電路中,電阻、電容、電感都會阻礙交變電流的流動,合稱阻抗。電阻是吸收電磁能量的,理想電容和電感不消耗電磁能量。阻抗合起來影響無線電波電壓、電流的幅值和相位。

同軸電纜的特性阻抗和導體內、外直徑大小及導休間介質的介電常數有關,而與工作頻率傳輸線所接的射頻器件以及傳輸線長短無關。也就是說,射頻傳輸線各處的電壓和電流的比值是一記的,特征阻抗是不 變的。

目前無線通信系統射頻器件有兩種特性阻抗,一種足50Ω,用于軍用微波、GSM、 WCDMA、LTE等系統;另一種足75Ω,用于有線電視系統,一般應用較少。

9、什么是阻抗匹配?

(匹配的類比)拳擊手在訓練的時候,使用的沙袋大重了,打起來很不舒適;而太輕了,又感覺沒有挑戰。只有沙袋重量適當,使用起來才感覺順手。

再舉一個例子,我的母親是個勤勞的裁縫,一次叫我給她遞一下剪刀,我 把父親常用的剪刀遞給她,她馬上說:“你爸的右手剪刀我用著不順手,我是左撇子,把旁邊那把左手剪刀遞給我。”我才意識到,這兩把剪刀外形一樣, 卻有左右手之分。手和剪刀不匹配,用得就不舒服。

傳輸線和射頻器件相連的時候,要求二者阻抗匹配。阻抗匹配就是在分界處只有入射波,沒有反射波;也就是傳輸線和射頻器件在無線電波傳送時如同沒有分界面一樣, 正如左手使用左手剪刀,雖然是兩個事物在一起,感覺上沒有任何不適。

那么,什么情況下,阻抗匹配呢?傳輸線所接射頻器件的阻抗Z1等于傳輸線的特性阻抗Z0時,就是阻抗匹配了。匹配時,能夠保證傳輸線的下一級射頻器件得到全部的信號功率,而沒有損失。

在選擇射頻器件的時候,一定要看各器件的特征阻抗是否匹配。衡量阻抗匹配程度的參數有反射系數、回波損耗、反射損耗、駐波比、行波系數,等等,它們之間有一定的關系,已知其中一個,能夠推出其他幾個。下面分別介紹。

10、什么是反射系數?

(計算類比)高小姐跟八戒說:“你每月掙的錢得交給我,我根據情況返給你生活費。 ”八戒第一個月交給高小姐2000元(入射波),高小姐返給八戒 ? 500元(反射波),75%都被高小姐留下了,返回比例是25%(類似于反射系數)。

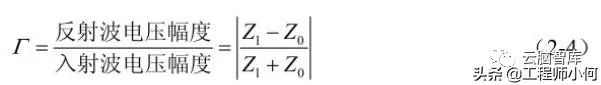

電壓反射系數就是指反射波電壓和入射波電壓幅度之比,記為廠。 經過推導,電壓反射系數的計算公式為:

當射頻器件和傳輸線阻抗匹配(即Z1=Z0時,廠=0,無線電波處于行波狀態, 沒有反射波;

在Z1=0或者Z1=∞的時候,廠=1,反射波和入射波電壓幅度完全相N, 屬于全反射,無線電波處于駐波狀態。

一般情況下,射頻器件的阻抗Z1介于上述兩種 條件之傳輸線上既有行波也有駐波,無線電波處于行駐波狀態,反射系數的范圍為 0?1。

在射頻器件安裝調試的時候,我們希望器件的連接處盡量沒有反射,即反射系數接 近0,這樣無線電波在器件的連接處就可以全部傳送過去,沒有反射損耗。

一、調制/開關頻譜

回到GSM全球移動通信系統,Modulation Spectrum(調制譜)和Switching Spectrum(切換譜/開關譜)也是扮演了鄰道泄漏比(ACLR)相似的角色;

不同的是它們的測量帶寬并不是GSM信號的占用帶寬;

從定義上看,可以認為調制譜是衡量同步系統之間的干擾,而切換譜是衡量非同步系統之間的干擾(事實上如果不對信號做gating,切換譜一定是會把調制譜淹沒掉的);

這就牽涉到另一個概念:GSM系統中,各小區之間是不同步的,雖然它用的是TDMA; 而相比之下,TD-SCDMA和之后的TD-LTE,小區之間是同步的(那個飛碟形狀或者球頭的GPS天線永遠是TDD系統擺脫不了的桎梏) ;

因為小區間不同步,所以A小區上升沿/下降沿的功率泄漏可能落到B小區的payload部分,所以我們用切換譜來衡量此狀態下發射機對鄰信道的干擾;

而在整個577us的GSM timeslot里,上升沿/下降沿的占比畢竟很少,多數時候兩個相鄰小區的payload部分會在時間上交疊,評估這種情況下發射機對鄰信道的干擾就可以參考調制譜;

二、SEM (Spectrum Emission Mask)

這是一個“帶內指標”,與spurious emission區分開來,后者在廣義上是包含了SEM的,但是著重看的其實是發射機工作頻段之外的頻譜泄漏,其引入也更多的是從EMC的角度;

SEM是提供一個“頻譜模版”,然后在測量發射機帶內頻譜泄漏的時候,看有沒有超出模版限值的點;

可以說它與ACLR有關系,但是又不相同;

ACLR是考慮泄漏到鄰近信道中的平均功率,所以它以信道帶寬為測量帶寬,它體現的是發射機在鄰近信道內的“噪聲底”;

SEM反映的是以較小的測量帶寬(往往100kHz到1MHz)捕捉在鄰近頻段內的超標點,體現的是“以噪聲底為基礎的雜散發射”;

如果用頻譜儀掃描SEM,可以看到鄰信道上的雜散點會普遍的高出ACLR均值,所以如果ACLR指標本身沒有余量,SEM就很容易超標;

反之SEM超標并不一定意味著ACLR不良,有一種常見的現象就是有LO的雜散或者某個時鐘與LO調制分量(往往帶寬很窄,類似點頻)串入發射機鏈路,這時候即便ACLR很好,SEM也可能超標。

三、EVM(誤差矢量)

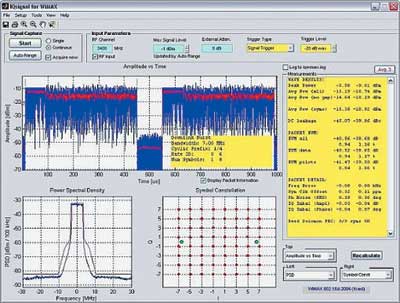

EVM是一個矢量值,也就是說它有幅度和角度,它衡量的是“實際信號與理想信號的誤差”,這個量度可以有效的表達發射信號的“質量”——實際信號的點距離理想信號越遠,誤差就越大,EVM的模值就越大;

四、為何發射信號的信噪比并不重要

第一是發射信號的SNR往往遠遠高于接收機解調所需要的SNR;

第二是我們計算接收靈敏度時參考的是接收機最惡劣的情況,即在經過大幅度空間衰落之后,發射機噪聲早已淹沒在自然噪聲底之下,而有用信號也被衰減到接收機的解調門限附近;

但是發射機的“固有信噪比”在某些情況下是需要被考慮的,譬如近距離無線通信,典型的如802.11系列;

802.11系列演進到802.11ac的時候,已經引入了256QAM的調制,對于接收機而言,即便不考慮空間衰落,光是解調這樣高階的正交調制信號就已經需要很高的信噪比,EVM越差,SNR就越差,解調難度就越高;

做802.11系統的工程師,往往用EVM來衡量Tx線性度;而做3GPP系統的工程師,則喜歡用ACLR/ACPR/Spectrum來衡量Tx線性性能。

從起源上講,3GPP是蜂窩通信的演進道路,從一開始就不得不關注鄰信道、隔信道(adjacent channel, alternative channel)的干擾。換句話說,干擾是影響蜂窩通信速率的第一大障礙,所以3GPP在演進的過程中,總是以“干擾最小化”為目標的:GSM時代的跳頻,UMTS時代的擴頻,LTE時代RB概念的引入,都是如此;

而802.11系統是固定無線接入的演進,它是秉承TCP/IP協議精神而來,以“盡最大能力的服務”為目標,802.11中經常會有時分或者跳頻的手段來實現多用戶共存,而布網則比較靈活(畢竟以局域網為主),信道寬度也靈活可變。總的來說它對干擾并不敏感(或者說容忍度比較高);

通俗的講,就是蜂窩通信的起源是打電話,打不通電話用戶會去電信局砸場子;802.11的起源是局域網,網絡不好大概率是先耐著性子等等(其實這時候設備是在作糾錯和重傳);

這就決定了3GPP系列必然以ACLR/ACPR一類“頻譜再生”性能為指標,而802.11系列則可以以犧牲速率來適應網絡環境;

具體說來,“以犧牲速率來適應網絡環境”,就是指的802.11系列中以不同的調制階數來應對傳播條件:當接收機發現信號差,就立即通知對面的發射機降低調制階數,反之亦然。前面提到過,802.11系統中SNR與EVM相關很大,很大程度上EVM降低可以提高SNR。這樣我們就有兩種途徑改善接收性能:一是降低調制階數,從而降低解調門限;二是降低發射機EVM,使得信號SNR提高;

因為EVM與接收機解調效果密切相關,所以802.11系統中以EVM來衡量發射機性能(類似的,3GPP定義的蜂窩系統中,ACPR/ACLR是主要影響網絡性能的指標);又因為發射機對EVM的惡化主要因為非線性引起(譬如PA的AM-AM失真),所以EVM通常作為衡量發射機線性性能的標志;

五、EVM與ACPR/ACLR的關系

很難定義EVM與ACPR/ACLR的定量關系,從放大器的非線性來看,EVM與ACPR/ACLR應該是正相關的:放大器的AM-AM、AM-PM失真會擴大EVM,同時也是ACPR/ACLR的主要來源;

但是EVM與ACPR/ACLR并不總是正相關,我們這里可以找到一個很典型的例子:數字中頻中常用的Clipping,即削峰。Clipping是削減發射信號的峰均比(PAR),峰值功率降低有助于降低通過PA之后的ACPR/ACLR;

但是Clipping同時會損害EVM,因為無論是限幅(加窗)還是用濾波器方法,都會對信號波形產生損傷,因而增大EVM;

審核編輯:湯梓紅

-

射頻

+關注

關注

104文章

5575瀏覽量

167700 -

接收機

+關注

關注

8文章

1180瀏覽量

53458 -

信噪比

+關注

關注

3文章

260瀏覽量

28624 -

發射機

+關注

關注

7文章

505瀏覽量

48009 -

信號

+關注

關注

11文章

2790瀏覽量

76734

原文標題:常見射頻指標參數詳解

文章出處:【微信號:射頻問問,微信公眾號:射頻問問】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

射頻PA常見指標和測試方法

手機的射頻指標測量

常見射頻指標參數口訣

移動WiMax參數指標及射頻測試淺析

WiMax參數指標及射頻測試

射頻指標和要求

射頻PA常見指標和測試方法

常見射頻指標參數詳解

常見射頻指標參數詳解

評論