Meta 新的開源模型 ImageBind 將多個數(shù)據(jù)流連接在一起,適用于文本、視頻和音頻等 6 種模態(tài)。

在人類的感官中,一張圖片可以將很多體驗融合到一起,比如一張海灘圖片可以讓我們想起海浪的聲音、沙子的質(zhì)地、拂面而來的微風(fēng),甚至可以激發(fā)創(chuàng)作一首詩的靈感。圖像的這種「綁定」(binding)屬性通過與自身相關(guān)的任何感官體驗對齊,為學(xué)習(xí)視覺特征提供了大量監(jiān)督來源。

理想情況下,對于單個聯(lián)合嵌入空間,視覺特征應(yīng)該通過對齊所有感官來學(xué)習(xí)。然而這需要通過同一組圖像來獲取所有感官類型和組合的配對數(shù)據(jù),顯然不可行。

最近,很多方法學(xué)習(xí)與文本、音頻等對齊的圖像特征。這些方法使用單對模態(tài)或者最多幾種視覺模態(tài)。最終嵌入僅限于用于訓(xùn)練的模態(tài)對。因此,視頻 - 音頻嵌入無法直接用于圖像 - 文本任務(wù),反之亦然。學(xué)習(xí)真正的聯(lián)合嵌入面臨的一個主要障礙是缺乏所有模態(tài)融合在一起的大量多模態(tài)數(shù)據(jù)。

今日,Meta AI 提出了 ImageBind,它通過利用多種類型的圖像配對數(shù)據(jù)來學(xué)習(xí)單個共享表示空間。該研究不需要所有模態(tài)相互同時出現(xiàn)的數(shù)據(jù)集,相反利用到了圖像的綁定屬性,只要將每個模態(tài)的嵌入與圖像嵌入對齊,就會實現(xiàn)所有模態(tài)的迅速對齊。Meta AI 還公布了相應(yīng)代碼。

主頁:https://imagebind.metademolab.com/

論文地址:https://dl.fbaipublicfiles.com/imagebind/imagebind_final.pdf

GitHub 地址:https://github.com/facebookresearch/ImageBind

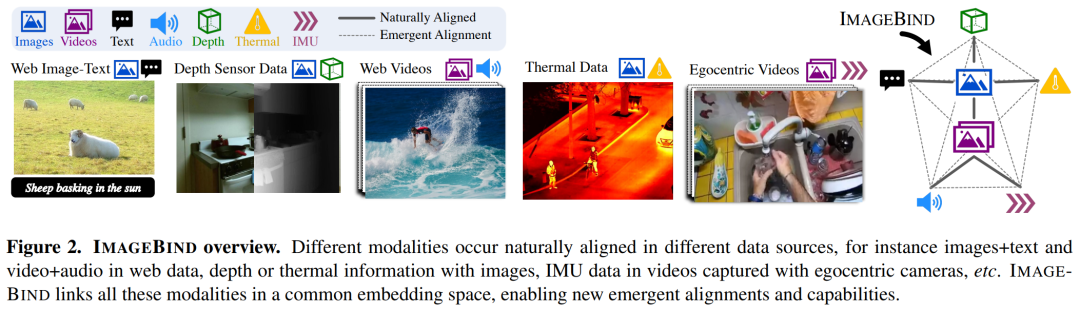

具體而言,ImageBind 利用網(wǎng)絡(luò)規(guī)模(圖像、文本)匹配數(shù)據(jù),并將其與自然存在的配對數(shù)據(jù)(視頻、音頻、圖像、深度)相結(jié)合,以學(xué)習(xí)單個聯(lián)合嵌入空間。這樣做使得 ImageBind 隱式地將文本嵌入與其他模態(tài)(如音頻、深度等)對齊,從而在沒有顯式語義或文本配對的情況下,能在這些模態(tài)上實現(xiàn)零樣本識別功能。

下圖 2 為 ImageBind 的整體概覽。

與此同時,研究者表示 ImageBind 可以使用大規(guī)模視覺語言模型(如 CLIP)進行初始化,從而利用這些模型的豐富圖像和文本表示。因此,ImageBind 只需要很少的訓(xùn)練就可以應(yīng)用于各種不同的模態(tài)和任務(wù)。

ImageBind 是 Meta 致力于創(chuàng)建多模態(tài) AI 系統(tǒng)的一部分,從而實現(xiàn)從所有相關(guān)類型數(shù)據(jù)中學(xué)習(xí)。隨著模態(tài)數(shù)量的增加,ImageBind 為研究人員打開了嘗試開發(fā)全新整體性系統(tǒng)的閘門,例如結(jié)合 3D 和 IMU 傳感器來設(shè)計或體驗身臨其境的虛擬世界。此外它還可以提供一種探索記憶的豐富方式,即組合使用文本、視頻和圖像來搜索圖像、視頻、音頻文件或文本信息。

綁定內(nèi)容和圖像,學(xué)習(xí)單個嵌入空間

人類有能力通過很少的樣本學(xué)習(xí)新概念,比如如閱讀對動物的描述之后,就可以在實際生活中認出它們;通過一張不熟悉的汽車模型照片,就可以預(yù)測其引擎可能發(fā)出的聲音。這在一定程度上是因為單張圖像可以將整體感官體驗「捆綁」在一起。然而在人工智能領(lǐng)域,雖然模態(tài)數(shù)量一直在增加,但多感官數(shù)據(jù)的缺乏會限制標準的需要配對數(shù)據(jù)的多模態(tài)學(xué)習(xí)。

理想情況下,一個有著不同種類數(shù)據(jù)的聯(lián)合嵌入空間能讓模型在學(xué)習(xí)視覺特征的同時學(xué)習(xí)其他的模態(tài)。此前,往往需要收集所有可能的配對數(shù)據(jù)組合,才能讓所有模態(tài)學(xué)習(xí)聯(lián)合嵌入空間。

ImageBind 規(guī)避了這個難題,它利用最近的大型視覺語言模型它將最近的大規(guī)模視覺語言模型的零樣本能力擴展到新的模態(tài),它們與圖像的自然配對,如視頻 - 音頻和圖像 - 深度數(shù)據(jù),來學(xué)習(xí)一個聯(lián)合嵌入空間。針對其他四種模式(音頻、深度、熱成像和 IMU 讀數(shù)),研究者使用自然配對的自監(jiān)督數(shù)據(jù)。

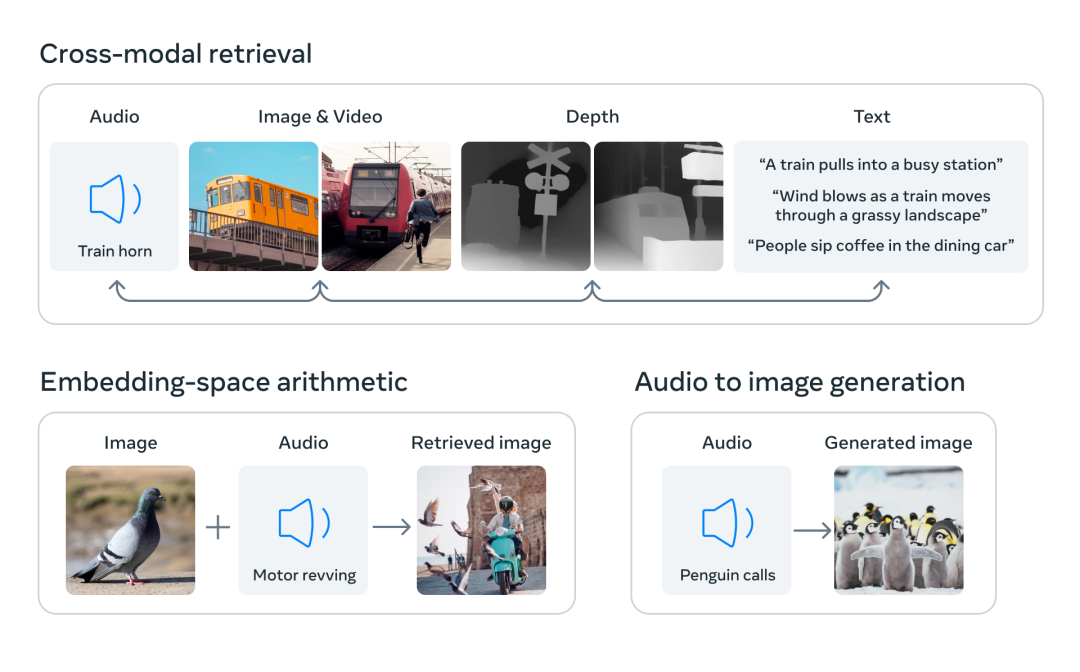

通過將六種模態(tài)的嵌入對齊到一個公共空間,ImageBind 可以跨模態(tài)檢索未同時觀察到的不同類型的內(nèi)容,添加不同模態(tài)的嵌入以自然地對它們的語義進行組合,以及結(jié)合使用 Meta AI 的音頻嵌入與預(yù)訓(xùn)練 DALLE-2 解碼器(設(shè)計用于與 CLIP 文本嵌入)來實現(xiàn)音頻到圖像生成。

互聯(lián)網(wǎng)上存在大量連同文本一起出現(xiàn)的圖像,因此訓(xùn)練圖像 - 文本模型已經(jīng)得到了廣泛的研究。ImageBind 利用了圖像能與各種模態(tài)相連接的綁定屬性,比如利用網(wǎng)絡(luò)數(shù)據(jù)將文本與圖像連接起來,或者利用在有 IMU 傳感器的可穿戴相機中捕捉到的視頻數(shù)據(jù)將運動與視頻連接起來。

從大規(guī)模網(wǎng)絡(luò)數(shù)據(jù)中學(xué)習(xí)到的視覺表征可以用作學(xué)習(xí)不同模態(tài)特征的目標。這使得 ImageBind 將圖像與同時出現(xiàn)的任何模態(tài)對齊,自然地使這些模態(tài)彼此對齊。熱圖和深度圖等與圖像具有強相關(guān)性的模態(tài)更容易對齊。音頻和 IMU(慣性測量單元)等非視覺的模態(tài)則具有較弱的相關(guān)性,比如嬰兒哭聲等特定聲音可以搭配各種視覺背景。

ImageBind 表明,圖像配對數(shù)據(jù)足以將這六種模態(tài)綁定在一起。該模型可以更全面地解釋內(nèi)容,使不同的模態(tài)可以相互「對話」,并在沒有同時觀察它們的情況下找到它們之間的聯(lián)系。例如,ImageBind 可以在沒有一起觀察音頻和文本的情況下將二者聯(lián)系起來。這使得其他模型能夠「理解」新的模態(tài),而不需要任何資源密集型的訓(xùn)練。

ImageBind 強大的 scaling 表現(xiàn)使該模型能夠替代或增強許多人工智能模型,使它們能夠使用其他模態(tài)。例如雖然 Make-A-Scene 可以通過使用文本 prompt 生成圖像,但 ImageBind 可以將其升級為使用音頻生成圖像,如笑聲或雨聲。

ImageBind 的卓越性能

Meta 的分析表明,ImageBind 的 scaling 行為隨著圖像編碼器的強度而提高。換句話說,ImageBind 對齊模態(tài)的能力隨著視覺模型的能力和大小而提升。這表明,更大的視覺模型對非視覺任務(wù)有利,如音頻分類,而且訓(xùn)練這種模型的好處超出了計算機視覺任務(wù)的范疇。

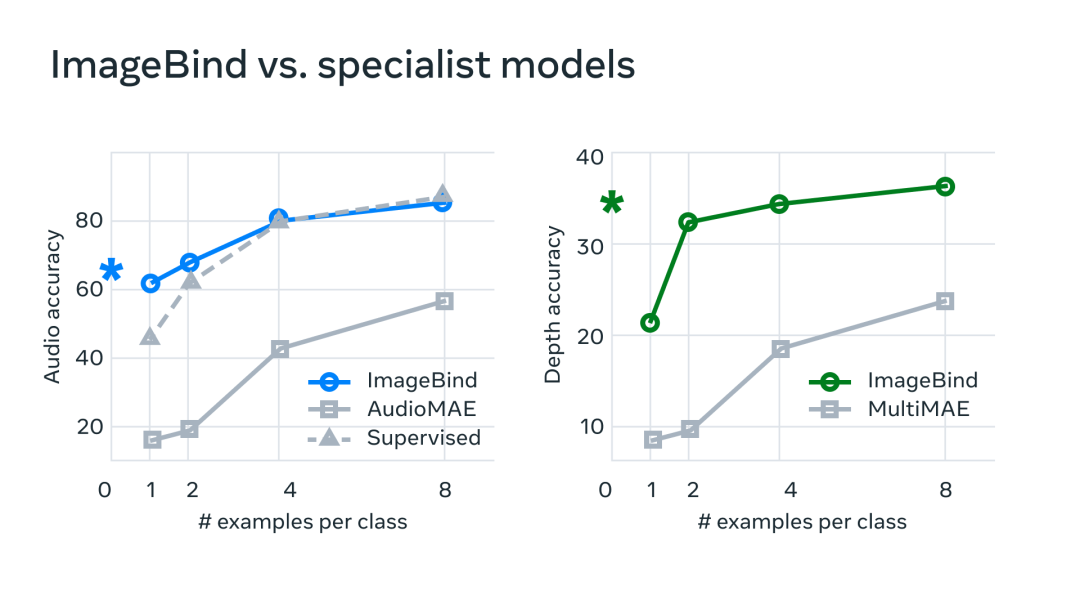

在實驗中,Meta 使用了 ImageBind 的音頻和深度編碼器,并將其與之前在 zero-shot 檢索以及音頻和深度分類任務(wù)中的工作進行了比較。

在基準測試上,mageBind 在音頻和深度方面優(yōu)于專家模型。

Meta 發(fā)現(xiàn) ImageBind 可以用于少樣本音頻和深度分類任務(wù),并且優(yōu)于之前定制的方法。例如,ImageBind 明顯優(yōu)于 Meta 在 Audioset 上訓(xùn)練的自監(jiān)督 AudioMAE 模型,以及在音頻分類上微調(diào)的監(jiān)督 AudioMAE 模型。

此外,ImageBind 還在跨模態(tài)的零樣本識別任務(wù)上取得了新的 SOTA 性能,甚至優(yōu)于經(jīng)過訓(xùn)練以識別該模態(tài)概念的最新模型。

審核編輯 :李倩

-

編碼器

+關(guān)注

關(guān)注

45文章

3706瀏覽量

135756 -

語言模型

+關(guān)注

關(guān)注

0文章

550瀏覽量

10425 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1212瀏覽量

24991

原文標題:爆火!ImageBind:跨模態(tài)之王,將6種模態(tài)全部綁定!

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

OpenHarmony實戰(zhàn)開發(fā)-如何實現(xiàn)模態(tài)轉(zhuǎn)場

模態(tài)窗口的設(shè)置問題

labview 模態(tài)分析

LMS Virtual Lab 流固模態(tài)分析

簡單的模型進行流固耦合的模態(tài)分析

百度研制知識增強的跨模態(tài)深度問答技術(shù)等在內(nèi)的的應(yīng)用系統(tǒng)

可解決數(shù)據(jù)異構(gòu)性問題的跨模態(tài)檢索方法

基于語義耦合相關(guān)的判別式跨模態(tài)哈希特征表示學(xué)習(xí)算法

可提高跨模態(tài)行人重識別算法精度的特征學(xué)習(xí)框架

模態(tài)分析定義以及模態(tài)假設(shè)理論

大模型+多模態(tài)的3種實現(xiàn)方法

鴻蒙ArkTS聲明式開發(fā):跨平臺支持列表【全屏模態(tài)轉(zhuǎn)場】模態(tài)轉(zhuǎn)場設(shè)置

鴻蒙ArkTS聲明式開發(fā):跨平臺支持列表【半模態(tài)轉(zhuǎn)場】模態(tài)轉(zhuǎn)場設(shè)置

ImageBind:跨模態(tài)之王,將6種模態(tài)全部綁定!

ImageBind:跨模態(tài)之王,將6種模態(tài)全部綁定!

評論