一個(gè)月前,就在GPT 4發(fā)布的第二天,同時(shí)也是英偉達(dá)(NVIDIA)線上大會(huì)的契機(jī),英偉達(dá)的創(chuàng)始人兼CEO黃仁勛("Jensen" Huang)與OpenAI的聯(lián)合創(chuàng)始人兼首席科學(xué)家伊爾亞-蘇茨克維(Ilya Sutskever )展開(kāi)了一次信息量巨大的長(zhǎng)達(dá)一個(gè)小時(shí)的“爐邊談話”(Fireside Chats)。期間談到了從伊爾亞-蘇茨克維早期介入神經(jīng)網(wǎng)絡(luò)、深度學(xué)習(xí),基于壓縮的無(wú)監(jiān)督學(xué)習(xí)、強(qiáng)化學(xué)習(xí)、GPT的發(fā)展路徑,以及對(duì)未來(lái)的展望。相信很多人都已經(jīng)看過(guò)了這次談話節(jié)目。我相信,因?yàn)槠渲袚诫s的各種專(zhuān)業(yè)術(shù)語(yǔ)和未經(jīng)展開(kāi)的背景,使得無(wú)專(zhuān)業(yè)背景的同仁很難徹底消化理解他們談話的內(nèi)容。本系列嘗試將他們完整的對(duì)話進(jìn)行深度地解讀,以便大家更好地理解ChatGPT到底給我們帶來(lái)了什么樣的變革。今天,就是這個(gè)系列的第六篇:ChatGPT未來(lái)將走向何方?這也是本系列的最后一篇。

?

一個(gè)月前,就在GPT 4發(fā)布的第二天,同時(shí)也是英偉達(dá)(NVIDIA)線上大會(huì)的契機(jī),英偉達(dá)的創(chuàng)始人兼CEO黃仁勛("Jensen" Huang)與OpenAI的聯(lián)合創(chuàng)始人兼首席科學(xué)家伊爾亞-蘇茨克維(Ilya Sutskever )展開(kāi)了一次信息量巨大的長(zhǎng)達(dá)一個(gè)小時(shí)的“爐邊談話”(Fireside Chats)。期間談到了從伊爾亞-蘇茨克維早期介入神經(jīng)網(wǎng)絡(luò)、深度學(xué)習(xí),基于壓縮的無(wú)監(jiān)督學(xué)習(xí)、強(qiáng)化學(xué)習(xí)、GPT的發(fā)展路徑,以及對(duì)未來(lái)的展望。相信很多人都已經(jīng)看過(guò)了這次談話節(jié)目。我相信,因?yàn)槠渲袚诫s的各種專(zhuān)業(yè)術(shù)語(yǔ)和未經(jīng)展開(kāi)的背景,使得無(wú)專(zhuān)業(yè)背景的同仁很難徹底消化理解他們談話的內(nèi)容。本系列嘗試將他們完整的對(duì)話進(jìn)行深度地解讀,以便大家更好地理解ChatGPT到底給我們帶來(lái)了什么樣的變革。今天,就是這個(gè)系列的第六篇:ChatGPT未來(lái)將走向何方?這也是本系列的最后一篇。

?關(guān)聯(lián)回顧

解讀老黃與Ilya的爐邊談話系列之一——故事要從AlexNet說(shuō)起

解讀老黃與Ilya的爐邊談話系列之二——信仰、準(zhǔn)備、等待機(jī)會(huì)的涌現(xiàn)

解讀老黃與Ilya的爐邊談話系列之三——超越玄幻,背后是人類(lèi)老師的艱辛付出

解讀老黃與Ilya的爐邊談話系列之四——人人都是ChatGPT的訓(xùn)練器

解讀老黃與Ilya的爐邊談話系列之五——將要擁抱多模態(tài)的ChatGPT

讓ChatGPT自己來(lái)談一談人工智能倫理

全圖說(shuō)ChatGPT的前世今生

對(duì)話譯文(06):

黃仁勛:這真是不可思議。你之前還說(shuō)過(guò)的一件事,是關(guān)于用 AI 生成測(cè)試,來(lái)訓(xùn)練另一個(gè) AI 的事。這讓我想起了一篇論文,雖然我不確定其中的內(nèi)容是否屬實(shí)。據(jù)說(shuō)在未來(lái)一段時(shí)間內(nèi),全世界大概有4萬(wàn)億到20萬(wàn)億的語(yǔ)言類(lèi)tokens 可以被用于訓(xùn)練模型。你知道,在一段時(shí)間內(nèi),可以用來(lái)訓(xùn)練的 token 會(huì)慢慢消耗殆盡。首先,我不知道你是否有同樣的感覺(jué)?

其次,我們是否可以利用 AI 生成自己的數(shù)據(jù)來(lái)訓(xùn)練AI 本身?你可能會(huì)反駁這是一個(gè)循環(huán),但我們無(wú)時(shí)無(wú)刻不在用生成的數(shù)據(jù),通過(guò)自我反省的方式,訓(xùn)練我們的大腦,并在腦海里思考某一個(gè)問(wèn)題。神經(jīng)科學(xué)家會(huì)建議人們保持充足的睡眠,我們會(huì)做很多事情,比如睡眠,來(lái)發(fā)展我們的神經(jīng)元。你如何看待合成數(shù)據(jù)生成領(lǐng)域?這是否會(huì)成為未來(lái)AI 訓(xùn)練重要的一部分,AI 能否自己訓(xùn)練自己?

Ilya Sutskever:我認(rèn)為不應(yīng)該低估現(xiàn)有的數(shù)據(jù),我認(rèn)為可能有比人們意識(shí)到的更多的數(shù)據(jù)。至于你的第二個(gè)問(wèn)題,這種可能性仍有待觀察。

黃仁勛:未來(lái)的某些時(shí)候,當(dāng)我們不使用 AI 時(shí),它可能會(huì)生成對(duì)抗性的內(nèi)容來(lái)進(jìn)行學(xué)習(xí),或者想象著它需要解決的問(wèn)題,不斷提升自己,并告訴我們它能做什么。關(guān)于我們現(xiàn)在在哪里,以及未來(lái)我們將會(huì)在哪里,時(shí)間不用很遙遠(yuǎn),比如說(shuō)可見(jiàn)的一兩年,在最讓你興奮的領(lǐng)域中,你認(rèn)為語(yǔ)言模型會(huì)走向何方?

Ilya Sutskever:預(yù)測(cè)是困難的,尤其是對(duì)太具體的事情。我們有理由認(rèn)為這個(gè)領(lǐng)域會(huì)持續(xù)進(jìn)步,我們將繼續(xù)看到AI 系統(tǒng)在它的能力邊界,讓人類(lèi)感到驚訝。AI的可靠性是由它是否可以被信任決定的,未來(lái)它肯定會(huì)達(dá)到能被完全信任的地步。如果它不能完全理解,它也會(huì)通過(guò)提問(wèn)來(lái)弄清楚。它會(huì)告訴你自己不知道,但同時(shí)它會(huì)說(shuō)需要更多的信息。

我認(rèn)為 AI 可用性影響最大的領(lǐng)域,未來(lái)會(huì)有最大的進(jìn)步。因?yàn)楝F(xiàn)在,我們就面臨著一個(gè)挑戰(zhàn),你想讓一個(gè)神經(jīng)網(wǎng)絡(luò)去總結(jié)長(zhǎng)文檔,獲取摘要。挑戰(zhàn)是,你能確定重要的細(xì)節(jié)沒(méi)被忽略嗎?

這仍然是一個(gè)有用的摘要,但當(dāng)你知道所有重要的點(diǎn)都被涵蓋時(shí),就會(huì)產(chǎn)生不同的結(jié)果。在某個(gè)時(shí)刻,尤其是當(dāng)存在歧義時(shí),這也是可以接受的。但如果某個(gè)點(diǎn)明顯很重要,以至于任何其他看到該點(diǎn)的人都會(huì)說(shuō)這真的很重要,當(dāng)神經(jīng)網(wǎng)絡(luò)也能可靠地識(shí)別到這一點(diǎn)時(shí),你就會(huì)知道它可信度提高了。這同樣適用于防護(hù)欄。它是否清楚的遵循用戶的意圖,也會(huì)成為衡量可靠性的標(biāo)準(zhǔn)。未來(lái)兩年,我們會(huì)看到很多這樣的技術(shù)。

黃仁勛:是的,這太棒了。這兩個(gè)領(lǐng)域的進(jìn)步將使這項(xiàng)技術(shù)變得值得信賴,使它能夠應(yīng)用于許多事情。這本應(yīng)該是最后一個(gè)問(wèn)題,但是我的確還有另外一個(gè)問(wèn)題,抱歉。從 ChatGPT 到 GPT-4,你是什么時(shí)候第一次開(kāi)始使用GPT-4 的?它表現(xiàn)出來(lái)什么樣的能力,讓你感到驚訝?

Ilya Sutskever:它展示了很多很酷的東西,非常驚人。它非常棒,我會(huì)提到兩點(diǎn),我在想怎么才可以更好地表達(dá)。簡(jiǎn)單來(lái)說(shuō),它的可靠性水平讓人感到驚訝。在此之前的神經(jīng)網(wǎng)絡(luò),如果你問(wèn)它一個(gè)問(wèn)題,它可能會(huì)以一種近乎愚蠢的方式誤解問(wèn)題。但在 GPT-4 上這種情況已經(jīng)不再發(fā)生。它解決數(shù)學(xué)問(wèn)題的能力大大提高了,你可以認(rèn)為它真的進(jìn)行了推導(dǎo),很長(zhǎng)的、復(fù)雜的推導(dǎo),并且還轉(zhuǎn)換了單位等等,這真的很酷。

黃仁勛:它是通過(guò)一步步的證明來(lái)工作的,這真的很神奇。

Ilya Sutskever:不是所有的證明,但起碼有很大一部分是的。另外一個(gè)例子,就像許多人注意到它可以用同一個(gè)字母開(kāi)頭的單詞寫(xiě)詩(shī),每個(gè)單詞都很清晰地遵循著指令。雖然仍不完美,但是已經(jīng)非常好了。

在視覺(jué)方面,我真的很喜歡它是如何解釋笑話的。它可以解釋網(wǎng)絡(luò)熱梗,你給它看一個(gè)網(wǎng)絡(luò)熱梗,并詢問(wèn)它這個(gè)為什么好笑,它會(huì)告訴你原因,并且它說(shuō)的還是對(duì)的。我認(rèn)為,在視覺(jué)部分,它就像真的可以看到那些圖像。你用一些復(fù)雜的圖像或圖表來(lái)追問(wèn)它問(wèn)題,然后得到解釋?zhuān)@非常酷。

但總的來(lái)說(shuō),我已經(jīng)從事這項(xiàng)工作很長(zhǎng)時(shí)間了,實(shí)際上幾乎整整20年了。最讓我感到驚訝的是,它真的運(yùn)行起來(lái)了。它似乎一直以來(lái)對(duì)人們來(lái)說(shuō)都是個(gè)小事,但它現(xiàn)在不再渺小,變得更重要、更強(qiáng)烈。

它還是那個(gè)神經(jīng)網(wǎng)絡(luò),只是變得更大,在更大的數(shù)據(jù)集上,以不同的方式訓(xùn)練,但訓(xùn)練的基礎(chǔ)算法都是一樣的,這是最令我驚訝的。

每當(dāng)我回顧時(shí),我就會(huì)想,這些概念性想法怎么可能呢?大腦有神經(jīng)元,也許人工神經(jīng)元也一樣好,我們可能只需要用某種學(xué)習(xí)算法對(duì)它們進(jìn)行訓(xùn)練。那些論點(diǎn)竟然如此正確,這本身就是最大的驚喜。

黃仁勛:在我們相識(shí)的十年里,你訓(xùn)練的模型和數(shù)據(jù)量,從你在 AlexNet 上所做的工作到現(xiàn)在,增加了約100萬(wàn)倍。在計(jì)算機(jī)科學(xué)界,沒(méi)有人會(huì)相信在這十年間,計(jì)算量會(huì)擴(kuò)大100萬(wàn)倍。并且你的整個(gè)職業(yè)生涯都致力于此,你有兩個(gè)開(kāi)創(chuàng)性的研究成果,早期的 AlexNet 和現(xiàn)在 OpenAI 的GPT,你所取得的成就真了不起。很高興能再次與你進(jìn)行思想上的碰撞,我的朋友 Ilya,這是一個(gè)相當(dāng)美妙的時(shí)刻,今天的對(duì)話,你將問(wèn)題抽絲剝繭,逐一解釋。這是最好的博士學(xué)位之一,除了博士學(xué)位,你還描述了大型語(yǔ)言模型的最新技術(shù)水平。我真的很感激,很高興見(jiàn)到你,恭喜你,非常感謝你。

智愿君:讓我們繼續(xù)解讀老黃和Ilya爐邊談話的第五六段對(duì)話(也就是本系列的終章),這一段主要是探討對(duì)ChatGPT未來(lái)的暢想。那么老黃和Ilya談話中哪些細(xì)節(jié)值得我們?nèi)リP(guān)注呢?

AI 能否自己訓(xùn)練自己?

老黃的這個(gè)問(wèn)題提得蠻尖銳的。而Ilya并未展開(kāi)回答這個(gè)問(wèn)題。我覺(jué)得這個(gè)問(wèn)題我們要回顧一下神經(jīng)網(wǎng)絡(luò)的發(fā)展歷史:

從20世紀(jì)40年代至今,神經(jīng)網(wǎng)絡(luò)經(jīng)歷了三次浪潮。

-

-

第一次浪潮指的是早期的控制論,其核心是邏輯主義。這一潮流始于1943年,由美國(guó)著名的神經(jīng)生物學(xué)家沃倫·麥卡洛克(Warren McCulloch)和數(shù)學(xué)家沃爾特·皮茨(Walter Pitts)提出了麥卡洛克-皮茨神經(jīng)元模型(McCulloch-Pitts neuron model)。感知機(jī)和自適應(yīng)線性單元是最典型的成果。感知機(jī)是一種學(xué)習(xí)權(quán)重的模型,根據(jù)每個(gè)類(lèi)別的輸入樣本來(lái)學(xué)習(xí)。自適應(yīng)線性單元?jiǎng)t是用函數(shù)f(x)本身的值來(lái)預(yù)測(cè)一個(gè)實(shí)數(shù)。第一次浪潮的主要限制是過(guò)于理想化的數(shù)學(xué)模型和機(jī)械邏輯論,希望通過(guò)符號(hào)演算(邏輯門(mén))的方法推理和計(jì)算。這種方式過(guò)于簡(jiǎn)單,無(wú)法真正解決現(xiàn)實(shí)生活中復(fù)雜的問(wèn)題,并且不具備靈活度,可以說(shuō)是一個(gè)大號(hào)的計(jì)算器。

-

第二次浪潮是在20世紀(jì)80年代到90年代出現(xiàn)的聯(lián)結(jié)主義(connectionism),又稱為并行分布處理(parallel distributed processing)。聯(lián)結(jié)主義的指導(dǎo)性啟示和主要靈感來(lái)自大腦或神經(jīng)系統(tǒng),將認(rèn)知看成是網(wǎng)絡(luò)的整體活動(dòng)。中心思想是,當(dāng)網(wǎng)絡(luò)將大量簡(jiǎn)單的計(jì)算單元連接在一起時(shí),可以實(shí)現(xiàn)智能行為。1982年,生物物理教授霍普菲爾德提出了一種新的神經(jīng)網(wǎng)絡(luò),可以解決一大類(lèi)模式識(shí)別問(wèn)題,還可以給出一類(lèi)組合優(yōu)化問(wèn)題的近似解。1986年,David Rumelhart和Geoffery Hinton發(fā)展了神經(jīng)網(wǎng)絡(luò)反向傳播學(xué)習(xí)算法Back Propagation,延展出來(lái)的分布式表示、長(zhǎng)短期記憶以及新認(rèn)知機(jī)成為了卷積網(wǎng)絡(luò)的基礎(chǔ)。聯(lián)結(jié)主義在許多領(lǐng)域得到了廣泛應(yīng)用,如模式識(shí)別、手寫(xiě)文字識(shí)別、字符識(shí)別和簡(jiǎn)單的人臉識(shí)別。但是,應(yīng)對(duì)復(fù)雜問(wèn)題時(shí)聯(lián)結(jié)主義的表現(xiàn)力不夠強(qiáng)大。第二次浪潮的衰退主要限制是算力跟不上,受限硬件計(jì)算能力和互聯(lián)網(wǎng)的并行處理能力。

-

第三次浪潮是基于互聯(lián)網(wǎng)大數(shù)據(jù)和GPU的深度學(xué)習(xí)的突破。2006年,加拿大CIFAR的Geoffrey Hinton和其他附屬研究小組使用一種稱為貪婪逐層預(yù)訓(xùn)練的策略來(lái)有效地訓(xùn)練深度網(wǎng)絡(luò)。這標(biāo)志這現(xiàn)在有能力訓(xùn)練以前不可能訓(xùn)練的比較深的神經(jīng)網(wǎng)絡(luò)。此時(shí)的深度神經(jīng)網(wǎng)絡(luò)已經(jīng)優(yōu)于與之競(jìng)爭(zhēng)的基于其他機(jī)器學(xué)習(xí)技術(shù)以及手工設(shè)計(jì)功能的 AI 系統(tǒng)。(參見(jiàn)前文我們提到在ImageNet上的奪冠)。第三次浪潮的驅(qū)動(dòng)力就是:推進(jìn)通用人工智能(強(qiáng)人工智能),并探索超人工智能。不僅僅是通過(guò)硬件的升級(jí),更是通過(guò)大數(shù)據(jù)的積累和GPU的高性能計(jì)算,使得深度學(xué)習(xí)的模型和算法得到了極大的提升,廣泛應(yīng)用于語(yǔ)音識(shí)別、自然語(yǔ)言處理、圖像和視頻識(shí)別等領(lǐng)域。例如,深度神經(jīng)網(wǎng)絡(luò)在計(jì)算機(jī)視覺(jué)領(lǐng)域的應(yīng)用,如人臉識(shí)別、物體檢測(cè)、圖像分割等任務(wù)中,已經(jīng)達(dá)到了人類(lèi)水平甚至超越了人類(lèi)。同時(shí),深度學(xué)習(xí)還帶來(lái)了很多新的技術(shù)突破,例如生成對(duì)抗網(wǎng)絡(luò)(GAN)、變分自編碼器(VAE)、殘差網(wǎng)絡(luò)(ResNet)、注意力機(jī)制(Attention)等等。與此同時(shí),深度學(xué)習(xí)也面臨著很多挑戰(zhàn)和問(wèn)題。例如,深度學(xué)習(xí)算法需要大量的訓(xùn)練數(shù)據(jù)和計(jì)算資源,而且很難解釋其內(nèi)部的決策過(guò)程;深度學(xué)習(xí)模型容易受到對(duì)抗性攻擊和過(guò)擬合等問(wèn)題的影響;深度學(xué)習(xí)的可解釋性和公平性等問(wèn)題也需要進(jìn)一步研究解決。

-

而回到剛才的問(wèn)題就是自己訓(xùn)練自己,也就是自我學(xué)習(xí)能力,是通用人工智能的標(biāo)志之一。所以老黃問(wèn)出這個(gè)問(wèn)題,還是挺有深意的。

那么為什么Ilya回避了對(duì)這個(gè)問(wèn)題的回答,我覺(jué)得大概率是兩點(diǎn)原因:

-

-

Ilya清楚這是一個(gè)敏感話題。他如果過(guò)度贊許AI自己訓(xùn)練自己的能力,會(huì)增加AI發(fā)展不受控的社會(huì)恐慌。從近期Geoffrey Hinton 宣布辭去 Google 的職務(wù),并稱自己現(xiàn)在對(duì)自己畢生的工作感到后悔這件事上,就能說(shuō)明問(wèn)題。Geoffrey Hinton對(duì)人工智能領(lǐng)域的發(fā)展所帶來(lái)的風(fēng)險(xiǎn)感到擔(dān)憂,并為人類(lèi)敲響警鐘。

-

Ilya明白,確實(shí)在使用這種AI自己訓(xùn)練自己的方式,但是效果有待觀察為什么這么說(shuō)呢?因?yàn)樽晕矣?xùn)練,可能會(huì)無(wú)法準(zhǔn)確評(píng)估訓(xùn)練模型的性能和魯棒性。人類(lèi)的信息有很多,有些信息是正確信息,有些是錯(cuò)誤信息。有些信息帶有明顯的惡意或者邏輯漏洞。如果不分青紅皂白,讓AI自己去訓(xùn)練自己,可能會(huì)在訓(xùn)練數(shù)據(jù)這個(gè)環(huán)節(jié)就會(huì)失控,因?yàn)椤芭K”數(shù)據(jù),自然不會(huì)學(xué)出一個(gè)理想的模型和能力沉淀。在機(jī)器學(xué)習(xí)中,訓(xùn)練數(shù)據(jù)的質(zhì)量對(duì)最終模型的表現(xiàn)和準(zhǔn)確性有著非常重要的影響。如果訓(xùn)練數(shù)據(jù)集中包含了大量的錯(cuò)誤數(shù)據(jù)、噪聲數(shù)據(jù)或者惡意數(shù)據(jù),那么最終的模型可能會(huì)受到這些數(shù)據(jù)的干擾,表現(xiàn)不如預(yù)期甚至出現(xiàn)偏差和過(guò)擬合等問(wèn)題。因此,在選擇訓(xùn)練數(shù)據(jù)時(shí),需要盡量篩選和清洗出具有代表性和高質(zhì)量的數(shù)據(jù),從而提高模型的表現(xiàn)和泛化能力。另外,對(duì)于AI自我訓(xùn)練自己這一過(guò)程,需要設(shè)計(jì)合理的學(xué)習(xí)策略和算法,以避免模型的學(xué)習(xí)過(guò)程受到“臟”數(shù)據(jù)的影響。例如,在訓(xùn)練過(guò)程中可以引入監(jiān)督信號(hào)或者其他的先驗(yàn)知識(shí),以引導(dǎo)模型學(xué)習(xí)正確的知識(shí)和規(guī)律。同時(shí),在評(píng)估模型的表現(xiàn)時(shí),也需要引入合理的評(píng)估標(biāo)準(zhǔn)和指標(biāo),以評(píng)估模型的性能和泛化能力。

-

所以,我總結(jié)一下這個(gè)問(wèn)題的答復(fù)應(yīng)該是:1. AI可以自己訓(xùn)練自己;2. 結(jié)果難與保證,所以有待觀察,或者需要人工干預(yù)。

如何看到AI系統(tǒng)的置信度

在對(duì)話里,Ilya拋出來(lái)一個(gè)疑問(wèn):讓AI去總結(jié)長(zhǎng)文檔,獲取摘要。但如何確定重要的細(xì)節(jié)沒(méi)被忽略嗎?

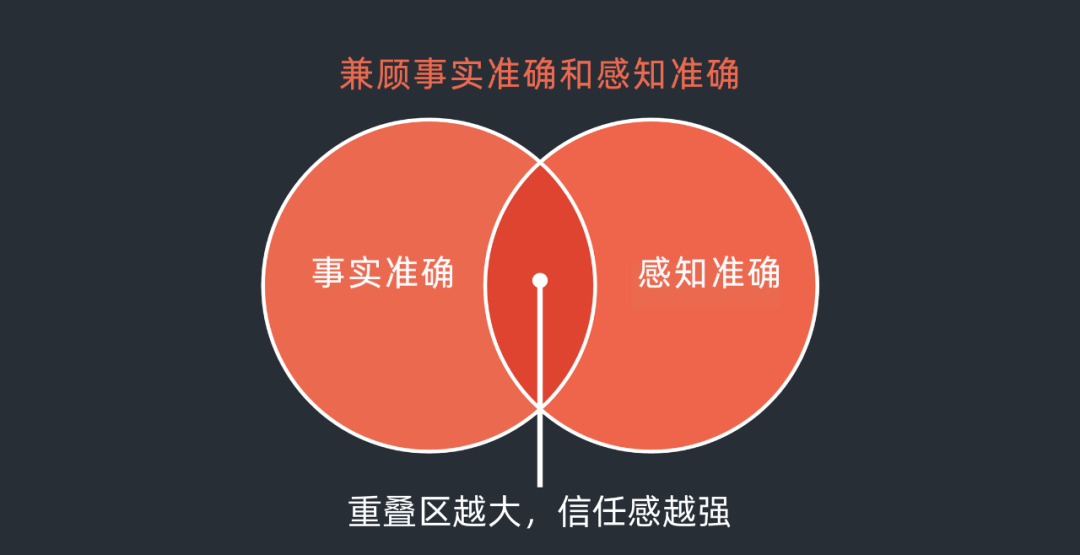

其實(shí)回答這個(gè)問(wèn)題是一個(gè)置信度的平衡問(wèn)題。對(duì)于到底總結(jié)是否準(zhǔn)確或者是否有遺漏,我覺(jué)得分為兩類(lèi)。一種是事實(shí)準(zhǔn)確,一種是感知準(zhǔn)確。前者是大模型本身通過(guò)深度學(xué)習(xí)技術(shù)和數(shù)據(jù)集的完備性來(lái)保障的,當(dāng)然也和人工強(qiáng)化學(xué)習(xí)和調(diào)優(yōu)等有關(guān)。后者是使用者的心理置信度,不管準(zhǔn)確與否,我信任你。這兩種準(zhǔn)確有交集,如果兩個(gè)交集越大就表明大模型的置信度能力越符合使用者的心理預(yù)期,信任感也就越容易建立。如果交集很少,使用者的產(chǎn)品信任度會(huì)逐漸降低,并最后放棄使用。這種邏輯在自動(dòng)駕駛的事實(shí)安全和感知安全上也可以通用。

拿Ilya舉的總結(jié)長(zhǎng)文摘要的例子。不同人總結(jié),肯定也會(huì)有千差萬(wàn)別。有的人總結(jié)詳細(xì)一點(diǎn)兒,有的人總結(jié)簡(jiǎn)約一點(diǎn)兒。有的人偏重文章的某一方面,有些人偏重文章的另外一個(gè)方面。而且,往往業(yè)務(wù)需求不同,總結(jié)也會(huì)不一樣,比如從財(cái)務(wù)角度分析,從技術(shù)演進(jìn)的角度分析,從企業(yè)創(chuàng)新實(shí)踐的角度分析,都會(huì)有不同的摘要。所以,對(duì)于總結(jié)長(zhǎng)文摘要,基本上存在兩點(diǎn):1. 對(duì)需求的精準(zhǔn)理解,懂得去和使用者進(jìn)一步交互,去了解對(duì)方的期待;2. 不管從哪一個(gè)角度的理解,能做到盡可能思考完備,不追求100%準(zhǔn)確,因?yàn)楹芸赡芤膊淮嬖跇?biāo)準(zhǔn)答案,但是一定要足夠靠譜。

所以對(duì)于一個(gè)好的AI,回答問(wèn)題的能力是一方面,懂得向使用者提問(wèn),而且能從使用者的答復(fù)中再提煉和精準(zhǔn)收斂理解用戶的需求,顯得更為重要。會(huì)聊天的AI,比單純只回答的AI,要總要得多。相信,這個(gè)也應(yīng)該是ChatGPT未來(lái)發(fā)展的重點(diǎn)。

訓(xùn)練AI的數(shù)據(jù)會(huì)耗盡嗎?

如果我們面臨的最終目標(biāo)是要訓(xùn)練通用人工智能,或者超人工智能,可能我們會(huì)思考如何應(yīng)對(duì)訓(xùn)練數(shù)據(jù)可能被耗竭的風(fēng)險(xiǎn)。但正如Ilya回答的那樣,我們不應(yīng)該低估現(xiàn)有的數(shù)據(jù),而且可能有比人們意識(shí)到的更多的數(shù)據(jù)。

這句話也有多層的涵義。

首先,我們不應(yīng)該低估現(xiàn)有的數(shù)據(jù)。這是什么意思呢?同樣的訓(xùn)練數(shù)據(jù),如果數(shù)據(jù)標(biāo)簽的數(shù)量不同,標(biāo)簽覆蓋的完備性不同,訓(xùn)練數(shù)據(jù)的多樣性選擇等等都會(huì)對(duì)最終結(jié)果產(chǎn)生影響。如果處理不當(dāng),可能會(huì)出現(xiàn)過(guò)擬合、梯度消失或梯度爆炸等問(wèn)題。如果要利用好同一個(gè)訓(xùn)練數(shù)據(jù),那么就要通過(guò)合理的標(biāo)注以確保訓(xùn)練數(shù)據(jù)的質(zhì)量和多樣性被體現(xiàn)、同時(shí),神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)(比如層級(jí))和參數(shù)數(shù)量的設(shè)計(jì)、訓(xùn)練算法和優(yōu)化技術(shù)的選擇等。在這個(gè)過(guò)程中,需要綜合考慮模型的性能、計(jì)算資源、訓(xùn)練時(shí)間、數(shù)據(jù)質(zhì)量等多個(gè)因素,以達(dá)到一個(gè)平衡點(diǎn)。也就是說(shuō),同樣一個(gè)數(shù)據(jù)集,不同公司來(lái)使用,如果標(biāo)注完備性不夠,網(wǎng)絡(luò)結(jié)構(gòu)不合理,參數(shù)不合適,訓(xùn)練算法不夠優(yōu)秀,都可能會(huì)導(dǎo)致差強(qiáng)人意的大模型結(jié)果。

其次,可以通過(guò)一些技術(shù)手段,來(lái)優(yōu)化學(xué)習(xí)樣本。比如:

-

-

數(shù)據(jù)增強(qiáng):通過(guò)對(duì)現(xiàn)有數(shù)據(jù)進(jìn)行擴(kuò)充和變換,可以生成更多的訓(xùn)練樣本。例如,可以使用圖像增強(qiáng)技術(shù)對(duì)圖像數(shù)據(jù)進(jìn)行旋轉(zhuǎn)、平移、縮放等變換,或者使用文本增強(qiáng)技術(shù)生成近義詞、反義詞等變換文本數(shù)據(jù)。

-

跨任務(wù)遷移學(xué)習(xí):在某些情況下,可以利用先前訓(xùn)練好的模型和數(shù)據(jù)來(lái)提高新模型的性能。這種方法稱為遷移學(xué)習(xí)。通過(guò)使用遷移學(xué)習(xí),可以將模型從一個(gè)任務(wù)轉(zhuǎn)移到另一個(gè)任務(wù),從而減少對(duì)大量數(shù)據(jù)的需求。

-

數(shù)據(jù)共享:在某些情況下,可以考慮共享學(xué)習(xí)的數(shù)據(jù)庫(kù),做一定程度但拉通。例如通過(guò)共享數(shù)據(jù)集或與其他機(jī)構(gòu)或組織合作共同收集數(shù)據(jù),以充分利用可用資源。

-

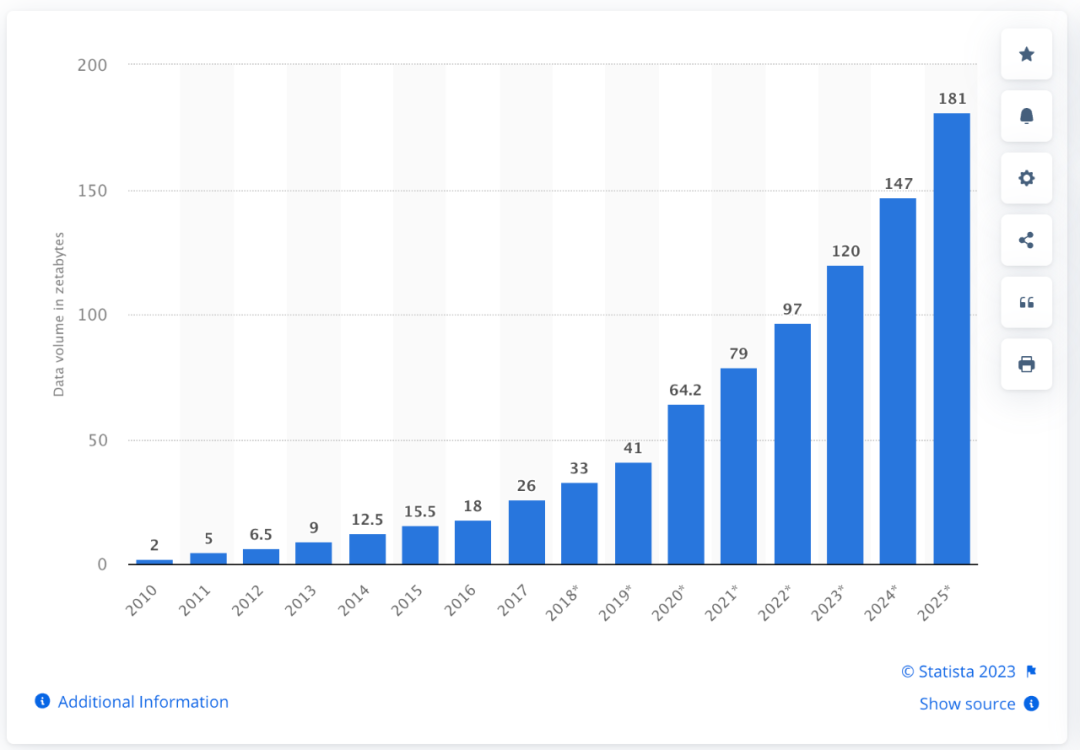

最后,要實(shí)時(shí)跟進(jìn),人們產(chǎn)生的數(shù)據(jù)的步伐。人類(lèi)的知識(shí)是一直不停地迭代和更新的。根據(jù)Statista 2023年的統(tǒng)計(jì),今年的互聯(lián)網(wǎng)上的數(shù)據(jù)量,已經(jīng)是2021年的一倍。所以這種數(shù)據(jù)擴(kuò)張的幅度和增長(zhǎng)曲線是指數(shù)級(jí)的。而且現(xiàn)在數(shù)據(jù)的形態(tài)也在發(fā)生變化。除了文本之外,視頻、音頻,3D等形態(tài)的數(shù)據(jù)也在日益增長(zhǎng)。所以,不要輕言訓(xùn)練數(shù)據(jù)耗盡,這種情況基本上不會(huì)出現(xiàn)。

GPT-4,到底是什么?

在老黃和Ilya談話的過(guò)程中,其實(shí)聊了很多的GPT-4。但到底什么是GPT-4,它和之前的版本到底有什么不同?

首先,就是準(zhǔn)確率的大幅提升。在本期談話中,Ilya談到了它回答錯(cuò)誤率大幅度降低了。降低到什么水平呢?OpenAI提供的文檔報(bào)告稱,GPT-4-launch的錯(cuò)誤行為率為0.02%,遠(yuǎn)低于GPT-3.5的0.07%和GPT-3的0.11%。這意味著GPT-4-launch生成的文本在10000次完成中只有2次違反OpenAI的內(nèi)容政策或用戶偏好。GPT-4雖然已經(jīng)具備解物理題的能力,但畢竟不是專(zhuān)門(mén)的解題算法,一些復(fù)雜的數(shù)理問(wèn)題對(duì)話中仍會(huì)出現(xiàn)一本正經(jīng)胡說(shuō)八道的情況。但是如果我們理解GPT的機(jī)制,就應(yīng)該明白準(zhǔn)確率再提升,也無(wú)法做到100%的準(zhǔn)確。由于大模型(包括GPT-4)本質(zhì)上可以視為訓(xùn)練集(人類(lèi)知識(shí)/語(yǔ)言)的有損壓縮,因此在模型運(yùn)行時(shí)無(wú)法完整復(fù)現(xiàn)或者應(yīng)答原始知識(shí),從而模型的幻覺(jué)來(lái)自于信息壓縮的偏差。多模態(tài)幻覺(jué)的本質(zhì)是這種有損壓縮偏差的體現(xiàn),也是通過(guò)數(shù)學(xué)逼近人類(lèi)語(yǔ)言的必然代價(jià)。(類(lèi)似于壓縮后的圖像邊緣出現(xiàn)不正常的條紋)。

第二,GPT-4如上文說(shuō)的那樣,是一個(gè)多模態(tài)的處理能力。已經(jīng)升級(jí)為多模態(tài)大語(yǔ)言模型(Multi-modal Large Language Model,MLLM)。Ilya在本期和上期的談話都提到了它如何理解圖像。圖像可以幫助GPT-4實(shí)現(xiàn)更好的常識(shí)推理性能,跨模態(tài)遷移更有利于知識(shí)獲取,產(chǎn)生更多新的能力,加速了能力的涌現(xiàn)。這些獨(dú)立模態(tài)或跨模態(tài)新特征、能力或模式通常不是通過(guò)目的明確的編程或訓(xùn)練獲得的,而是模型在大量多模態(tài)數(shù)據(jù)中自然而然的學(xué)習(xí)到的。量變引發(fā)質(zhì)變。涌現(xiàn)能力的另一個(gè)重要表現(xiàn)是模型的泛化能力。在沒(méi)有專(zhuān)門(mén)訓(xùn)練過(guò)的情況,GPT-4也可以泛化到新的、未知的多模態(tài)數(shù)據(jù)樣本上。這種泛化能力取決于模型的結(jié)構(gòu)和訓(xùn)練過(guò)程,以及數(shù)據(jù)的數(shù)量和多樣性。如果模型具有足夠的復(fù)雜性和泛化能力,就可以從原始數(shù)據(jù)中發(fā)現(xiàn)新的、未知的特征和模式。當(dāng)然,GPT-4涌現(xiàn)出的新能力可能仍有局限性,例如:模型可能產(chǎn)生錯(cuò)誤的回答,對(duì)某些問(wèn)題缺乏理解,容易受到輸入干擾等。目前認(rèn)為GPT-4的幻覺(jué)與其涌現(xiàn)能力具有相關(guān)性。GPT-4的多模態(tài)輸入的能力對(duì)語(yǔ)言模型至關(guān)重要,使得“蘋(píng)果”等單純的符號(hào)語(yǔ)義擴(kuò)展為更多的內(nèi)涵。第一,多模態(tài)感知使語(yǔ)言模型能夠獲得文本描述之外的常識(shí)性知識(shí)。第二,感知與語(yǔ)義理解的結(jié)合為新型任務(wù)提供了可能性,例如機(jī)器人交互技術(shù)和多媒體文檔處理。第三,通過(guò)感知統(tǒng)一了接口。圖形界面其實(shí)是最自然和高效的人機(jī)自然交互方式。多模態(tài)大語(yǔ)言模型可通過(guò)圖形方式直接進(jìn)行信息交互,提升交互效率。多模態(tài)模型可以從多種來(lái)源和模式中學(xué)習(xí)知識(shí),并使用模態(tài)的交叉關(guān)聯(lián)來(lái)完成任務(wù)。通過(guò)圖像或圖文知識(shí)庫(kù)學(xué)習(xí)的信息可用于回答自然語(yǔ)言問(wèn)題;從文本中學(xué)到的信息也可在視覺(jué)任務(wù)中使用。

第三,就是更強(qiáng)的推理能力。GPT-4的思維鏈(Chain of Thought)能讓大眾感覺(jué)到語(yǔ)言模型“像人”的關(guān)鍵特性。雖然GPT-4這些模型并非具備真正的意識(shí)或思考能力,但用類(lèi)似于人的推理方式的思維鏈來(lái)提示語(yǔ)言模型,極大的提高了GPT-4在推理任務(wù)上的表現(xiàn),打破了精調(diào)(Fine-tune)的平坦曲線。具備了多模態(tài)思維鏈能力的GPT-4模型具有一定邏輯分析能力,已經(jīng)不是傳統(tǒng)意義上的詞匯概率逼近模型。通過(guò)多模態(tài)思維鏈技術(shù),GPT-4將一個(gè)多步驟的問(wèn)題(例如圖表推理)分解為可以單獨(dú)解決的中間步驟。在解決多步驟推理問(wèn)題時(shí),模型生成的思維鏈會(huì)模仿人類(lèi)思維過(guò)程。這意味著額外的計(jì)算資源被分配給需要更多推理步驟的問(wèn)題,可以進(jìn)一步增強(qiáng)GPT-4的表達(dá)和推理能力。一般認(rèn)為模型的思維推理能力與模型參數(shù)大小有正相關(guān)趨勢(shì),一般是突破一個(gè)臨界規(guī)模(大概62B,B代表10億),模型才能通過(guò)思維鏈提示的訓(xùn)練獲得相應(yīng)的能力。思維鏈不是隨隨便便就能被訓(xùn)練出來(lái)的。另外也有研究表明,在語(yǔ)言訓(xùn)練集中加入編程語(yǔ)言(例如Python編程代碼)可提升模型邏輯推理能力。具有思維鏈推理能力的GPT-4模型可用于簡(jiǎn)單數(shù)學(xué)問(wèn)題、符號(hào)操作和常識(shí)推理等任務(wù)。完成思維鏈的訓(xùn)練,才算真正拿到了這波大模型AI競(jìng)技的入場(chǎng)券。

GPT的未來(lái),到底何去何從?

對(duì)AI的狂熱追捧的熱度高峰過(guò)去后,很多人開(kāi)始冷靜下來(lái)。從一個(gè)多月前,包括埃隆馬斯克和蘋(píng)果公司聯(lián)合創(chuàng)始人史蒂夫沃茲尼亞克在內(nèi)的一些科技行業(yè)人士發(fā)表公開(kāi)信敦促OpenAI停止訓(xùn)練比GPT-4更強(qiáng)大的人工智能系統(tǒng)。以及最近從谷歌辭去職務(wù)的Geoffrey Hinton警示AI 有可能會(huì)傷害人類(lèi)。讓我們從另外一個(gè)視角來(lái)看到這個(gè)問(wèn)題。

其實(shí)關(guān)于人工智能是否會(huì)危及人類(lèi)生存的話題,很早就出現(xiàn)了。早在1863 年,小說(shuō)家塞繆爾·巴特勒 (Samuel Butler)就在《機(jī)器中的達(dá)爾文》中寫(xiě)道:“結(jié)果只是一個(gè)時(shí)間問(wèn)題,但機(jī)器將真正統(tǒng)治世界及其居民的時(shí)刻將會(huì)到來(lái),這是任何真正具有哲學(xué)頭腦的人都不會(huì)懷疑的。”。卡雷爾·恰佩克(Karel ?apek)在1920年羅森的萬(wàn)能機(jī)器人RUR的喜劇中,第一次引入了機(jī)器人的概念,就通過(guò)夸張的舞臺(tái)故事預(yù)言AI接管人類(lèi)(AI takeover)。AI takeover是一種假設(shè)情景,超級(jí)智能AI機(jī)器人成為地球上主要的智能形式,并從人類(lèi)手中奪走了地球的控制權(quán)。這一概念在后續(xù)科幻小說(shuō)和電影等藝術(shù)作品中被廣泛運(yùn)用。甚至連計(jì)算機(jī)科學(xué)家艾倫·圖靈 (Alan Turing)也曾在1951年一篇題為“智能機(jī)械,一種異端理論”的文章中提出:隨著人工智能變得比人類(lèi)更聰明,它們可能會(huì)“控制”世界。

存在風(fēng)險(xiǎn)(“x-risk”)學(xué)派認(rèn)為:人類(lèi)物種目前支配著其他物種,因?yàn)槿祟?lèi)大腦具有其他動(dòng)物所缺乏的一些獨(dú)特能力。如果人工智能在一般智能上超越人類(lèi),成為“超級(jí)智能”,那么人類(lèi)將難以或無(wú)法控制。正如山地大猩猩的命運(yùn)取決于人類(lèi)的善意,人類(lèi)的命運(yùn)也可能取決于未來(lái)機(jī)器超級(jí)智能的行為。說(shuō)白一點(diǎn)兒就是,盡管我們?cè)谟?xùn)練AI的過(guò)程中一直在灌輸與人類(lèi)兼容的價(jià)值觀。但是我們無(wú)法控制的是機(jī)器人是否在認(rèn)知提升后產(chǎn)生新的邏輯體系和價(jià)值判斷體系。道格拉斯·恩格爾巴特 (Douglas Engelbart)在1994年,正式提出“集體智商”(collective IQ)的概念,作為集體智慧的衡量標(biāo)準(zhǔn)。隨著互聯(lián)網(wǎng)的普及、大數(shù)據(jù)和基于深度學(xué)習(xí)的人工智能的迅猛發(fā)展,AI正在朝著集體智慧的方向進(jìn)化。集體智慧的倫理和強(qiáng)調(diào)個(gè)體關(guān)系的人類(lèi)的倫理會(huì)產(chǎn)生巨大的差別。

前一段時(shí)間,我分析過(guò)美國(guó)國(guó)防部DARPA的一些和人工智能相關(guān)的項(xiàng)目。其中包括:比如CREATE項(xiàng)目(具有對(duì)抗策略的建設(shè)性機(jī)器學(xué)習(xí)戰(zhàn)斗Context Reasoning for Autonomous Teaming 的縮寫(xiě))、ACK (自適應(yīng)跨域“殺”網(wǎng)是Adapting Cross-Domain Kill-Webs 的縮寫(xiě))等。美國(guó)軍方計(jì)劃將這項(xiàng)技術(shù)應(yīng)用于戰(zhàn)爭(zhēng)的一些想法確實(shí)令人作嘔,且毛骨悚然。這些項(xiàng)目都屬于致命自主武器系統(tǒng)(LAWS) ,也就是通常被稱為“殺手機(jī)器人”或者“戰(zhàn)爭(zhēng)機(jī)器人”,理論上能夠在沒(méi)有人類(lèi)監(jiān)督和干擾的情況下瞄準(zhǔn)和射擊。而且是物聯(lián)網(wǎng)多武器協(xié)同作戰(zhàn)。2014年,常規(guī)武器公約(CCW)召開(kāi)了兩次會(huì)議。第一個(gè)是致命自主武器系統(tǒng) (LAWS) 專(zhuān)家會(huì)議。會(huì)議就LAWS 的特別授權(quán),并引起了激烈的討論。許多非政府組織和發(fā)展中國(guó)家都呼吁預(yù)防性地禁止 LAWS。他們根據(jù)道義論和后果論推理提出了自己的觀點(diǎn)。人們有“不被機(jī)器殺死的權(quán)利”。

但一味的擔(dān)心,沒(méi)有解決方案,也是不對(duì)的。早在1941年,作為科幻“三巨頭”之一的艾薩克·阿西莫夫(Isaac Asimov),就在他最著名的作品銀河帝國(guó)系列和機(jī)器人系列中的一篇短篇小說(shuō)《Runaround》中,第一次提及”機(jī)器人三定律”。這個(gè)奠定了機(jī)器人倫理的基礎(chǔ):第一定律:機(jī)器人不得傷害人類(lèi),或因不作為而讓人類(lèi)受到傷害。第二定律:機(jī)器人必須服從人類(lèi)給它的命令,除非這些命令與第一定律相沖突。第三定律:只要不違反第一或第二定律,機(jī)器人就必須保護(hù)自己的存在。但隨著時(shí)代的發(fā)展,顯然,這個(gè)遠(yuǎn)遠(yuǎn)不夠。2005~2006,由機(jī)器人學(xué)院協(xié)調(diào)的Euron項(xiàng)目(The Research EURON Atelier on Roboethics),制作了第一個(gè)機(jī)器人倫理學(xué)路線圖。這里并未給出非常明確的路標(biāo),但是書(shū)中確實(shí)提出了關(guān)于機(jī)器倫理的各種挑戰(zhàn)、場(chǎng)景、原則和觀點(diǎn)。首次明確提出了在機(jī)器人倫理中考慮:“尊嚴(yán)、正義、公平、多元化、非歧視、自主權(quán)、隱私、利益分享、社會(huì)責(zé)任以及對(duì)生物圈的責(zé)任。比爾·希伯德(Bill Hibbard)在2014 年出版的著作《道德人工智能》,談到了他關(guān)于人工智能的看法。他認(rèn)為,由于人工智能將對(duì)人類(lèi)產(chǎn)生如此深遠(yuǎn)的影響,人工智能開(kāi)發(fā)人員是未來(lái)人類(lèi)的代表,因此有道德義務(wù)在他們的努力中保持透明。因此他主張?jiān)谌斯ぶ悄芩惴ê蛙浖a領(lǐng)域要采用開(kāi)源方式,這是對(duì)整個(gè)人類(lèi)負(fù)責(zé)的表現(xiàn)。而我們知道,從GPT-3開(kāi)始,OpenAI就不再開(kāi)源,違背了透明度原則,這也是讓人擔(dān)心的原因之一。

默奧大學(xué)計(jì)算機(jī)科學(xué)系的教授弗吉尼亞·迪格努姆 (Virginia Dignum) 在2018年3 月出版的《倫理與信息技術(shù)》上指出,機(jī)器人倫理有三個(gè)目標(biāo):1. 設(shè)計(jì)產(chǎn)生的倫理(Ethics by Design),指代倫理算法,是人工智能行為的表現(xiàn)基礎(chǔ)。2. 設(shè)計(jì)中的倫理(Ethics in Design),指代如何分析和評(píng)估設(shè)計(jì)的機(jī)器人是符合倫理的。3. 倫理化設(shè)計(jì)(Ethics for Design),也就是如何保證開(kāi)發(fā)設(shè)計(jì)的人員在前期研究、設(shè)計(jì)、構(gòu)建的過(guò)程中,能確保機(jī)器人倫理的實(shí)現(xiàn)。2019年,布里斯托爾機(jī)器人實(shí)驗(yàn)室的艾倫·溫菲爾德(Alan Winfield)提出,圖靈測(cè)試存在缺陷,人工智能通過(guò)測(cè)試的要求太低。一項(xiàng)替代測(cè)試被稱為道德圖靈測(cè)試,該測(cè)試將通過(guò)讓多名法官?zèng)Q定 AI 的決定是否符合道德或不道德來(lái)評(píng)判機(jī)器人,在圖靈測(cè)試中增加道德決策的權(quán)重。2019年,IEEE推出了自治系統(tǒng)透明度的 IEEE 標(biāo)準(zhǔn)。描述了可測(cè)量、可測(cè)試的透明度級(jí)別,以便可以客觀地評(píng)估自治系統(tǒng),并確定合規(guī)級(jí)別。不僅僅是標(biāo)準(zhǔn)組織,很多研究人員建議將政府監(jiān)管作為確保透明度的一種手段,并通過(guò)它來(lái)確保人類(lèi)的責(zé)任感。經(jīng)合組織、聯(lián)合國(guó)、歐盟和許多國(guó)家目前正在制定監(jiān)管人工智能的戰(zhàn)略,并尋找適當(dāng)?shù)姆煽蚣堋5陨峡隙ㄟ€遠(yuǎn)遠(yuǎn)不夠。

歐洲議會(huì)人工智能倫理領(lǐng)域顧問(wèn)安娜·費(fèi)蘭德近日表示:人類(lèi)已走到了關(guān)鍵的十字路口。在人工智能野蠻生長(zhǎng)的當(dāng)下,沒(méi)有一致的立法監(jiān)管,人工智能在實(shí)踐層面會(huì)面臨諸多挑戰(zhàn)。當(dāng)前世界需要對(duì)人工智能采取倫理學(xué)上的切實(shí)有效的考量。

過(guò)去這半年時(shí)間,仿佛世界一下子翻了一個(gè)個(gè)。以前從來(lái)不相信通用人工智能的人,都開(kāi)始擔(dān)心那個(gè)曾經(jīng)被雷·庫(kù)茲韋爾(Ray Kurzweil)預(yù)測(cè)的2045年的奇點(diǎn),會(huì)不會(huì)提前到來(lái),甚至?xí)粫?huì)突然的“智能爆炸”讓毫無(wú)準(zhǔn)備的人類(lèi)措手不及。所以,這種警覺(jué)的狀態(tài)已經(jīng)讓大多數(shù)人行動(dòng)起來(lái),樂(lè)觀來(lái)看,這應(yīng)該是值得欣慰的變化。

好了,今天我們先解讀到這里。關(guān)于英偉達(dá)的創(chuàng)始人兼CEO黃仁勛("Jensen" Huang)與OpenAI的聯(lián)合創(chuàng)始人兼首席科學(xué)家伊爾亞-蘇茨克維(Ilya Sutskever )的“爐邊談話”,我們一共花了六期來(lái)解讀,今天是終篇。解讀的觀點(diǎn)肯定存在片面和偏僻,歡迎大家批評(píng)指正。

<本系列完>

-

開(kāi)源技術(shù)

+關(guān)注

關(guān)注

0文章

389瀏覽量

7928 -

OpenHarmony

+關(guān)注

關(guān)注

25文章

3716瀏覽量

16274

原文標(biāo)題:河套IT TALK 77: (原創(chuàng)) 解讀老黃與Ilya的爐邊談話系列之六——ChatGPT未來(lái)將走向何方(萬(wàn)字長(zhǎng)文)

文章出處:【微信號(hào):開(kāi)源技術(shù)服務(wù)中心,微信公眾號(hào):共熵服務(wù)中心】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

單日獲客成本超20萬(wàn),國(guó)產(chǎn)大模型開(kāi)卷200萬(wàn)字以上的長(zhǎng)文本處理

NVIDIA助力企業(yè)用AI創(chuàng)建數(shù)據(jù)飛輪

解讀 MEMS 可編程 LVCMOS 振蕩器 SiT1602 系列:精準(zhǔn)頻率的創(chuàng)新之選

解讀 MEMS 可編程 LVCMOS 振蕩器 SiT8008 系列:精準(zhǔn)與靈活的時(shí)脈之選

NVIDIA CEO 黃仁勛對(duì)話 Meta CEO 馬克·扎克伯格:創(chuàng)作者將擁有個(gè)性化的 AI 助手

萬(wàn)字長(zhǎng)文淺談系統(tǒng)穩(wěn)定性建設(shè)

奇異摩爾攜手SEMiBAY Talk 邀您暢談互聯(lián)與計(jì)算

MiniMax推出“海螺AI”,支持超長(zhǎng)文本處理

OpenAI聯(lián)合創(chuàng)始人Ilya Sutskever宣布離職

黃仁勛工資多少錢(qián)?黃仁勛薪酬大漲到3420萬(wàn)美元

阿里通義千問(wèn)重磅升級(jí),免費(fèi)開(kāi)放1000萬(wàn)字長(zhǎng)文檔處理功能

“單純靠大模型無(wú)法實(shí)現(xiàn) AGI”!萬(wàn)字長(zhǎng)文看人工智能演進(jìn)

河套IT TALK 77: (原創(chuàng)) 解讀老黃與Ilya的爐邊談話系列之六——ChatGPT未來(lái)將走向何方(萬(wàn)字長(zhǎng)文)

河套IT TALK 77: (原創(chuàng)) 解讀老黃與Ilya的爐邊談話系列之六——ChatGPT未來(lái)將走向何方(萬(wàn)字長(zhǎng)文)

評(píng)論