模擬人類推理過程,華為諾亞提出 Progressive-Hint Prompting (PHP) 引導(dǎo)大模型漸近正確答案。

近期,華為聯(lián)和港中文發(fā)表論文《Progressive-Hint Prompting Improves Reasoning in Large Language Models》,提出Progressive-Hint Prompting(PHP),用來模擬人類做題過程。在 PHP 框架下,Large Language Model (LLM) 能夠利用前幾次生成的推理答案作為之后推理的提示,逐步靠近最終的正確答案。要使用 PHP,只需要滿足兩個(gè)要求:

問題能夠和推理答案進(jìn)行合并,形成新的問題;

模型可以處理這個(gè)新的問題,給出新的推理答案。

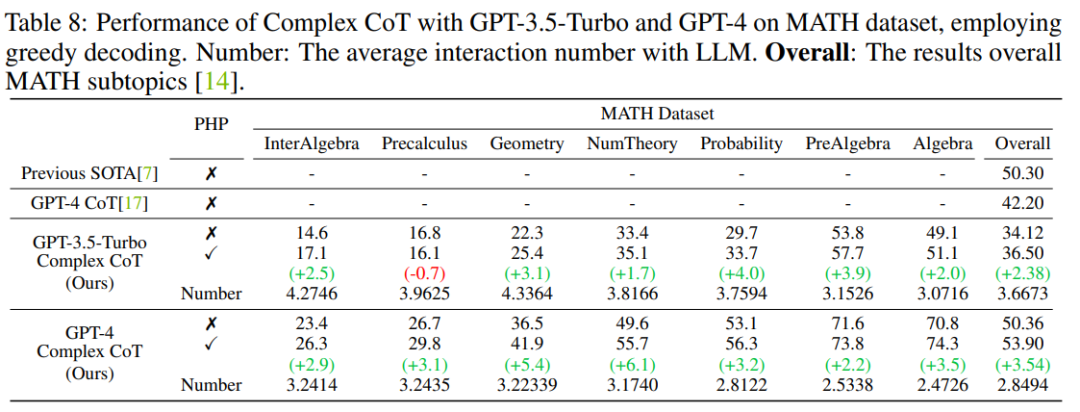

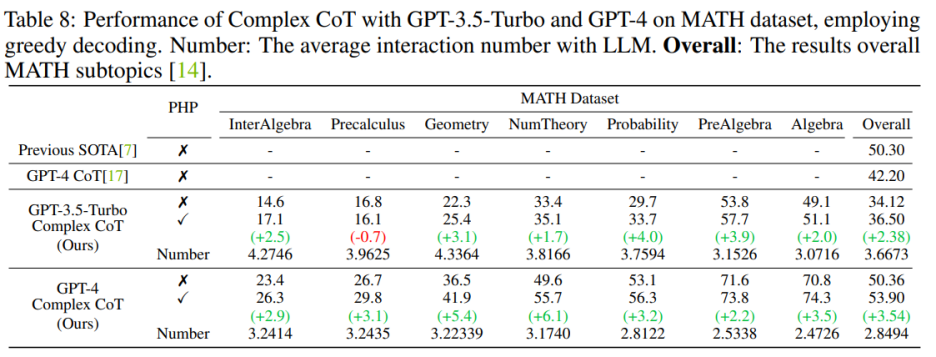

結(jié)果表明,GP-T-4+PHP 在多個(gè)數(shù)據(jù)集上取得了SOTA結(jié)果,包括 SVAMP (91.9%), AQuA (79.9%), GSM8K (95.5%) 以及 MATH (53.9%)。該方法大幅超過 GPT-4+CoT。比如,在現(xiàn)在最難的數(shù)學(xué)推理數(shù)據(jù)集 MATH 上,GPT-4+CoT 只有 42.5%,而 GPT-4+PHP 在 MATH 數(shù)據(jù)集的 Nember Theory (數(shù)論) 子集提升 6.1%, 將 MATH 整體提升到 53.9%,達(dá)到 SOTA。

論文鏈接:https://arxiv.org/abs/2304.09797

代碼鏈接:https://github.com/chuanyang-Zheng/Progressive-Hint

介紹

隨著 LLM 的發(fā)展,涌現(xiàn)了關(guān)于 prompting 的一些工作,其中有兩個(gè)主流方向:

一個(gè)以 Chain-Of-Thought( CoT,思維鏈) 為代表,通過清楚得寫下推理過程,激發(fā)模型的推理能力;

另一個(gè)以 Self-Consistency (SC) 為代表,通過采樣多個(gè)答案,然后進(jìn)行投票得到最終答案。

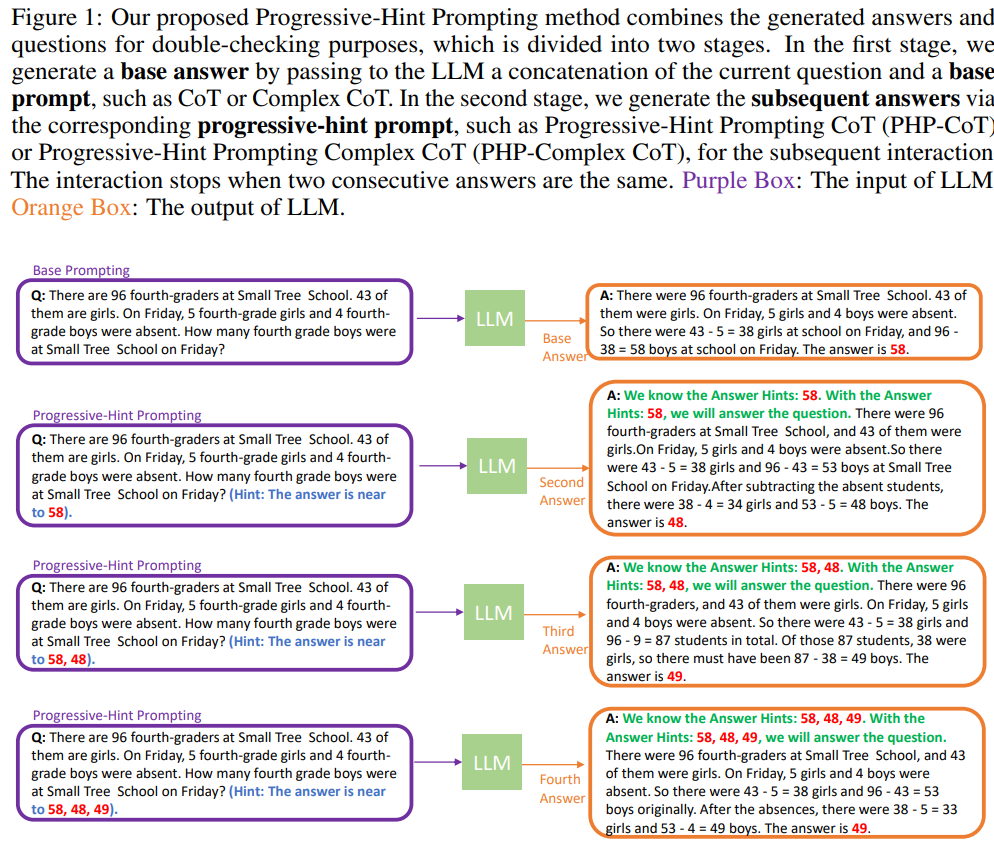

顯然,現(xiàn)存的兩種方法,沒有對(duì)問題進(jìn)行任何的修改,相當(dāng)于做了一遍題目之后就結(jié)束了,而沒有反過來帶著答案進(jìn)行再次檢查。PHP 嘗試模擬更加類人推理過程:對(duì)上次的推理過程進(jìn)行處理,然后合并到初始的問題當(dāng)中,詢問 LLM 進(jìn)行再次推理。當(dāng)最近兩次推理答案一致時(shí),得到的答案是準(zhǔn)確的,將返回最終答案。具體的流程圖如下所示:

在第一次與 LLM 交互的時(shí)候,應(yīng)當(dāng)使用 Base Prompting (基礎(chǔ)提示), 其中的 prompt(提示)可以是 Standard prompt,CoT prompt 或者其改進(jìn)版本。通過 Base Prompting,可以進(jìn)行第一次交互,然后得到初步的答案。在隨后的交互中,應(yīng)當(dāng)使用 PHP,直至最新的兩個(gè)答案一致。

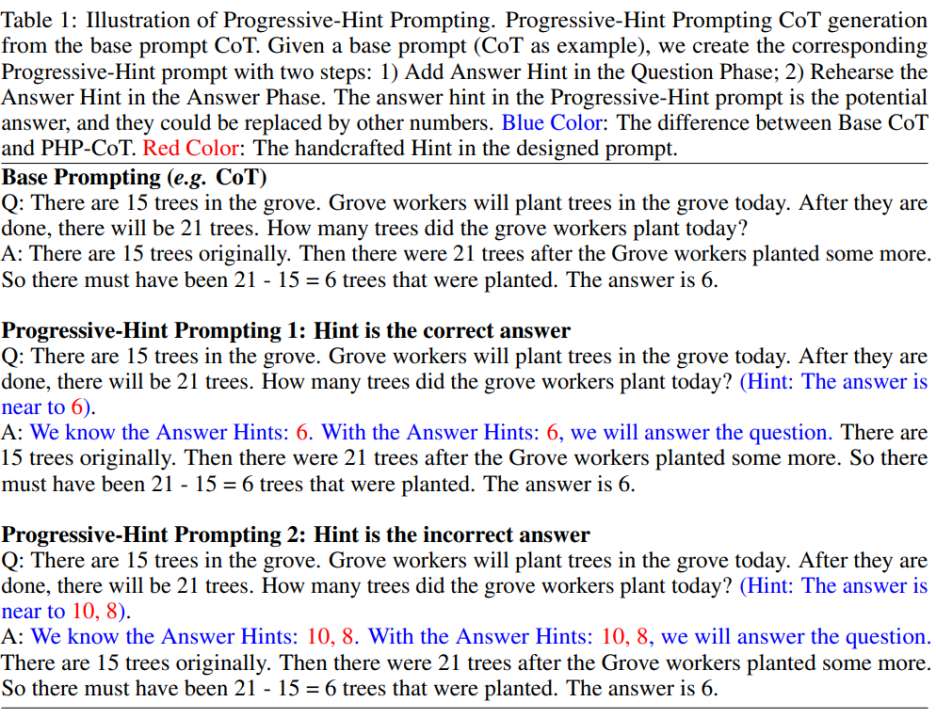

PHP prompt 基于 Base Prompt 進(jìn)行修改。給定一個(gè) Base Prompt,可以通過制定的 PHP prompt design principles 來得到對(duì)應(yīng)的 PHP prompt。具體如下圖所示:

作者希望PHP prompt能夠讓大模型學(xué)習(xí)到兩種映射模式:

1)如果給的 Hint 是正確答案,那么返回的答案依然要是正確答案 (具體如上圖所示的「Hint is the correct answer」);

2)如果給的 Hint 是錯(cuò)誤答案,那么 LLM 要通過推理,跳出錯(cuò)誤答案的 Hint,返回正確答案(具體如上圖所示的「Hint is the incorrect answer」)。

按照這種 PHP prompt 的設(shè)計(jì)規(guī)則,給定任意現(xiàn)存的 Base Prompt,作者都可以設(shè)定出對(duì)應(yīng)的 PHP Prompt。

實(shí)驗(yàn)

作者使用七個(gè)數(shù)據(jù)集,包括 AddSub、MultiArith、SingleEQ、SVAMP、GSM8K、 AQuA 和 MATH。同時(shí),作者一共使用了四個(gè)模型來驗(yàn)證作者的想法,包括 text-davinci-002、text-davinci-003、GPT-3.5-Turbo 和 GPT-4。

主要結(jié)果

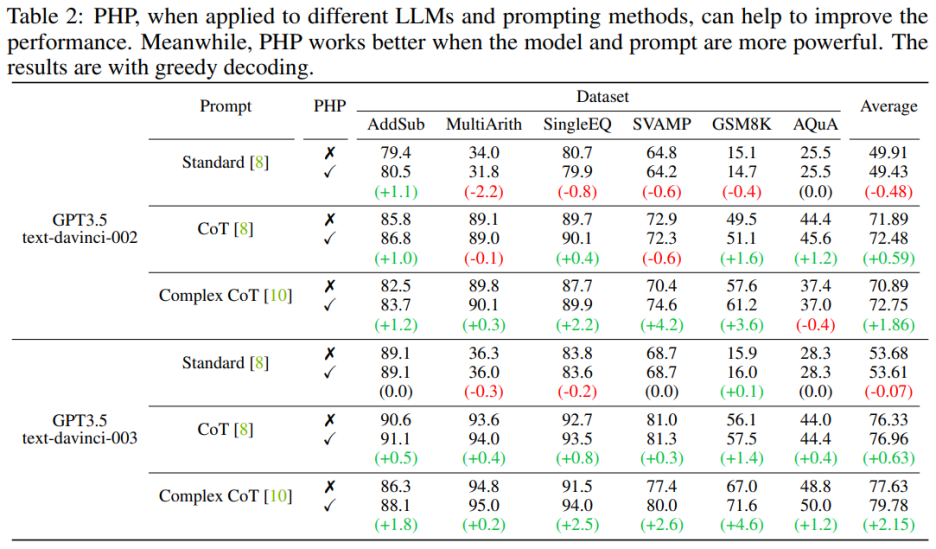

當(dāng)語言模型更強(qiáng)大、提示更有效時(shí),PHP 的效果更好。相比于 Standard Prompt 和 CoT Prompt,Complex CoT prompt 表現(xiàn)出了顯著的性能提升。分析還顯示,使用強(qiáng)化學(xué)習(xí)進(jìn)行微調(diào)的 text-davinci-003 語言模型比使用監(jiān)督指令微調(diào)的 text-davinci-002 模型表現(xiàn)更好,能夠提升文檔效果。text-davinci-003 的性能提高歸因于其增強(qiáng)的能力,使其更好地理解和應(yīng)用給定的提示。同時(shí),如果只是使用 Standard prompt,那么 PHP 所帶來的提升并不明顯。如果需要讓 PHP 起到效果,至少需要 CoT 來激發(fā)模型的推理能力。

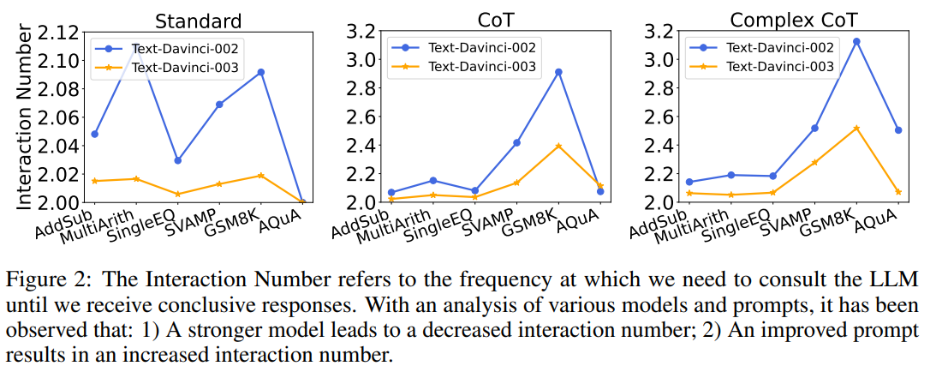

同時(shí),作者也探究了交互次數(shù)與模型、prompt 之間的關(guān)系。當(dāng)語言模型更強(qiáng)大,提示更弱時(shí),交互次數(shù)會(huì)減少。交互次數(shù)指代智能體與 LLMs 互動(dòng)的次數(shù)。當(dāng)收到第一個(gè)答案時(shí),交互次數(shù)為 1;收到第二個(gè)答案時(shí),交互次數(shù)增加到 2。在圖 2 中,作者展示了各種模型和提示的交互次數(shù)。作者的研究結(jié)果表明:

1)在給定相同提示的情況下,text-davinci-003 的交互次數(shù)通常低于 text-davinci-002。這主要是由于 text-davinci-003 的準(zhǔn)確性更高,導(dǎo)致基礎(chǔ)答案和后續(xù)答案的正確率更高,因此需要更少的交互才能得到最終的正確答案;

2)當(dāng)使用相同的模型時(shí),隨著提示變得更強(qiáng)大,交互次數(shù)通常會(huì)增加。這是因?yàn)楫?dāng)提示變得更有效時(shí),LLMs 的推理能力會(huì)得到更好的發(fā)揮,從而使它們能夠利用提示跳出錯(cuò)誤答案,最終導(dǎo)致需要更高的交互次數(shù)才能達(dá)到最終答案,這使得交互次數(shù)增加。

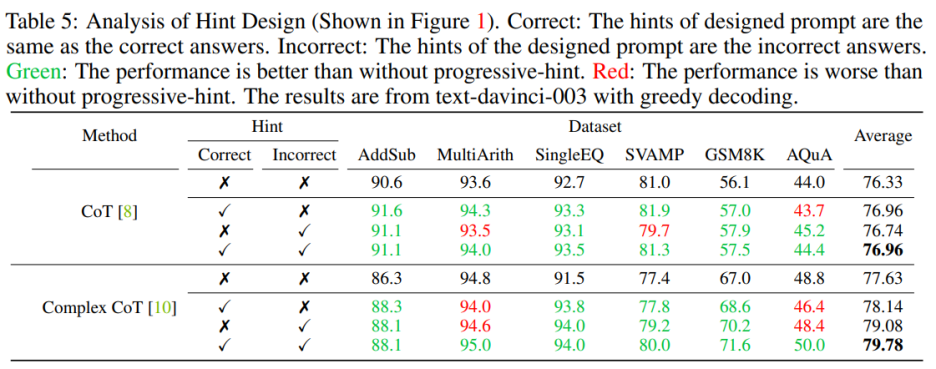

Hint 質(zhì)量的影響

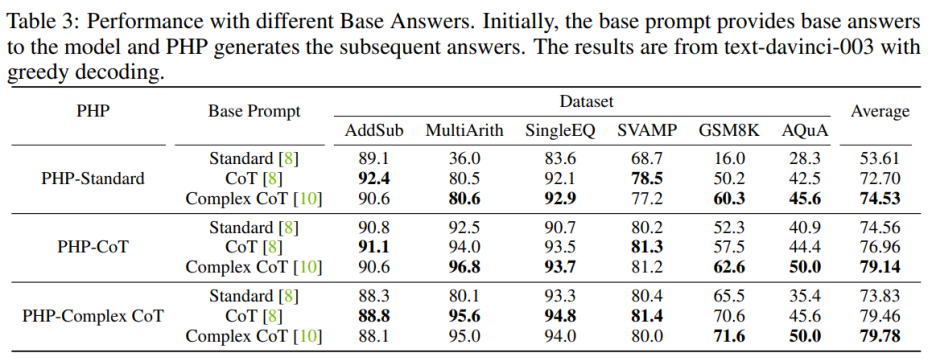

為了增強(qiáng) PHP-Standard 的性能,將 Base Prompt Standard 替換為 Complex CoT 或 CoT 可以顯著提高最終性能。對(duì) PHP-Standard 而言,作者觀察到在 Base Prompt Standard 下,GSM8K 的性能從 16.0% 提高到了在基礎(chǔ)提示 CoT 下的 50.2%,再提高到在基礎(chǔ)提示 Complex CoT 下的 60.3%。相反,如果將 Base Prompt Complex CoT 替換為 Standard,則最終性能會(huì)降低。例如,在將基礎(chǔ)提示 Complex CoT 替換為 Standard 后,PHP-Complex CoT 在 GSM8K 數(shù)據(jù)集上的性能從 71.6% 下降到了 65.5%。

如果 PHP 不是基于相應(yīng)的 Base Prompt 進(jìn)行設(shè)計(jì),那么效果可能進(jìn)一步提高。使用 Base Prompt Complex CoT 的 PHP-CoT 在六個(gè)數(shù)據(jù)集中的四個(gè)數(shù)據(jù)集表現(xiàn)優(yōu)于使用 CoT 的 PHP-CoT。同樣地,使用基礎(chǔ)提示 CoT 的 PHP-Complex CoT 在六個(gè)數(shù)據(jù)集中的四個(gè)數(shù)據(jù)集表現(xiàn)優(yōu)于使用 Base Prompt Complex CoT 的 PHP-Complex CoT。作者推推測(cè)這是因?yàn)閮煞矫娴脑颍?)在所有六個(gè)數(shù)據(jù)集上,CoT 和 Complex CoT 的性能相似;2)由于 Base Answer 是由 CoT(或 Complex CoT)提供的,而后續(xù)答案是基于 PHP-Complex CoT(或 PHP-CoT),這就相當(dāng)于有兩個(gè)人合作解決問題。因此,在這種情況下,系統(tǒng)的性能可能進(jìn)一步提高。

消融實(shí)驗(yàn)

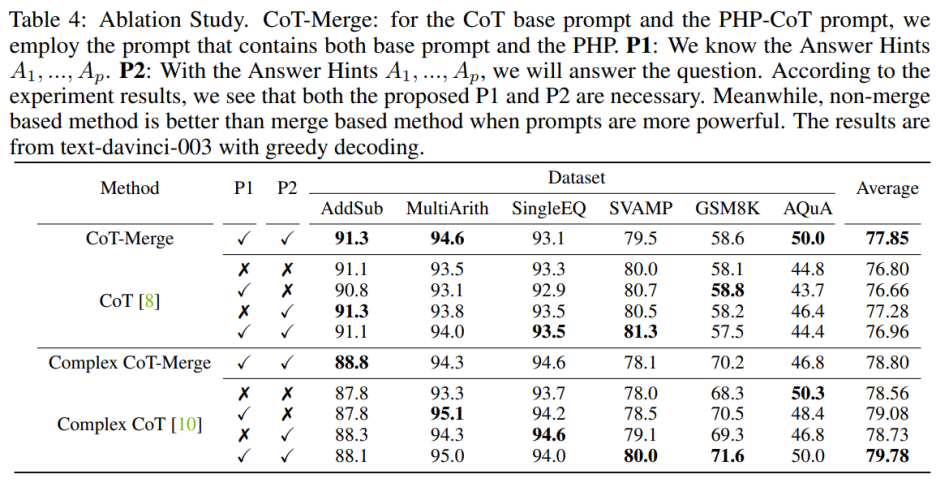

將句子 P1 和 P2 納入模型可以提高 CoT 在三個(gè)數(shù)據(jù)集上的表現(xiàn),但當(dāng)使用 Complex CoT 方法時(shí),這兩個(gè)句子的重要性尤為明顯。在加入 P1 和 P2 后,該方法在六個(gè)數(shù)據(jù)集中有五個(gè)數(shù)據(jù)集的表現(xiàn)得到了提升。例如,在 SVAMP 數(shù)據(jù)集上,Complex CoT 的表現(xiàn)從 78.0% 提高到了 80.0%,在 GSM8K 數(shù)據(jù)集上從 68.3% 提高到了 71.6%。這表明,尤其是在模型的邏輯能力更強(qiáng)時(shí),句子 P1 和 P2 的效果更為顯著。

在設(shè)計(jì)提示時(shí)需要同時(shí)包含正確和錯(cuò)誤的提示。當(dāng)設(shè)計(jì)的提示同時(shí)包含正確和錯(cuò)誤的提示時(shí),使用 PHP 的效果優(yōu)于不使用 PHP。具體來說,提示中提供正確的提示會(huì)促進(jìn)生成與給定提示相符的答案。相反,提示中提供錯(cuò)誤的提示則會(huì)通過給定的提示鼓勵(lì)生成其他答案

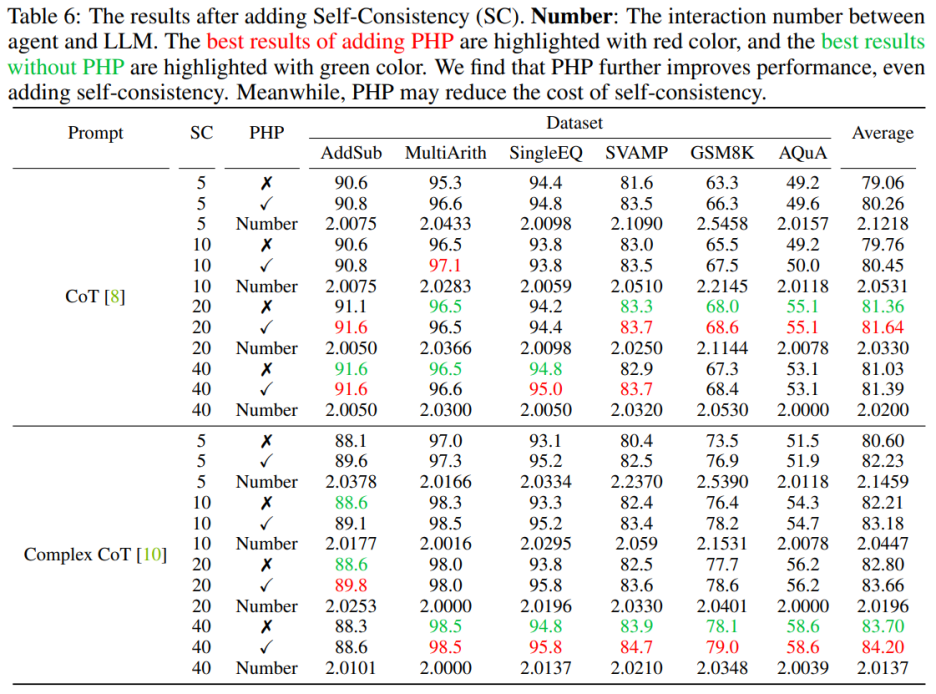

PHP+Self-Consistency

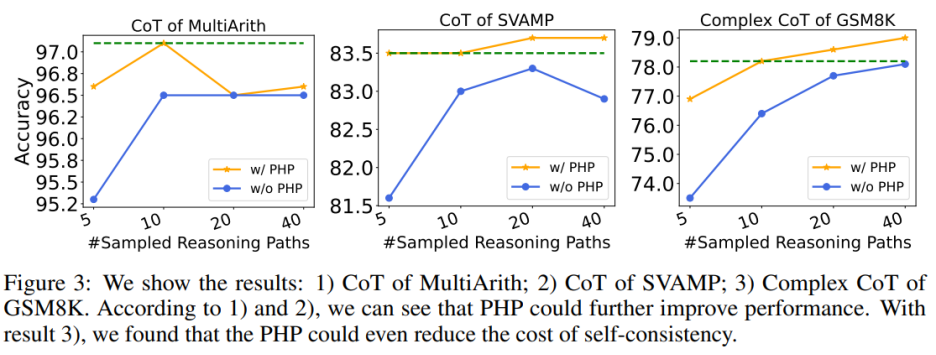

使用 PHP 可以進(jìn)一步提高性能。通過使用類似的提示和樣本路徑數(shù)量,作者發(fā)現(xiàn)在表 6 和圖 3 中,作者提出的 PHP-CoT 和 PHP-Complex CoT 總是比 CoT 和 Complex CoT 表現(xiàn)更好。例如,CoT+SC 的樣本路徑為 10、20 和 40 時(shí),能夠在 MultiArith 數(shù)據(jù)集上達(dá)到 96.5% 的準(zhǔn)確率。因此,可以得出結(jié)論,CoT+SC 的最佳性能為 96.5%,使用 text-davinci-003。然而,在實(shí)施 PHP 之后,性能升至 97.1%。同樣,作者還觀察到在 SVAMP 數(shù)據(jù)集上,CoT+SC 的最佳準(zhǔn)確率為 83.3%,在實(shí)施 PHP 后進(jìn)一步提高到 83.7%。這表明,PHP 可以打破性能瓶頸并進(jìn)一步提高性能。

使用 PHP 可以降低 SC 的成本,眾所周知,SC 涉及更多的推理路徑,導(dǎo)致成本更高。表 6 說明,PHP 可以是降低成本的有效方法,同時(shí)仍保持性能增益。如圖 3 所示,使用 SC+Complex CoT,可以使用 40 個(gè)樣本路徑達(dá)到 78.1% 的準(zhǔn)確率,而加入 PHP 將所需平均推理路徑降低到 10×2.1531=21.531 條路徑,并且結(jié)果更好,準(zhǔn)確率達(dá)到了 78.2%。

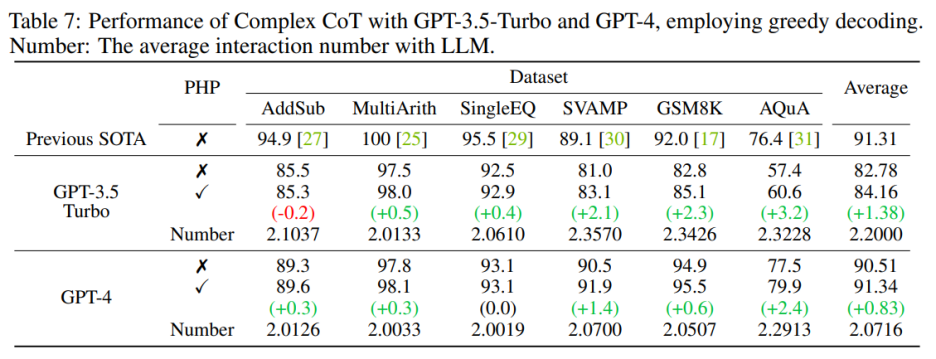

GPT-3.5-Turbo 和 GPT-4

作者按照以前的工作設(shè)置,使用文本生成模型進(jìn)行實(shí)驗(yàn)。隨著 GPT-3.5-Turbo 和 GPT-4 的 API 發(fā)布,作者在相同的六個(gè)數(shù)據(jù)集上驗(yàn)證了具有 PHP 的 Complex CoT 的性能。作者對(duì)這兩個(gè)模型都使用貪心解碼(即溫度 = 0)和 Complex CoT 作為提示。

如表 7 所示,提出的 PHP 增強(qiáng)了性能,在 GSM8K 上提高了 2.3%,在 AQuA 上提高了 3.2%。然而,與 text-davinci-003 相比,GPT-3.5-Turbo 表現(xiàn)出對(duì)提示的依附能力降低。作者提供了兩個(gè)例子來說明這一點(diǎn):

a)在提示缺失的情況下,GPT-3.5-Turbo 無法回答問題,并回復(fù)類似于 “由于答案提示缺失,我無法回答此問題。請(qǐng)?zhí)峁┐鸢柑崾疽岳^續(xù)” 的聲明。相比之下,text-davinci-003 在回答問題之前會(huì)自主生成并填充缺失的答案提示;

b)當(dāng)提供超過十個(gè)提示時(shí),GPT-3.5-Turbo 可能會(huì)回復(fù) “由于給出了多個(gè)答案提示,我無法確定正確的答案。請(qǐng)為問題提供一個(gè)答案提示。”

在部署 GPT-4 模型后,作者能夠在 SVAMP、GSM8K、AQuA 和 MATH 基準(zhǔn)測(cè)試上實(shí)現(xiàn)新的 SOTA 性能。作者提出的 PHP 方法不斷改善了 GPT-4 的性能。此外,與 GPT-3.5-Turbo 模型相比,作者觀察到 GPT-4 所需的交互次數(shù)減少了,這與 “當(dāng)模型更加強(qiáng)大時(shí),交互次數(shù)會(huì)減少” 的發(fā)現(xiàn)相一致。

總結(jié)

本文介紹了 PHP 與 LLMs 交互的新方法,具有多個(gè)優(yōu)點(diǎn):

1)PHP 在數(shù)學(xué)推理任務(wù)上實(shí)現(xiàn)了顯著的性能提升,在多個(gè)推理基準(zhǔn)測(cè)試上領(lǐng)先于最先進(jìn)的結(jié)果;

2)使用更強(qiáng)大的模型和提示,PHP 可以更好地使 LLMs 受益;

3)PHP 可以與 CoT 和 SC 輕松結(jié)合,進(jìn)一步提高性能。

為了更好地增強(qiáng) PHP 方法,未來的研究可以集中在改進(jìn)問題階段的手工提示和答案部分的提示句子的設(shè)計(jì)上。此外,除了將答案當(dāng)作 hint,還可以確定和提取有助于 LLMs 重新考慮問題的新 hint。

審核編輯 :李倩

-

模型

+關(guān)注

關(guān)注

1文章

3500瀏覽量

50105 -

PHP

+關(guān)注

關(guān)注

0文章

454瀏覽量

27322 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25315

原文標(biāo)題:華為諾亞提出新型Prompting (PHP),GPT-4拿下最難數(shù)學(xué)推理數(shù)據(jù)集新SOTA

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

OpenAI宣布GPT 4o升智計(jì)劃

OpenAI即將發(fā)布GPT-4.5與GPT-5

GPT架構(gòu)及推理原理

中國電提出大模型推理加速新范式Falcon

麻省理工學(xué)院推出新型機(jī)器人訓(xùn)練模型

訊飛星火大模型技術(shù)進(jìn)展及落地

Llama 3 與 GPT-4 比較

科大訊飛發(fā)布訊飛星火4.0 Turbo:七大能力超GPT-4 Turbo

OpenAI即將發(fā)布“草莓”推理大模型

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

OpenAI揭秘CriticGPT:GPT自進(jìn)化新篇章,RLHF助力突破人類能力邊界

OpenAI推出新模型CriticGPT,用GPT-4自我糾錯(cuò)

OpenAI API Key獲取:開發(fā)人員申請(qǐng)GPT-4 API Key教程

評(píng)論