大型語言模型能力驚人,但在部署過程中往往由于規模而消耗巨大的成本。華盛頓大學聯合谷歌云計算人工智能研究院、谷歌研究院針對該問題進行了進一步解決,提出了逐步蒸餾(Distilling Step-by-Step)范式幫助模型訓練。該方法在訓練用于特定任務的小型模型方面優于 LLM,訓練數據遠少于傳統的微調和蒸餾。他們的 770M T5 模型在一個基準任務上表現優于 540B PaLM 模型。令人印象深刻的是,他們的模型只使用了可用數據的 80%。

雖然大型語言模型(LLMs)展現了令人印象深刻的少樣本學習能力,但將這樣大規模的模型部署在現實應用中是很難的。為 1750 億參數規模的 LLM 提供服務的專門基礎設施,至少需要 350GB 的 GPU 內存。更甚者,現今最先進的 LLM 是由超過 5000 億的參數組成的,這意味著它需要更多的內存和計算資源。這樣的計算要求對于大多數生產商來說都是難以企及的,更何況是要求低延遲的應用了。

為了解決大型模型的這個問題,部署者往往采用小一些的特定模型來替代。這些小一點的模型用常見范式 —— 微調或是蒸餾來進行訓練。微調使用下游的人類注釋數據升級一個預訓練過的小模型。蒸餾用較大的 LLM 產生的標簽訓練同樣較小的模型。但是很遺憾,這些范式在縮小模型規模的同時也付出了代價:為了達到與 LLM 相當的性能,微調需要昂貴的人類標簽,而蒸餾需要大量很難獲得的無標簽數據。

在一篇題為「Distilling Step-by-Step! Outperforming Larger Language Models with Less Training Data and Smaller Model Sizes」的論文中,來自華盛頓大學、谷歌的研究者引入了一種新的簡單機制 —— 逐步蒸餾(Distilling step-bystep),用于使用更少的訓練數據來訓練更小的模型。這種機制減少了微調和蒸餾 LLM 所需的訓練數據量,使之有更小的模型規模。

論文鏈接:https://arxiv.org/pdf/2305.02301v1.pdf

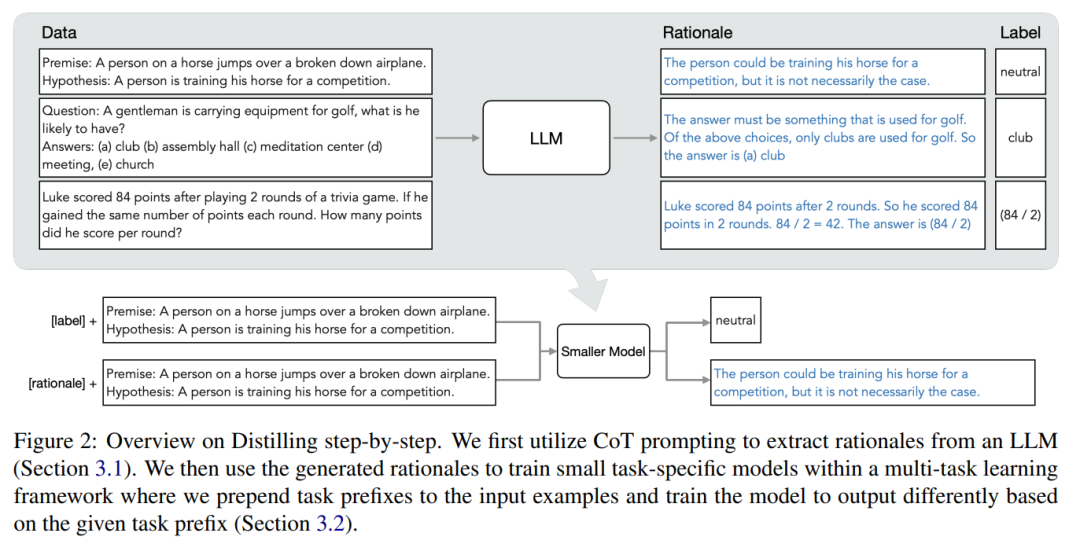

該機制的核心是換一種角度,將 LLM 看作是可以推理的 agent,而不是噪聲標簽的來源。LLM 可以產生自然語言的理由(rationale),這些理由可以用來解釋和支持模型所預測的標簽。例如,當被問及「一位先生攜帶著打高爾夫球的設備,他可能有什么?(a) 球桿,(b) 禮堂,(c) 冥想中心,(d) 會議,(e) 教堂」,LLM 可以通過思維鏈(CoT)推理回答出「(a)球桿」,并通過說明「答案一定是用來打高爾夫球的東西」來合理化這個標簽。在上述選擇中,只有球桿是用來打高爾夫的。研究者使用這些理由作為額外更豐富的信息在多任務訓練設置中訓練較小的模型,并進行標簽預測和理由預測。

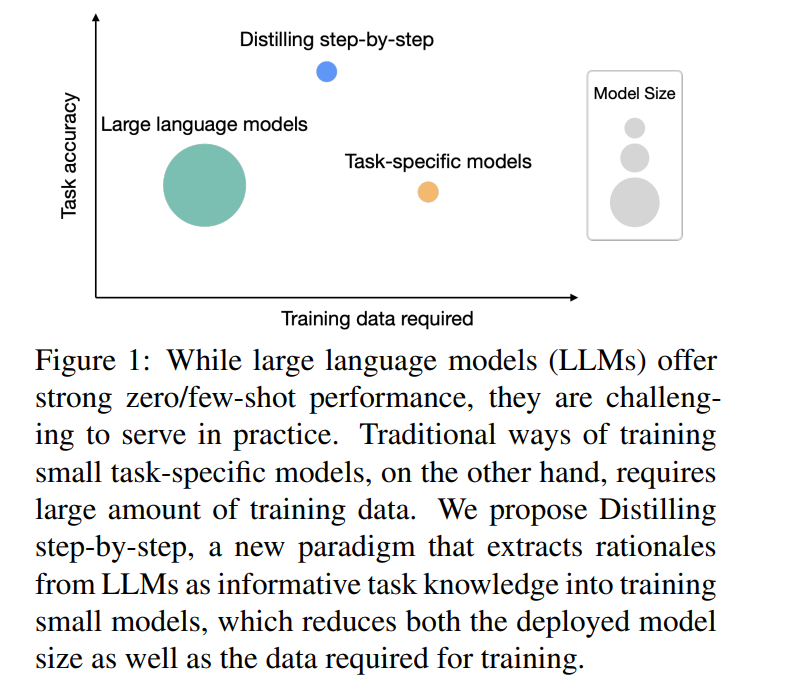

如圖 1 所示,逐步蒸餾可以學習特定任務的小模型,這些模型的參數量還不到 LLM 的 1/500。與傳統的微調或蒸餾相比,逐步蒸餾使用的訓練示例要也少得多。

實驗結果顯示,在 4 個 NLP 基準中,有三個有希望的實驗結論。

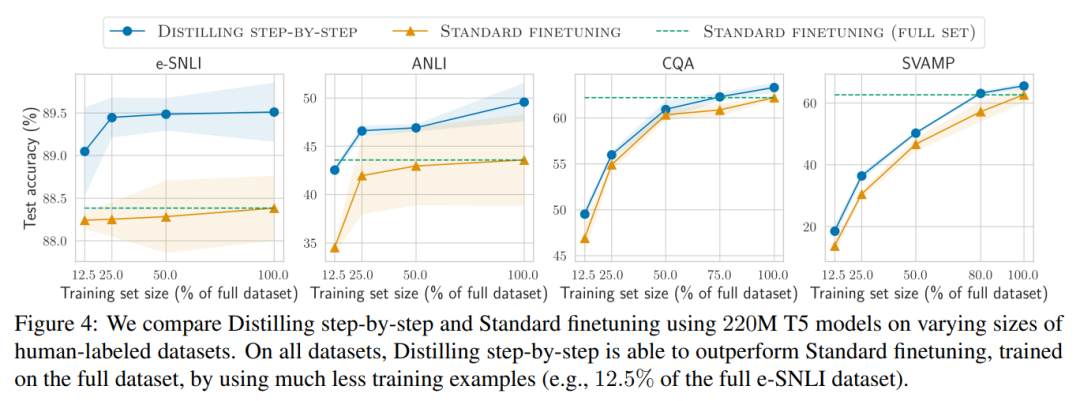

第一,相對于微調和蒸餾,逐步蒸餾模型在各數據集上實現了更好的性能,平均減少了 50% 以上的訓練實例(最多可減少 85% 以上)。

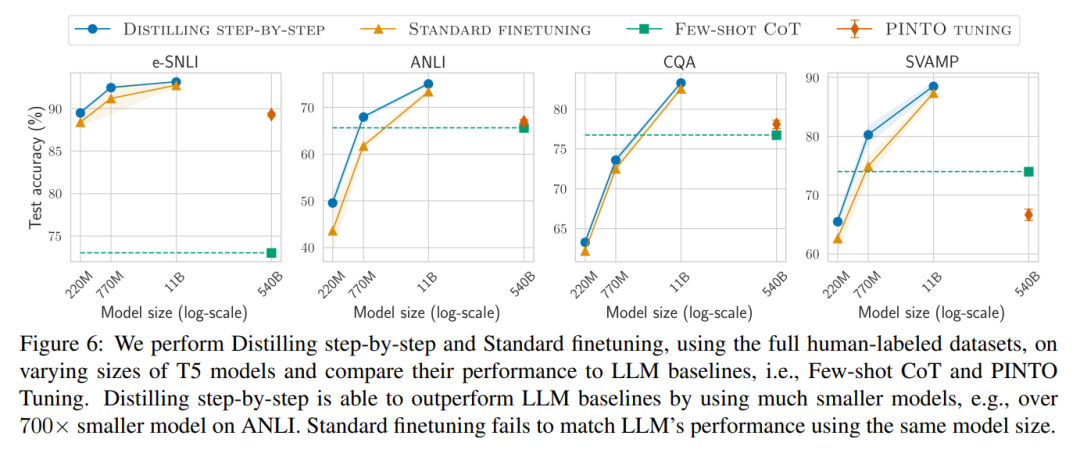

第二,我們的模型在模型尺寸更小的情況下表現優于 LLM(最多可以小到 2000 倍),極大地降低了模型部署所需的計算成本。

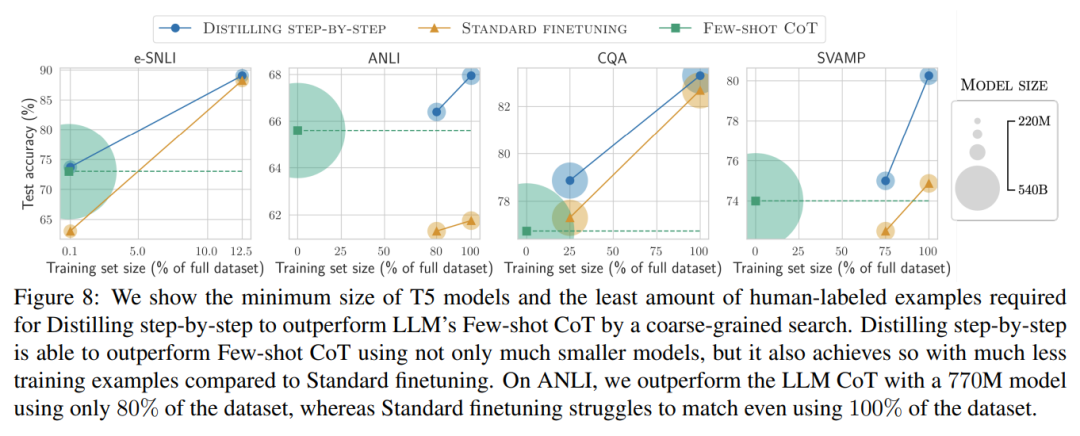

第三,該研究在縮減模型尺寸的同時,也減少了超越 LLM 所需要的數據量。研究者使用一個 770M 的 T5 模型超越了 540B 參數的 LLM 的性能。這個較小的模型只使用了現有微調方法 80% 的標記數據集。

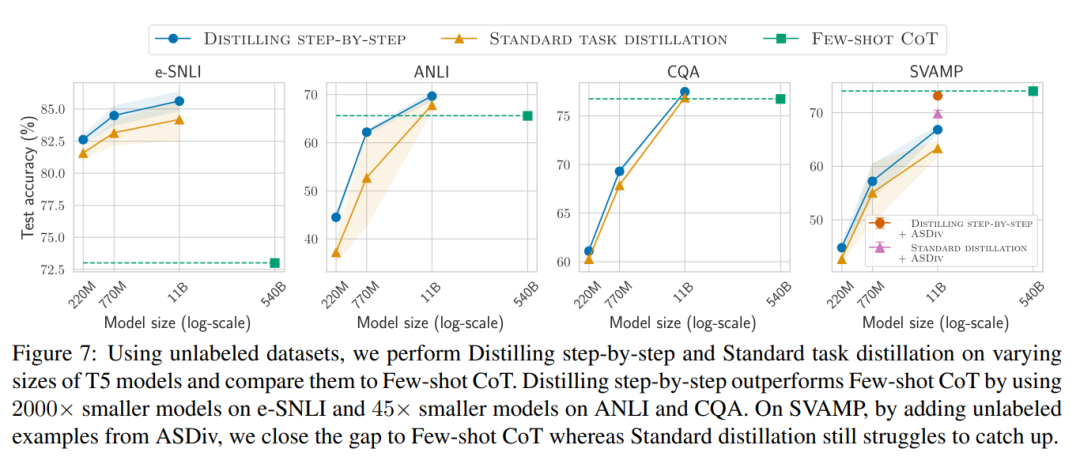

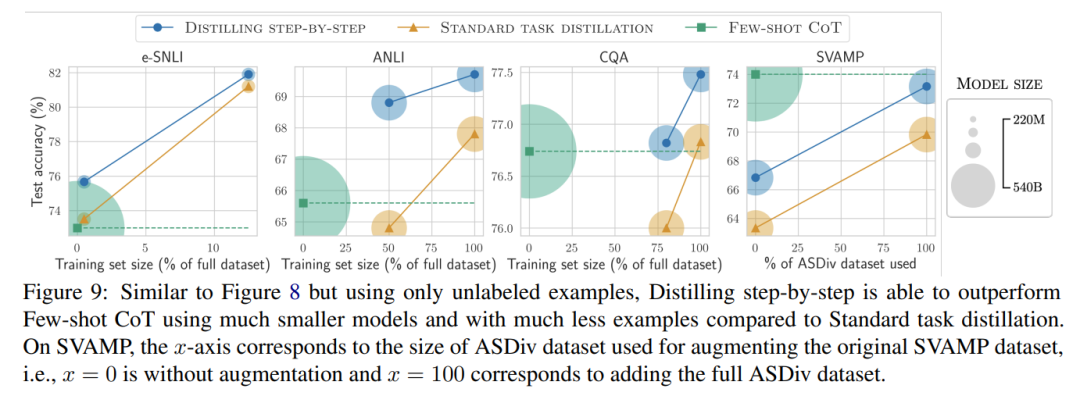

當只有未標記的數據時,小模型的表現相比 LLM 而言仍然有過之而無不及 —— 只用一個 11B 的 T5 模型就超過了 540B 的 PaLM 的性能。

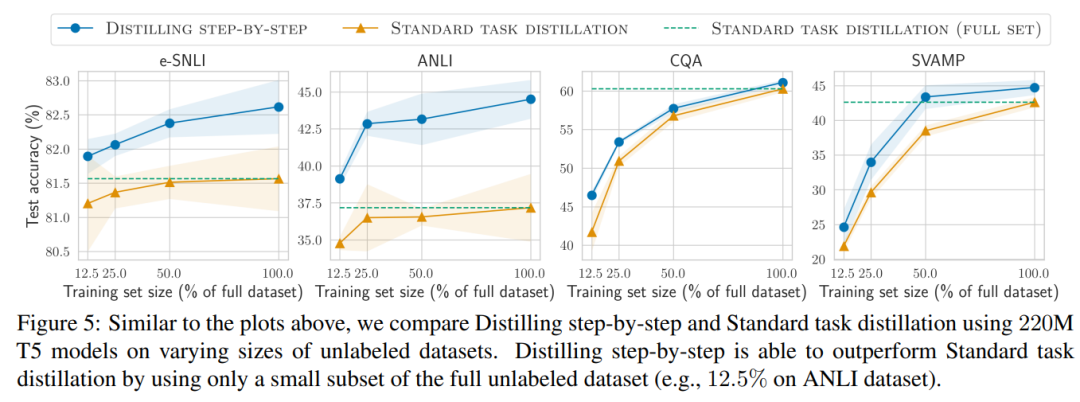

該研究進一步表明,當一個較小的模型表現比 LLM 差時,與標準的蒸餾方法相比,逐步蒸餾可以更有效地利用額外的無標簽數據來使較小的模型媲美 LLM 的性能。

逐步蒸餾

研究者提出了逐步蒸餾這個新范式,是利用 LLM 對其預測的推理能力,以數據高效率的方式訓練更小的模型。整體框架如圖 2 所示。

該范式有兩個簡單的步驟:首先,給定一個 LLM 和一個無標簽的數據集,提示 LLM 生成輸出標簽以及證明該標簽成立的理由。理由用自然語言解釋,為模型預測的標簽提供支持(見圖 2)。理由是當前自監督 LLM 的一個涌現的行為屬性。

然后,除了任務標簽之外,利用這些理由來訓練更小的下游模型。說白了,理由能提供了更豐富、更詳細的信息,來說明一個輸入為什么被映射到一個特定的輸出標簽。

實驗結果

研究者在實驗中驗證了逐步蒸餾的有效性。首先,與標準的微調和任務蒸餾方法相比,逐步蒸餾有助于實現更好的性能,訓練實例的數量少得多,大幅提高了學習小型特定任務模型的數據效率。

其次,研究表明,逐步蒸餾方法以更小的模型大小超越了 LLM 的性能,與 llm 相比,大大降低了部署成本。

最后,研究者調查了逐步蒸餾方法在超過 LLM 的性能方面所需的最低資源,包括訓練示例數量和模型大小。他們展示了逐步蒸餾方法通過使用更少的數據和更小的模型,同時提高了數據效率和部署效率。

審核編輯 :李倩

-

人工智能

+關注

關注

1791文章

47206瀏覽量

238274 -

語言模型

+關注

關注

0文章

521瀏覽量

10268 -

自然語言

+關注

關注

1文章

288瀏覽量

13347

原文標題:蒸餾也能Step-by-Step:新方法讓小模型也能媲美2000倍體量大模型

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯網技術研究所】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

Altium19 3D STEP模型的導出

Kicad6.0導出step模型遇到無法導出元件的問題

STEP與WRL 3D模型的區別

keras順序模型與函數式模型

如何使用STEP-BY-STEP在KEIL5中建立TM4C1294項目

STM32 Step-by-Step如何加快開發速度

Altium Designer導出3D STEP模型的方法

南開/南理工/曠視提出CTKD:動態溫度超參蒸餾新方法

大模型應用Step-By-Step

蒸餾也能Step-by-Step:新方法讓小模型也能媲美2000倍體量大模型

蒸餾也能Step-by-Step:新方法讓小模型也能媲美2000倍體量大模型

評論