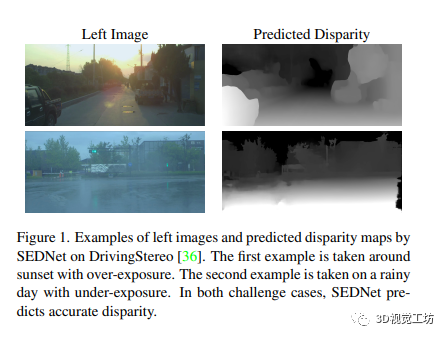

本文提出了一種新的深度立體匹配中用于聯合視差和不確定性估計的損失函數。在神經網絡中加入KL散度項,要求不確定性分布匹配視差誤差分布,以實現精確的不確定性估計。使用可微的軟直方圖技術來近似分布,并在損失函數中使用。該方法在大型數據集上獲得了顯著的改進。作為cvpr2023最新的文章,非常值得閱讀一下。

1 前言

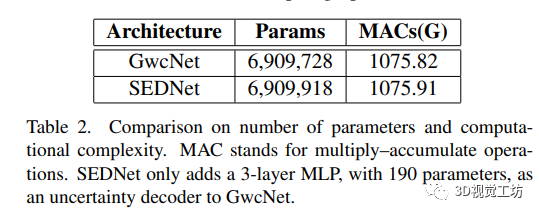

本文提出了SEDNet,一種用于視差和基礎不確定性聯合估計的深度網絡。SEDNet包括一個新穎的、輕量級的不確定性估計子網絡,將不確定度的分布與視差誤差的分布相匹配。為了生成這個新的損失函數的輸入,作者使用可微的軟直方圖技術以可微分的方式近似分布。在具有真實值的大型數據集上對SEDNet的視差估計和不確定度預測的性能進行了廣泛的實驗驗證。SEDNet優于具有相似架構但沒有提出的損失函數的基線。

主要貢獻是:

一個新穎的不確定性估計子網絡,從視差子網絡生成的中間多分辨率視差圖中提取信息。

一種可微的軟直方圖技術,用于近似視差誤差和估計不確定性的分布。

一種基于KL散度的損失,應用于使用上述技術獲得的直方圖。

2 相關背景

立體匹配網絡在一種稱為成本體積(cost volume)的體積上運行,該體積在每個像素處匯聚每個可能視差處的二維特征,并可以通過相關或串聯來構建。DispNetC、iResNet和SegStereo等基于相關的網絡生成兩個視圖中提取的特征的單通道相關地圖,在各視差層中,利用有效的計算流程犧牲結構和語義信息在特征表示中。GCNet、PSMNet和GANet等基于串聯的網絡在成本體積的對應元素所指定的視差處組裝兩個視圖的特征。這有助于學習上下文特征,但需要更多的參數以及一個后續的聚合網絡。在置信度估計方面,將置信度和不確定度區分開來,包括置信度CNN、PBCP、EFN、LFN和MMC等方法,以及ConfNet、LGC和LAF等利用圖像和視差圖作為輸入的方法。KL散度用于測量變分推斷估計的網絡參數分布的近似和精確后驗分布之間的距離。(需要注意的是,在分配離散度誤差的分布上,作者使用了KL散度來實現完全不同的目的。)

3 方法

本文旨在聯合估計視差和不確定性,通過最小化預測不確定性和實際視差誤差之間的差異來訓練網絡。其中,預測模型的損失函數為KL散度損失,用于匹配誤差分布和不確定性分布。立體匹配網絡通過學習聯合公式預測比單獨的視差估計器更準確的視差。

3.1 Aleatoric Uncertainty Estimation - 隨機不確定性估計

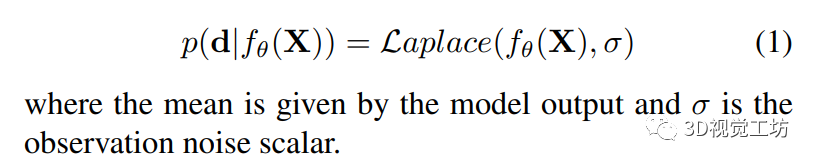

為了預測不確定性并降低噪聲的影響,Kendall和Gal通過最小化模型輸出的負對數似然來實現像素級的預測。模型假設輸出服從高斯分布。Ilg等人的后續工作表明,預測的分布可以分別模擬為拉普拉斯分布或高斯分布,具體取決于是對視差估計采用L1損失還是L2損失。由于作者采用的是前者,因此可以將預測模型表示為:

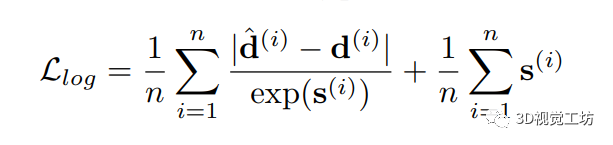

為了模擬算法不確定性,Kendall和Gal引入了像素特定的噪聲參數σ(i)。作者采用了Ilg等人在構建拉普拉斯模型時使用的方法,并獲得了以下像素級損失函數:

該式可以被視為魯棒損失函數,其中像素的殘差損失受其不確定性的影響而減弱,而第二項則作為正則化項。訓練網絡來預測觀測噪聲標量的對數s,以保證數值穩定性。

3.2 Matching the Distribution of Errors - 誤差分布的匹配

這部分作者討論了調整不確定性分布以匹配誤差分布的問題。采用KL散度作為衡量二者之間差異的度量,但直接最小化KL散度需要兩個分布的歸納公式。為此作者使用直方圖來表示分布,同時采用軟直方圖使其可微分。對于每個批次訓練,基于誤差值的統計量創建一個直方圖。作者對獨立的不確定性采用相同的直方圖參數,并使用反比例權重的softmax函數來計算每個誤差值或不確定性貢獻的直方圖值。最后,該直方圖的KL損失用于網絡的訓練。

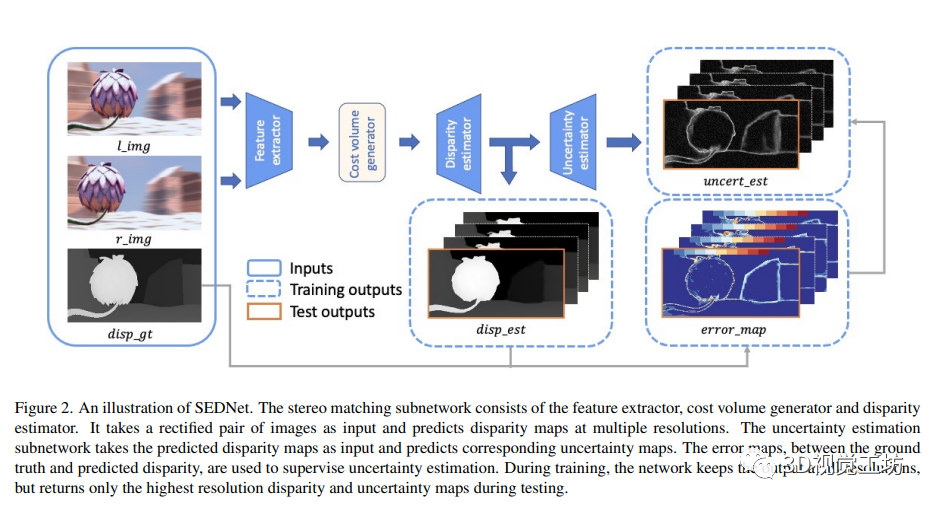

3.3 SEDNet

SEDNet是一個包括視差估計和不確定性估計子網絡的網絡體系結構。其中視差估計子網絡采用GwcNet,GwcNet子網絡使用類似ResNet的特征提取器從圖像中提取特征,生成代價體積,并使用soft-argmax運算符為像素分配視差。視差預測器的輸出模塊在不同分辨率下生成K個視差圖。不確定性估計子網絡學習預測每個像素的觀測噪聲標量的對數誤差。為了計算不確定性圖像,作者提出了使用像素對差分向量(PDV)的多分辨率視差預測的新方法。視差估計器輸出的視差圖首先進行上采樣處理,然后進行成對差分以形成PVD。其中,PVD表示像素對之間的視差差異。

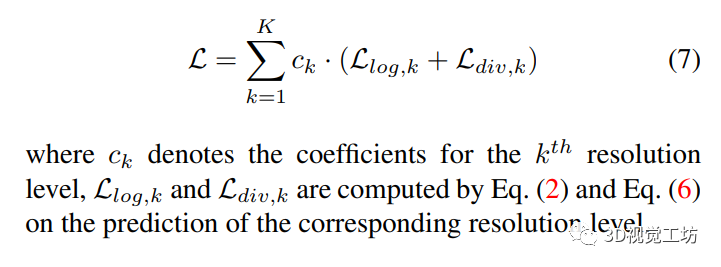

3.4 Loss Function - 損失函數

本文所使用的損失函數由兩部分組成:對數似然損失和KL散度損失。其中對數似然損失用于優化誤差和不確定性,KL散度損失用于匹配不確定性分布和誤差。總損失將所有視差和不確定性圖像考慮在內,上采樣到最高分辨率,并通過每個分辨率級別的系數對不同分辨率級別的對數似然損失和KL散度損失進行加權計算。

4 實驗

4.1 數據集和評估指標

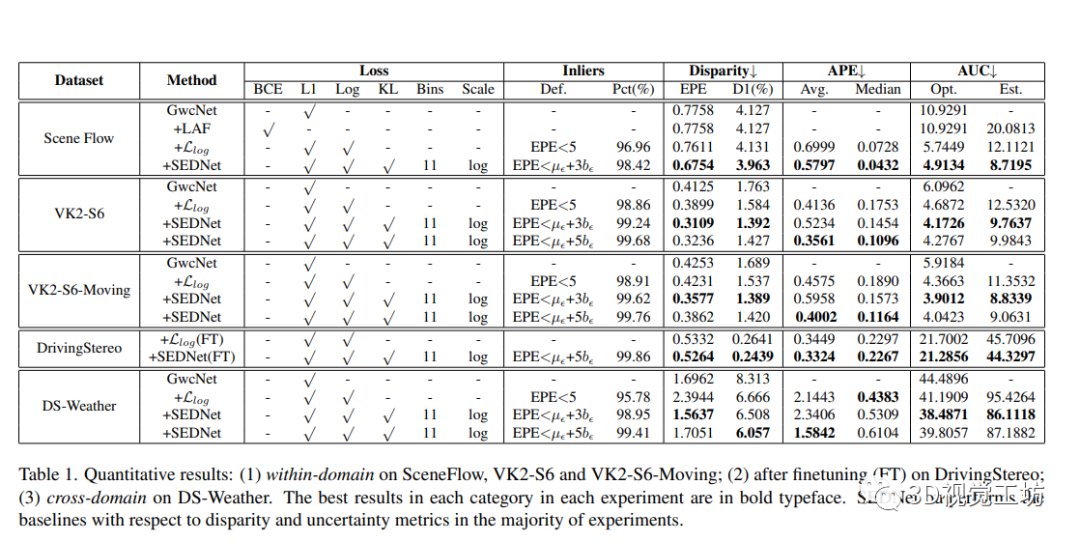

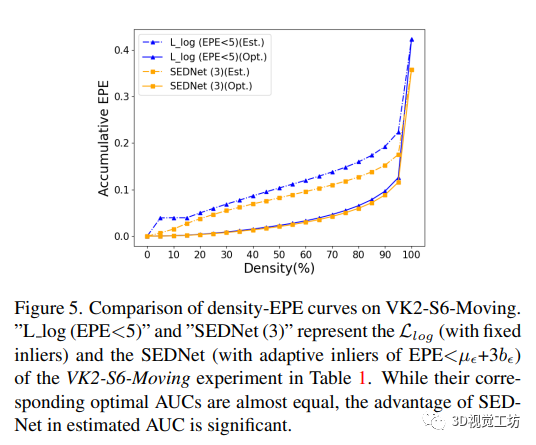

這部分作者介紹了多個用于立體圖像深度估計的數據集和評估指標。其中SceneFlow、Virtual KITTI 2和DrivingStereo是當前被廣泛使用的三個數據集。作者使用端點誤差(EPE)和異常值百分數(D1)來評估視差估計的準確度,并使用密度-EPE ROC曲線和曲線下的面積(AUC)來評估不確定性估計。本文還比較了SEDNet和三個基線:原始GwcNet、LAF-Net和僅使用對數似然損失的SEDNet。

4.2 實施細節

作者在PyTorch中實現了所有網絡,并對所有實驗使用了Adam優化器,其中β1 = 0.9,β2 = 0.999。在所有模型過擬合之前停止訓練。

在VK2數據集上的實驗是在兩個NVIDIA RTX A6000 GPU上執行的,每個GPU都帶有48GB的RAM。對于此數據集,使用初始學習率為0.0001從頭訓練了所有模型,在每10個epoch后降低了5個。在訓練過程中,從圖像中隨機裁剪了512×256的補丁。在測試期間,在VK2的完整分辨率上評估。

歡迎關注微信公眾號「3D視覺工坊」,加群/文章投稿/課程主講,請加微信:dddvisiona,添加時請備注:加群/投稿/主講申請

方向主要包括:3D視覺領域各細分方向,比如相機標定|三維點云|三維重建|視覺/激光SLAM|感知|控制規劃|模型部署|3D目標檢測|TOF|多傳感器融合|AR|VR|編程基礎等。

對于DrivingStereo數據集(DS),坐這兒也在兩個NVIDIA RTX A6000 GPU上進行了實驗。對于此數據集,使用在VK2上預訓練的模型進行了兩個實驗:(1)在DS訓練集上進行微調,學習率從0.0001開始,在第10個epoch后每3個epoch降低2次學習率,然后在DS測試集上進行領域內評估;(2)跳過微調步驟,并在DS-Weather子集上進行跨域評估。在訓練期間,作者隨機裁剪了與VK2實驗相同大小的輸入。在測試期間,作者對測試樣本進行了填充,使其分辨率與VK2相同。

在SceneFlow數據集上的實驗是在一臺具有24 GB內存的Nvidia TITAN RTX GPU上進行的。作者從半分辨率圖像中裁剪了256×128的補丁來限制內存消耗,并將初始學習率設置為0.001,在第10個epoch后每2個epoch降低2次學習率。

4.3 定性和定量結果

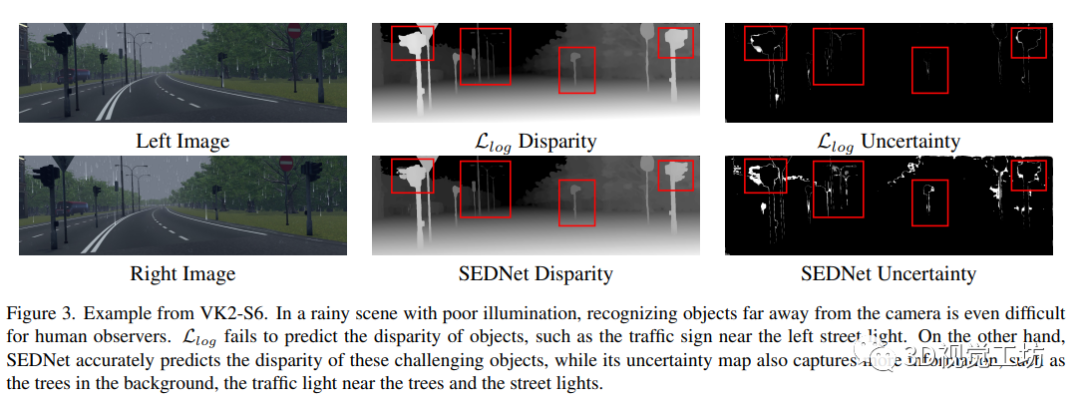

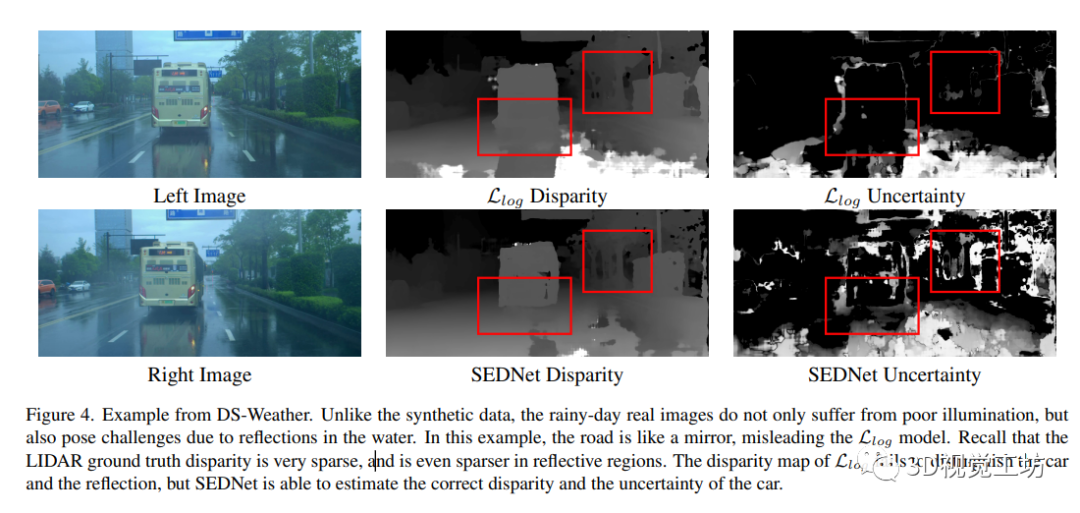

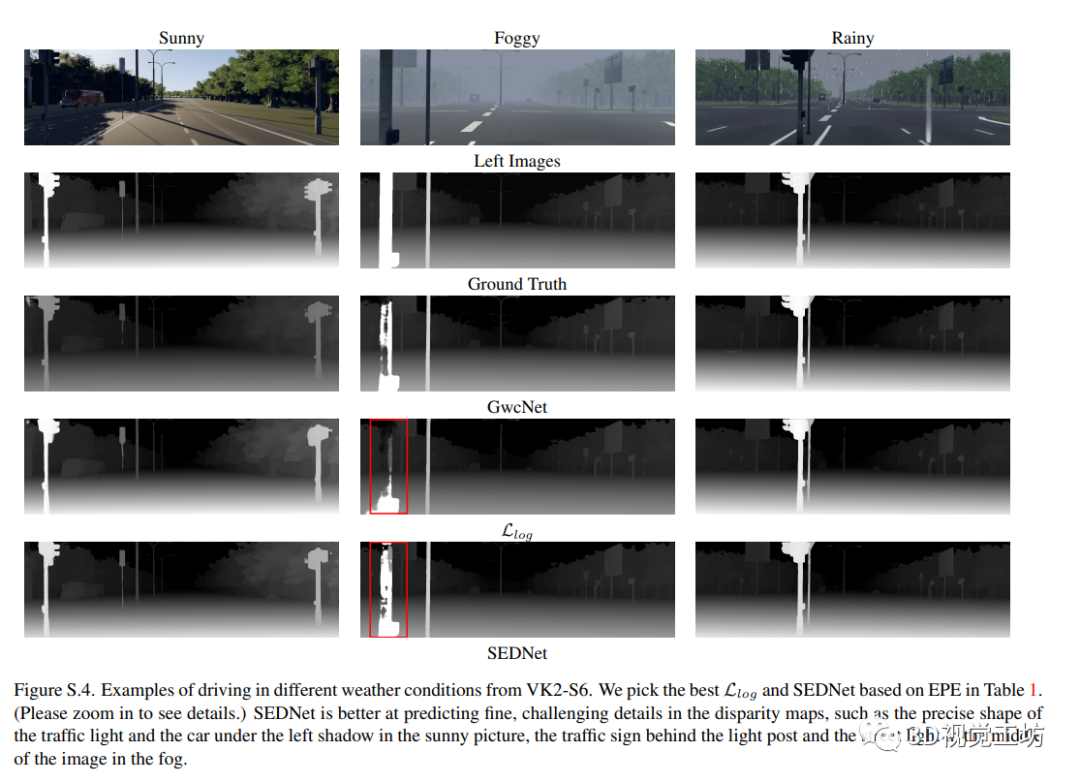

作者進行了視差估計和不確定性估計的定量和定性分析,并展示了針對不同實驗設置的SEDNet的性能優于基線結果。使用自適應閾值的內點過濾器使模型在視差和不確定性估計方面表現更好。SEDNet還具有在極端天氣下預測視差的能力,不受糟糕照明和模糊影響。此外,作者還發現使用自適應閾值進行內點過濾可以提高網絡的性能。

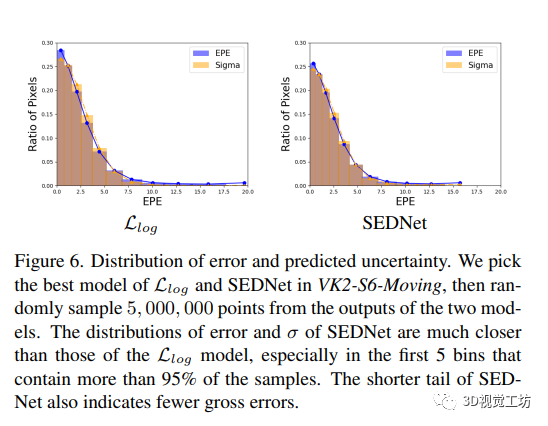

4.4 匹配誤差分布

作者提出的能夠更好匹配真實分布的視差估計和不確定性估計方法SEDNet,表明其在精度和魯棒性方面具有優勢。在誤差分布匹配方面,通過比較APE的結果,驗證了SEDNet的匹配能力。

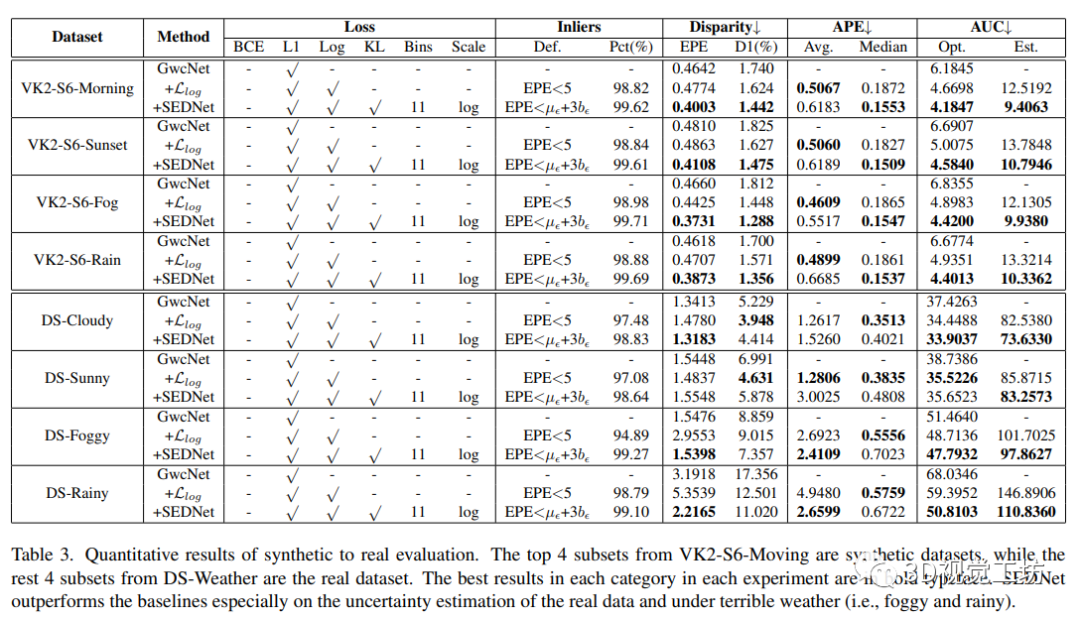

4.5 從合成數據到真實數據的泛化

視差匹配網絡通常在合成數據上進行訓練,并在目標域的少量真實數據上進行微調,因為獲取帶有真實深度信息的真實數據成本高且難度大。在本節中,作者將VK2-S6和DS-Weather的實驗擴展到所有僅在合成數據上進行訓練的方法在看不見的真實域上的泛化性能進行比較。

5 總結

本文提出了一種新的視差和不確定性聯合評估的方法,其中關鍵思想是使用基于KLD散度的獨特損失函數來比較視差誤差和不確定性估計的分布情況,通過一種可微的直方圖方案實現,同時引入了僅有190個參數的不確定性估計子網絡。實驗表明,該方法在視差和不確定性預測方面都取得了比較有效的結果。和GwcNet相比,即使基本上具有相同的容量和幾乎相同的架構,SEDNet在視差估計方面表現更好,這歸因于微小的不確定性估計子網絡。未來研究計劃將該方法同樣應用于其他逐像素回歸任務。

該篇論文介紹了一種視差和不確定性聯合評估的方法SEDNet,提出了一種可微的直方圖方案來實現KL散度損失函數,通過匹配視差誤差和不確定性分布來實現精確的不確定性估計。實驗表明,該方法在視差和不確定性預測方面都取得了有效的結果,并且在視差估計方面表現更好,相比于GwcNet,這歸因于微小的不確定性估計子網絡。該文章的主要貢獻是引入了一種新穎的不確定性估計子網絡和使用KL散度的損失函數來對比視差誤差和不確定性估計的分布情況。SEDNet的實現對于視覺和深度學習領域的研究也有一定的參考意義。

審核編輯 :李倩

-

函數

+關注

關注

3文章

4381瀏覽量

64963 -

數據集

+關注

關注

4文章

1224瀏覽量

25468

原文標題:CVPR2023|SEDNet:視差和不確定性聯合評估的新方法

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

去嵌入和不確定性是否使用了正確的設置

是否可以使用全雙端口校準中的S11不確定性來覆蓋單端口校準的不確定性?

N5531S TRFL不確定性

435B-K05輸出不確定性

如何用不確定性解決模型問題

針對自閉癥輔助的不確定性聯合組稀疏建模方法

評論