本文主要來源于中國慕課大學《機器學習概論》學習筆記

根據機器學習相關介紹(9)——支持向量機(線性不可分情況),通過引入松弛變量δi將支持向量機推廣至解決非線性可分訓練樣本分類的方式不能解決所有非線性可分訓練樣本的分類問題。因此,支持向量機的可選函數范圍需被擴展以提升其解決非線性可分訓練樣本分類問題的能力。

支持向量機可選函數范圍被擴大的方式與其他機器學習算法可選函數范圍的被擴大方式不同。

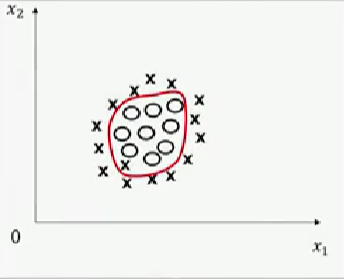

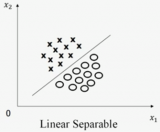

其他算法(包括:人工神經網絡、決策樹等)可選函數范圍被擴大的方式是直接產生更多可選函數。例如:人工神經網絡可通過多層非線性函數的組合產生類似橢圓的曲線,以解決類似圖一的分類問題。

圖一,圖片來源:中國慕課大學《機器學習概論》

支持向量機則通過將特征空間由低維映射至高維,并在高維度中采用線性超平面分類數據。下文通過案例介紹該數據分類方式。

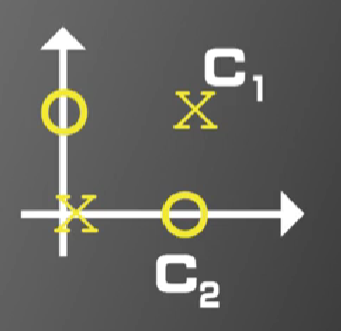

如圖二所示,圓圈和叉對應的向量分別為X1=[0,0]T(左下叉),X2=[1,1]T(右上叉),X3=[1,0]T(右下圓圈),X4=[0,1]T(左上圓圈),即X1、X2屬于同一類別,X3、X4屬于同一類別。圖二所示分類問題為線性不可分分類問題,機器學習算法或人類均不能找到一條直線將圓圈和叉完全分類。

圖二,圖片來源:中國慕課大學《機器學習概論》

但若構造一個二維特征空間到五維特征空間的映射φ(x),該案例可能轉化為線性可分分類問題。

二維特征空間到五維特征空間映射的一種方式如下:

當在二維特征空間向量x=[a,b]T時,其五維特征空間向量φ(x)=[a2,b2,a,b,ab]T。

根據此映射方式,二維特征空間向量X1、X2、X3、X4對應的五維特征空間向量分別為φ(X1)=[0,0,0,0,0]T,φ(X2)=[1,1,1,1,1]T,φ(X3)=[1,0,1,0,0]T,φ(X4)=[0,1,0,1,0]T。

設:ω=[-1,-1,-1,-1,6]T,b=1,則:ωTφ(X1)+b=1>0,ωTφ(X2)+b=3>0,ωTφ(X3)+b=-1<0,ωTφ(X4)+b=-1<0,根據線性可分的定義,此時ωTφ(X1)+b=0所代表的函數在五維特征空間中將圓圈和叉完全分類。

支持向量機通過將特征空間由低維映射至高維解決非線性分類問題的方式可基于以下定理理解:

在一個M維空間上隨機取N個訓練樣本,隨機對每個訓練樣本賦予標簽+1或-1,同時假設這些訓練樣本線性可分的概率為P(M),當M趨于無窮大時,P(M)=1。

即增加特征空間維度M時,帶估計參數ω和b的維度也會增加,算法模型的自由度增加。因此,算法模型更可能將低維時無法完全分類的問題在高維完全分類。

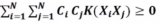

綜上,支持向量機的優化問題可改寫為:

最小化:1/2||ω||2+C∑δi或1/2||ω||2+C∑δi2,

限制條件:(1)δi≥0,i=1~N;(2)yi(ωTφ(Xi)+b)≥1-δi,i=1~N。

其中,ω的維度與φ(Xi)的維度相同。

審核編輯:湯梓紅

-

神經網絡

+關注

關注

42文章

4771瀏覽量

100715 -

函數

+關注

關注

3文章

4327瀏覽量

62573 -

機器學習

+關注

關注

66文章

8406瀏覽量

132565

原文標題:機器學習相關介紹(10)——支持向量機(低維到高維的映射)

文章出處:【微信號:行業學習與研究,微信公眾號:行業學習與研究】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

支持向量機——機器學習中的殺手級武器!

基于向量機隨機投影特征降維分類下降解決方案

機器學習相關介紹:支持向量機(低維到高維的映射)

機器學習相關介紹:支持向量機(低維到高維的映射)

評論