2022年12月,國際知名OpenAI公司發布了ChatGPT3.5。僅僅不到3個月,OpenAI公布了最新版本GPT-4。與3.5版本相比,GPT-4在識圖能力、回答準確性等方面能力得到躍升。ChatGPT的橫空出世掀起一波巨浪,有人把它喻為互聯網革命后的又一次人類技術的大進步,甚至把它與工業革命對人類社會的進步作用相比肩。恩格斯曾預言:“一旦技術上的進步可以用于軍事目的并且已經用于軍事目的,它們便立刻幾乎強制地,而且往往是違反指揮官的意志而引起作戰方式上的改變甚至變革。”那么,ChatGPT能否應用于軍事目的,會不會像互聯網技術一樣引起作戰方式的變革呢?單從目前ChatGPT的功能及原理來看,至少現在還不能對軍事領域產生較大的影響,其理由有以下幾點。

ChatGPT還不具備軍事智能

ChatGPT到底有沒有出現人類智能,進而擁有軍事智能?有人認為ChatGPT能夠寫詩、編代碼、繪畫、寫論文等等這些人類需要智能,而且是高智能才能完成的工作。因而ChatGPT應該已經具備了人類的一些智能。這種說法犯了一個錯誤,錯誤事實在于把結果與過程等同起來。如一個簡單的計算器能算出9位數的平方根,而人類幾乎極難完成,但不代表計算器比人類聰明。

再分析ChatGPT為何有如此的能力,實際上ChatGPT是一個大語言模型,其技術根源是運用“無限猴子定理”,形象的比喻ChatGPT是一只升級版的,講邏輯、懂道理、會表述的猴子。“無限猴子定理”認為,讓一只猴子在打字機上隨機地按鍵,當按鍵時間和按鍵次數達到無窮時,猴子幾乎必然能夠打出任何給定的文字,比如莎士比亞的全套著作。當猴子在無窮的某一時刻打出一段莎士比亞著作中某一句話時,只是純粹的巧合、運氣與概率。

如何在接近無窮次的語句挑出契合人類思維和表述習慣的答案,ChatGPT開始運用貝葉斯定理進行反向推理。貝葉斯定理看起來平淡無奇,但給人類提供了探知未知概率的方法。人們首先有一個先驗猜測,然后結合觀測數據,修正先驗,得到更為合理的后驗概率。這就是說,當你不能準確知悉某個事物本質時,你可以依靠經驗去對未知世界的狀態步步逼近,從而判斷其本質屬性。ChatGPT正是運用了貝葉斯的“逆向概率”,把貼近人類常用表達的字詞留下,無用的字詞撇去,從而得到一句符合人類邏輯的話。因而,ChatGPT的核心原理是概率論,是貝葉斯定律的勝利。

從ChatGPT底層技術的運用邏輯,不難看出ChatGPT仍然是數學和計算機科學相結合的產物。無論它產生的結果多么貼近人的答案、出乎人的意料、超越人的能力,但它仍然不具備人類的智能,更不可能產生人類智能。從這個角度來看,ChatGPT和過去出現的機器學習、深度學習等一樣,只是人工智能的另一個產品,是傾向于自然語言處理系統的。它目前難以形成人類智能,也就不可能出現軍事智能,更不會引起作戰方式的變革。

ChatGPT還不是好參謀

判斷人與機器的區別,最經典的測試是圖靈測試。讓無關的第三人,從人與機器的對話中,能否準確區分于人與機器。如果把這一測試應于ChatGPT與人類之間,或許能夠騙過第三人,把機器看作人。可見,ChatGPT在自然語言處理方面的杰出能力。

ChatGPT跟提問人之間這種往復交談的過程,看上去似乎真的就是一個有思維的人,但嚴格來說,ChatGPT并不是對它所說的那些東西有了理解。它仍然是一種概率算法,只不過是它的算法、參數等等極為強大。OpenAI的 GPT-3 模型具有 1750 億參數量,ChatGPT-3.5,參數數量應該多于1750 億,ChatGPT4.0技術相比之前的幾個版本來說模型規模更大,預計將包含數萬億個參數。這些參數指的是在訓練模型前需要預先設置的參數,這些接近天文數字的巨量參數是Chatgpt的能源,是其生存發展的養分。

ChatGPT能否直接運用軍事決策輔助呢?回答卻是否定的。我們確實可以通過ChatGPT詢問一些關于時事政治、氣候地理、軍事實力、經濟水平等一些與軍事領域密切相關的問題,得到一些超乎“意外”的信息,但這些信息的來源是互聯網,這些信息的基礎是互聯網的認知,是基于互聯網上所有信息的綜合,是互聯網自己的答案。

一方面,由于互聯網上有關軍事理論、軍事裝備、作戰戰法、戰爭案例、力量部署等等信息資源的天然缺陷。無論它引用或綜合了某一論壇、某一網站、某一網友的結論,或者從零樣本或少量樣本中生成具有語法和語義正確性的新軍事信息方案,看上去是哪樣的“完整”,但由于其信息本源是殘缺的,信息來源是無事實依據的,其答案就不可信了。因為,假消息是軍事決策領域的最大忌諱;另一方面,一旦數據源本身或者算法存在偏見和錯誤,其結論同樣會繼承錯誤和偏見。

同樣,如果ChatGPT的技術直接移植到軍事情報領域,但由于缺乏龐大、巨量的既往信息資源和每天產生的海量信息資源的支持,其也難以做出“完美”的決策。誠然,ChatGPT能夠協助指揮員快速生成標準的軍用文書,提升參謀人員作業的效率;ChatGPT能夠突破語言文字交流壁壘,讓交流溝通和信息獲取更加順暢,但這些能力不是參謀的核心能力,只是參謀的基本素質,只是一個工具,本身需要人來掌握。因而,其離一名優秀的參謀還有相當大的距離,不是其能力不夠,而是其頭腦中的真實軍事信息、數據缺乏,難以提出適合的、科學的建議和方案。

ChatGPT還不能進行決策對抗

軍事斗爭是人類特殊的一個領域,它需要進行博弈,需要基于對方的態勢,下一步可能的行動,決策自己的行動,再預測對方的行動,對己方應對行動作出安排。其遵循的是“觀察-調整-決策-行動”的OODA循環,最基本的博弈策略是對方更快更好地完成OODA循環,比拼的是誰能夠在短時間完成OODA循環。顯然,ChatGPT是無法完成這一決策環的。ChatGPT的專長是生成“與人類作品類似”的文本,它不能生成“與戰場適應”作戰方案。ChatGPT能夠生成符合語法的文字,但它目前還不能進行數學計算、邏輯推理等等另一些復雜的工作。軍事領域的斗爭策略確實可以用文字來顯示,但真正對文字起作用是人的思維對周圍信息的感知、環境的判斷形成的決策。加之,戰場環境信息瞬間萬變,理性決策和非理性決策充斥整個斗爭過程。ChatGPT是無法適應這一變化的。人們也經常發現ChatGPT “一本正經”地“胡說八道”,其原因是因為對它沒有聽過的東西,無法給出正確的回答。在對話連貫性上,一旦進行長時間對話,ChatGPT的回話會上下不一致,容易生成不合理或矛盾的回答,這些虛假、不確定信息會導致出現重大指揮失誤。

哲學家笛卡爾的一句名言,“我思故我在”,他這句名言有兩個“我”,分別代表不同的“我”。前一個我對后一個我進行觀察,有一個永遠質疑“我”的“我”。對比應用到戰爭博弈,也是同樣有兩個我,我對我的觀察,我對我的質疑,我對我的判斷。要想用人工智能去模擬一個自我,得先要知曉我的認知,而問題是我的認知又恰恰是不能被觀察和認識的,也就更無法模擬了。同樣,在軍事斗爭的最高形式——戰爭指揮上,就是兩個“大我”的博弈。既然,最底層的我是不能被模擬的,后面的我更不能被認知。這就決定了ChatGPT無法具備人的主觀能動性,不會有非理性思維的能力,也就無法去設定戰爭目標,進而去實現戰爭目標。它強大的推理能力、計算能力,都是用來人為實現戰場目標而服務的。決策的本身是人的目標對抗,ChatGPT還不具備自主對抗的能力。

雖然ChatGPT暫時還不能廣泛直接運用于軍事領域,但人類在ChatGPT發明、升級、改造過程中獲得的知識、積累的經驗和取得的技術進步等成果,卻讓人類越來越接近通用強人工智能。ChatGPT鍛煉和提升人的思維能力、提出問題的能力、超越ChatGPT能力的能力,卻是軍事斗爭領域一直以來推崇的。或許不能斷言:未來誰掌控ChatGPT,誰就贏得斗爭的主動權,但至少有一點可以肯定:ChatGPT給予一方在軍事謀略能力的輔助和信息綜合能力的提升,一旦超越了對手,也等于間接地掌握了斗爭的主動權,勝利的天平就傾向了這一方。

審核編輯 :李倩

-

互聯網

+關注

關注

54文章

11148瀏覽量

103229 -

深度學習

+關注

關注

73文章

5500瀏覽量

121111 -

ChatGPT

+關注

關注

29文章

1558瀏覽量

7595

原文標題:ChatGPT軍事運用的幾個誤區

文章出處:【微信號:CloudBrain-TT,微信公眾號:云腦智庫】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

DFT的常見誤區與解決方案

eda的常見誤區和解決方案

怎樣搭建基于 ChatGPT 的聊天系統

ChatGPT 適合哪些行業

如何使用 ChatGPT 進行內容創作

做了個opa2344運用電路,實物測量遇到的幾個疑問求解

必看!光伏并網逆變器的3個典型認識誤區

用launch pad燒錄chatgpt_demo項目會有api key報錯的原因?

使用espbox lite進行chatgpt_demo的燒錄報錯是什么原因?

OpenAI 深夜拋出王炸 “ChatGPT- 4o”, “她” 來了

在FPGA設計中是否可以應用ChatGPT生成想要的程序呢

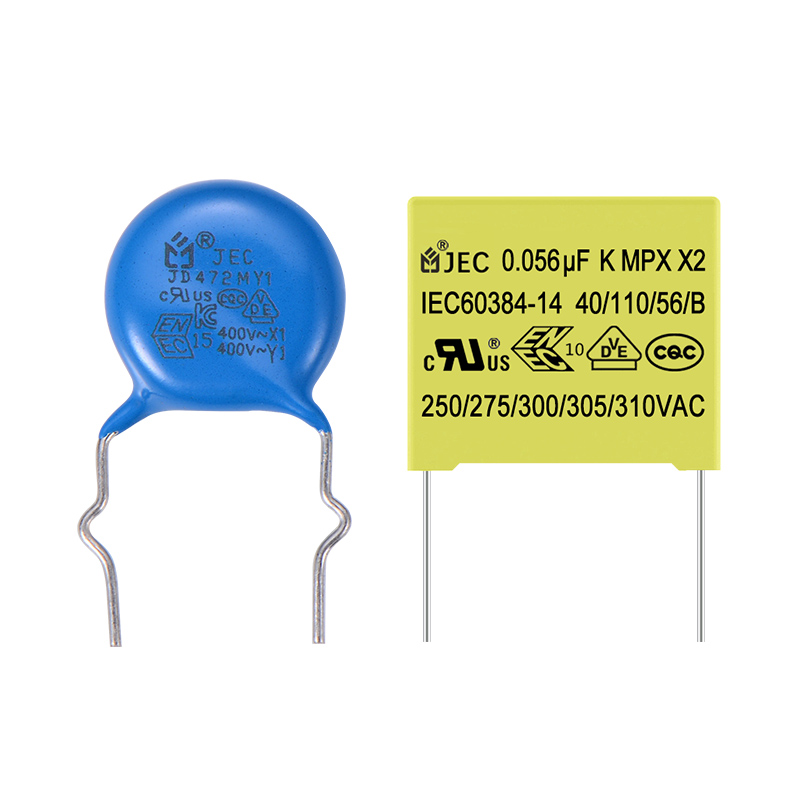

選購安規電容的幾個常見誤區你中了幾個?

ChatGPT軍事運用的幾個誤區

ChatGPT軍事運用的幾個誤區

評論