CVPR 2023舉辦在即。

今天,官方公布了12篇獲獎論文候選。(占接受論文的0.51%,占提交論文的0.13%)

根據官網上統計數據,本次CVPR一共接受論文9155篇,錄用2359篇,接受率為25.8%。

其中,235篇被評為Highlights。(占接受論文的10%,占提交論文的2.6%)

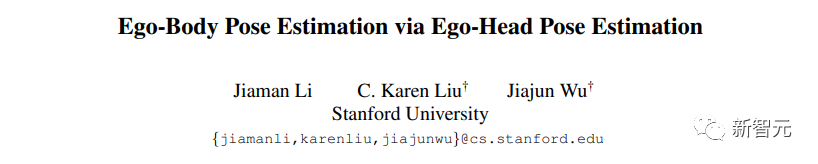

1. Ego-Body Pose Estimation via Ego-Head Pose Estimation

作者:Jiaman Li,Karen Liu,Jiajun Wu

機構:斯坦福大學

論文地址:https://arxiv.org/pdf/2212.04636.pdf

本文中,研究人員提出了一種新的方法,即通過自我-頭部姿勢估計的自我身體姿勢估計(EgoEgo),它將問題分解為兩個階段,由頭部運動作為中間表征來連接。EgoEgo首先整合了SLAM和一種學習方法,以估計準確的頭部運動。

隨后,利用估計的頭部姿勢作為輸入,EgoEgo利用條件擴散,以產生多個可信的全身運動。這種頭部和身體姿勢的分離消除了對配對自我中心視頻和三維人體運動的訓練數據集的需要,使研究人員能夠分別利用大規模自我中心視頻數據集和運動捕捉數據集。

此外,為了進行系統的基準測試,研究人員開發了一個合成數據集AMASS-Replica-Ego-Syn(ARES),其中包括成對的自我中心視頻和人類運動。在ARES和真實數據上,研究人員的EgoEgo模型的表現明顯優于目前最先進的方法。

2. 3D Registration with Maximal Cliques

作者:Xiyu Zhang,Jiaqi Yang,Shikun Zhang,Yanning Zhang

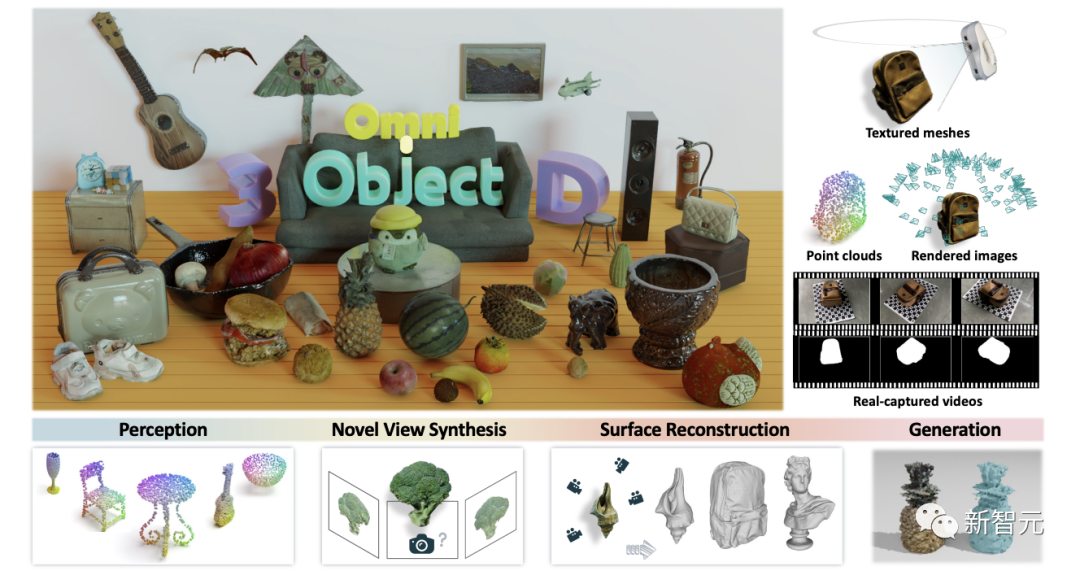

3. OmniObject3D: Large Vocabulary 3D Object Dataset for Realistic Perception, Reconstruction and Generation

作者:Tong Wu,Jiarui Zhang,Xiao Fu,Yuxin WANG,Jiawei Ren,Liang Pan,Wenyan Wu,Lei Yang,Jiaqi Wang,Chen Qian,Dahua Lin,Ziwei Liu

機構:上海人工智能實驗室,香港中文大學,商湯,香港科技大學,南洋理工大學

論文地址:https://arxiv.org/pdf/2301.07525.pdf

由于缺乏大規模的真實掃描三維數據庫,最近在三維物體建模方面的進展大多依賴于合成數據集。

為了促進現實世界中3D感知、重建和生成的發展,研究人員提出了OmniObject3D,一個具有大規模高質量真實掃描3D物體的大型詞匯3D物體數據集。

OmniObject3D有幾個吸引人的特性:1)超大數據量:它包括190個日常類別的6000個掃描物體,與流行的二維數據集(如ImageNet和LVIS)共享共同的類別,有利于追求可通用的三維表征。2)豐富的注釋:每個三維物體都由二維和三維傳感器捕獲,提供紋理網格、點云、多視角渲染圖像和多個真實捕獲的視頻。3) 真實的掃描:專業掃描儀支持高質量的物體掃描,具有精確的形狀和逼真的外觀。

利用OmniObject3D提供的廣闊探索空間,研究人員精心設置了四個評估基準:a)強大的3D感知,b)新視角合成,c)神經表面重建,以及d)3D物體生成。

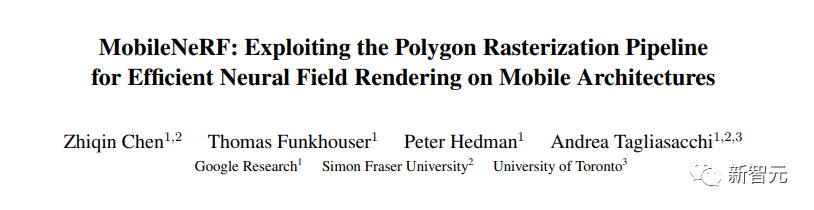

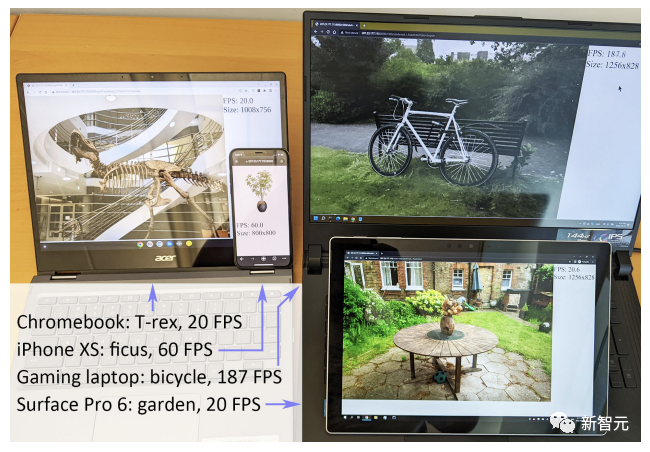

4. MobileNeRF: Exploiting the Polygon Rasterization Pipeline for Efficient Neural Field Rendering on Mobile Architectures

作者:Zhiqin Chen,Thomas Funkhouser,Peter Hedman,Andrea Tagliasacchi

機構:谷歌,西蒙菲莎大學,多倫多大學

論文地址:https://arxiv.org/pdf/2208.00277.pdf

神經輻射場(NeRFs)在從新的視角合成三維場景的圖像方面表現出驚人的能力。然而,它們依賴的專有體積渲染算法,與廣泛部署的圖形硬件的能力并不匹配。

本文介紹了一種新的基于紋理多邊形的NeRF表征方法,它可以用標準渲染管道有效地合成新的圖像。NeRF被表征為一組多邊形,其紋理代表二進制不透明度和特征矢量。用Z型緩沖器對多邊形進行傳統的渲染,得到的圖像在每個像素上都有特征,這些特征被運行在片段著色器中的一個小型的、依賴于視圖的MLP解釋,以產生最終的像素顏色。

這種方法使NeRF能夠用傳統的多邊形光柵化管道進行渲染,它提供了大規模的像素級并行性,在包括手機在內的各種計算平臺上實現了足以進行交互的幀率。

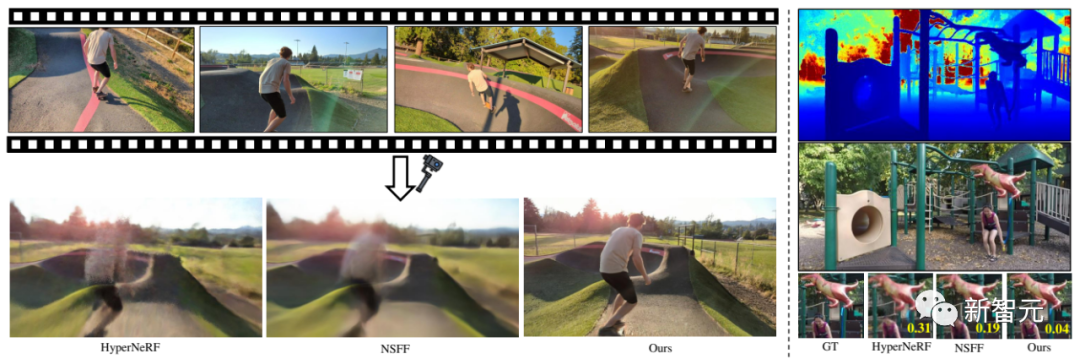

5. DynIBaR: Neural Dynamic Image-Based Rendering

作者:Zhengqi Li,Qianqian Wang,Forrester Cole,Richard Tucker,Noah Snavely

機構:谷歌,康奈爾科技校區

論文地址:https://arxiv.org/pdf/2211.11082.pdf

本文中,研究人員提出了一種基于體積圖像的渲染框架,該框架通過以場景運動感知的方式,來聚合附近的視點特征,從而合成新的視點。

研究人員的系統保留了先前方法的優點,即能夠對復雜的場景和視點相關的效果進行建模,而且還能夠從具有復雜場景動態和無約束相機軌跡的長視頻中合成照片般真實的新視點。

結果證明,在動態場景數據集上,新方法比SOTA有明顯改進。并且,還能應用于頗具挑戰性的運動視頻當中,此前的方法在這里都無法產生高質量的渲染。

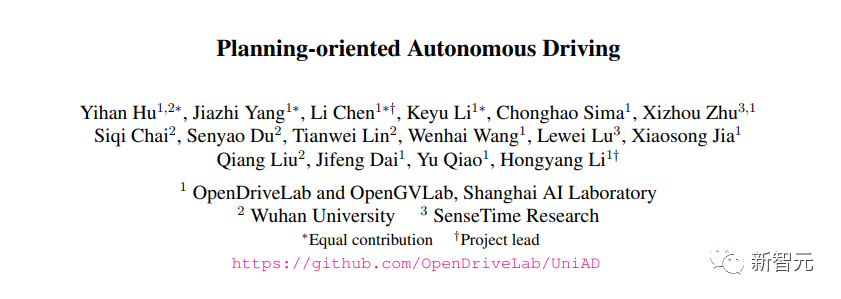

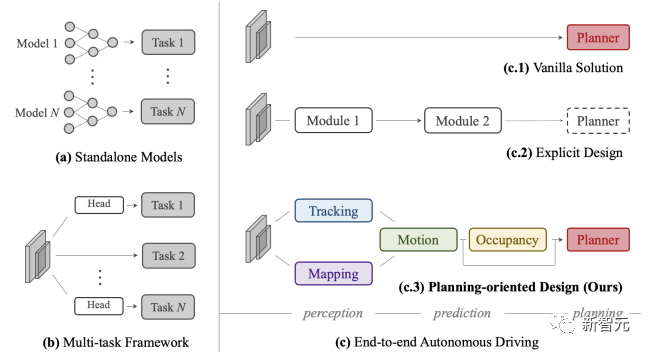

6. Planning-oriented Autonomous Driving

作者:Yihan Hu,Jiazhi Yang,Li Chen,Keyu Li,Chonghao Sima,Xizhou Zhu,Siqi Chai,Senyao Du,Tianwei Lin,Wenhai Wang,Lewei Lu,Xiaosong Jia,Qiang Liu,Jifeng Dai,Yu Qiao,Hongyang Li機構:上海人工智能實驗室,武漢大學,商湯

論文地址:https://arxiv.org/pdf/2212.10156.pdf 本文中,研究人員提出了一種全新的綜合框架——統一自動駕駛(UniAD)。通過將全棧式的駕駛任務納入一個網絡,該框架可以利用每個模塊的優勢,并從全局角度為智能體交互提供互補的特征抽象。任務通過統一的查詢接口進行通信,從而促進彼此的規劃。 研究人員在具有挑戰性的nuScenes基準上對UniAD進行了實例化。消融實驗顯示,新方法在各個方面的性能都大大優于此前的SOTA。

7. DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation

作者:Nataniel Ruiz,Yuanzhen Li,Varun Jampani,Yael Pritch,Michael Rubinstein,Kfir Aberman機構:谷歌,波士頓大學

論文地址:https://arxiv.org/pdf/2208.12242.pdf 在這項工作中,研究人員提出了一種新的「個性化」文本到圖像擴散模型的方法。 只需輸入少數幾張主體的圖片,就可以微調預訓練的文本到圖像模型,使其學會將獨特的標識符與特定主體綁定。一旦將主體嵌入模型的輸出域,就可以使用獨特的標識符在不同場景中合成該主體的新的真實感圖像。 通過利用模型中嵌入的語義先驗以及新的自生類特定先驗保留損失,新的方法使得在各種場景、姿態、視角和光照條件下合成主體成為可能,而這些條件在參考圖像中并未出現。

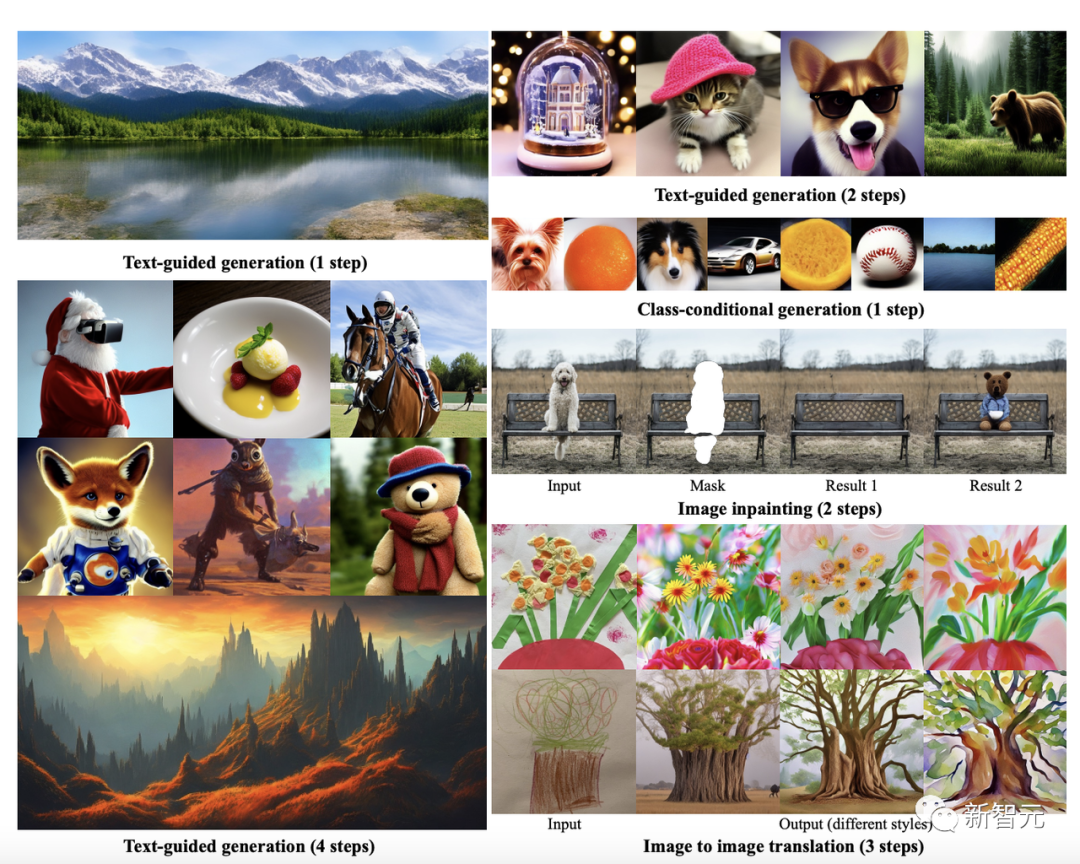

8. On Distillation of Guided Diffusion Models

作者:Chenlin Meng,Robin Rombach,Ruiqi Gao,Diederik Kingma,Stefano Ermon,Jonathan Ho,Tim Salimans機構:斯坦福大學,Stability AI,慕尼黑大學,谷歌

論文地址:https://arxiv.org/pdf/2210.03142.pdf 無分類器指導的擴散模型的一個缺點是,它們在推理時的計算成本很高,因為它們需要評估兩個擴散模型,一個類別條件模型和一個無條件模型,需要數十到數百次。 為了解決這一局限性,研究人員提出了一種將無分類器指導的擴散模型提煉成快速采樣的模型的方法。 給定一個預先訓練好的無分類器指導的模型,首先學習一個單一的模型來匹配合并的條件和無條件模型的輸出,然后逐步將該模型提煉成一個需要更少采樣步驟的擴散模型。

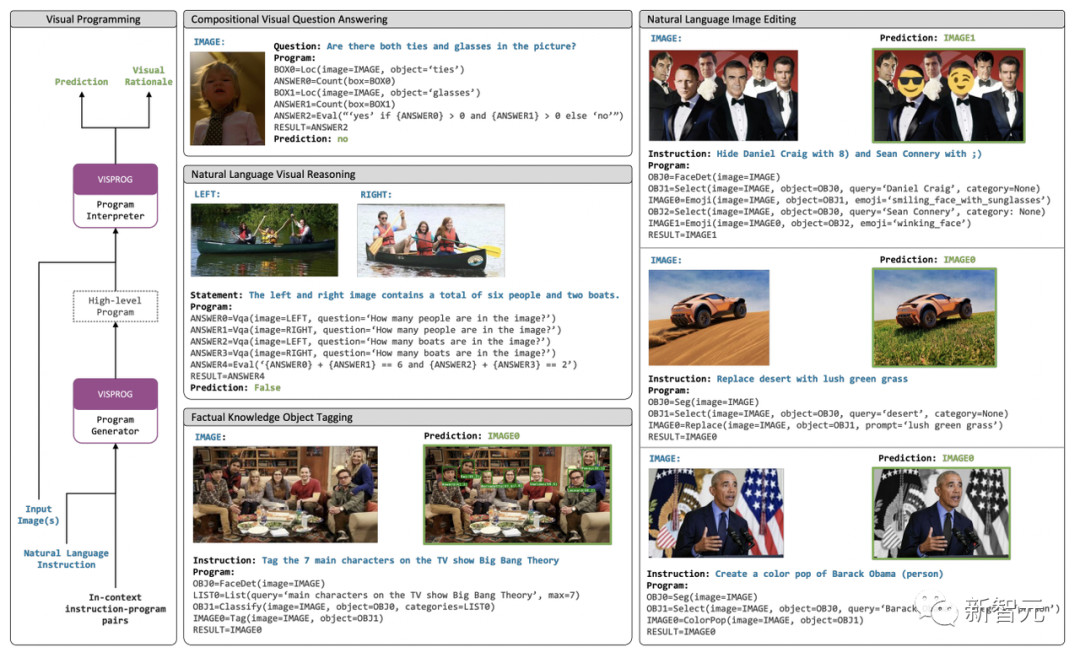

9. Visual Programming: Compositional visual reasoning without training

作者:Tanmay Gupta,Aniruddha Kembhavi機構:艾倫人工智能研究所

論文地址:https://arxiv.org/pdf/2211.11559.pdf 研究人員提出了一種神經符號方法VISPROG,用于解決給定自然語言指令的復雜和組合性的視覺任務。 VISPROG使用大型語言模型的非文本學習能力來生成類似于python的模塊化程序,然后執行這些程序以獲得解決方案和一個全面的、可解釋的理由。 生成的程序的每一行都可以調用幾個現成的CV模型、圖像處理子程序或python函數中的一個,以產生中間輸出。 研究人員在4個不同的任務上展示了VISPROG的靈活性:組合式視覺問題回答、圖像對的零點推理、事實知識對象標簽和語言引導的圖像編輯。 研究人員表示,像VISPROG這樣的神經符號方法是一條令人興奮的途徑,可以輕松有效地擴大人工智能系統的范圍,為人們可能希望執行的長尾復雜任務提供服務。

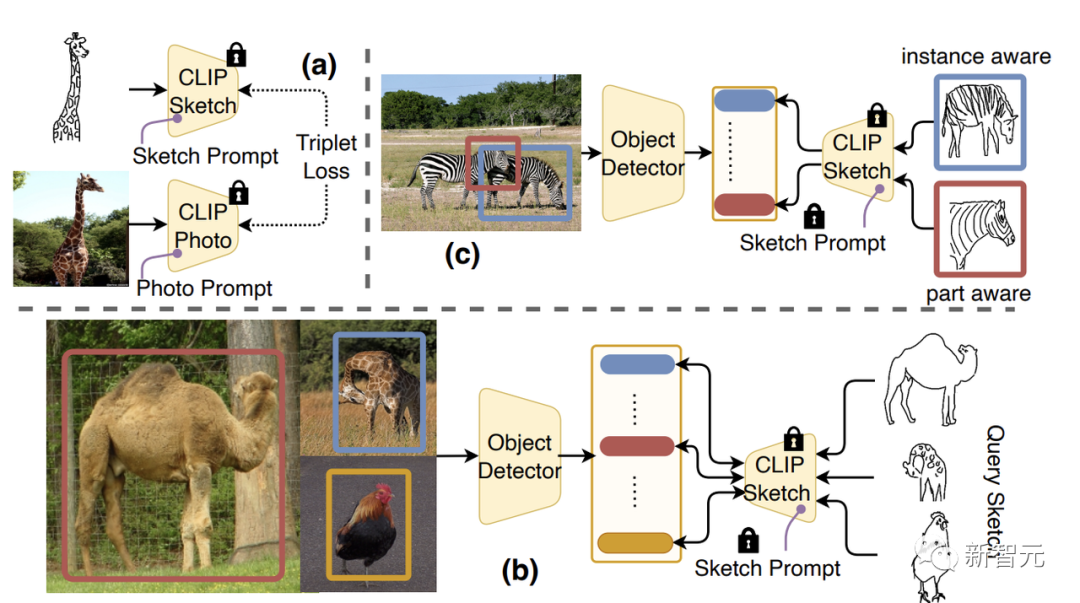

10. What Can Human Sketches Do for Object Detection?

作者:Pinaki Nath Chowdhury,Ayan Kumar Bhunia,Aneeshan Sain,Subhadeep Koley,Tao Xiang,Yi-Zhe Song機構:薩里大學

論文地址:https://arxiv.org/pdf/2303.15149.pdf 草圖,具有很強的表現力,本身就能捕捉到主觀和細粒度的視覺線索。然而,當前對草圖這種先天屬性的探索僅限于圖像檢索領域。 論文中,研究人員嘗試開發草圖的表現力,而不是目標檢測這一基本視覺任務。 研究人員首先對SBIR模型的草圖和照片分支進行獨立提示,在CLIP的泛化能力的基礎上建立高度可泛化的Sketches和照片編碼器。 然后,研究人員設計了一個訓練范式,使編碼器適用于物體檢測,這樣,檢測到的邊界款區域的嵌入,與SBIR的草圖和照片嵌入對齊。 通過在標準目標檢測數據集(如PASCAL-VOC和MS-COCO)上評估最新框架,可見在零樣本設置上優于受監督(SOD)和弱監督目標檢測器(WSOD)。

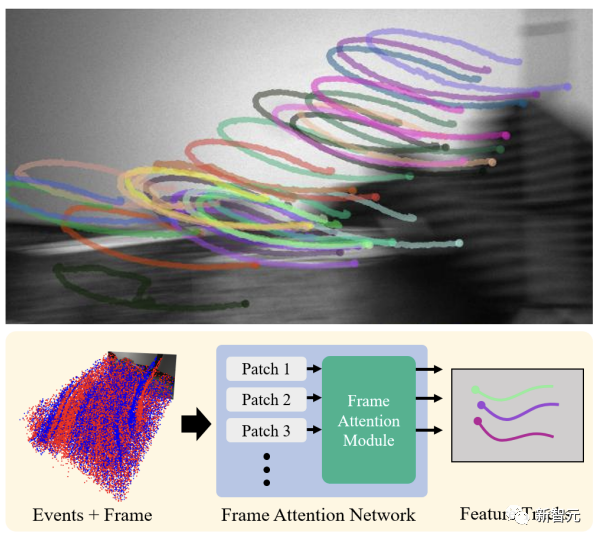

11. Data-driven Feature Tracking for Event Cameras

作者:Nico Messikommer,Carter Fang,Mathias Gehrig,Davide Scaramuzza機構:蘇黎世大學

論文地址:https://arxiv.org/pdf/2211.12826.pdf 現有的事件相機特征跟蹤方法要么是人工制作的,要么是從第一性原理中推導出來的,但需要大量的參數調整,且對噪聲敏感,由于未建模的效應,無法泛化到不同的場景。 為了解決這些不足,研究人員引入了第一個數據驅動的事件相機特征跟蹤器,該跟蹤器利用低延遲的事件來跟蹤在灰度幀中檢測到的特征。 通過直接從合成數據無縫轉移到真實數據,新的數據驅動跟蹤器在相對特征年齡上超過了現有方法高達120%,同時也實現了最低的延遲。通過使用一種新的自監督策略讓跟蹤器適應真實數據,這個性能差距進一步增加到130%。

12. Integral Neural Networks

作者:Kirill Solodskikh,Azim Kurbanov,Ruslan Aydarkhanov,Irina Zhelavskaya,Yury Parfenov,Dehua Song,Stamatios Lefkimmiatis機構:華為諾亞方舟實驗室

論文地址:https://openaccess.thecvf.com/content/CVPR2023/papers/Solodskikh_Integral_Neural_Networks_CVPR_2023_paper.pdf 研究人員介紹了一個新的深度神經網絡系列。研究人員使用了沿過濾器和通道維度的連續層表征,而不是傳統的網絡層作為N維權重張量的表示。研究人員稱這種網絡為積分神經網絡(INNs)。 特別是,INNs的權重被表示為定義在N維超立方體上的連續函數,而輸入到各層的離散轉換也相應地被連續的集成操作所取代。 在推理階段,連續層可以通過數值積分求積法轉換為傳統的張量表示。這種表示允許網絡以任意大小和各種離散化間隔對積分核進行離散化。 這種方法可用于直接在邊緣設備上對模型進行剪枝,而在沒有任何微調的情況下,即使在高剪枝率下也只會有小的性能損失。 為了評估提出方法的實際效益,研究人員在多個任務上使用各種神經網絡架構進行了實驗。 報告結果顯示,所提出的INNs實現了與傳統的離散對應物相同的性能,同時能夠在不進行微調的高剪枝率(高達30%)下保持大致相同的性能(對于Imagenet上的ResNet18,精度損失為2%),而傳統剪枝方法在相同條件下的準確性損失65%。

審核編輯 :李倩

-

傳感器

+關注

關注

2550文章

51046瀏覽量

753140 -

SLAM

+關注

關注

23文章

423瀏覽量

31824 -

數據集

+關注

關注

4文章

1208瀏覽量

24691

原文標題:重磅!CVPR 2023最佳論文候選出爐!

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

ISS建議高通選出四名候選人與博通談判出售

高工產品及論文大賽火熱報名中~~~~~~~~

CVPR2019一共收到5165篇有效投遞論文,在線編輯器一度崩潰!

ICLR 2019最佳論文日前揭曉 微軟與麻省等獲最佳論文獎項

ICML 2019最佳論文新鮮出爐!

CVPR 2019最佳論文公布了:來自CMU的辛書冕等人合作的論文獲得最佳論文獎

62篇論文入選十年來最難CVPR,商湯研究再創佳績

ICLR 2021杰出論文獎出爐 讓我們看看前八位優秀論文有哪些

CVPR 2021華為諾亞方舟實驗室發表30篇論文 |CVPR 2021

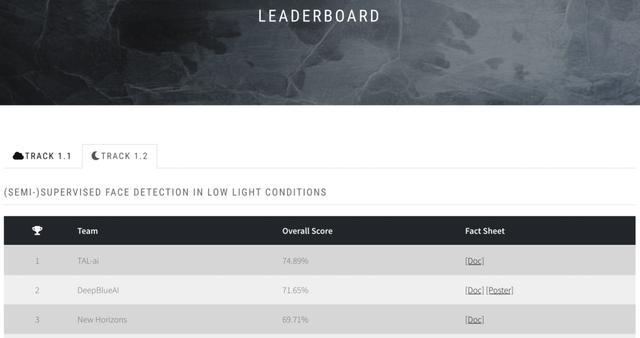

中國團隊包攬CVPR 2021弱光人臉檢測挑戰賽前三名!高分論文已公開播

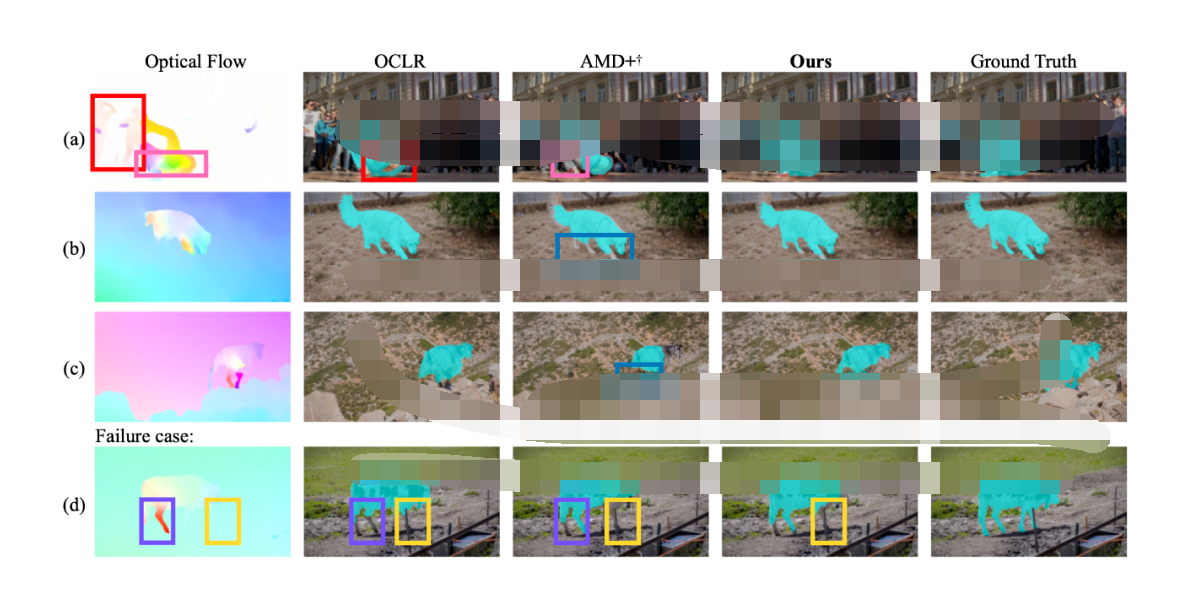

CVPR 2023 | 完全無監督的視頻物體分割 RCF

FPL 2023最佳論文獎!

中科馭數聯合處理器芯片全國重點實驗室獲得FPL 2023最佳論文獎!

CVPR 2023最佳論文候選出爐!

CVPR 2023最佳論文候選出爐!

評論