| NSDI 2016-2023論文數據分析,來源:網絡NSDI常年錄取率非常低,穩定在20%以下,有的年份甚至低于15%。投稿量來看,在早幾年中呈現出緩慢上升的趨勢,從16年的228到2021年的369篇,一路上升,然后有所下降,2022年和2023年分別為298和272篇。錄取量也呈現出緩慢上升的趨勢,到2020年的65篇,之后開始下降,至2022的50篇。錄取率整體呈現浮動的趨勢,但是相對穩定,2023年錄取率為18.4%。NSDI重點關注計算機網絡,但也覆蓋了人工智能、機器學習、計算機視覺、無線和分布式計算等內容,是一個非常全面的會議。本文介紹了NSDI 2023中可編程、RDMA、數據中心、GPU方向的相關論文,文末附NSDI 2023全部論文下載鏈接。

可編程

標題:A High-Speed Stateful Packet Processing Approach for Tbps Programmable Switches

| NSDI 2016-2023論文數據分析,來源:網絡NSDI常年錄取率非常低,穩定在20%以下,有的年份甚至低于15%。投稿量來看,在早幾年中呈現出緩慢上升的趨勢,從16年的228到2021年的369篇,一路上升,然后有所下降,2022年和2023年分別為298和272篇。錄取量也呈現出緩慢上升的趨勢,到2020年的65篇,之后開始下降,至2022的50篇。錄取率整體呈現浮動的趨勢,但是相對穩定,2023年錄取率為18.4%。NSDI重點關注計算機網絡,但也覆蓋了人工智能、機器學習、計算機視覺、無線和分布式計算等內容,是一個非常全面的會議。本文介紹了NSDI 2023中可編程、RDMA、數據中心、GPU方向的相關論文,文末附NSDI 2023全部論文下載鏈接。

可編程

標題:A High-Speed Stateful Packet Processing Approach for Tbps Programmable Switches作者:Mariano Scazzariello and Tommaso Caiazzi, KTH Royal Institute of Technology and Roma Tre University; Hamid Ghasemirahni, KTH Royal Institute of Technology; Tom Barbette, UCLouvain; Dejan Kosti? and Marco Chiesa, KTH Royal Institute of Technology

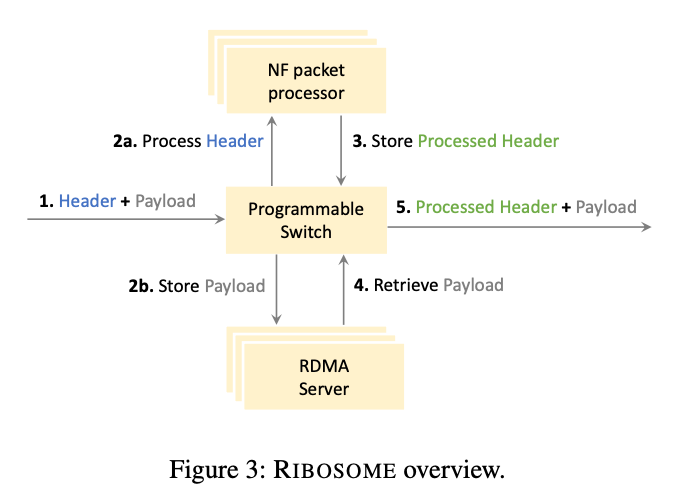

>摘要高速 ASIC 交換機有望在高速數據平面中直接卸載復雜的數據包處理管道。然而,當今各種各樣的數據包處理管道,包括有狀態網絡功能和數據包調度程序,都需要以編程的方式在短時間內存儲一些(或所有)數據包。而如今的高速 ASIC 交換機缺少這種可編程緩沖功能。在這項工作中,我們提出了一種擴展可編程交換機系統——RIBOSOME。它具有外部存儲器(用于存儲數據包)和外部通用數據包處理設備(用于執行有狀態操作),如 CPU 或 FPGA。由于當今的數據包處理設備受到網絡接口速度的限制,RIBOSOME 只將相關數據比特傳輸到這些設備。RIBOSOME 利用直接連接的服務器的空閑帶寬,通過RDMA存儲傳入的有效負載。 標題:ExoPlane: An Operating System for On-Rack Switch Resource Augmentation

標題:ExoPlane: An Operating System for On-Rack Switch Resource Augmentation作者:Daehyeok Kim, Microsoft and University of Texas at Austin; Vyas Sekar and Srinivasan Seshan, Carnegie Mellon University

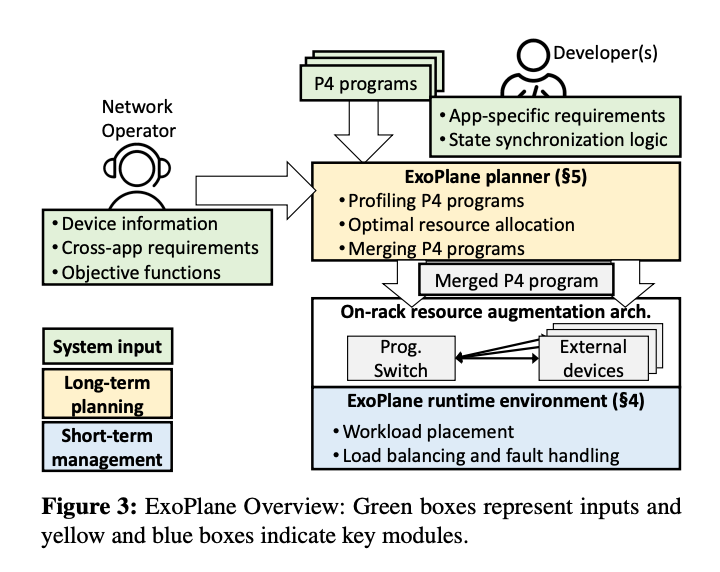

>摘要在實際的部署中(例如云和 ISP),在網計算的承諾仍然沒有實現,因為交換機的片上資源有限,在可編程交換機上服務并發有狀態應用程序仍然具有挑戰性。在這項工作中,我們設計并實施了 ExoPlane,這是一種用于機架交換機資源擴充的操作系統,可以支持多個并發應用程序。在設計 ExoPlane 時,我們提出了一個實用的運行時操作模型和狀態抽象,以最小的性能和資源開銷解決跨多個設備正確管理應用程序狀態的挑戰。我們對各種 P4 應用程序的評估表明,ExoPlane 可以為應用程序提供低延遲、可擴展吞吐量和快速故障轉移,同時以較小的資源開銷實現這些,并且無需或只需對應用程序進行少量修改。 標題:Sketchovsky: Enabling Ensembles of Sketches on Programmable Switches

標題:Sketchovsky: Enabling Ensembles of Sketches on Programmable Switches作者:Hun Namkung, Carnegie Mellon University; Zaoxing Liu, Boston University; Daehyeok Kim, Microsoft Research; Vyas Sekar and Peter Steenkiste, Carnegie Mellon University

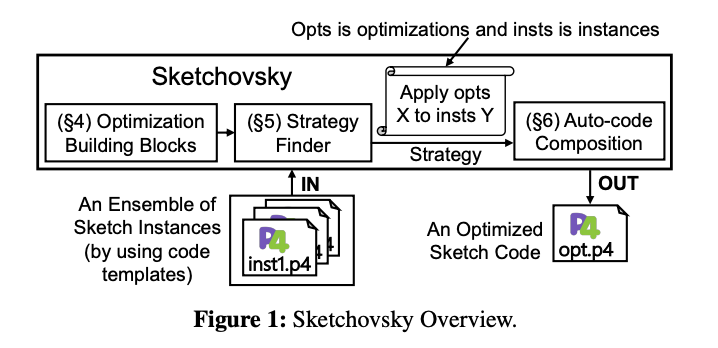

>摘要網絡運營商需要在可編程交換機上運行各種測量任務,以支持管理決策(例如流量工程或異常檢測)。雖然之前的工作已經表明運行單個sketch實例的可行性,但它們在很大程度上忽略了為一組測量任務運行多個sketch實例的問題。因此,現有的工作不足以有效地支持sketch實例的一般集合。在這項工作中,我們介紹了 Sketchovsky 的設計和實現,這是一種新穎的cross-sketch優化和構圖框架。我們確定了五個新的cross-sketch優化構建塊,以減少關鍵的交換機硬件資源。我們設計了有效的啟發式方法來為任意集合選擇和應用這些構建塊。為了簡化開發人員的工作,Sketchovsky 自動生成要輸入到硬件編譯器的組合代碼。我們的評估表明,Sketchovsky 使多達 18 個sketch實例的集成變得可行,并且可以減少多達 45% 的關鍵硬件資源。 標題:RingLeader: Efficiently Offloading Intra-Server Orchestration to NICs

標題:RingLeader: Efficiently Offloading Intra-Server Orchestration to NICs作者:Jiaxin Lin, Adney Cardoza, Tarannum Khan, and Yeonju Ro, UT Austin; Brent E. Stephens, University of Utah; Hassan Wassel, Google; Aditya Akella, UT Austin

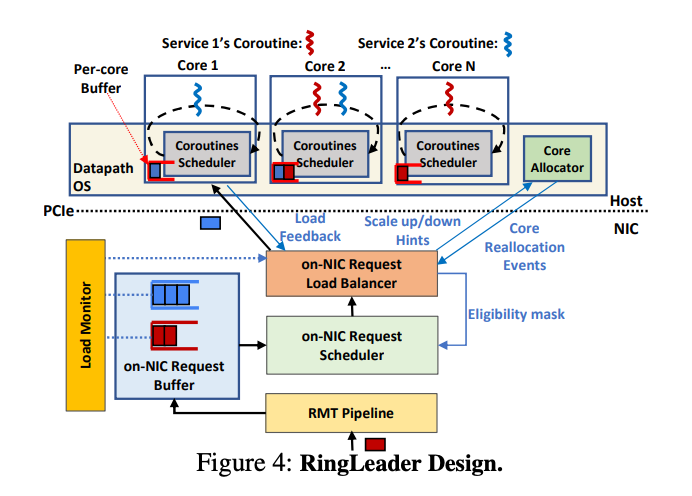

>摘要在數據中心服務器上周密的編排請求,對于滿足嚴格的尾部延遲要求并確保高吞吐量和最佳 CPU 利用率至關重要。編排是多管齊下的,涉及到負載平衡和調度跨CPU資源屬于不同服務的請求,以及調整 CPU 分配以適應突發請求。集中式服務器內編排提供了理想的負載平衡性能、調度精度和突發容錯 CPU 重新分配。然而,現有的純軟件方法無法實現理想的編排,因為它們的可擴展性有限,并且浪費 CPU 資源。我們主張采用一種新方法,將服務器內編排完全卸載到網卡。我們提出了RingLeader,一個新的可編程網卡,具有新穎的硬件單元,用于軟件通知請求負載平衡和可編程調度,以及一個新的輕量級 OS-NIC 接口,可實現 NIC-CPU 緊密協調并支持 NIC 輔助 CPU 調度。基于 100 Gbps FPGA 原型的詳細實驗表明,與包括 Shinjuku 和 Caladan 在內的最先進的純軟件協調器相比,我們獲得了更好的可擴展性、效率、延遲和吞吐量。 ?

?RDMA

標題:SRNIC: A Scalable Architecture for RDMA NICs

?

?RDMA

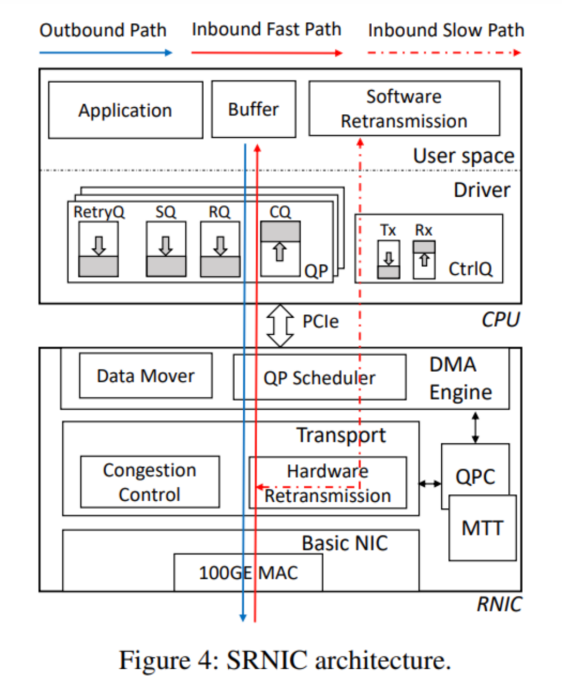

標題:SRNIC: A Scalable Architecture for RDMA NICs作者:Zilong Wang, Hong Kong University of Science and Technology; Layong Luo and Qingsong Ning, ByteDance; Chaoliang Zeng, Wenxue Li, and Xinchen Wan, Hong Kong University of Science and Technology等

>摘要符合設想的RDMA需要具有高度可擴展性:在不可避免丟包的大型數據中心網絡中表現良好(即高網絡可擴展性),并支持每臺服務器大量高性能連接(即高可擴展性)。商用RoCEv2 NIC(RNIC)缺乏可擴展性,因為它們依賴于無損、有限規模的網絡結構,只支持少量高性能連接。在本文中,我們旨在通過設計SRNIC(一種可擴展RDMA NIC架構)來解決連接可擴展性挑戰,同時保持商用RNIC的高性能和低CPU開銷,以及IRN的高網絡可擴展性。我們對SRNIC的關鍵見解是,通過仔細的協議和架構協同設計,可以將RNIC中的片上數據結構及其內存需求降至最低,從而提高連接可擴展性。在此基礎上,我們分析了RDMA概念模型中涉及的所有數據結構,并通過RDMA協議頭修改和架構創新(包括無緩存QP調度器和無內存選擇性重傳)盡可能多地刪除它們。我們使用FPGA實現了一個功能齊全的SRNIC原型。實驗表明,SRNIC在芯片上實現了10K性能連接,在標準化連接可擴展性(即每1MB內存的性能連接數)方面比商用RNIC高18倍,同時實現了97 Gbps吞吐量和3.3μs延遲,CPU開銷低于5%,并保持了高網絡可擴展性。 標題:Hostping: Diagnosing Intra-host Network Bottlenecks in RDMA Servers

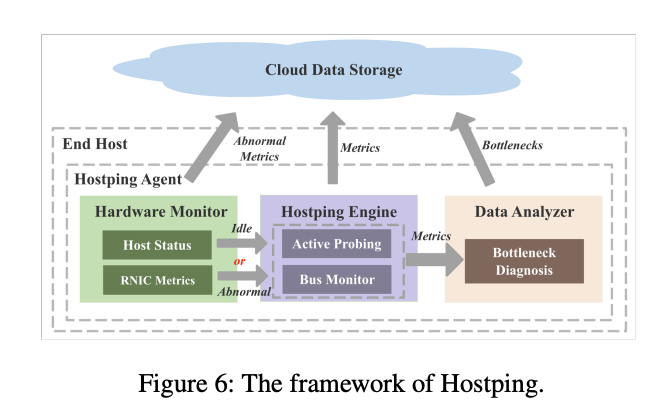

標題:Hostping: Diagnosing Intra-host Network Bottlenecks in RDMA Servers作者:Kefei Liu, BUPT; Zhuo Jiang, ByteDance Inc.; Jiao Zhang, BUPT and Purple Mountain Laboratories; Haoran Wei, BUPT and ByteDance Inc.; Xiaolong Zhong, BUPT; Lizhuang Tan, ByteDance Inc.; Tian Pan and Tao Huang, BUPT and Purple Mountain Laboratories

>摘要在RDMA網絡中,主機內網絡被認為是健壯的,但很少受到關注。然而,隨著RNIC(RDMA網卡)線路速率快速提升至數百G,主機內網絡成為網絡應用潛在的性能瓶頸。主機內網絡瓶頸可能導致主機內帶寬降低和主機內延遲增加,這會嚴重影響網絡性能。然而,當發生主機內瓶頸時,由于缺乏監控系統,它們很難被發現。此外,現有的瓶頸診斷機制無法有效診斷主機內瓶頸。在本文中,我們根據長期的故障排除經驗分析了主機內瓶頸的癥狀,并提出了 Hostping——首個專用于主機內網絡的瓶頸監控和診斷系統,可實現低開銷分鐘級主機內故障定位,有效提升RDMA數據中心集群的算力平穩輸出能力。Hostping 的核心思想是在主機內的 RNIC 和端點之間進行環回測試,以測量主機內延遲和帶寬。 標題:Understanding RDMA Microarchitecture Resources for Performance Isolation

標題:Understanding RDMA Microarchitecture Resources for Performance Isolation作者:Xinhao Kong and Jingrong Chen, Duke University; Wei Bai, Microsoft; Yechen Xu, Shanghai Jiao Tong University; Mahmoud Elhaddad, Shachar Raindel, and Jitendra Padhye, Microsoft; Alvin R. Lebeck and Danyang Zhuo, Duke University

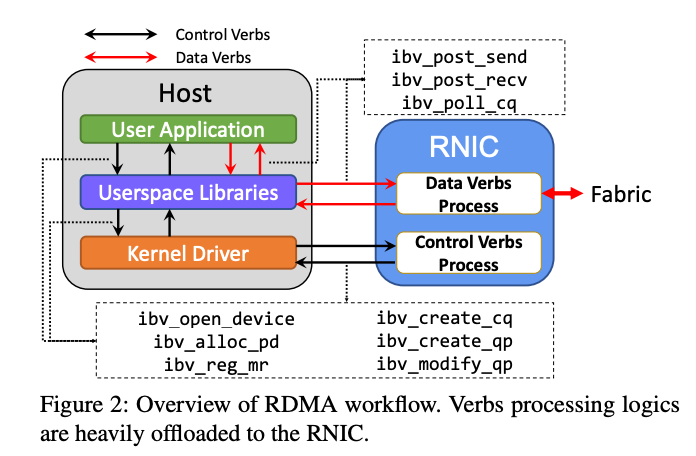

>摘要近年來,RDMA 在云中得到了廣泛采用,以加速first-party workloads,并通過釋放 CPU 周期來節省成本。現在,云提供商正致力于在通用客戶VM 中支持 RDMA,以使 third-party workloads受益。為此,云提供商必須提供強大的性能隔離,以便一個租戶的 RDMA 工作負載不會對另一個租戶的 RDMA 性能產生不利影響。盡管在公有云中的網絡性能隔離方面已經做出了很多努力,但我們發現 RDMA 因其復雜的 NIC 微架構資源(例如NIC 緩存)帶來了獨特的挑戰。在本文中,我們旨在系統地了解 RNIC 微架構資源對性能隔離的影響。我們提出了一個模型來表示 RDMA 操作如何使用 RNIC 資源。使用此模型,我們開發了一個測試套件來評估 RDMA 性能隔離解決方案。最后,根據測試結果,我們總結了設計未來 RDMA 性能隔離解決方案的新見解。 標題:Empowering Azure Storage with RDMA

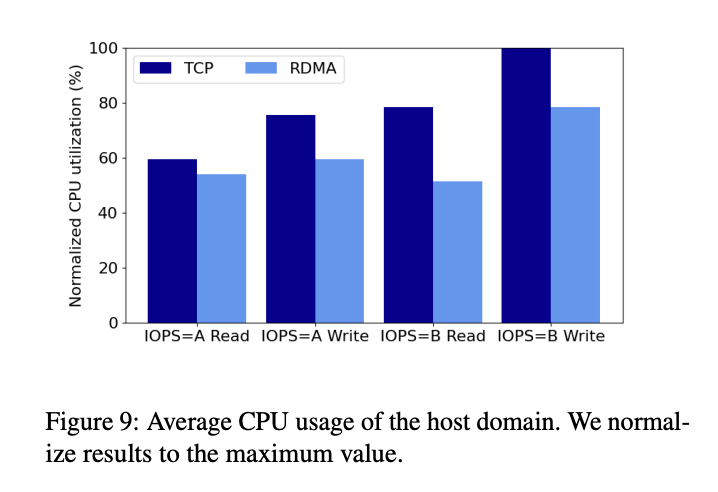

標題:Empowering Azure Storage with RDMA作者:Wei Bai, Shanim Sainul Abdeen, Ankit Agrawal, Krishan Kumar Attre, Paramvir Bahl, Ameya Bhagat, Gowri Bhaskara, Tanya Brokhman, Lei Cao, Ahmad Cheema, Rebecca Chow, Jeff Cohen, Mahmoud Elhaddad等

>摘要網絡是在云存儲服務中實現高性能和高可靠性的關鍵。在Azure中,我們選擇遠程RDMA作為傳輸方式,旨在為存儲前端流量(計算虛擬機和存儲集群之間)和后端流量(存儲集群內)啟用它,以充分發揮其優勢。由于計算和存儲集群可能位于Azure區域內的不同數據中心,因此需要在區域范圍內支持RDMA。這項工作展示了我們在部署區域內RDMA以支持Azure中的存儲工作負載方面的經驗。基礎設施的高度復雜性和異構性帶來了一系列新的挑戰,例如不同類型的RDMA網絡接口卡之間的互操作性問題。為了應對這些挑戰,我們對網絡基礎設施做了一些更改。今天,Azure中大約70%的流量是RDMA,所有Azure公共區域都支持區域內RDMA。RDMA幫助我們實現了顯著的磁盤I/O性能改進和CPU內核節省。 ?

?數據中心

標題:Flattened Clos: Designing High-performance Deadlock-free Expander Data Center Networks Using Graph Contraction

?

?數據中心

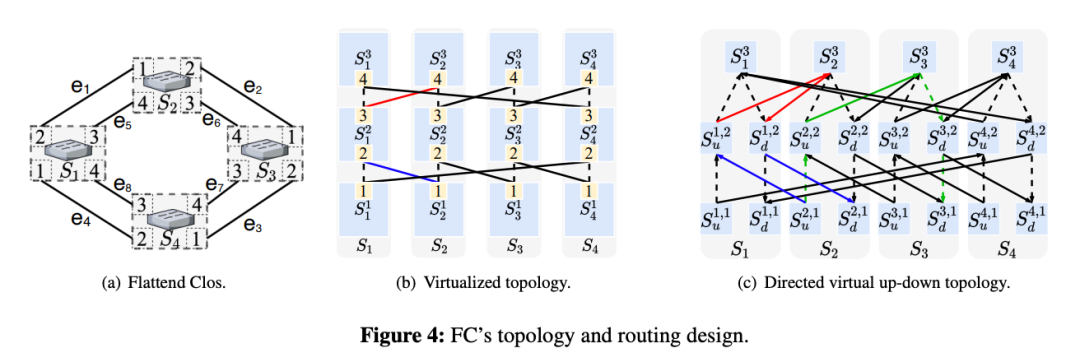

標題:Flattened Clos: Designing High-performance Deadlock-free Expander Data Center Networks Using Graph Contraction作者:Shizhen Zhao, Qizhou Zhang, Peirui Cao, Xiao Zhang, and Xinbing Wang, Shanghai Jiao Tong University; Chenghu Zhou, Shanghai Jiao Tong University and Chinese Academy of Sciences

>摘要Flattened Clos (FC),一種拓撲/路由協同設計方法,用于消除expander網絡中由 PFC 引起的死鎖。FC的拓撲結構和路由設計分為三步:1)將每個ToR交換機在邏輯上劃分為k個虛擬層,只在相鄰虛擬層之間建立連接;2) 生成用于路由的虛擬上下路徑;3) 利用圖形收縮對虛擬多層網絡和虛擬上下路徑進行平面化。FC 的設計是無死鎖的,并使用真實的測試平臺和數據包級仿真驗證了這一特性。與EDST(edge-disjoint-spanning-tree)路由相比,FC 將平均跳數減少了至少 50%,并將網絡吞吐量提高了2 - 10倍以上。 ?標題:Scalable Tail Latency Estimation for Data Center Networks

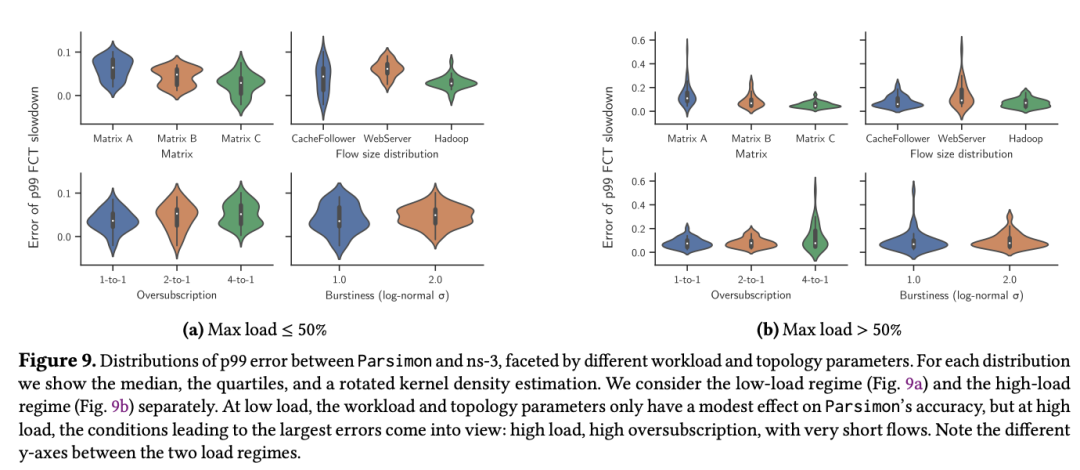

?標題:Scalable Tail Latency Estimation for Data Center Networks作者:Kevin Zhao, University of Washington; Prateesh Goyal, Microsoft Research; Mohammad Alizadeh, MIT CSAIL; Thomas E. Anderson, University of Washington

>摘要該論文主要研究了如何為超大規模數據中心網絡提供流級尾延遲性能的快速估計。網絡尾部延遲通常是云應用性能的一個關鍵指標,它會受到多種因素的影響,包括網絡負載、機架間流量偏差、流量突發、流量大小分布、超額訂閱和拓撲不對稱等。像ns-3 和 OMNeT++ 這樣的網絡模擬器可以提供準確的答案,但很難并行化,即使是中等規模的單個配置也需要數小時或數天來回答 what if 問題。MimicNet 展示了如何使用機器學習來提高模擬性能,不過每個配置都包含一個很長的訓練步驟,并且對工作量和拓撲一致性的假設通常在實踐中并不適用。本文主要介紹了解決上述問題的技術,為具有通用流量矩陣和拓撲的大型網絡提供快速性能估計。其中一個關鍵步驟是將問題分解成大量并行獨立的單鏈路模擬,通過仔細結合這些鏈路級模擬可以準確估計整個網絡的端到端流量級性能分布。同時盡可能利用對稱性來獲得額外的加速,但不依賴機器學習,因此沒有訓練延遲。在 ns-3 需要 11到 27 小時來模擬 5 秒的網絡行為的大規模網絡上,新技術只需 1 到 2 分鐘內便可完成運行,尾流完成時間的準確度在 9% 以內。 標題:Shockwave: Fair and Efficient Cluster Scheduling for Dynamic Adaptation in Machine Learning

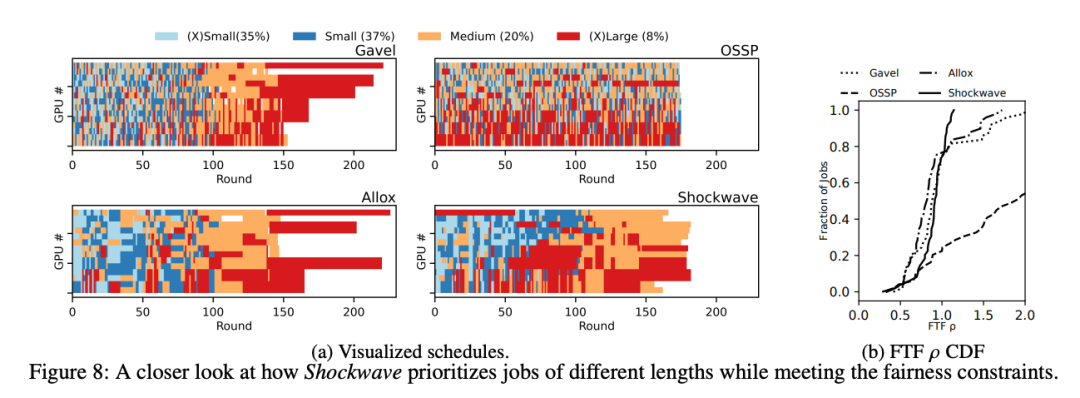

標題:Shockwave: Fair and Efficient Cluster Scheduling for Dynamic Adaptation in Machine Learning作者:Pengfei Zheng and Rui Pan, University of Wisconsin-Madison; Tarannum Khan, The University of Texas at Austin; Shivaram Venkataraman, University of Wisconsin-Madison; Aditya Akella, The University of Texas at Austin

>摘要動態自適應已成為加速分布式機器學習 (ML) 訓練的關鍵技術。最近的研究表明,動態調整模型結構或超參數可以在不犧牲準確性的情況下顯著加速訓練。然而,現有的 ML 集群調度器并不是為處理動態適應而設計的。研究表明,當訓練吞吐量在動態適應下隨時間變化時,現有方案無法提供公平性并降低系統效率。Shockwave是一個基于兩個關鍵思想的未來規劃調度程序。首先,Shockwave 將經典市場理論從靜態設置擴展到動態設置,共同優化效率和公平性。第二,Shockwave 利用隨機動態規劃來處理動態變化。我們為 Shockwave 構建了一個系統,并通過跟蹤驅動模擬和集群實驗驗證了其性能。結果表明,對于具有動態適應性的 ML 作業軌跡,與現有的公平調度方案相比,Shockwave 將 makespan 提高了 1.3 倍,公平性提高了 2 倍。 標題:Protego: Overload Control for Applications with Unpredictable Lock Contention

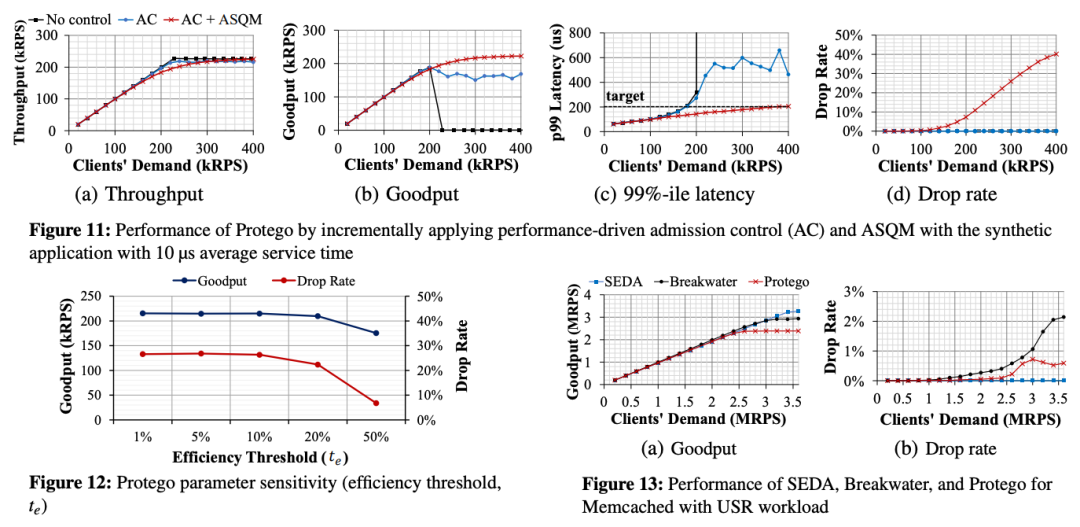

標題:Protego: Overload Control for Applications with Unpredictable Lock Contention作者:Inho Cho, MIT CSAIL; Ahmed Saeed, Georgia Tech; Seo Jin Park, Mohammad Alizadeh, and Adam Belay, MIT CSAIL

>摘要現代數據中心應用程序是并發的,因此它們需要同步來控制對共享數據的訪問。本文介紹了Protego系統用于防止鎖爭用問題。Protego提供了一種新的準入控制策略,可以防止出現鎖爭用時的計算擁塞。關鍵思想是在基于信用的準入控制算法中使用觀察到的吞吐量的邊際改進,而不是 CPU 負載或延遲測量,該算法調節對服務器的傳入請求的速率。Protego還引入了一種新的延遲感知同步抽象,稱為ASQM(Active synchronization Queue Management),允許應用程序在延遲超過延遲目標時中止請求。Protego 目前已經應用于兩個真實的應用程序 Lucene 和 Memcached,并表明它在避免擁塞崩潰的同時,比最先進的過載控制系統實現了高達3.3倍的吞吐量和低12.2倍的99%延遲。 GPU標題:Transparent GPU Sharing in Container Clouds for Deep Learning Workloads

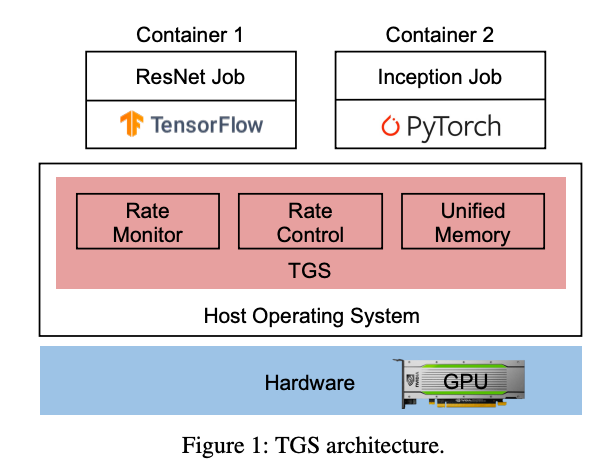

GPU標題:Transparent GPU Sharing in Container Clouds for Deep Learning Workloads作者:Bingyang Wu and Zili Zhang, Peking University; Zhihao Bai, Johns Hopkins University; Xuanzhe Liu and Xin Jin, Peking University

>摘要容器廣泛用于數據中心的資源管理。在容器云中支持深度學習 (DL) 訓練的一種常見做法是將 GPU 靜態綁定到整個容器。由于生產中 DL 作業的資源需求多種多樣,大量 GPU 未得到充分利用。因此,GPU 集群的 GPU 利用率較低,導致作業完成時間較長,因為需要排隊。TGS(Transparent GPU Sharing)是一個為容器云中的 DL 訓練提供透明 GPU 共享的系統。與最近用于 GPU 共享的應用層解決方案形成鮮明對比的是,TGS 在容器下的操作系統層運行。TGS 利用自適應速率控制和透明統一內存來同時實現高 GPU 利用率和性能隔離。它確保生產作業不會受到共享 GPU 上的機會作業的很大影響。我們構建了 TGS 并將其與 Docker 和 Kubernetes 集成。實驗表明 (i) TGS 對生產作業的吞吐量影響很小;(ii) TGS為機會作業提供了與最先進的應用層解決方案AntMan相似的吞吐量,并且與現有的操作系統層解決方案MPS相比,其吞吐量提高了15倍。 ?標題:ARK: GPU-driven Code Execution for Distributed Deep Learning

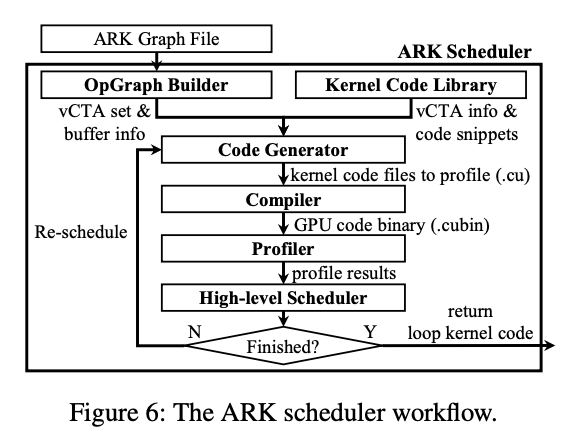

?標題:ARK: GPU-driven Code Execution for Distributed Deep Learning作者:Changho Hwang, KAIST, Microsoft Research; KyoungSoo Park, KAIST; Ran Shu, Xinyuan Qu, Peng Cheng, and Yongqiang Xiong, Microsoft Research

>摘要目前最先進的深度學習 (DL) 應用程序傾向于橫向擴展到大量并行 GPU。然而,我們觀察到跨 GPU 的集體通信開銷通常是分布式 DL 性能的關鍵限制因素。它通過頻繁傳輸小數據塊來充分利用網絡帶寬,這也會在 GPU 上產生大量 I/O 開銷,從而干擾 GPU 上的計算。根本原因在于基于 CPU 的通信事件處理效率低下以及無法通過 GPU 線程控制 GPU 內部的 DMA 引擎。為了解決這個問題,我們提出了一個 GPU 驅動的代碼執行系統,該系統利用 GPU 控制的硬件 DMA 引擎進行 I/O 卸載。我們的自定義 DMA 引擎流水線處理多個 DMA 請求以支持高效的小型數據傳輸,同時消除了 GPU 內核上的 I/O 開銷。與僅由 CPU 啟動的現有 GPU DMA 引擎不同,我們讓 GPU 線程直接控制 DMA 操作,其中 GPU 驅動自己的執行流并自主處理通信事件,而無需 CPU 干預,更高效。我們的原型 DMA 引擎從小至 8KB 的消息大小(吞吐量提高 3.9 倍)的線速,通信延遲僅為 4.3 微秒(快 9.1 倍),同時它對 GPU 上的計算幾乎沒有干擾,在實際訓練工作負載中實現了1.8倍的吞吐量。 標題:BGL: GPU-Efficient GNN Training by Optimizing Graph Data I/O and Preprocessing

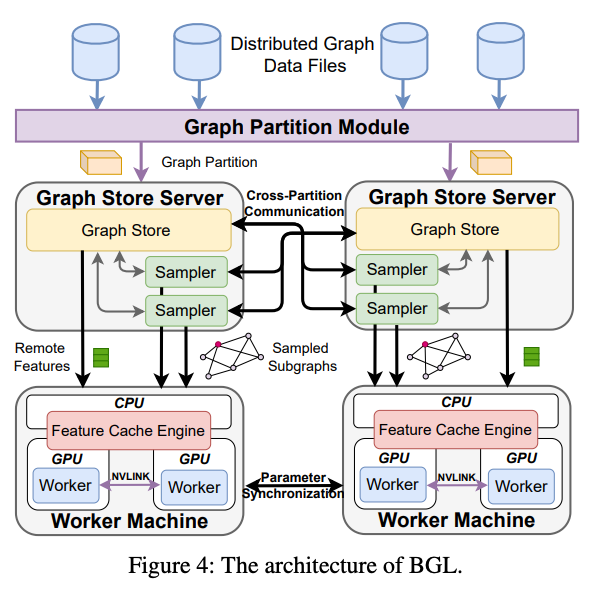

標題:BGL: GPU-Efficient GNN Training by Optimizing Graph Data I/O and Preprocessing作者:Tianfeng Liu, Tsinghua University, Zhongguancun Laboratory, ByteDance; Yangrui Chen, The University of Hong Kong, ByteDance; Dan Li, Tsinghua University, Zhongguancun Laboratory; Chuan Wu, The University of Hong Kong; Yibo Zhu, Jun He, and Yanghua Peng, ByteDance; Hongzheng Chen, ByteDance, Cornell University; Hongzhi Chen and Chuanxiong Guo, ByteDance

>摘要現有系統在使用 GPU 訓練具有數十億個節點和邊的大型圖形時效率低下,主要瓶頸是為 GPU 準備數據的過程——子圖采樣和特征檢索。本文提出了 BGL,一種分布式 GNN 訓練系統,旨在通過幾個關鍵思想解決瓶頸問題。首先是提出了一個動態緩存引擎來最小化特征檢索流量。通過共同設計緩存策略和采樣順序,我們找到了低開銷和高緩存命中率的最佳平衡點。其次改進了圖分區算法,以減少子圖采樣期間的跨分區通信。最后,仔細的資源隔離減少了不同數據預處理階段之間的爭用。在各種 GNN 模型和大型圖形數據集上進行的大量實驗表明,BGL 的平均性能明顯優于現有 GNN 訓練系統 1.9 倍。 ?標題:Zeus: Understanding and Optimizing GPU Energy Consumption of DNN Training

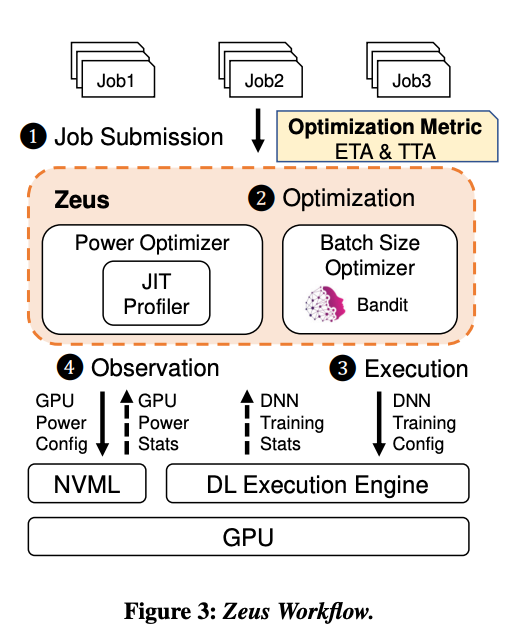

?標題:Zeus: Understanding and Optimizing GPU Energy Consumption of DNN Training作者:Jie You, Jae-Won Chung, and Mosharaf Chowdhury, University of Michigan

>摘要我們觀察到優化深度神經網絡((DNN)訓練的常見做法通常會導致能效低下,而能源消耗和性能優化之間需要存在權衡。Zeus是一種優化框架,可通過自動為重復出現的 DNN 訓練作業找到最佳作業和 GPU 級配置來進行權衡。Zeus 將在線探索-開發方法與實時能量分析相結合,避免了對昂貴的離線測量的需要,同時適應了數據隨時間的變化。評估表明,Zeus 可以針對不同的工作負載將 DNN 訓練的能效提高 15.3%–75.8%。

審核編輯 :李倩

-

gpu

+關注

關注

28文章

4743瀏覽量

129006 -

可編程

+關注

關注

2文章

865瀏覽量

39843 -

網絡通信

+關注

關注

4文章

808瀏覽量

29833

原文標題:NSDI '23熱點論文:可編程、RDMA、數據中心、GPU有哪些新動態?(附下載)

文章出處:【微信號:SDNLAB,微信公眾號:SDNLAB】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

當CPU/GPU遭遇數據中心功耗天花板,SDAccel來了

數據中心是什么

Mali-Valhall系列GPU可編程內核

基于現場可編程芯片的動態下載應用研究

可編程SoC(SoPC),什么是可編程SoC(SoPC)

如何利用可編程邏輯實現數據中心互連 DCI互連盒架構解讀

可編程邏輯實現數據中心互連

NSDI '23熱點論文:可編程、RDMA、數據中心、GPU有哪些新動態?

NSDI '23熱點論文:可編程、RDMA、數據中心、GPU有哪些新動態?

評論