預(yù)訓(xùn)練 AI 模型是為了完成特定任務(wù)而在大型數(shù)據(jù)集上訓(xùn)練的深度學(xué)習(xí)模型。這些模型既可以直接使用,也可以根據(jù)不同行業(yè)的應(yīng)用需求進(jìn)行自定義。

如果要教一個(gè)剛學(xué)會(huì)走路的孩子什么是獨(dú)角獸,那么我們首先應(yīng)該向孩子展示這種生物的圖像并描述其獨(dú)有特征。

那么,如果要教一臺(tái)人工智能(AI)機(jī)器什么是獨(dú)角獸,該從什么地方做起呢?

預(yù)訓(xùn)練 AI 模型提供了解決方案。

預(yù)訓(xùn)練 AI 模型是一種為了完成某項(xiàng)特定任務(wù)而在大型數(shù)據(jù)集上進(jìn)行訓(xùn)練的深度學(xué)習(xí)模型,它是一種類腦神經(jīng)算法的表現(xiàn)形式,可以根據(jù)數(shù)據(jù)找到模式或進(jìn)行預(yù)測(cè)。預(yù)訓(xùn)練 AI 模型既可以直接使用,也可以根據(jù)某個(gè)應(yīng)用的具體需求進(jìn)行進(jìn)一步微調(diào)。

為什么使用預(yù)訓(xùn)練 AI 模型?

開發(fā)者可以使用預(yù)訓(xùn)練模型并根據(jù)需求對(duì)其進(jìn)行自定義,無需從頭開始構(gòu)建 AI 模型。

無論是識(shí)別一匹虛構(gòu)的馬,檢測(cè)自動(dòng)駕駛汽車的安全隱患,還是根據(jù)醫(yī)學(xué)影像診斷癌癥,要構(gòu)建一個(gè) AI 應(yīng)用,開發(fā)者首先需要一個(gè)能夠完成特定任務(wù)的 AI 模型。而這個(gè)模型需要大量具有代表性的數(shù)據(jù)進(jìn)行學(xué)習(xí)。

模型的學(xué)習(xí)過程需要經(jīng)歷好幾層傳入數(shù)據(jù),并在每一層強(qiáng)調(diào)與目標(biāo)相關(guān)的特征。

例如,在創(chuàng)建一個(gè)能夠識(shí)別獨(dú)角獸的模型時(shí),首先會(huì)為其提供獨(dú)角獸、馬、貓、老虎和其他動(dòng)物的圖像作為傳入數(shù)據(jù)。

然后再構(gòu)建具有代表性的數(shù)據(jù)特征層。從線條、顏色等簡(jiǎn)單特征開始,深入到復(fù)雜的結(jié)構(gòu)特征。依據(jù)計(jì)算出的概率,這些特征將被賦予不同程度的相關(guān)性。

舉個(gè)例子,當(dāng)一個(gè)生物看起來越像馬,它是獨(dú)角獸而不是貓或老虎的概率就越大。這些概率值被存儲(chǔ)在 AI 模型的每個(gè)神經(jīng)網(wǎng)絡(luò)層。隨著層數(shù)的增加,模型對(duì)表征的理解程度也在提高。

若要從頭開始創(chuàng)建一個(gè)這樣的模型,開發(fā)者通常需要調(diào)用包含數(shù)十億行數(shù)據(jù)的巨大數(shù)據(jù)集,并且這些數(shù)據(jù)可能十分昂貴且難以獲得。但如果因此在數(shù)據(jù)上讓步,就會(huì)導(dǎo)致模型性能不佳。

預(yù)先計(jì)算的概率表征(也稱權(quán)重)能夠節(jié)省開發(fā)者或企業(yè)的時(shí)間、金錢和精力。已建立完成的預(yù)訓(xùn)練模型可通過這些權(quán)重進(jìn)行訓(xùn)練。

高質(zhì)量的預(yù)訓(xùn)練模型搭配大量準(zhǔn)確且具有代表性的權(quán)重可以提高 AI 部署的成功率。

權(quán)重可以被修改,而且可以通過添加更多數(shù)據(jù)為模型進(jìn)行進(jìn)一步的自定義或微調(diào)。

在預(yù)訓(xùn)練模型基礎(chǔ)上進(jìn)行構(gòu)建的開發(fā)者可以更快創(chuàng)建出 AI 應(yīng)用,因?yàn)樗麄儫o需處理堆積如山的傳入數(shù)據(jù)或去計(jì)算密集的數(shù)據(jù)層的概率。

換言之,使用預(yù)訓(xùn)練 AI 模型就像是用一件成衣根據(jù)自己的需求進(jìn)行剪裁,而不用從布料和針線做起。

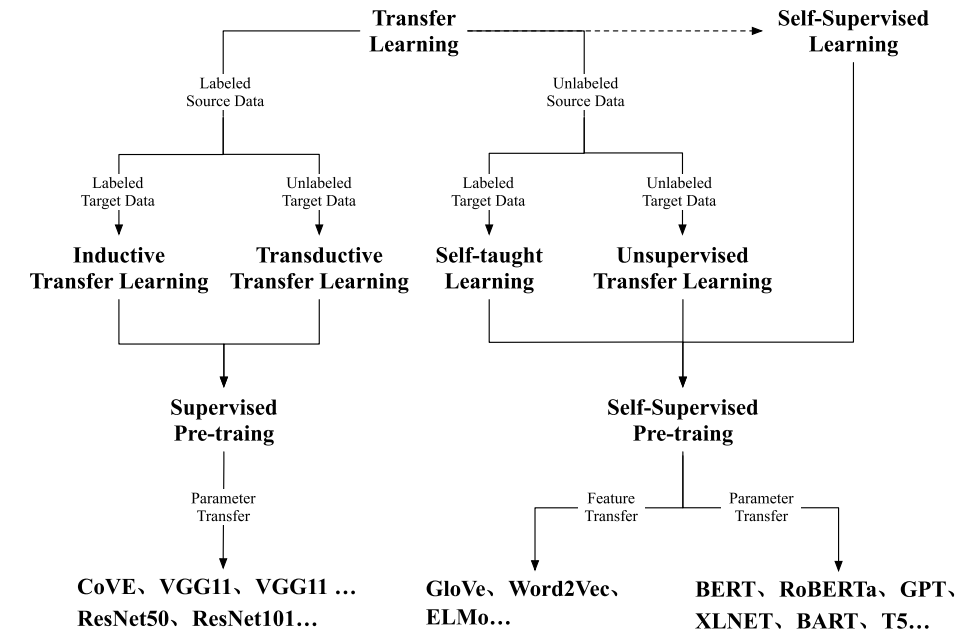

預(yù)訓(xùn)練 AI 模型通常被用于遷移學(xué)習(xí),可以基于多種模型架構(gòu)類型而構(gòu)建。其中一種流行的架構(gòu)類型是 Transformer 模型,一種通過追蹤連續(xù)數(shù)據(jù)中的關(guān)系來學(xué)習(xí)上下文和意義的神經(jīng)網(wǎng)絡(luò)。

AI 公司 Clarifai 的平臺(tái)高級(jí)副總裁 Alfredo Ramos 表示,預(yù)訓(xùn)練模型可以將 AI 應(yīng)用的開發(fā)時(shí)間縮短一年并節(jié)約數(shù)十萬美元的成本。

預(yù)訓(xùn)練模型如何推動(dòng) AI 的發(fā)展?

預(yù)訓(xùn)練模型簡(jiǎn)化并加快了 AI 的開發(fā),許多開發(fā)者和公司通過它們來加速各種 AI 用例。

預(yù)訓(xùn)練模型主要推動(dòng)了以下幾個(gè)領(lǐng)域的 AI 發(fā)展:

自然語言處理:預(yù)訓(xùn)練模型被用于翻譯、聊天機(jī)器人等自然語言處理應(yīng)用。大型語言模型一般基于 Transformer 模型架構(gòu)構(gòu)建,是預(yù)訓(xùn)練模型的延伸。世界上最大的 AI 模型之一NVIDIA NeMo Megatron就是一個(gè)預(yù)訓(xùn)練大型語言模型。

語音 AI:預(yù)訓(xùn)練模型能幫助語音 AI 應(yīng)用在不同的語言下也能直接使用。用例包括呼叫中心自動(dòng)化、AI 助手和語音識(shí)別技術(shù)。

計(jì)算機(jī)視覺:如上文所述的獨(dú)角獸模型,預(yù)訓(xùn)練模型可以幫助 AI 快速識(shí)別生物或者物體、地點(diǎn)和人。預(yù)訓(xùn)練模型通過這種方式加速計(jì)算機(jī)視覺,為體育運(yùn)動(dòng)、智慧城市等領(lǐng)域的應(yīng)用提供近似于人類的視覺能力。

醫(yī)療:在醫(yī)療應(yīng)用方面,MegaMolBART(NVIDIA BioNeMo服務(wù)和框架的一部分)等預(yù)訓(xùn)練 AI 模型能夠理解化學(xué)語言并學(xué)習(xí)現(xiàn)實(shí)世界分子中原子之間的關(guān)系,為科學(xué)界提供了一種加快藥物研發(fā)的強(qiáng)大工具。

網(wǎng)絡(luò)安全:預(yù)訓(xùn)練模型為實(shí)施 AI 網(wǎng)絡(luò)安全解決方案打下了基礎(chǔ),并幫助人類安全分析師更快的發(fā)現(xiàn)威脅。包括人類和機(jī)器的數(shù)字指紋及異常、敏感信息和網(wǎng)絡(luò)釣魚檢測(cè)等多種情況。

藝術(shù)和創(chuàng)作流程:為推動(dòng)最新的 AI 藝術(shù)浪潮,預(yù)訓(xùn)練模型可以在GauGAN和NVIDIA Canvas等工具的幫助下加快創(chuàng)作流程。

預(yù)訓(xùn)練 AI 模型的自定義和微調(diào)為其帶來了無限的應(yīng)用可能性,因此也可以用于更多其他行業(yè)。

何處獲取預(yù)訓(xùn)練 AI 模型

谷歌、Meta、微軟、NVIDIA 等公司正在發(fā)明用于構(gòu)建 AI 模型的尖端模型架構(gòu)和框架。

這些模型有時(shí)會(huì)在模型中心或作為開放源碼發(fā)布,使開發(fā)者能夠?qū)︻A(yù)訓(xùn)練 AI 模型進(jìn)行微調(diào)、提高其準(zhǔn)確性并擴(kuò)展模型庫。

NVIDIA NGC匯集了通過 GPU 優(yōu)化的 AI 軟件、模型和 Jupyter Notebook 示例,包括各種預(yù)訓(xùn)練模型以及為 NVIDIA AI 平臺(tái)優(yōu)化的 AI 基準(zhǔn)和訓(xùn)練方式。

NVIDIA AI Enterprise是一套全面且安全的云原生 AI 與數(shù)據(jù)分析軟件套件,包含未加密的預(yù)訓(xùn)練模型。這讓希望將 NVIDIA 預(yù)訓(xùn)練模型整合到其自定義 AI 應(yīng)用中的開發(fā)者和企業(yè)能夠查看模型權(quán)重和偏差、提高可解釋性并輕松進(jìn)行調(diào)試。

在 GitHub、Hugging Face 等平臺(tái)也有數(shù)千個(gè)可供使用的開源模型。

十分重要的是,在訓(xùn)練預(yù)訓(xùn)練模型時(shí),模型數(shù)據(jù)必須透明、可解釋、符合隱私要求,并且是獲得同意許可且無偏見的道德數(shù)據(jù)。

NVIDIA 預(yù)訓(xùn)練 AI 模型

為幫助更多開發(fā)者將 AI 原型投入到生產(chǎn)中,NVIDIA 提供了幾種開箱即用的預(yù)訓(xùn)練模型:

NVIDIA SegFormer是一個(gè)在 GitHub 上提供的 Transformer 模型,可實(shí)現(xiàn)簡(jiǎn)單、高效、強(qiáng)大的語義分割。

NVIDIA 的專用計(jì)算機(jī)視覺模型經(jīng)數(shù)百萬張圖像訓(xùn)練而成,可用于智慧城市、停車管理等應(yīng)用。

NVIDIA NeMo Megatron是一個(gè)大型可定制語言模型,包含在 NVIDIA NeMo 中。NeMo 是一個(gè)用于構(gòu)建靈活、高性能對(duì)話式 AI、語音 AI 和生物學(xué)應(yīng)用的開源框架。

NVIDIA StyleGAN是一個(gè)基于風(fēng)格的生成器架構(gòu),用于生成式對(duì)抗網(wǎng)絡(luò)(或稱 GAN)。它可以使用遷移學(xué)習(xí)來無限生成各種不同風(fēng)格的繪畫。

除此之外,NVIDIA 還能夠提供:

NVIDIA Riva:一款用于構(gòu)建和部署語音 AI 應(yīng)用的 GPU 加速軟件開發(fā)工具包,包含了十種語言的預(yù)訓(xùn)練模型。

MONAI:由 NVIDIA 和倫敦國王學(xué)院聯(lián)合開發(fā)的開源醫(yī)療研究 AI 框架,包含了用于醫(yī)學(xué)影像的預(yù)訓(xùn)練模型

審核編輯:湯梓紅

-

NVIDIA

+關(guān)注

關(guān)注

14文章

4978瀏覽量

102987 -

AI

+關(guān)注

關(guān)注

87文章

30728瀏覽量

268886 -

人工智能

+關(guān)注

關(guān)注

1791文章

47183瀏覽量

238245 -

模型

+關(guān)注

關(guān)注

1文章

3226瀏覽量

48807

原文標(biāo)題:麗臺(tái)科普 | 什么是預(yù)訓(xùn)練 AI 模型?

文章出處:【微信號(hào):Leadtek,微信公眾號(hào):麗臺(tái)科技】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

基于不同量級(jí)預(yù)訓(xùn)練數(shù)據(jù)的RoBERTa模型分析

【大語言模型:原理與工程實(shí)踐】大語言模型的預(yù)訓(xùn)練

訓(xùn)練好的ai模型導(dǎo)入cubemx不成功怎么解決?

小米在預(yù)訓(xùn)練模型的探索與優(yōu)化

2021 OPPO開發(fā)者大會(huì):NLP預(yù)訓(xùn)練大模型

如何實(shí)現(xiàn)更綠色、經(jīng)濟(jì)的NLP預(yù)訓(xùn)練模型遷移

一種基于亂序語言模型的預(yù)訓(xùn)練模型-PERT

利用視覺語言模型對(duì)檢測(cè)器進(jìn)行預(yù)訓(xùn)練

使用 NVIDIA TAO 工具套件和預(yù)訓(xùn)練模型加快 AI 開發(fā)

NVIDIA 和 Evozyne 創(chuàng)建用于生成蛋白質(zhì)的生成式 AI 模型

淺析預(yù)訓(xùn)練模型的起源與發(fā)展

什么是預(yù)訓(xùn)練 AI 模型?

預(yù)訓(xùn)練模型的基本原理和應(yīng)用

大語言模型的預(yù)訓(xùn)練

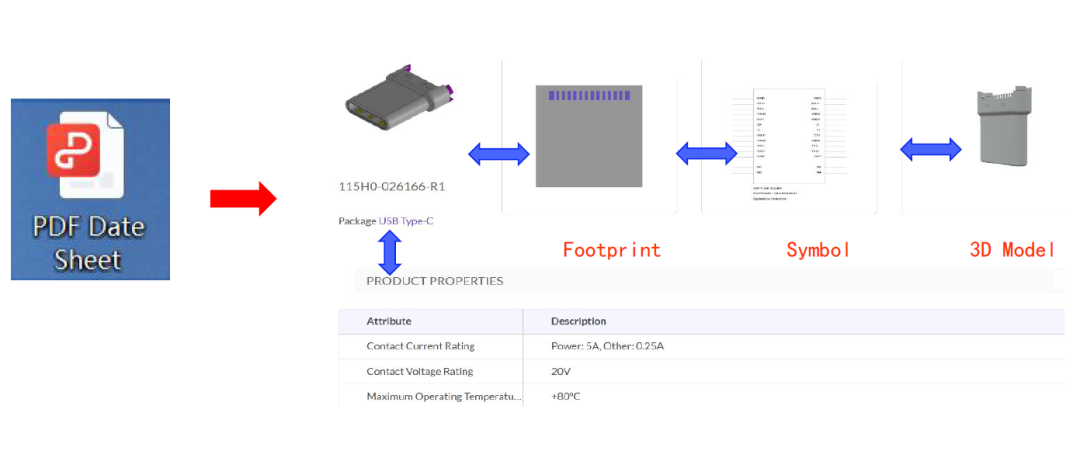

KiCon演講回顧(四):AI助力電子元件庫自動(dòng)化提取

什么是預(yù)訓(xùn)練AI模型?

什么是預(yù)訓(xùn)練AI模型?

評(píng)論