Introduction

Hi,guys.今天我們來介紹一下人工智能下棋,我們將用機械臂來作為對手跟你進行下棋。

人工智能下棋的研究可以追溯到20世紀50年代。當時,計算機科學家開始探索如何編寫程序,使計算機能夠下象棋。其中最著名的例子是由IBM研發(fā)的Deep Blue,它在1997年以3.5-2.5的成績擊敗了當時的世界象棋冠軍加里·卡斯帕羅夫。

人工智能下棋,就好像給電腦一個思考的方式讓它在比賽中取得勝利。這個思考的方式有很多種,大多數(shù)都源于優(yōu)秀的算法。Deep Blue的核心算法是基于暴力窮舉:生成所有可能的走法,然后執(zhí)行盡可能深的搜索,并不斷對局面進行評估,嘗試找出最佳走法。

今天我將要介紹一款AI機械臂下棋是如何來實現(xiàn)的。

**Connect 4 **

Connect4是今天要介紹的一種策略棋類游戲,也被稱為是四子棋。Connect4的游戲目標是在一個垂直放置的6行7列網(wǎng)格中先達成連續(xù)四個棋子的橫向、縱向或斜向排列。兩名玩家輪流在網(wǎng)格的頂部插入自己的棋子,棋子會落到當前列的最底部可用的位置。玩家可以選擇將自己的棋子放置在任意一列,但棋子只能被放置在已有棋子下方的位置。

就如動圖中所示,這就是connect4。

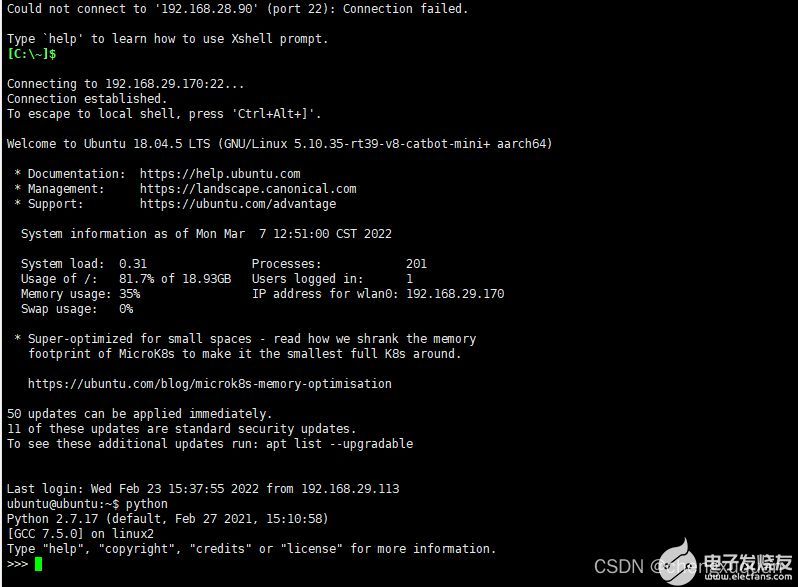

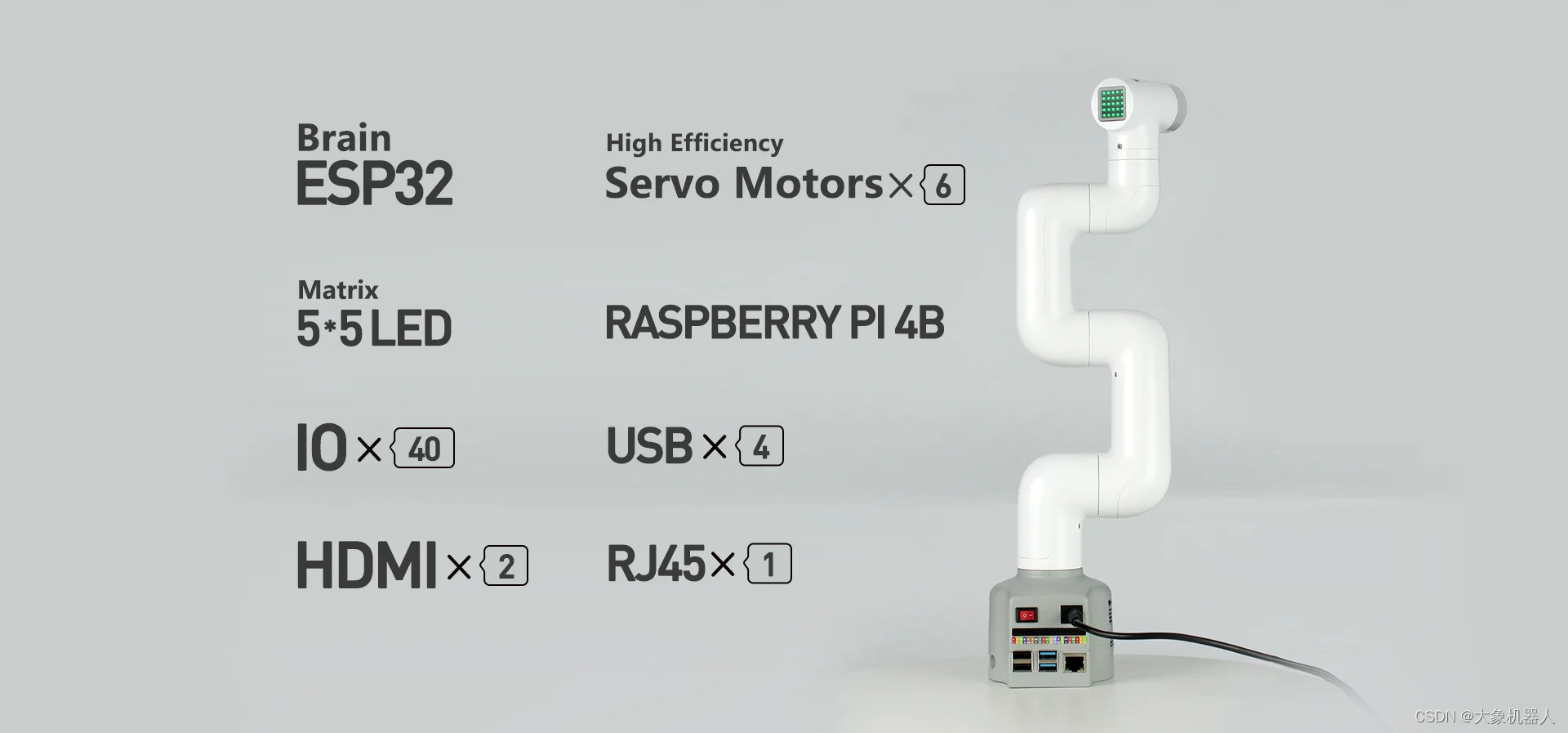

myCobot 280

機械臂這邊選擇的是myCobot 280 M5Stack,它是一款功能強大的桌面型六軸機械臂,它采用M5Stack-Basic作為控制核心,支持多種編程語言開發(fā)。Mycobot280的六軸結構使其具有高度的靈活性和精度,能夠進行各種復雜的操作和運動。它支持多種編程語言,包括Python、C++、Java等,使開發(fā)者能夠根據(jù)自己的需求對機械臂進行編程和控制。它的簡單操作界面和詳細的用戶手冊使得用戶能夠快速上手,而且其嵌入式設計使得機械臂的體積小巧,易于攜帶和存儲。

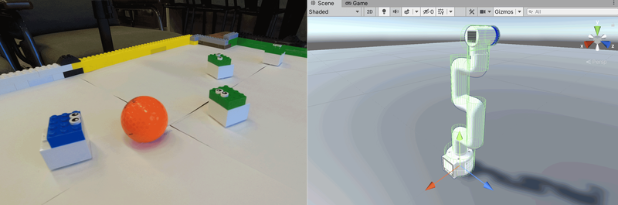

下面是我們搭建的場景。

用myCobot來作為人工智能來跟我們進行下棋。

對弈算法

首先,我們得解決一個最關鍵的問題,就是應該用什么算法來進行對弈。換句話說就是給機械臂提供一個能夠進行思考的大腦。我們將為你簡單介紹幾種常見的對弈算法:

極小化極大算法:

這是一種經(jīng)典的博弈算法,適用于兩人對弈的游戲。它通過遞歸地模擬對手和自己的行動,評估每個可能的走法的得分,并選擇具有最優(yōu)得分的行動。極小化極大算法可以通過搜索棋局的樹狀結構來找到最佳的下棋策略。該算法是一個零總和算法,即一方要在可選的選項中選擇將其優(yōu)勢最大化的選擇,另一方則選擇令對手優(yōu)勢最小化的方法。而開始的時候總和為0。簡單舉例井字棋說明一下。

Max代表我們,Min代表對手。這個時候我們需要給每一種結果一個分數(shù),就是這里的Utility。這個分數(shù)是站在我們(也就是Max)的角度評估的,比如上圖中我贏了就是+1,輸了是-1,平局時0。所以,我們希望最大化這個分數(shù),而對手希望最小化這個分數(shù)。(在游戲中,這個分數(shù)被稱為static value。)這里要說一下,井字棋是個比較簡單的游戲,所以可以列出所有可能的結果。但是,大部分游戲是不太可能把所有結果都列出來的。根據(jù)計算機運算量,我們可能只能往前推7,8步,所以這個時候分數(shù)就不只-1,1,0這么簡單了,會有專門的算法來根據(jù)當前結果給不同的分數(shù)。

Alpha-Beta剪枝算法:

這是對極小化極大算法的優(yōu)化。它通過剪枝來減少搜索的分支數(shù),從而加快搜索速度。Alpha-Beta剪枝算法利用上下界(Alpha和Beta值)來判斷哪些分支可以被丟棄,從而減少搜索的深度。

神經(jīng)網(wǎng)絡+深度學習:

我們設計的對弈算法connect4中用到的也是神經(jīng)網(wǎng)絡+深度學習來解決對弈的算法。

神經(jīng)網(wǎng)絡:

科學家一直希望模擬人的大腦,造出可以思考的機器。人為什么能夠思考?科學家發(fā)現(xiàn),原因在于人體的神經(jīng)網(wǎng)絡。神經(jīng)網(wǎng)絡是一種模擬人腦神經(jīng)系統(tǒng)結構和功能的數(shù)學模型,通過模擬神經(jīng)元之間的連接和信號傳遞來進行信息處理和學習。神經(jīng)網(wǎng)絡是一切人工智能的開始。

神經(jīng)網(wǎng)絡算法的基本思想是將輸入數(shù)據(jù)傳遞給網(wǎng)絡的輸入層,然后通過一系列中間層(隱藏層)的計算和傳遞,最終得到輸出層的結果。訓練過程通過調(diào)整連接權重來最小化實際輸出與期望輸出之間的差異,以優(yōu)化網(wǎng)絡的性能。

深度學習:

深度學習是一種機器學習的分支,專注于利用深度神經(jīng)網(wǎng)絡進行學習和推理。深度學習通過構建深層次的神經(jīng)網(wǎng)絡,也就是有多個中間層(隱藏層)的神經(jīng)網(wǎng)絡,來解決復雜的學習和決策問題。可以說深度學習是利用神經(jīng)網(wǎng)絡作為核心工具的一種學習方法。深度學習不僅包括了神經(jīng)網(wǎng)絡的結構和算法,還包括了訓練方法、優(yōu)化算法和大規(guī)模數(shù)據(jù)處理等方面的內(nèi)容。

項目的構建

項目主要分為,硬件和軟件兩個部分:

該項目中最為重要的就是信息收集和信息分析和處理這一部分內(nèi)容。

前面也提到了神經(jīng)算法和深度學習的相關知識,我們使用到的是DQN神經(jīng)網(wǎng)絡。

DQN神經(jīng)網(wǎng)絡

DQN神經(jīng)網(wǎng)絡是由DeepMind公司提出的,它結合了深度學習和強化學習的思想。DQN通過使用深度神經(jīng)網(wǎng)絡來估計狀態(tài)-動作值函數(shù)(Q函數(shù)),從而實現(xiàn)對復雜環(huán)境中的最優(yōu)決策DQN的核心思想是使用深度神經(jīng)網(wǎng)絡作為函數(shù)逼近器來近似狀態(tài)-動作值函數(shù)。通過將當前狀態(tài)作為輸入,神經(jīng)網(wǎng)絡輸出每個動作的對應Q值,即預測該動作在當前狀態(tài)下的長期回報。然后,根據(jù)Q值選擇最優(yōu)的動作進行執(zhí)行。

環(huán)境搭建

首先我們要定義Connect4這個游戲,用一個二維數(shù)組表示游戲棋盤,兩種顏色的棋子,紅色R,黃色Y。再定義游戲結束的條件,當有四個統(tǒng)一顏色的棋子連成一線就退出游戲。

#Define a 6*7 chessboard

self.bgr_data_grid = [[None for j in range(6)] for i in range(7)]

#Used to display the state of the board

def debug_display_chess_console(self):

for y in range(6):

for x in range(7):

cell = self.stable_grid[x][y]

if cell == Board.P_RED:

print(Board.DISPLAY_R, end="")

elif cell == Board.P_YELLOW:

print(Board.DISPLAY_Y, end="")

else:

print(Board.DISPLAY_EMPTY, end="")

print()

print()

復制

下面是定義游戲是否結束的code:

def is_game_over(board):

# Check if there are four consecutive identical pieces in a row.

for row in board:

for col in range(len(row) - 3):

if row[col] != 0 and row[col] == row[col+1] == row[col+2] == row[col+3]:

return True

# Check if there are four consecutive identical pieces in a column.

for col in range(len(board[0])):

for row in range(len(board) - 3):

if board[row][col] != 0 and board[row][col] == board[row+1][col] == board[row+2][col] == board[row+3][col]:

return True

# Examine if there are four consecutive identical pieces in a diagonal line.

for row in range(len(board) - 3):

for col in range(len(board[0]) - 3):

if board[row][col] != 0 and board[row][col] == board[row+1][col+1] == board[row+2][col+2] == board[row+3][col+3]:

return True

for row in range(len(board) - 3):

for col in range(3, len(board[0])):

if board[row][col] != 0 and board[row][col] == board[row+1][col-1] == board[row+2][col-2] == board[row+3][col-3]:

return True

# Verify if the game board is filled completely.

for row in board:

if 0 in row:

return False

return True

復制

構建DQN神經(jīng)網(wǎng)絡

定義神經(jīng)網(wǎng)絡的輸入層和輸出層,其中輸入層的維度應與游戲板的狀態(tài)表示方式相匹配,輸出層的維度應與合法動作的數(shù)量相匹配。簡而言之,輸入層接受游戲棋盤的狀態(tài)信息,輸出層產(chǎn)生對應的動作選擇。

經(jīng)驗緩存區(qū)

機器是需要學習,我們要構建一個經(jīng)驗緩存區(qū),來存儲智能體的經(jīng)驗。這可以是一個列表或隊列,用于存儲游戲過程中的狀態(tài)、動作、獎勵和下一個狀態(tài)等信息。

下面是構建經(jīng)驗緩存區(qū)的偽代碼:

class ReplayBuffer:

def __init__(self, capacity):

self.capacity = capacity

self.buffer = []

def add_experience(self, experience):

if len(self.buffer) >= self.capacity:

self.buffer.pop(0)

self.buffer.append(experience)

def sample_batch(self, batch_size):

batch = random.sample(self.buffer, batch_size)

states, actions, rewards, next_states, dones = zip(*batch)

return states, actions, rewards, next_states, dones

復制

決策

我們定義了一個名為EpsilonGreedyStrategy的策略類,使用ε-greedy策略進行動作選擇和探索。在初始化函數(shù)__init__()中,我們指定了探索率ε。select_action()方法根據(jù)Q值選擇動作,根據(jù)探索率的概率隨機選擇動作或選擇具有最高Q值的動作。

class EpsilonGreedyStrategy:

def __init__(self, epsilon):

self.epsilon = epsilon

def select_action(self, q_values):

if random.random() < self.epsilon:

action = random.randint(0, len(q_values) - 1)

else:

action = max(enumerate(q_values), key=lambda x: x[1])[0]

return action

復制

訓練框架

使用python的PyTorch框架構建訓練,循環(huán)訓練。定期使用當前的DQN神經(jīng)網(wǎng)絡與預訓練的或其他對手進行對弈評估,以評估智能體的性能。直至達到預設的要求。

總結:

本篇文章的內(nèi)容暫告一段落。本文主要介紹了DQN神經(jīng)算法是如何在Connect4 當中實現(xiàn)的,下一篇文章將介紹機械臂是如何根據(jù)的出來的最優(yōu)解來執(zhí)行的。文中算法的介紹只是冰山一角,如果你感興趣對弈算法可以自行查閱相關的書籍去進一步了解。

現(xiàn)在我們正處于時代的大變革,人工智能無處不在,不僅僅是在下棋中能夠戰(zhàn)勝頂尖的人們,在各個的領域都有著它們的身影。我們得抓住時代,抓住機會跟上這個充滿科技的21世紀。

我們會很快的更新出下一篇文章,如果你感興趣的話歡迎關注我們,在下方留言就是對我們最好的支持!

審核編輯 黃宇

-

機器人

+關注

關注

211文章

28390瀏覽量

206957 -

人工智能

+關注

關注

1791文章

47208瀏覽量

238298 -

機械臂

+關注

關注

12文章

513瀏覽量

24558

發(fā)布評論請先 登錄

相關推薦

使用myCobot 280 Jeston Nano進行物體精確識別追蹤

基于LabVIEW的五子棋博弈算法

實現(xiàn)人與機器人的直接對弈_強大的對弈系統(tǒng)如何實現(xiàn)

對弈機器人與圖像識別

六軸機械臂免費使用,學習ROS、Python火熱報名中

myCobot機械臂應用于Unity機器人編程實戰(zhàn)課

Mycobot機械臂各關節(jié)的運動(三)

對弈人工智能!myCobot 280開源六軸機械臂Connect 4 四子棋對弈下篇

大象機器人開源協(xié)作機械臂機械臂接入GPT4o大模型!

對弈人工智能!myCobot 280開源六軸機械臂Connect 4 四子棋對弈

對弈人工智能!myCobot 280開源六軸機械臂Connect 4 四子棋對弈

評論