2022年3月,NVIDIA發布了首款數據中心CPU Grace、新一代高性能計算GPU Hopper,同時利用它們打造了兩顆“超級芯片”(Super Chip),一是Grace CPU二合一,二是Grace CPU+Hopper GPU二合一,看起來都極為酷炫。

現在,足足14個月過去了,NVIDIA終于宣布,GH200 Grace Hopper超級芯片已經全面投產,將為復雜AI、HPC工作負載提供澎湃的動力。

再加上Grace CPU、Hopper GPU、Ada Lovelace GPU、BlueField DPU等全套系統方案,NVIDIA現在已經有400多種配置,可滿足市場對生成式AI的激增需求。

歐洲和美國的超大規模云服務商、超算中心,將會成為接入GH200系統的首批客戶。

同時,黃仁勛還公布了Grace Hopper的更多細節,尤其是它的CPU、GPU之間使用NVLink-C2C互連技術,總帶寬高達900GB/s,相比傳統的PCIe 5.0通道超出足足7倍,能夠滿足要求最苛刻的生成式AI和HPC應用,功耗也降低了超過80%。

Grace Hopper是一塊CPU+GPU合體的超級芯片,CPU是NVIDIA自研的72核處理器,Neoverse V2內核,擁有480GB LPDDR5內存,512GB/s帶寬。

GPU部分是H100,FP64性能34TFLOPS,但更強的是INT8性能,AI運算能力達到了3958TFLOPS,帶96GB HBM3內存。

同時,NVIDIA發布了針對AI推出的大內存DGX GH200超算系統,配備了256個Grace Hopper芯片,總計1.8萬CPU核心,144TB內存,相比之前漲了500倍。

AI運算對內存容量的要求更高,所以DGX GH200通過最新的NVLink、NVLink Switch等技術連接了256塊Grace Hooper超級芯片,實現了極為夸張的性能及內存。

GH200總計有256塊Grace Hooper芯片,因此總計18432個CPU核心,144TB HBM3內存,AI性能達到了1 exaFLOPS,也就是100億億次。

這是什么概念?當前最強的TOP500超算也就是百億億次性能,只不過這個性能是HPC計算的,NVIDIA的是百億億次AI性能。

為了讓256個超級芯片互聯,GH200還使用了256塊單口400Gb/s InfiniBand互聯芯片,256個雙口200Gb/s InfiniBand芯片,還有96組L1 NVLink、36組L2 NVLink開關等等,設計非常復雜。

NVIDIA表示,谷歌、Meta及微軟是首批獲得DGX H200系統的公司,后續他們還會開放給更多客戶,運行客戶定制。

不過DGX H200還不是最強的,NVIDIA今年晚些時候會推出名為NVIDIA Helios的AI超算系統,由4組GH200組成,總計1024個Grace Hooper超級芯片,576TB HBM內存。

黃仁勛還向傳統的CPU服務器集群發起“挑戰”,認為在人工智能和加速計算這一未來方向上,GPU服務器有著更為強大的優勢。

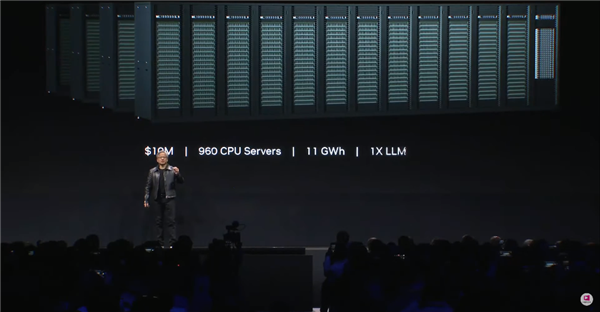

根據黃仁勛在演講上展示的范例,訓練一個LLM大語言模型,將需要960個CPU組成的服務器集群,這將耗費大約1000萬美元(約合人民幣7070萬元),并消耗11千兆瓦時的電力。

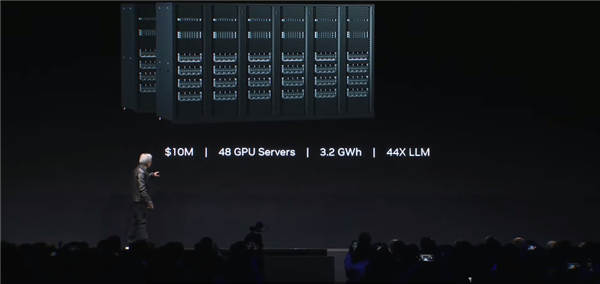

相比之下,同樣以1000萬美元的成本去組建GPU服務器集群,將以僅3.2千兆瓦時的電力消耗,訓練44個LLM大模型。

如果同樣消耗11千兆瓦時的電量,那么GPU服務器集群能夠實現150倍的加速,訓練150個LLM大模型,且占地面積更小。

而當用戶僅僅想訓練一個LLM大模型時,則只需要一個40萬美元左右,消耗0.13千兆瓦時電力的GPU服務器即可。

換言之,相比CPU服務器,GPU服務器能夠以4%的成本和1.2%的電力消耗來訓練一個LLM,這將帶來巨大的成本節省。

審核編輯 :李倩

-

NVIDIA

+關注

關注

14文章

4981瀏覽量

102997 -

gpu

+關注

關注

28文章

4729瀏覽量

128897 -

超級芯片

+關注

關注

0文章

34瀏覽量

8876

原文標題:領先幾光年!NVIDIA CPU+GPU超級芯片終于量產

文章出處:【微信號:hdworld16,微信公眾號:硬件世界】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

NVIDIA 以太網加速 xAI 構建的全球最大 AI 超級計算機

【「算力芯片 | 高性能 CPU/GPU/NPU 微架構分析」閱讀體驗】--全書概覽

名單公布!【書籍評測活動NO.43】 算力芯片 | 高性能 CPU/GPU/NPU 微架構分析

NVIDIA GB200超級芯片引領液冷散熱新紀元

NVIDIA GB200 CPU+GPU超級芯片功耗達2700W

超級猛獸 GPU ?NVIDIA GeForce RTX 5090 基本頻率接近 2.9 GHz

進一步解讀英偉達 Blackwell 架構、NVlink及GB200 超級芯片

利用NVIDIA組件提升GPU推理的吞吐

AI服務器異構計算深度解讀

NVIDIA推出搭載GB200 Grace Blackwell超級芯片的NVIDIA DGX SuperPOD?

NVIDIA 推出 Blackwell 架構 DGX SuperPOD,適用于萬億參數級的生成式 AI 超級計算

深度解讀Nvidia AI芯片路線圖

NVIDIA CPU+GPU超級芯片終于量產

NVIDIA CPU+GPU超級芯片終于量產

評論