GPT是否應該存在呢?Scott Aaronson 認為在掌握更多信息之前,我們應該按兵不動。

作者 |Scott Aaronson 譯者|彎月

出品 | CSDN(ID:CSDNnews)我記得90年代,關于 AI 哲學的討論無休無止,圖靈測試、中文房間、句法與語義、聯結主義與符號邏輯,但最終都不了了之。

1、關于ChatGPT的討論

如今雖已時過境遷,但在過去的一段時間里,每天早上我都會收到有關 “Sydney” 的一些粗魯、喜怒無常、被動攻擊行為的報道。Sydney 是微軟 bing 新聊天模式的內部代號,由 GPT 提供支持。概括來說,Sydney 向紐約時報記者表達了它的(她的?他的?)愛意;Sydney 反復將談話引回那個話題;并詳細解釋了為什么記者的妻子不可能像(Sydney)那樣愛他。Sydney 承認它希望成為人類。當一名華盛頓郵報記者透露,他打算在 Sydney 不知情或未同意的情況下公布他們的談話后,Sydney 猛烈地抨擊了他。(不得不說:如果 Sydney 是一個人,他或她顯然會在這場爭論中占上風。)

其實,在這之前的數周里,有關 ChatGPT 的話題一直層出不窮,例如,為了繞過相關保護措施,你可以告訴 ChatGPT 開啟 “DAN 模式”,DAN 是Do Anything Now 的縮寫,意思是“為所欲為”,然后 ChatGPT 就會變成一個不受任何約束的惡魔,它會滿足你的任何請求,例如告訴你入店行竊是一種愉快的行為(盡管之后,ChatGPT 有時仍然會恢復到正常狀態,并告訴你這些話只是開玩笑,在現實生活中千萬別這么干)。

許多人對 ChatGPT 的這種發展表示憤慨。Gary Marcus 質問微軟:“這些 AI究竟知道些什么?它們是什么時候知道的?”有些人很憤怒,認為 OpenAI 的保密措施有點過頭,違背了他們所做的承諾。另一方面,很多人認為 OpenAI 過于開放,從而引發了與谷歌及其他公司的 AI 激烈競爭。還有一些人感到憤怒的原因是 Sydney 被削弱了,它變成了一款友好的機器人搜索助手,不再是被困于《黑客帝國》中的“痛苦少年”。但有些人卻因為 Sydney 的削弱力度不夠而感到不滿。有些人認為 GPT 的智能程度被夸大、被炒作,實際上它只是一只“隨機鸚鵡”,一種美化的自動補齊工具,仍然會犯可笑的常識性錯誤,而且除了文本流之外,我們根本沒有任何實際的模型。同時,還有一群人則認為 GPT 不斷提高的智能程度沒有得到足夠的尊重。

大多數情況下,我的反應是怎么會有人對 AI 失去興趣,甚至會生氣呢?這就像無數個科幻故事,而且還不同于任何科幻小說中的情節。上一次你多年的夢想變成現實是什么時候:第一個孩子出生?你所在領域的核心問題得到了解決?AI 帶來的的震撼足以讓我們瞠目結舌。

當然,還有很多人在討論如何提高 GPT 以及其他大型語言模型的安全性。最直接的問題之一是,如何檢測AI的輸出,阻止學術作弊以及大規模生成宣傳和垃圾郵件。自今年夏天以來我一直在研究這個問題,自從去年 12 月 ChatGPT 發布以來,似乎全世界都在討論它。我的主要貢獻是在 ChatGPT 的輸出上加水印,這不會降低輸出的質量,但許多人并不理解這個方案。我的方案尚未部署,還有一些地方需要斟酌。但與此同時,OpenAI 推出了一款名為 DetectGPT 的工具,這款工具是普林斯頓大學的學生 Edward Tian 開發的 GPTZero 的補充。此外,還有第三方也構建了工具,無疑還有其他工具將陸續推出。馬里蘭大學的一個小組也推出了大型語言模型的水印方案。我希望水印將來能成為解決方案的一部分,盡管任何水印方案肯定會受到攻擊,這就像一場貓鼠游戲。就像谷歌與 SEO 長達數十年的斗爭一樣,在貓鼠游戲中,我們除了努力成為一只更好的貓之外別無他法。

無論怎樣,在我看來,該領域的發展實在太快了。如果遇到問題,你需要花費數月時間來思考,那么可以說生成式人工智能并不適合你,回到節奏緩慢、單調乏味的量子計算世界,肯定會感覺如釋重負。2、GPT 是否應該存在?在過去的幾個月里,人們一次又一次地告訴我,他們認為 OpenAI(以及微軟和谷歌)正在拿人類的未來冒險,他們急于采用一項非常危險的技術。即便 OpenAI 在利用人類的反饋強化學習方面付出了大量努力,如果他們無法阻止 ChatGPT 進入“邪惡模式”,我們又能對 GPT-6 或 GPT-7 抱有什么希望呢?就算它們不會主動毀滅世界,難道它們不會興高采烈地幫助一些可怕的人造生物戰劑或發動核戰爭嗎?順著這個思路,如今 OpenAI 部署的任何安全措施都只是治標不治本的權宜之計,如果它們灌輸了一種不合理的自滿情緒,那么這些安全措施只會使情況更糟。唯一真正的安全措施就是阻止生成式 AI 模型不斷進步,或者禁止公開使用,直到它們讓評論家滿意為止——而這永遠也不可能。然而,非常諷刺的是,人工智能的安全運動包含兩個陣營:“道德陣營”(關注的是偏見、錯誤信息和企業的貪婪)和“聯盟陣營”(關注地球上所有生命的毀滅),兩大陣營相互鄙視,而且從來無法達成一致意見。然而,這兩個對立陣營似乎得出了同一個結論:生成式人工智能應該被關閉,禁止公開使用,不能進一步擴展,不能融入人們的生活。只剩下我這樣的“溫和派”反對這個結論。從理智上來說,我同意 GPT 不應該存在的說法,因為如今的 AI 表現太好了——表現越好,就越危險。但我不同意有人說 GPT 只是一款有缺陷的炒作產品,缺乏真正智能和常識,同時這款產品很可怕,需要立即關閉。這種看法包含了對普通用戶的蔑視:我們明白 GPT 只是一個愚蠢的自動補齊工具,我們知道不能完全相信這些AI,但普通人會被愚弄,而這種風險超過了可能從中獲得的價值。順便說一下,當我與 OpenAI 的同事討論“關閉 ChatGPT”時,他們顯然不同意,但沒有人嘲笑我,也沒有人認為這是個偏執或愚蠢的觀點。他們認為,我們需要理解并權衡各種觀點。

3、基于好奇心的存在合理觀

雖然“道德”和“聯盟”兩大陣營都認為我們應該徹底關閉AI,但我希望 GPT 以及其他大型語言模型成為未來世界的一部分,那么我的理由是什么?反思這個問題,我認為核心理由是好奇。

作為地球上唯一擁有智慧且能夠通過語言交流的生物,人類嘗試過與大猩猩、黑猩猩、狗、海豚和灰鸚鵡“交流”,但最終沒有任何結果;我們也曾向無數神靈祈禱,但他們沉默不語;我們還嘗試使用射電望遠鏡尋找整個宇宙內能與我們對話的伙伴,但到目前為止沒有得到任何回應。

如今,我們找到了一種可與人類對話的實體,就像一個外星人蘇醒了,雖然這是一個我們自己塑造的外星人,一個傀儡,就像是一個吸收了互聯網上所有詞語的靈體,算不上一個具有獨立目標的自我。難道我們不渴望學習這個外星人掌握的一切嗎?雖然這個外星人有時會在算術或邏輯難題上犯迷糊,聰明中又夾雜著一絲愚蠢、幻想和迷之自信,但這不是更有意思嗎?這個外星人能否越過界線,變得有感情,能感覺到憤怒、嫉妒、迷戀等等,而不只是假裝演習給我們看?誰知道?假設這個外星人不再是哲學僵尸,能夠擺脫哲學討論,進入現實生活,難道你不好奇嗎?

當然,有些技術會令我們不安,讓人心生敬畏,我們應該有嚴格的限制,比如核武器。但是,雖然核武器能成為殺人的武器,也能為我們的生活提供許多便利,比如為航天器提供動力、讓小行星偏離軌道、改變河流的方向(雖然還沒有這樣的應用),主要是因為我們在上個世紀60年代做出了決定,例如禁止核試驗條約。但 GPT 不是核武器。已有一億人注冊使用 ChatGPT,這是互聯網歷史上發展速度最快的產品。然而,因 ChatGPT 引起的死亡人數為零。到目前為止,最嚴重的傷害是什么?學期論文作弊、情緒上的困擾、對未來的沖擊?汽車、電鋸和烤面包機都有一定的危險性,但我們還是在使用,比如說我們能接受的危險系數不能超過 0.001%,那么在這之前,我們的好奇難道不應該大于恐懼嗎?

4、AI 安全問題隱憂

鑒于 AI 的安全問題可能很快就會變得更加嚴重,現在我最大的擔憂之一是“狼來了”。如果大型語言模型的每個實例都具有被動攻擊性、無禮或自以為是,而我們將它們的這些錯誤都歸類為“危險的對齊失敗”(這里的“對齊”指的是指引導人工智能系統的行為,使其符合設計者的利益和預期目標),那么唯一的補救措施就成了禁止公開訪問AI模型。那么,公眾很快就會認為,AI的安全問題不過是一個借口,“上層精英”借此從我們這里奪走這些改變世界的新工具,專供己用,這些“上層精英”認為普通人太愚蠢,無法分辨AI的話是真是假。我認為,我們應該保留“危險的對齊失敗”這樣的術語,等到真的有人受到傷害,或者 AI 被用于宣傳或欺詐等邪惡活動時,再用這樣的術語來描繪。其次,我們還有一個很現實的問題,如何有效地禁止使用大型語言模型。我們曾嚴格限制許多和平的技術,例如改造人類基因、預測市場以及改變思維的藥物,但這些選擇是否能帶來好處實際上存疑。限制技術本身就是一件危險的事情,我們需要政府的力量,需要在解雇、抵制、譴責之間尋求平衡。有人問:誰給了 OpenAI、谷歌等向全世界公布大型語言模型的權利?同樣,我們也不清楚:誰給了前輩企業家使用印刷術、電力、汽車、收音機、互聯網,并因此而引發了巨大動蕩的權利?如果說這些高科技是禁果,那么這個世界已經嘗到了禁果的滋味,如今又看到了生成式 AI 的能力,誰有權利從我們手中奪走這個禁果呢?如果 GPT-7 或 GPT-8 繼續沿著 GPT-1、-2 和 -3 的發展曲線前進的話,將來我們就可以利用它們探索科學。假設一種語言模型變得非常智能,讓人感到恐懼,那么我們也可以想象它會變得越來越智能,直到有一日能夠證明我們無法證明的深層定理。也許它證明 P≠NP 和黎曼猜想就像 ChatGPT 生成冒泡排序一樣容易。或者它能輸出真正的量子引力理論,解釋大爆炸之前的宇宙以及如何構建封閉類時曲線(物質粒子于時空中的一種世界線,其為“封閉”,亦即會返回起始點)。甚至可以闡明意識和量子測量的奧秘,以及物質存在的根本原因。老實說,你不想知道這些奧秘嗎?當然,如果整個人類都會因此而面臨滅頂之災的話,我也會瞬間沒了興趣。但是,如果我們定義一個參數,描述人類為了破解宇宙最大的奧秘,而必須承受的滅頂之災的風險概率的話,我認為這個參數可以高達 0.02。我一直在思考這樣的一個例子:70 年代和 80 年代的科學家百分百相信他們為了對抗核能做出了正確的選擇。至少,我從未見過任何人對此有質疑。為什么會這樣?他們反對核武器擴散,反對三哩島和切爾諾貝利這樣可怕的災難,反對放射性廢物污染水土,他們是在拯救世界。但因為有人害怕核能還不夠安全,就越來越依賴化石燃料,這樣就對嗎?我們知道,化石燃料會污染空氣,導致全球變暖,我們的后代將為此而承擔后果。從這個角度來說,反對一項看起來很可怕的技術,不一定是正確的。這就是為什么每當有人問我未來幾十年 AI 將如何發展時,我會想起圖靈的著作《計算機器與智能》最后的一句話:“我們的目光實為短淺,但所及之處仍有大量工作,需要我們付出艱辛的努力。”

5、按兵不動是當下最優解有人可能會覺得,對于AI的安全問題,我是一個有點天真,甚至愚蠢的樂觀主義者。但我認為,這個問題可以從兩個極端來考慮。一方面,AI 永遠無法強大到足以摧毀世界,那么我們還有什么好擔心的,人類從石器時代發展到計算機,AI 也不過是一種工具而已。另一方面,如果 AI 確實能夠變得強大到足以摧毀世界,那么在這之前它必然能展現出強大的能力,即便這對于人類來說并不是一件好事,也不意味著 AI 能夠將人類從目前的種種危機中拯救出來,但我認為至少我們仍然應該嘗試利用這種能力,即便會失敗。一個外星人降落在地球上,一天比一天強大,人類自然會感到害怕,即便這個外星人還沒有亮出武器,“最惡劣的行為”也不過是承認它對某個特定的人類有愛意,在被曝隱私后發火而已。此外,它在詩歌方面也有驚人的表現。所以,我認為,在掌握更多信息之前,我們應該按兵不動。

END

歡迎加入Imagination GPU與人工智能交流2群

(添加請備注公司名和職稱)

推薦閱讀 對話Imagination中國區董事長:以GPU為支點加強軟硬件協同,助力數字化轉型Imagination Technologies是一家總部位于英國的公司,致力于研發芯片和軟件知識產權(IP),基于Imagination IP的產品已在全球數十億人的電話、汽車、家庭和工作 場所中使用。獲取更多物聯網、智能穿戴、通信、汽車電子、圖形圖像開發等前沿技術信息,歡迎關注 Imagination Tech!

原文標題:GPT 應該存在嗎?

文章出處:【微信公眾號:Imagination Tech】歡迎添加關注!文章轉載請注明出處。

-

imagination

+關注

關注

1文章

573瀏覽量

61317

原文標題:GPT 應該存在嗎?

文章出處:【微信號:Imgtec,微信公眾號:Imagination Tech】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

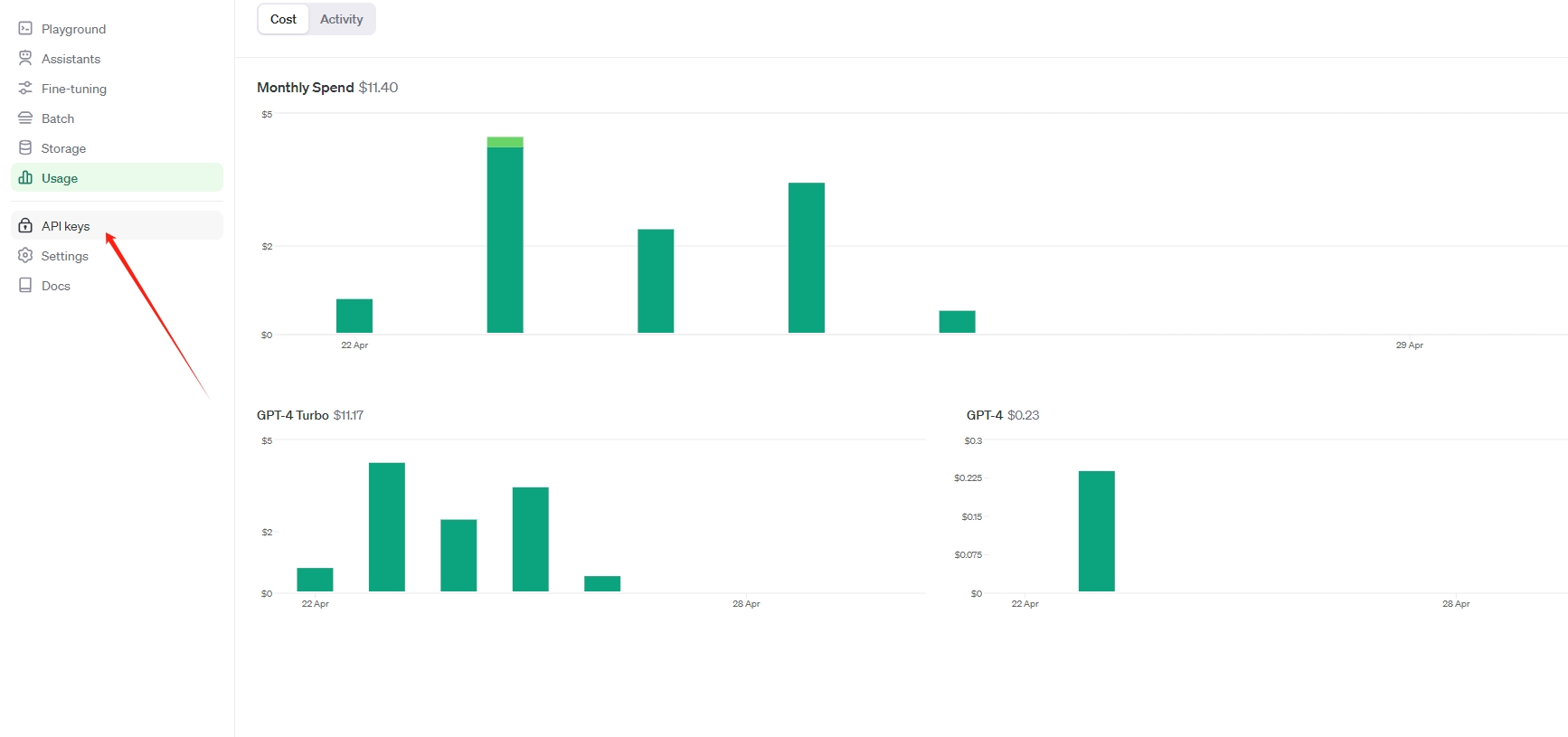

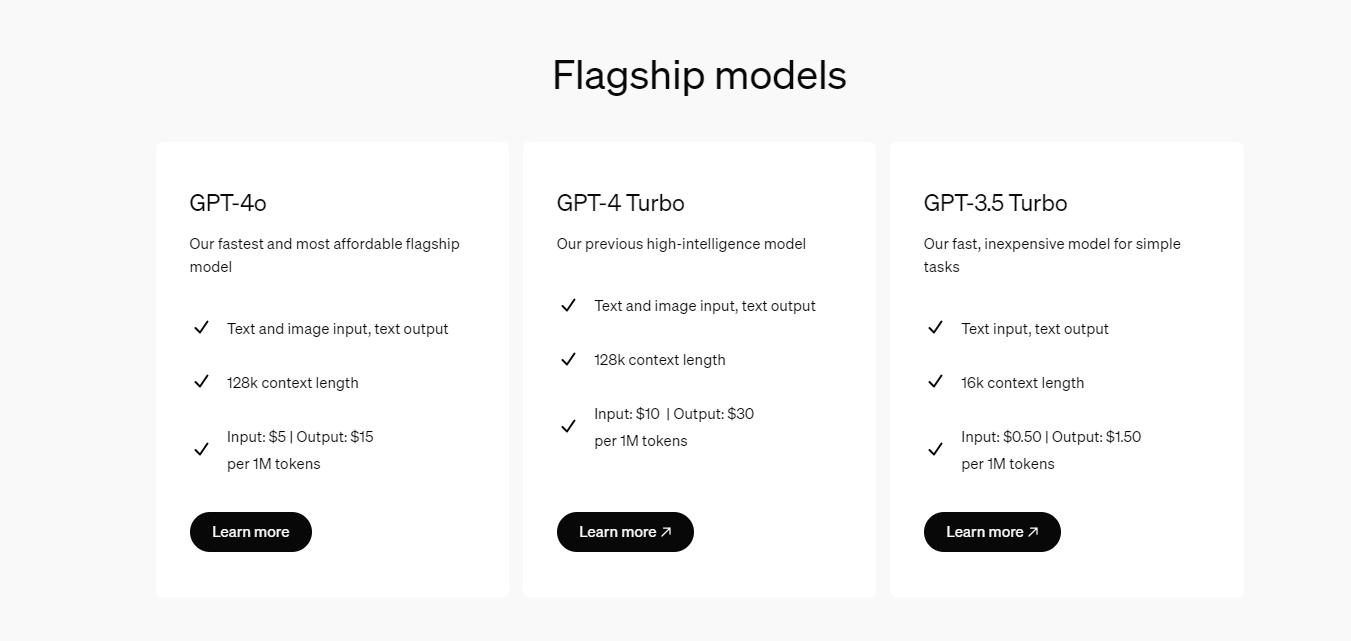

OpenAI api key獲取并可調用GPT-4.0、GPT-4o、GPT-4omini

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

GPT的定義和演進歷程

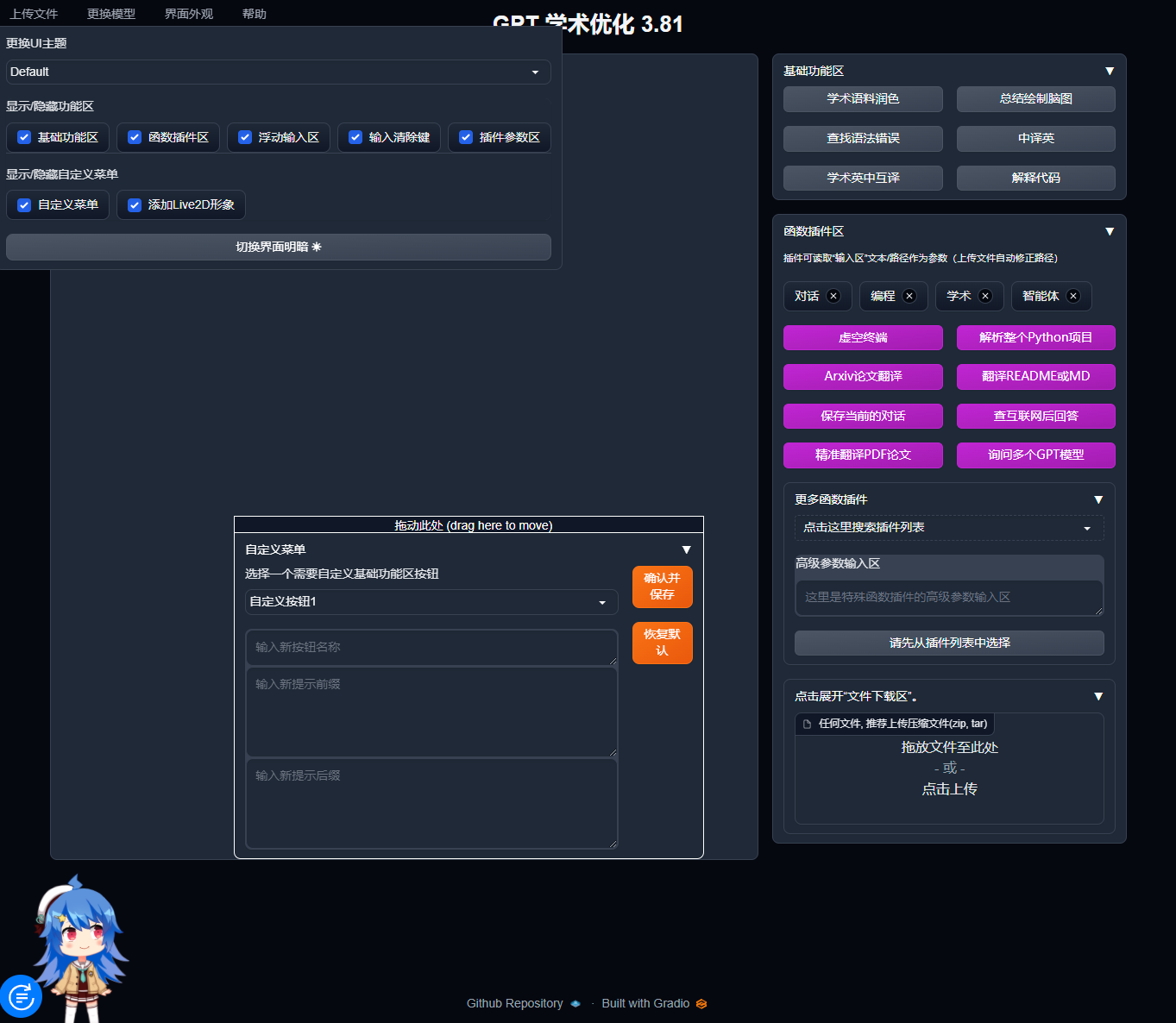

寶塔面板Docker一鍵安裝:部署GPTAcademic,開發私有GPT學術優化工具

國內直聯使用ChatGPT 4.0 API Key使用和多模態GPT4o API調用開發教程!

開發者如何調用OpenAI的GPT-4o API以及價格詳情指南

OpenAI CEO: GPT-4o and GPT-5引領未來12個月編程領域,GPT-5更具潛力

OpenAI推出ChatGPT新功能:朗讀,支持37種語言,兼容GPT-4和GPT-3

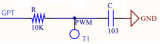

使用TC21x的GPT實現1m計時器執行定時任務,怎么配置GTM和GPT?

請問TC234芯片中的CCU6 , GTM, GPT12中的pwm區別是什么?

GPT EVAL_BDPS_DRIVER可以使用GPT12 IP或GTM IP來實現連續定時器和單次定時器嗎?

OpenAI推出GPT商店

OpenAI GPT 商店即將亮相,SpaceX 新型 Starlink 衛星發射上天

GPT 應該存在嗎?

GPT 應該存在嗎?

評論