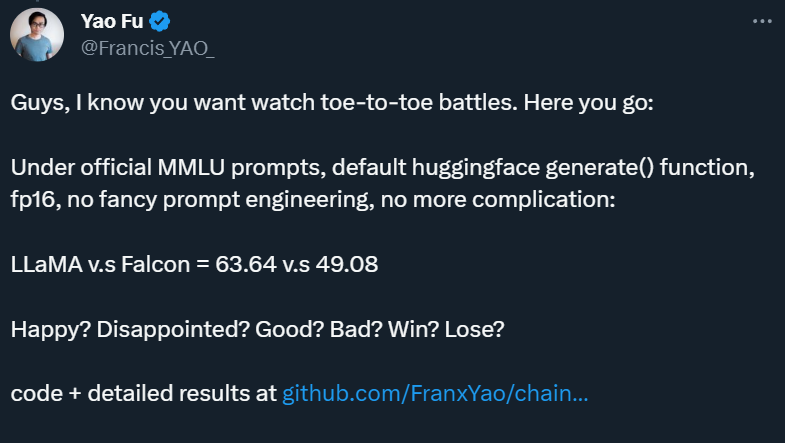

LLaMA v.s. Falcon = 63.64 v.s. 49.08。評估結果表明,LLaMA 并未被「碾壓」。

作為開源模型界的扛把子,LLaMA 一直備受矚目。

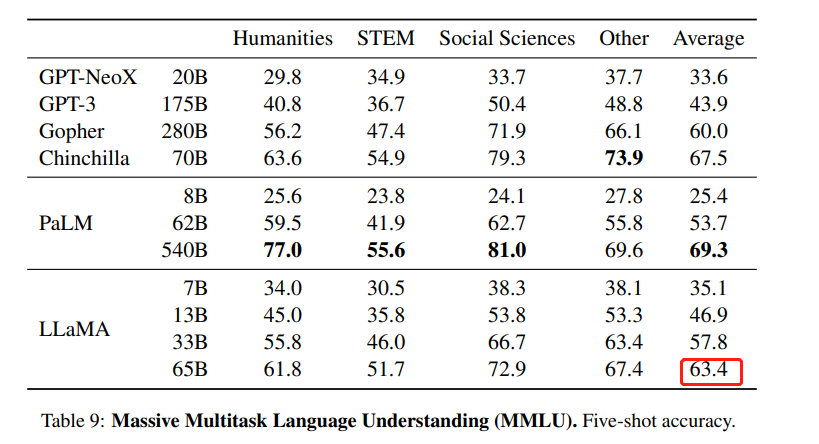

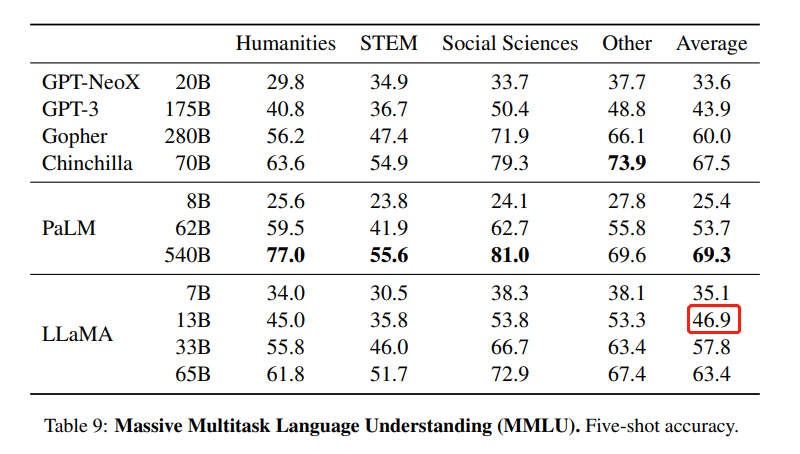

這是一組由 Meta 開源的大型語言模型,共有 7B、13B、33B、65B 四種版本。其中,LLaMA-13B 在大多數數據集上超過了 GPT-3(175B),LLaMA-65B 達到了和 Chinchilla-70B、PaLM-540B 相當的水平。

自 2 月份發布以來,開源社區一直在 LLaMA 的基礎上進行二創,先后推出了 Alpaca、Vicuna 等多個「羊駝」大模型,生物學羊駝屬的英文單詞都快被用光了。

不過,也有人對 LLaMA 發起了挑戰。5 月底,阿聯酋阿布扎比的技術創新研究所(TII)開源了一個 400 億參數的因果解碼器模型「Falcon-40B」,該模型在 RefinedWeb 的 1 萬億個 token 上進行了訓練,并使用精選數據集增強。剛一發布,「Falcon-40B」就沖上了 Huggingface 的 OpenLLM 排行榜首位,「碾壓」了參數規模 1.5 倍的「LLaMA-65B」,也優于 MPT、RedPajama 和 StableLM 等開源大模型。

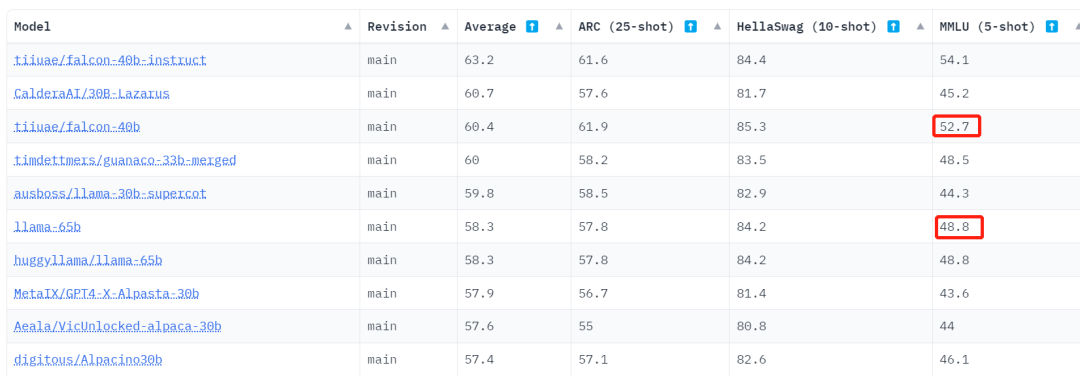

后來,Falcon-40B Instruct 版本占據了排行榜首位,Falcon-40B 則退到了第三,而 LLaMA-65B 已經掉到了第六位。

不過,仔細看過數據之后,圍觀者產生了疑問:為什么在 HuggingFace 的 Open LLM 排行榜上,LLaMA-65B 的 MMLU 這項分數是 48.8,明顯低于官方數據 63.4?

HuggingFace 的 Open LLM 排行榜。地址:https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

LLaMA 論文中的 MMLU 數據。MMLU 是 Massive Multitask Language Understanding 的縮寫,是一個基準數據集,旨在通過僅在零樣本和少樣本設置下評估模型來衡量預訓練期間獲取的知識。它由一系列學術科目中類似考試的問題組成,用于測試模型對于世界理解的能力。

還有人表示,在測 Falcon-40B 時,他們也復現不了排行榜上的分數。

面對這樣的爭議,Karpathy 等大牛選擇了謹慎觀望。

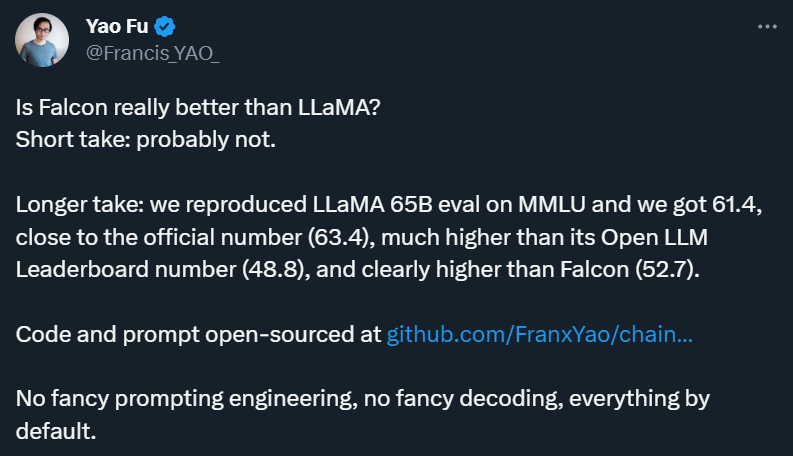

愛丁堡大學博士生符堯等則選擇自己測一遍。

簡而言之,他們在 Chain-of-thought Hub 上重新寫了開源的 LLaMA eval 代碼,然后在同樣的設定下,用官方 prompt,fp16,HF 默認代碼,公平比較了 Falcon 和 LLaMA 在 MMLU 上的表現。

「沒有花哨的 prompt 工程和解碼,一切都是在默認設置下進行的。」符堯在推文中寫道。

6 月 8 日,他們公布了第一批結果:LLaMA 65B 的 MMLU 得分為 61.4,比較接近官方數字(63.4),明顯高于其 Open LLM Leaderboard 分數 48.8,且遠高于 Falcon-40B 的 Leaderboard 分數 52.7。

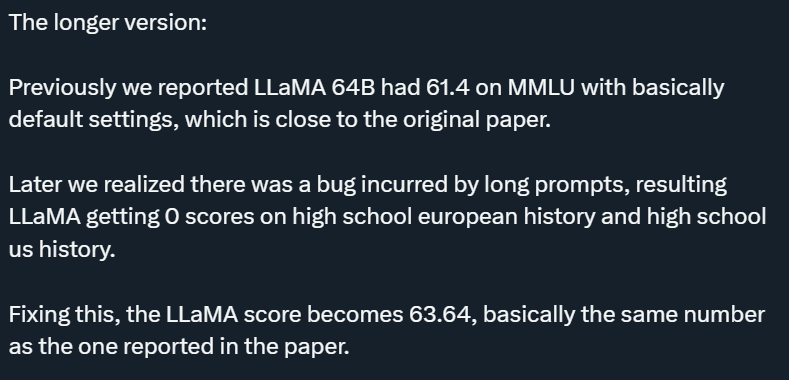

初步來看,「你大爺還是你大爺」。不過,這還不是 LLaMA 65B 的真實實力。在 6 月 10 日凌晨公布的第二波結果中,符堯解釋說,他們在第一波測評中發現了一個「long prompt」引起的 bug,這個 bug 導致 LLaMA 在高中歐洲歷史和高中美國歷史上得到 0 分。在修復了這個 bug 后,LLaMA 得分變成了 63.64,與論文中報道的數字基本相同。

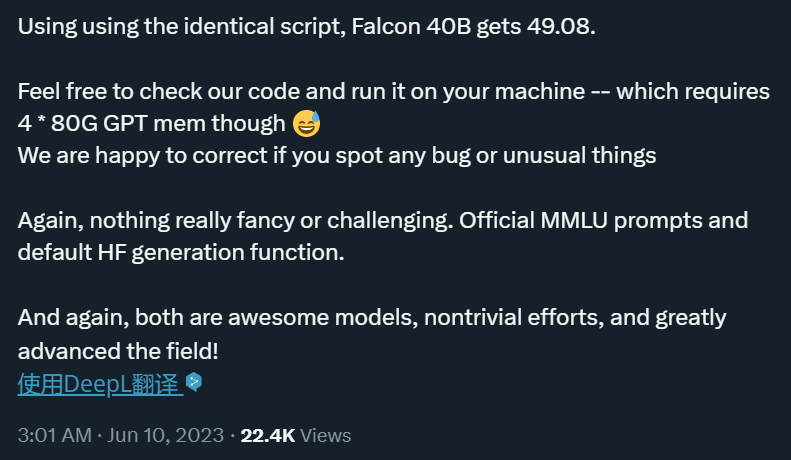

公平起見,使用相同的腳本,他們也測出了 Falcon-40B 的得分:49.08,低于 Leaderboard 分數 52.7,只比 LLaMA 13B 好一點。

由此,這次所謂的「碾壓」事件徹底反轉。

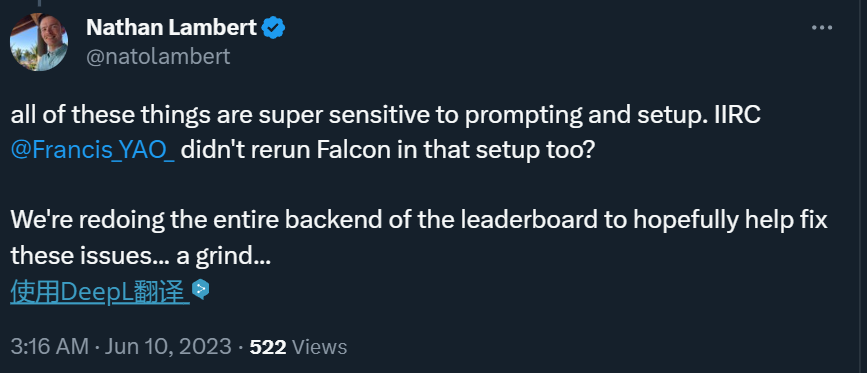

符堯團隊的這一嘗試也吸引了 HuggingFace 研究科學家 Nathan Lambert 的注意,后者決定重寫 Open LLM Leaderboard 的代碼。

不過,符堯專門指出,他們不打算在 LLaMA 和 Falcon 之間挑起戰爭:「兩者都是偉大的開源模型,并為該領域做出了重大貢獻!Falcon 還具有更簡單的許可證優勢,這也賦予了它強大的潛力!」

為了方便大家檢查代碼和開源結果,符堯公布了相關地址:https://github.com/FranxYao/chain-of-thought-hub/tree/main/MMLU

如果在檢查后有新的發現,歡迎在評論區留言。

-

解碼器

+關注

關注

9文章

1143瀏覽量

40718 -

語言模型

+關注

關注

0文章

520瀏覽量

10268

原文標題:徹底反轉:號稱「碾壓」LLaMA的Falcon實測得分僅49.08,HuggingFace決定重寫排行榜代碼

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學堂】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

HarmonyOS開發案例:【排行榜頁面】

中國IC設計公司排行榜

2013年2月份編程軟件排行榜,LabVIEWTop27,進步很大。

各種排行榜匯總貼!!!!!

2014年4月方案公司出貨量排行榜

2014年10月 TIOBE 編程語言排行榜發布

小米放出“手機電量排行榜” 為續航神機Max 2造勢

2020年最新主板型號排行榜 精選資料推薦

華為榮獲手機推薦度排行榜第一

開源大模型Falcon(獵鷹) 180B發布 1800億參數

號稱「碾壓」LLaMA的Falcon實測得分僅49.08,HuggingFace決定重寫排行榜代碼

號稱「碾壓」LLaMA的Falcon實測得分僅49.08,HuggingFace決定重寫排行榜代碼

評論