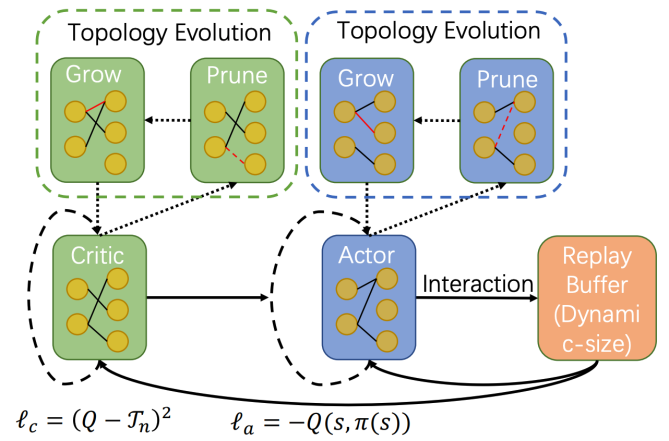

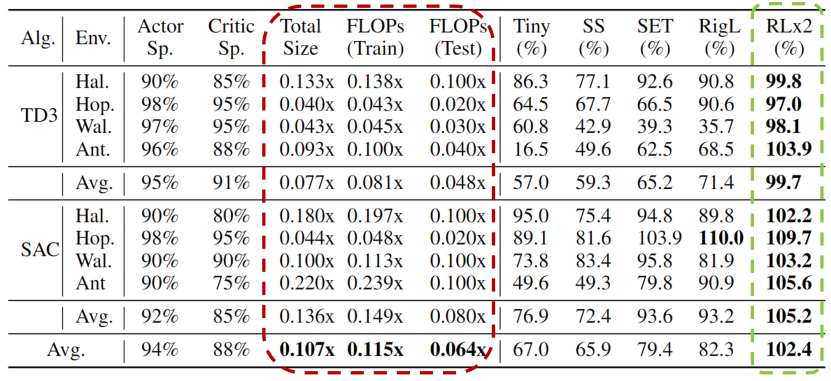

深度強(qiáng)化學(xué)習(xí)模型的訓(xùn)練通常需要很高的計算成本,因此對深度強(qiáng)化學(xué)習(xí)模型進(jìn)行稀疏化處理具有加快訓(xùn)練速度和拓展模型部署的巨大潛力。然而現(xiàn)有的生成小型模型的方法主要基于知識蒸餾,即通過迭代訓(xùn)練稠密網(wǎng)絡(luò),訓(xùn)練過程仍需要大量的計算資源。另外,由于強(qiáng)化學(xué)習(xí)自舉訓(xùn)練的復(fù)雜性,訓(xùn)練過程中全程進(jìn)行稀疏訓(xùn)練在深度強(qiáng)化學(xué)習(xí)領(lǐng)域尚未得到充分的研究。 清華大學(xué)黃隆波團(tuán)隊提出了一種強(qiáng)化學(xué)習(xí)專用的動態(tài)稀疏訓(xùn)練框架,“Rigged Reinforcement Learning Lottery”(RLx2),可適用于多種離策略強(qiáng)化學(xué)習(xí)算法。它采用基于梯度的拓?fù)溲莼瓌t,能夠完全基于稀疏網(wǎng)絡(luò)訓(xùn)練稀疏深度強(qiáng)化學(xué)習(xí)模型。RLx2 引入了一種延遲多步差分目標(biāo)機(jī)制,配合動態(tài)容量的回放緩沖區(qū),實(shí)現(xiàn)了在稀疏模型中的穩(wěn)健值學(xué)習(xí)和高效拓?fù)涮剿鳌T诙鄠€ MuJoCo 基準(zhǔn)任務(wù)中,RLx2 達(dá)到了最先進(jìn)的稀疏訓(xùn)練性能,顯示出 7.5 倍至 20 倍的模型壓縮,而僅有不到 3% 的性能降低,并且在訓(xùn)練和推理中分別減少了高達(dá) 20 倍和 50 倍的浮點(diǎn)運(yùn)算數(shù)。大模型時代,模型壓縮和加速顯得尤為重要。傳統(tǒng)監(jiān)督學(xué)習(xí)可通過稀疏神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)模型壓縮和加速,那么同樣需要大量計算開銷的強(qiáng)化學(xué)習(xí)任務(wù)可以基于稀疏網(wǎng)絡(luò)進(jìn)行訓(xùn)練嗎?本文提出了一種強(qiáng)化學(xué)習(xí)專用稀疏訓(xùn)練框架,可以節(jié)省至多 95% 的訓(xùn)練開銷。

- 論文主頁:https://arxiv.org/abs/2205.15043

- 論文代碼:https://github.com/tyq1024/RLx2

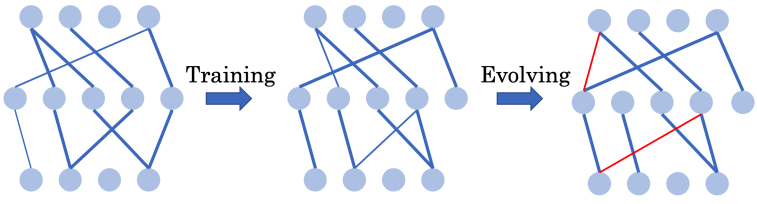

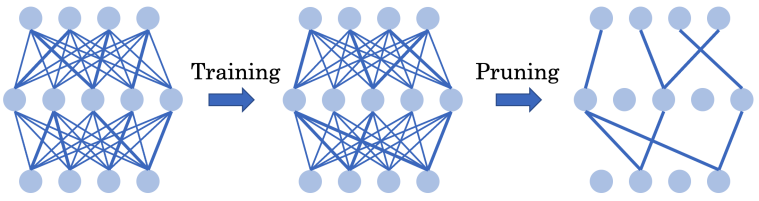

圖:基于強(qiáng)化學(xué)習(xí)的 AlphaGo-Zero 在圍棋游戲中擊敗了已有的圍棋 AI 和人類專家 高昂的資源消耗限制了深度強(qiáng)化學(xué)習(xí)在資源受限設(shè)備上的訓(xùn)練和部署。為了解決這一問題,作者引入了稀疏神經(jīng)網(wǎng)絡(luò)。稀疏神經(jīng)網(wǎng)絡(luò)最初在深度監(jiān)督學(xué)習(xí)中提出,展示出了對深度強(qiáng)化學(xué)習(xí)模型壓縮和訓(xùn)練加速的巨大潛力。在深度監(jiān)督學(xué)習(xí)中,SET [Mocanu et al. 2018] 和 RigL [Evci et al. 2020] 等常用的基于網(wǎng)絡(luò)結(jié)構(gòu)演化的動態(tài)稀疏訓(xùn)練(Dynamic sparse training - DST)框架可以從頭開始訓(xùn)練一個 90% 稀疏的神經(jīng)網(wǎng)絡(luò),而不會出現(xiàn)性能下降。

能否通過全程使用超稀疏網(wǎng)絡(luò)從頭訓(xùn)練出高效的深度強(qiáng)化學(xué)習(xí)智能體?

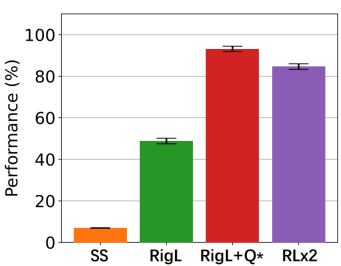

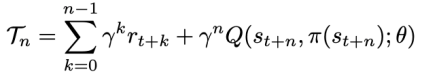

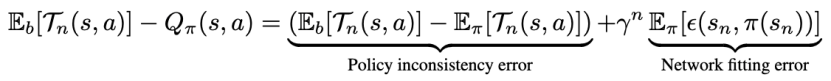

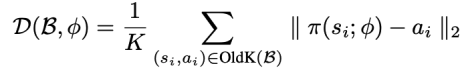

方法 清華大學(xué)黃隆波團(tuán)隊對這一問題給出了肯定的答案,并提出了一種強(qiáng)化學(xué)習(xí)專用的動態(tài)稀疏訓(xùn)練框架,“Rigged Reinforcement Learning Lottery”(RLx2),用于離策略強(qiáng)化學(xué)習(xí)(Off-policy RL)。這是第一個在深度強(qiáng)化學(xué)習(xí)領(lǐng)域以 90% 以上稀疏度進(jìn)行全程稀疏訓(xùn)練,并且僅有微小性能損失的算法框架。RLx2 受到了在監(jiān)督學(xué)習(xí)中基于梯度的拓?fù)溲莼膭討B(tài)稀疏訓(xùn)練方法 RigL [Evci et al. 2020] 的啟發(fā)。然而,直接應(yīng)用 RigL 無法實(shí)現(xiàn)高稀疏度,因?yàn)橄∈璧纳疃葟?qiáng)化學(xué)習(xí)模型由于假設(shè)空間有限而導(dǎo)致價值估計不可靠,進(jìn)而干擾了網(wǎng)絡(luò)結(jié)構(gòu)的拓?fù)溲莼?/span> 因此,RLx2 引入了延遲多步差分目標(biāo)(Delayed multi-step TD target)機(jī)制和動態(tài)容量回放緩沖區(qū)(Dynamic capacity buffer),以實(shí)現(xiàn)穩(wěn)健的價值學(xué)習(xí)(Value learning)。這兩個新組件解決了稀疏拓?fù)湎碌膬r值估計問題,并與基于 RigL 的拓?fù)溲莼瘻?zhǔn)則一起實(shí)現(xiàn)了出色的稀疏訓(xùn)練性能。為了闡明設(shè)計 RLx2 的動機(jī),作者以一個簡單的 MuJoCo 控制任務(wù) InvertedPendulum-v2 為例,對四種使用不同價值學(xué)習(xí)和網(wǎng)絡(luò)拓?fù)涓路桨傅南∈栌?xùn)練方法進(jìn)行了比較。

原文標(biāo)題:ICLR 2023 Spotlight|節(jié)省95%訓(xùn)練開銷,清華黃隆波團(tuán)隊提出強(qiáng)化學(xué)習(xí)專用稀疏訓(xùn)練框架RLx2

文章出處:【微信公眾號:智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

物聯(lián)網(wǎng)

+關(guān)注

關(guān)注

2931文章

46315瀏覽量

393690

原文標(biāo)題:ICLR 2023 Spotlight|節(jié)省95%訓(xùn)練開銷,清華黃隆波團(tuán)隊提出強(qiáng)化學(xué)習(xí)專用稀疏訓(xùn)練框架RLx2

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

清華光芯片取得新突破,邁向AI光訓(xùn)練

NVIDIA Isaac Lab可用環(huán)境與強(qiáng)化學(xué)習(xí)腳本使用指南

【書籍評測活動NO.62】一本書讀懂 DeepSeek 全家桶核心技術(shù):DeepSeek 核心技術(shù)揭秘

海思SD3403邊緣計算AI數(shù)據(jù)訓(xùn)練概述

用PaddleNLP為GPT-2模型制作FineWeb二進(jìn)制預(yù)訓(xùn)練數(shù)據(jù)集

詳解RAD端到端強(qiáng)化學(xué)習(xí)后訓(xùn)練范式

字節(jié)豆包大模型團(tuán)隊提出稀疏模型架構(gòu)

大模型訓(xùn)練框架(五)之Accelerate

港大提出SparX:強(qiáng)化Vision Mamba和Transformer的稀疏跳躍連接機(jī)制

PyTorch GPU 加速訓(xùn)練模型方法

如何使用 PyTorch 進(jìn)行強(qiáng)化學(xué)習(xí)

什么是協(xié)議分析儀和訓(xùn)練器

冠軍說|第二屆OpenHarmony競賽訓(xùn)練營冠軍團(tuán)隊專訪

直播預(yù)約 |數(shù)據(jù)智能系列講座第4期:預(yù)訓(xùn)練的基礎(chǔ)模型下的持續(xù)學(xué)習(xí)

評論