本文介紹如何使能 Linux 網(wǎng)絡(luò)協(xié)議棧中的 RFS(receive flow steering)功能以優(yōu)化 MPSoC APU 的并行處理能力,解決丟包問題。

問題描述:

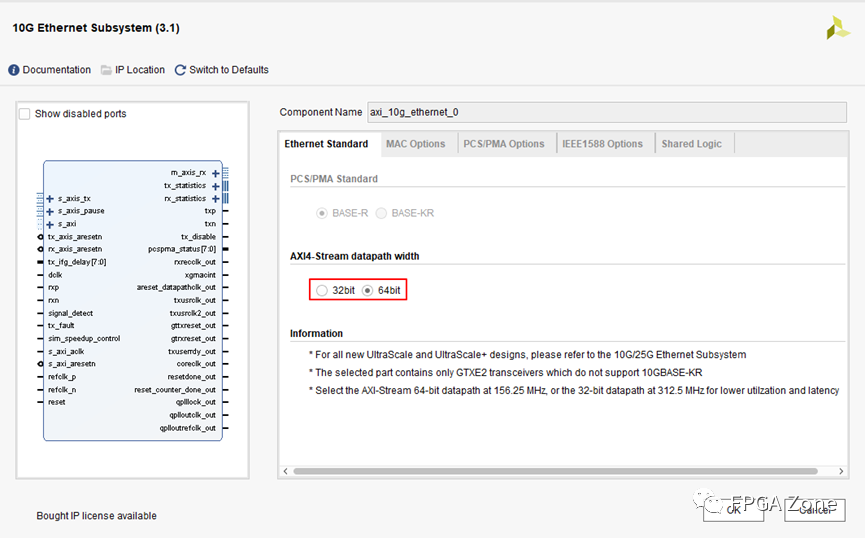

在測試 ZCU102 PL 10G Ethernet with MCDMA 設(shè)計的性能時,遇到 UDP 接收丟包率很高的情況,測試使用的工具是 iperf3。

測試過程:

Board side:在 core1~3 上各開一個 iperf3 服務(wù)端用于收包,命令如下:

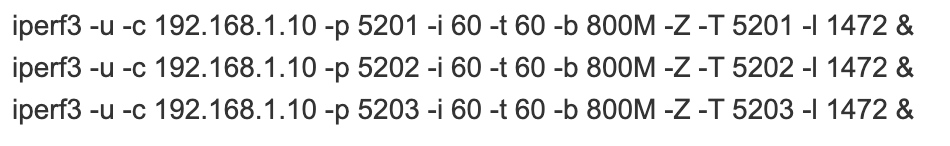

Server side:使用與 zcu102 用光纖相連的服務(wù)器發(fā)送 UDP 幀,命令如下:

雙方的網(wǎng)卡都工作在 MTU1500 模式下,故數(shù)據(jù)段長度設(shè)為 1472B,總帶寬暫設(shè)為 2400M。

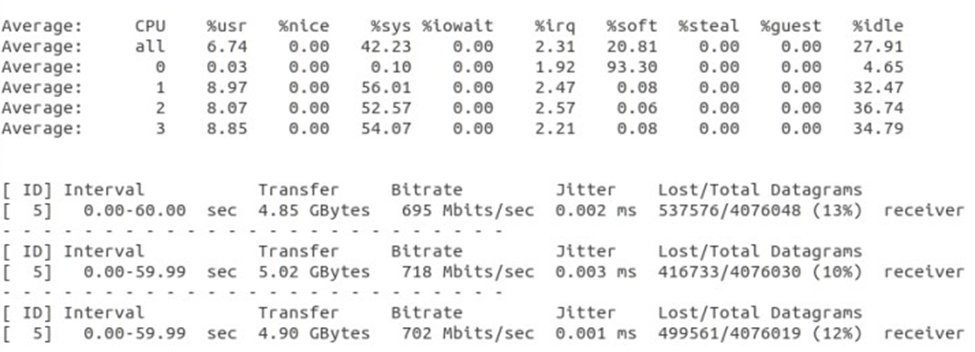

測試結(jié)果如上圖所示,丟包率超過了百分之十,故實際傳輸速度也達(dá)不到設(shè)定的帶寬,使用 mpstat 命令觀察 CPU 使用狀況,發(fā)現(xiàn)接收工程中 CPU0 的軟中斷占用達(dá)到93.3%。

解決方案:

使用 RFS 接收流導(dǎo)向,RFS 是 Linux 網(wǎng)絡(luò)協(xié)議棧提供的一項輔助性功能,RFS 的目標(biāo)是通過將數(shù)據(jù)包在內(nèi)核中的處理引導(dǎo)到使用該數(shù)據(jù)包的應(yīng)用程序線程對應(yīng)的 CPU 來提高數(shù)據(jù)緩存的命中率,詳情可參考 Linux 內(nèi)核文檔https://www.kernel.org/doc/html/latest/networking/scaling.html

在本文的測試中 Board side 上運行了三個 iperf 服務(wù)端在三個CPU 上,RFS 可以將發(fā)給某個服務(wù)端的數(shù)據(jù)包的部分處理工作交給這個服務(wù)端對應(yīng)的 CPU 執(zhí)行,以此平衡工作負(fù)載。

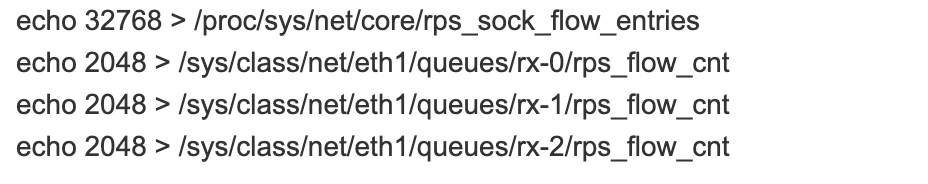

按照文檔中的說明,rps_sock_flow_entries 設(shè)置為32768,本文使用的設(shè)計中 MCDMA 共有16個接收通道,所以 rps_flow_cnt 為32768/16=2048,另外共開啟了三個 iperf 服務(wù)端,所以暫時只設(shè)置 rx-0~rx-2,綜上,執(zhí)行命令如下:

重新測試后結(jié)果如上圖所示,丟包率大大降低,實際傳輸速度也達(dá)到了設(shè)定值,使用 mpstat 命令監(jiān)控傳輸期間的 CPU 狀況,發(fā)現(xiàn) CPU0 的軟中斷占用時間降低,而 CPU1~3 的軟中斷占用升高,可以看出實現(xiàn)了負(fù)載的分配,但是從總體來看,四個 CPU 的總負(fù)載升高,說明 RFS 還是有一定的額外工作開銷。

總結(jié):

使用 RFS 可以一定程度上解決 MPSoC 10G 以太網(wǎng)應(yīng)用(使用 MCDMA 時)中的 UDP 接收丟包問題,但是會產(chǎn)生額外的 CPU 開銷,如果丟包率在接受范圍內(nèi)可以選擇不開啟。

-

以太網(wǎng)

+關(guān)注

關(guān)注

40文章

5527瀏覽量

173800 -

Linux

+關(guān)注

關(guān)注

87文章

11399瀏覽量

212023 -

Xilinx

+關(guān)注

關(guān)注

73文章

2175瀏覽量

123684 -

UDP

+關(guān)注

關(guān)注

0文章

329瀏覽量

34315 -

MPSoC

+關(guān)注

關(guān)注

0文章

199瀏覽量

24527

原文標(biāo)題:開發(fā)者分享|如何解決 MPSoC 萬兆以太網(wǎng)應(yīng)用中 UDP 接收丟包問題

文章出處:【微信號:gh_2d1c7e2d540e,微信公眾號:XILINX開發(fā)者社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

萬兆以太網(wǎng)規(guī)范

萬兆以太網(wǎng)規(guī)范解讀

在米爾電子MPSOC實現(xiàn)12G SDI視頻采集H.265壓縮SGMII萬兆以太網(wǎng)推流

在米爾電子MPSOC實現(xiàn)12G SDI視頻采集H.265壓縮SGMII萬兆以太網(wǎng)推流

基于FPGA的萬兆以太網(wǎng)接口的設(shè)計與實現(xiàn)

以太網(wǎng)在MPSoC中的數(shù)據(jù)通訊實現(xiàn)

萬兆以太網(wǎng)LAN與WAN技術(shù)的研究

基于FPGA的萬兆以太網(wǎng)接口設(shè)計

基于FPGA的萬兆以太網(wǎng)接口的設(shè)計與實現(xiàn)

萬兆以太網(wǎng)和IP SAN的融合

造成以太網(wǎng)交換機(jī)性能測試丟包的因素有哪些

千兆以太網(wǎng)交換機(jī)能量數(shù)據(jù)控制丟包現(xiàn)象簡介

以太網(wǎng)設(shè)備高溫流量測試丟包問題案例(晶振篇)

基于FPGA的UDP萬兆光通信測試

評論