引言

目標檢測是計算機視覺中的一個非常重要的基礎任務,與常見的的圖像分類/識別任務不同,目標檢測需要模型在給出目標的類別之上,進一步給出目標的位置和大小信息,在 CV三大任務(識別、檢測、分割)中處于承上啟下的關鍵地位。當前大火的多模態 GPT4在視覺能力上只具備目標識別的能力,還無法完成更高難度的目標檢測任務。而識別出圖像或視頻中物體的類別、位置和大小信息,是現實生產中眾多人工智能應用的關鍵,例如自動駕駛中的行人車輛識別、安防監控應用中的人臉鎖定、醫學圖像分析中的腫瘤定位等等。

已有的目標檢測方法如 YOLO系列、R-CNN系列等耳熟能詳的目標檢測算法在科研人員的不斷努力下已經具備很高的目標檢測精度與效率,但由于現有方法需要在模型訓練前就定義好待檢測目標的集合(閉集),導致它們無法檢測訓練集合之外的目標,比如一個被訓練用于檢測人臉的模型就不能用于檢測車輛;另外,現有方法高度依賴人工標注的數據,當需要增加或者修改待檢測的目標類別時,一方面需要對訓練數據進行重新標注,另一方面需要對模型進行重新訓練,既費時又費力。一個可能的解決方案是,收集海量的圖像,并人工標注Box信息與語義信息,但這將需要極高的標注成本,而且使用海量數據對檢測模型進行訓練也對科研工作者提出了嚴峻的挑戰,如數據的長尾分布問題與人工標注的質量不穩定等因素都將影響檢測模型的性能表現。

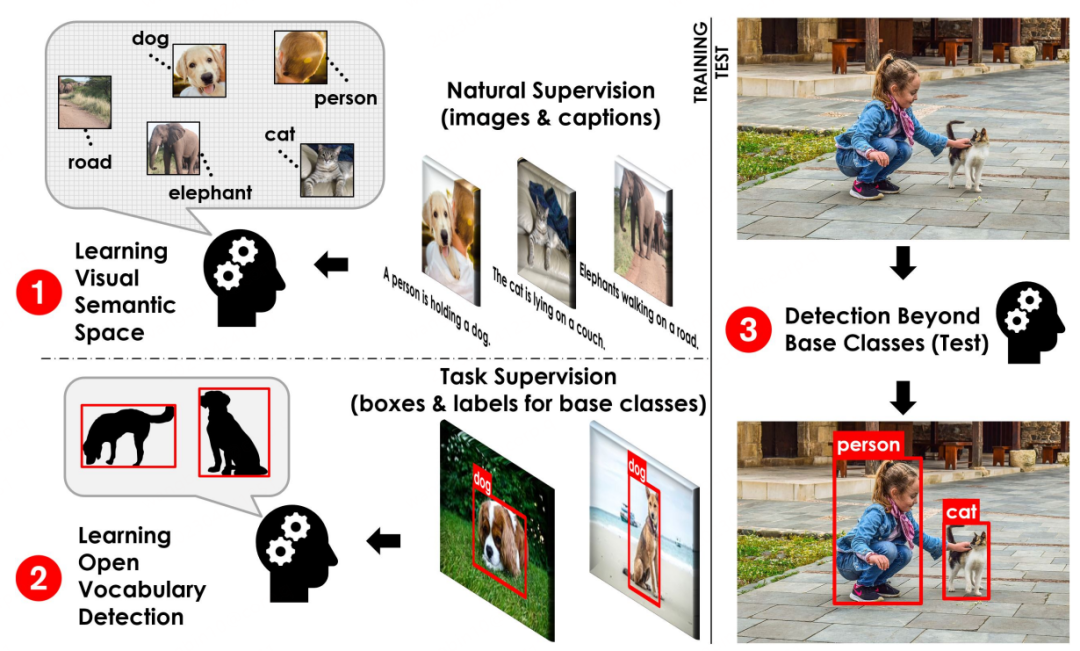

發表于 CVPR2021的文章 OVR-CNN[1]提出了一種全新的目標檢測范式:開放詞集目標檢測(Open-Vocabulary Detection,OVD,亦稱為開放世界目標檢測),來應對上文提到的問題,即面向開放世界未知物體的檢測場景。OVD由于能夠在無需人工擴充標注數據量的情形下識別并定位任意數量和類別目標的能力,自提出后吸引了學術界與工業界持續增長的關注,也為經典的目標檢測任務帶來了新的活力與新的挑戰,有望成為目標檢測的未來新范式。具體地,OVD技術不需要人工標注海量的圖片來增強檢測模型對未知類別的檢測能力,而是通過將具有良好泛化性的無類別(class-agnostic)區域檢測器與經過海量無標注數據訓練的跨模態模型相結合,通過圖像區域特征與待檢測目標的描述性文字進行跨模態對齊來擴展目標檢測模型對開放世界目標的理解能力。跨模態和多模態大模型工作近期的發展非常迅速,如 CLIP[2]、ALIGN[3]與R2D2[4](鏈接:https://github.com/yuxie11/R2D2)等,而它們的發展也促進了 OVD的誕生與 OVD領域相關工作的快速迭代與進化。

OVD技術涉及兩大關鍵問題的解決:1)如何提升區域(Region)信息與跨模態大模型之間的適配;2)如何提升泛類別目標檢測器對新類別的泛化能力。從這個兩個角度出發,下文我們將詳細介紹一些 OVD領域的相關工作。

OVD基本流程示意[1]

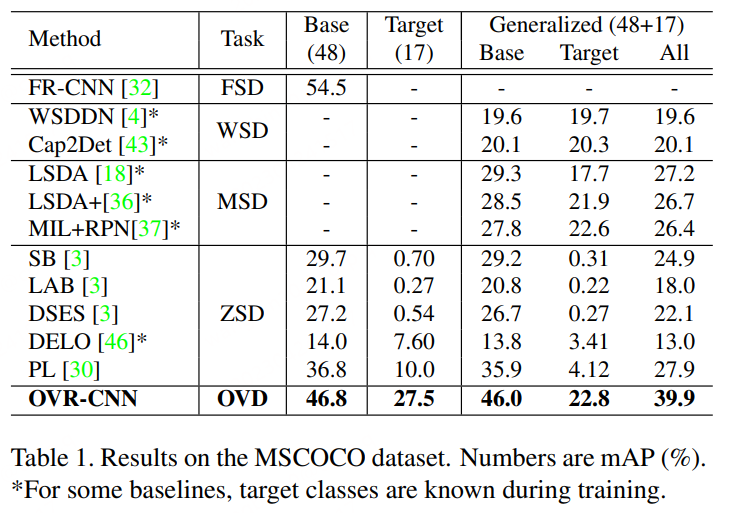

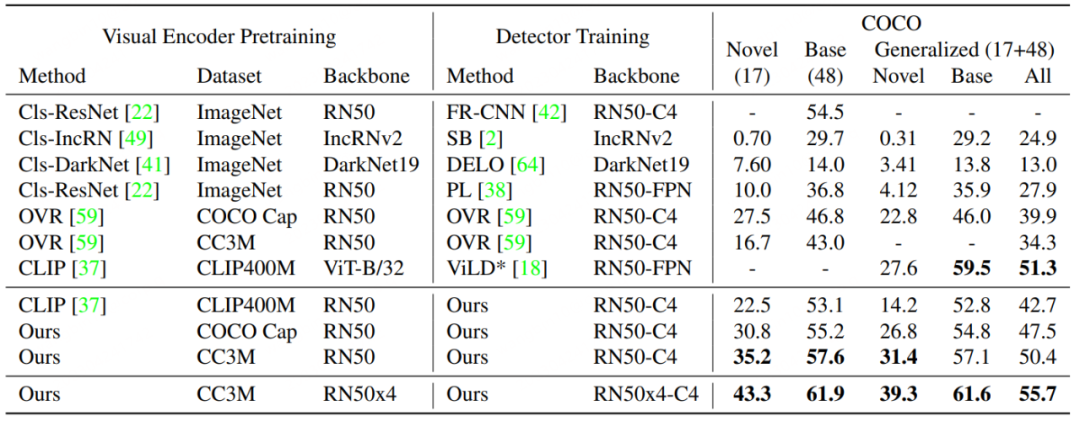

OVD的基礎概念:OVD的使用主要涉及到 few-shot 和 zero-shot兩大類場景,few-shot是指有少量人工標注訓練樣本的目標類別,zero-shot則是指不存在任何人工標注訓練樣本的目標類別。在常用的學術評測數據集 COCO、LVIS上,數據集會被劃分為 Base類和 Novel類,其中Base類對應 few-shot場景,Novel類對應 zero-shot場景。如 COCO數據集包含65種類別,常用的評測設定是 Base集包含48種類別,few-shot訓練中只使用該48個類別。Novel集包含17種類別,在訓練時完全不可見。測試指標主要參考 Novel類的 AP50數值進行比較。

Open-Vocabulary Object Detection Using Captions

論文地址:https://arxiv.org/pdf/2011.10678.pdf

代碼地址:https://github.com/alirezazareian/ovr-cnn

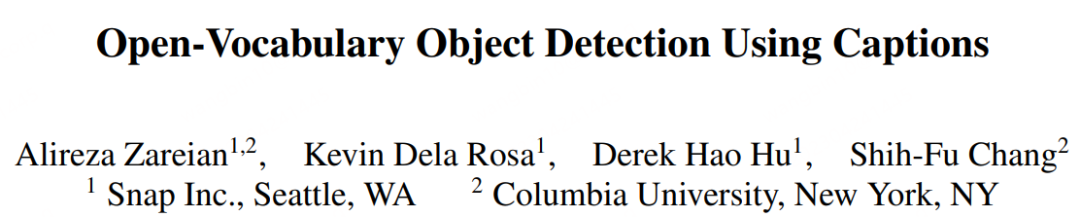

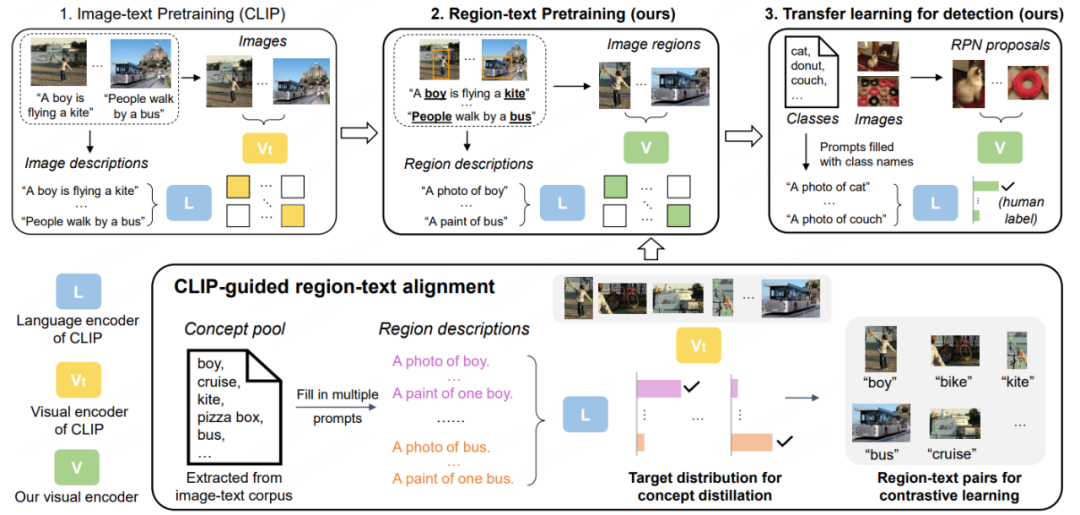

OVR-CNN是 CVPR2021的 Oral-Paper,也是 OVD領域的開山之作。它的二階段訓練范式,影響了后續很多的 OVD工作。如下圖所示,第一階段主要使用 image-caption pairs對視覺編碼器進行預訓練,其中借助 BERT(參數固定)來生成詞掩碼,并與加載 ImageNet預訓練權重的 ResNet50進行弱監督的 Grounding匹配,作者認為弱監督會讓匹配陷入局部最優,于是加入多模態 Transformer進行詞掩碼預測來增加魯棒性。

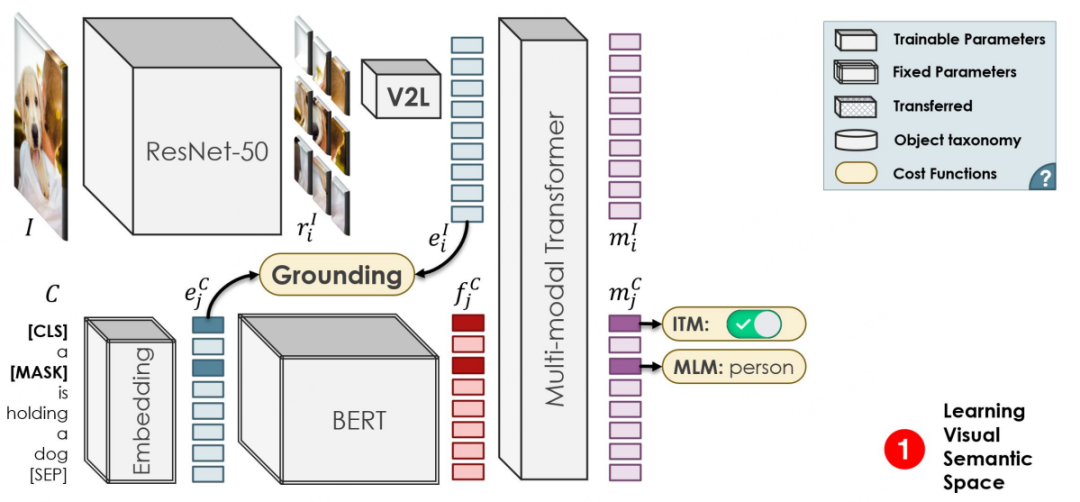

第二階段的訓練流程與 Faster-RCNN類似,區別點在于,特征提取的 Backbone來自于第一階段預訓練得到的 ResNet50的1-3層,RPN后依然使用 ResNet50的第四層進行特征加工,隨后將特征分別用于 Box回歸與分類預測。分類預測是 OVD任務區別于常規檢測的關鍵標志,OVR-CNN中將特征輸入一階段訓練得到的 V2L模塊(參數固定的圖向量轉詞向量模塊)得到一個圖文向量,隨后與標簽詞向量組進行匹配,對類別進行預測。在二階段訓練中,主要使用 Base類對檢測器模型進行框回歸訓練與類別匹配訓練。由于 V2L模塊始終固定,配合目標檢測模型定位能力向新類別遷移,使得檢測模型能夠識別并定位到全新類別的目標。

如下圖所示,OVR-CNN在 COCO數據集上的表現遠超之前的 Zero-shot目標檢測算法。

RegionCLIP: Region-based Language-Image Pretraining

論文地址:https://arxiv.org/abs/2112.09106

代碼地址:https://github.com/microsoft/RegionCLIP

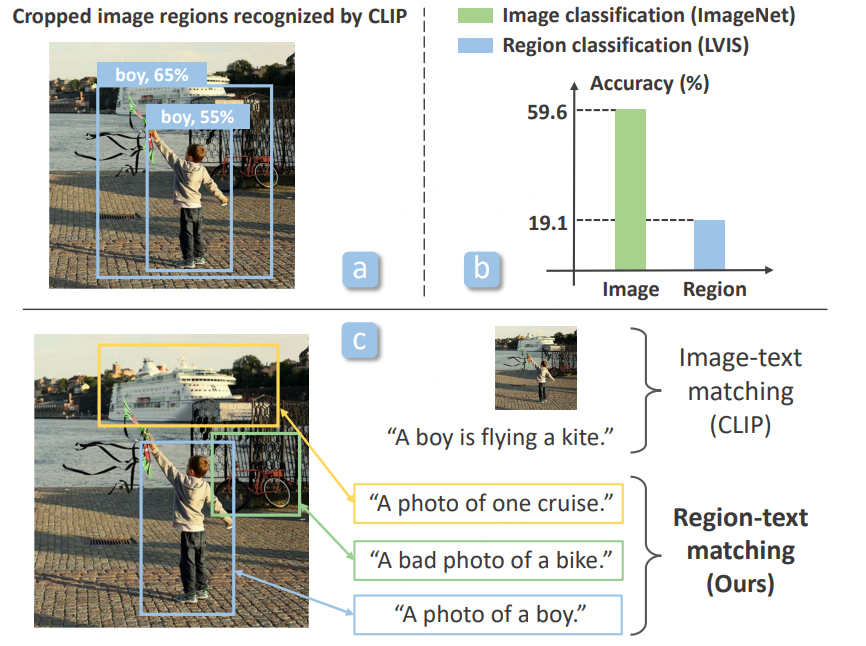

OVR-CNN中使用 BERT與多模態 Transfomer進行 iamge-text pairs預訓練,但隨著跨模態大模型研究的興起,科研工作者開始利用 CLIP,ALIGN等更強力的跨模態大模型對 OVD任務進行訓練。檢測器模型本身主要針對 Proposals,即區域信息進行分類識別,發表于 CVPR2022的 RegionCLIP[5]發現當前已有的大模型,如 CLIP,對裁剪區域的分類能力遠低于對原圖本身的分類能力,為了改進這一點,RegionCLIP提出了一個全新的兩階段 OVD方案。

第一階段,數據集主要使用 CC3M,COCO-caption等圖文匹配數據集進行區域級別的蒸餾預訓練。具體地,

將原先存在于長文本中的詞匯進行提取,組成Concept Pool,進一步形成一組關于Region的簡單描述,用于訓練。

利用基于LVIS預訓練的RPN提取Proposal Regions,并利用原始CLIP對提取到的不同Region與準備好的描述進行匹配分類,并進一步組裝成偽造的語義標簽。

將準備好的Proposal Regions與語義標簽在新的CLIP模型上進行Region-text對比學習,進而得到一個專精于Region信息的CLIP模型。

在預訓練中,新的CLIP模型還會通過蒸餾策略學習原始CLIP的分類能力,以及進行全圖級別的image-text對比學習,來維持新的CLIP模型對完整圖像的表達能力。

第二階段,將得到的預訓練模型在檢測模型上進行遷移學習。

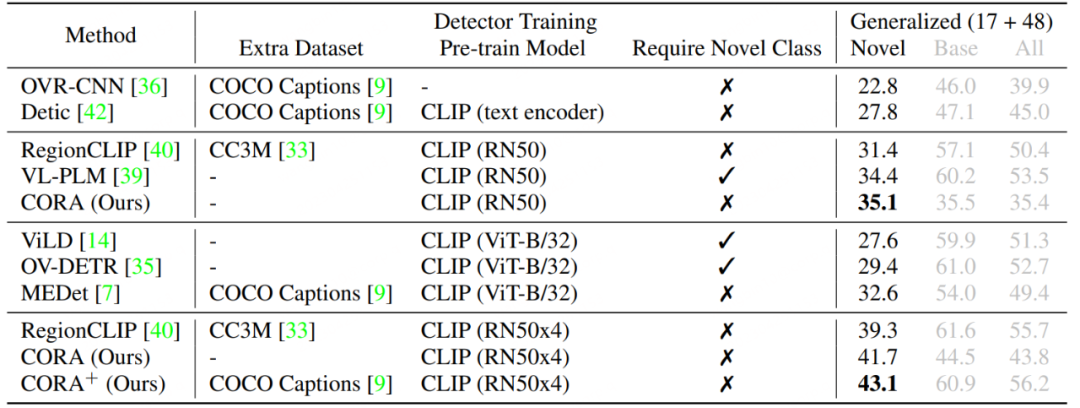

RegionCLIP進一步拓展了已有跨模態大模型在常規檢測模型上的表征能力,進而取得了更加出色的性能,如下圖所示,RegionCLIP相比 OVR-CNN在 Novel類別上取得了較大提升。RegionCLIP通過一階段的預訓練有效地的提升了區域(Region)信息與多模態大模型之間的適應能力,但 CORA認為其使用更大參數規模的跨模態大模型進行一階段訓練時,訓練成本將會非常高昂。

CORA: Adapting CLIP for Open-Vocabulary Detection with Region Prompting and Anchor Pre-Matching

論文地址:https://arxiv.org/abs/2303.13076

代碼地址:https://github.com/tgxs002/CORA

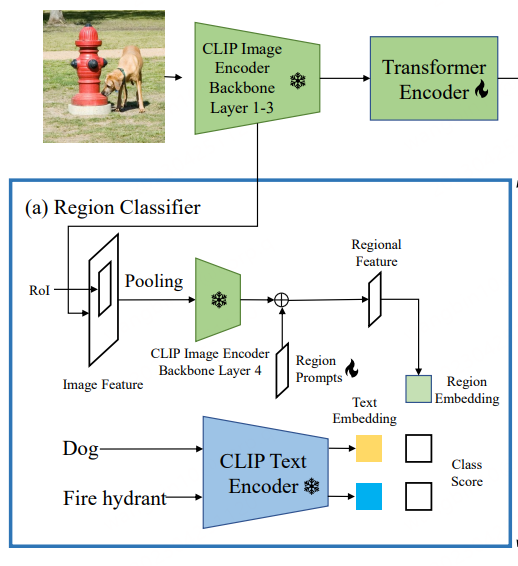

CORA[6]已被收錄于 CVPR2023,為了克服其所提出當前 OVD任務所面臨的兩個阻礙,設計了一個類 DETR的OVD模型。如其文章標題所示,該模型中主要包含了 Region Prompting與 Anchor Pre-Matching兩個策略。前者通過 Prompt技術來優化基于 CLIP的區域分類器所提取的區域特征,進而緩解整體與區域的分布差距,后者通過 DETR檢測方法中的錨點預匹配策略來提升 OVD模型對新類別物體定位能力的泛化性。

CLIP 原始視覺編碼器的整體圖像特征與區域特征之間存在分布差距,進而導致檢測器的分類精度較低(這一點與 RegionCLIP的出發點類似)。因此,CORA提出 Region Prompting來適應 CLIP圖像編碼器,提高對區域信息的分類性能。具體地,首先通過 CLIP編碼器的前3層將整幅圖像編碼成一個特征映射,然后由 RoI Align生成錨點框或預測框,并將其合并成區域特征。隨后由 CLIP 圖像編碼器的第四層進行編碼。為了緩解 CLIP 圖像編碼器的全圖特征圖與區域特征之間存在分布差距,設置了可學習的 Region Prompts并與第四層輸出的特征進行組合,進而生成最終的區域特征用來與文本特征進行匹配,匹配損失使用了樸素的交叉熵損失,且訓練過程中與 CLIP相關的參數模型全都凍結。

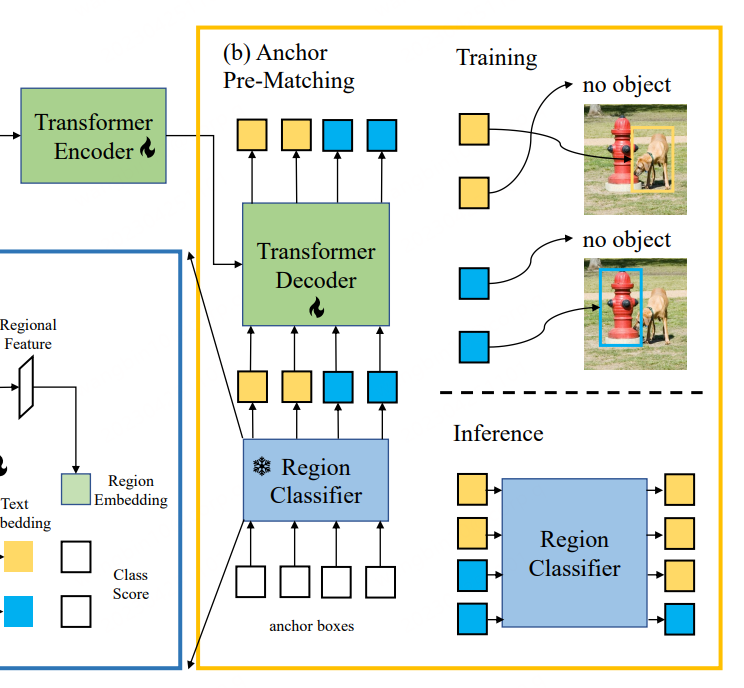

CORA是一個類 DETR的檢測器模型,類似于 DETR,其也使用了錨點預匹配策略來提前生成候選框用于框回歸訓練。具體來說,錨點預匹配是將每個標簽框與最接近的一組錨點框進行匹配,以確定哪些錨點框應該被視為正樣本,哪些應該被視為負樣本。這個匹配過程通常是基于 IoU(交并比)進行的,如果錨點框與標簽框的 IoU 超過一個預定義的閾值,則將其視為正樣本,否則將其視為負樣本。CORA表明該策略能夠有效提高對新類別定位能力的泛化性。

但是使用錨點預匹配機制也會帶來一些問題,比如只有在至少有一個錨點框與標簽框形成匹配時,才可正常進行訓練。否則,該標簽框將被忽略,同時阻礙模型的收斂。進一步,即使標簽框獲得了較為準確的錨點框,由于Region Classifier的識別精度有限,進而導致該標簽框仍可能被忽略,即標簽框對應的類別信息沒有與基于CLIP訓練的Region Classifier形成對齊。因此,CORA用CLIP-Aligned技術利用CLIP的語義識別能力,與預訓練ROI的定位能力,在較少人力情形下對訓練數據集的圖像進行重新標注,使用這種技術,可以讓模型在訓練中匹配更多的標簽框。

相比于RegionCLIP,CORA在COCO數據集上進一步提升了2.4的AP50數值。

360人工智能研究院在OVD技術上的實踐

OVD技術不僅與當前流行的跨/多模態大模型的發展緊密聯系,同時也承接了過去科研工作者對目標檢測領域的技術耕耘,是傳統AI技術與面向通用AI能力研究的一次成功銜接。OVD更是一項面向未來的全新目標檢測技術,可以預料到的是,OVD可以檢測并定位任意目標的能力,也將反過來推進多模態大模型的進一步發展,有希望成為多模態AGI發展中的重要基石。

360 人工智能研究院近年來的研發重點包括:21年跨模態方向,22年OVD和視頻分析方向,23年AIGC和多模態大模型方向。在底層海量圖文數據及多模態方向長期技術積累的加持下,360人工智能研究院自研OVD大模型,目前已在互聯網、智能硬件等業務中落地,在長尾目標檢測、巡店、看護、設備巡檢等場景中實現廣泛應用。未來我們計劃將OVD與多模態大模型MLLM相結合,賦予LLM在基礎的視覺能力之外更為重要的開放世界目標檢測能力,讓多模態大模型的能力向通用人工智能更近一步。

號外

為了推動OVD研究在國內的普及和發展,360人工智能研究院聯合中國圖象圖形學學會舉辦了2023開放世界目標檢測競賽(鏈接:https://360cvgroup.github.io/OVD_Contest/),目前競賽正在火熱報名中。競賽可以幫助大家找到OVD方向的研究同好,與他們切磋交流,并能接觸實際業務場景數據,體驗OVD技術在實際生產中的優勢與魅力,歡迎報名和轉發。

360人工智能研究院簡介:360人工智能研究院隸屬于360技術中臺。自2015年成立以來積累了大量人工智能與機器學習前沿能力,范圍包括但不限于自然語言理解、機器視覺與運動、語音語義交互等方面,技術水平行業領先,核心成員和團隊多次榮獲AI相關比賽冠軍/提名獎項,發表頂會、頂刊論文數十篇。業務落地方面,研究院提供智能安全大數據、互聯網信息分發、企業數字化、AIoT、智能汽車等360集團全量業務場景支持,支持千萬級硬件設備,億級用戶,產生千億規模數據量。2023年著重攻堅大語言模型、CV大模型和多模態大模型,為360集團和行業 AIGC技術發展應用提供底層技術支撐。

-

算法

+關注

關注

23文章

4713瀏覽量

95534 -

目標檢測

+關注

關注

0文章

228瀏覽量

16038 -

Agi

+關注

關注

0文章

93瀏覽量

10525

原文標題:邁向多模態AGI之開放世界目標檢測

文章出處:【微信號:AI科技大本營,微信公眾號:AI科技大本營】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

世界模型:多模態融合+因果推理,解鎖AI認知邊界

多文化場景下的多模態情感識別

基于聯合壓縮感知的多模態目標統一跟蹤方法

如何利用LLM做多模態任務?

邱錫鵬團隊提出具有內生跨模態能力的SpeechGPT,為多模態LLM指明方向

自動駕駛深度多模態目標檢測和語義分割:數據集、方法和挑戰

GPT-4只是AGI的火花?LLM終將退場,世界模型才是未來

基于多模態學習的虛假新聞檢測研究

評論