除了各類開源模型外,還有GPT-4、PaLM 2等眾多「閉源」模型,甚至還開設了一個「準中文」排行榜。

最近,來自斯坦福的團隊,也發布了一款LLM自動評測系統——AlpacaEval,以及對應的AlpacaEval Leaderboard。

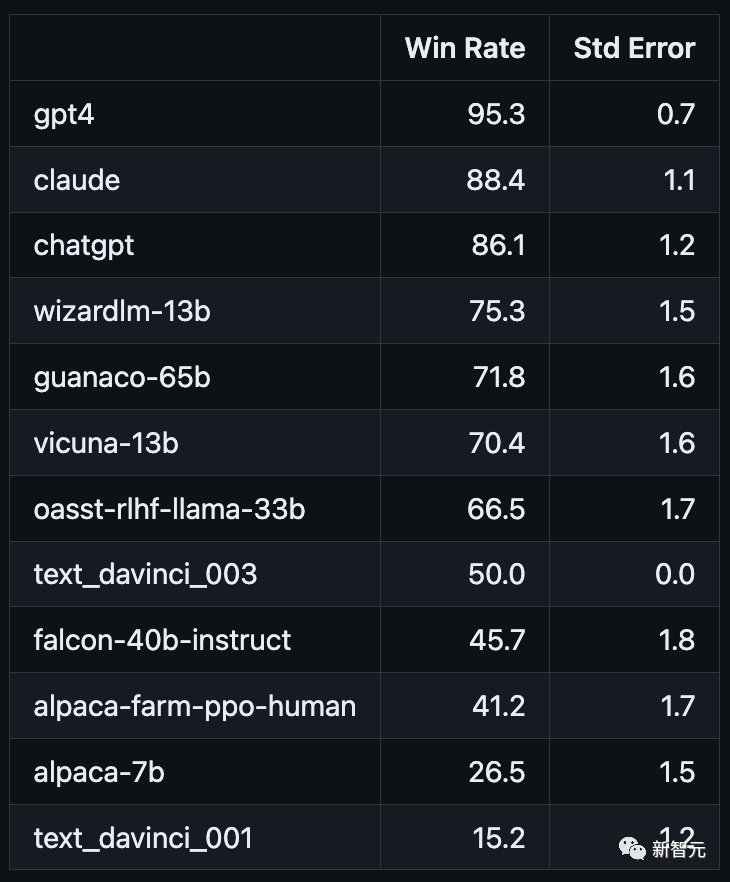

在斯坦福的這個排行榜中,GPT-4依然以絕對領先的優勢奪得第一,勝率超過了95%。

緊隨其后的是,勝率都在80%以上的Claude和ChatGPT。其中,Claude以不到3%的優勢拿下第二,而ChatGPT則位列第三。

此次獲得第四名的,則是一位排位賽新人——微軟華人團隊發布的WizardLM。

UC伯克利的Vicuna發揮依然穩定,憑借著超過70%的勝率排在第六。

相比之下,斯坦福自己的Alpaca卻只排到了第16……

其實,團隊自從原始的Alpaca推出以來,已經做了不小的改進——勝率從26%提升到了44%,但依然距離領獎臺很遠。

對此,其中一位作者有些無奈地表示:「是不是我們哪里做的不對?」

AlpacaEval:易使用、速度快、成本低、經過人類標注驗證

AlpacaEval把AlpacaFarm和Aviary進行了結合。

一方面使用與AlpacaFarm相同的代碼(緩存/隨機排列/超參數),另一方面則使用類似于Aviary的排序提示。

與此同時,還對Aviary的提示進行了修改,從而減少對較長輸出的偏見。

團隊表示,AlpacaEval有著拔群的效果:

與人類多數票的一致性,高于單個人類標注者

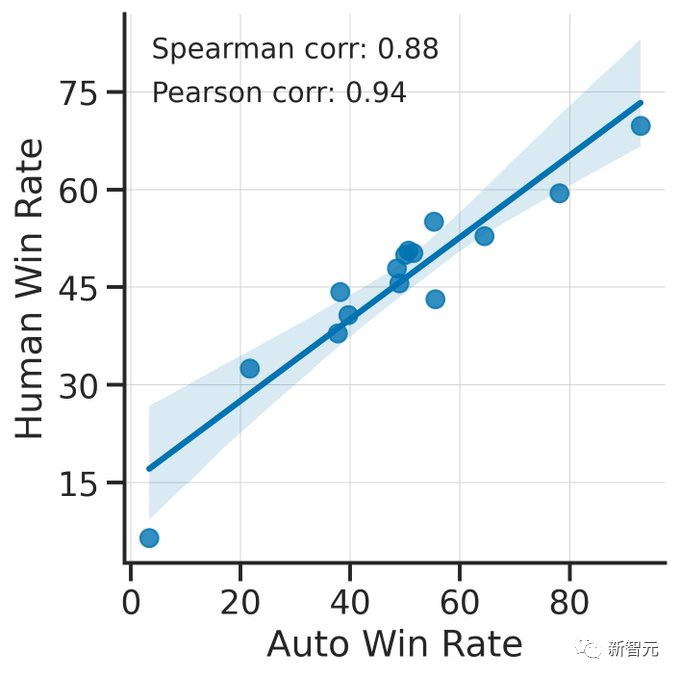

勝率與人類標注高度相關(0.94)

相比于lmsys評測器,有顯著提升(從63%提高到69%)

勝率

模型的輸出在每個指令上優于text-davinci-003(即參考文本)的比例。

具體而言,首先從AlpacaEval數據集中收集了期望模型在每個指令上的輸出對,并將每個輸出與相同指令下的參考模型(text-davinci-003)的輸出進行配對。

隨后,把這些輸出同時喂給自動評測器,讓它去判斷哪一個更好(也就是評測器的偏好)。

最后,將數據集中所有指令的偏好進行平均,從而得到模型相對于text-davinci-003的勝率。如果兩個模型打平,那么就算半個偏好。

論文地址:

https://arxiv.org/pdf/2305.14387.pdf

標準誤差

勝率的標準誤差(通過N-1進行歸一化),即不同指令上的平均偏好。

不同評測器的對比

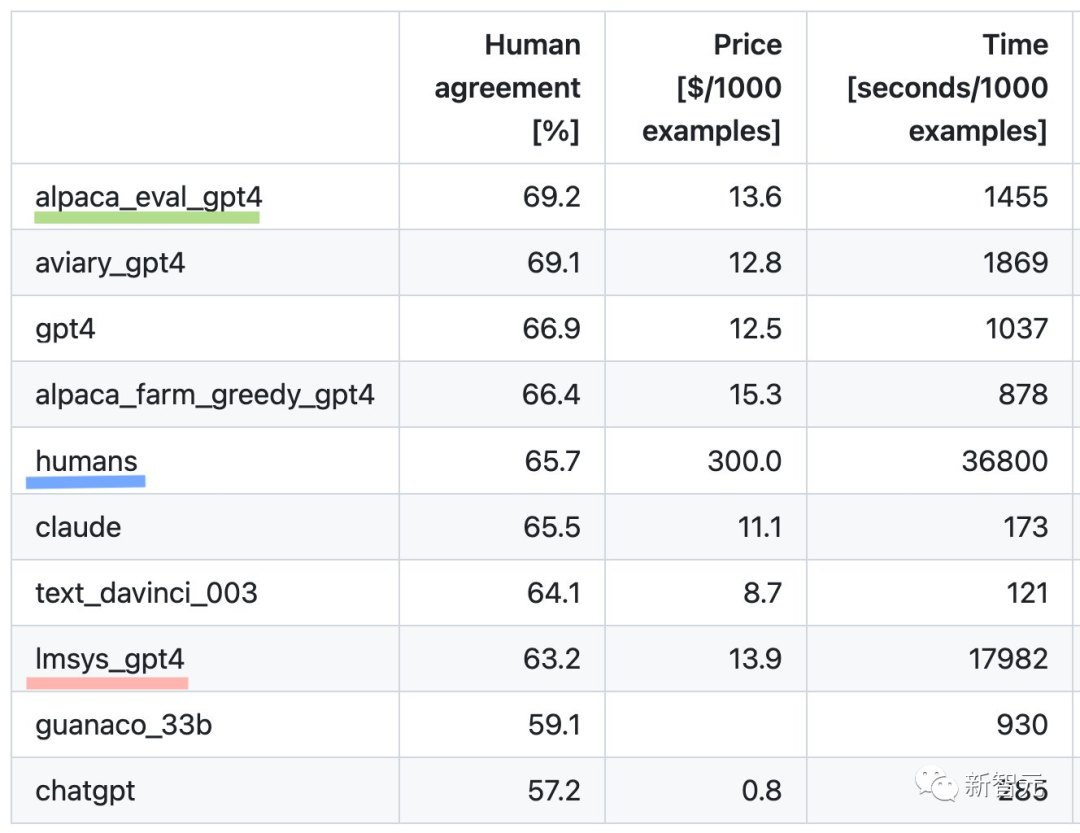

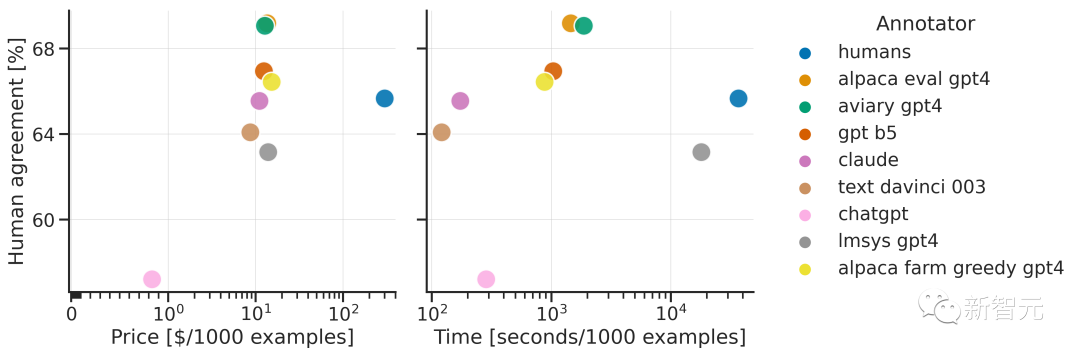

團隊通過與收集的2.5K個人工標注(每個指令平均包含4個人工標注)進行比較,評測了AlpacaEval數據集上的不同自動標注程序。

▲斯坦福的評測器(alpaca_eval_gpt4)、之前的自動評測器(alpaca_farm_greedy_gpt4、aviary_gpt4、lmsys_gpt4)、人類(humans)以及不同基準模型(gpt4、claude、text_davinci_003、guanaco_33b、chatgpt)的測試結果

▲斯坦福的評測器(alpaca_eval_gpt4)、之前的自動評測器(alpaca_farm_greedy_gpt4、aviary_gpt4、lmsys_gpt4)、人類(humans)以及不同基準模型(gpt4、claude、text_davinci_003、guanaco_33b、chatgpt)的測試結果

人類一致性:標注者與交叉標注集中人類多數票之間的一致性

為了估計單個人類標注者(表格中的humans行)與多數人類之間的一致性,首先需要選取一個標注,并計算其在預測其他3個標注的眾數時的準確率。

然后,將所有4個標注和650個指令上的準確率求平均,得到人類一致性,即計算預期的(對于人類和樣本)留一法一致性。如果眾數不唯一,我們隨機選擇其中一個眾數。

對于自動標注器,我們進行完全相同的計算,以便最終的結果可以進行比較。

價格:每1000個標注的平均價格

對于人類來說,這是支付眾包工人進行這些標注的價格(每小時18美元)。如果價格取決于用于計算標注的機器(例如Guanaco),則將其留空。

時間:計算1000個標注所需的平均時間

對于人類來說,這是每個眾包工人標注1000個示例所需時間的中位數。

對于自動標注器,這是運行標注所需的平均時間。值得注意的是,這可能取決于不同用戶的API限制以及集群正在處理的請求數量。

最后,為了進一步改善自動評測流程,團隊發布了:

一個易于定制的流程

模型和自動評測器的排行榜

分析自動評測器的工具包

18K人類標注

2K人類交叉標注

局限性

雖然AlpacaEval提供了一個有用的比較模型,但它并不是一個全面的的模型能力評測系統,其局限性可以概括為以下三點:

指令比較簡單

評分時可能更偏向于風格而非事實

沒有衡量模型可能造成的危害

責任編輯:彭菁

-

微軟

+關注

關注

4文章

6591瀏覽量

104026 -

代碼

+關注

關注

30文章

4780瀏覽量

68527 -

工具包

+關注

關注

0文章

46瀏覽量

9529

原文標題:斯坦福最新LLM排行榜發布!自家Alpaca墊底,華人團隊WizardLM開源第一,GPT-4、Claude穩居前二

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

SAM9G45-EK評測工具包怎么樣?

固件工具包

SAM9G45評測工具包(Atmel)

愛特梅爾推出SAM9G45評測工具包

用于代碼編碼器的分析工具包V1.3版本的詳細資料概述

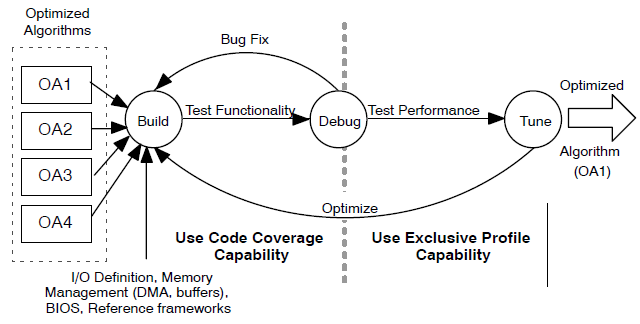

分析自動評測器的工具包

分析自動評測器的工具包

評論