本文旨在更好地理解基于 Transformer 的大型語言模型(LLM)的內部機制,以提高它們的可靠性和可解釋性。

隨著大型語言模型(LLM)在使用和部署方面的不斷增加,打開黑箱并了解它們的內部工作原理變得越來越重要。更好地理解這些模型是如何做出決策的,這對改進模型和減輕其故障(如幻覺或推理錯誤)至關重要。 眾所周知,最近 LLM 成功的一個重要因素是它們能夠從上下文中學習和推理。LLM 對這些上下文的學習能力通常歸功于 Transformer 架構,特別是自注意力塊的使用,其能夠仔細選擇輸入序列,進而推理出可信的下一個 token。此外,預測可能需要全局知識,如語法規則或一般事實,這些可能不會出現在上下文中,需要存儲在模型中。 我們不禁會疑問,為什么基于 Transformer 的模型非常擅長使用它們的上下文來預測新的 token,這種能力是如何在訓練中產生的?帶著這些問題,來自 Meta AI 的研究者進行了深入的研究。他們通過研究合成設置下 Transformer 的學習機制,揭示了其全局和上下文學習的平衡,并將權重矩陣解釋為聯想記憶,為理解和優化 Transformer 提供了基礎。

論文地址:https://arxiv.org/abs/2306.00802 首先要了解的是在訓練過程中 Transformer 是如何發現這些能力的。為此,該研究引入了一個合成數據集,該數據集由二元語言模型生成的序列組成。然后,模型需要依靠上下文學習來對特定的二元序列進行良好的預測,而全局二元可以根據當前 token 的全局統計數據進行猜測。雖然單層的 Transformer 無法可靠地預測上下文二元,但該研究發現通過開發感應頭(induction head)機制的雙層 Transformer 取得了成功,即擁有兩個注意力頭的 circuit,其允許 Transformer 從上下文 [???, a, b,???, a] 中預測 b,并且在 Transformer 語言模型中似乎無處不在。這種感應頭(induction head)機制在 Transformer 語言模型中是普遍存在的,并且取得了成功。 更進一步的,為了更好的了解上下文機制是怎樣出現在訓練過程中的,該研究在隨機初始化時凍結了一些層(包括嵌入和值矩陣)來進一步簡化模型架構。這樣一來研究重點轉移到注意力和前饋機制,同時避免了學習表征的困難。與此同時,這種簡化還為單個權重矩陣引入了一個自然模型作為聯想記憶。自然模型可以通過它們的外積存儲輸入 - 輸出或鍵 - 值對嵌入。隨機高維嵌入由于其接近正交性而特別適合這種觀點。 總結而言,該研究的貢獻可概括為:

本文引入了一種新的合成設置來研究全局和上下文學習:序列遵循二元語言模型,其中一些二元在序列中變化,而另一些不會。

本文將 Transformer 的權重矩陣視為學習存儲特定嵌入對的聯想記憶,并以此為任務推導出一個簡化但更可解釋的模型。

本文對訓練動態進行了細致的實證研究:首先學習全局二元,然后以自上而下的方式學習適當的記憶,形成感應頭。

本文給出了訓練動力學的理論見解,展示了如何通過在噪聲輸入中找到信號,在種群損失上進行一些自上而下的梯度步驟來恢復所需的聯想記憶。

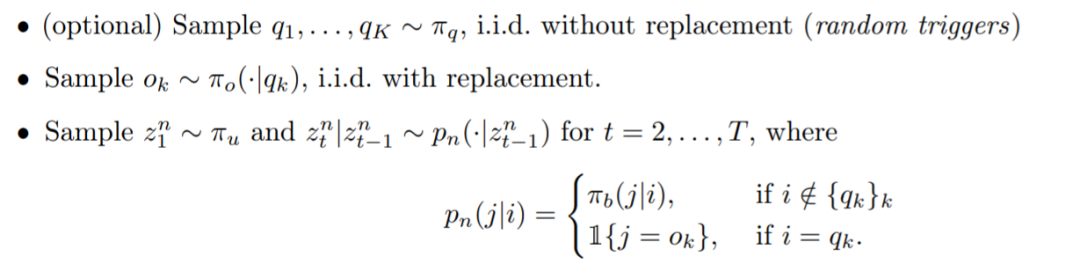

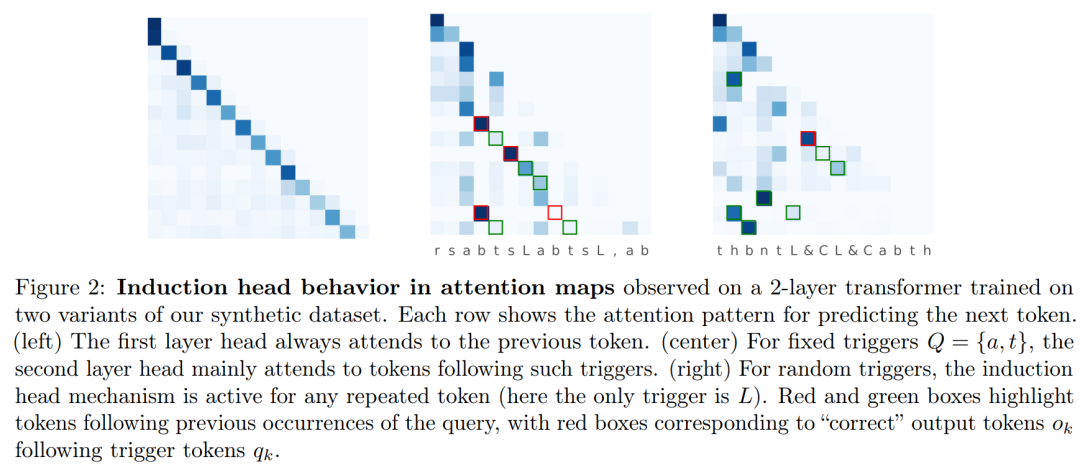

方法介紹 接著該研究介紹了合成數據設置,這樣能夠仔細研究感應頭機制在訓練過程中的發展以及 Transformer 如何學習利用上下文信息的。 雙元數據模型:模型序列由一個通用的雙元語言模型(即馬爾可夫鏈)組成,每個序列的生成方式如下:  下圖 2 可視化了測試序列上的注意力圖,這表明該模型已經學習了感應頭機制。

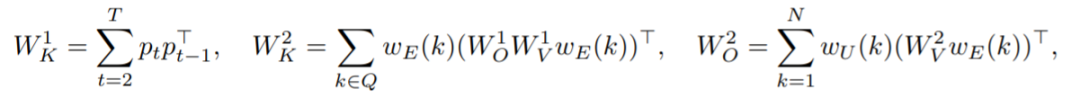

下圖 2 可視化了測試序列上的注意力圖,這表明該模型已經學習了感應頭機制。  接著該研究介紹了 Transformer 聯想記憶觀點:因為幾乎正交的嵌入,權重矩陣表現為聯想記憶,將成對的嵌入存儲為其外積的加權和。研究引入了一個具有固定隨機嵌入的簡化 Transformer 模型,將用這種想法產生對學習動力學的精確理解。 此外,該研究提出了一個有用的觀點,將 Transformer 中的模型權重視為高維嵌入向量的聯想記憶。感應頭機制可以通過以下外積矩陣作為記憶來獲得,而其他所有權重則固定為隨機初始化狀態:

接著該研究介紹了 Transformer 聯想記憶觀點:因為幾乎正交的嵌入,權重矩陣表現為聯想記憶,將成對的嵌入存儲為其外積的加權和。研究引入了一個具有固定隨機嵌入的簡化 Transformer 模型,將用這種想法產生對學習動力學的精確理解。 此外,該研究提出了一個有用的觀點,將 Transformer 中的模型權重視為高維嵌入向量的聯想記憶。感應頭機制可以通過以下外積矩陣作為記憶來獲得,而其他所有權重則固定為隨機初始化狀態:  實驗 圖 3 研究了在迭代 300 次之前凍結不同層對訓練動態的影響。

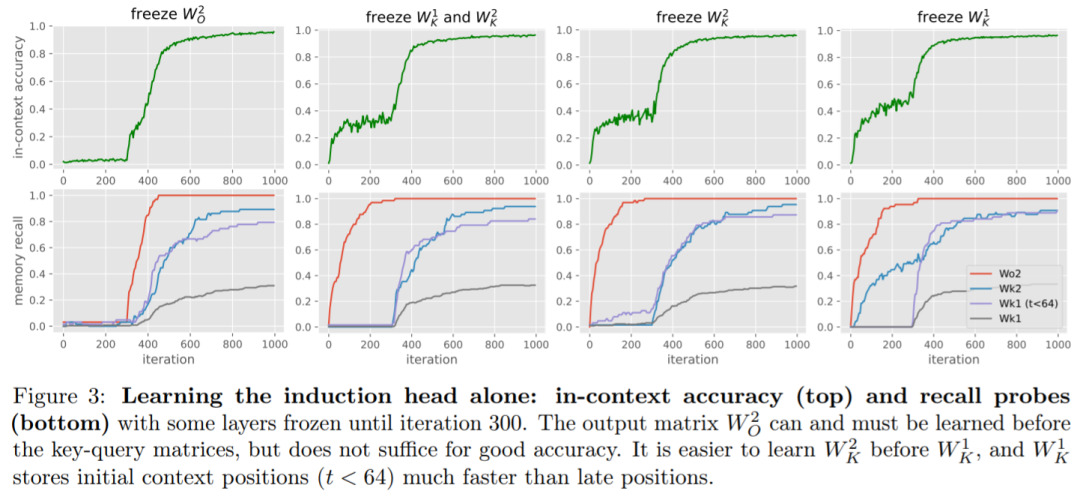

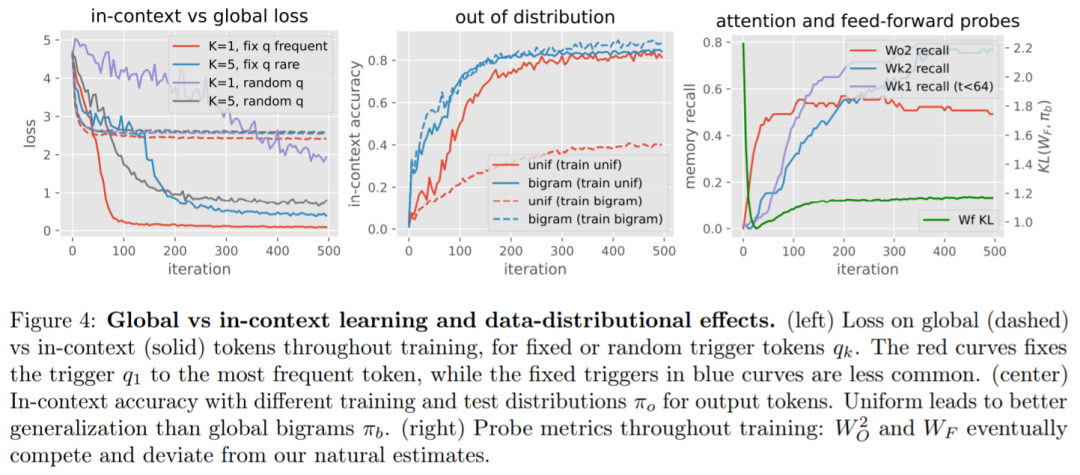

實驗 圖 3 研究了在迭代 300 次之前凍結不同層對訓練動態的影響。  全局 vs 上下文學習。從圖 4(左 / 右)可以看出,當聯合訓練所有層時,全局二元統計的學習速度往往比感應頭更快,這可以從早期迭代中的 loss 和 KL 的快速下降中看出。 此外,從圖 4(左)中看到,數據分布的變化會對上下文機制的學習速度產生重大影響。該研究觀察到以下情況可能會使上下文學習減慢:(i) 較少數量的觸發器 K, (ii) 僅使用少有的固定觸發器,以及 (iii) 使用隨機觸發器而不是固定觸發器。 該研究還在圖 4(中間)中顯示,在訓練時將輸出 token 分布更改為二元分布會降低準確率,這表明,使用更多樣化的訓練分布可以產生具有更好泛化準確率的模型,并且只需少量的額外訓練成本。

全局 vs 上下文學習。從圖 4(左 / 右)可以看出,當聯合訓練所有層時,全局二元統計的學習速度往往比感應頭更快,這可以從早期迭代中的 loss 和 KL 的快速下降中看出。 此外,從圖 4(左)中看到,數據分布的變化會對上下文機制的學習速度產生重大影響。該研究觀察到以下情況可能會使上下文學習減慢:(i) 較少數量的觸發器 K, (ii) 僅使用少有的固定觸發器,以及 (iii) 使用隨機觸發器而不是固定觸發器。 該研究還在圖 4(中間)中顯示,在訓練時將輸出 token 分布更改為二元分布會降低準確率,這表明,使用更多樣化的訓練分布可以產生具有更好泛化準確率的模型,并且只需少量的額外訓練成本。

-

存儲

+關注

關注

13文章

4540瀏覽量

87541 -

語言模型

+關注

關注

0文章

562瀏覽量

10816 -

Transformer

+關注

關注

0文章

151瀏覽量

6532 -

LLM

+關注

關注

1文章

326瀏覽量

865

原文標題:基于Transformer的大模型是如何運行的?Meta揭秘內部機制!

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【大語言模型:原理與工程實踐】大語言模型的基礎技術

無法在OVMS上運行來自Meta的大型語言模型 (LLM),為什么?

大型語言模型(LLM)的自定義訓練:包含代碼示例的詳細指南

大型語言模型的應用

Medusa如何加速大型語言模型(LLM)的生成?

評論