介紹

以往的特征檢測和匹配算法側重于提取大量冗余的局部可靠特征,這樣會導致效率和準確性有限,特別是在大規模環境中挑戰性的場景,比如天氣變化、季節變化、光照變化等等。

本文將高級語義信息隱式地嵌入到檢測和描述過程中來提取全局可靠的特征,即他們設計了一個語義感知檢測器,能夠從可靠的區域(如建筑物、交通車道)檢測關鍵點,并隱式地抑制不可靠的區域(如天空、汽車),而不是依賴于顯式的語義標簽。通過減少對外觀變化敏感的特征數量,并避免加入額外的語義分割網絡,提高了關鍵點匹配的準確性。此外,生成的描述符嵌入了語義信息后具有更強的鑒別能力,提供了更多的inliers。

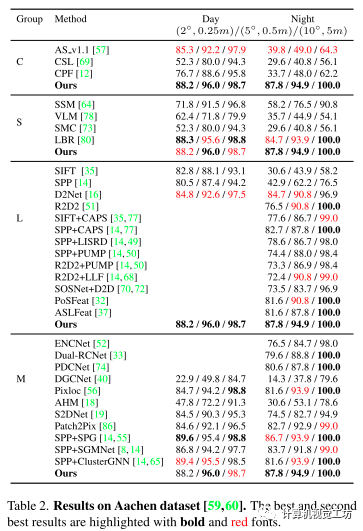

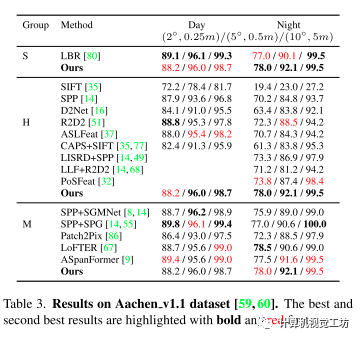

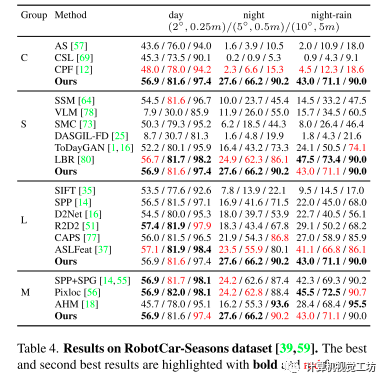

論文實驗是在Aachen DayNight和RobotCar-Seasons數據集上進行的長時大規模視覺定位測試。

出發點

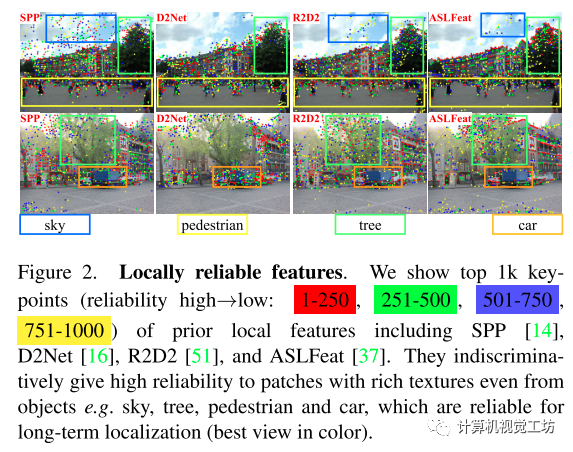

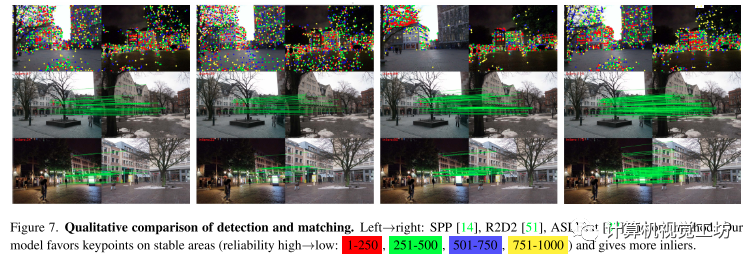

目前最先進效果最好的特征檢測和描述算法都是基于學習的方法,由于有大量的訓練數據,這些方法能夠通過聚焦于有判別性的特征,即從更可靠的區域(如建筑物、交通車道)中提取關鍵點,但是訓練中缺少語義信息,他們選擇全局可靠的關鍵點的能力有限,如下圖所示,他們更喜歡從物體中提取局部可靠的特征,包括那些對長時定位沒有幫助的特征(如天空、樹、汽車),這導致精度有限。

雖然也有方法融入過語義這些高層次信息,但它們需要額外的分割網絡在測試時提供語義標簽,并且很容易出現分割錯誤,本文則隱式地融入語義信息到檢測和描述中去,以此提高匹配的性能,進而提升下游視覺定位的性能。

雖然也有方法融入過語義這些高層次信息,但它們需要額外的分割網絡在測試時提供語義標簽,并且很容易出現分割錯誤,本文則隱式地融入語義信息到檢測和描述中去,以此提高匹配的性能,進而提升下游視覺定位的性能。

主要貢獻

1.提出了一種新的特征網絡,在訓練時隱式地將語義融入到檢測和描述過程中,使模型能夠在測試時產生端到端的語義感知特征。

2.采用語義感知和特征感知相結合的引導策略來使得模型更有效地嵌入語義信息。

3.在長時定位任務上優于以往的局部特征,具有與先進匹配算法相當的精度和較高的效率。

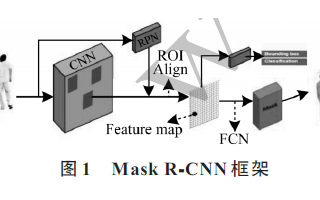

Pipeline

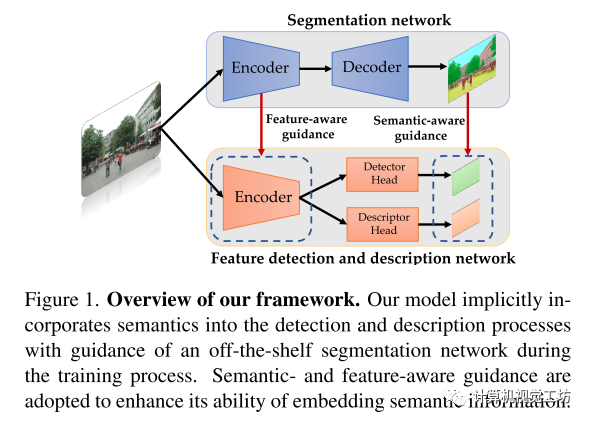

如上圖所示,模型由一個編碼器和兩個解碼器組成。一個編碼器負責從圖像中提取High level的特征,一個解碼器預測可靠性圖, 一個解碼器產生描述符。

語義引導的特征檢測:

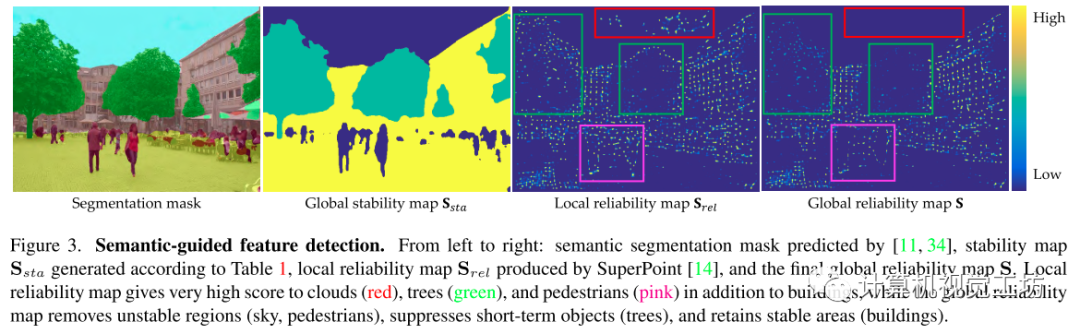

特征檢測器預測的可靠性圖為,之前方法預測的可靠性圖是由紋理的豐富度主導的。如下圖所示,以往的方法只揭示了像素在局部層面的可靠性,缺乏全局層面的穩定性,本文通過考慮局部可靠性和全局穩定性來重新定義特征的可靠性。

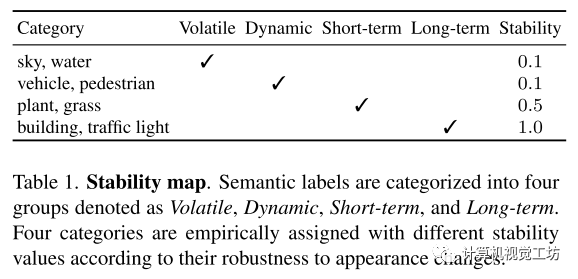

其中局部可靠性這里用super-point預測的可靠性圖,全局穩定性是根據像素所屬的語義標簽來確定其全局穩定性。具體來說,將ADE20k數據集中的120個語義標簽按照它們隨時間變化的方式分為四類,分別表示為Volatile、Dynamic、Short-term和Long-term。

Volatile(如天空、水)是不斷變化的,對于定位來說是多余的。

Dynamic(如汽車、行人)每天都在移動,可能會因為引入錯誤的匹配而導致定位錯誤。

Short-term(如樹)可以用于短期定位任務(如VO/SLAM),但它們對光照(低反照率)和季節條件的變化很敏感。

Long-term(如建筑、交通燈)不受上述變化的影響,是長時定位的理想對象。

而且他們沒有直接過濾不穩定的特征,而是根據期望的抑制程度,根據經驗分配的穩定性值對特征重新排序。其中,Long-term對象對于短期和長期定位都是魯棒的,因此將其穩定性值設置為1.0,Short-term對于短期定位很有用,將其穩定性設置為0.5。Volatile和Dynamic類別的穩定性值被設置為0.1,因為它們對于短期/長期定位都沒有用處。重新排序策略鼓勵模型優先使用穩定的特征,當發現不穩定的關鍵點時,使用來自其他對象的關鍵點作為補償,增加了模型對各種任務的魯棒性(如特征匹配、短期定位)。

然后將局部可靠性圖與全局穩定性圖相乘得到全局可靠性圖。

語義引導的特征描述:

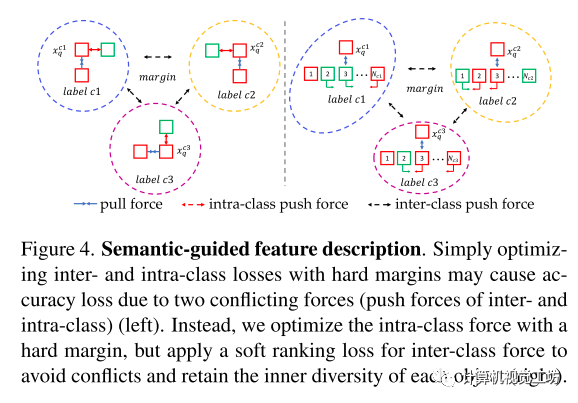

通過在描述符中嵌入語義來增強它們的區分能力。與之前的描述符僅根據局部patch信息區分關鍵點不同的是,本文的描述符加強了同一類特征的相似性,同時保留了類內匹配的不相似性。但在訓練過程中,這兩種力量相互沖突,因為類間判別能力需要擠壓同一類中描述符的空間,而類內判別能力需要增加空間。

為了解決這個問題,本文基于兩種不同的度量設計里類間損失和類內損失。

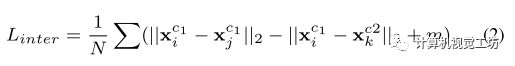

類間損失:先通過最大化不同標簽描述符之間的歐幾里德距離來增強特征的語義一致性。這使得特征可以從具有相同標簽的候選對象中找到對應,減少了搜索空間,從而提高了匹配的準確性。定義了基于三態損失的類間損失,該損失具有硬邊距,用于將一批不同標簽的所有可能的正負關鍵點分離開來。

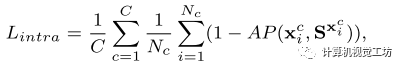

類內損失:為了確保類內損失不會與類間損失沖突,放寬了具有相同標簽的描述符之間距離的限制。采用了軟排序損失,而不是使用硬邊的三重損失,通過優化正樣本和負樣本的排序而不是它們的距離。通過對所有樣本的排序進行優化,而不是像帶硬邊緣的三態損失那樣在正負對之間強制設置硬邊界,軟排序損失也保持了同一類對象上特征的多樣性。

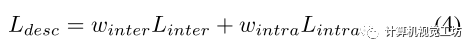

最終的損失為:

實驗

在Aachen (v1.0和v1.1)和RobotCar-Seasons數據集上測試了各種光照、季節和天氣條件下的方法。

Aachen v1.0包含了在亞琛城市周圍捕獲的4328張參考圖片和922張(824天,98夜)查詢圖片。

Aachen v1.1對v1.0進行了擴展,添加了2369張參考圖片和93張夜間查詢圖片。

RobotCar-Seasons有26121個參考圖像和11934個查詢圖像,由于郊區白天(雨、雪、黃昏、冬季)查詢圖像的條件多樣,夜間查詢圖像的光照條件較差,因此具有一定的挑戰性。

采用錯誤閾值(2?,0.25m),(5?,0.5m),(10?,5m)的成功率作為度量。

baseline:

基線包括經典的方法(C),如AS v1.1、CSL和CPF以及使用語義的方法(S),如LLN、SMC、SSM、DASGIL、ToDayGAN和LBR。

還與學習的特征和稀疏/密集匹配器(M)進行了比較,例如,Superglue (SPG) , SGMNet , ClusterGNN和ASpanFormer , LoFTER , Patch2Pix , Dual-RCNet。

可以看出其方法在定位下游任務和最先進的方法表現持平或超過。

匹配定性結果:

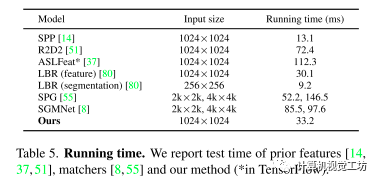

運行時間比較:

其方法可以說是又快又準了!

-

編碼器

+關注

關注

45文章

3638瀏覽量

134427 -

檢測器

+關注

關注

1文章

863瀏覽量

47678 -

數據

+關注

關注

8文章

7002瀏覽量

88943

原文標題:CVPR 2023 | 融入語義的特征檢測和描述,更快更準!

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

基于OWL屬性特征的語義檢索研究

模擬電路故障診斷中的特征提取方法

基于TICA和GMM的視頻語義概念檢測算法

如何提取和檢測視頻中的文字?數字視頻中文字的檢測提取技術的分析

高斯過程隱變量模型及相關實踐

結合雙目圖像的深度信息跨層次特征的語義分割模型

將高級語義信息隱式地嵌入到檢測和描述過程中來提取全局可靠的特征

將高級語義信息隱式地嵌入到檢測和描述過程中來提取全局可靠的特征

評論