近日,在AIGC的廣闊世界里出現了一個火熱的圖像編輯方法—即通過在給定圖像上通過把語義內容從原位置(handle point)拖動到目標位置(target point)的方式進行精細的定制化編輯操作。比如令人印象深刻的讓你家貓咪對你wink的神奇操作:

這一驚人效果來自于發表在SIGGRAPH 2023會議上的 [Drag Your GAN] 論文(簡稱為DragGAN)。并且DragGAN的代碼一經發出就在短短幾周內狂攬30K star,引發廣大網友的“Drag”熱潮。有了DragGAN的加持,各種AI畫圖工具的「阿喀琉斯之踵」再也不是弱點,哪里不滿意就只修哪里!

圖 1 DragGAN 由于內容突變發生跟蹤點丟失

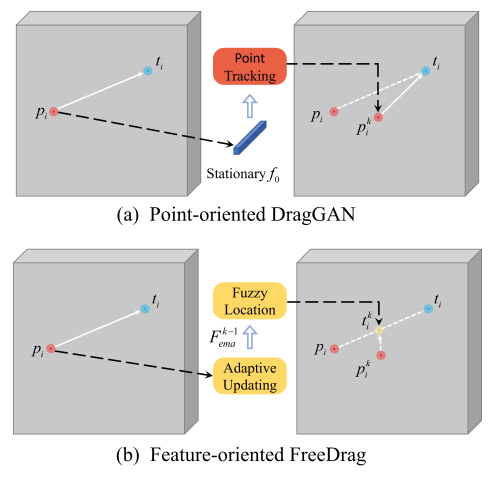

近日,中科大和上海AI Lab的研究者們又發布了一項相關研究—FreeDrag。研究者們表明,先前的DragGAN由兩個交替迭代進行的過程構成:(1)運動監督(motion supervision)過程指導handle point向著對應的target point進行移動;(2)點跟蹤(point tracking)過程則負責定位移動后handle point的精確位置從而為下次移動提供方向和約束特征。因此DragGAN 嚴重依賴于點跟蹤的精確性。然而,點跟蹤的策略本質上是不穩定的,因為它隱式地假設每次移動后在默認的搜索區域內有且僅有一個點完美繼承了handle point的特征。這個假設會在以下兩種情況下失效:i) 圖像內容發生劇烈變化導致的跟蹤丟失(圖1) ii) 搜索區域內的相似點導致的跟蹤錯誤(圖2),例如輪廓線和馬腿等。錯誤的點跟蹤會為下一次移動提供錯誤的方向和約束特征,造成誤差累積從而損害編輯的質量。

圖 1 DragGAN 由于相似點的存在發生錯誤的點跟蹤

方法介紹

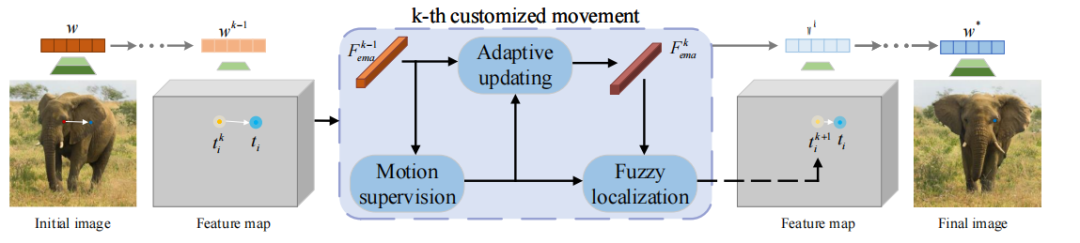

為了防止不穩定的點跟蹤過程不可避免地損害圖像編輯的質量,中國科學技術大學和上海AI Lab的研究者們共同提出FreeDrag, 一種以特征為導向的基于點的交互式編輯框架。FreeDrag通過引入自適應更新的模板特征,模糊定位和線性搜索技術,在無需進行精確點跟蹤的情況下即可實現更加穩定可靠的拖動編輯。

圖 2 FreeDrag 的流程圖

圖 3 DragGAN的點跟蹤和FreeDrag 點定位的比較。

DragGAN 要求精確定位 的位置,而FreeDrag 通過約束特征差異限制定位點

的位置,而FreeDrag 通過約束特征差異限制定位點 在

在 附近,但不要求確定

附近,但不要求確定 的具體位置。

的具體位置。

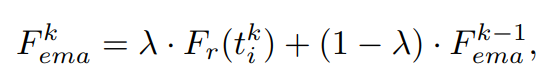

動態更新的模板特征

研究者們首先提出了動態更新的模板特征技術來緩解跟蹤點丟失問題。模板特征通過衡量每次移動的質量來決定是否更新,即通過控制 的值來決定每次更新的比例。更大的

的值來決定每次更新的比例。更大的 意味著更大的更新程度。移動質量越高更新程度越大。移動質量通過衡量移動結束后

意味著更大的更新程度。移動質量越高更新程度越大。移動質量通過衡量移動結束后 處的特征

處的特征 和上一次的模板特征值

和上一次的模板特征值 的?????? L1 距離 (

的?????? L1 距離 ( ) 來度量,

) 來度量, 越小說明移動質量越高。模板特征的更新過程不依賴于handle point 的位置和特征,從而擺脫了對精確的點跟蹤的負擔,同時自適應的更新策略帶來的平滑性賦予了模板特征更好的魯棒性來克服劇烈的內容變化,避免編輯內容的異常丟失。

越小說明移動質量越高。模板特征的更新過程不依賴于handle point 的位置和特征,從而擺脫了對精確的點跟蹤的負擔,同時自適應的更新策略帶來的平滑性賦予了模板特征更好的魯棒性來克服劇烈的內容變化,避免編輯內容的異常丟失。

模糊定位和線性搜索

緊接著,研究者們提出模糊定位和線性搜索技術來緩解跟蹤點模糊問題。FreeDrag 通過移動距離 和特征差異

和特征差異 來為每次的移動定位適合的目標點,即公式(10)。定位主要分為三種情況:繼續向target point移動(移動質量高);保持當前位置不動(移動不徹底),點回退(移動異常)。

來為每次的移動定位適合的目標點,即公式(10)。定位主要分為三種情況:繼續向target point移動(移動質量高);保持當前位置不動(移動不徹底),點回退(移動異常)。

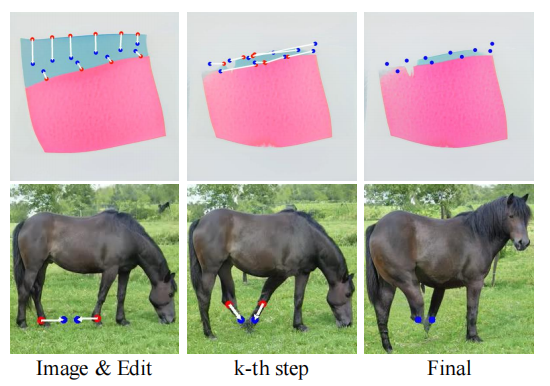

相比于DragGAN要求的精確的點跟蹤,公式(10)搜尋的定位點是“模糊”因為它并不要求搜尋handle point的準確位置,而是通過約束特征差異確保定位點在handle point附近, 因此擺脫了精確定位的負擔。此外,公式(10) 只在原始handle point 和 target point 形成的直線上進行點搜索,這種線性搜索策略有效地緩解了相鄰區域內相似點的干擾,保障了運動監督的可靠性,進一步提高點移動的穩定性。

實驗對比

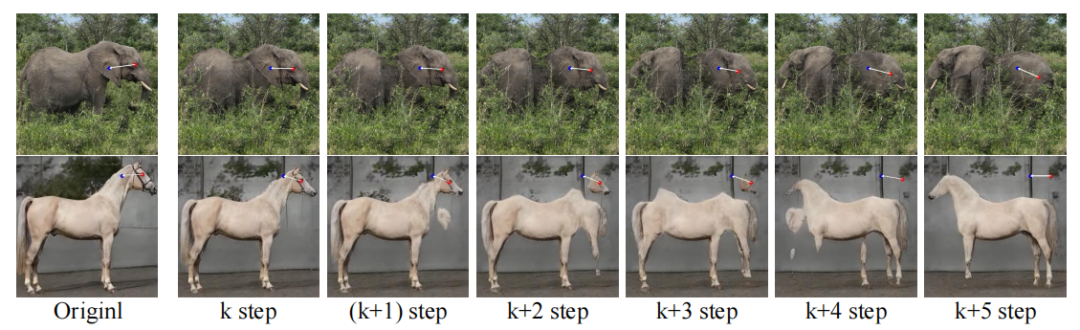

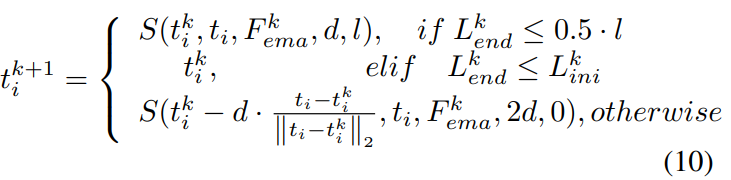

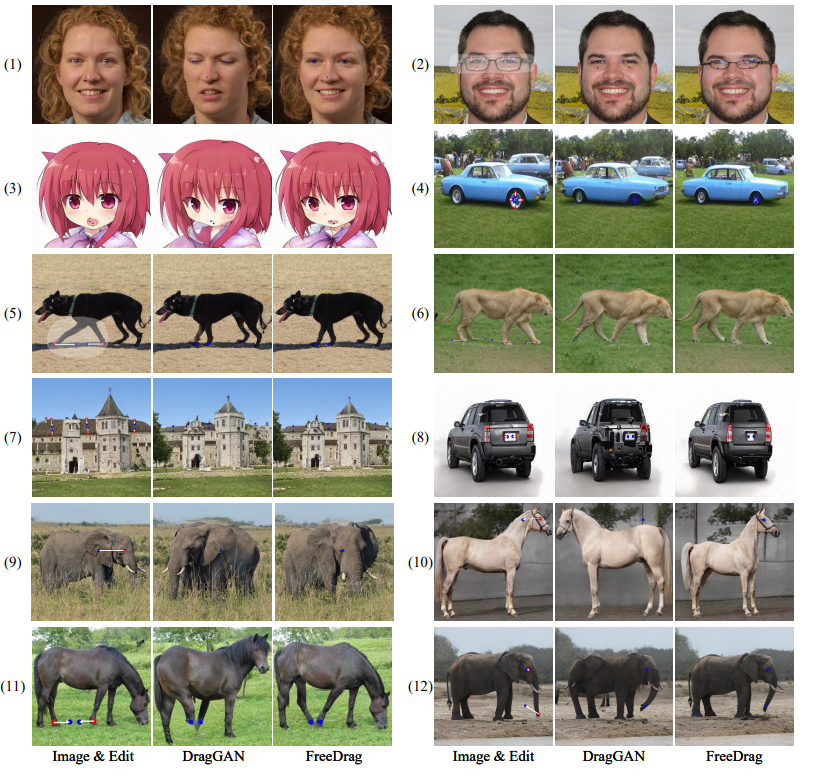

DragGAN 和 FreeDrag 在各類場景上的對比如下圖(圖4)所示,可以發現FreeDrag可以有效地防止handle point的異常消失(如圖4第一個例子中消失的嘴巴和第二個例子中消失的眼鏡),同時有力地避免了由于內容突變和相似點干擾導致的異常編輯,保障了點移動的可靠性(如圖4第三個例子中大象的眼睛和第四個例子中的馬腿)。此外,從圖4的(5)-(8)例子可以觀察到FreeDrag 可以通過穩定的點移動更有效更精確地實現預定的編輯目標。進一步的,在各類場景上的大量實驗(圖5) 充分驗證了FreeDrag 可以通過穩定的點移動實現更高的編輯質量,助力交互式的基于點的圖像編輯達到新的高度。

圖 4 DragGAN 和 FreeDrag 在各類場景上的對比圖

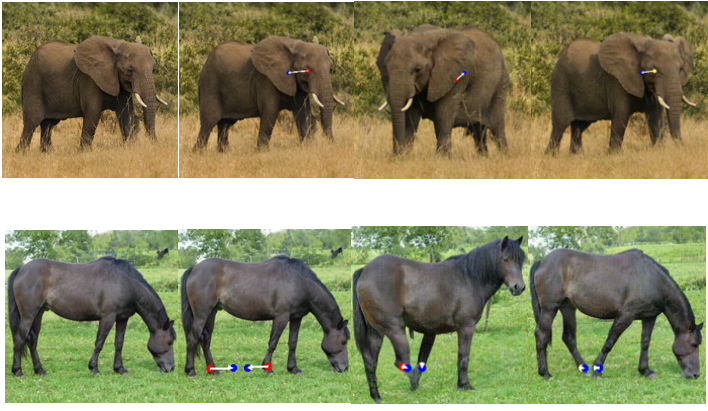

圖 5 DragGAN 和 FreeDrag 在更多場景下的對比圖

視頻對比如下:

左邊兩張圖分別為原始圖片和編輯目標(紅色為handle point, 藍色為target point)

右邊分別為為DragGAN 和FreeDrag的處理過程(gif)

對于拖動大象眼睛的例子,可以觀察到,DragGAN 在移動大象眼睛的過程中發生了圖像布局的突變造成點跟蹤丟失,點跟蹤丟失導致無法為之后的運動提供有效的運動監督,進而無法實現預定的編輯目的。相比而言,得益于動態更新的模板特征的平滑性,FreeDrag 可以更好地避免圖像內容的急劇變化,從而更可靠地將眼部特征拖向預定的位置。

對于拖動馬腿的例子,可以觀察到, DragGAN在移動馬腿過程中發生了錯誤的點跟蹤,從而為之后的運動監督提供了錯誤的優化方向,進而降低了圖像質量,這種錯誤會在多次迭代中累計導致編輯結果質量的急劇下降。相比而言, FreeDrag 的模糊定位和線性搜索策略有效地緩解了相似點的干擾,為點移動提供了可靠的監督信號,從而高質量地實現預定的編輯目的。

-

圖像

+關注

關注

2文章

1094瀏覽量

41199 -

代碼

+關注

關注

30文章

4899瀏覽量

70597 -

AIGC

+關注

關注

1文章

386瀏覽量

2419

原文標題:你的DragGAN并不需要點跟蹤!中科大和上海AI Lab提出FreeDrag:無需點跟蹤即可穩定拖動語義內容

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

AMD高管表示,我們的32核Threadripper處理器只需要風冷散熱即可,并不需要水冷機

《日本經濟新聞》報道:中科大為何能對中國AI領域產生很的影響?

在醫療AI領域砥礪前行的中科大學子

不需要點表的工業網關應用案例:如何提升工業企業生產效率與質量?

評論