1

可信執行環境是什么?

大語言模型為什么需要它?

OpenAI 的 GPT 系列大語言模型(Large Language Mode,以下縮寫為 LLM)的興起與應用,也帶來了諸如數據泄露、數據濫用、模型被攻擊和知識產權被竊取等一些列隱私和安全風險或挑戰。

可信執行環境(Trusted Execution Environment,以下縮寫為 TEE)是一項基于軟硬件組合創建安全執行環境,能夠更好地確保計算和數據處理機密性和完整性。其關鍵機制為:

-

安全隔離:通過硬件加密和內存隔離等硬件隔離技術,將敏感數據和關鍵代碼與其他應用及操作系統相隔離,從而確保它們即使在系統其他部分被攻擊或受到惡意軟件影響時也能夠得到更好的保護。

-

安全驗證:在啟動過程中進行身份驗證和完整性檢查,確保只有經過授權的代碼和數據可以在其中運行,以此防止惡意軟件或未經授權的訪問。

-

安全執行環境:提供包含加密算法、安全協議和密鑰管理等防護功能的執行環境,用于處理敏感數據和執行關鍵算法,以增強數據在執行過程中的保密性和完整性。

TEE 與 LLM 可在多行業、多場景融合,TEE 可用于為 LLM 提供頗具商業落地價值的隱私和數據保護創新解決方案。

2

LLM 與 TEE 的融合需求

LLM 在許多行業的不同場景都有著廣泛應用,例如金融行業的風險評估和交易分析,醫療保健領域的醫學圖像識別、病歷紀錄和疾病預測,以及法律和合規行業的法律咨詢、合同審查和文書處理等。這些行業或場景中涉及到的數據多為重要敏感的交易數據或個人數據,必須得到有效保護。將 TEE 與 LLM 融合,有助于在這類場景中更好地保障數據在 LLM 模型訓練和推理過程中的保密性。訓練階段,TEE 中的數據處理都處于加密狀態;推理階段,TEE 則可保護用戶輸入和模型結果的隱私。同時,其硬件隔離和安全驗證機制可以更有效地防止未經授權的訪問和攻擊,增強模型運行時的安全性。

3

TEE 與 LLM 融合的挑戰:

資源和性能限制

-

資源限制:TEE 的計算資源和存儲空間通常都非常有限,LLM 龐大的模型參數和計算需求可能會超出一般 TEE 的能力范圍。

-

性能下降:I/O 數據的加密和安全計算操作會引入額外的計算開銷,導致模型訓練和推理性能有一定程度下降。基于算法的解決方案可減少模型規模和計算需求,以適應 TEE 的資源限制,但 CPU 仍會成為制約 LLM 訓練的算力瓶頸。

4

基于英特爾 平臺的解決方案:

加速 TEE 與 LLM 融合應用

4.1 基于英特爾 SGX/TDX[1] 的 TEE 解決方案

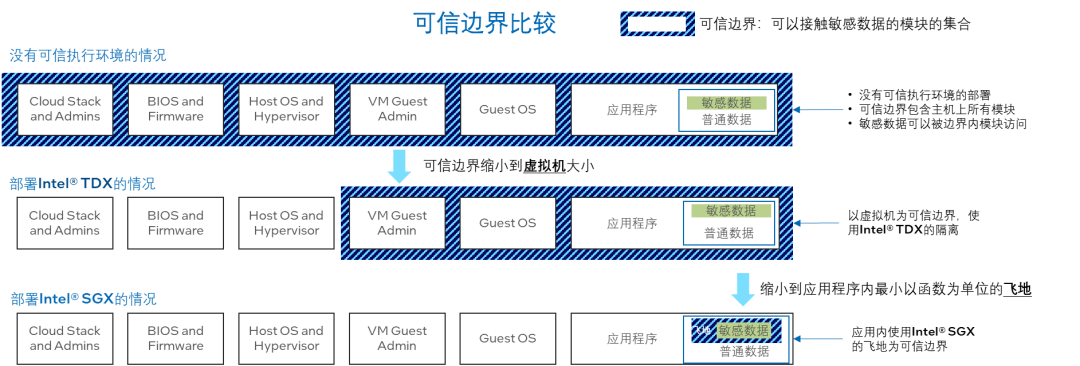

英特爾自第三代英特爾 至強可擴展處理器開始內置英特爾軟件防護擴展(英特爾SGX)技術,其安全飛地的容量最多可達單顆 CPU 512GB,雙路共計 1TB 容量,可滿足目前千億大模型的執行空間需求。此外,該技術提供支持的機密計算可實現應用層、虛擬機(VM)、容器和功能層的數據隔離。無論是在云端、邊緣還是本地環境,都能確保計算與數據始終在私密性和安全性上獲得更全面的保護,以免暴露給云服務提供商、未經授權的管理員和操作系統,甚至是特權應用。另一方面,英特爾Trust Domain Extension(英特爾 TDX)可將客戶機操作系統和虛擬機應用與云端主機、系統管理程序和平臺的其他虛擬機隔離開來。它的信任邊界較英特爾SGX 應用層的隔離邊界更大,使受其保護的機密虛擬機比基于英特爾SGX 的安全飛地的應用更易于進行大規模部署和管理,在部署 LLM 這類復雜應用時,TDX 在易用性上更具優勢。此外,今年推出的全新第四代英特爾 至強可擴展處理器內置英特爾 AMX,可大幅提升矩陣運算性能,而英特爾 SGX/TDX也可為英特爾AMX、英特爾 DL Boost等計算指令提供支持,進而為 TEE 中的大模型賦予快速落地+優化性能的雙重優勢。

圖 1.SGX/TDX 的可信邊界

構建完善的 TEE 生態系統對推動 LLM 的應用和發展至關重要。開發者需要能夠簡化集成和使用過程的面向 TEE 的開發者工具和框架。為此,英特爾在 SDK 的基礎上,推出了開源的 lib OS 項目 Gramine 來幫助開發者更好地使用基于英特爾 SGX的 TEE,助推 LLM 與 TEE 的融合。

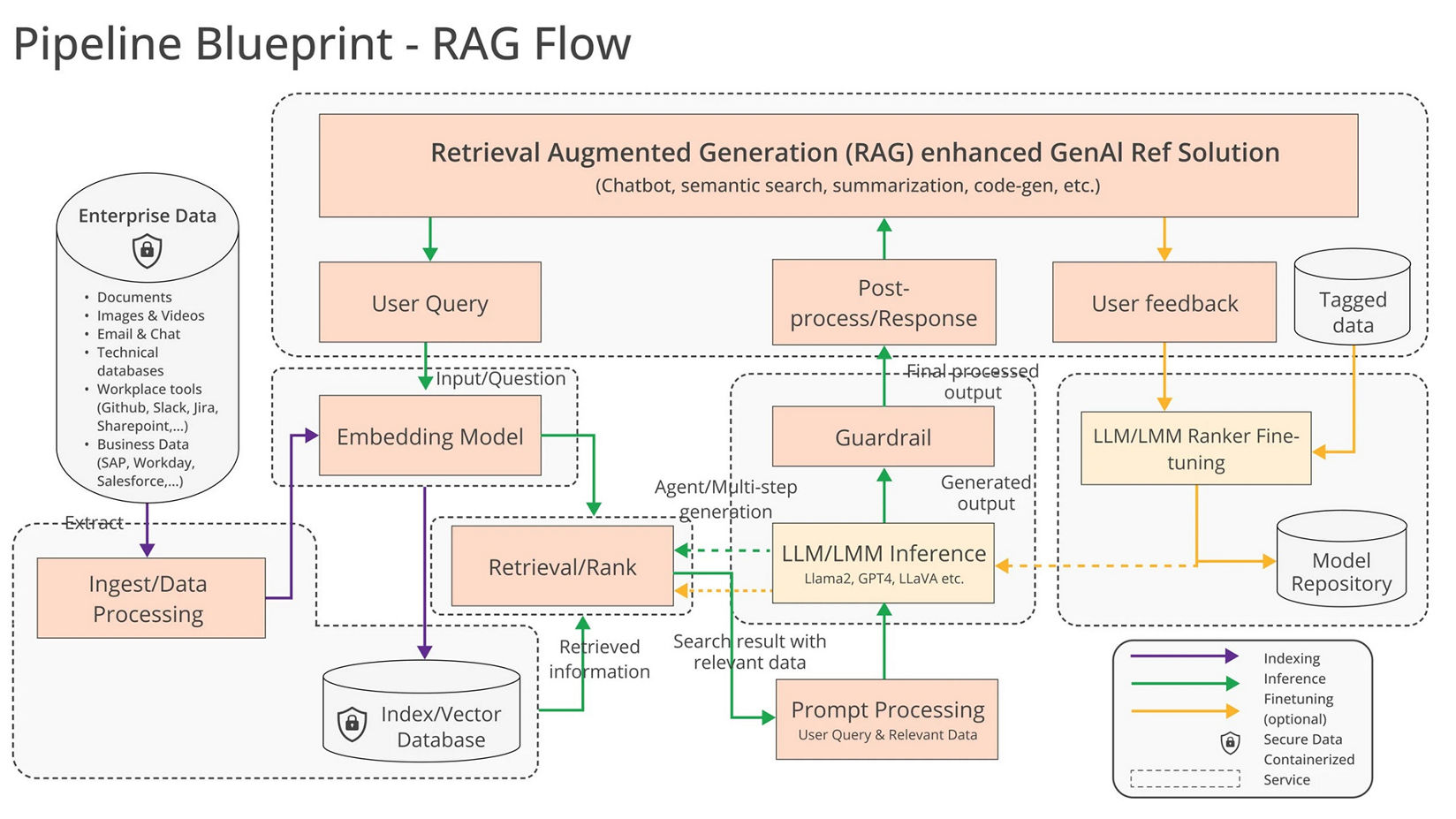

4.1.1 大語言模型推理

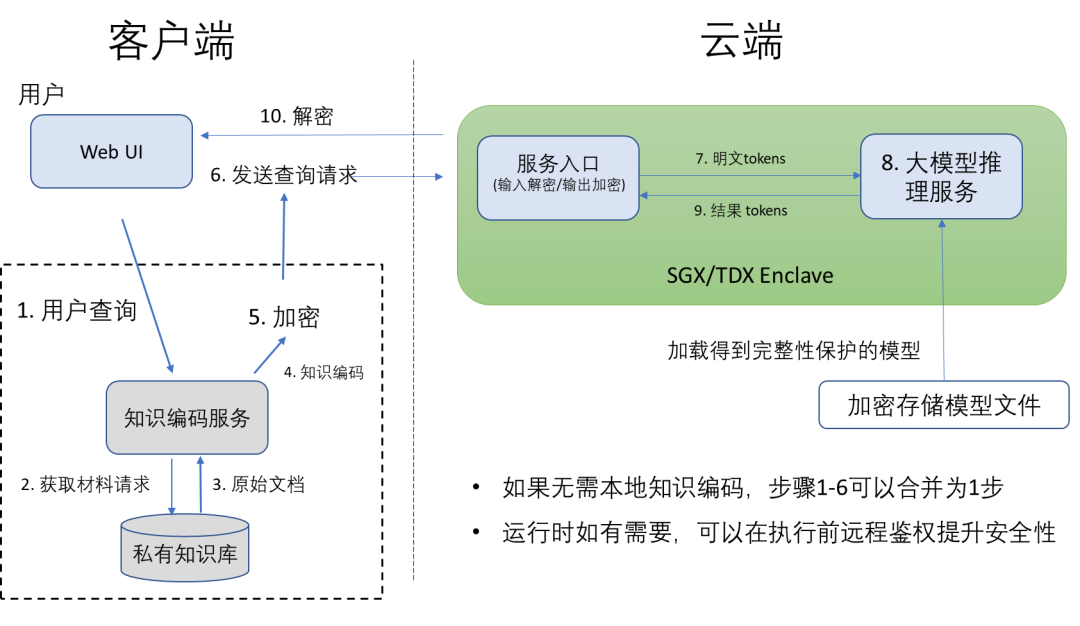

使用私有數據進行個性化訓練的大模型不僅包含私有數據信息,其查詢本身也具有隱私性,尤其是基于邊端的非安全環境部署。基于英特爾SGX/TDX 的 TEE 可為大模型提供更安全的運行環境,在數據上傳云端前,查詢可先通過客戶端對傳輸內容加密,云端只需在英特爾 SGX/TDX 中解密查詢問題,然后輸入大模型的推理服務中,并將所得結果在云端的 TEE 中加密后傳輸回本地客戶端。在整個工作流程中,客戶端以外的數據和運行態程序均處于密態環境當中,效率遠遠高于其他基于純密碼學的解決方案。目前像 LLAMA 7B、ChatGLM 6B 等模型都可以在該 TEE 方案上滿足實時可交互性能的運行。圖 2 展示了使用 LLM 部署知識問答的參考設計。基于英特爾SGX/TDX 的 TEE 為實際部署 LLM 中的自有知識產權保護提供了一套完整的方案,優化整個模型在查詢、傳輸和推理過程中的安全保護。

圖 2. 基于 TEE 的大語言模型私密問答

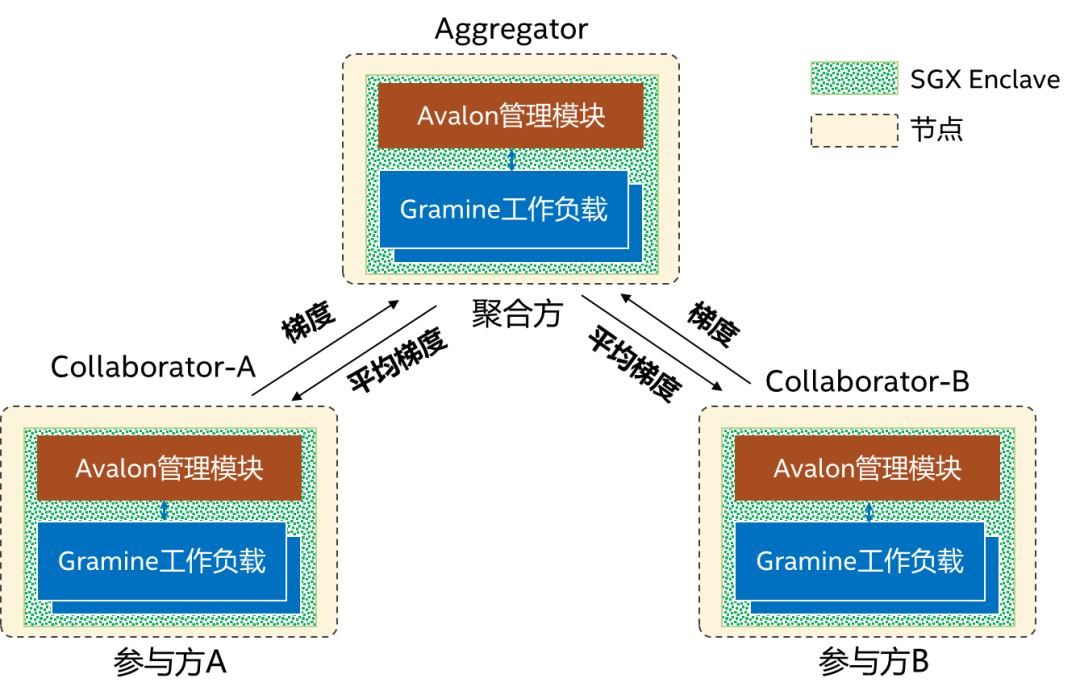

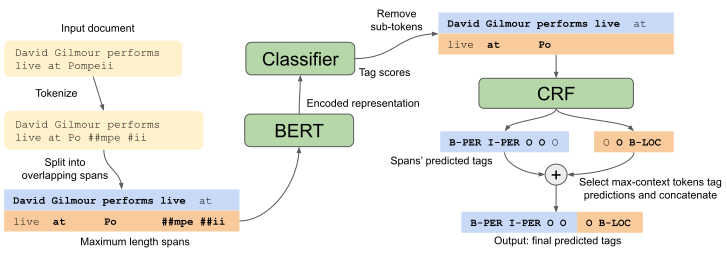

4.1.2 聯邦學習借助基于TEE的聯邦學習解決方案[2](見圖 3),就可在多機構之間實現基于 NLP 的深度學習例如使用 BERT 的命名體識別。在金融和醫療等行業提升準確性,實現多機構數據互通,同時更好避免數據泄露。此方案中每個參與方包含一個Avalon[3]管理模塊和 Gramine 工作負載,均運行在英特爾SGX 的安全飛地中,在管理模塊彼此間的遠程認證完成執行后,即可啟動聯邦學習過程,參與方在本地使用各自的數據集進行訓練,然后將梯度上傳至聚合方,聚合方進行聚合后將平均梯度下發至各參與方,以繼續進行下一輪訓練。對比圖 4 所示的 BERT + CRF 模型[4],此方案可以在強化隱私保護的同時,讓性能損失維持在 50% 以下[2]。

圖 3.基于 TEE的聯邦學習

圖 4.BERT+CRF模型[4]

4.2 BigDL:端到端大模型和 TEE 融合的方案

據行業用戶反饋,LLM 在端到端應用中的痛點包括:

-

軟件棧復雜,難以確保端到端應用的安全。LLM 的訓練和推理常依賴較多的軟件棧、服務和硬件。為保護用戶數據和模型產權,需確保每個環節的安全性(不同硬件、運行環境、網絡和存儲等)。

-

計算量大,且對性能敏感。LLM 的計算量非常大,需引入足夠多的性能優化。但是,不同模型、平臺和軟件棧需要使用不同的優化方案,要在特定平臺上實現更理想的性能,需要長時間的性能調優。

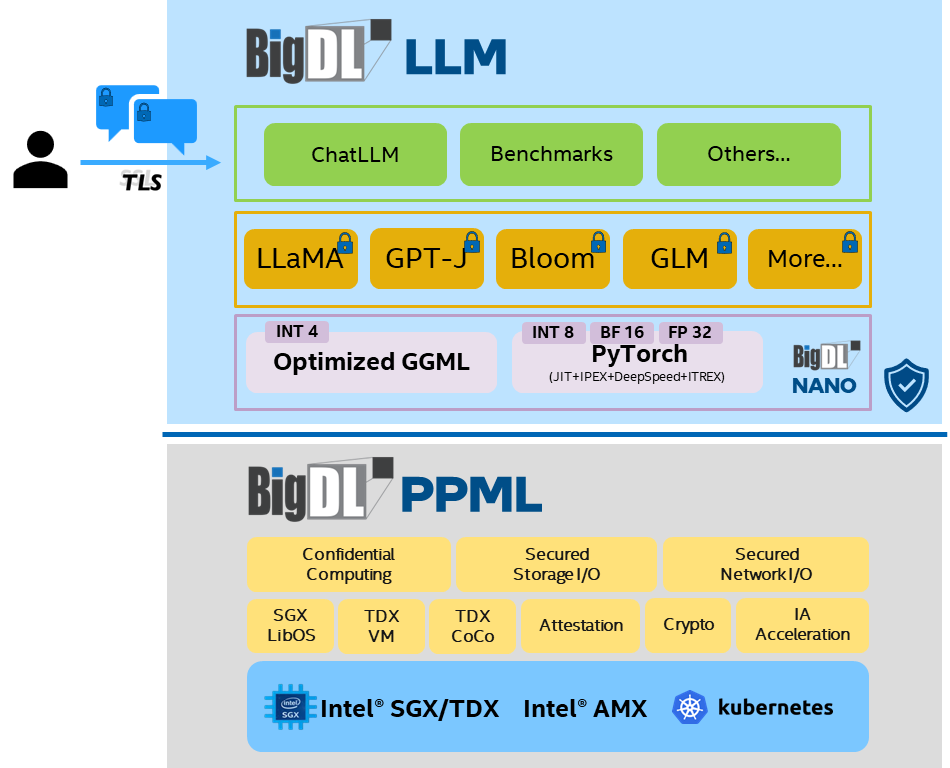

為解決這些痛點,由英特爾主導的開源項目 BigDL,近期就推出了針對 LLM 的隱私保護方案,其兩大主要功能為:

-

提供端到端的安全保護:在不修改代碼的情況下,為單機和分布式的 LLM 應用提供端到端的安全保護功能。具體包括,基于英特爾 SGX/TDX 的 TEE、遠程證明、統一的密鑰管理接口和透明的加解密 API 等。

-

實現一站式性能優化:BigDL Nano 提供的針對 LLM 的一站式性能優化方案,可讓現有 LLM 應用在幾乎不用修改代碼的情況下受益于英特爾 AMX、英特爾 AVX-512 和英特爾 Extension for PyTorch。同時,用戶還可利用 BigDL Nano 提供的 LLM API,快速構建應用。

圖 5.BigDL端到端安全的大模型方案

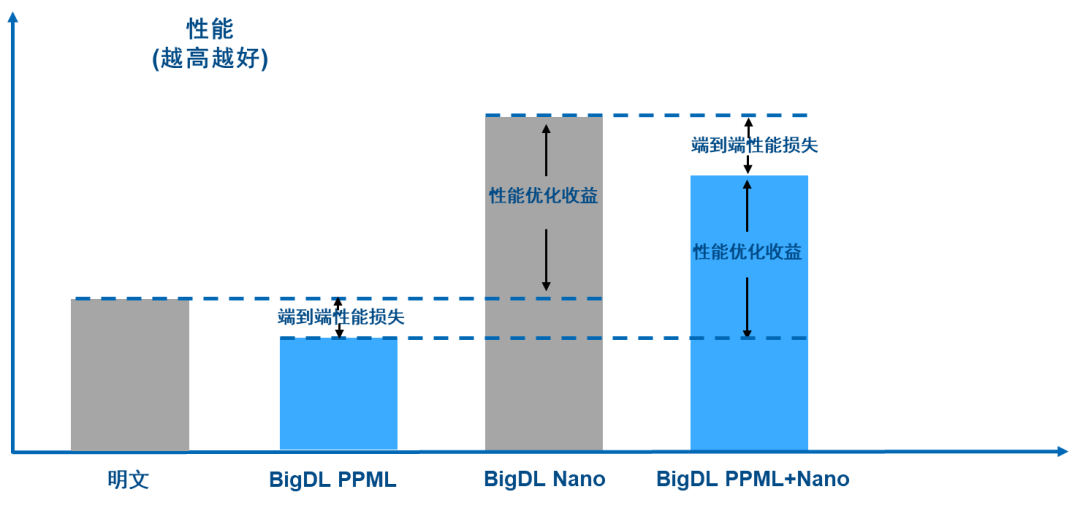

如圖 6 所示,在應用了 PPML(Privacy Preserving Machine Learning,隱私保護的機器學習)提供的安全技術后,由于更強的安全和隱私保護會帶來額外開銷,因此端到端應用性能會略有下降;但應用了 BigDL Nano 提供的優化功能后,端到端的性能得到了顯著改善*,總體性能甚至高于沒有任何保護的明文性能。

圖 6.BigDL PPML + Nano 端到端性能損失情況

目前,該方案已經開源,并開始陸續交付給行業客戶進行測試和集成[5]。

5

未來趨勢

TEE 提供了隱私保護和數據安全防護功能的創新解決方案,將在 LLM 實際落地過程中扮演重要角色。通過將二者融合,可更好地保障數據在訓練和推理過程中的保密性,增強對未經授權訪問和模型結果篡改的防御。然而,在 TEE 中保護用戶隱私的同時,需要平衡性能需求,隨著大模型對于計算需求的大幅提升,算力可能會執行在異構硬件上,TEE 和異構硬件的結合將成為未來發展趨勢。隨著 CPU 性能的提升以及內置 AI 加速技術的升級和更新,在方便部署的場景下,CPU 會是大模型推理和 TEE 結合的首選,在訓練的場景下,基于 CPU 的 TEE 結合異構硬件的加密支持,則會是大模型訓練甚至大模型聯邦訓練的技術方向。英特爾將一如既往地以軟硬結合的產品技術組合促進開發者參與,推動 LLM 與 TEE 的融合。 作者 都在從事 AI 和 SGX/TDX 相關工作 俞巍:英特爾公司 AI 架構師 李志強:英特爾公司平臺安全資深架構師 李青青:英特爾公司安全軟件研發工程師 龔奇源:英特爾公司軟件架構師

資料援引:[1]SGX/TDX:https://www.intel.cn/content/www/cn/zh/customer-spotlight/cases/innovation-data-protection-with-security-engines.html

[2]Wei Yu. et al. 2022, TEE based Cross-silo Trustworthy Federated Learning Infrastructure, FL-IJCAI'22

[3]https://github.com/hyperledger-archives/avalon

[4]Souza, F., Nogueira, R. and Lotufo, R. 2020, Portuguese Named Entity Recognition using Bert-CRF, arXiv.org

(請參見 https://arxiv.org/pdf/1909.10649.pdf)

[5]https://github.com/intel-analytics/BigDL/tree/main/python/llm

*性能優化效果與具體平臺、模型和環境有關

-

英特爾

+關注

關注

61文章

9949瀏覽量

171695 -

cpu

+關注

關注

68文章

10855瀏覽量

211590

原文標題:用基于英特爾? SGX 的可信執行環境有效應對大語言模型隱私和安全挑戰

文章出處:【微信號:英特爾中國,微信公眾號:英特爾中國】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

英特爾換帥 英特爾CEO Pat Gelsinger(帕特·基辛格)正式退休

HPM6750evkmini如何實現可信的執行環境?

英特爾醞釀出售Mobileye股權以應對挑戰

英特爾IT的發展現狀和創新動向

從運動員到開發者: 英特爾以開放式AI系統應對多重挑戰

英特爾CEO:AI時代英特爾動力不減

已有超過500款AI模型在英特爾酷睿Ultra處理器上得以優化運行

AlmaLinux 9.4兼容棄用的RHEL硬件,包括英特爾Data Streaming設備

英特爾AI產品助力其運行Meta新一代大語言模型Meta Llama 3

浪潮信息與英特爾合作推出一種大模型效率工具“YuanChat”

英特爾推AI增效車用芯片,與極氪汽車達成合作

英特爾的2023:以強大執行力推進產品、技術創新

用基于英特爾? SGX 的可信執行環境有效應對大語言模型隱私和安全挑戰

用基于英特爾? SGX 的可信執行環境有效應對大語言模型隱私和安全挑戰

評論