英特爾廣泛的AI硬件組合及開放的軟件環境,為Meta發布的Llama 2模型提供了極具競爭力的選擇,進一步助力大語言模型的普及,推動AI發展惠及各行各業。

大語言模型(LLM)在生成文本、總結和翻譯內容、回答問題、參與對話以及執行復雜任務(如解決數學問題或推理)方面表現出的卓越能力,使其成為最有希望規模化造福社會的AI技術之一。大語言模型有望解鎖更豐富的創意和洞察,并激發AI社區推進技術發展的熱情。

Llama 2旨在幫助開發者、研究人員和組織構建基于生成式AI的工具和體驗。Meta發布了多個Llama 2的預訓練和微調版本,擁有70億、130億和700億三種參數。通過Llama 2,Meta在公司的各個微調模型中采用了三項以安全為導向的核心技術:安全的有監督微調、安全的目標文本提取以及安全的人類反饋強化學習(RLHF)。這些技術相結合,使Meta得以提高安全性能。隨著越來越廣泛的使用,人們將能夠以透明、公開的方式不斷識別并降低生成有害內容的風險。

英特爾致力于通過提供廣泛的硬件選擇和開放的軟件環境,推動AI的發展與普及。英特爾提供了一系列AI解決方案,為AI社區開發和運行Llama 2等模型提供了極具競爭力和極具吸引力的選擇。英特爾豐富的AI硬件產品組合與優化開放的軟件相結合,為應對算力挑戰提供了可行的方案。

“

英特爾提供了滿足模型的開發和部署的AI優化軟件。開放生態系統是英特爾得天獨厚的戰略優勢,在AI領域亦是如此。我們致力于培育一個充滿活力的開放生態系統來推動AI創新,其安全、可追溯、負責任以及遵循道德,這對整個行業至關重要。此次發布的大模型進一步彰顯了我們的核心價值觀——開放,為開發人員提供了一個值得信賴的選擇。Llama 2模型的發布是我們行業向開放式AI發展轉型邁出的重要一步,即以公開透明的方式推動創新并助力其蓬勃發展。

--李煒

英特爾軟件與先進技術副總裁

兼人工智能和分析部門總經理

-- Melissa Evers

英特爾軟件與先進技術副總裁

兼執行戰略部總經理

”

在Llama 2發布之際,我們很高興地分享70億和130億參數模型的初始推理性能測試結果。這些模型在英特爾AI產品組合上運行,包括HabanaGaudi2 深度學習加速器、第四代英特爾至強可擴展處理器、英特爾至強CPU Max系列和英特爾數據中心GPU Max系列。我們在本文中分享的性能指標是我們當前軟件提供的“開箱即用”的性能,并有望在未來的軟件中進一步提升。我們還支持700億參數模型,并將很快分享最新相關信息。

HabanaGaudi2 深度學習加速器

Habana Gaudi2旨在為用戶提供高性能、高能效的訓練與推理,尤其適用于諸如Llama和Llama 2的大語言模型。Gaudi2加速器具備96GB HBM2E的內存容量,可滿足大語言模型的內存需求并提高推理性能。Gaudi2配備HabanaSynapseAI軟件套件,該套件集成了對PyTorch和DeepSpeed的支持,以用于大語言模型的訓練和推理。此外,SynapseAI近期開始支持HPU Graphs和DeepSpeed推理,專門針對時延敏感度高的推理應用。Gaudi2還將進行進一步的軟件優化,包括計劃在2023年第三季度支持FP8數據類型。此優化預計將在執行大語言模型時大幅提高性能、吞吐量,并有效降低延遲。

大語言模型的性能需要靈活敏捷的可擴展性,來突破服務器內以及跨節點間的網絡瓶頸。每張Gaudi2芯片集成了21個100Gbps以太網接口,21個接口專用于連接服務器內的8顆Gaudi2,該網絡配置有助于提升服務器內外的擴展性能。

在近期發布的MLPerf基準測試中,Gaudi2在大語言模型上展現了出色的訓練性能,包括在384個Gaudi2加速器上訓練1750億參數的GPT-3模型所展現的結果。Gaudi2經過驗證的高性能使其成為Llama和Llama 2模型訓練和推理的高能效解決方案。

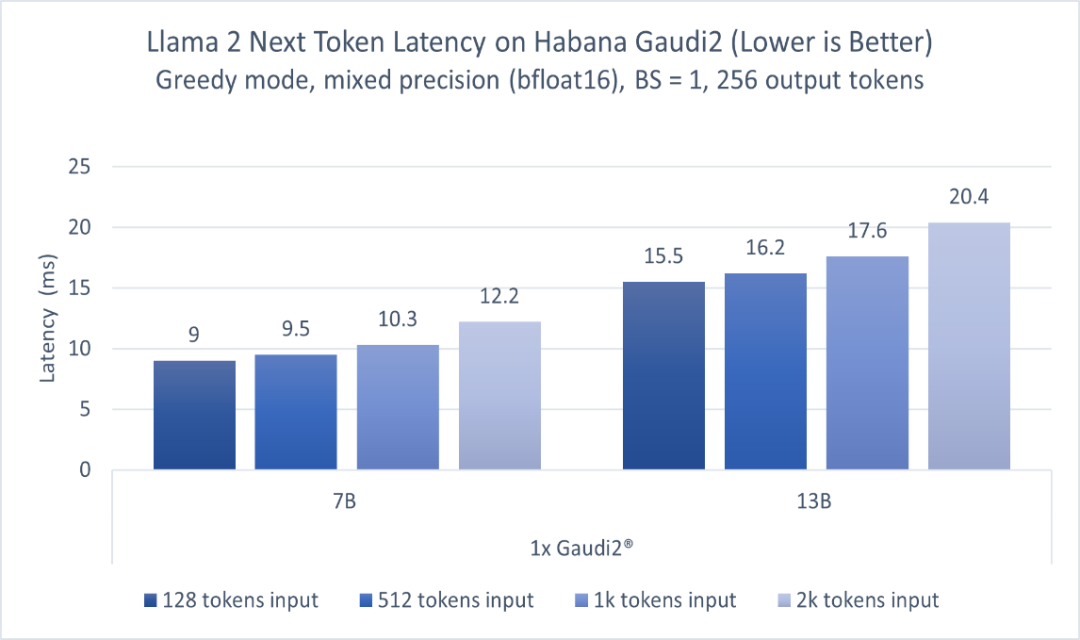

圖1顯示了70億參數和130億參數Llama 2模型的推理性能。模型分別在一臺Habana Gaudi2設備上運行,batch size=1,輸出token長度256,輸入token長度不定,使用BF16精度。報告的性能指標為每個token的延遲(不含第一個)。該測試使用optimum-habana文本生成腳本在Llama模型上運行推理。optimum-habana庫能夠幫助簡化在Gaudi加速器上部署此類模型的流程,僅需極少的代碼更改即可實現。如圖1所示,對于128至2000輸入token,在70億參數模型上Gaudi2的推理延遲范圍為每token 9.0-12.2毫秒,而對于130億參數模型,范圍為每token 15.5-20.4毫秒1。

圖1基于Habana Gaudi2,70億和130億參數Llama 2模型的推理性能

若想訪問Gaudi2,可按照此處(https://developer.habana.ai/intel-developer-cloud/)在英特爾開發者云平臺上注冊一個實例,或聯系超微(Supermicro)了解Gaudi2服務器基礎設施。

英特爾至強可擴展處理器

第四代英特爾至強可擴展處理器是一款通用計算處理器,具有英特爾高級矩陣擴展(英特爾AMX)的AI加速功能。具體而言,該處理器的每個核心內置了BF16和INT8通用矩陣乘(GEMM)加速器,以加速深度學習訓練和推理工作負載。此外,英特爾至強CPU Max系列,每顆CPU提供64GB的高帶寬內存(HBM2E),兩顆共128GB,由于大語言模型的工作負載通常受到內存帶寬的限制,因此,該性能對于大模型來說極為重要。

目前,針對英特爾至強處理器的軟件優化已升級到深度學習框架中,并可用于PyTorch*、TensorFlow*、DeepSpeed*和其它AI庫的默認發行版。英特爾主導了torch.compile CPU后端的開發和優化,這是PyTorch 2.0的旗艦功能。與此同時,英特爾還提供英特爾PyTorch擴展包*(IntelExtension for PyTorch*),旨在PyTorch官方發行版之前,盡早、及時地為客戶提供英特爾CPU的優化。

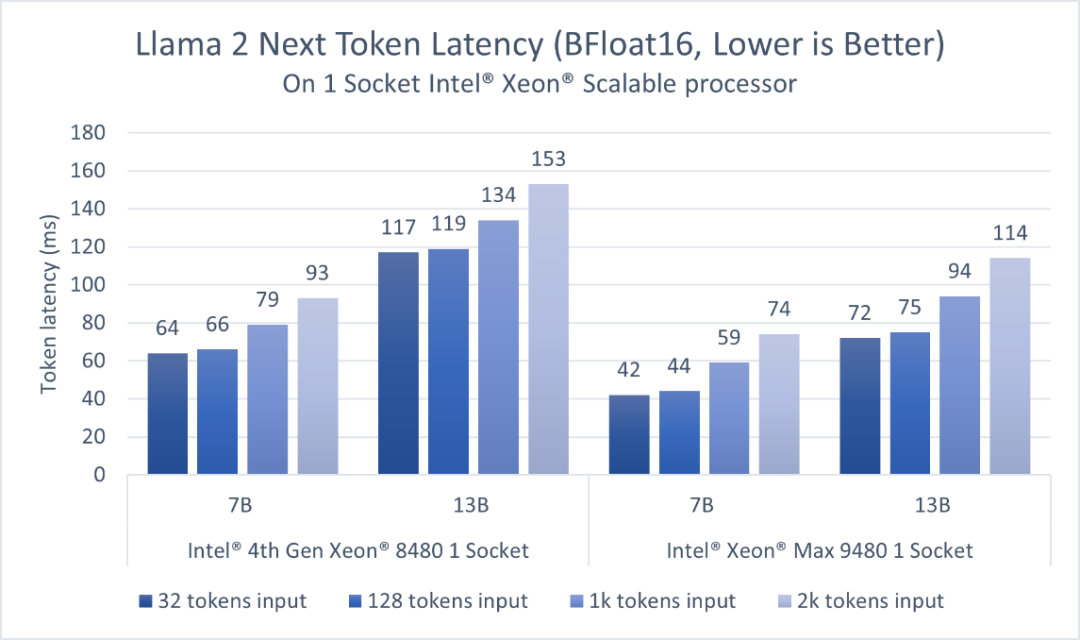

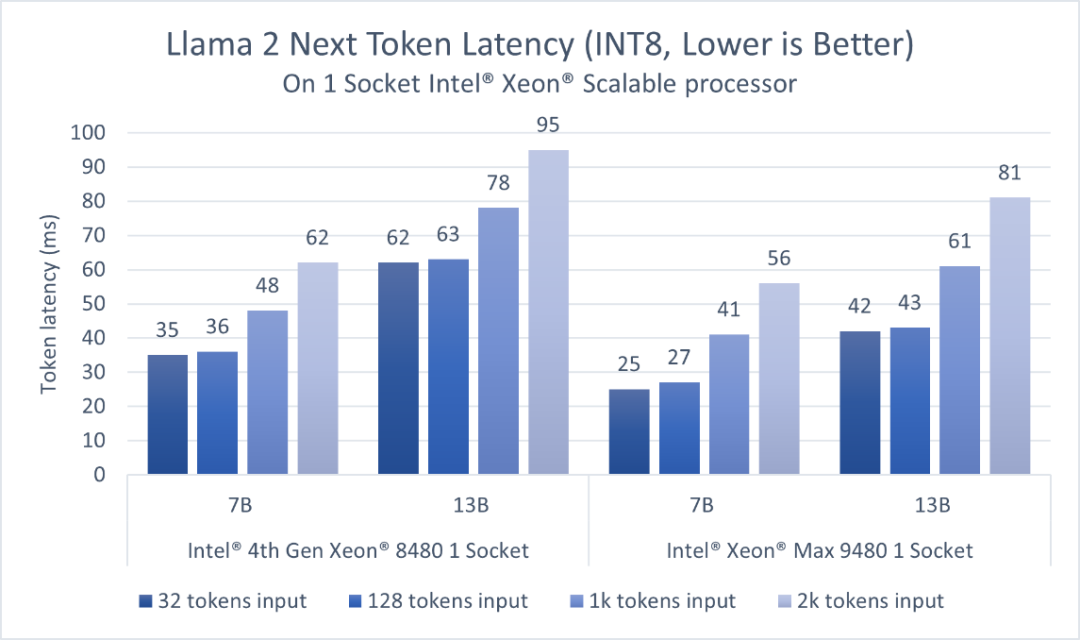

第四代英特爾至強可擴展處理器擁有更高的內存容量,支持在單個插槽內實現適用于對話式AI和文本摘要應用的、低延遲的大語言模型執行。對于BF16和INT8,該結果展示了單個插槽內執行1個模型時的延遲。英特爾PyTorch擴展包*支持SmoothQuant,以確保INT8精度模型具有良好的準確度。

考慮到大語言模型應用需要以足夠快的速度生成token,以滿足讀者較快的閱讀速度,我們選擇token延遲,即生成每個token所需的時間作為主要的性能指標,并以快速人類讀者的閱讀速度(約為每個token 100毫秒)作為參考。如圖2、3所示,對于70億參數的Llama2 BF16模型和130億參數的Llama 2 INT8模型,第四代英特爾至強單插槽的延遲均低于100毫秒2。

得益于更高的HBM2E帶寬,英特爾至強CPU Max系列為以上兩個模型提供了更低的延遲。而憑借英特爾AMX加速器,用戶可以通過更高的批量尺寸(batch size)來提高吞吐量。

圖2 基于英特爾至強可擴展處理器,70億參數和130億參數Llama 2模型(BFloat16)的推理性能

圖3 基于英特爾至強可擴展處理器,70億參數和130億參數Llama 2模型(INT8)的推理性能

對于70億和130億參數的模型,每個第四代至強插槽可提供低于100毫秒的延遲。用戶可以分別在兩個插槽上同時運行兩個并行實例,從而獲得更高的吞吐量,并獨立地服務客戶端。亦或者,用戶可以通過英特爾PyTorch擴展包*和DeepSpeed* CPU,使用張量并行的方式在兩個第四代至強插槽上運行推理,從而進一步降低延遲或支持更大的模型。

關于在至強平臺上運行大語言模型和Llama 2,開發者可以點擊此處(https://intel.github.io/intel-extension-for-pytorch/llm/cpu/)了解更多詳細信息。第四代英特爾至強可擴展處理器的云實例可在AWS和Microsoft Azure上預覽,目前已在谷歌云平臺和阿里云全面上線。英特爾將持續在PyTorch*和DeepSpeed*進行軟件優化,以進一步加速Llama 2和其它大語言模型。

英特爾數據中心GPU Max系列

英特爾數據中心GPU Max系列提供并行計算、科學計算和適用于科學計算的AI加速。作為英特爾性能最為出色、密度最高的獨立顯卡,英特爾數據中心GPU Max系列產品中封裝超過1000億個晶體管,并包含多達128個Xe內核,Xe是英特爾GPU的計算構建模塊。

英特爾數據中心GPU Max系列旨在為AI和科學計算中使用的數據密集型計算模型提供突破性的性能,包括:

●408 MB基于獨立SRAM技術的L2緩存、64MB L1緩存以及高達128GB的高帶寬內存(HBM2E)。

●AI增強型的Xe英特爾矩陣擴展(英特爾XMX)搭載脈動陣列,在單臺設備中可實現矢量和矩陣功能。

英特爾Max系列產品統一支持oneAPI,并基于此實現通用、開放、基于標準的編程模型,釋放生產力和性能。英特爾oneAPI工具包括高級編譯器、庫、分析工具和代碼遷移工具,可使用SYCL輕松將CUDA代碼遷移到開放的C++。

英特爾數據中心Max系列GPU通過當今框架的開源擴展來實現軟件支持和優化,例如面向PyTorch*的英特爾擴展、面向TensorFlow*的英特爾擴展和面向DeepSpeed*的英特爾擴展。通過將這些擴展與上游框架版本一起使用,用戶將能夠在機器學習工作流中實現快速整合。

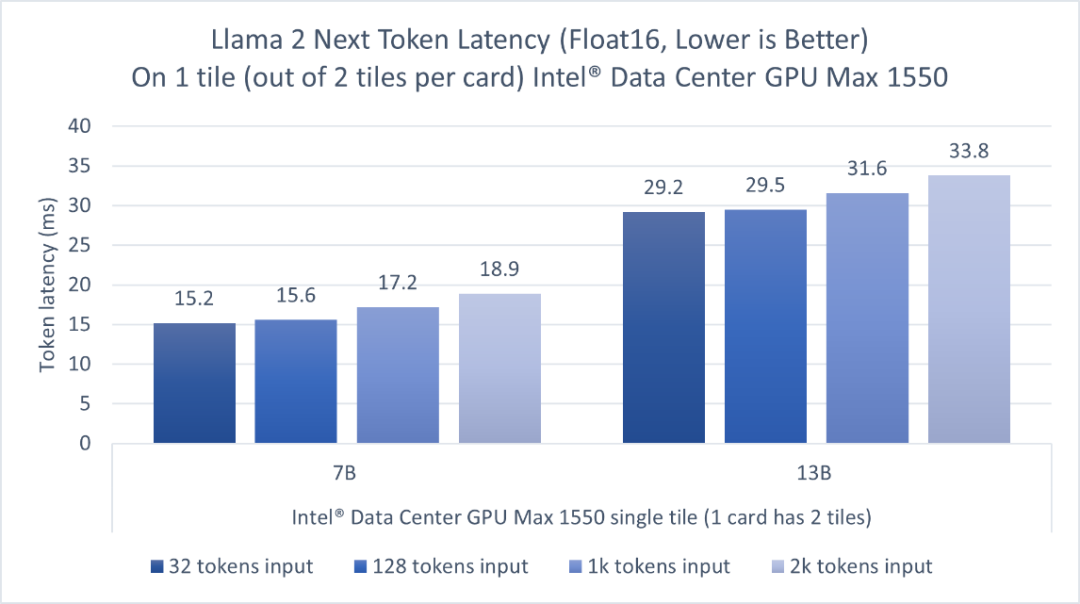

我們在一個600瓦OAM形態的GPU上評估了Llama 2的70億參數模型和Llama 2的130億參數模型推理性能,這個GPU上封裝了兩個tile,而我們只使用其中一個tile來運行推理。圖4顯示,對于輸入長度為32到2000的token,英特爾數據中心GPU Max系列的一個tile可以為70億參數模型的推理提供低于20毫秒的單token延遲,130億參數模型的單token延遲為29.2-33.8毫秒3。因為該GPU上封裝了兩個tile,用戶可以同時并行運行兩個獨立的實例,每個tile上運行一個,以獲得更高的吞吐量并獨立地服務客戶端。

圖4英特爾數據中心GPUMax1550上的Llama2的70億和130億參數模型的推理性能

關于在英特爾GPU平臺上運行大語言模型和Llama 2,可以點擊此處(https://intel.github.io/intel-extension-for-pytorch/llm/xpu/)獲取詳細信息。目前英特爾開發者云平臺上已發布英特爾GPU Max云實例測試版。

英特爾平臺上的大語言模型微調

除了推理之外,英特爾一直在積極地推進微調加速,通過向Hugging Face Transformers、PEFT、Accelerate和Optimum庫提供優化,并在面向Transformers的英特爾擴展中提供參考工作流。這些工作流支持在相關英特爾平臺上高效地部署典型的大語言模型任務,如文本生成、代碼生成、完成和摘要。

總結

上述內容介紹了在英特爾AI硬件產品組合上運行Llama 2的70億和130億參數模型推理性能的初始評估,包括Habana Gaudi2深度學習加速器、第四代英特爾至強可擴展處理器、英特爾至強CPU Max系列和英特爾數據中心GPU Max系列。我們將繼續通過軟件發布提供優化,后續會再分享更多關于大語言模型和更大的Llama 2模型的評估。

Intel / intel-extension-for-pytorch:一個用于擴展官方PyTorch的PyTorch軟件包,可以輕松地獲取英特爾平臺的性能(github.com)

使用英特爾神經壓縮器進行模型壓縮:huggingface/optimum-habana:在Habana Gaudi處理器(HPU)上輕松地極速訓練Transformers(github.com)

面向英特爾數據中心GPU Max系列的開發工具

Meta Llama2論文:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

Meta Llama2博客:https://ai.meta.com/llama/

產品和性能信息

1HabanaGaudi2深度學習加速器:所有測量使用了一臺HLS2 Gaudi2服務器上的Habana SynapseAI 1.10版和optimum-habana 1.6版,該服務器具有八個Habana Gaudi2 HL-225H Mezzanine卡和兩個英特爾至強白金8380 CPU@2.30GHz以及1TB系統內存。2023年7月進行測量。

2第四代英特爾至強可擴展處理器

·第四代英特爾至強8480:第四代英特爾至強白金8480+2插槽系統,112核/224線程,啟用睿頻,啟用超線程,內存:16x32GB DDR5 4800MT/s,存儲:953.9GB;操作系統:CentOS Stream 8;內核:5.15.0-spr.bkc.pc.16.4.24.x86_64;批處理大小:1;在1個插槽上測量:1;PyTorch nightly build0711;IntelExtensions for PyTorch* tag v2.1.0.dev+cpu.llm;模型:Llama 2 70億和Llama 2 130億參數;數據集LAMBADA;令牌長度:32/128/1024/2016(in),32(out);Beam Width 4;精度:BF16和INT8;英特爾在2023年7月12日測試。

·英特爾至強Max 9480:英特爾至強Max 9480 2插槽系統,112核/224線程,啟用睿頻,啟用超線程,內存:16x64GB DDR5 4800MT/s;8x16GB HBM2 3200 MT/s,存儲:1.8TB;操作系統:CentOS Stream 8;內核:5.19.0-0812.intel_next.1.x86_64+server;批處理大小:1;在1個插槽上測量;PyTorch nightly build0711;IntelExtensions for PyTorch* llm_feature_branch;模型:Llama 2 70億和Llama 2 130億參數,數據集LAMBADA;令牌長度:32/128/1024/2016(in),32(out);Beam Width 4;精度:BF16和INT8;英特爾在2023年7月12日測試。

3英特爾數據中心GPU Max系列:1節點,2個英特爾至強白金8480+,56核,啟用超線程,啟用睿頻,NUMA 2,總內存1024GB(16x64GB DDR5 4800 MT/s [4800 MT/s]),BIOS:SE5C7411.86B.9525.D19.2303151347,微代碼0x2b0001b0,1個用于10GBASE-T的以太網控制器X710,1個1.8T WDC WDS200T2B0B,1個931.5G英特爾SSDPELKX010T8,Ubuntu 22.04.2 LTS,5.15.0-76-generic,4個英特爾數據中心GPU Max 1550(僅使用單個OAM GPU卡的一個區塊測量),IFWI PVC 2_1.23166,agama驅動程序:agama-ci-devel-627.7,英特爾oneAPI基礎工具包2023.1,PyTorch* 2.0.1 + IntelExtension for PyTorch* v2.0.110+xpu(dev/LLM分支),AMC固件版本:6.5.0.0,模型:Meta AI Llama 2 70億和Llama 2 130億參數,數據集LAMBADA;令牌長度:32/128/1024/2016(in),32(out);Greedy搜索;精度FP16;英特爾在2023年7月7日測試。

4性能因用途、配置和其它因素而異。更多信息請見www.Intel.com/PerformanceIndex。

-

英特爾

+關注

關注

61文章

9949瀏覽量

171693 -

cpu

+關注

關注

68文章

10854瀏覽量

211584

原文標題:英特爾通過軟硬件為LIama 2大模型提供加速,持續發力推動AI發展

文章出處:【微信號:英特爾中國,微信公眾號:英特爾中國】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

英特爾攜手百度智能云加速AI落地

英特爾軟硬件構建模塊如何幫助優化RAG應用

英特爾CEO:AI時代英特爾動力不減

Intel Vision 2024大會: 英特爾發布全新軟硬件平臺,全速助力企業推進AI創新

英特爾通過軟硬件為LIama 2大模型提供加速,持續發力推動AI發展

英特爾通過軟硬件為LIama 2大模型提供加速,持續發力推動AI發展

評論