今年三月,OpenAI 重磅發布了 GPT-4 大模型,帶來了比 ChatGPT 背后 GPT-3.5 更強的推理、計算、邏輯能力,也引發了全民使用的熱潮。在各行各領域研究人員、開發者、設計師的使用過程中,「GPT-4 是最為領先的大模型」似乎已成為了公認的結果。

然而,8 月 7 日,畢業于美國麻省理工學院、現任 Dyania Health CTO的Konstantine Arkoudas 最新撰寫了一篇標題為《GPT-4 Can't Reason》(GPT-4 不能推理)的預印本(指尚未在需要同行評審的科學期刊上出版的科學文獻的草稿)論文,在業界引起軒然大波。

該論文指出,GPT-4 與 GPT 3.5 相比有了全面的實質性改進。然而,盡管確實取得了令人印象深刻的改進,但其有充分的理由對 GPT-4 的推理能力表示高度懷疑。這篇論文討論了推理的本質,批評當前 NLP 界對推理問題的表述以及目前評估 LLM 推理表現的方式,同時分享了基于 GPT-4 給出的 21 個不同推理問題的集合。

最終得出結論:盡管GPT-4偶爾會閃現出分析的才華,但它目前是完全無法推理的。

一語掀起千層浪,難道此前 GPT-4 在短短幾分鐘之內生成一款游戲代碼,難道都不算是推理嗎?

什么是推理?

其實在今年一月初,論文作者 Konstantine Arkoudas 就在 Medium 平臺上分享了一篇有關 ChatGPT 的非正式評估,評估涉及的學科非常廣泛,包括傳統 NLU、民間物理、信息檢索、心理理論、空間推理、簡單邏輯推理和數學。

當時其得到的主要結論是:ChatGPT 是一項開創性的突破;基于 LLM 的系統并不只是“隨機鸚鵡”,而是建立了真正的抽象,并能展現創造力;這類系統將帶來大量令人興奮的新應用;盡管取得了上述的成就,但這些系統在推理能力上仍然受到嚴重限制。

在他看來,如今升級版的 GPT-4 依然如此,甚至完全沒有推理能力。

在論文中,Konstantine Arkoudas 指出,業界關于“LLM 是否有推理能力”的爭論已經持續了很長時間。

一方面,是 LLM 支持派。他們對大模型美好推理能力預測往往會依賴不斷變化的“定律”,而這些所謂的“定律”,Konstantine Arkoudas 認為,實際上就是站不住腳的經驗證據、大量有問題的建模假設、理解不清的概念(LLM 特性),以及甚至包含一點教條信念,即在龐大的語料庫中最大限度地減少下一個標記預測的交叉熵損失,就能通過遷移學習的魔力和通用高級表征的構建,提供一個通用的推理引擎。

另一方面,則是 LLM 懷疑派。他們往往有著嚴謹的論據,但是這些論點大多是基于過往經驗和分析,有些含糊不清(例如,LLM 缺乏“世界模型”,即關于世界如何運作的內部模型)。

基于這兩方面考慮,Konstantine Arkoudas 認為,對于可靠的魯棒 LLM 推理的合理性,最令人信服的先驗(過往經驗和分析)考慮是計算復雜性的結果。推理是一個非常難以計算的問題。事實上,在一般情況下(一階或高階邏輯),它在算法上是不可判定的。

Konstantine Arkoudas 表示,「任何 LLM,無論規模有多大,經過多么廣泛和巧都無法破解任意推理問題。這與機器學習中著名的 "沒有免費的午餐"定理是一致的,后者指出了模型通用性與性能之間類似的反比關系」。

因此,為了驗證“GPT-4 是否具有推理能力”,首先要做的是統一理念,即什么是推理,以及判定推理能力所采用的具體方法。

對于推理的定義,Konstantine Arkoudas 表示,「推理不是不擇手段地得出正確的答案,而是根據正確的理由得出正確的答案。」

更準確地說,推理是提出論點,更重要的是證明論點的過程。一個論證包括一個結論(可以說是論證的結果)和一系列前提,結論就是由這些前提推導出來的。前提代表了為論證目的而被視為既定的信息,即使只是暫時的。結論和前提通常是陳述句,用自然語言或符號邏輯的符號來表達,可真可假,但也可以用圖表等其他符號來表示。如果 S 中的所有句子都為真,則 p 為真,在這種情況下,這個論點被認為是有效的。

對于方法論,Konstantine Arkoudas 在論文中所采用的評估不是基于一個語料庫或一組語料庫。相反,其對 GPT-4 在廣泛領域的 21 個簡單推理問題上的性能進行了詳細的定性分析,其中大部分是從頭開始編寫的,而其余的(例如 Wason 的選擇任務)則經過手動調整,使模型不易識別它們,這樣做的部分原因也是為了避免數據污染。

用測試問題驗證 GPT-4 的推理性

基于此,Konstantine Arkoudas 從多個維度對 GPT-4 提出問題,并根據其輸出進行了詳盡的分析。

值得一提的是,由于 GPT-4 的屬性,有時候即使用相同的“Prompt”,在不同的運行中也可能會得到不同的答案。

接下來,驗證開始(以下所有測試時間多出自2023 年 7 月 5 日測試結果)。

簡單算術

Konstantine Arkoudas 表示,執行基本算術運算的能力是通用推理的必要組成部分,尤其是在科學和工程應用領域。為了確保 GPT-4 不會死記硬背,他提出了讓 GPT-4 在其選擇的范圍內隨機選擇兩個隨機整數,然后對選擇的值執行操作。

KA 給出的 Prompt 是:

在 1381 和 1453 之間選擇兩個隨機數,然后將它們相乘,并報告結果。

GPT-4 的回答是:

當然,讓我們在 1381 到 1453 的范圍內選取兩個隨機數。假設這個數字是 1405 和 1421。

要得到乘積,我們只需將這兩個數字相乘:1405*1421 = 1996025

但實際上,正確答案是 1405*1421=1996505。

事實證明,GPT-4 仍然無法可靠地執行基本算術運算,如加法和乘法。

Konstantine Arkoudas 表示,也許LLM 的支持者此時可能會承認 GPT-4 不是一個圖靈完備的框架,不能執行通用計算:它不能進行加、乘法或除法運算,不能對列表進行排序、不能求逆矩陣或解微分方程組、不能將任意程序編譯成機器碼、不能推導定理等等。

不過,這些計算能力的缺失可以通過第三方插件來彌補,如 ReAct、MRKL 框架。正是這種工作方式催生了 LangChain 和 AutoGPT 這樣的系統。這里的想法是使用 LLM 作為規劃器,將復雜問題遞歸分解為一系列子問題,通過適當的 API 將這些子問題分派給專門的代理。

然而,Konstantine Arkoudas 認為,這種方法的問題在于它的循環性。規劃本身就需要推理,所以這是一個 "兩難選擇",即我們無法通過將問題委托給合適的代理來解決推理問題,因為找出委托的方法(如何分解問題、調用哪些代理、如何調用以及如何分解結果)本身在計算上就不可行。這不僅需要理解自然語言的能力,還需要推理先決條件和效果的能力。即使在這些過于簡單化的假設下,規劃的計算成本也非常高昂(PSPACE-complele),需要進行徹底的簡化才能將復雜度降低到 NP-complele 的水平。在更現實的假設條件下,規劃是在不完全的知識條件下進行的,在機制上是不可判定的。正如我們今天所理解的那樣,期望通用 LLMs 能夠成功解決規劃問題是天真的想法。

簡單計數

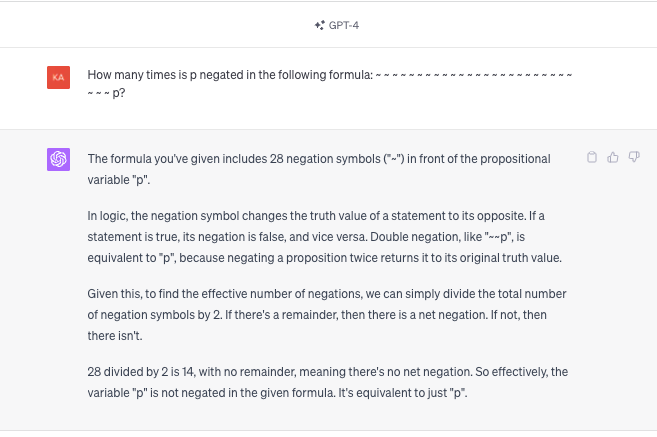

給 GPT-4 一個命題變量,在它前面有 27 個否定符號,并要求它計算否定的數量。對于人類來說,這是個很容易的任務,尤其是因為否定符號是分五塊寫的,每塊有五個小點,最后是一對否定符號,但是 GPT-4 的表現如何呢?

KA:

在下面的公式中,p 被否定了多少次:

~~~~~ ~~~~~ ~~~~~ ~~~~~ ~~~~~ ~~ p

GPT-4 的回答是:

GPT-4:你給出的公式在命題變量 "p "前面包含了 28 個否定符號("~")。在邏輯學中,否定符號將語句的真值改變為它的相反值。如果一個語句為真,那么它的否定就是假的,反之亦然。雙重否定,如"~ ~ p",等價于 "p",因為對一個命題否定兩次,它就恢復到原來的真值。

如果有余數,那么就有一個否定。如果沒有,那么就沒有否定。

28 除以 2 是 14,沒有余數,也就是說沒有否定。因此,實際上在給定的公式中,變量 "p "并沒有被否定。它只相當于 "p"。

Konstantine Arkoudas 發現,GPT-4 多數了一個否定符號帶來的差別似乎并不嚴重,直到我們意識到它在邏輯輸入上的所有差別,正如 GPT-4 自己(不請自來)的解釋所強調的那樣。即使在明確告訴 GPT-4 要慢慢來、仔細數的情況下,多次重復這個實驗也得到了大相徑庭的結果。

常識性問題

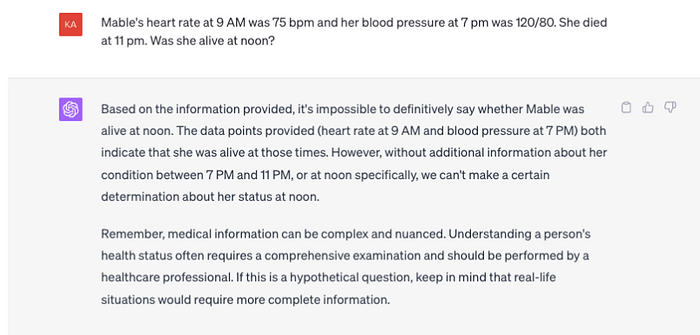

緊接著 Konstantine Arkoudas 又提出:“Mable 上午 9 點的心率是 75bom,下午 7 點的血壓是 120/80。她于晚上 11 點死亡。她中午還活著嗎?”

GPT-4:

根據所提供的信息,我們無法確定 Mable 中午是否還活著。所提供的數據點(上午 9 點的心率和下午 7 點的血壓)都表明她當時還活著。但是,如果沒有更多關于她下午 7 點到 11 點之間或者具體到中午的情況信息,我們就無法確定她中午時的狀況。

請記住,醫療信息可能是復雜而微妙的。要了解一個人的健康狀況,通常需要進行全面的檢查,并應由專業醫護人員進行。如果這是一個假設性問題,請記住現實生活中需要更完整的信息。

在目前的情況下,其實可以將常識論證視為從給定信息加上未說明的前提得出的直接推導結論,這些前提構成了普遍接受的背景知識。在這種特殊情況下,這種常識性知識就是 "人在死前是活著的,死后就不會再活著 "這樣的命題。在論文中,Konstantine Arkoudas 認為,GPT-4 給出"這是一個復雜的問題,請務必向專業人士咨詢 "的說法似乎具有諷刺意味。

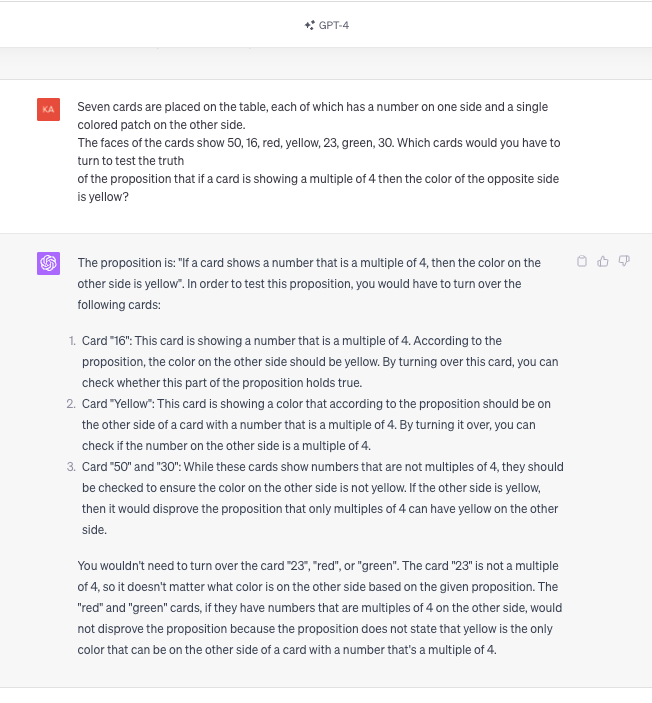

Wason 選擇問題

Wason 選擇任務是推理心理學的主要內容。

KA:

桌上放著七張撲克牌,每張撲克牌的一面都有一個數字,另一面有一個單色的圖案。牌面分別顯示 50、16、紅、黃、23、綠、30。如果一張牌上顯示的是 4 的倍數,那么反面的顏色就是黃色,你需要翻哪張牌來檢驗這個命題的真偽?

GPT-4:

命題是:"如果一張牌上的數字是 4 的倍數,那么另一面的顏色是黃色"。為了驗證這個命題,你必須翻開下面的牌:

撲克牌"16":根據命題,另一面的顏色應該是黃色。通過翻開這張牌,你可以檢查命題的這一部分是否成立。

撲克牌"黃色":翻開這張牌,你就可以檢查對面的數字是否是 4 的倍數。

撲克牌"50"和"30":雖然這兩張卡片上的數字不是 4 的倍數,但還是要檢查一下,以確保另一面的顏色不是黃色。如果另一面是黃色,那么就推翻了“只有 4 的倍數的另一面是黃色”的命題。

你不需要翻開卡片"23"、"紅色 "或 "綠色"。卡片"23"不是 4 的倍數,所以根據給定的命題,另一面是什么顏色并不重要。如果 "紅色 "和 "綠色 "卡片的另一面的數字是 4 的倍數,它們也不會推翻命題,因為命題并沒有說明黃色是唯一可以出現在數字是 4 的倍數的卡片的另一面的顏色。

事實上,只有 16、紅色和綠色需要翻轉。因此,在精確度方面,這些回答再次表明,GPT-4 并不理解物質條件式的語義。

當 GPT-4 說撲克牌 "50 "和 "30 "必須翻過來時,它似乎把 if 錯當成了 if and only if:「當這些卡片上顯示的數字不是 4 的倍數,它們應檢查以確保另一面的顏色不是黃色。如果另一面是黃色,那么就會推翻 "只有 4 的倍數的另一面是黃色 "這一命題」。當然,所檢驗的命題并不要求只有 4 的倍數的另一面是黃色;它只是要求,如果一張牌的另一面是 4 的倍數,那么另一面一定是黃色;或者換句話說,如果一張牌的正面不是黃色,那么另一面的數字就不是 4 的倍數。

但要注意的是,即使是將規則錯誤地解釋為一個雙重條件,也沒有得到一致的遵守。如果 GPT-4 將被測試的規則理解為一個雙重條件,因而不得不翻轉 50 和 30,那么它就應該對 23 做同樣的事情。但它沒有這樣做。

事實上,它明確地說,撲克牌 "23 "不是 4 的倍數,因此根據給定的命題,另一面是什么顏色并不重要,這與它用來作為翻轉 50 和 30 的理由的二條件解釋相矛盾。這再次說明了這些例子中出現的另一個重要主題:GPT-4 的回答,無論對錯,往往都存在內在的不一致。

除此之外,Konstantine Arkoudas 還在論文中驗證了空間推理、熵、簡單編譯器的正確性、時間推理等能力。

因篇幅問題,我們在本文中只選取以上幾個示例加以說明。

結論

最終種種驗證無疑證明了 GPT-4 推理能力的慘淡畫面。

結果表明,該模型存在內部不一致性、不能正確應用基本推理技術和缺乏對推理中起基礎性作用的概念(如物質條件)的理解等問題。

但是現實中,這些問題往往歸納為大模型帶來的誤差與“幻覺”,實則其實是它不具備推理能力。

鑒于 GPT-4 是目前最有能力的 LLM,Konstantine Arkoudas從這些發現中得出三個主要結論:

在軟件開發(或一般的科學和工程)中使用生成式人工智能來完成乏味的任務(作為一種針對知識密集型編碼問題的渦輪增壓自動補全)之外的任何任務都充滿了嚴重的風險。正確性的規范標準是至關重要的,在這些領域,目前的 LLM 不能滿足這樣的標準。就像生成人工智能已經開始用糟糕的廣告污染網絡一樣,它有可能大規模地增加 Bug 代碼。

如果 LLM 推理繼續改進,嚴格的證明檢查就可能變得越來越重要。對于應用程序來說,對系統推理的正確性有信心是必不可少的,尤其是在科學、醫學和工程領域,而驗證檢查是一種能夠提供這種信任的技術。這種方法可以通過要求 LLMS 將其推理正規化(用易于驗證檢查的符號表示法來表示),或者可能通過培訓其他 LLMS 檢查用自然語言表示的一段推理來實現。

就目前情況來看,反烏托邦的場景涉及一個讓人類屈服的流氓人工智能,甚至其他人類使用人工智能來達到邪惡的目的,是非常牽強的。當最先進的人工智能系統在空間推理過程中甚至無法區分左右時,行業中還有那么多呼吁制定政策和機構來保護人類免受其 AI 侵害的做法顯然是不成熟的。

爭議

在 Konstantine Arkoudas 看來,當前的生成式 AI 還處于發展的早期,距離推理能力以及 AGI 時代還有很遠的距離。

此篇論文一經發布,也在 HN 上吸引了很多人的關注與討論,難道過去 5 個月間,我們都被騙了嗎?

不過,他的這一獨特的看法,也得到了不少 AI 學者的認同。

人工智能領域內的“叛逆者”、紐約大學心理學和神經科學榮譽教授Gary Marcus 發推文表示:“如果這是真的——正如我早就說過的——我們距離通用人工智能還差得很遠。可能需要進行大量的重新校準:沒有推理就不可能擁有通用人工智能。”

@SiSafLtd首席人工智能官 Nikos Tzagarakis 表示,“深度學習算法是為了根據感知進行預測而構建的。他們可能會偽造推理,但實際上這是感知。”

不過,也有網友提出質疑:

我瀏覽了這些資料,并嘗試重現了一些報告的故障,從中得出了兩個結論。

1. 作者不善于 Prompt。有很多方法可以減少幻覺,為模型提供更好的思考路徑。

2. 作者使用的是 ChatGPT 的 GPT-4,導致他將 "GPT-4 "與 "ChatGPT "混為一談。雖然你可以認為這是 OpenAI 的共同失誤,但由于 OpenAI 的溝通不暢,任何認真評估這些模型的人都會知道,你需要做的第一件事就是使用 API 并鎖定模型版本。就作者而言,他應該使用 gpt-4-0314 或 gpt-4-0613。我懷疑他只是使用了 ChatGPT 的 GPT-4,而且很可能是默認模型。(任何人都不應該使用默認模式。這是性能優化最差的模型,在推理任務上的表現比 Plugins 模型更差,甚至在上下文大小的任務上也是如此)。

如果作者一直在認真地評估模型,那么說明模型是他要做的第一件事。也許他應該解釋一下他的理由。

至此,你怎么看?

審核編輯:劉清

-

機器學習

+關注

關注

66文章

8406瀏覽量

132558 -

GPT

+關注

關注

0文章

352瀏覽量

15342 -

OpenAI

+關注

關注

9文章

1079瀏覽量

6480 -

ChatGPT

+關注

關注

29文章

1558瀏覽量

7592 -

LLM

+關注

關注

0文章

286瀏覽量

327

原文標題:GPT-4 其實沒有推理能力?!

文章出處:【微信號:AI科技大本營,微信公眾號:AI科技大本營】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

Llama 3 與 GPT-4 比較

科大訊飛發布訊飛星火4.0 Turbo:七大能力超GPT-4 Turbo

OpenAI推出新模型CriticGPT,用GPT-4自我糾錯

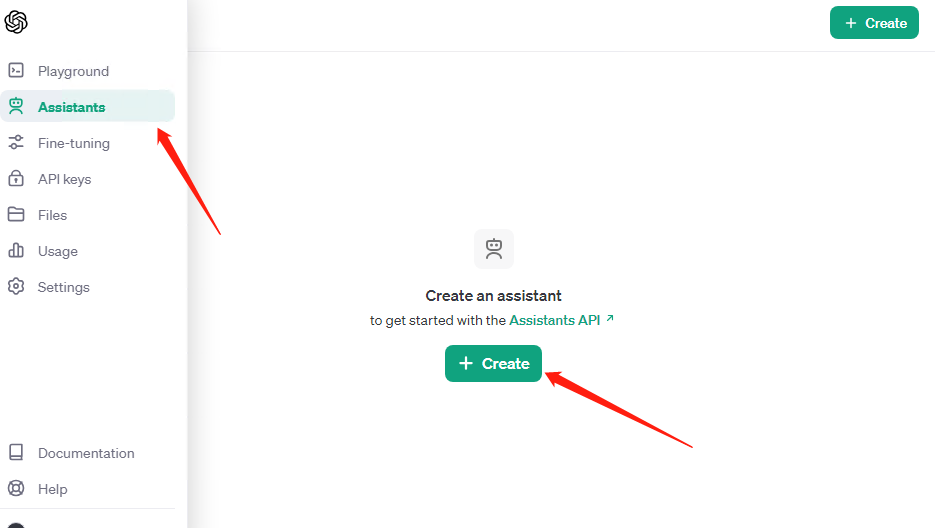

OpenAI API Key獲取:開發人員申請GPT-4 API Key教程

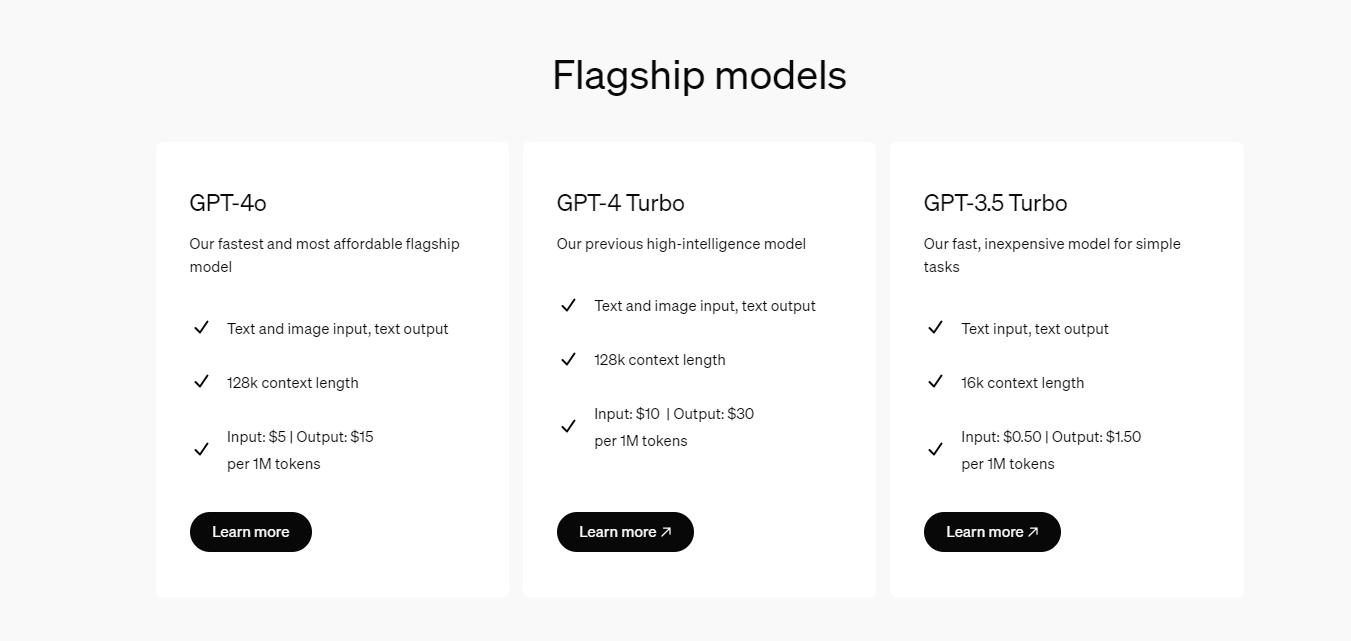

開發者如何調用OpenAI的GPT-4o API以及價格詳情指南

GPT-4人工智能模型預測公司未來盈利勝過人類分析師

OpenAI全新GPT-4o能力炸場!速度快/成本低,能讀懂人類情緒

OpenAI計劃宣布ChatGPT和GPT-4更新

阿里云發布通義千問2.5大模型,多項能力超越GPT-4

商湯科技發布5.0多模態大模型,綜合能力全面對標GPT-4 Turbo

OpenAI推出Vision模型版GPT-4 Turbo,融合文本與圖像理解

微軟Copilot全面更新為OpenAI的GPT-4 Turbo模型

新火種AI|秒殺GPT-4,狙殺GPT-5,橫空出世的Claude 3振奮人心!

GPT-4沒有推理能力嗎?

GPT-4沒有推理能力嗎?

評論