摘要

語(yǔ)義占用網(wǎng)格感知對(duì)于自動(dòng)駕駛至關(guān)重要,因?yàn)樽詣?dòng)駕駛車(chē)輛需要對(duì)3D城市場(chǎng)景進(jìn)行細(xì)粒度感知。然而,現(xiàn)有的相關(guān)基準(zhǔn)測(cè)試在城市場(chǎng)景的多樣性方面存在不足,并且僅評(píng)估前視預(yù)測(cè)感知。為了全面評(píng)估周視感知算法,我們提出了OpenOccupancy,這是第一個(gè)用于周視語(yǔ)義占用網(wǎng)格感知的基準(zhǔn)測(cè)試方法。在OpenOccupancy基準(zhǔn)測(cè)試中,我們通過(guò)添加稠密的語(yǔ)義占用網(wǎng)格標(biāo)注來(lái)擴(kuò)展大規(guī)模的nuScenes數(shù)據(jù)集。以前的標(biāo)注依賴(lài)于LiDAR點(diǎn)云的疊加,由于LiDAR數(shù)據(jù)的稀疏,導(dǎo)致一些占用標(biāo)簽被遺漏。為了緩解這個(gè)問(wèn)題,我們引入了增強(qiáng)與凈化(AAP)流程,將標(biāo)注密度提高了約2倍,其中涉及約4000個(gè)人工小時(shí)的標(biāo)注過(guò)程。此外為OpenOccupancy基準(zhǔn)測(cè)試建立了基于攝像頭、LiDAR和多模態(tài)的基線模型。此外考慮到周視占用感知的復(fù)雜性在于高分辨率3D預(yù)測(cè)的計(jì)算負(fù)擔(dān),我們提出了級(jí)聯(lián)占用網(wǎng)絡(luò)(CONet)來(lái)改進(jìn)粗糙預(yù)測(cè),相對(duì)于基線模型提高了約30%的性能。我們希望OpenOccupancy基準(zhǔn)測(cè)試能促進(jìn)周視占用感知算法的發(fā)展。

主要貢獻(xiàn)

盡管目前對(duì)于語(yǔ)義占用網(wǎng)格感知越來(lái)越受到關(guān)注,但大多數(shù)相關(guān)基準(zhǔn)都是針對(duì)室內(nèi)場(chǎng)景設(shè)計(jì)的,SemanticKITTI 將占用感知擴(kuò)展到駕駛場(chǎng)景,但其數(shù)據(jù)集規(guī)模相對(duì)較小且多樣性有限,這影響了開(kāi)發(fā)占用感知算法的泛化和評(píng)估。此外,SemanticKITTI只評(píng)估前視圖的占用網(wǎng)格結(jié)果,而對(duì)于安全駕駛而言,周視感知更為關(guān)鍵。為解決這些問(wèn)題,我們提出了OpenOccupancy,這是第一個(gè)用于周視語(yǔ)義占用感知的基準(zhǔn)。在OpenOccupancy基準(zhǔn)中引入了nuScenes-Occupancy,它將大規(guī)模的nuScenes數(shù)據(jù)集與密集的語(yǔ)義占用標(biāo)注相結(jié)合。

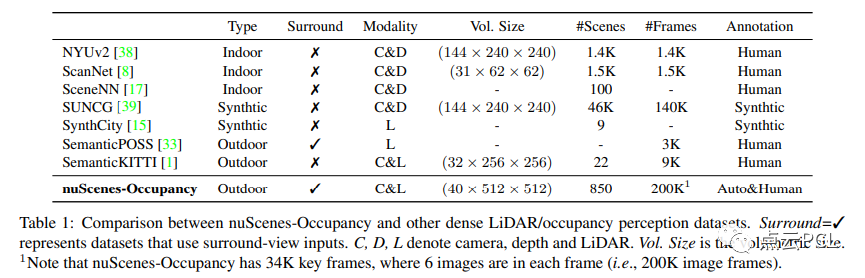

如表1所示,nuScenes-Occupancy標(biāo)注的場(chǎng)景和幀數(shù)比多約40倍和20倍。值得注意的是,通過(guò)人工直接標(biāo)注大規(guī)模的占用標(biāo)簽幾乎是不現(xiàn)實(shí)的。因此引入了Augmenting And Purifying (AAP)流程,以高效地標(biāo)注和稠密的占用標(biāo)簽。

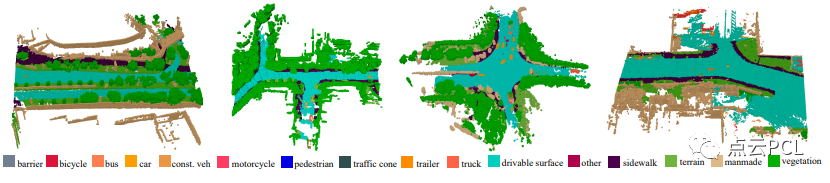

圖1:nuScenes-Occupancy為nuScenes數(shù)據(jù)集中的所有關(guān)鍵幀提供了稠密的語(yǔ)義占用網(wǎng)格標(biāo)簽,在這里展示了標(biāo)注的地面真值,體積大小為(40 × 512 × 512),網(wǎng)格大小為0.2米。

圖1展示了稠密標(biāo)注的可視化效果。為了促進(jìn)未來(lái)研究,我們?cè)贠penOccupancy基準(zhǔn)中建立了基于相機(jī)、基于LiDAR和多模式的基線。實(shí)驗(yàn)結(jié)果顯示,基于相機(jī)的方法在小物體(如自行車(chē)、行人、摩托車(chē))方面表現(xiàn)更好,而基于LiDAR的方法在大型結(jié)構(gòu)區(qū)域(如行駛表面、人行道)方面表現(xiàn)更優(yōu)。值得注意的是,多模式基線通過(guò)自適應(yīng)融合兩種模態(tài)的中間特征,相對(duì)提高了基于相機(jī)和基于LiDAR方法的整體性能,分別提升了47%和29%。考慮到周?chē)加酶兄挠?jì)算負(fù)擔(dān),所提出的基線只能生成低分辨率的預(yù)測(cè)。為了實(shí)現(xiàn)高效的占用感知,我們提出了級(jí)聯(lián)占用網(wǎng)絡(luò)(CONet),在所提出的基線之上構(gòu)建了一個(gè)從粗糙到精細(xì)的流程,相對(duì)提高了性能約30%。主要貢獻(xiàn)總結(jié)如下:

提出了OpenOccupancy,這是第一個(gè)針對(duì)駕駛場(chǎng)景中周?chē)加酶兄幕鶞?zhǔn)。

通過(guò)nuScenes數(shù)據(jù)集引入了AAP流程,它高效地標(biāo)注和稠密化了周?chē)Z(yǔ)義占用標(biāo)簽,結(jié)果形成了第一個(gè)用于周?chē)Z(yǔ)義占用分割的數(shù)據(jù)集nuScenes-Occupancy。

我們?cè)贠penOccupancy基準(zhǔn)上建立了基于相機(jī)、基于LiDAR和多模式的基線。此外,我們引入了CONet來(lái)減輕高分辨率占用預(yù)測(cè)的計(jì)算負(fù)擔(dān),相對(duì)提高了基線性能約30%。

主要內(nèi)容

周視語(yǔ)義占用網(wǎng)格感知

周視語(yǔ)義占用感知是指生成場(chǎng)景的完整3D表示,包括體積占用和語(yǔ)義標(biāo)簽,與前視圖感知的單目范例不同,周視占用感知算法旨在在周?chē)晥D的駕駛場(chǎng)景中生成語(yǔ)義占用,具體而言,給定360度的輸入Xi(例如LiDAR掃描或周?chē)晥D圖像),感知算法需要預(yù)測(cè)周?chē)恼加脴?biāo)簽F(Xi) ∈ R D×H×W,其中D、H、W是整個(gè)場(chǎng)景的體積大小。值得注意的是,周視圖的輸入范圍比前視覺(jué)傳感器覆蓋的范圍大約多了5倍,因此,周視占用網(wǎng)格感知的核心挑戰(zhàn)在于高效構(gòu)建高分辨率的占用表示。

nuScenes-Occupancy

SemanticKITTI 是首個(gè)用于室外占據(jù)感知的數(shù)據(jù)集,但在駕駛場(chǎng)景方面缺乏多樣性,并且僅評(píng)估前視感知,為了創(chuàng)建一個(gè)大規(guī)模的環(huán)境占據(jù)感知數(shù)據(jù)集,我們引入了nuScenes-Occupancy,它在nuScenes數(shù)據(jù)集的基礎(chǔ)上添加了稠密的語(yǔ)義占用標(biāo)注。作者引入了AAP(Augmenting And Purifying)流程來(lái)高效地標(biāo)注和密集化占據(jù)標(biāo)簽。

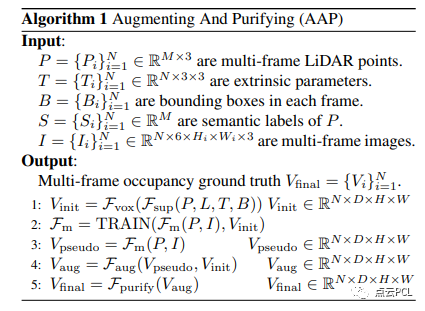

整個(gè)AAP流程如算法1所示。

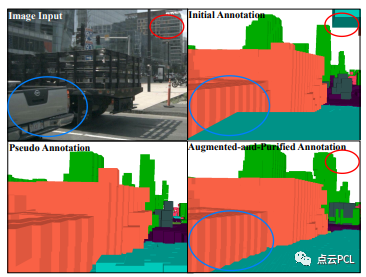

如圖2所示,偽標(biāo)簽對(duì)初始標(biāo)注是補(bǔ)充的,而增強(qiáng)和純化標(biāo)簽更密集和精確,值得注意的是增強(qiáng)和純化標(biāo)注中每個(gè)幀中約有40萬(wàn)個(gè)占據(jù)體素,比初始標(biāo)注密集了約2倍。總之,nuScenes-Occupancy包含28130個(gè)訓(xùn)練幀和6019個(gè)驗(yàn)證幀,在每個(gè)幀中對(duì)占據(jù)的體素分配了17個(gè)語(yǔ)義標(biāo)簽。

圖2:初始標(biāo)注、偽標(biāo)注和增強(qiáng)純化標(biāo)注之間的對(duì)比,紅圈和藍(lán)圈突出顯示增強(qiáng)標(biāo)注更加密集和準(zhǔn)確的區(qū)域。

OpenOccupancy基線

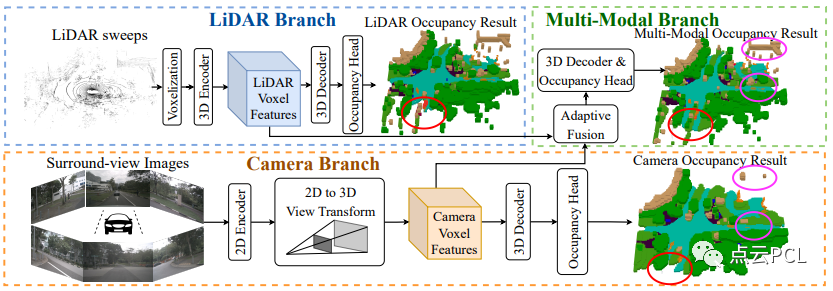

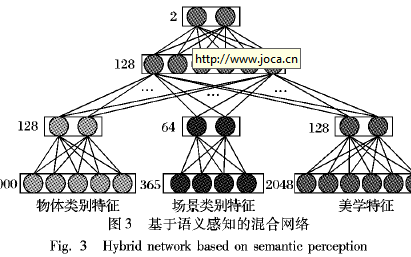

大多數(shù)現(xiàn)有的占據(jù)感知方法都是為前視感知而設(shè)計(jì)的,為了將這些方法擴(kuò)展到周?chē)恼紦?jù)感知,需要對(duì)每個(gè)相機(jī)視角的輸入進(jìn)行單獨(dú)處理,這是低效的。此外,兩個(gè)相鄰輸出的重疊區(qū)域可能存在不一致性,為了緩解這些問(wèn)題,我們建立了一致地從360度輸入(例如LiDAR掃描或環(huán)視圖像)中學(xué)習(xí)周?chē)Z(yǔ)義占據(jù)的基線,具體而言,為OpenOccupancy基準(zhǔn)提出了基于相機(jī)的、基于LiDAR的和多模態(tài)的基線,如圖3所示。

圖3:三種提出的基線的整體架構(gòu),LiDAR分支利用3D編碼器提取體素化的LiDAR特征,相機(jī)分支使用2D編碼器學(xué)習(xí)環(huán)視圖特征,然后將其轉(zhuǎn)換為生成3D相機(jī)體素特征,在多模態(tài)分支中,自適應(yīng)融合模塊動(dòng)態(tài)地集成兩種模態(tài)的特征。所有三個(gè)分支都利用3D解碼器和占據(jù)頭來(lái)產(chǎn)生語(yǔ)義占據(jù),在占據(jù)結(jié)果圖中,紅色和紫色圈圈標(biāo)示出多模態(tài)分支可以生成更完整和準(zhǔn)確的預(yù)測(cè)。

實(shí)驗(yàn)

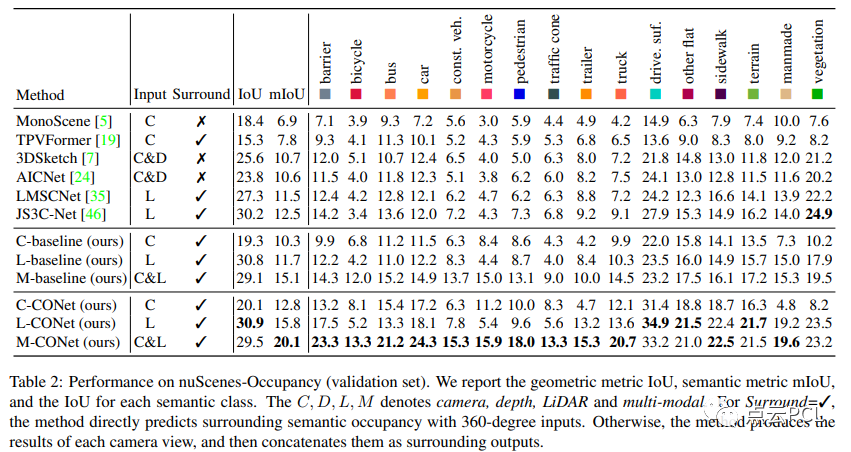

在OpenOccupancy基準(zhǔn)測(cè)試中,基于nuScenes-Occupancy評(píng)估周?chē)Z(yǔ)義占據(jù)感知性能,對(duì)提出的基線、CONet和現(xiàn)代占據(jù)感知算法進(jìn)行全面實(shí)驗(yàn)。所有模型在8個(gè)A100 GPU上以8個(gè)批次大小進(jìn)行訓(xùn)練,共訓(xùn)練24個(gè)時(shí)期。利用OpenOccupancy基準(zhǔn)測(cè)試,我們分析了六種現(xiàn)代方法(MonoScene ,TPVFormer,3DSketch ,AICNet ,LMSCNet,JS3C-Net )以及提出的基線和CONet的周?chē)紦?jù)感知性能,從表2的結(jié)果可以看出:

與單視圖方法相比,周?chē)紦?jù)感知范式表現(xiàn)出更好的性能。

提出的基線對(duì)周?chē)紦?jù)感知具有適應(yīng)性和可擴(kuò)展性。

相機(jī)和LiDAR的信息相互補(bǔ)充,多模態(tài)基線顯著提高了性能。

周視占據(jù)感知的復(fù)雜性在于高分辨率3D預(yù)測(cè)的計(jì)算負(fù)擔(dān),這可以通過(guò)提出的CONet來(lái)減輕。

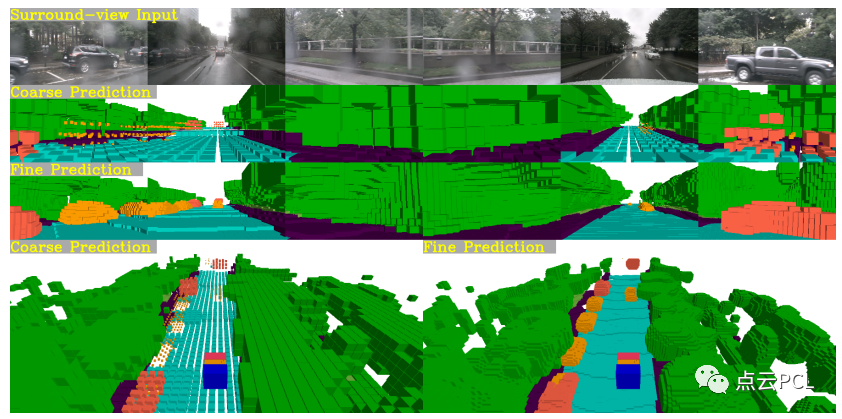

這里提供可視化結(jié)果(見(jiàn)圖5)來(lái)驗(yàn)證CONet可以基于粗糙預(yù)測(cè)生成精細(xì)的占據(jù)網(wǎng)格結(jié)果。

圖5:語(yǔ)義占據(jù)預(yù)測(cè)的可視化,第1行是周視圖像。第2行和第3行顯示了由多模態(tài)基線和多模態(tài)CONet生成的相機(jī)視圖的粗糙和精細(xì)占據(jù),第4行比較了它們的全局視圖預(yù)測(cè)。

總結(jié)

本文提出了OpenOccupancy,這是首個(gè)用于駕駛場(chǎng)景中周視語(yǔ)義占據(jù)感知的基準(zhǔn)測(cè)試,具體而言引入了nuScenes-Occupancy,它基于提出的AAP流水線擴(kuò)展了nuScenes數(shù)據(jù)集,帶有稠密的語(yǔ)義占據(jù)標(biāo)注,在OpenOccupancy基準(zhǔn)測(cè)試中建立了基于相機(jī)、基于LiDAR和多模態(tài)的基線。此外還提出了CONet來(lái)減輕高分辨率占據(jù)預(yù)測(cè)的計(jì)算負(fù)擔(dān)。在OpenOccupancy基準(zhǔn)測(cè)試中進(jìn)行了全面的實(shí)驗(yàn),結(jié)果顯示基于相機(jī)和基于LiDAR的基線相互補(bǔ)充,而多模態(tài)基線進(jìn)一步提高了性能,分別提高了47%和29%。此外所提出的CONet相對(duì)于基線提高了約30%,并且延遲開(kāi)銷(xiāo)最小。我們希望OpenOccupancy基準(zhǔn)測(cè)試對(duì)于周視語(yǔ)義占據(jù)感知的發(fā)展有所幫助。

審核編輯:劉清

-

傳感器

+關(guān)注

關(guān)注

2552文章

51239瀏覽量

754816 -

編碼器

+關(guān)注

關(guān)注

45文章

3651瀏覽量

134777 -

視覺(jué)傳感器

+關(guān)注

關(guān)注

3文章

250瀏覽量

22908 -

自動(dòng)駕駛

+關(guān)注

關(guān)注

784文章

13877瀏覽量

166618 -

LiDAR芯片

+關(guān)注

關(guān)注

1文章

17瀏覽量

3240

原文標(biāo)題:OpenOccupancy:一個(gè)用于周視語(yǔ)義占用網(wǎng)格感知的基準(zhǔn)測(cè)試

文章出處:【微信號(hào):3D視覺(jué)工坊,微信公眾號(hào):3D視覺(jué)工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

未來(lái)已來(lái),多傳感器融合感知是自動(dòng)駕駛破局的關(guān)鍵

集成語(yǔ)義和多Agent 的網(wǎng)格資源發(fā)現(xiàn)模型

基于感知網(wǎng)格的無(wú)線傳感器網(wǎng)絡(luò)動(dòng)態(tài)采樣策略_趙意

基于語(yǔ)義與事務(wù)屬性的QoS感知的服務(wù)優(yōu)化選擇

基于語(yǔ)義的文本語(yǔ)義分析

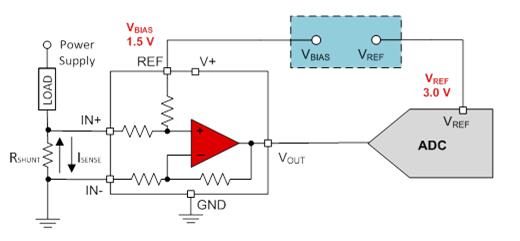

一文看懂單電壓基準(zhǔn)與雙電壓基準(zhǔn)區(qū)別

如何使用語(yǔ)義感知來(lái)進(jìn)行圖像美學(xué)質(zhì)量評(píng)估的方法

MySQL基準(zhǔn)測(cè)試和sysbench工具

一個(gè)結(jié)合監(jiān)督學(xué)習(xí)的多層感知機(jī)模型

地平線推出業(yè)內(nèi)首個(gè)周視感知NOA方案Pilot 3

介紹一個(gè)JavaScript數(shù)據(jù)網(wǎng)格組件

語(yǔ)義分割數(shù)據(jù)集:從理論到實(shí)踐

自動(dòng)駕駛中基于網(wǎng)格的交通場(chǎng)景感知介紹

深度學(xué)習(xí)圖像語(yǔ)義分割指標(biāo)介紹

一個(gè)用于周視語(yǔ)義占用網(wǎng)格感知的基準(zhǔn)測(cè)試

一個(gè)用于周視語(yǔ)義占用網(wǎng)格感知的基準(zhǔn)測(cè)試

評(píng)論