載自:「Yoaz 的博客」

原文:https://url.hi-linux.com/12Rw2

背景

官方提供了多篇文檔說明如何配置 Cilium 和 BGP 協同工作,本文主要對以下部分功能進行驗證:

Using BIRD to run BGP[1]

Using kube-router to run BGP[2]

BGP[3]

Cilium BGP Control Plane[4]

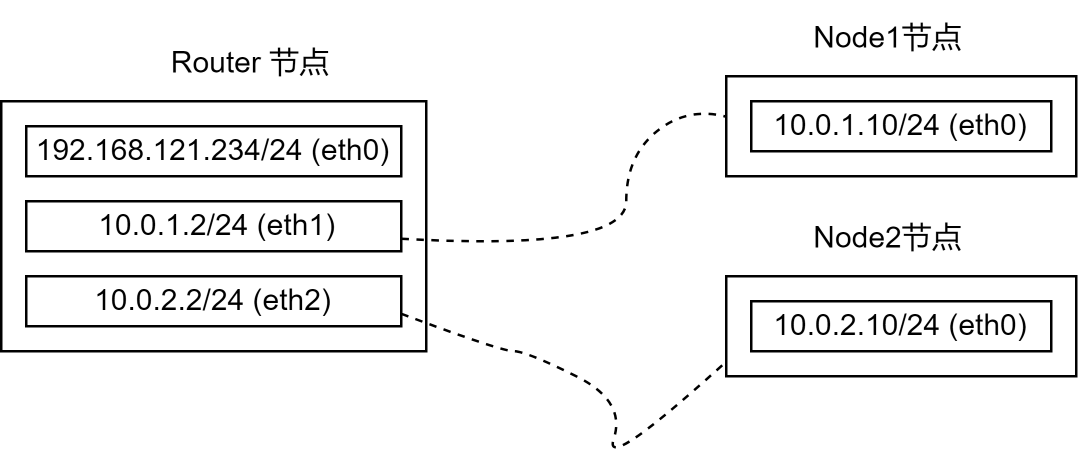

為了模擬支持 BGP 的網絡環境,文中所有節點均是通過 vagrant 創建的 VM, 網絡拓撲如下圖。

注意:實際配置時使用 vagrant 創建的 VM 模擬網絡環境并不便利。可以參考以下文章,使用 ContainerLab 和 Kind 進行驗證。

上圖中,Router 節點包含多張網卡并將作為其他兩臺主機的網關,對應的系統配置如下:

net.ipv4.ip_forward=1 net.ipv6.conf.all.disable_ipv6=1 net.ipv6.conf.default.disable_ipv6=1 net.ipv6.conf.lo.disable_ipv6=1 net.ipv6.conf.all.forwarding=1

node1、node2 節點均只包含一張網卡,其默認路由均指向 router 節點(node1 指向 10.0.1.2,node2 指向 10.0.2.2)。

node1、node2 上將部署 Kubernetes 和 Cilium。

基于 Bird 部署容器網絡

Cilium 為 PodCIDR 提供了 Encapsulation 和 Native-Routing 兩種組網方式。

Native-Routing 方案中,Cilium 會將 PodCIDR 中的跨節點流量委托給 Linux 內核的路由子系統,此時 Linux 內核需要知道如何路由 PodCIDR 中的特定地址。

當用戶的所有 Node 處于同一個 L2 網絡時,我們可以設置參數 autoDirectNodeRoutes=true ,此時整個 PodCIDR 路由信息被插入到每個節點的內核路由表中,用戶無需其他額外工作即部署完成。

上述測試環境中,Node1 和 Node2 分別處于 10.0.1.0/24 和 10.0.2.0/24 ,并不滿足設置 autoDirectNodeRoutes 的條件,因此我們需要借助設置 BGP 服務完成 PodCIDR 組網。

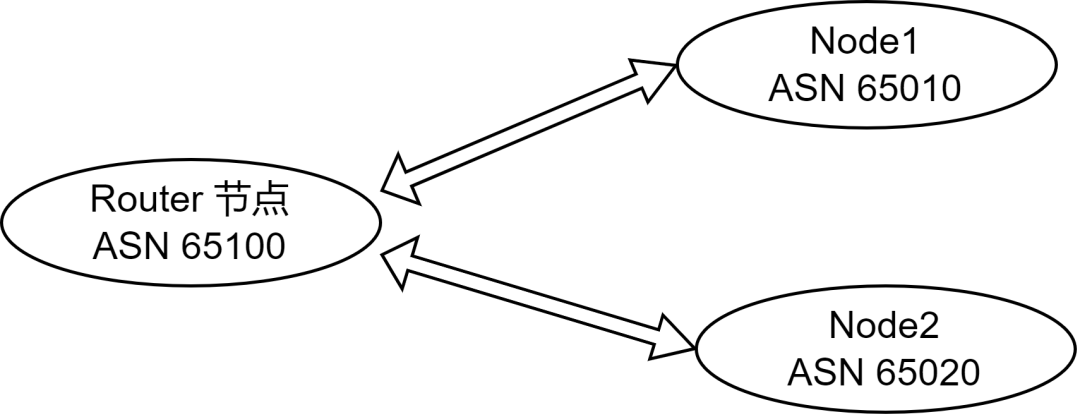

參考Using BIRD to run BGP[5]文檔中的描述,并結合測試環境的網絡拓撲,我們設定測試節點的 ASN 如下圖:

1. FRR 設置

在 router 上部署軟件路由器 FRR , 如下:

FRRVER="frr-stable" curl-Ohttps://rpm.frrouting.org/repo/$FRRVER-repo-1-0.el7.noarch.rpm sudoyuminstall./$FRRVER* sudoyuminstallfrrfrr-pythontools

修改 /etc/frr/daemons 文件,打開 bgpd 功能(設置配置文件中 bgpd=yes)。編輯 /etc/frr/frr.conf 文件,寫入以下 BGP 相關的配置:

frrversion8.4.1 frrdefaultstraditional hostnamerouter#主機名 logsysloginformational ! routerbgp65100#router節點的本地ASN bgprouter-id192.168.121.16#router-id nobgpebgp-requires-policy neighbor10.0.1.10remote-as65010#配置Node1作為router的鄰居,ASN為65010 neighbor10.0.2.10remote-as65020#配置Node2作為router的鄰居,ASN為65020 exit !

完成上述配置后,啟動 frr 服務systemctl restart frr!

2. 部署 Cilium

登錄 Node1 或 Node2 部署 Cilium,配置如下:

k8sServiceHost:"10.0.1.10" k8sServicePort:6443 kubeProxyReplacement:strict devices:eth1 ipam: operator: clusterPoolIPv4PodCIDR:"172.31.254.0/23" clusterPoolIPv4PodCIDRList:[] clusterPoolIPv4MaskSize:26 loadBalancer: mode:dsr tunnel:disabled autoDirectNodeRoutes:false bpf: masquerade:true ipv4NativeRoutingCIDR:"172.31.254.0/23" socketLB: enabled:true nodePort: enabled:true externalIPs: enabled:true hostPort: enabled:true

Cilium 容器就緒后,Kubernetes 集群中可以正常創建容器并分配容器IP,但是跨節點容器無法正常通信。

3. 部署 Bird

Cilium 官方文檔中,給出了 Bird2 的配置示例。我們可以直接通過yum -y install bird2安裝。

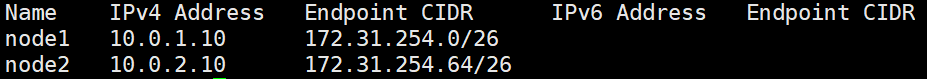

查看各個節點分配的 PodCIDR 網段,執行kubectl -n kube-system exec -it ds/cilium -- cilium node list:

參考以下配置 bird2 服務,配置文件 /etc/bird.conf

routerid10.0.1.10;

protocoldevice{

scantime10;#Scaninterfacesevery10seconds

}

#Disableautomaticallygeneratingdirectroutestoallnetworkinterfaces.

protocoldirect{

disabled;#Disablebydefault

}

#ForbidsynchronizingBIRDroutingtableswiththeOSkernel.

protocolkernel{

ipv4{#ConnectprotocoltoIPv4tablebychannel

importnone;#Importtotable,defaultisimportall

exportnone;#Exporttoprotocol.defaultisexportnone

};

}

#StaticIPv4routes.

protocolstatic{

ipv4;

route172.31.254.0/26via"cilium_host";#將 PodCICR 通告到上游,PS:這里是 Node1 分配到的 PodCIDR

}

#BGPpeers

protocolbgpuplink0{

description"BGPuplink0";

local10.0.1.10as65010;#設置當前節點的 ASN ,PS:這里示例的是 Node1

neighbor10.0.1.2as65100;#設置節點的Neighbor,這里是router節點

ipv4{

importfilter{reject;};

exportfilter{accept;};

};

}

在 Node1、Node2 按照上述方式配置完成 Bird2 后啟動服務。執行以下命令檢查 BGP 連接是否正常:

#在router執行以下命令 #查看bgppeer連接 vtysh-c"showbgpsummary" #查看注冊到router的路由信息 vtysh-c"showbgpipv4all"

完成上述流程后,使得 Node1 和 Node2 上的容器網絡打通,并且任意以 router 節點作為默認網關的服務器都可以直連 PodIP。

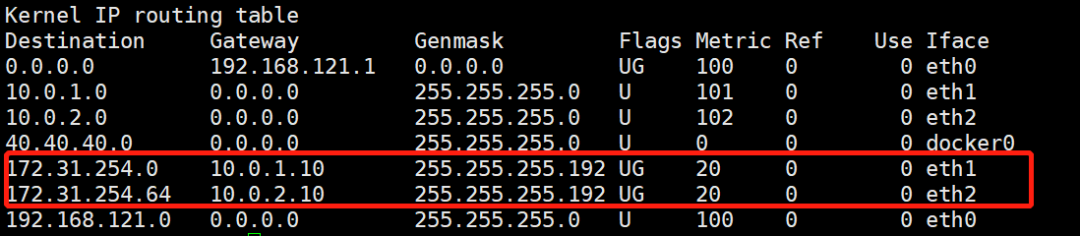

查看 router 接地的路由信息如下:

上圖中,我們發現 router 節點被注入了 PodCIDR 。

本文測試環境的網絡拓撲非常簡單,實際上直接通過命令行直接在 router 節點上插入路由信息可以達到同樣效果。在實際生產中,我們可以通過 BGP 動態發現簡化配置流程。

內置 BGP

Cilium 1.10 之后的版本內置了 BGP Speaker 的功能,用戶無需在節點上部署 Bird2 也可以向外廣播節點的 PodCIDR 信息,并且 1.12 版本中 Cilium 參考 Metallb 實現支持基于 BGP + ECMP 的 LoadBalancer 功能。

參考文檔[6]中的描述,啟用內置的 BGP 能力需要額外創建以下 ConfigMap,Cilium-Agent 和 Cilium-Operator 啟動時均會掛載該配置。

apiVersion:v1 kind:ConfigMap metadata: name:bgp-config namespace:kube-system data: config.yaml:| peers: -peer-address:192.168.121.16 peer-asn:65100 my-asn:65000 address-pools: -name:default protocol:bgp addresses: -192.0.2.0/24

上述配置中,Cilium 將使用 192.168.121.16 連接 router 節點的 bgpd 服務(PS:BGP 建立連接是基于 TCP 的),并且 Node1 和 Node2 將使用相同的 ASN 65000。

address-pools 指定的是 LoadBalanacer 的 IP 地址池,當用戶創建 LoadBalancer 類型的 Service 時,Cilium 將自動從該地址池中分配 ip 地址,并自動進行 BGP 宣告。

安裝上述 Configmap 后,我們需要為 Cilium 為添加如下配置:

bgp: enabled:true announce: loadbalancerIP:true podCIDR:true loadBalancer: mode:snat#此處使用dsr模式時,存在問題

創建 service 如下:

apiVersion:v1 kind:Service metadata: name:whoami-lb spec: type:LoadBalancer ports: -port:80 targetPort:80 protocol:TCP name:http selector: app:whoami

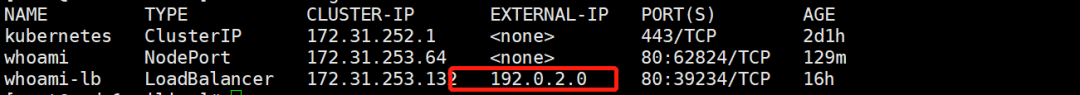

cilium 自動分配 192.0.2.0 作為 service 的 EXTERNAL-IP:

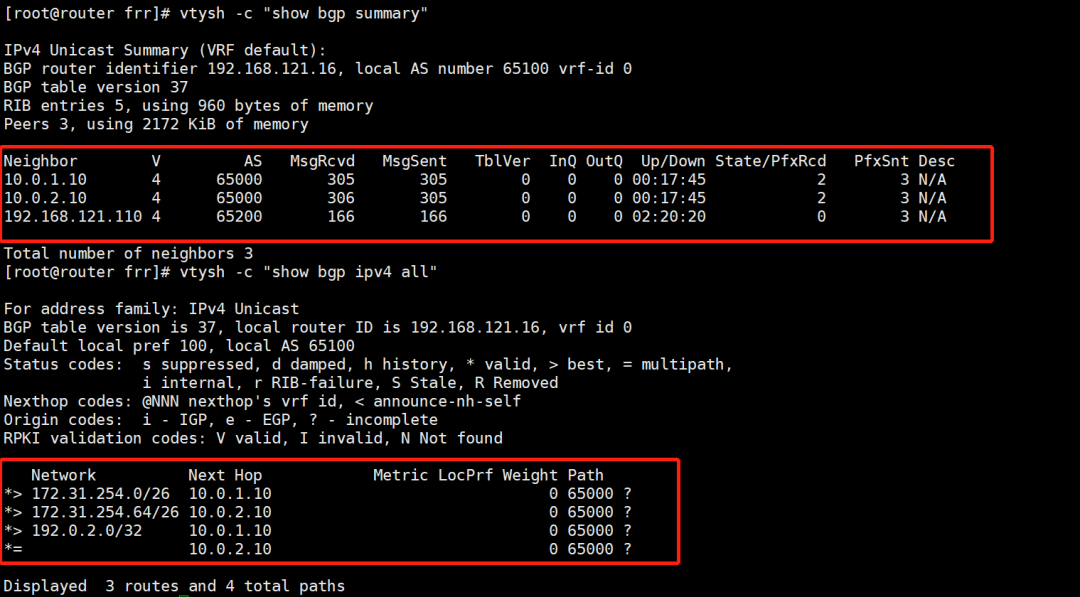

我們登錄 router 節點通過 vtysh 查看 Cilium 是否 bgpd 服務建立了連接,并且查看其通告的路由信息如下:

需要注意,router 節點上我們需要添加 ECMP 的相關配置,并且依然靜態指定 Node1 和 Node2 作為 neighbor 如下:

frrversion8.4.1 frrdefaultstraditional hostnamerouter logsysloginformational ! routerbgp65100 bgpbestpathas-pathmultipath-relax bgpbestpathbandwidthskip-missing bgprouter-id192.168.121.16 nobgpebgp-requires-policy neighbor10.0.1.10remote-as65000 neighbor10.0.2.10remote-as65000 exit !

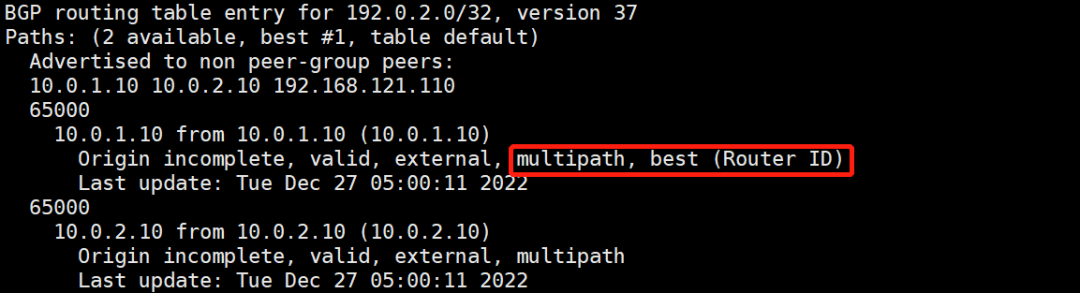

執行vtysh -c "show bgp ipv4 unicast 192.0.2.0/32"我們可以查看當前,FRR 執行 ECMP 時的路徑選擇:

Cilium BGP Control Plane

BGP Controller 控制器是 Cilium 高版本推出的針對內置 BGP Speaker 更加細粒度的控制功能,其功能是上述 ConfigMap 的擴展。

審核編輯:劉清

-

控制器

+關注

關注

114文章

17143瀏覽量

184653 -

路由器

+關注

關注

22文章

3841瀏覽量

116942 -

BGP

+關注

關注

0文章

87瀏覽量

15712 -

LINUX內核

+關注

關注

1文章

317瀏覽量

22449 -

TCP通信

+關注

關注

0文章

146瀏覽量

4568

原文標題:如何快速讓 Cilium 和 BGP 協同工作

文章出處:【微信號:良許Linux,微信公眾號:良許Linux】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

bgp配置實例講解 如何配置Cilium和BGP協同工作

動態BGP與靜態BGP的區別?

labview控制兩個儀器協同工作

基于CSCW和多Agent的電網調度協同工作模型

如何使用自動BGP在數據中心構建最佳 ASN 配置

Macros如何協同工作

華為路由器BGP基礎配置實驗記錄

三電系統是如何協同工作的?

在多路電源并聯的系統中,濾波器之間如何實現良好的協同工作

評論