電子發燒友網報道(文/周凱揚)英偉達于今年發布了新一代的GH200 Grace Hopper硬件平臺,預示著其發展HPC與AI的重要路線邁進了新階段。GH200將用于應對世界上最復雜的生成式AI負載,涵蓋大語言模型、推薦系統和矢量數據庫等應用,且英偉達依然為GH200準備了不同的配置選項,無疑這一芯片很快就會用于各大數據中心和超算中。

NVLink,從片外互聯走向片內互聯

或許在多數人眼中,GH200不過是新一代Grace CPU和Hopper GPU結合的又一新產品,但這必然不是英偉達追求的“1+1=2”效果。事實上,GH200是象征著英偉達在芯片互聯技術先進設計水平的集大成者。

在英偉達的第四代NVLink技術和第三代NVSwitch技術下,創造一個256個GH200連接在一起的系統也不在話下。但這樣的片外互聯技術并不算罕見,市面上也有不少初創公司的AI芯片可以做到類似或者更夸張的擴展性。

然而在片內芯片互聯上,NVLink-C2C這一互聯技術確實達到了新的高度。NVLink-C2C是英偉達專為其superchip系列打造的內存一致、高帶寬、低延遲互聯技術。也是其實現高達900GB/s總帶寬的關鍵所在。900GB/s的帶寬是什么概念呢?與現代AI/HPC加速器常用的16路的PCIe 5.0相比,還要快上6倍。

NVLink-C2C的優勢

NVLink-C2C的第一大優勢就是其內存一致性,這不僅提高了開發者的效率、芯片性能,還提高了GPU可以訪問的內存量。在這一互聯技術的支持下,如今CPU、GPU線程都可以并行訪問CPU和GPU各自的內存,無需頁遷移,所以開發者可以專心于優化算法本身,而不是內存管理。

其次就是900GB/s的帶寬了,有了NVLink-C2C,應用程序可以直接用滿GPU的內存,再以超高的帶寬直接調用Grace CPU的內存。畢竟即便是最新的HBM3e版GH200,也只有144GB的內存,而Grace CPU可以支持到最高480GB的LPDDR5X內存。甚至在NVSwitch的支持下,可以高速訪問整個系統中最高達144TB的內存。

如此一來在GPT這樣的LLM模型中,可用的內存也就變多了。這對于batch size增加后,推理所需內存數增加的生成式AI來說至關重要。相比過去x86 CPU+PCIe 5.0 H100的搭配組合,GH200在更大的batch size下推理速度有著數倍的提升。

英偉達也對高帶寬在HPC加速上的優勢進行了解讀,以ABINIT的標準執行時間為例,ABINIT是一個用于計算材料光學、機械、振動等特性的模擬軟件。以只用x86 CPU的執行時間作為標準,在x86 CPU與Hopper GPU的結合下,超高性能的Hopper GPU極大地縮短了執行時間。

然而在CPU與GPU之間的傳輸開銷下,這一組合最終只能做到快上1.16倍的優勢。而如果是使用Grace Hopper方案的話,在NVLink-C2C的超大帶寬下,CPU與GPU之間的傳輸開銷迅速縮減,最終實現了縮短4.25倍的執行時間。

寫在最后

英偉達會走上自研CPU和Superchip的路線其實并不令人意外,為CPU與GPU之間打通一個更快的接口一直是英偉達的努力方向之一。此前由于x86的CPU設計主要還是有英特爾和AMD兩家廠商完成,而Grace這樣的自研Arm芯片則沒了設計限制,可以摻入英偉達的各種定制化開發。

NVLink-C2C也為市面上其他的AI芯片帶來了更大的挑戰,畢竟英偉達在性能、軟件生態上已經處于領先地位,又有著如此高效的互聯技術。可以預見未來其他廠商也會在芯片互聯、高速接口等領域發力,否則很難與英偉達同臺競爭。

-

英偉達

+關注

關注

22文章

3771瀏覽量

91000

發布評論請先 登錄

相關推薦

英偉達Blackwell芯片量產加速,Q4預計出貨達45萬片

英偉達帶領芯片股飆升 英偉達大漲4.76%

亞馬遜AWS暫緩采購英偉達GH200芯片,期待Blackwell更強

進一步解讀英偉達 Blackwell 架構、NVlink及GB200 超級芯片

Meta將率先使用英偉達最新人工智能芯片

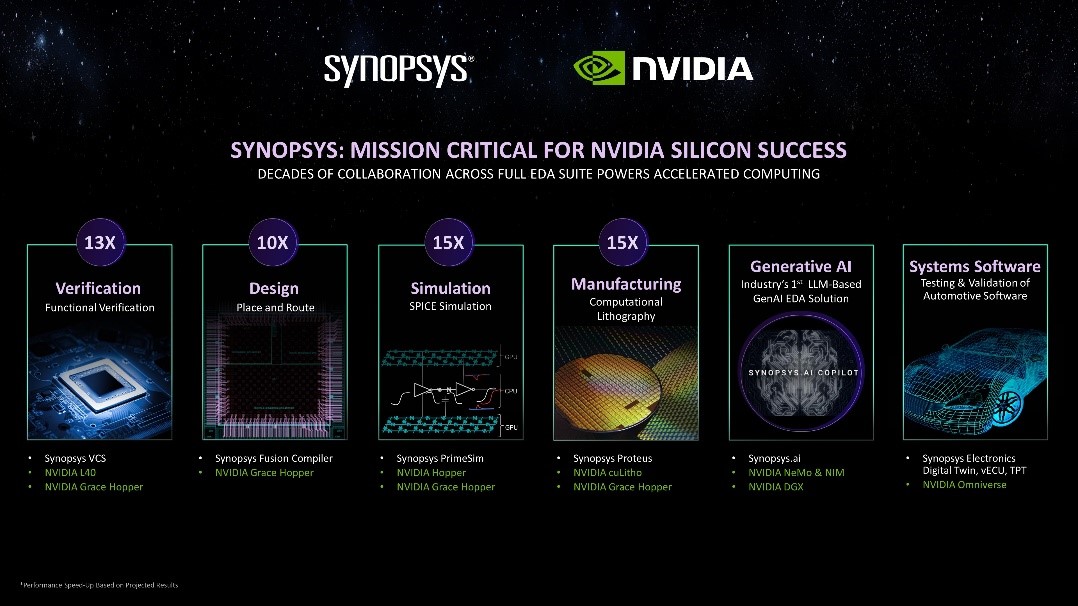

新思科技攜手英偉達:基于加速計算、生成式AI和Omniverse釋放下一代EDA潛能

英偉達超級芯片的真正殺手锏,C2C互聯技術

英偉達超級芯片的真正殺手锏,C2C互聯技術

評論