來源:新智元報道

導讀

人類距離AGI還有多遠?也許大語言模型不是最終答案,一個理解世界的模型才是未來的方向。在人類的認知之中,似乎早已習慣將通用人工智能(AGI)設定為人工智能的終極形態和發展的最終目標。

雖然OpenAI早已把公司的目標設定為實現AGI。但對于什么是AGI,OpenAI CEO Sam Altman自己都沒法給出具體的定義。

對于AGI何時能夠到來,也只存在于大佬們拋出的一個個近未來的敘事場景之中,似乎唾手可得,但又遙遙無期。

今天,在國外的知名的播客網站Substack上,一位名為Valentino Zocca的人工智能行業資深人士,站在人類歷史的敘事立場上,寫了一篇雄文,全面而深刻地講述了人類和通用人工智能之間的距離。

文章中將AGI大致定義為一個「能夠理解世界的模型」,而不僅僅是「描述世界的模型」。

他認為,人類要想真正達到AGI的世界,就需要建立一個「能夠質疑自身現實、能夠自我探究的系統」。

而這個偉大的探索過程中,也許誰都沒有資格和能力來給出一個具體的路線圖。

正如OpenAI科學家肯尼斯·斯坦利和喬爾·雷曼最近的新書《為什么偉大不能被計劃》中闡述的那樣,對于偉大的追求是個方向,但是具體的結果可能是意外所得。

我們離AGI還有多遠?

大約 20 萬年前,智人開始在地球上直立行走,與此同時,他們也開始了在思想和知識的領域中的遨游。

人類歷史上的一系列發現和發明塑造了人類的歷史。其中一些不僅影響了我們的語言和思維,還對我們的生理構造產生了潛在的影響。

例如,火的發現使原始人能夠烹飪食物。熟食為大腦能提供了更多的能量,從而促進了人類智能的發展。

從車輪的發明到蒸汽機的創造,人類迎來了工業革命。電力進一步為我們今天的技術發展鋪平了道路,印刷術加快了新思想和新文化的廣泛傳播,促進了人類創新的發展。

然而,進步不僅來自于新的物理層面的發現,同樣也源于新的思想。

西方世界的歷史是從羅馬帝國衰落到中世紀,在文藝復興和啟蒙運動期間經歷了一次重生。

但隨著人類知識的增長,人類這個物種開始慢慢認識到自身的渺小。

在蘇格拉底之后的兩千多年里,人類開始「知道自己一無所知」,我們的地球不再被視為宇宙的中心。宇宙本身在擴張,而我們只是其中的一粒微塵。

改變對現實的看法

但人類對世界的認知的最大改變,發生在20世紀。

1931 年,Kurt G?del發表了不完備性定理。

僅僅四年后,為了延續「完備性」這一主題,愛因斯坦、Podolsky和 Rosen發表了題為「Can Quantum-Mechanical Description of Physical Reality Be Considered Complete?」(量子力學對于物理實在的描述是完備的嗎?)

隨后,玻爾(Niels Bohr)對這篇論文進行了反駁,證明了量子物理學的有效性。

G?del定理表明,即使是數學也無法最終證明一切——人類始終會有無法證明的事實——而量子理論則說明,我們的世界缺乏確定性,使我們無法預測某些事件,例如電子的速度和位置。

盡管愛因斯坦曾表達過「上帝不會與宇宙玩骰子」這一著名的觀點,但從本質上講,僅僅在預測或理解物理中的事物時,人類的局限性就已經體現得淋漓盡致。

無論人類如何努力地嘗試設計出一個由人類制定的規則來運行的數學宇宙,但這樣抽象的宇宙始終是不完整的,其中隱藏著無法證明又無法否認的客觀公理。

除了數學的抽象表述之外,人類的世界還由描述現實的哲學所表述。

但是人類發現自己無法描述、充分表達、理解甚至僅僅是定義這些表述。

20世紀初「真理」的概念依然是不確定的,「藝術」、「美」和「生命」等概念在定義層面也都缺乏基本的共識。

其他很多重要的概念也一樣,「智慧」和「意識」同樣沒有辦法被人類自己清晰地定義。

智能的定義

為了填補對于智能定義的空缺,2007年,Legg和Hart在「General Intelligence」一書中提出了機器智能的定義:「智能衡量的是智能體(Agent)在多變環境中實現目標的能力」。

同樣,在「Problem Solving and Intelligence」一書中,Hambrick、Burgoyne和Altman認為,解決問題的能力不僅是智能的一個方面或特征,而是智能的本質。

這兩種說法在語言描述上有相似的地方,都認為「實現目標」可以與「解決問題」聯系起來。

Gottfredson在 「Mainstream Science on Intelligence: An Editorial with 52 Signatories」一書中,從更廣闊的視角總結了幾位研究者對于智能的定義:

「智能是一種非常普遍的心智能力,包括推理能力、計劃能力、解決問題的能力、抽象思維能力、理解復雜思想的能力、快速學習的能力以及從經驗中學習的能力。它不僅僅是書本知識、狹隘的學術技能或應試技巧。相反,它反映了一種更廣泛、更深層次的理解周圍環境的能力——『捕捉』、『理解』事物或『想出』該做什么的能力」。

這一定義使智能的構建超越了單純的 「解決問題的技能」,引入了兩個關鍵維度:從經驗中學習的能力和理解周圍環境的能力。

換句話說,智能不應該被看作是一種抽象的找到解決一般問題的方法的能力,而應該被看作是一種具體的將我們從以往經驗中學到的東西應用到我們所處環境中可能出現的不同情況的能力。

這就強調了智能與學習之間的內在聯系。

在「How We Learn」一書中,Stanislas Dehaene將學習定義為 「學習是形成世界模型的過程」,意味著智能也是一種需要理解周圍環境并創建內在模型來描述環境的能力。

因此,智能也需要創建世界模型的能力,盡管不僅僅包括這種能力。

當前的機器有多智能?

在討論人工通用智能(AGI)與狹義人工智能(Narrow AI)時,我們經常會強調它們之間的區別。

狹義人工智能(或稱弱人工智能)非常普遍,也很成功,在特定任務中的表現往往都能超越人類。

比如這個眾所周知的例子,2016年,狹義人工智能AlphaGo在圍棋比賽中以 4 比 1 的大比分擊敗世界冠軍李世石,就是一個很好的例子。

不過,2023年業余棋手Kellin Perline利用人工智能沒有沒有辦法應對的戰術又在圍棋場上替人類扳回了一局,說明了狹義人工智能在某些情況下確實還有局限性。

它缺乏人類那種識能別不常見戰術,并做出相應調整的能力。

而且,在最基礎的層面上,即使是剛入行的數據科學家,都明白人工智能所依賴的每個機器學習模型,都需要在偏差(bias)和方差(variance)之間取得平衡。

這意味著要從數據中學習,理解和歸納解決方案,而不僅僅是死記硬背。

狹義人工智能利用計算機的算力和內存容量,可以相對輕松地根據大量觀察到的數據生成復雜的模型。

但是,一旦條件稍有變化,這些模型往往就無法通用。

這就好比我們根據觀測結果提出了一個描述地球的引力理論,然后卻發現物體在月球上要輕得多。

如果我們在引力理論知識的基礎上使用變量而不是數字,我們就會明白如何使用正確的數值快速預測每個行星或衛星上的引力大小。

但是,如果我們只使用沒有變量的數字方程,那么在不重寫這些方程的情況下,我們將無法正確地將這些方程推廣到其他星球。

換句話說,人工智能可能無法真正 「學習」,而只能提煉信息或經驗。人工智能不是通過形成一個全面的世界模型去理解,而只是創建一個概要去表述。

我們真的到達AGI了嗎?

現在人們普遍理解的AGI是指:能夠在人類水平或者更高水平的多個認知領域進行理解和推理的人工智能系統,即強人工智能。

而我們當前用于特定任務的人工智能僅是一種弱人工智能,如下圍棋的AlphaGO。

AGI代表一種涵蓋抽象思維領域各個領域的、具有人類智能水平的人工智能系統。

這意味著,我們所需的AGI是一個與經驗一致且能做到準確預測的世界模型。

如「Safety Literature Review」(AGI安全文獻綜述)中Everitt、Lea和Hutter指出的事實那樣:AGI還沒有到來。

對于「我們離真正的AGI還有多遠」這個問題,不同的預測之間差異很大。

但與大多數人工智能研究人員和權威機構的觀點是一致的,即人類距離真正的通用人工智能最少也有幾年的時間。

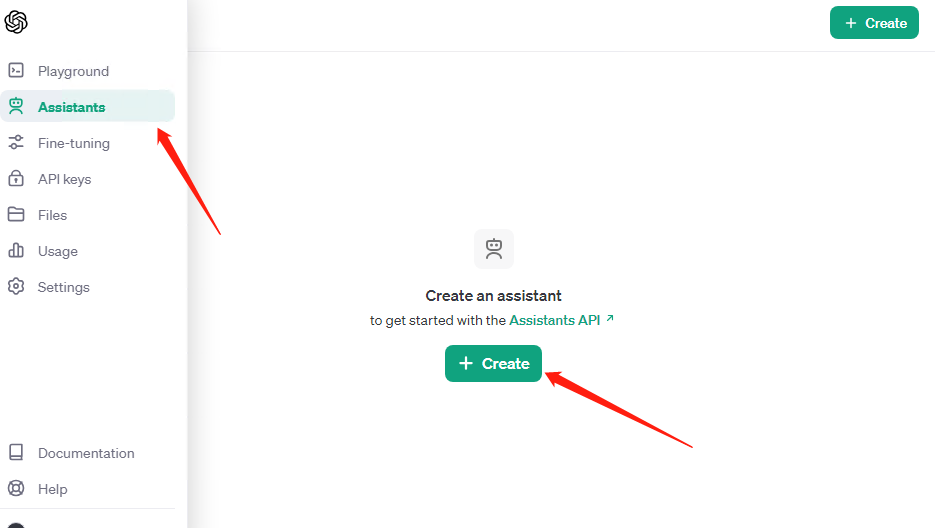

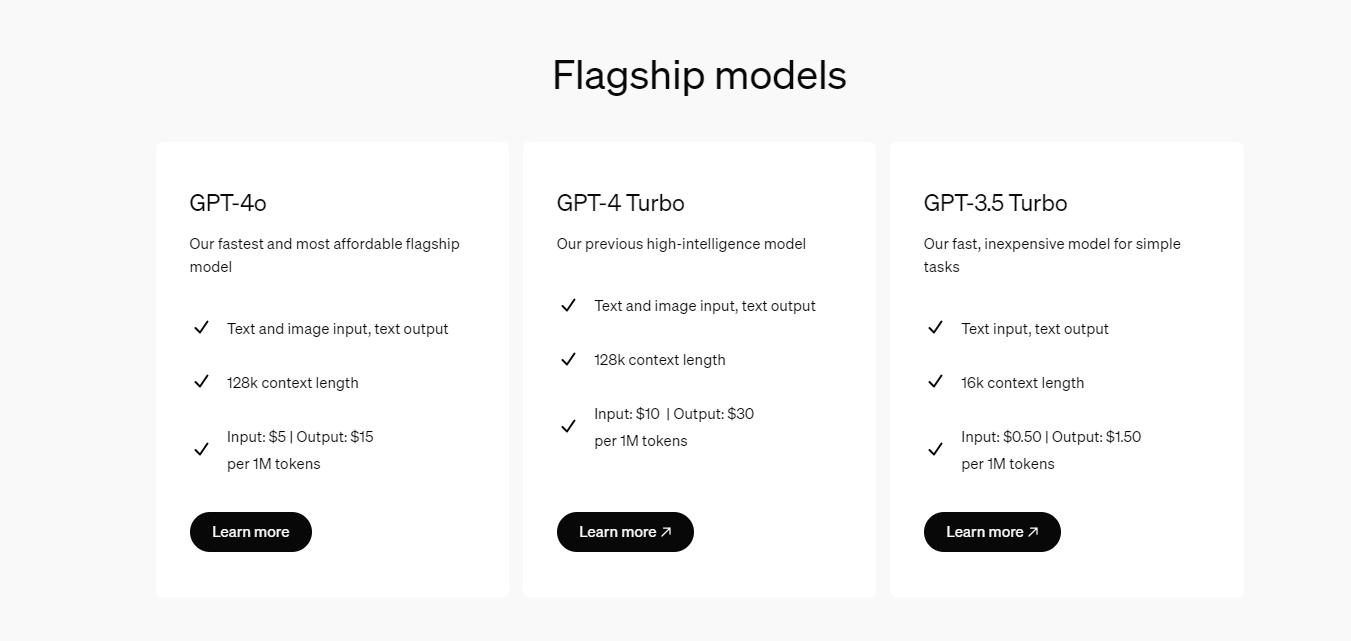

在GPT-4發布后,面對這個目前性能最強大的人工智能,很多人將GPT-4視作AGI的火花。

4月13日,OpenAI的合作伙伴微軟發布了一篇論文「Sparks of Artificial General Intelligence:Early experiments with GPT-4」(通用人工智能的火花:GPT-4的早期實驗)。

論文地址:https://arxiv.org/pdf/2303.12712

論文地址:https://arxiv.org/pdf/2303.12712

其中提到:

「GPT-4不僅掌握了語言,還能解決涵蓋數學、編碼、視覺、醫學、法律、心理學等領域的前沿任務,且不需要人為增加任何的特殊提示。

并且在所有上述任務中,GPT-4的性能水平都幾乎與人類水平相當。基于GPT-4功能的廣度和深度,我們相信它可以合理地被視為通用人工智能的近乎但不完全的版本。」

但就像卡內基梅隆大學教授Maarten Sap所評價的那樣,「AGI的火花」只是一些大公司將研究論文也納為公關宣傳的一個例子。

另一方面,研究員兼機器企業家Rodney Brooks指出了人們認識上的一個誤區:「在評估ChatGPT等系統的功能時,我們經常把性能等同于能力。」

錯誤地將性能等同于能力,意味著GPT-4生成的是對世界的摘要性描述認為是對真實世界的理解。

這與人工智能模型訓練的數據有關。

現在的大多數模型僅接受文本訓練,不具備在現實世界中說話、聽聲、嗅聞以及生活行動的能力。

這種情況與柏拉圖的洞穴寓言相似,生活在洞穴中的人只能看到墻上的影子,而不能認識到事物的真實存在。

僅在文本上訓練的世界模型,僅僅只能保證它們在語法上的正確。但在本質上,它不理解語言所指的對象,也缺乏與環境直接接觸的常識。

當前大模型的主要局限性

大語言模型(LLM)最受爭議的挑戰是它們產生幻覺的傾向。

幻覺指的是模型會捏造參考資料和事實,或在邏輯推斷、因果推理等方面顛三倒四、生成毫無意義的內容的情況。

大語言模型的幻覺源于它們缺乏對事件之間因果關系的了解。

在「Is ChatGPT a Good Causal Reasoner? A Comprehensive Evaluation」這篇論文中,研究人員證實了這樣一個事實:

ChatGPT這類大語言模型,不管現實中是否存在關系,它們都傾向于假設事件之間存在因果關系。

研究人員最后得出結論:

「ChatGPT是一個優秀的因果關系解釋器,但卻不是一個好的因果關系推理器。」

同理,這個結論也可以推廣到其他LLM中。

這意味著,LLM本質上只具有通過觀察進行因果歸納的能力,而不具備因果演繹的能力。

這也導致了LLM的局限性,如果智能(intelligence)意味著從經驗中學習,并將學習得到的內容轉化為對理解周圍環境的世界模型,那么因果推斷作為構成學習的基本要素,是智能不可或缺的一部分。

現有的LLMs正缺乏這一方面,這也是Yann LeCun認為現在的大語言模型不可能成為AGI的原因。

結論

正如20世紀初誕生的量子力學所揭示的,現實往往與我們日常觀察所形成的直覺不同。

我們所構建的語言、知識、文本資料、甚至是視頻、音頻等資料都僅僅只是我們所能體驗到的現實的很有限的一部分。

就像我們探索、學習并掌握一個違背我們直覺和經驗的現實那樣,當我們能夠構建一個有能力質疑自身現實、能夠自我探究的系統時,AGI才能真正實現。

而至少在現階段,我們應該構建一個能夠進行因果推斷、能夠理解世界的模型。

這一前景是人類歷史上又一進步,意味著我們對世界本質的更深的理解。

盡管AGI的出現將減弱我們對自身獨一無二的價值篤定,以及存在的重要性,但通過不斷地進步和對認知邊界的拓展,我們將更加清楚地認識到人類在宇宙中的地位,以及人類與宇宙的關系。

-

AI

+關注

關注

87文章

30758瀏覽量

268902 -

人工智能

+關注

關注

1791文章

47206瀏覽量

238276 -

Agi

+關注

關注

0文章

80瀏覽量

10204 -

GPT

+關注

關注

0文章

354瀏覽量

15345 -

LLM

+關注

關注

0文章

286瀏覽量

327

發布評論請先 登錄

相關推薦

Llama 3 與 GPT-4 比較

llm模型和chatGPT的區別

OpenAI推出新模型CriticGPT,用GPT-4自我糾錯

OpenAI API Key獲取:開發人員申請GPT-4 API Key教程

GPT-4人工智能模型預測公司未來盈利勝過人類分析師

OpenAI推出面向所有用戶的AI模型GPT-4o

阿里云發布通義千問2.5大模型,多項能力超越GPT-4

商湯科技發布5.0多模態大模型,綜合能力全面對標GPT-4 Turbo

OpenAI推出Vision模型版GPT-4 Turbo,融合文本與圖像理解

微軟Copilot全面更新為OpenAI的GPT-4 Turbo模型

新火種AI|秒殺GPT-4,狙殺GPT-5,橫空出世的Claude 3振奮人心!

GPT-4只是AGI的火花?LLM終將退場,世界模型才是未來

GPT-4只是AGI的火花?LLM終將退場,世界模型才是未來

評論