自 ChatGPT 發布以來,大模型的強大讓人們看見了通用人工智能的曙光,各個科技大廠也紛紛開源自家的大語言模型。然而,大模型也意味著高昂的硬件成本,讓不少平民玩家望而卻步。

為了讓大模型走入千家萬戶,賦能百業,上海人工智能實驗室開發了低成本大模型訓練工具箱 XTuner,旨在讓大模型訓練不再有門檻。通過 XTuner,最低只需 8GB 顯存,就可以打造專屬于你的 AI 助手。

X 種選擇

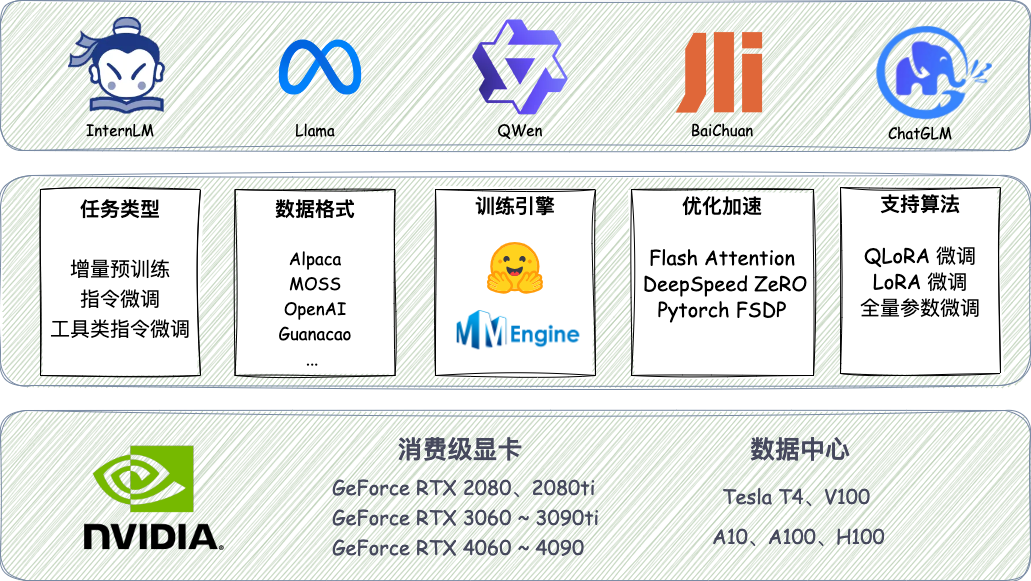

XTuner 提供了豐富的功能,上圖中的各項功能都可以隨意組合搭配。

除單點功能外,XTuner 還有以下三個黑科技,讓開發者可以做到真正的“面向數據”工作。

高效的數據引擎

XTuner 適配了多個熱門開源數據集格式,開發者如已有對應格式的數據集,可以直接使用,并支持多種格式數據源的混合使用:

Alpaca 格式,斯坦福大學開源數據集的格式,也是社區開源項目使用較多的一種格式

MOSS 格式,復旦大學開源指令微調數據集的格式,包含多輪對話和工具調用

Gunacao 格式,QLoRA 項目中所使用數據集的格式

OpenAI 格式,GPT-3.5-Turbo Finetune 接口要求的數據集格式

更多數據集格式正在持續添加中......

pip install xtuner # 訓練混合了 Alpaca 格式和 Gunacao 格式的數據 xtuner train internlm_7b_qlora_alpaca_enzh_oasst1_e3

除了支持多種數據集格式外,XTuner 還針對大語言模型數據的特點,對各種數據集格式做了充分的解耦,相較于其他的 Finetune 開源項目,可以在不破壞 Chat 模型對話模版的情況下,對 Chat 模型進行 Finetune。

pip install xtuner # 不破壞 Chat 模型對話模版,繼續增量指令微調 xtuner train internlm_chat_7b_qlora_oasst1_e3

針對 GPU 計算特點,在顯存允許的情況下,XTuner 支持將多條短數據拼接至模型最大輸入長度,以此最大化 GPU 計算核心的利用率,可以顯著提升訓練速度。例如,在使用 oasst1 數據集微調 Llama2-7B 時,數據拼接后的訓練時長僅為普通訓練的 50%。

多種訓練引擎

XTuner 首次嘗試將 HuggingFace 與 OpenMMLab 進行結合,兼顧易用性和可配置性。支持使用 MMEngine Runner 和 HuggingFace Trainer 兩種訓練引擎,開發者如有深度定制化需求,可根據使用習慣靈活配置。

pip install xtuner # 使用 MMEngine Runner 訓練 xtuner train internlm_7b_qlora_oasst1_e3 # 使用 HugingFace Trainer 訓練 xtuner train internlm_7b_qlora_oasst1_e3_hf

一鍵啟動訓練

XTuner 內置了增量預訓練、單輪&多輪對話指令微調、工具類指令微調的標準化流程,讓開發者只需聚焦于數據本身。

同時, XTuner 集成了 QLoRA、DeepSpeed 和 FSDP 等技術,提供各種尺寸模型在各種規格硬件下的訓練解決方案,通過 XTuner 一鍵式啟動訓練,僅需 8GB 顯存即可微調 7B 模型。

pip install 'xtuner[deepspeed]' # 8G 顯存微調 Llama2-7B xtuner train llama2_7b_qlora_oasst1_512_e3 --deepspeed deepspeed_zero2

基于此,開發者可以專注于數據,其他環節放心交給 XTuner,抽出更多精力去奔向大模型的星辰大海!

X 種玩法

通過 XTuner,開發者可以給大模型添加插件,補足大模型欠缺的能力,甚至獲得某些 ChatGPT 才有的技能。

XTuner 在 HuggingFace Hub 上提供了豐富的大模型插件,以下示例都可以在 Hub 中找到,歡迎大家下載體驗!

ColoristLlama -- 你的專屬調色師

通過在少量顏色注釋數據集上對 Llama2-7B 進行指令微調訓練,XTuner 成功解鎖了其調色能力。最終得到的模型甚至可以像“你的甲方”一樣反復修訂!

pip install xtuner xtuner chat hf meta-llama/Llama-2-7b-hf --adapter xtuner/Llama-2-7b-qlora-colorist --prompt-template colorist

Llama "聯網" -- 更可靠及時的回答

借助 XTuner 及插件開源數據集,我們還解鎖了 Llama 2、QWen 等開源模型的隱藏能力, 使其可以像 ChatGPT 一樣聯網搜索、調用工具,獲得更可靠的回復。

-

gpu

+關注

關注

28文章

4729瀏覽量

128890 -

顯存

+關注

關注

0文章

108瀏覽量

13654 -

大模型

+關注

關注

2文章

2423瀏覽量

2643

原文標題:8G顯存一鍵訓練,解鎖Llama2隱藏能力!XTuner帶你玩轉大模型

文章出處:【微信號:GiantPandaCV,微信公眾號:GiantPandaCV】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

用Ollama輕松搞定Llama 3.2 Vision模型本地部署

Llama 3 語言模型應用

一鍵斷電開關的種類有哪些

源2.0-M32大模型發布量化版 運行顯存僅需23GB 性能可媲美LLaMA3

8G顯存一鍵訓練,解鎖Llama2隱藏能力!XTuner帶你玩轉大模型

8G顯存一鍵訓練,解鎖Llama2隱藏能力!XTuner帶你玩轉大模型

評論